Do Wan tạo

Nhúng văn bản và xếp hạng lại là những công nghệ nền tảng trong xử lý ngôn ngữ tự nhiên (NLP) hỗ trợ các công cụ tìm kiếm hiện đại, hệ thống đề xuất, quy trình tạo dữ liệu tăng cường truy xuất (RAG) và thậm chí là cả AI tự chủ.

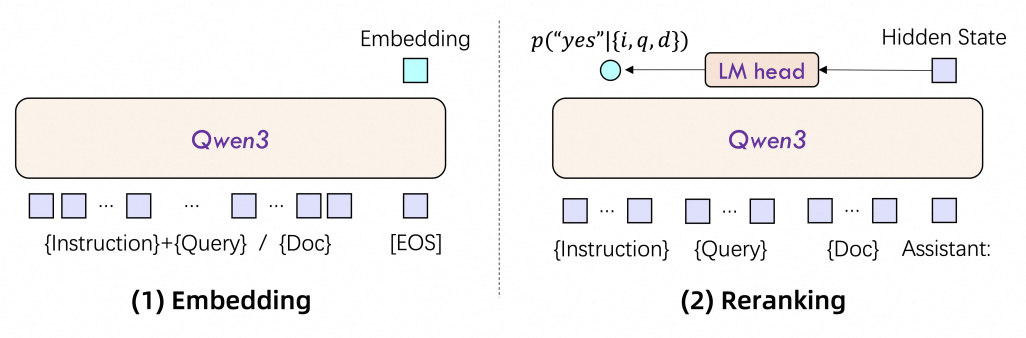

Mô hình nhúng văn bản chuyển đổi văn bản phi cấu trúc thành các vector số dày đặc (ví dụ: dãy số) nắm bắt được ý nghĩa ngữ nghĩa. Các vector này cho phép máy đo lường mức độ tương đồng giữa các văn bản, hỗ trợ các tác vụ như tìm kiếm ngữ nghĩa, phân cụm và phân loại. Ví dụ, truy vấn như_ "LLM tốt nhất cho ngành tài chính"_ có thể được khớp với các mô tả LLM (Mô hình ngôn ngữ lớn) hoặc các bài viết phù hợp với mục đích của truy vấn.

Mô hình xếp hạng lại tinh chỉnh kết quả của bước truy xuất ban đầu bằng cách sắp xếp lại các kết quả đề xuất dựa trên điểm chi tiết hơn về mức độ liên quan. Trong khi các mô hình nhúng thu thập kết quả khớp trên diện rộng, thì mô hình xếp hạng lại sẽ ưu tiên các kết quả phù hợp nhất theo ngữ cảnh. Ví dụ, công cụ tìm kiếm trước tiên có thể sẽ truy xuất 100 tài liệu bằng cách sử dụng mô hình nhúng, sau đó áp dụng mô hình xếp hạng lại để chọn ra 10 tài liệu phù hợp nhất.

Ứng dụng chính:

Dòng sản phẩm Qwen3 Embedding, được xây dựng dựa trên các mô hình Qwen3, là minh chứng cho bước tiến vượt bậc trong việc tìm hiểu cách trình bày văn bản. Trong đó bao gồm các mô hình nhúng (để vector hóa văn bản) và các mô hình xếp hạng lại (để tinh chỉnh kết quả tìm kiếm), với dung lượng tham số là 0,6B, 4B và 8B.

1. Đặc biệt linh hoạt:

2. Linh hoạt toàn diện:

3. Thành thạo nhiều ngôn ngữ:

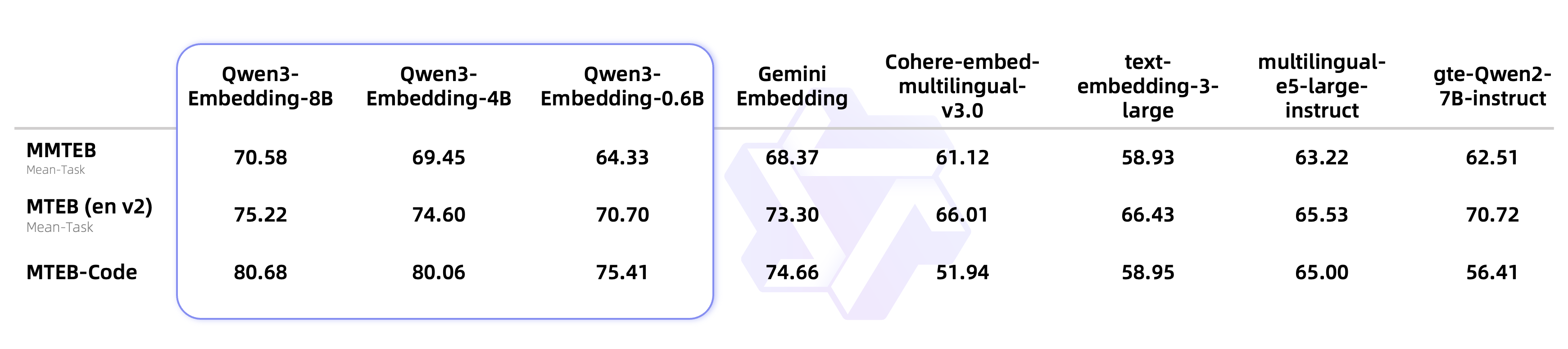

Kết quả đánh giá cho các mô hình xếp hạng lại:

Kết quả đánh giá cho các mô hình xếp hạng lại:

| Mô hình | Tham số | MTEB-R | CMTEB-R | MMTEB-R | MLDR | Mã MTBB | FollowIR |

|---|---|---|---|---|---|---|---|

| Qwen3-Embedding-0.6B | 0,6B | 61,82 | 71,02 | 64,64 | 50,26 | 75,41 | 5,09 |

| Jina-multilingual-reranker-v2-base | 0,3B | 58,22 | 63,37 | 63,73 | 39,66 | 58,98 | -0,68 |

| gte-multilingual-reranker-base | 0,3B | 59,51 | 74,08 | 59,44 | 66,33 | 54,18 | -1,64 |

| BGE-reranker-v2-m3 | 0,6B | 57,03 | 72,16 | 58,36 | 59,51 | 41,38 | -0,01 |

| Qwen3-Reranker-0.6B | 0,6B | 65,80 | 71,31 | 66,36 | 67,28 | 73,42 | 5,41 |

| Qwen3-Reranker-4B | 4B | 69,76 | 75,94 | 72,74 | 69,97 | 81,20 | 14,84 |

| Qwen3-Reranker-8B | 8B | 69,02 | 77,45 | 72,94 | 70,19 | 81,22 | 8,05 |

Hiệu suất

Hiệu quả:

Tùy chỉnh:

Yêu cầu về nguồn lực::

Độ trễ:

Tổng quan về mô hình:

| Loại mô hình | Mô hình | Dung lượng | Lớp | Độ dài chuỗi | Kích thước nhúng | Hỗ trợ MRL | Nhận biết hướng dẫn |

|---|---|---|---|---|---|---|---|

| Nhúng văn bản | Qwen3-Embedding-0.6B | 0,6B | 28 | 32K | 1024 | Có | Có |

| Qwen3-Embedding-4B | 4B | 36 | 32K | 2560 | Có | Có | |

| Qwen3-Embedding-8B | 8B | 36 | 32K | 4096 | Có | Có | |

| Xếp hạng lại văn bản | Qwen3-Reranker-0.6B | 0,6B | 28 | 32K | - | - | Có |

| Qwen3-Reranker-4B | 4B | 36 | 32K | - | - | Có | |

| Qwen3-Reranker-8B | 8B | 36 | 32K | - | - | Có |

Lưu ý: "Hỗ trợ MRL" cho biết liệu mô hình nhúng có hỗ trợ số chiều tùy chỉnh cho lần nhúng cuối cùng hay không. "Nhận biết hướng dẫn" cho biết liệu mô hình nhúng hoặc xếp hạng lại có hỗ trợ tùy chỉnh hướng dẫn đầu vào cho các tác vụ khác nhau hay không.

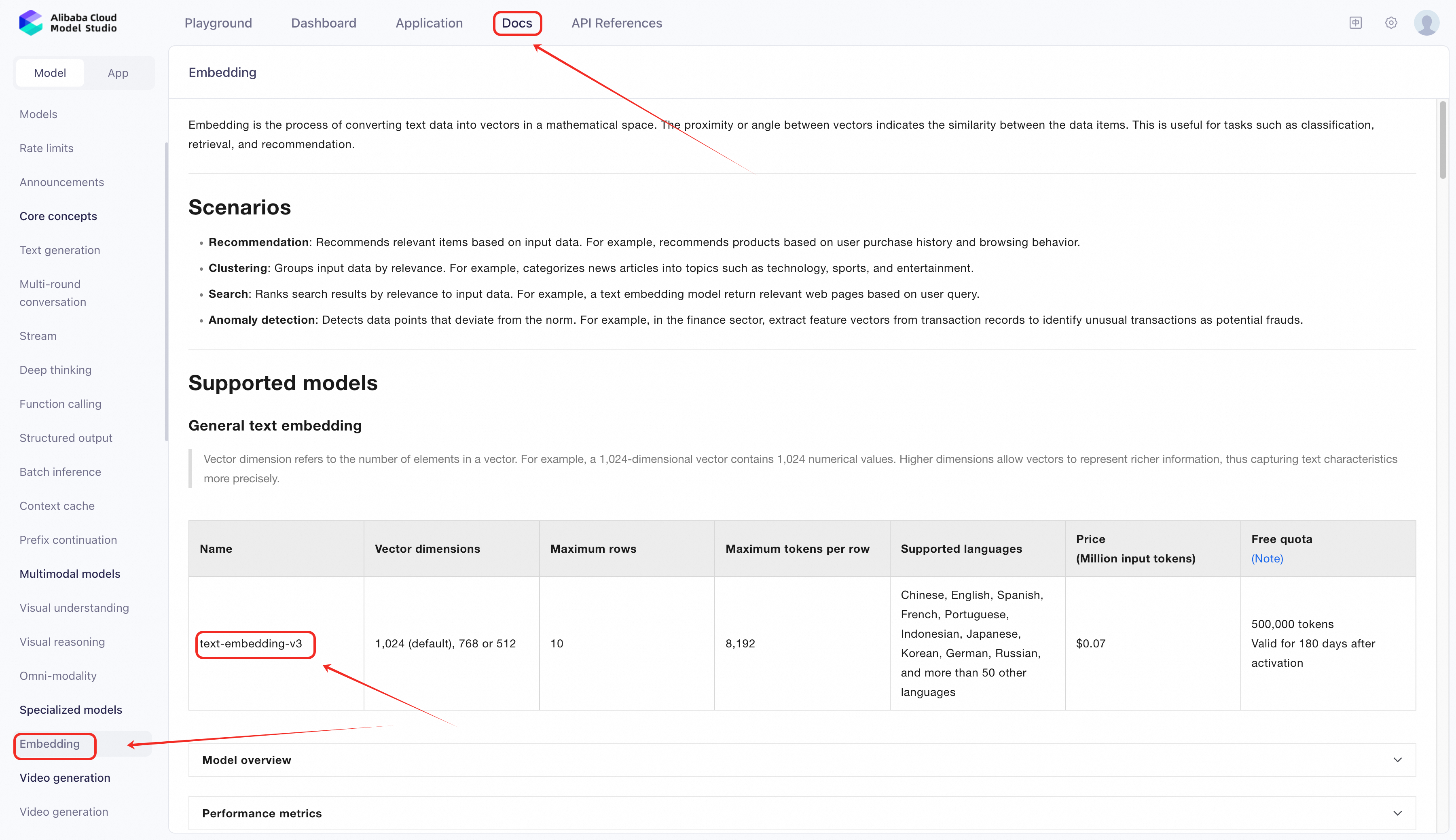

Alibaba Cloud cung cấp hai phương pháp chính để gọi mô hình nhúng:

Model Studio của Alibaba Cloud giúp truy cập vào các mô hình độc quyền và nguồn mở được đào tạo trước đơn giản hơn, bao gồm text-embedding-v3, mà không yêu cầu triển khai hoặc quản lý cơ sở hạ tầng.

1. Truy cập Model Studio:

2. Gọi mô hình thông qua API tương thích với OpenAI:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"), # Thay thế bằng Khóa API của bạn nếu bạn chưa cấu hình biến môi trường

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1" # base_url for Model Studio

)

completion = client.embeddings.create(

model="text-embedding-v3",

input='The quality of the clothes is excellent, very beautiful, worth the wait, I like it and will buy here again',

dimensions=1024,

encoding_format="float"

)

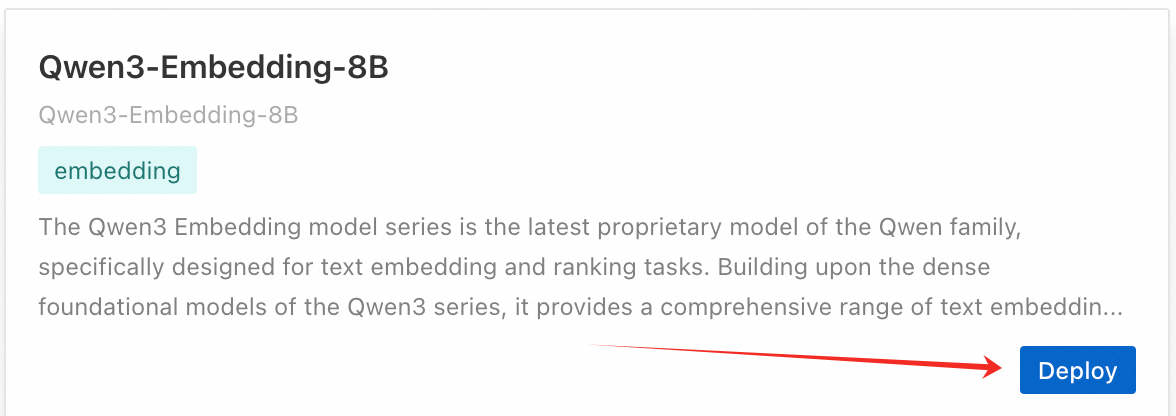

print(completion.model_dump_json())Đối với các trường hợp sử dụng nâng cao yêu cầu tùy chỉnh (ví dụ: tinh chỉnh theo từng lĩnh vực cụ thể), hãy triển khai Qwen3-Embedding-8B hoặc các biến thể Qwen3 khác trên PAI-EAS (Elastic Accelerated Service). Dưới đây là hướng dẫn từng bước dựa trên các công cụ và giao diện PAI mới nhất:

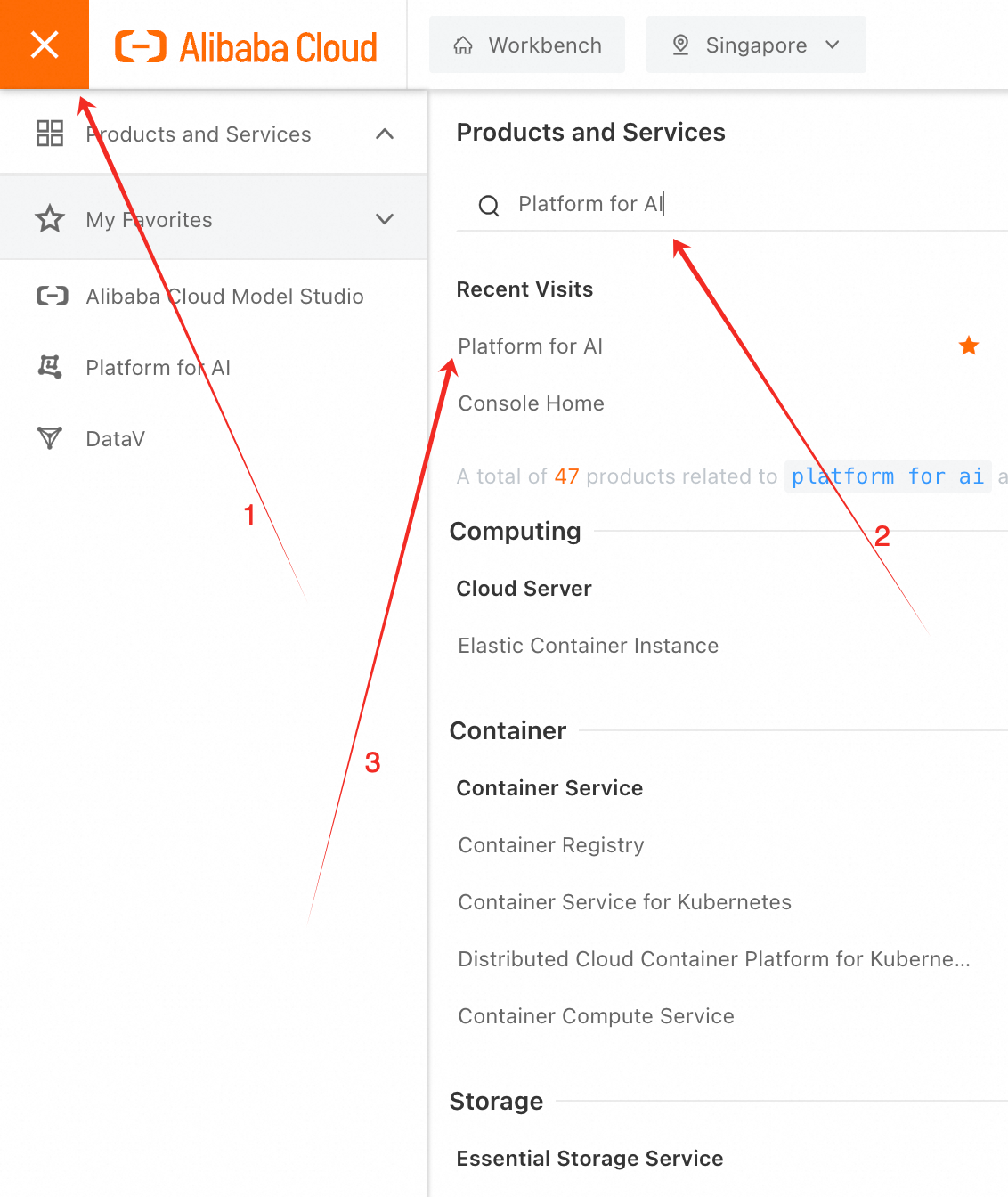

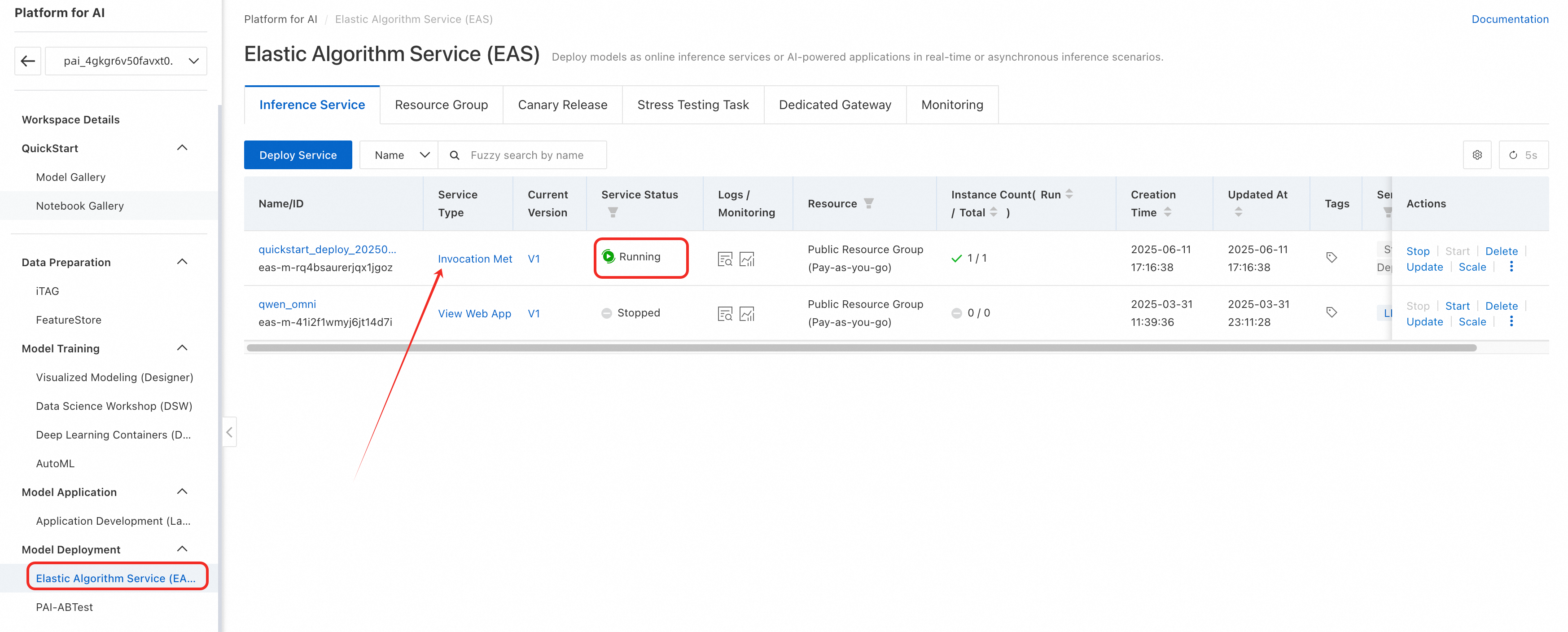

1. Đăng nhập vào bảng điều khiển PAI.

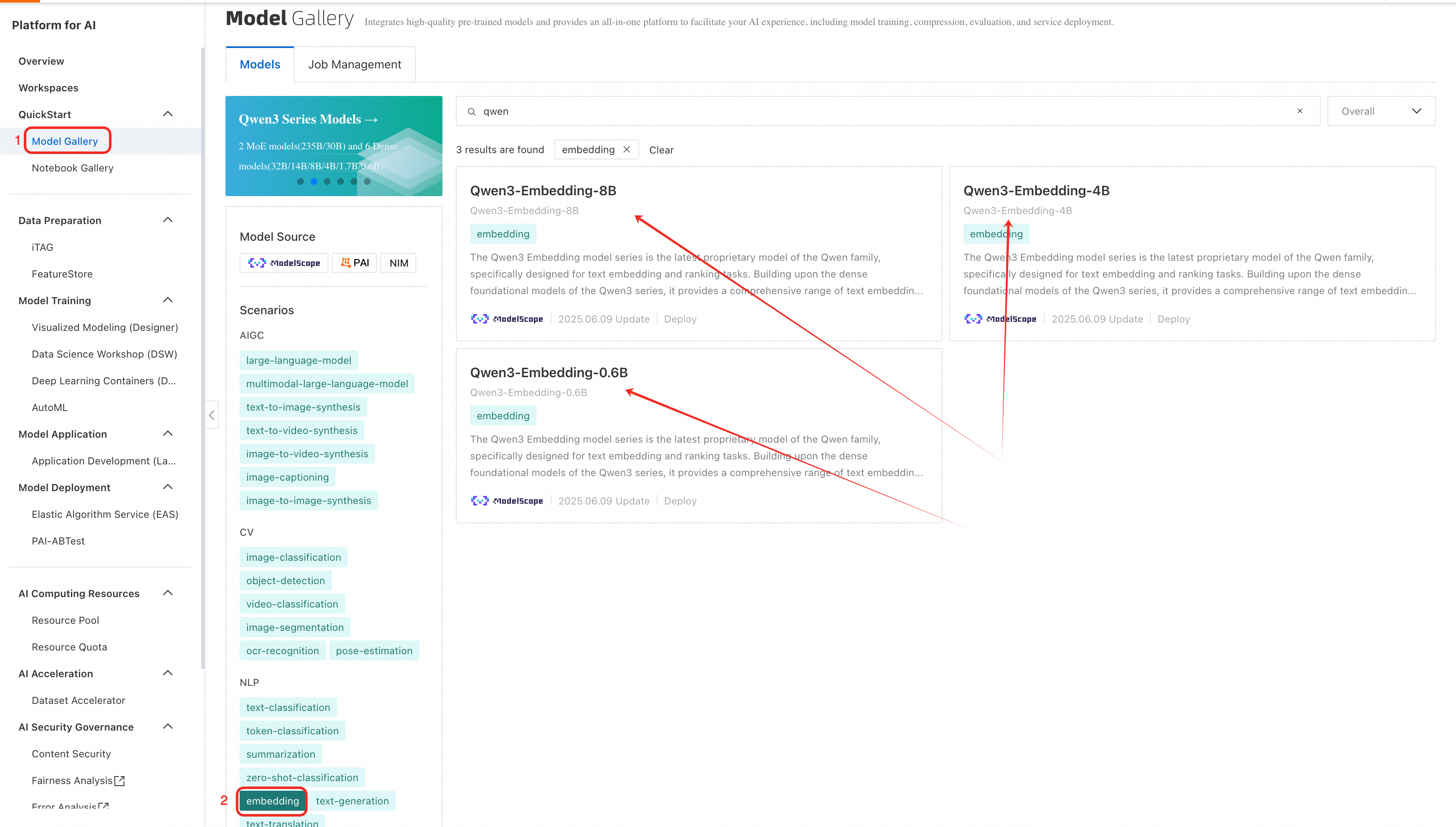

2. Chọn không gian làm việc rồi chọn _QuickStart > Model Gallery > NLP > embedding_, tìm mô hình Qwen3-Embedding.

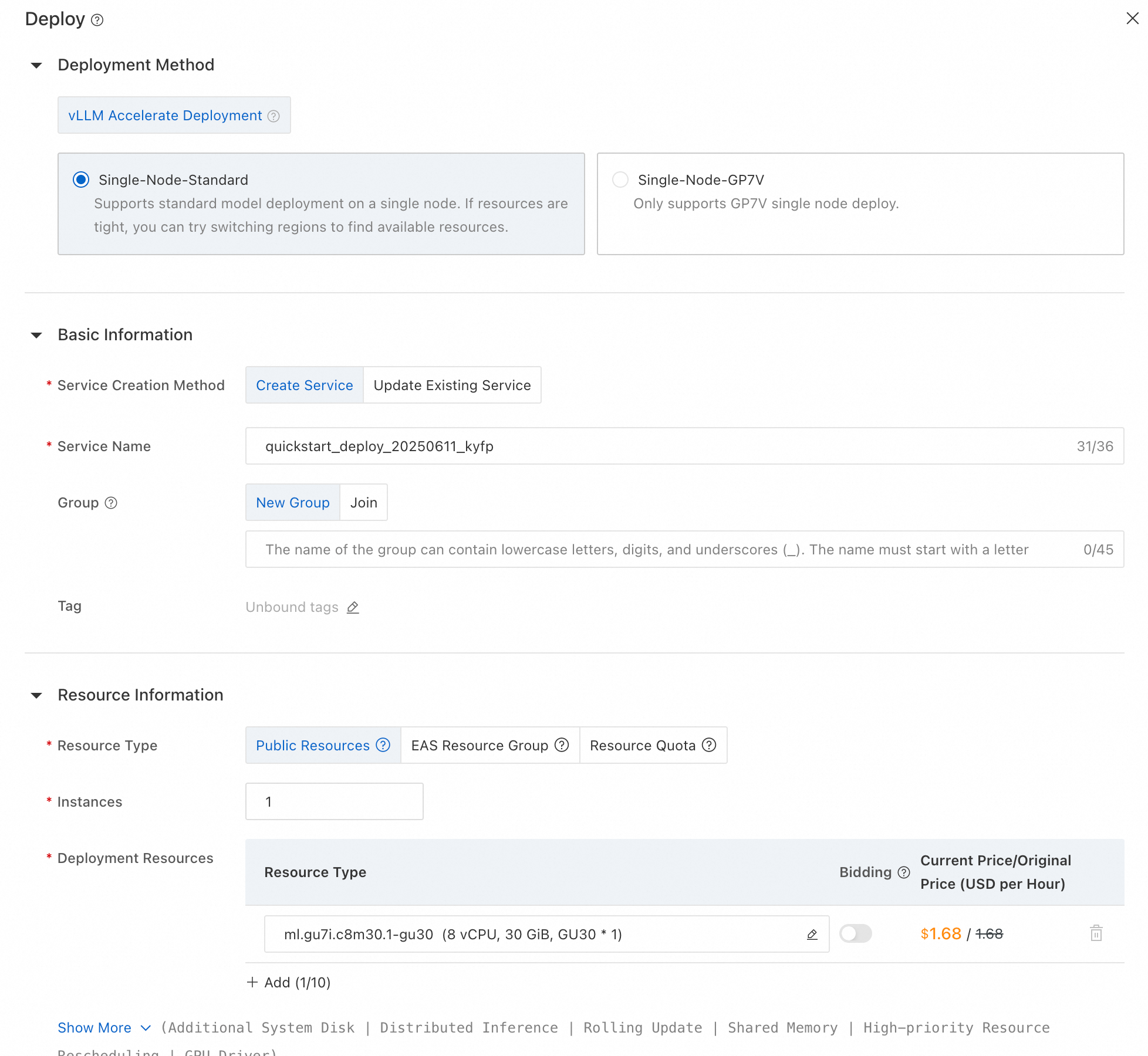

4. Cấu hình loại phiên bản, tự động mở rộng và các tham số khác.

5. Để truy cập vào mô hình đã triển khai gần đây, hãy mở phần Model Deployment và chọn Elastic Algorithm Service (EAS). Khi "Service Status" chuyển sang "Running", bạn sẽ có thể bắt đầu sử dụng mô hình.

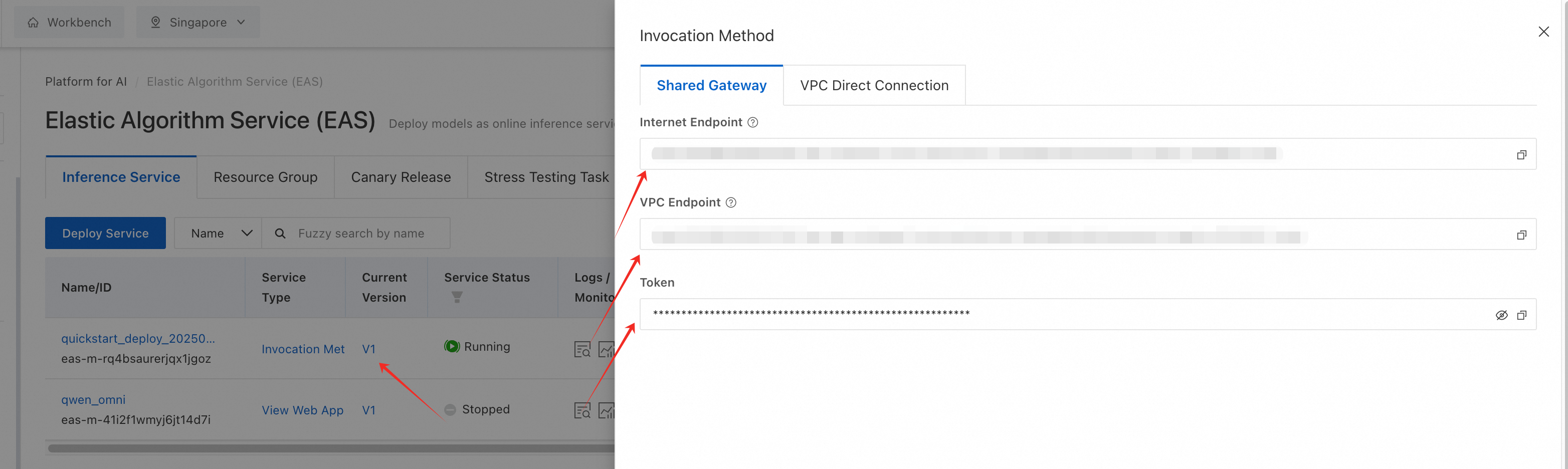

6. Nhấp vào Invocation Method và sao chép điểm cuối API đã tạo để tích hợp.

Quy trình làm việc đơn giản hơn này đảm bảo triển khai nhanh chóng trong khi vẫn duy trì tính linh hoạt để tùy chỉnh nâng cao.

PAI-EAS có sẵn khả năng hỗ trợ định dạng API của OpenAI, cho phép tích hợp liền mạch với các công cụ như langchain hoặc openai:

from openai import OpenAI

# Initialize client with PAI-EAS endpoint

client = OpenAI(

base_url="https://<pai-eas-endpoint>/v1",

api_key="<your-pai-api-key>"

)

# Generate embeddings

embedding = client.embeddings.create(

input="How should I choose best LLM for the finance industry?",

model="qwen3-embedding-8b"

)

print(embedding.data[0].embedding) # Outputs a 4096D vector

# Rerank search results

rerank = client.rerank.create(

query="Renewable energy solutions",

documents=[

"Solar power adoption surged by 30% in 2024.",

"Wind energy faces challenges in urban areas.",

"Hydrogen fuel cells offer zero-emission transportation."

],

model="qwen3-reranker-4b"

)

print(rerank.results) # Returns relevance scores 1. Gọi API trực tiếp (không bắt buộc) Để kiểm soát cấp thấp, hãy gửi yêu cầu HTTP thô:

import requests

# Example request

url = "<pai-eas-endpoint>/v1/embeddings"

headers = {"Authorization": "Bearer <your-api-key>"}

payload = {

"input": ["Quantum computing will revolutionize cryptography."],

"model": "qwen3-embedding-8b"

}

response = requests.post(url, headers=headers, json=payload)

print(response.json()) | Trường hợp sử dụng | Model Studio | PAI-EAS |

|---|---|---|

| Tạo nguyên mẫu nhanh | ✅Không cần mã, truy cập tức thì | ❌Cần thiết lập triển khai |

| Tùy chỉnh theo từng lĩnh vực cụ thể | ❌Giới hạn ở các mô hình được đào tạo trước | ✅Hỗ trợ tinh chỉnh và mô hình tùy chỉnh |

| Hiệu quả chi phí | ✅Tính giá mỗi token | ✅Tính giá phiên bản GPU linh hoạt |

| Tích hợp với SDK OpenAI | ✅Hỗ trợ API tương thích với OpenAI | ✅Hỗ trợ API tương thích với OpenAI |

Các mô hình nhúng và xếp hạng lại của Qwen3 có hiệu suất hàng đầu và khả năng thích ứng cao trong nhiều lĩnh vực. Bằng cách tận dụng hệ sinh thái PAI của Alibaba Cloud, bạn có thể triển khai và tinh chỉnh các mô hình này để giải quyết các khó khăn cụ thể theo từng lĩnh vực, từ phân tích rủi ro tài chính đến nghiên cứu y tế. Trong tương lai, chúng tôi sẽ mở rộng chức năng đa phương thức (ví dụ: truy xuất hình ảnh và văn bản đa phương thức), cũng như tối ưu hóa cho các thiết bị biên.

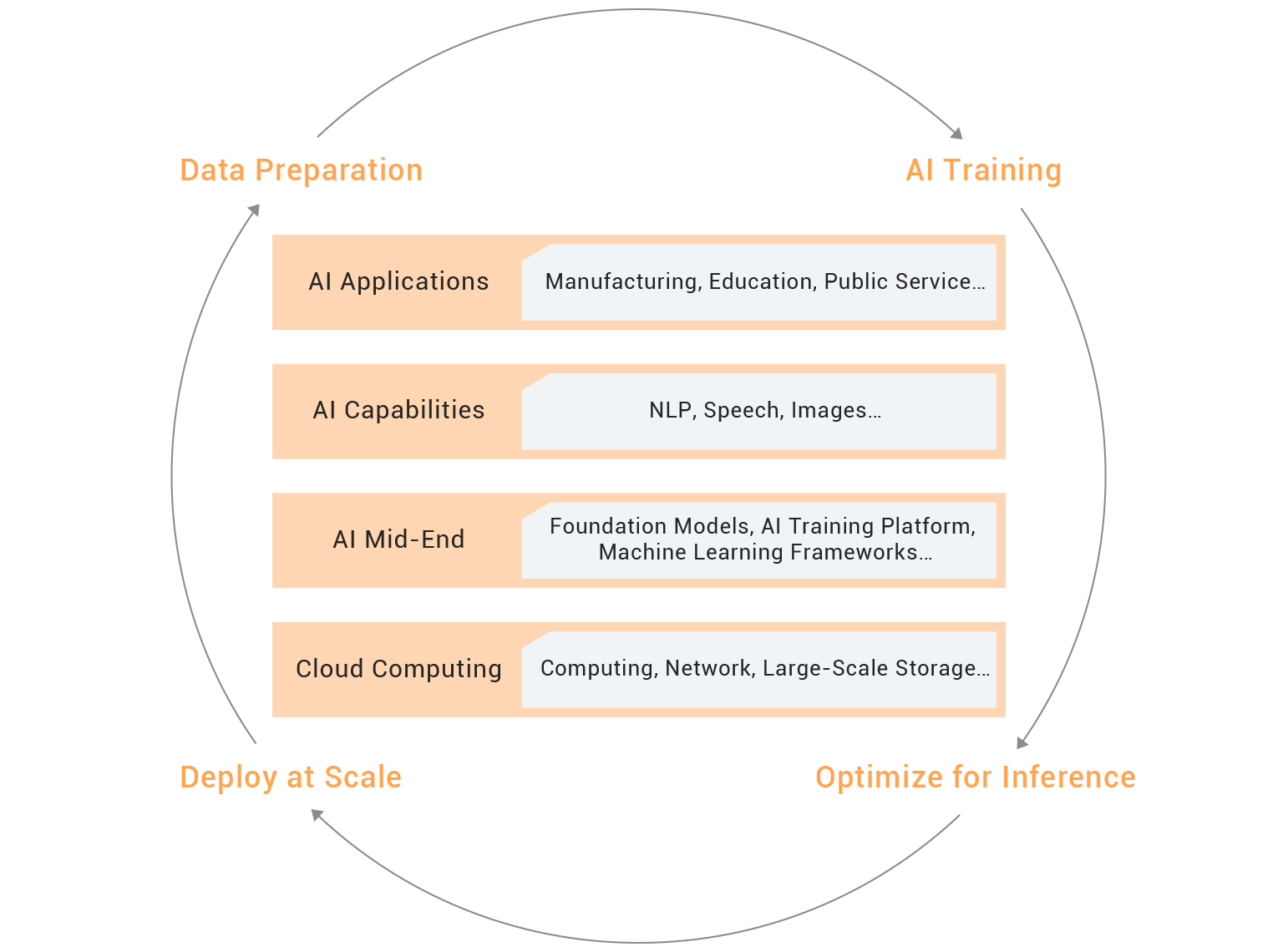

Trong thế giới AI, không có một công thức chung nào cho mọi trường hợp. Trong khi các mô hình nhúng và xếp hạng lại của Qwen3 được đào tạo trước để thành thạo các tác vụ chung, từ hiểu văn bản đa ngôn ngữ đến truy xuất mã, thì tiềm năng thực sự của chúng chỉ phát huy khi được điều chỉnh cho phù hợp với các lĩnh vực như tài chính, y tế hoặc luật. Đây chính là lúc PAI-Lingjun, nền tảng đào tạo quy mô lớn của Alibaba Cloud, đóng vai trò là chất xúc tác cho quá trình đổi mới.

Hãy tưởng tượng một nhà nghiên cứu dược phẩm đang sàng lọc hàng triệu thử nghiệm lâm sàng để tìm ra phương pháp phù hợp cho một căn bệnh hiếm gặp, hoặc một luật sư đang xem xét hàng nghìn hợp đồng để tìm một điều khoản cụ thể. Các mô hình chung mặc dù mạnh mẽ những lại thiếu độ tinh tế cần thiết khi xử lý ngôn ngữ chuyên ngành — các thuật ngữ như “EBITDA”, “nhồi máu cơ tim” hoặc “bất khả kháng” đòi hỏi độ chính xác. Khả năng tinh chỉnh sẽ giúp cải thiện sự thiếu sót này, bằng cách điều chỉnh kiến trúc của Qwen3 để nắm bắt được những sắc thái riêng biệt của các tác vụ chuyên biệt, từ phát hiện thuốc đến đánh giá rủi ro tài chính.

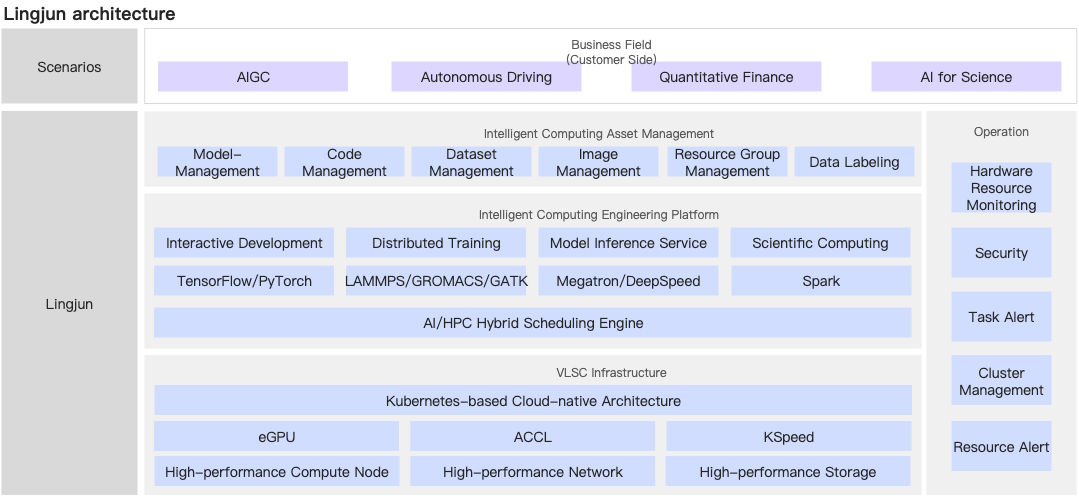

PAI-Lingjun là một công cụ mạnh mẽ được thiết kế để xử lý nhu cầu điện thoán khi tinh chỉnh các mô hình Qwen3. Với khả năng hỗ trợ đào tạo phân tán trên mọi GPU/TPU, giải pháp này giúp các tổ chức mở rộng quy mô từ mô hình tham số 0,6B lên 8B, đảm bảo ngay cả những lĩnh vực phức tạp nhất cũng có thể tìm được sự cân bằng lý tưởng giữa tốc độ và độ chính xác.

Các thành phần chính của quy trình làm việc:

1. Đào tạo bước đầu ít giám sát:

Tại giai đoạn này, Qwen3 tiếp thu nhịp điệu ngôn ngữ của một lĩnh vực cụ thể. Bằng cách tạo ra dữ liệu tổng hợp — như tạo truy vấn cho đơn xin vay hoặc mô phỏng thuật ngữ pháp lý — Qwen3 xây dựng nền tảng hiểu biết, ngay cả trong những tình huống thiếu nguồn lực.

2. Tinh chỉnh có giám sát:

Với dữ liệu được chọn lọc, mô hình sẽ cải thiện được chuyên môn của mình. Một ngân hàng dữ liệu có thể sẽ được đào tạo về 12 triệu tài liệu tài chính, dạy cách phát hiện những dấu hiệu đáng ngờ trong đơn xin vay với độ chính xác cao.

3. Hợp nhất mô hình:

Giống như việc pha trộn màu sắc trên bảng màu, nội suy tuyến tính hình cầu (SLERP) kết hợp các điểm kiểm tra, cân bằng giữa khái quát hóa và chuyên môn hóa. Kết quả? Một mô hình phát triển vững mạnh cả về chiều rộng lẫn chiều sâu.

Việc tinh chỉnh Qwen3-Embedding-8B là thử thách thực sự cho những ai đủ khả năng. Cần có GPU 8x NVIDIA A100 và thời gian đào tạo từ 3–5 ngày. Tuy nhiên, kết quả nhận lại vô cùng to lớn: độ chính xác khi truy xuất tăng trực tiếp từ 72% lên 89% và độ bao phủ lĩnh vực tăng vọt lên 93%. Các mô hình nhỏ hơn, như Qwen3-Reranker-0.6B, sở hữu sự linh hoạt để đánh giá theo thời gian thực, chứng minh rằng sức mạnh không phải lúc nào cũng phụ thuộc vào kích thước.

| Số lượng tham số mô hình | Tài nguyên đào tạo đầy đủ tham số | Tài nguyên đào tạo đầy đủ tham số | Áp dụng kỹ thuật song song hóa mô hình để đào tạo dựa trên Megatron. |

|---|---|---|---|

| 7 tỷ | Tám GPU gu7xf hoặc tám GPU gu7ef | Một GPU NVIDIA V100 (bộ nhớ 32 GB) hoặc một GPU NVIDIA A10 (bộ nhớ 24 GB) | TP1 và PP1 |

| 14 tỷ | Tám GPU gu7xf hoặc tám GPU gu7ef | Hai GPU NVIDIA V100 (bộ nhớ 32 GB) hoặc hai GPU NVIDIA A10 (bộ nhớ 24 GB) | TP2 và PP1 |

| 72 tỷ | Bốn máy chủ, mỗi máy chủ có tám GPU gu7xf hoặc tám GPU gu7ef | Sáu GPU NVIDIA V100 (bộ nhớ 32 GB) hoặc hai GPU gu7xf | TP8 và PP2 |

Giải pháp:

Giải pháp:

Giải pháp:

Giải pháp:

Giải pháp:

Với PAI-Lingjun và Qwen3, sức mạnh đổi mới các ngành công nghiệp nằm trong tầm tay bạn. Cho dù bạn đang tối ưu hóa các mô hình kiểm soát rủi ro tài chính hay thúc đẩy đột phá về y tế, chức năng nhúng và xếp hạng lại của Qwen3 đều mang lại độ chính xác vượt trội. Hãy cùng nhau vẽ nên tương lai mới.

Bạn có câu hỏi? Hãy liên hệ với đội ngũ của chúng tôi hoặc khám phá PAI-Lingjun để bắt đầu dùng thử miễn phí ngay hôm nay!

Việc tinh chỉnh Qwen3 không chỉ là một quy trình kỹ thuật, mà còn là một bước nhảy vọt mang tính chiến lược. Cho dù bạn đang cách mạng hóa lĩnh vực tài chính, y tế hay khoa học vật liệu, PAI-Lingjun đều trang bị cho bạn khả năng khai thác toàn bộ tiềm năng của AI.

Dòng sản phẩm Qwen3 Embedding đánh dấu bước tiến quan trọng trong việc tìm hiểu cách trình bày văn bản. Tuy nhiên, những tiến bộ liên tục về các mô hình ngôn ngữ lớn (LLM) đang mở ra những ranh giới mới. Dưới đây là các lĩnh vực trọng tâm cho sự phát triển trong tương lai, nhấn mạnh vào hoạt động nhúng nhận thức hướng dẫn và MRL (Matryoshka Representation Learning):

Các mô hình truyền thống cần được đào tạo lại để thích ứng với các tác vụ mới, nhưng kiến trúc nhận thức hướng dẫn của Qwen3 giúp thích ứng linh hoạt thông qua câu lệnh cụ thể cho từng tác vụ. Cách này loại bỏ nhu cầu tinh chỉnh theo từng lĩnh vực cụ thể, giúp giảm chi phí và độ phức tạp.

Các khái niệm chính:

Các mô hình nhúng Qwen3 chấp nhận các hướng dẫn rõ ràng làm dữ liệu đầu vào, hướng dẫn mô hình tạo ra các hoạt động nhúng phù hợp với các tác vụ cụ thể. Ví dụ:

def get_detailed_instruct(task_description: str, query: str) -> str:

return f'Instruct: {task_description}\nQuery: {query}'

# Example: Flag loan applications with geopolitical risk factors

task = "Identify loan applications with geopolitical risk factors"

query = "Loan application for a tech firm in Southeast Asia"

input_text = get_detailed_instruct(task, query) Phương pháp này nhúng hướng dẫn vào ngữ cảnh đầu vào, đảm bảo mô hình tập trung vào các sắc thái cụ thể của từng lĩnh vực (ví dụ: "rủi ro địa chính trị") mà không cần phải đào tạo lại.

Bằng cách thêm các hướng dẫn cụ thể theo từng tác vụ vào truy vấn, Qwen3 có thể thích ứng với các lĩnh vực mới với dữ liệu được gắn nhãn ở mức tối thiểu. Ví dụ: một mô hình xếp hạng lại trong lĩnh vực hóa học có thể ưu tiên các phân tử liên quan đến một mục tiêu thuốc cụ thể bằng cách đưa vào một hướng dẫn như:

task = "Find molecules similar to aspirin for anti-inflammatory use"

query = "C1CC(=O)NC(=O)C1" # Aspirin's SMILES string MRL hỗ trợ điều chỉnh linh động số chiều nhúng trong quá trình suy luận, tạo ra sự linh hoạt mà không cần đào tạo lại. Sự đổi mới này cho phép một mô hình duy nhất phục vụ nhiều tình huống (ví dụ: thiết bị biên nhẹ so với máy chủ có độ chính xác cao).

Cách hoạt động của MRL:

Các mô hình nhúng Qwen3 tạo ra các hoạt động nhúng có số chiều có thể tùy chỉnh (ví dụ: 1024D, 2560D hoặc 4096D).

Trong quá trình suy luận, bạn có thể chọn số chiều mong muốn thông qua tham số output_dimension:

# Generate a 2560D vector for financial risk analysis

embeddings = model.encode(queries, output_dimension=2560) Ưu điểm của MRL:

Ví dụ: MRL trong lĩnh vực y tế

Một nhà nghiên cứu dược phẩm có thể tạo hoạt động nhúng 4096D để sàng lọc phân tử chính xác nhưng chuyển sang 1024D để phân cụm hồ sơ bệnh án theo thời gian thực:

# High-precision molecule embedding

molecule_embedding = model.encode("C1CC(=O)NC(=O)C1", output_dimension=4096)

# Lightweight patient record clustering

patient_notes_embedding = model.encode("Patient presents with chest pain", output_dimension=1024) •Thách thức: Ưu tiên các đơn xin vay có dấu hiệu đáng ngờ (ví dụ: lịch sử nợ quá hạn).

•Giải pháp:

task = "Identify loans with delinquency risks"

query = "Loan application for a tech startup in India"

input_text = get_detailed_instruct(task, query) •Số liệu về hiệu suất:

| Số liệu | Cơ bản | Sau khi tối ưu hóa |

|---|---|---|

| Độ chính xác khi truy xuất | 72% | 89% |

| Độ chính xác xếp hạng lại@10 | 65% | 84% |

Giải pháp:

# Generate embeddings for clinical notes

embeddings = model.encode(clinical_notes, output_dimension=256)

# Cluster notes with HDBSCAN

clusterer = HDBSCAN(min_cluster_size=50)

labels = clusterer.fit_predict(embeddings) Giải pháp:

| Mô hình | Điểm mã MTEB | Độ trễ truy vấn (ms) |

|---|---|---|

| Qwen3-Embedding-8B | 80,68 | 150 |

| Qwen3-Embedding-8B (MRL) | 85,21 (4096D) | 160 (độ chính xác cao hơn) |

Giải pháp: Thiết kế nhận thức hướng dẫn của Qwen3 cho phép các nhà phát triển xác định hướng dẫn cụ thể cho từng tác vụ tại thời điểm suy luận.

Lợi ích:

Giải pháp: MRL giúp điều chỉnh số chiều linh động.

Lợi ích:

Các mô hình nhúng Qwen3 định nghĩa lại tính linh hoạt bằng cách kết hợp nhúng nhận thức hướng dẫn và Hỗ trợ MRL, loại bỏ nhu cầu tinh chỉnh theo từng lĩnh vực cụ thể.

Khi tận dụng những đổi mới này, các tổ chức có thể:

Tài liệu tham khảo:

Kho lưu trữ mã:

Liên hệ: Nếu muốn hợp tác hoặc khi có câu hỏi, hãy liên hệ với Alibaba Cloud.

Lần đầu tiên trong lịch sử, máy móc có thể giải mã mối quan hệ di truyền giữa một bài thơ tiếng Phạn, một hàm Python và chẩn đoán y khoa — một bước đột phá mà ai cũng có thể tiếp cận được thông qua cải tiến mã nguồn mở. Tương tự như cách giải trình tự DNA đã cách mạng hóa ngành sinh học bằng cách hé lộ mã phổ quát của sự sống, Qwen3 Embedding làm biến đổi AI bằng cách mô phỏng cấu trúc phân tử của chính ý nghĩa. Công nghệ này vượt qua ngôn ngữ, văn hóa và kỷ luật, mở ra những mối kết nối ẩn giúp định nghĩa lại cách các hệ thống AI hiểu và thu thập thông tin.

Tìm kiếm bằng AI truyền thống hoạt động như một con robot chỉ biết so khớp từ khóa, bị giới hạn ở việc tìm kiếm dựa trên văn bản. Tuy nhiên, Qwen3 Embedding hoạt động như một công cụ giải trình tự DNA cho ngôn ngữ, nắm bắt các mối quan hệ ngữ nghĩa sâu sắc giữa các khái niệm bằng hơn 250 ngôn ngữ và mô hình lập trình. Dù là phân tích chẩn đoán y khoa, hợp đồng pháp lý hay thuật toán điện toán lượng tử, Qwen3 đều giải mã được mã di truyền của ý nghĩa, giúp máy nắm bắt được sắc thái, bối cảnh và mối liên hệ liên ngành. Đây không chỉ là sự cải thiện gia tăng mà còn là sự chuyển mình của mô hình.

Hệ thống đào tạo nhiều giai đoạn của Qwen3 Embedding kết hợp việc tạo dữ liệu tổng hợp, tinh chỉnh có giám sát và hợp nhất mô hình để đạt được hiệu suất tiên tiến. Với điểm số 70,58 trong bài kiểm tra MTEB đa ngôn ngữ và 80,68 trong bài kiểm tra Mã MTEB, Qwen3 đã vượt qua những gã khổng lồ độc quyền như Gemini-Embedding của Google, chứng minh rằng sự đổi mới nguồn mở có thể vượt xa các hệ sinh thái khép kín. Bằng cách cung cấp mã nguồn mở cho các mô hình theo giấy phép Apache 2.0, Alibaba dân chủ hóa quyền truy cập vào "mã di truyền của ý nghĩa" này, trao cho các nhà phát triển trên toàn thế giới cơ hội xây dựng các hệ thống thông minh hơn và trực quan hơn.

Sức mạnh thực sự của Qwen3 không chỉ nằm ở thông số kỹ thuật mà còn ở khả năng kết nối các thế giới:

Đây không phải là những tình huống mang tính giả định mà là những thực tế đang được định hình thông qua khả năng nắm bắt ý nghĩa ở cấp độ di truyền của Qwen3.

Khi AI phát triển, Qwen3 Embedding tạo tiền đề cho các hệ thống đa phương thức, không chỉ giải mã văn bản mà cả hình ảnh, âm thanh và video thông qua cùng một lăng kính di truyền. Hãy tưởng tượng một AI có thể đọc hiểu báo cáo y sinh, trực quan hóa ý nghĩa của nó trong mô hình protein 3D và tạo ra mã để mô phỏng hành vi của nó — tất cả thông qua nhúng đa phương thức thống nhất.

Hơn nữa, hiệu quả của Qwen3, từ các mô hình 0,6B nhẹ đến các biến thể 8B hiệu suất cao, đảm bảo khả năng thích ứng cho cả thiết bị biên và ứng dụng quy mô đám mây. Tương lai thuộc về các hệ thống có khả năng học hỏi như sinh vật, tiến hóa thông qua việc tiếp xúc với các hệ sinh thái dữ liệu đa dạng. Qwen3 Embedding không chỉ là một công cụ, mà là bản thiết kế cho sự tiến hóa này.

Mã di truyền của ý nghĩa nay đã nằm trong tầm tay. Khám phá các mô hình nhúng và xếp hạng lại Qwen3 trên Hugging Face và ModelScope. Triển khai trên hệ sinh thái PAI của Alibaba Cloud hoặc tinh chỉnh cho lĩnh vực cụ thể của bạn. Cho dù bạn là nhà nghiên cứu, nhà phát triển hay doanh nghiệp, kỷ nguyên kiến thức AI ở cấp độ di truyền bắt đầu từ hôm nay.

_Liên hệ_: Nếu muốn hợp tác hoặc khi có câu hỏi, hãy liên hệ với Alibaba Cloud

Bài viết này được dịch từ tiếng Anh. Xem bài viết gốc tại đây.

Menguasai Penyematan Teks dan Pemeringkat Ulang dengan Qwen3

125 posts | 4 followers

FollowRegional Content Hub - December 15, 2025

Regional Content Hub - July 28, 2025

Regional Content Hub - May 7, 2025

Regional Content Hub - May 13, 2024

Regional Content Hub - August 29, 2024

Regional Content Hub - April 14, 2025

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub