Oleh Farruh Kushnazarov

Dunia telah menyaksikan bahwa kecerdasan buatan berkembang dari pencarian akademis ceruk menjadi gaya transformatif yang membentuk ulang industri. Di jantung revolusi ini terdapat model dasar–jaringan neural kolosal yang telah menunjukkan kemampuan menakjubkan dalam bahasa, penalaran, dan kreativitas. Namun, kisah sukses mereka terkait erat dengan kisah infrastruktur yang mendukung mereka. Ini adalah kisah pertumbuhan eksponensial dari menghadapi batas fisik, dan dari inovasi tanpa henti yang diperlukan untuk membangun landasan komputasional yang kuat bagi generasi kecerdasan berikutnya.

Artikel ini mengeksplorasi sejarah dramatis pelatihan AI, memecahkan hambatan penting yang mengancam untuk menghambat kemajuan, dan membidik masa depan infrastruktur yang direkayasa untuk mengatasi tantangan monumental ini.

Perjalanan menuju model triliun parameter saat ini bukanlah serangkaian garis lurus dari kesetimbangan terpatah-patah, di mana terobosan konseptual dibuka oleh tingkat kekuatan komputasi baru. Selama beberapa dekade, harapan terhadap jaringan neural terhambat oleh kemampuan pemrosesan dan data yang terbatas. Semuanya berubah pada 2012.

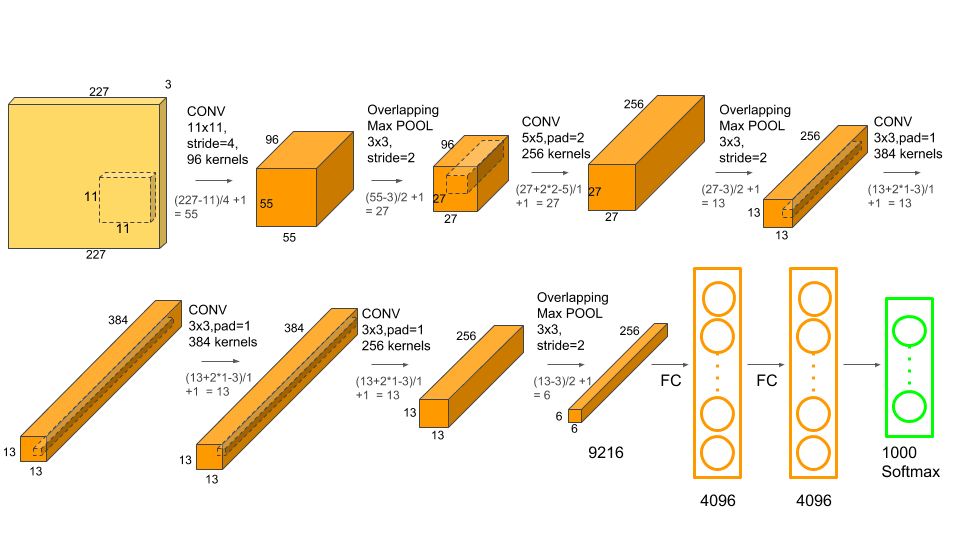

Tantangan Pengenalan Visual Skala Besar ImageNet (ILSVRC) 2012 secara luas dianggap sebagai "Dentuman Besar" era AI modern. Sebuah jaringan neural konvolusional (CNN) bernama AlexNet, yang dikembangkan oleh Alex Krizhevsky, Ilya Sutskever, dan Geoffrey Hinton, mencapai kemenangan yang menakjubkan [1]. AlexNet tidak hanya menang; ia memecahkan rekor dengan tingkat kesalahan 15,3%, lompatan besar dari 26,2% entri terbaik berikutnya.

Kesuksesan AlexNet bukan hanya karena arsitektur barunya. Yang terpenting, ini adalah salah satu model pertama yang akan dilatih pada Unit Pemrosesan Grafis (GPU). Dengan memanfaatkan kekuatan pemrosesan paralel dua GPU NVIDIA GTX 580, para peneliti dapat melatih model dengan 60 juta parameter pada 1,2 juta himpunan data gambar—Skala sebelumnya tidak dapat dibayangkan. Momen ini membuktikan bahwa dengan data dan komputasi yang cukup, pembelajaran yang mendalam tidak hanya layak tetapi lebih unggul daripada metode tradisional, memicu ledakan Kambriah dalam penelitian AI.

Arsitektur AlexNet, yang menggabungkan lapisan konvolusional mendalam dengan pemrosesan GPU untuk mencapai performa terobosannya. Sumber: Krizhevsky et al., 2012.

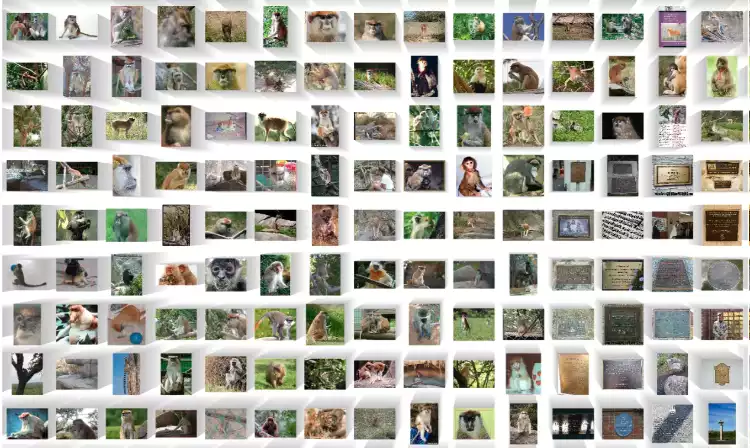

Sampel kecil jutaan gambar berlabel dalam himpunan data ImageNet yang menjadi bahan bakar revolusi pembelajaran mendalam. Sumber: ImageNet

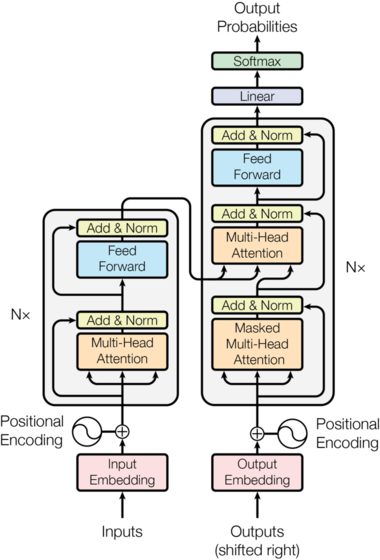

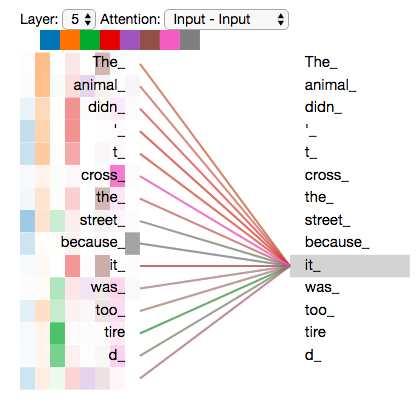

Lima tahun kemudian, terjadi pergeseran seismik lainnya. Pada 2017, sebuah makalah dari Google berjudul "Attention is All You Need" memperkenalkan arsitektur Transformer [2]. Desain baru ini sepenuhnya meniadakan struktur berulang dan konvolusional yang mendominasi bidang ini. Sebaliknya, arsitektur ini mengandalkan sebuah mekanisme yang disebut "perhatian mandiri", yang memungkinkan model untuk menimbang pentingnya berbagai kata dalam urutan input secara bersamaan.

Inovasi utamanya adalah paralelisasi. Tidak seperti Jaringan Neural Berulang (RNN) yang memproses data secara berurutan, Transformer dapat memproses semua bagian input sekaligus. Perubahan arsitektur ini merupakan pasangan sempurna untuk sifat paralel GPU yang masif, membuka kemampuan untuk melatih model yang jauh lebih besar dan lebih kompleks dengan kecepatan yang belum pernah ada sebelumnya. Transformer menjadi cetak biru mendasar bagi hampir semua model bahasa besar (LLM) selanjutnya, termasuk seri GPT.

Arsitektur Transformer asli saat diperkenalkan dalam makalah "Attention Is All You Need". Sumber: Vaswani et al., 2017.

Visualisasi mekanisme perhatian mandiri, yang memungkinkan model untuk menimbang pentingnya berbagai kata dalam sebuah kalimat. Sumber: Jay Alammar

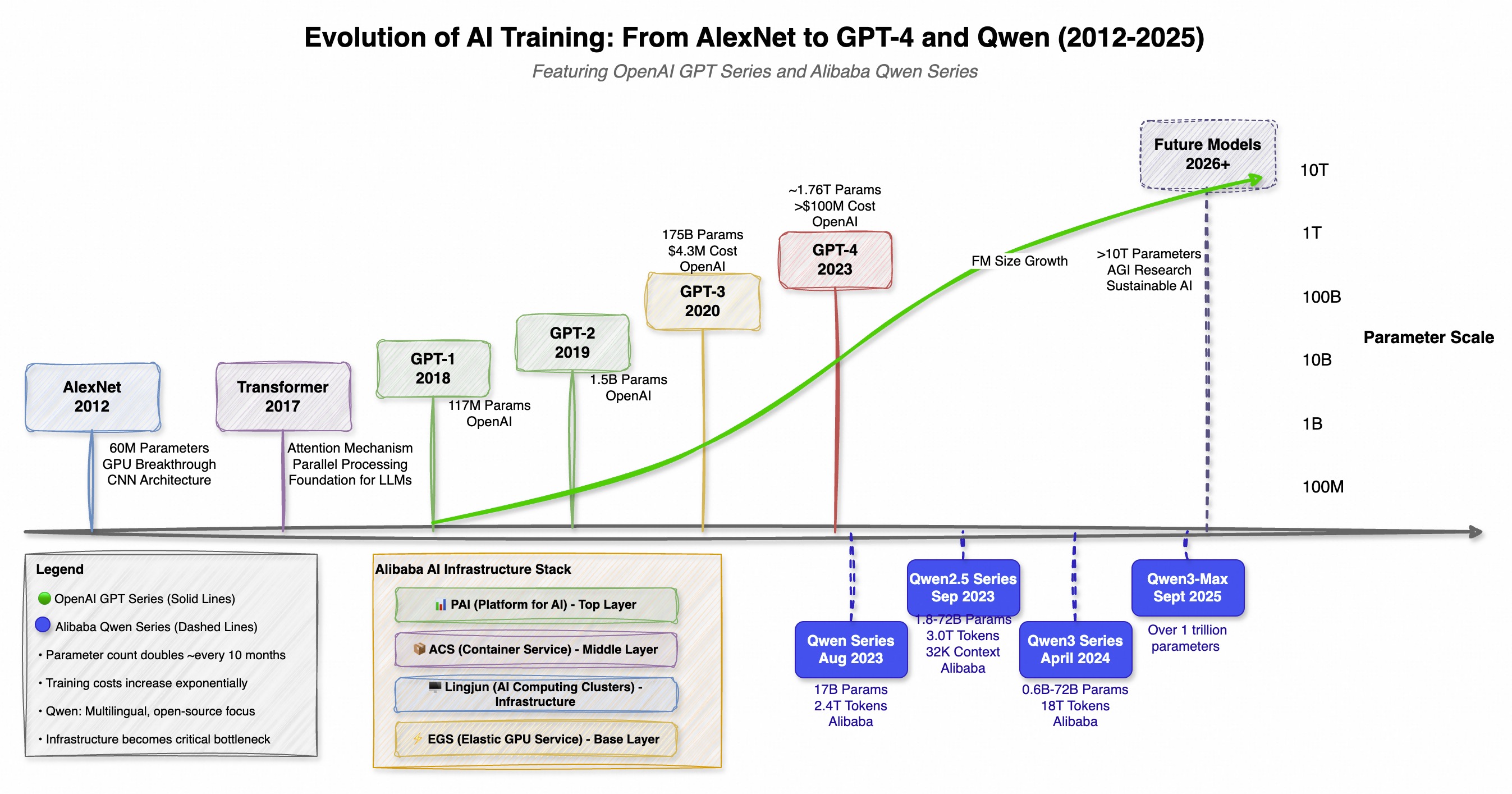

Pengenalan Transformer mengawali perlombaan komputasional global. Ukuran, biaya, dan kompleksitas model AI mulai tumbuh dengan laju eksponensial. Tren ini dicontohkan bukan hanya oleh satu perusahaan, tetapi oleh pengembangan paralel di seluruh dunia, terutama dengan seri GPT OpenAI di Barat dan seri Qwen (通义千问) Alibaba di Timur. Keduanya telah mendorong batasan skala, tetapi dengan filosofi yang berbeda—GPT yang berfokus pada kemampuan terobosan dan Qwen yang menekankan pada sumber terbuka yang kuat dan pendekatan multibahasa.

Evolusi jalur ganda ini menyoroti kemajuan cepat di seluruh dunia menuju AI yang lebih canggih dan efisien, dengan setiap rilis model baru menetapkan standar yang lebih tinggi untuk yang berikutnya.

| Model | Tanggal Rilis | Parameter | Inovasi/Fokus Utama |

|---|---|---|---|

| GPT-1 | 2018 | 117 Juta | Pra-Pelatihan Tanpa Pengawasan (OpenAI) |

| GPT-2 | 2019 | 1,5 Miliar | Performa Tugas Zero-shot (OpenAI) |

| GPT-3 | 2020 | 175 Miliar | Pembelajaran dalam Konteks Beberapa Shot (OpenAI) |

| Qwen-7B | Agu 2023 | 7 Miliar | Basis multibahasa sumber terbuka yang kuat (Alibaba) |

| GPT-4 | Sep 2023 | ~1,76 Triliun (MoE) | Penalaran Tingkat Lanjut, Multimodalitas (OpenAI) |

| Qwen-72B | Nov 2023 | 05-72 Miliar | 32K panjang konteks, sumber terbuka (Alibaba) |

| Qwen2.5 | Sep 2024 | Hingga 72 Miliar | Terlatih dengan 18T token, pengodean yang disempurnakan/matematika (Alibaba) |

| Qwen3-Max | Sep 2025 | ~ 1 Triliun | Model terbesar dan paling mahir dari Qwen (Alibaba) saat ini |

Pertumbuhan yang eksplosif ini, di mana tuntutan komputasi meningkat dua kali lipat setiap lima hingga enam bulan, telah mendorong pengembangan AI garis depan ke dalam domain yang dapat diakses hanya oleh beberapa perusahaan hyperscale dengan modal untuk membangun dan mengoperasikan supercomputer skala planet [5].

Garis waktu yang menunjukkan evolusi paralel seri GPT OpenAI dan seri Qwen Alibaba, menyoroti perlombaan global dalam pengembangan model dasar.

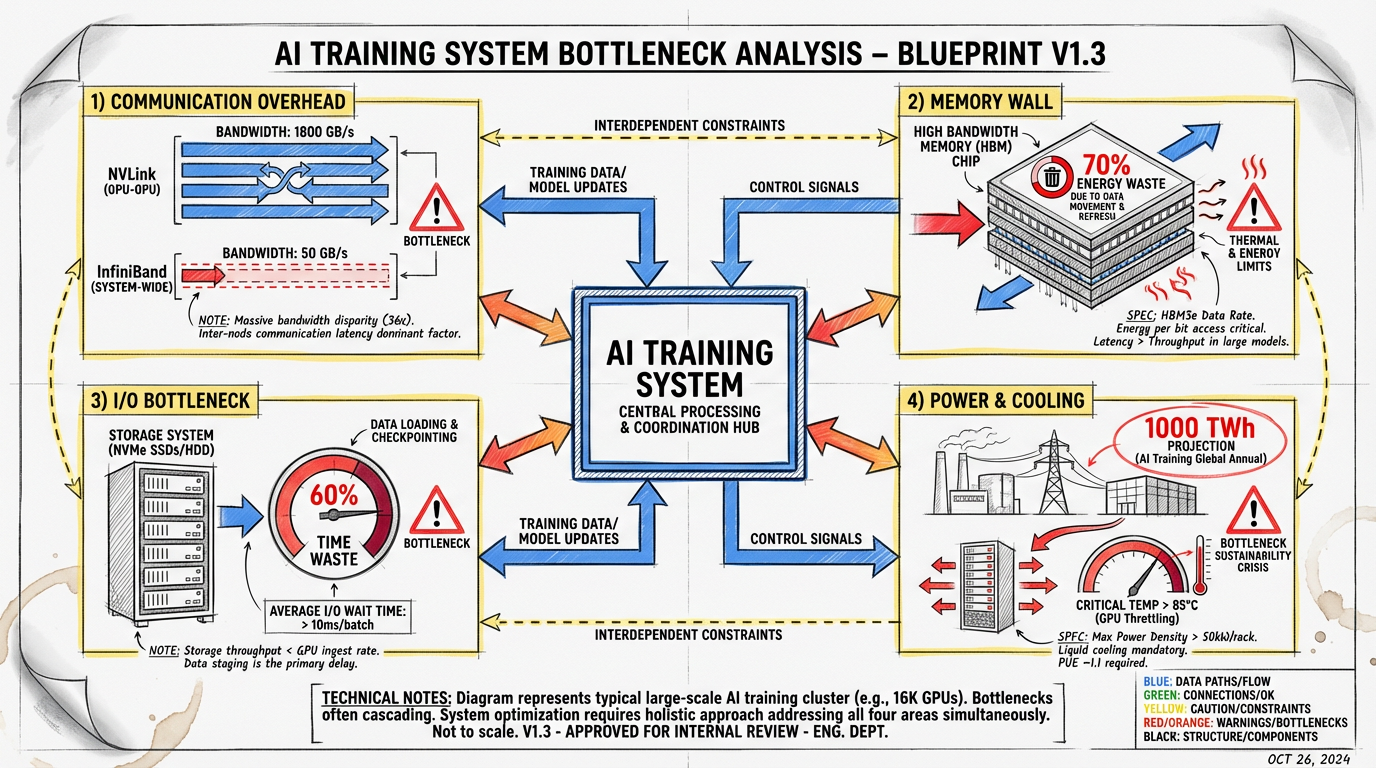

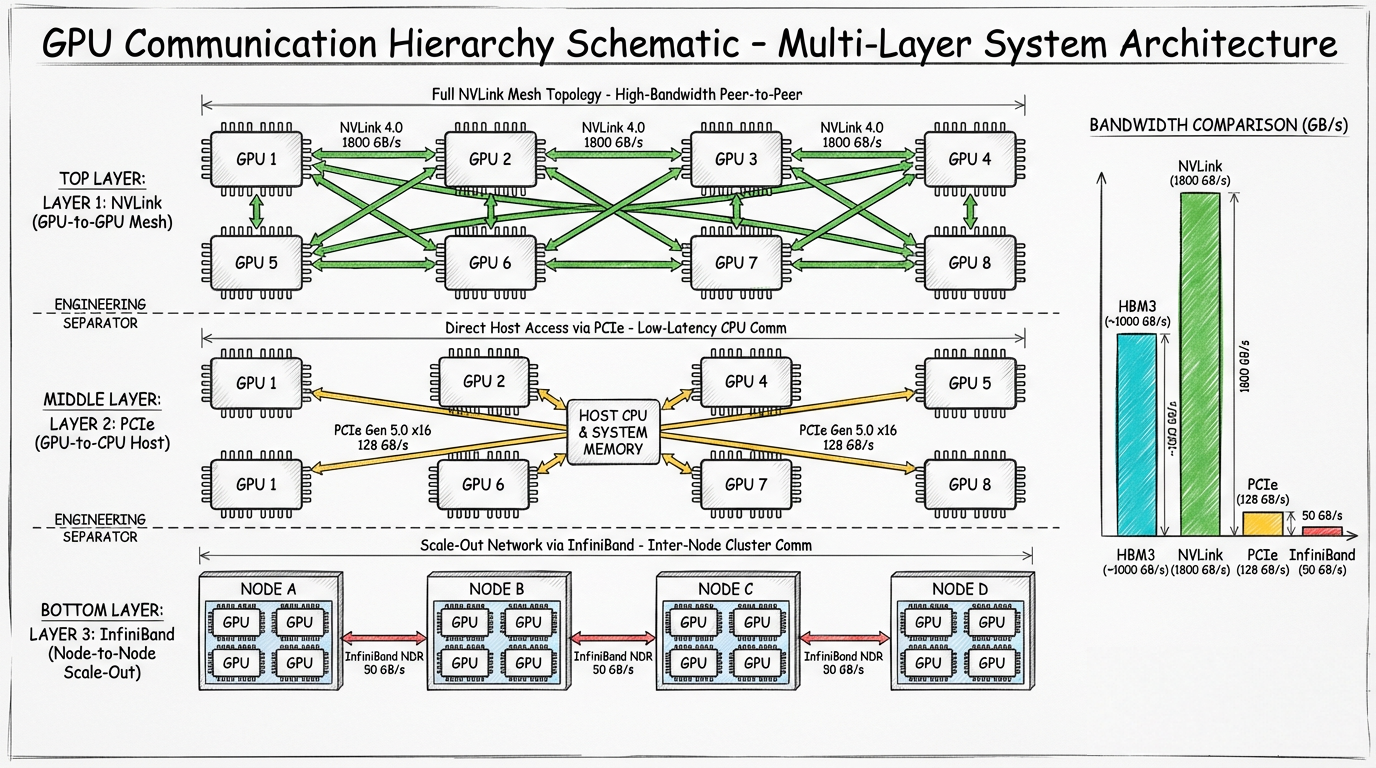

Pencarian skala tanpa henti ini telah mendorong infrastruktur yang mendasari menuju titik pecah. Melatih model triliun parameter bukan sekadar menambahkan lebih banyak GPU; ini adalah tantangan rekayasa yang kompleks penuh dengan kemacetan fisik dan sistemik. Tujuan utamanya adalah menjaga setiap prosesor mahal dimanfaatkan sepenuhnya, tapi sejumlah masalah menghadang.

Pabrik AI modern adalah pusat data besar yang berisi ribuan GPU yang saling terhubung. Sumber: NVIDIA

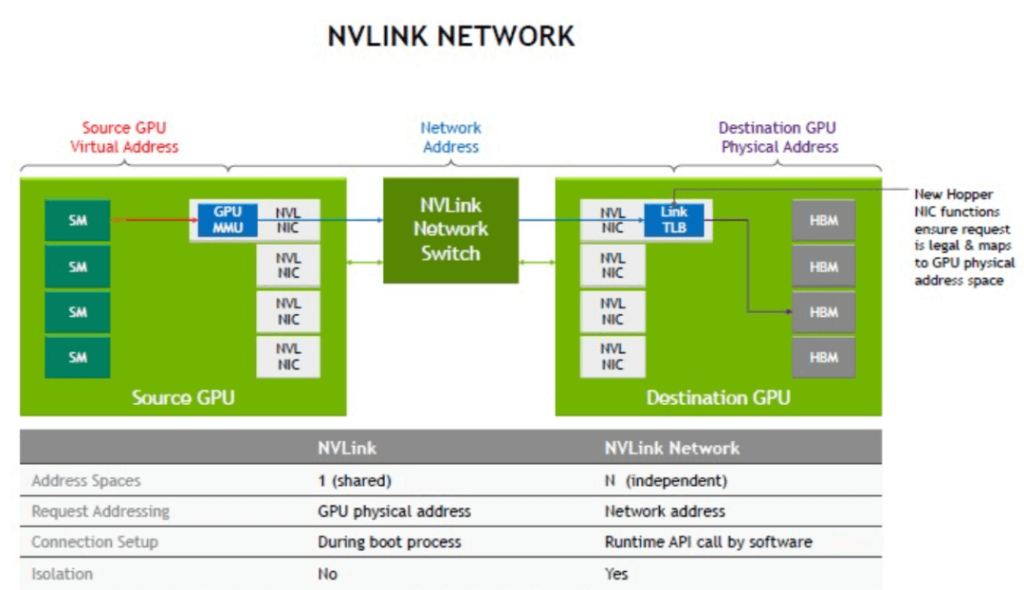

Dalam pelatihan terdistribusi, model tersebar di ribuan GPU, masing-masing menangani satu potongan teka-teki. Langkah paling penting dan memakan waktu adalah sinkronisasi gradien, di mana semua GPU harus mengomunikasikan hasilnya untuk sepakat pada pembaruan bobot model berikutnya. Ini menciptakan hambatan komunikasi yang masif.

Diagram teknologi NVLink NVIDIA, yang menyediakan komunikasi langsung berkecepatan tinggi antara GPU dalam server. Sumber: NVIDIA

Skema yang menunjukkan kemacetan komunikasi dalam penyiapan pelatihan terdistribusi, tempat GPU berkomunikasi satu sama lain dan dengan struktur jaringan.

Model AI Modern adalah pemakai memori yang rakus. Parameter, status pengoptimal, dan aktivasi perantara untuk model triliun parameter dapat memerlukan terabyte penyimpanan, jauh melebihi memori yang tersedia dalam satu GPU (biasanya 80-120 GB). Ini menimbulkan masalah "dinding memori".

Data harus selalu diacak antara memori bandwidth tinggi (HBM) GPU dan RAM sistem yang lebih lambat atau bahkan penyimpanan jaringan. Gerakan data ini tidak hanya lambat tetapi juga sangat padat energi. Menurut NVIDIA, hingga 70% energi dalam beban kerja GPU biasa dikonsumsi hanya untuk memindahkan data [8].

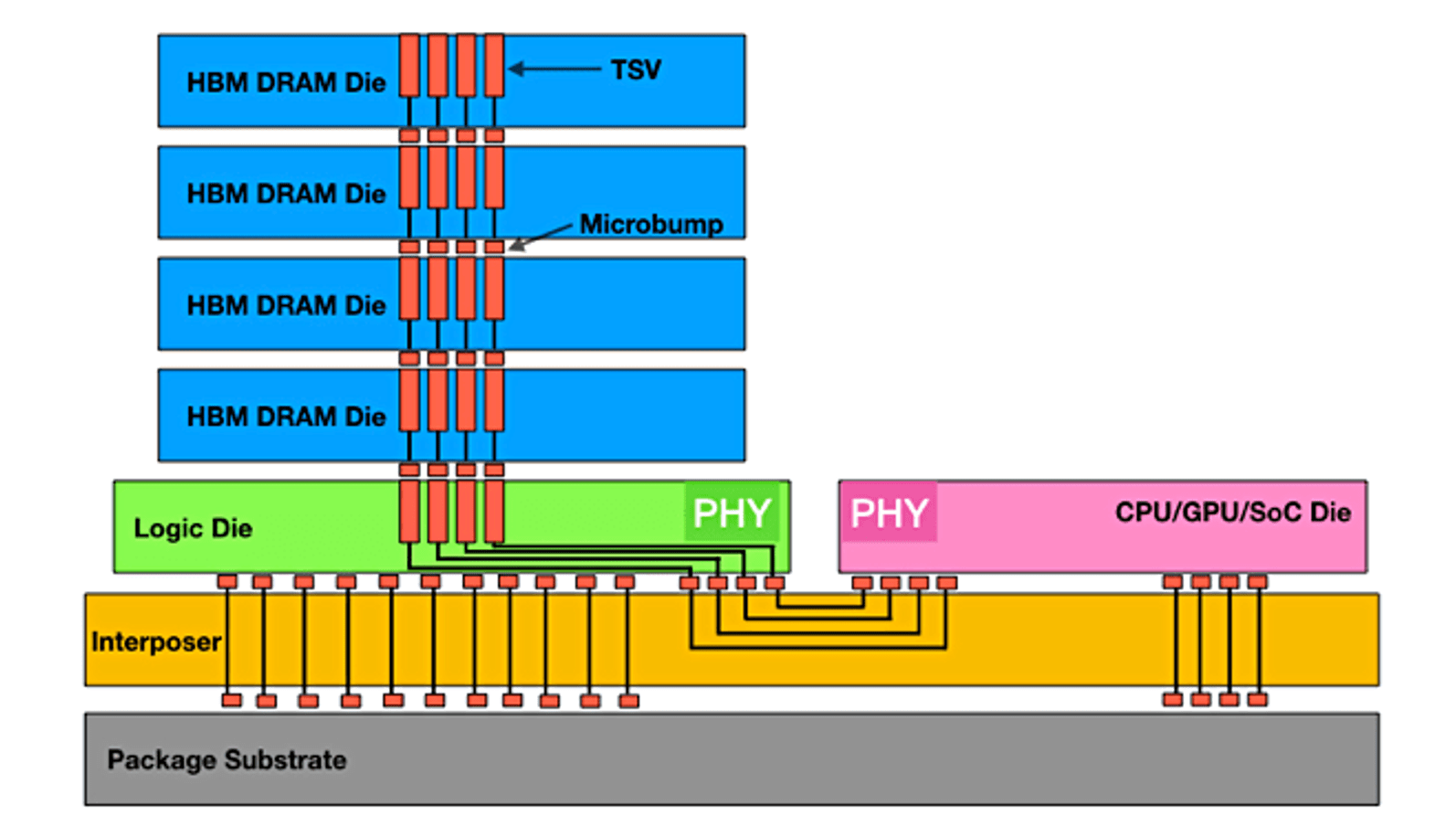

Memori Bandwidth Tinggi (HBM) menumpuk memori secara vertikal untuk menyediakan bandwidth masif yang dibutuhkan oleh GPU modern, tetapi masih merupakan sumber daya terbatas dan mahal. Sumber: Semiconductor Engineering

Bahkan sebelum dapat memulai kalkulasi, GPU memerlukan data. Dalam banyak skenario pelatihan skala besar, proses memuat data pelatihan dari penyimpanan ke GPU dapat menjadi kemacetan besar. Sistem file paralel performa tinggi diperlukan untuk mengirimkan data dengan kecepatan terabyte per detik untuk menjaga asupan puluhan ribu GPU. Jika jalur data tidak dioptimalkan dengan sempurna, GPU dapat menganggur, membuang-buang jutaan dolar untuk potensi komputasi. Dalam beberapa kasus, memuat data dapat menghabiskan lebih dari 60% dari total waktu pelatihan, secara efektif mengurangi setengah dari efisiensi seluruh kluster [9].

Energi yang diperlukan untuk mendukung pabrik AI ini sangat besar. Satu proses pelatihan skala besar dapat menghabiskan listrik layaknya kota kecil. International Energy Agency memperkirakan bahwa penggunaan listrik pusat data dapat meningkat dua kali lipat hingga 1.000 terawatt-jam pada 2026, yang sebagian besarnya digerakkan oleh AI [10]. Konsumsi daya yang luar biasa ini menghasilkan panas yang sangat besar, menciptakan tantangan paralel dalam pendinginan. Pendinginan udara tradisional menjadi tidak memadai, sehingga mendorong industri menuju solusi yang lebih eksotis seperti cairan dan pendinginan celup untuk mengelola densitas termal yang ekstrem dari perangkat keras AI modern.

Tumpukan padat server GPU menghasilkan panas yang besar, sehingga pendinginan menjadi tantangan infrastruktur yang sangat penting. Sumber: AMAX

Industri ini menangani kendala ini dengan pendekatan dari banyak sudut, berinovasi di seluruh perangkat keras, perangkat lunak, dan arsitektur sistem. Masa depan infrastruktur AI bukan hanya tentang chip yang lebih kuat, tetapi tentang sistem holistik yang dirancang bersama, di mana setiap komponen dioptimalkan untuk efisiensi dan skala.

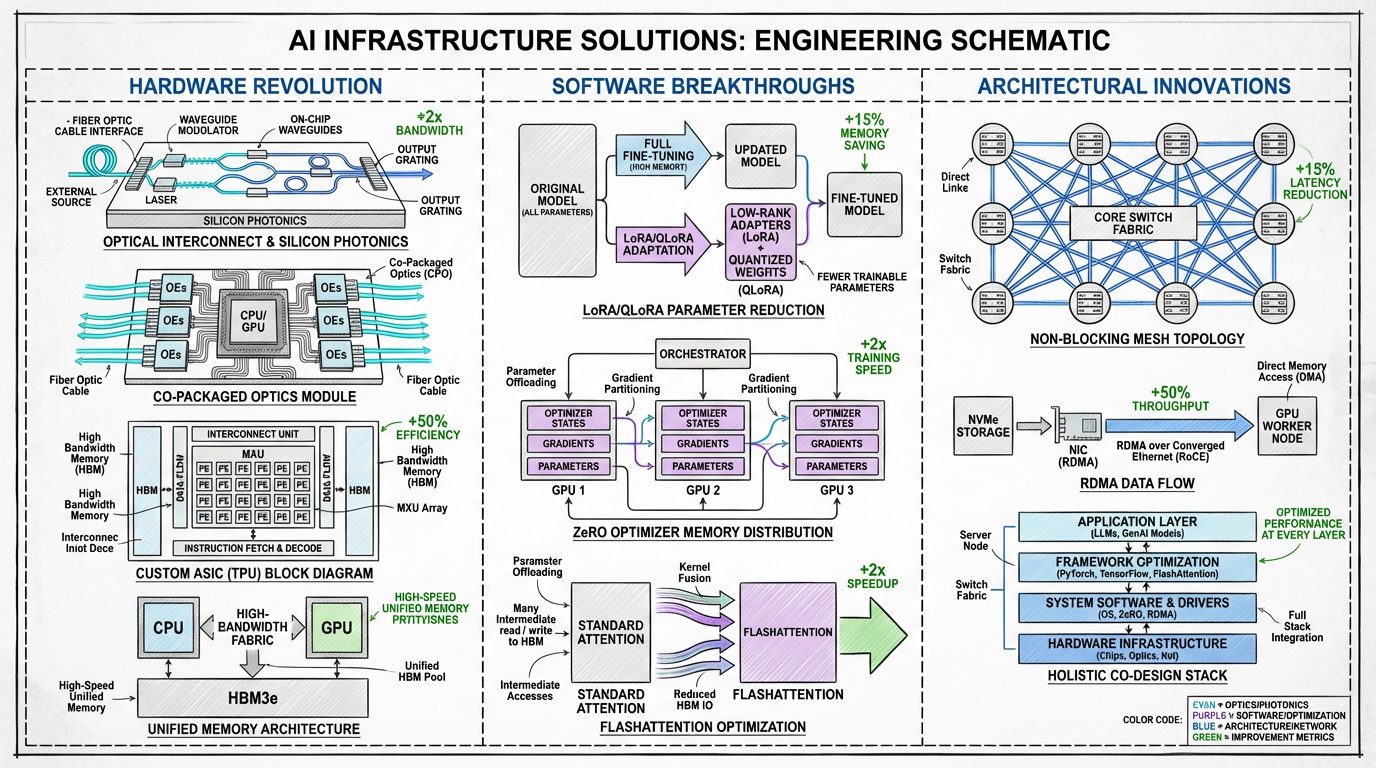

Skema solusi yang diusulkan untuk mengatasi kendala infrastruktur.

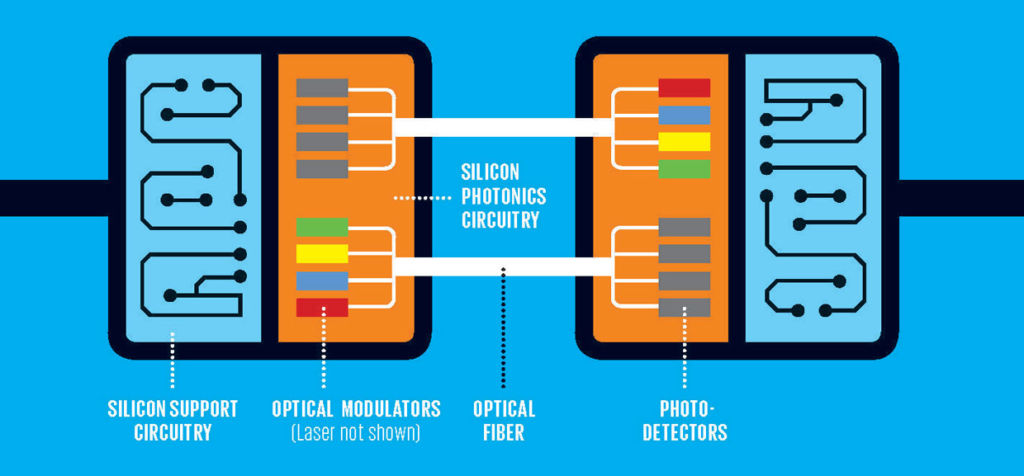

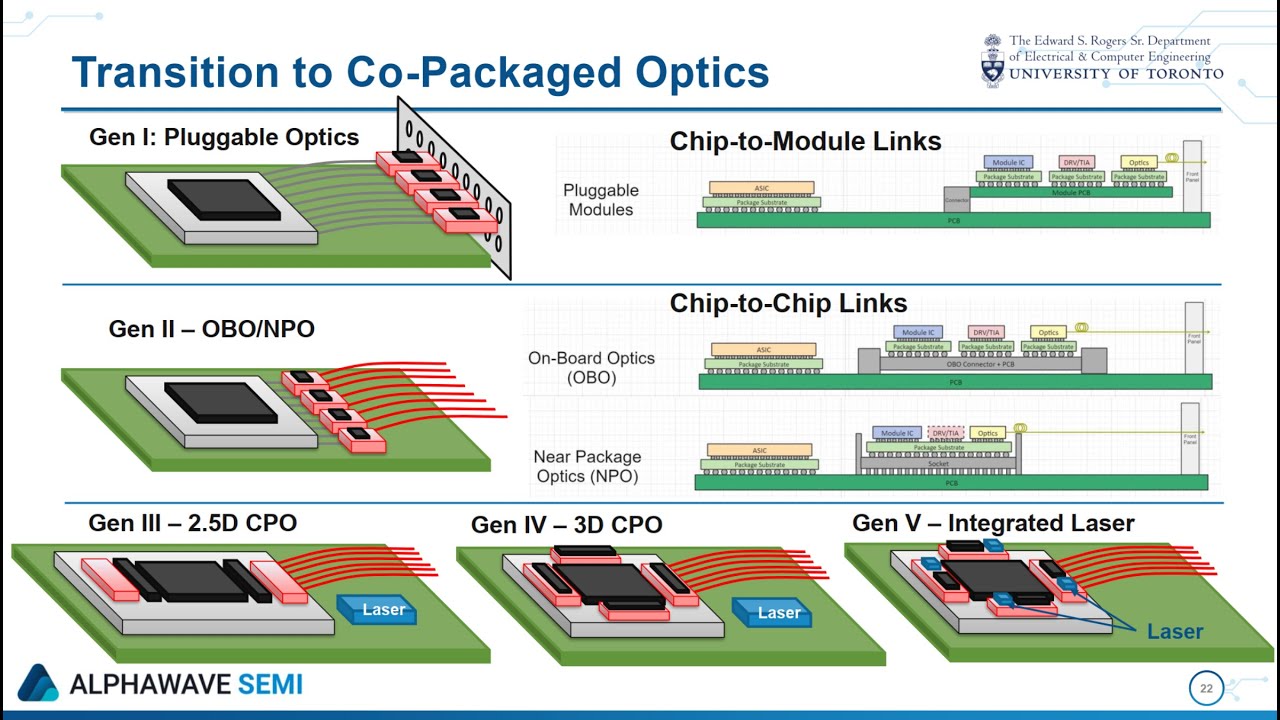

Interkoneksi Optik: Pergeseran paling jelas terlihat adalah perpindahan dari interkoneksi listrik (tembaga) ke optik (berbasis cahaya). Fotonik silikon menjanjikan transmisi data pada kecepatan terabit per detik dengan latensi dan konsumsi daya yang sangat rendah. Optik yang dipaketkan bersama, yang mengintegrasikan I/O optik langsung ke paket prosesor, akan meniadakan kebutuhan akan koneksi listrik yang lambat dan menghabiskan daya, secara langsung mengatasi kendala komunikasi dan energi [11].

Fotonik silikon menggunakan cahaya untuk transmisi data, menawarkan jalan menuju bandwidth yang jauh lebih tinggi dan konsumsi daya yang lebih rendah dibandingkan dengan kawat tembaga tradisional. Sumber: FindLight

Optik yang dipaketkan bersama (CPO) mengintegrasikan transceiver optik langsung dengan chip prosesor, meminimalkan jarak perjalanan data dan memaksimalkan efisiensi. Sumber: Anritsu

Akselerator Generasi Berikutnya: Walaupun GPU tetap dominan, lanskapnya menjadi beragam. ASIC (Application Specific Integrated Circuit), seperti TPU dari Google dan MTIA dari Meta dirancang untuk beban kerja AI spesifik, yang menawarkan performa dan efisiensi yang lebih unggul untuk tugas targetnya. Tren menuju akselerator khusus domain ini akan memungkinkan infrastruktur yang lebih dioptimalkan melampaui GPU satu ukuran untuk semua.

Arsitektur Memori Terpadu: Untuk menghancurkan dinding memori, berbagai perusahaan mengembangkan chipset yang sangat terintegrasi. Grace Hopper Superchip dari NVIDIA, misalnya, menggabungkan CPU dan GPU dalam satu modul dengan interkoneksi koheren berkecepatan tinggi. Ini memungkinkan kedua prosesor berbagi satu kumpulan memori, yang secara drastis mengurangi gerakan data yang mahal antara domain memori CPU dan GPU.

Penyesuaian Efisien Parameter (PEFT): Tidak setiap tugas memerlukan pelatihan ulang model multi-miliar dolar dari awal. Berbagai teknik, seperti LoRA (Low Rank Adaptation) dan QLoRA memungkinkan penyesuaian efisien hanya dengan memperbarui bagian kecil parameter model [12]. Ini secara dramatis mengurangi kebutuhan komputasional dan memori, membuat adaptasi model dapat diakses oleh berbagai pengguna dan organisasi yang lebih luas.

Pengoptimal dan Algoritma Modern: Inovasi perangkat lunak memainkan peran penting dalam meningkatkan efisiensi. ZeRO (Zero Redundancy Optimizer) dari Microsoft mempartisi keadaan model di seluruh GPU yang tersedia, memungkinkan pelatihan model masif dengan jauh lebih sedikit memori per perangkat [13]. Algoritma seperti FlashAttention merekayasa ulang mekanisme perhatian untuk mengurangi pembacaan/penulisan memori, memberikan peningkatan kecepatan yang signifikan dan berkurangnya jejak memori.

Superkomputer AI yang dibangun dengan tujuan tertentu mengintegrasikan solusi perangkat keras dan perangkat lunak ini menjadi satu kesatuan yang kohesif. Tren utama di area ini adalah pengembangan arsitektur supernode, yang bertujuan menciptakan unit komputasi yang lebih besar, lebih canggih, dan lebih efisien. Arsitektur ini mempertimbangkan kembali rak server tradisional untuk mengoptimalkan beban kerja spesifik AI.

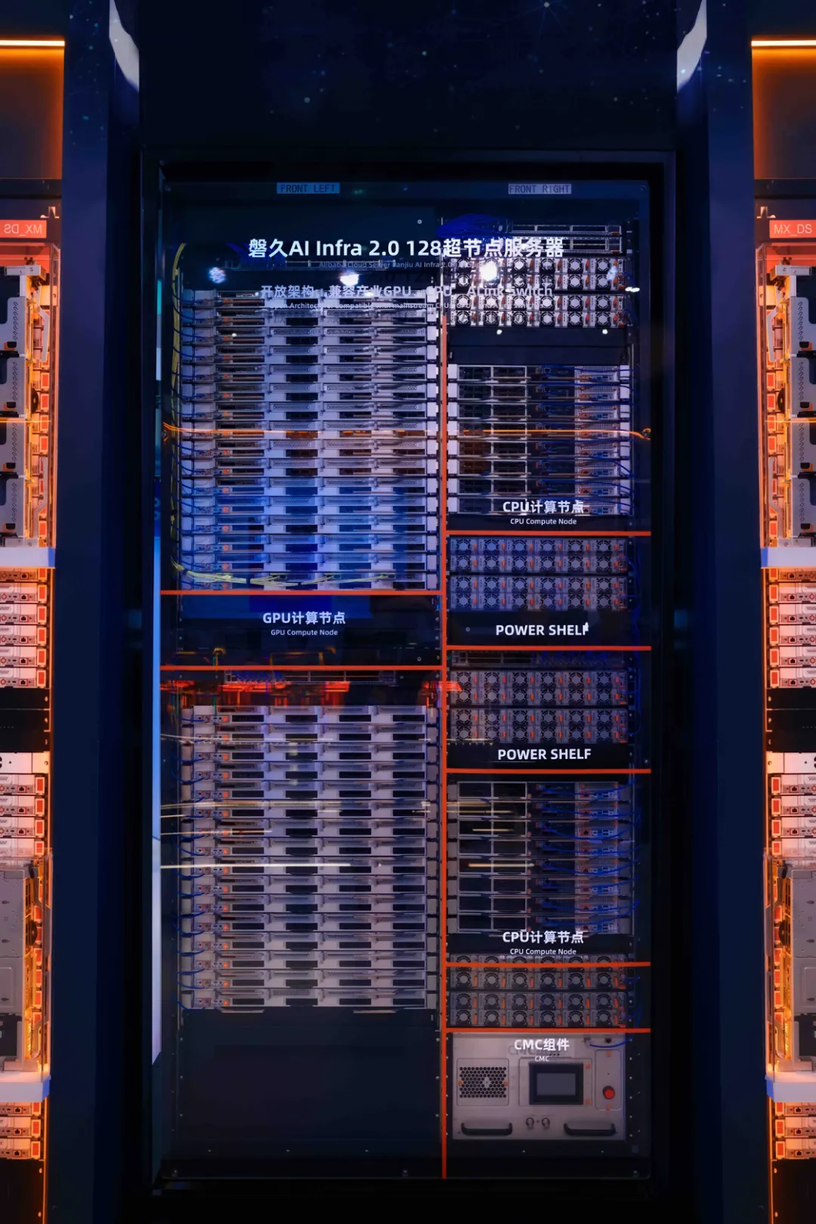

Satu contoh terkemuka adalah platform Lingjun Alibaba Cloud, yang memanfaatkan desain supernode Panjiu AL128. Arsitektur ini merepresentasikan pergeseran menuju sistem yang lebih modular dan terpisah. Fitur utama meliputi:

Arsitektur supernode Panjiu AL128, yang memiliki desain interkoneksi ortogonal dan modul terpisah untuk CPU, GPU, dan daya. Sumber: Alibaba Cloud

Walaupun terintegrasi erat, sistem densitas tinggi menawarkan penguatan performa yang signifikan (Alibaba mengklaim peningkatan 50% dalam performa inferensi untuk daya komputasi yang sama), sistem ini juga memiliki berbagai tantangan. Kelebihannya mencakup efisiensi yang lebih tinggi, latensi komunikasi yang lebih rendah, dan skalabilitas yang lebih besar di dalam supernode. Namun, kekurangannya termasuk meningkatnya kompleksitas, ketergantungan pada perangkat keras dan interkoneksi kustom (seperti UALink), serta kebutuhan akan pendinginan cairan dan infrastruktur daya yang canggih, yang dapat meningkatkan modal dan biaya operasional.

Inovasi arsitektur ini, dikombinasikan dengan teknik lainnya, akan menciptakan blueprint baru bagi pabrik AI:

Untuk mendalami teknis lebih jauh tentang arsitektur Panjiu AL128, lihat analisis terperinci ini dan video gambaran umum dari Alibaba Cloud di sini and di sini.

Era pertama revolusi AI ditentukan oleh penskalaan brute force–model yang lebih besar, data lebih banyak, komputasi lebih banyak. Walaupun skala selalu penting, era selanjutnya akan ditentukan oleh efisiensi dan finesse. Masa Depan AI bukan hanya tentang membangun model yang lebih besar, tetapi juga tentang membangun infrastruktur yang lebih cerdas, lebih berkelanjutan, dan lebih dapat diakses untuk melatih dan menjalankannya.

Perjalanan dari penggunaan pertama GPU AlexNet menuju pabrik AI optik, yang dirancang bersama di masa depan merupakan pembuktian kecepatan inovasi tanpa henti. Mengatasi hambatan komunikasi, memori, dan daya adalah tantangan besar saat ini, dan solusi yang dikembangkan hari ini akan menjadi landasan bagi gelombang kecerdasan buatan berikutnya.

[1] Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems 25.

[2] Vaswani, A., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems 30.

[3] Visual Capitalist. (2023). Charted: The Skyrocketing Cost of Training AI Models Over Time.

[4] Forbes. (2024). The Extreme Cost of Training AI Models.

[5] R&D World. (2024). AI’s great compression: 20 charts show vanishing gaps but still soaring costs.

[6] NVIDIA. (2024). NVIDIA GB200 NVL72.

[7] Zhai, E., et al. (2024). HPN: A Non-blocking, Dual-plane, Application-layer-agnostic High-performance Network for Large-scale AI Training. SIGCOMM 2024.

[8] Szasz, D. (2024). Understanding Bottlenecks in Multi-GPU AI Training. Medium.

[9] Alibaba Cloud. (2024). PAI-Lingjun Intelligent Computing Service Features.

[10] Forbes. (2025). Why Optical Infrastructure Is Becoming Core To The Future Of AI.

[11] Yole Group. (2023). Co-Packaged Optics for Datacenters 2023.

[12] Dettmers, T., et al. (2023). QLoRA: Efficient Finetuning of Quantized LLMs. Advances in Neural Information Processing Systems 36.

[13] Microsoft Research. (2020). ZeRO & DeepSpeed: New system optimizations enable training models with over 100 billion parameters.

[14] Alibaba Cloud. (2025). In-depth Analysis of Alibaba Cloud Panjiu AL128 Supernode AI Servers and Their Interconnect Architecture. Alibaba Cloud Blog.

[15] Alibaba Cloud. (2025). Panjiu AL128 Supernode AI Server Video Overview. YouTube.

Artikel ini adalah terjemahan dari versi bahasa Inggris asli. Untuk konten sumbernya, kunjungi: https://www.alibabacloud.com/blog/from-brute-force-to-finesse-the-evolution-and-future-of-ai-training-infrastructure_602718

Từ sức mạnh thô mộc đến sự tinh tế: Sự phát triển và tương lai của cơ sở hạ tầng đào tạo AI

127 posts | 4 followers

FollowRegional Content Hub - July 14, 2025

Alibaba Cloud Community - December 13, 2023

Regional Content Hub - May 13, 2025

Regional Content Hub - May 20, 2024

Alibaba Cloud Community - December 14, 2023

Alibaba Cloud Community - December 12, 2023

127 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub