작성: Farruh Kushnazarov

세계는 인공 지능이 학문적 전문 분야에서 산업을 재구성하는 변혁적인 힘으로 진화하는 모습을 경외심을 가지고 지켜보았습니다. 이 혁명의 중심에는 언어, 추론 및 창의성에서 놀라운 능력을 보여준 거대한 신경망과 같은 기초 모델이 있습니다. 그러나 그 성공에 대한 이야기는 이러한 모델을 구동하는 인프라의 이야기와 뗄 수 없는 관계가 있습니다. 이것은 기하급수적인 성장의 이야기이자, 물리적 한계에 직면하는 이야기, 그리고 차세대 지능을 위한 계산 기반을 구축하는 데 필요한 끊임없는 혁신에 대한 이야기입니다.

이 글은 AI 훈련의 극적인 역사를 탐구하고, 발전을 저해할 수 있는 중요한 병목 현상을 분석하고, 이러한 거대한 과제를 극복하기 위해 설계되고 있는 인프라의 미래를 살펴봅니다.

오늘날의 조 단위 매개변수 모델에 이르는 여정은 직선이 아니라, 새로운 수준의 계산 능력에 의해 개념적 돌파구가 열린 일련의 점진적인 평형 과정이었습니다. 수십 년 동안, 신경망의 약속은 제한된 데이터 및 처리 기능으로 인해 제한을 받아 왔습니다. 이 모든 것은 2012년에 바뀌었습니다.

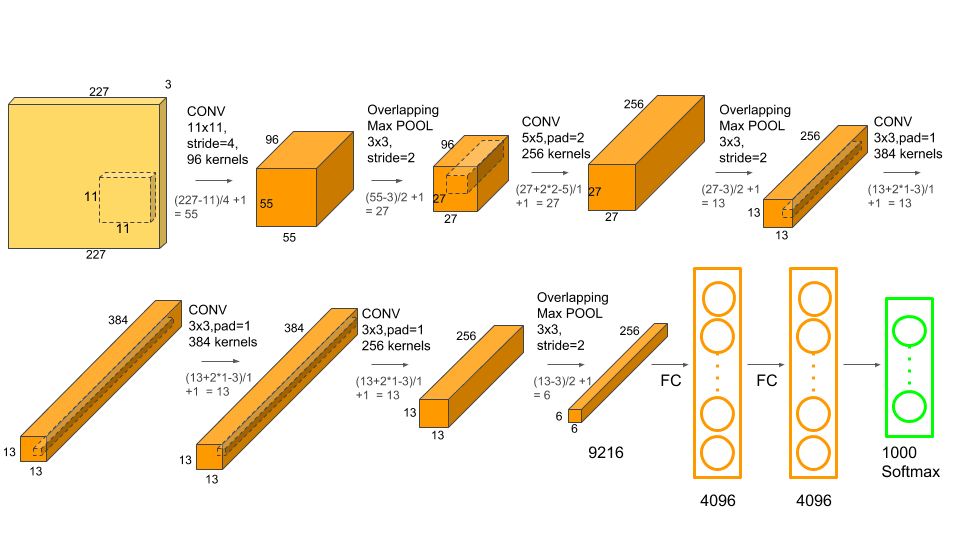

2012 ImageNet Large Scale Visual Recognition Challenge(ILSVRC)는 현대 AI 시대의 "빅뱅"으로 널리 알려져 있습니다. Alex Krizhevsky, Ilya Sutskever, Geoffrey Hinton이 개발한 AlexNet이라는 심층 합성곱 신경망(CNN)이 놀라운 승리를 거두었습니다[1]. 단순히 승리하는 데서 그치지 않고, 15.3%의 오류율로 기록을 경신했으며, 이는 그 다음으로 가장 뛰어난 항목의 26.2%와 비교하여 큰 도약을 이뤘습니다.

AlexNet의 성공은 단지 새로운 아키텍처 때문만이 아닙니다. 결정적으로, 이 모델은 그래픽 처리 장치(GPU)로 훈련된 최초의 모델 중 하나였습니다. 두 개의 NVIDIA GTX 580 GPU의 병렬 처리 능력을 활용하여, 연구원들은 이전에는 상상할 수 없었던 수준인 120만 개 이미지의 데이터 세트에서 6천만 개의 매개변수가 있는 모델을 훈련할 수 있었습니다. 이 순간은 충분한 데이터와 계산을 갖추면 딥 러닝이 실행 가능할뿐만 아니라 기존 방법보다 훨씬 우수하다는 것을 증명하며, AI 연구에서 캄브리아기와 같은 폭발을 일으켰습니다.

심층 합성곱 레이어와 GPU 처리를 결합하여 획기적인 성능을 달성한 AlexNet 아키텍처. 출처: Krizhevsky et al., 2012.

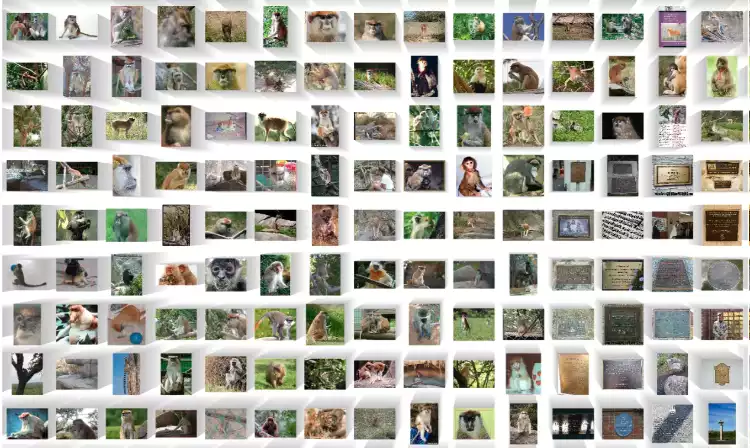

딥 러닝 혁명을 촉진시킨 ImageNet 데이터 세트의 라벨이 지정된 수백만 개 이미지의 작은 샘플. 출처: ImageNet

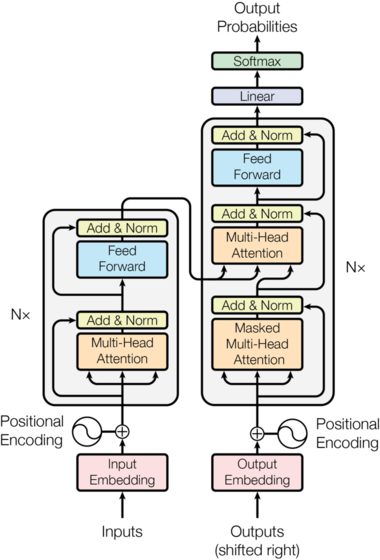

5년 후, 또 하나의 큰 변화가 일어났습니다. 2017년, Google의 논문 'Attention Is All You Need'에서 트랜스포머 아키텍처를 소개했습니다[2]. 이 새로운 설계는 그동안 이 분야를 지배해 온 순환 구조와 합성곱 구조를 완전히 없앴습니다. 대신, 이 모델은 '셀프 어텐션'이라는 메커니즘을 활용하여, 모델이 입력 시퀀스 내의 여러 단어들의 중요도를 동시에 측정할 수 있도록 했습니다.

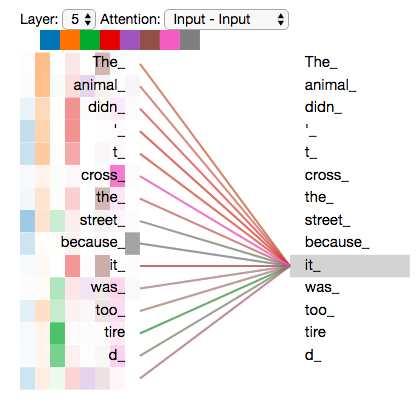

핵심 혁신은 병렬 처리였습니다. 데이터를 순차적으로 처리하는 순환 신경망(RNN)과 달리, 트랜스포머는 입력의 모든 부분을 한 번에 처리할 수 있었습니다. 이러한 아키텍처 변화는 GPU의 대규모 병렬 처리 특성과 완벽하게 일치하여, 전례 없는 속도로 훨씬 더 크고 복잡한 모델을 훈련시킬 수 있는 능력을 열어주었습니다. 트랜스포머는 GPT 시리즈를 포함하여 이후 거의 모든 대규모 언어 모델(LLM)의 기본 설계(청사진)가 되었습니다.

"Attention Is All You Need" 논문에 소개된 원래 트랜스포머 아키텍처. 출처: Vaswani et al., 2017.

모델이 문장에서 여러 단어들의 중요도를 평가할 수 있도록 하는 셀프 어텐션 메커니즘의 시각화. 출처: Jay Alammar

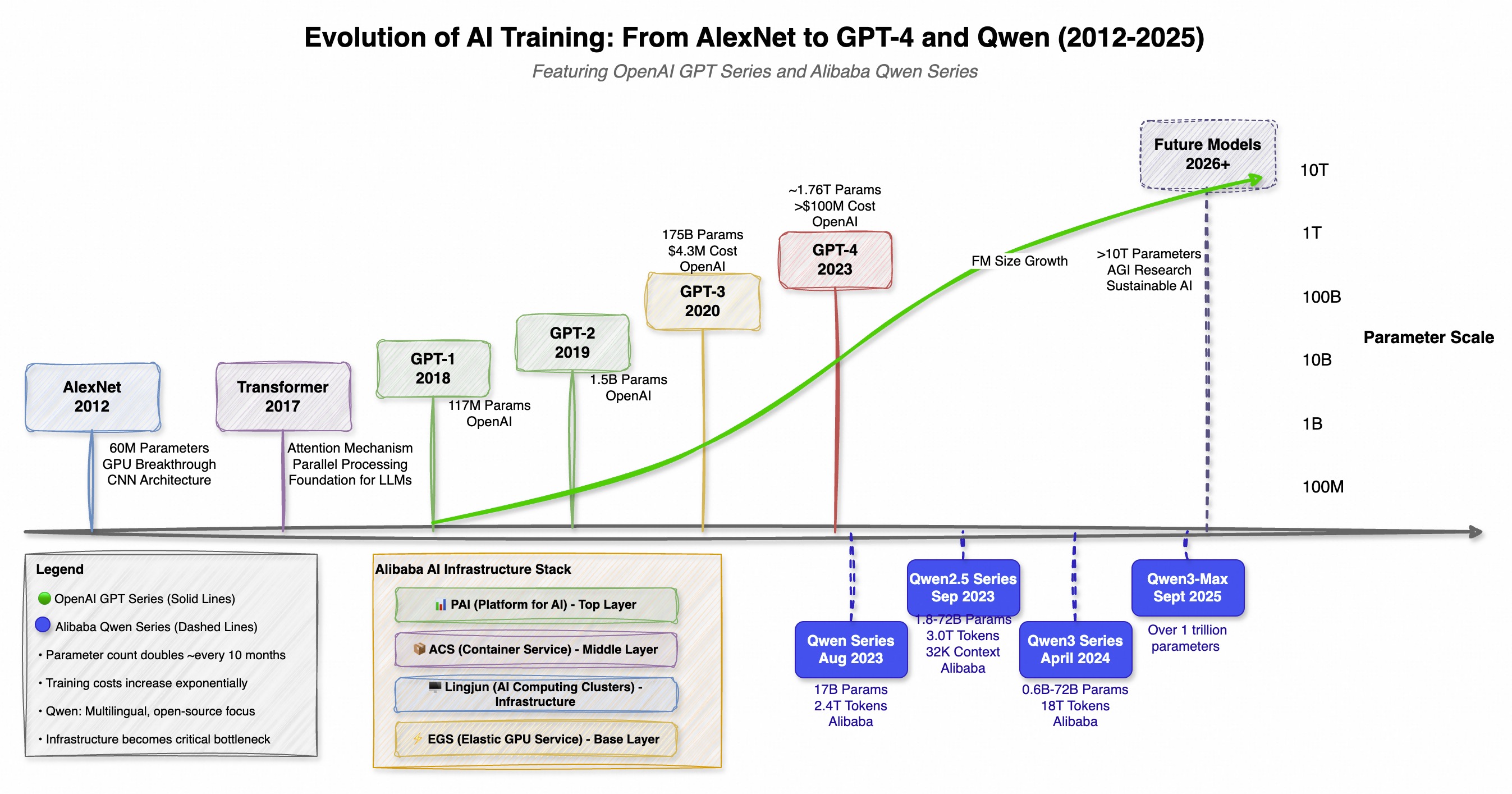

트랜스포머의 도입은 전 세계적인 계산 경쟁을 일으켰습니다. AI 모델의 규모, 비용 및 복잡성은 기하급수적으로 증가하기 시작했습니다. 이러한 추세는 한 회사뿐만 아니라 전 세계의 병렬 개발, 특히 서쪽에서는 OpenAI의 GPT 시리즈, 동쪽에서는 Alibaba의Qwen (通义千) 시리즈에서 두드러지게 나타납니다. 두 시리즈 모두 규모의 한계를 뛰어넘었지만, 철학은 서로 다릅니다. GPT는 혁신적인 기능에 중점을 두었고, Qwen은 강력한 오픈 소스와 다국어 접근 방식을 강조했습니다.

이러한 이중 발전은 더 강력하고 효율적인 AI를 향한 전 세계적인 경쟁을 보여주며, 새로운 모델이 출시될 때마다 다음 모델의 기준을 한층 높이고 있습니다.

| 모델 | 출시일 | 매개변수 | 핵심 혁신 / 초점 |

|---|---|---|---|

| GPT-1 | 2018 | 117 100만 | 비지도 사전 훈련(OpenAI) |

| GPT-2 | 2019 | 1.5 10억 | 제로샷 작업 수행(OpenAI) |

| GPT-3 | 2020 | 175 10억 | 소수 샘플, 문맥 내 학습(OpenAI) |

| Qwen-7B | 2023년 8월 | 70억 | 강력한 오픈 소스 다국어 기반(Alibaba) |

| GPT-4 | 2023년 9월 | ~ 1.76조(MoE) | 고급 추론, 멀티모달리티(OpenAI) |

| Qwen-72B | 2023년 11월 | 50~720억 | 32K 컨텍스트 길이, 오픈 소스(Alibaba) |

| Qwen2.5 | 2024년 9월 | 최대 720억 | 18T 토큰으로 훈련됨, 향상된 코딩/수학 능력(Alibaba) |

| Qwen3-Max | 2025년 9월 | ~1조 | 현재까지 Qwen의 가장 크고 가장 유능한 모델(Alibaba) |

컴퓨팅 수요가 5~6개월마다 두 배로 늘어나는 이 폭발적인 성장은, 최첨단 AI 개발을 행성 규모의 슈퍼컴퓨터를 구축하고 운영할 자본을 가진 소수의 하이퍼스케일 기업들만이 접근할 수 있는 영역으로 밀어넣었습니다[5].

OpenAI의 GPT 시리즈와 Alibaba의 Qwen 시리즈의 병렬 발전을 보여주는 타임라인으로, 기초 모델 개발의 전 세계적인 경쟁을 강조합니다.

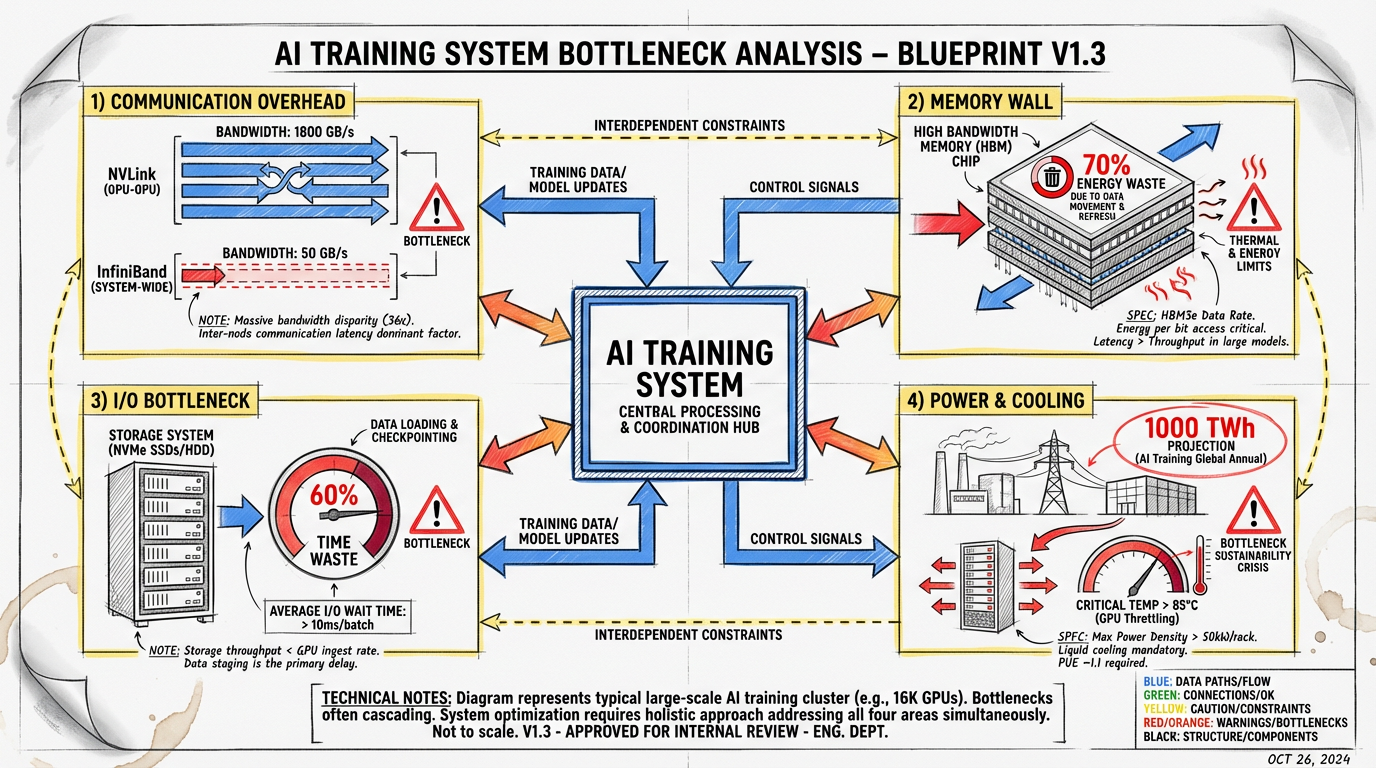

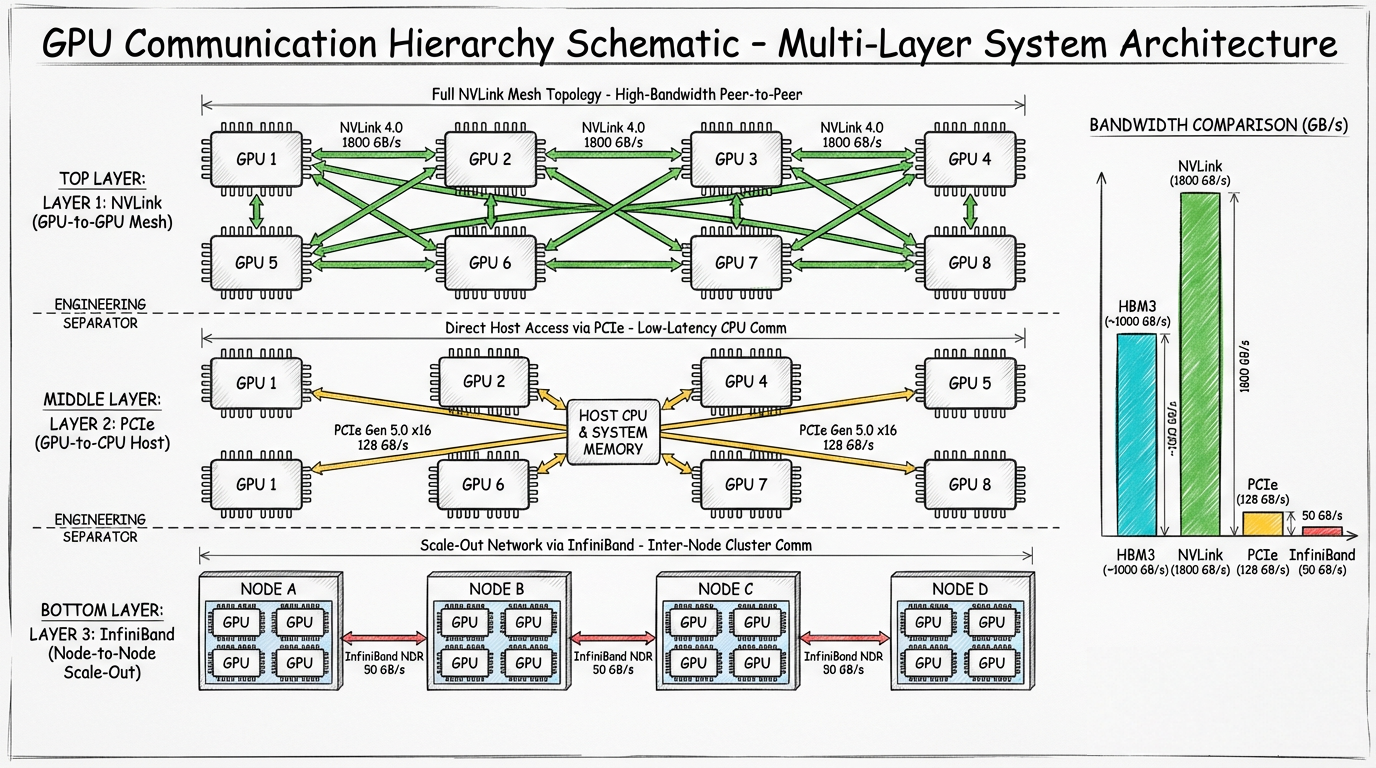

규모 확장에 대한 이러한 끊임없는 추구는 기본 인프라를 한계점까지 밀어붙였습니다. 조 단위 매개변수 모델을 훈련시키는 것은 단순히 더 많은 GPU를 추가하는 문제가 아니라, 물리적 및 체계적인 병목 현상으로 가득 찬 복잡한 엔지니어링 과제입니다. 주요 목표는 모든 값비싼 프로세서를 완전히 활용하는 것이지만, 이를 가로막는 수많은 문제들이 있습니다.

현대 AI 공장은 수천 개의 상호 연결된 GPU를 포함하는 방대한 데이터 센터입니다. 출처: NVIDIA

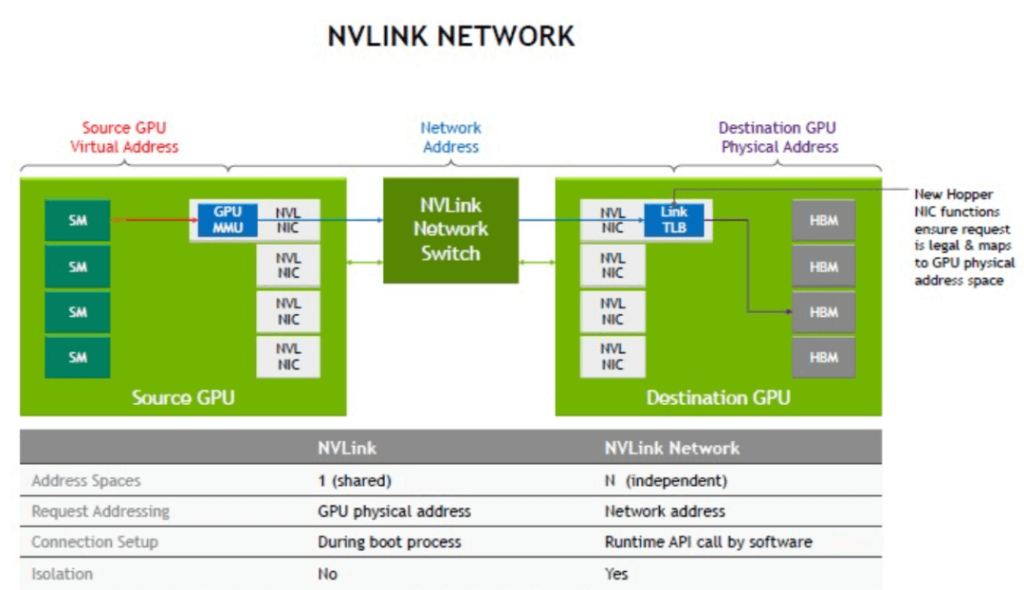

분산 훈련에서 모델은 수천 개의 GPU에 퍼져 있으며, 각 GPU는 퍼즐의 한 조각을 처리합니다. 가장 중요하고 시간이 많이 걸리는 단계는그래디언트 동기화로, 모든 GPU는 모델 가중치에 대한 다음 업데이트에 합의하기 위해 각자의 결과를 통신해야 합니다. 이는 대규모 통신 병목 현상을 만들어냅니다.

서버 내 GPU 간의 고속 직접 통신을 제공하는 NVIDIA의 NVLink 기술 다이어그램. 출처: NVIDIA

GPU가 서로와 통신하고 네트워크 패브릭과 통신하는 분산 훈련 환경에서 통신 병목 현상을 보여주는 도식.

현대 AI 모델은 메모리를 엄청나게 소비합니다. 조 단위 매개변수 모델의 매개변수, 옵티마이저 상태 및 중간 활성화는 테라바이트 단위의 스토리지를 요구하며, 이는 단일 GPU에서 사용 가능한 메모리(일반적으로 80~120GB)를 훨씬 초과합니다. 이것은 "메모리 장벽" 문제를 야기합니다.

데이터는 GPU의 고대역폭 메모리(HBM)와 더 느린 시스템 RAM, 심지어 네트워크 스토리지 사이에서 끊임없이 섞여 이동해야 합니다. 이러한 데이터 이동은 느릴 뿐만 아니라 매우 에너지 집약적입니다. NVIDIA에 따르면, 일반적인 GPU 워크로드에서 에너지의 최대 70%가 데이터를 이동시키는 데 소비됩니다[8].

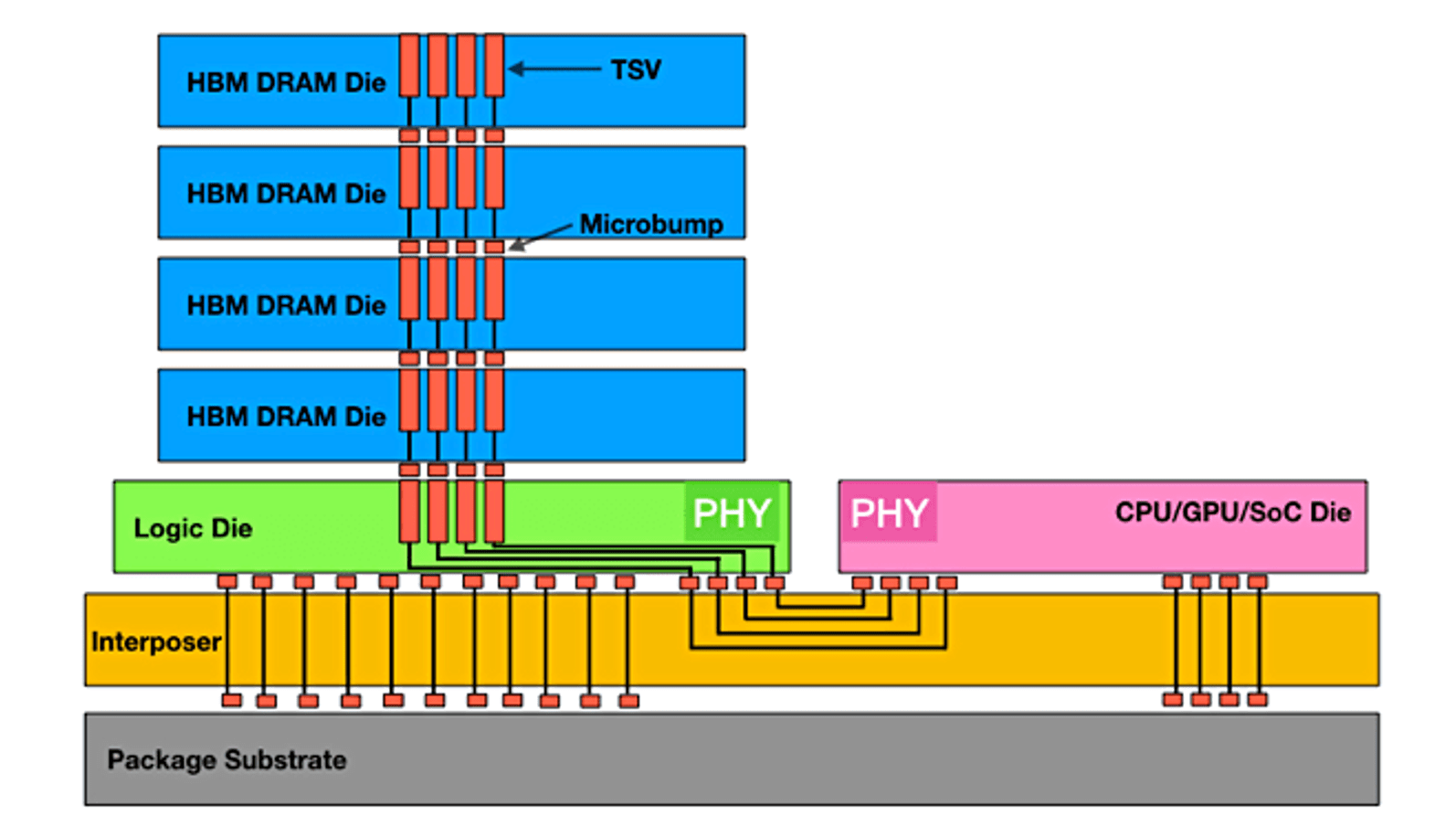

고대역폭 메모리(HBM)는 최신 GPU에서 요구하는 방대한 대역폭을 제공하기 위해 메모리 다이를 수직으로 쌓지만 여전히 유한하고 값비싼 리소스입니다. 출처: Semiconductor Engineering

GPU가 계산을 시작하기도 전에, 데이터가 필요합니다. 많은 대규모 훈련 시나리오에서, 훈련 데이터를 저장소에서 GPU로 로드하는 프로세스가 주요 병목 현상이 될 수 있습니다. 수만 개의 GPU에 데이터를 공급하기 위해서는 초당 테라바이트 단위로 데이터를 전달할 수 있는 고성능 병렬 파일 시스템이 필요합니다. 데이터 파이프라인이 완벽하게 최적화되지 않으면 GPU가 유휴 상태가 되어 수백만 달러에 해당하는 계산 잠재력이 낭비될 수 있습니다. 경우에 따라 데이터 로딩이 전체 훈련 시간의 60% 이상을 소비할 수 있으며, 이는 전체 클러스터의 효율성을 사실상 절반으로 줄입니다[9].

이러한 AI 공장에 전력을 공급하는 데 필요한 에너지의 양은 엄청납니다. 한 번의 대규모 훈련으로 작은 도시에 맞먹는 전기를 소비할 수 있습니다. 국제 에너지 기구는 상당 부분 AI로 인해 데이터 센터 전력 사용량이 2026년까지 두 배로 늘어나 1,000테라와트시에 달할 수 있다고 추정합니다[10]. 이러한 엄청난 전력 소비는 엄청난 양의 열을 발생시키며, 이로 인해 냉각과 관련된 또 다른 과제가 발생합니다. 전통적인 공기 냉각으로는 불충분해지고 있으며, 이로 인해 업계는 현대 AI 하드웨어의 극심한 열 밀도를 관리하기 위해 액체 냉각 및 침지 냉각과 같은 더 이색적인 솔루션으로 나아가고 있습니다

GPU 서버의 밀집된 랙은 엄청난 열을 발생시켜 냉각을 중요한 인프라 과제로 만듭니다. 출처: AMAX

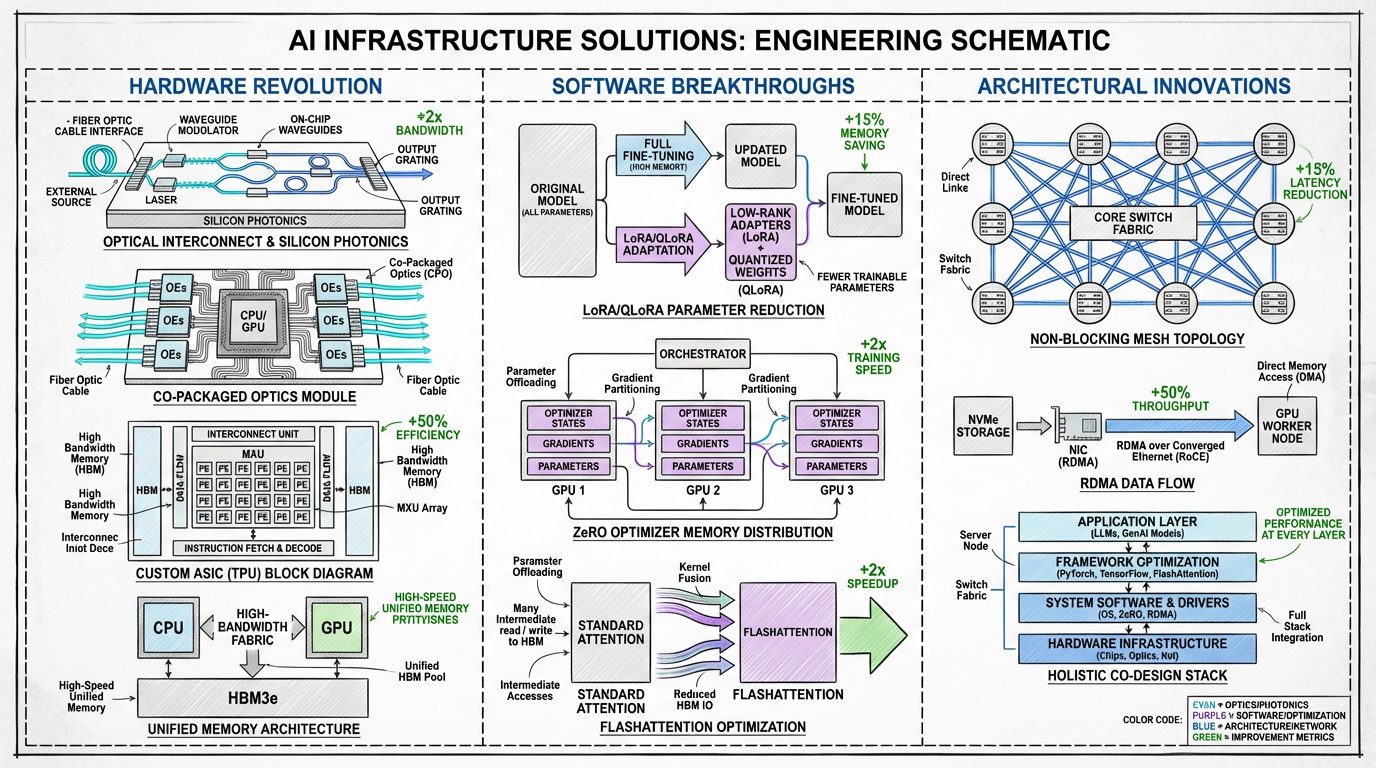

업계는 하드웨어, 소프트웨어, 시스템 아키텍처 전반에 걸쳐 혁신하는 다각적인 접근 방식을 통해 이러한 병목 현상을 해결하고 있습니다. AI 인프라의 미래는 단순히 더 강력한 칩에 관한 것이 아니라, 모든 구성 요소가 효율성과 규모를 위해 최적화된 총체적인, 공동 설계된 시스템에 관한 것입니다.

인프라 병목 현상을 극복하기 위해 제안된 솔루션의 도식.

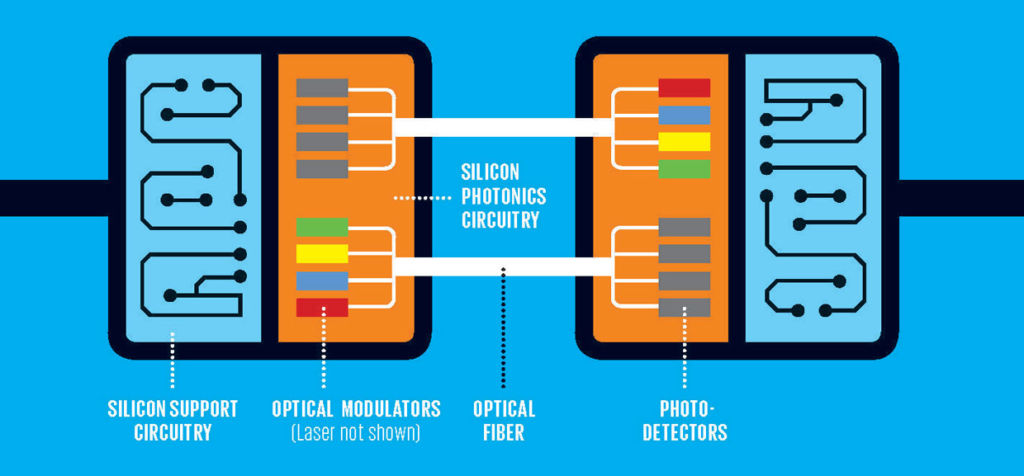

광학 상호 연결: 다가오는 가장 근본적인 변화는 전기(구리)에서 광학적(빛 기반) 상호 연결로의 이동입니다. 실리콘 포토닉스는 훨씬 낮은 지연 시간과 전력 소비로 초당 테라비트 단위의 속도의 데이터 전송을 가능하게 합니다. 광학 I/O를 프로세서 패키지에 직접 통합하는 공동 패키징 광학은 느리고 전력이 소모가 많은 전기 연결의 필요성을 없애, 통신 및 에너지 병목 현상을 직접적으로 해결할 것입니다[11].

실리콘 포토닉스는 빛을 사용하여 데이터를 전송하며, 전통적인 구리 배선에 비해 훨씬 높은 대역폭과 낮은 전력 소비를 향한 경로를 제공합니다. 출처: FindLight

! Copackaged_optics

공동 패키징 광학(CPO)은 광학 트랜시버를 프로세서 칩에 직접 통합하여 데이터 이동 거리를 최소화하고 효율성을 극대화합니다. 출처: Anritsu

차세대 가속기: GPU가 여전히 지배적이지만 환경은 다변화되고 있습니다. Google의 TPU 및 Meta의 MTIA와 같은 맞춤형 ASIC(주문형 집적 회로)는 특정 AI 워크로드를 위해 설계되어 대상 작업에 우수한 성능과 효율성을 제공합니다. 도메인별 가속기로 나아가는 이러한 추세는 획일적인 GPU를 넘어 더 최적화된 인프라를 가능하게 합니다.

통합 메모리 아키텍처: 메모리 장벽을 허물기 위해, 기업들은 긴밀하게 통합된 칩셋을 개발하고 있습니다. 예를 들어, NVIDIA의 Grace Hopper Superchip은 단일 모듈의 CPU와 GPU를 일관된 고속 상호 연결과 결합합니다. 이를 통해 두 프로세서 모두 단일 메모리 풀을 공유하여 CPU와 GPU 메모리 도메인 간의 높은 비용이 드는 데이터 이동을 크게 줄일 수 있습니다.

매개변수 효율적 미세 조정(PEFT): 모든 작업이 처음부터 수십억 달러의 모델을 처음부터 다시 훈련시키도록 요구하지는 않습니다. LoRA(Low-Rank Adaptation) 및 QLoRA와 같은 기술은 모델 매개변수의 아주 작은 일부만 업데이트하여 효율적인 미세 조정을 가능하게 합니다[12]. 이를 통해 컴퓨팅 및 메모리 요구 사항이 크게 줄어들어, 훨씬 더 광범위한 사용자와 조직이 모델 적응에 접근할 수 있습니다.

고급 옵티마이저 및 알고리즘: 소프트웨어 혁신은 효율성 향상에 중요한 역할을 하고 있습니다. Microsoft의 ZeRO(Zero Redundancy Optimizer)는 모델의 상태를 사용 가능한 GPU 간에 분할하여 장치당 훨씬 적은 메모리로 거대한 모델을 훈련할 수 있도록 합니다[13]. FlashAttention과 같은 알고리즘은 어텐션 메커니즘을 재설계하여 메모리 읽기/쓰기 횟수를 줄이며, 이는 속도 향상 및 메모리 공간 감소로 이어집니다.

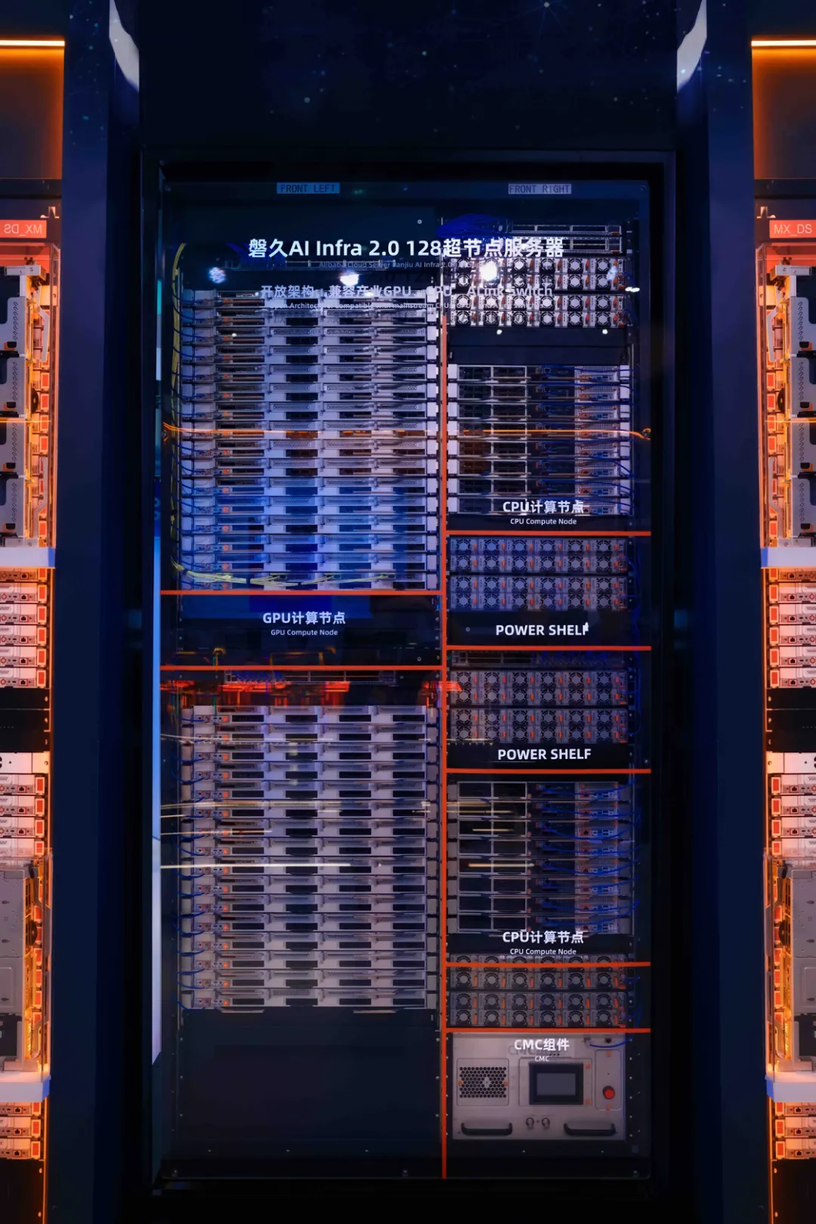

목적에 맞게 구축된 AI 슈퍼 컴퓨터는 이러한 하드웨어 및 소프트웨어 솔루션을 응집력 있게 전체적으로 통합하고 있습니다. 이 분야의 핵심 트렌드는 더 크고, 더 강력하며, 더 효율적인 컴퓨팅 단위를 만드는 것을 목표로 하는 슈퍼노드 아키텍처의 개발입니다 이러한 아키텍처는 기존 서버 랙을 재고하여 AI 관련 워크로드를 최적화합니다.

한 가지 대표적인 예시는 Panjiu AL128 슈퍼노드 설계를 활용하는 Alibaba Cloud의 Lingjun플랫폼입니다. 이 아키텍처는 더 모듈화되고 분리된 시스템으로의 전환을 나타냅니다. 주요 기능은 다음과 같습니다.

직교 상호 연결 설계와 CPU, GPU 및 전력을 위한 분리형 모듈을 특징으로 하는 Panjiu AL128 슈퍼노드 아키텍처. 출처: Alibaba Cloud

이러한 긴밀하게 통합된 고밀도 시스템은 상당한 성능 향상을 제공하지만(Alibaba는 동일한 컴퓨팅 성능에 대한 추론 성능이 50% 향상되었다고 주장함), 이는 과제도 제시합니다. 장점에는 더 높은 효율성, 더 낮은 통신 대기 시간 및 슈퍼노드 내에서의 더 뛰어난 확장성이 포함됩니다. 그러나 단점으로는 복잡성 증가, 맞춤형 하드웨어 및 상호 연결(예: UALink)에 대한 의존, 정교한 액체 냉각 및 전력 인프라에 대한 필요성으로 인해 자본 및 운영 비용이 증가할 수 있다는 점이 있습니다.

이러한 아키텍처 혁신은 다른 기술과 결합되어 AI 공장을 위한 새로운 청사진을 만들고 있습니다.

Panjiu AL128 아키텍처에 대한 보다 심층적인 기술 분석은 여기 및 여기에 있는 Alibaba Cloud의 자세한 분석 및 동영상 개요를 참조하세요.

AI 혁명의 첫 번째 시대는 더 큰 모델, 더 많은 데이터 및 더 많은 컴퓨팅과 같이 무차별적인 확장으로 정의되었습니다. 규모는 항상 중요하겠지만, 다음 시대는 효율성과 정교함으로 정의될 것입니다. AI의 미래는 단순히 더 큰 모델을 구축하는 것이 아니라, 더 스마트하고 지속 가능하며 더 접근하기 쉬운 인프라를 구축하여 훈련시키고 운영하는 것입니다.

AlexNet이 GPU를 처음 사용한 것부터 미래의 광학 기반, 공동 설계된 AI 공장으로 나아가는 여정은 끊임없는 혁신 속도를 보여주는 증거입니다. 통신, 메모리 및 전력의 병목 현상을 극복하는 것은 우리 시대의 큰 과제이며, 오늘날 개발되고 있는 솔루션은 인공 지능의 다음 물결을 위한 토대를 마련할 것입니다.

[1] Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems 25.

[2] Vaswani, A., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems 30.

[3] Visual Capitalist. (2023). Charted: The Skyrocketing Cost of Training AI Models Over Time.

[4] Forbes. (2024). The Extreme Cost of Training AI Models.

[5] R&D World. (2024). AI’s great compression: 20 charts show vanishing gaps but still soaring costs.

[6] NVIDIA. (2024). NVIDIA GB200 NVL72.

[7] Zhai, E., et al. (2024). HPN: A Non-blocking, Dual-plane, Application-layer-agnostic High-performance Network for Large-scale AI Training. SIGCOMM 2024.

[8] Szasz, D. (2024). Understanding Bottlenecks in Multi-GPU AI Training. Medium.

[9] Alibaba Cloud. (2024). PAI-Lingjun Intelligent Computing Service Features.

[10] Forbes. (2025). Why Optical Infrastructure Is Becoming Core To The Future Of AI.

[11] Yole Group. (2023). Co-Packaged Optics for Datacenters 2023.

[12] Dettmers, T., et al. (2023). QLoRA: Efficient Finetuning of Quantized LLMs. Advances in Neural Information Processing Systems 36.

[13] Microsoft Research. (2020). ZeRO & DeepSpeed: New system optimizations enable training models with over 100 billion parameters.

[14] Alibaba Cloud. (2025). In-depth Analysis of Alibaba Cloud Panjiu AL128 Supernode AI Servers and Their Interconnect Architecture. Alibaba Cloud Blog.

[15] Alibaba Cloud. (2025). Panjiu AL128 Supernode AI Server Video Overview. YouTube.

이 문서는 원본 영어 버전을 번역한 것입니다. 소스 콘텐츠는 다음을 방문하세요. https://www.alibabacloud.com/blog/from-brute-force-to-finesse-the-evolution-and-future-of-ai-training-infrastructure_602718

127 posts | 4 followers

FollowRegional Content Hub - July 23, 2025

Regional Content Hub - April 15, 2024

Regional Content Hub - May 13, 2025

Regional Content Hub - May 20, 2024

Regional Content Hub - January 20, 2025

JJ Lim - November 10, 2021

127 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub