작성자: Wan

텍스트 임베딩 및 리랭킹은 최신 검색 엔진, 추천 시스템, 검색 증강 생성(RAG) 파이프 라인, 심지어 Agentic AI를 구하는 자연어 처리(NLP) 의 기본 기술입니다.

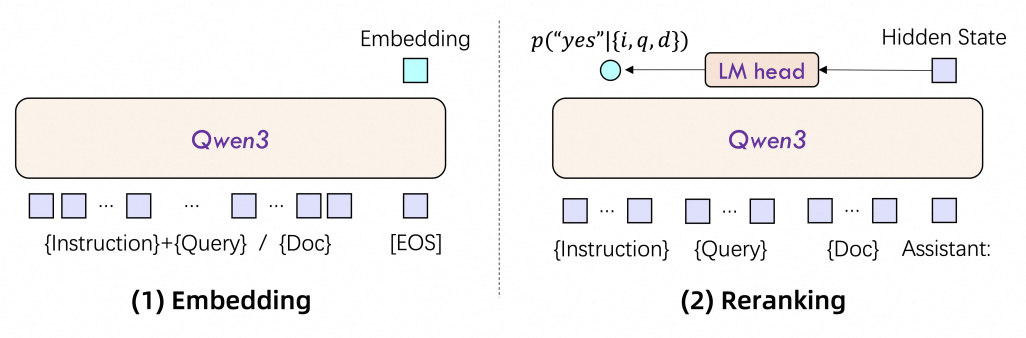

텍스트 임베딩은 구조화되지 않은 텍스트를 의미론적 의미를 포착하는 조밀한 숫자 벡터(예: 숫자 배열)로 변환합니다. 이러한 벡터를 통해 기계는 텍스트 간의 유사성을 측정하여 의미론적 검색, 클러스터링, 분류와 같은 작업을 지원할 수 있습니다. 예를 들어, _"금융 업계를 위한 최고의 LLM"_과 같은 쿼리는 그 의도에 부합하는 LLM(대규모 언어 모델) 설명이나 문서와 연결될 수 있습니다.

리랭킹은 세분화된 관련성 점수를 기반으로 후보의 순서를 다시 지정하여 초기 검색 단계의 결과를 개선합니다. 임베딩 모델은 전체적으로 일치하는 결과를 검색하는 반면, 리랭킹은 가장 문맥에 맞는 결과를 우선합니다. 예를 들어, 검색 엔진은 먼저 임베딩을 사용하여 100개의 문서를 검색한 다음 리랭킹을 적용하여 가장 관련성이 높은 상위 10개의 문서를 선택할 수 있습니다.

주로 활용되는 분야:

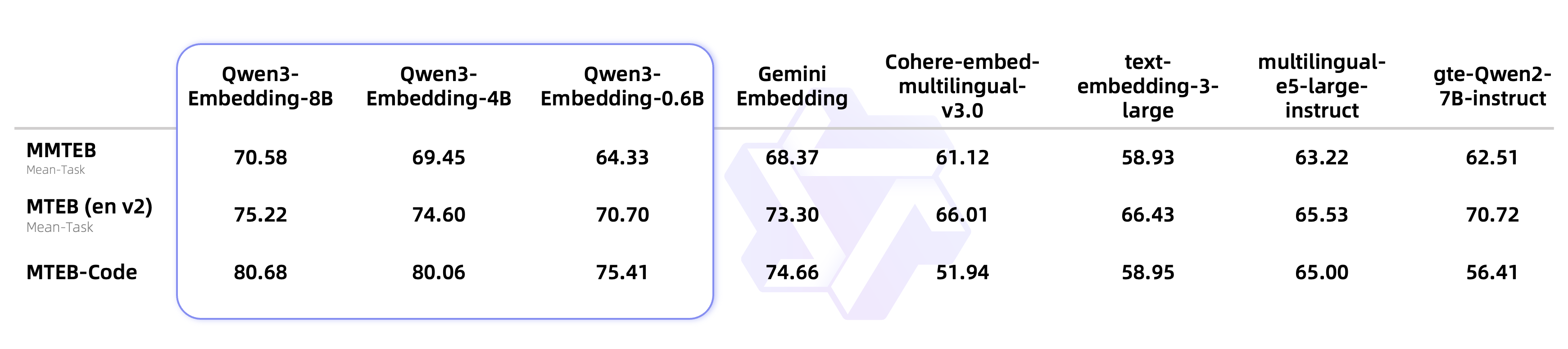

Qwen3 모델을 기반으로 구축된 Qwen3 임베딩 시리즈는 텍스트 표현 학습의 비약적인 발전을 의미합니다. 여기에는 임베딩 모델(텍스트 벡터화용) 및 리랭킹 모델(검색 결과 구체화용)이 포함되며, 파라미터 크기는 0.6B, 4B, 8B입니다.

1. 탁월한 활용성:

2. 광범위한 유연성:

3. 다국어 숙달:

리랭킹 모델 평가 결과:

리랭킹 모델 평가 결과:

| 모델 | 파라미터 | MTEB-R | CMTEB-R | MMTEB-R | MLDR | MTEB-Code | FollowIR |

|---|---|---|---|---|---|---|---|

| Qwen3-Embedding-0.6B | 0.6B | 61.82 | 71.02 | 64.64 | 50.26 | 75.41 | 5.09 |

| Jina-multilingual-reranker-v2-base | 0.3B | 58.22 | 63.37 | 63.73 | 39.66 | 58.98 | -0.68 |

| gte-multilingual-reranker-base | 0.3B | 59.51 | 74.08 | 59.44 | 66.33 | 54.18 | -1.64 |

| BGE-reranker-v2-m3 | 0.6B | 57.03 | 72.16 | 58.36 | 59.51 | 41.38 | -0.01 |

| Qwen3-Reranker-0.6B | 0.6B | 65.80 | 71.31 | 66.36 | 67.28 | 73.42 | 5.41 |

| Qwen3-Reranker-4B | 4B | 69.76 | 75.94 | 72.74 | 69.97 | 81.20 | 14.84 |

| Qwen3-Reranker-8B | 8B | 69.02 | 77.45 | 72.94 | 70.19 | 81.22 | 8.05 |

성능:

효율성:

맞춤화:

리소스 요구사항:

지연:

모델 개요:

| 모델 유형 | 모델 | 크기 | 레이어 | 시퀀스 길이 | 임베딩 차원 | MRL 지원 | 지시 사항 인식 |

|---|---|---|---|---|---|---|---|

| 텍스트 임베딩 | Qwen3-Embedding-0.6B | 0.6B | 28 | 32K | 1024 | 예 | 예 |

| Qwen3-Embedding-4B | 4B | 36 | 32K | 2560 | 예 | 예 | |

| Qwen3-Embedding-8B | 8B | 36 | 32K | 4096 | 예 | 예 | |

| 텍스트 리랭킹 | Qwen3-Reranker-0.6B | 0.6B | 28 | 32K | - | - | 예 |

| Qwen3-Reranker-4B | 4B | 36 | 32K | - | - | 예 | |

| Qwen3-Reranker-8B | 8B | 36 | 32K | - | - | 예 |

참고: "MRL 지원"은 임베딩 모델이 최종 임베딩에 대한 맞춤형 차원을 지원하는지 나타냅니다. "지시 사항 인식"은 임베딩 모델 또는 리랭킹 모델이 다른 작업에 대한 입력 지시 사항 맞춤화를 지원하는지 기록합니다.

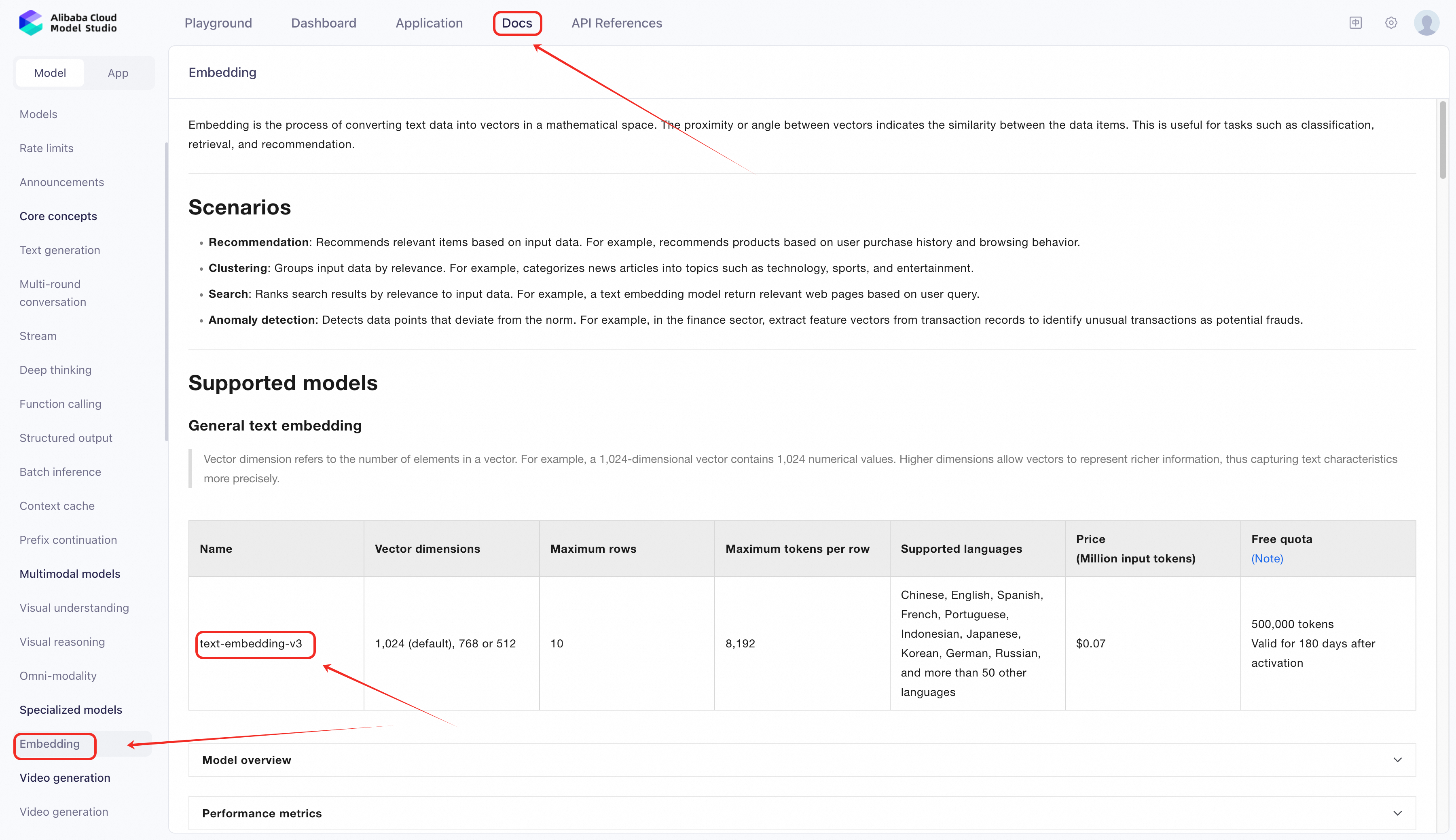

Alibaba Cloud는 임베딩 모델을 발동하는 두 가지 주요 방법을 제공합니다.

Alibaba Cloud의 Model Studio는 배포나 인프라 관리 없이도 text-embedding-v3를 포함하여 사전 학습된 오픈 소스 및 독점 모델에 간편하게 액세스할 수 있습니다.

1. Model Studio 액세스:

2. OpenAI 호환 API를 통해 모델 발동:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"), # Replace with your API Key if you have not configured environment variables

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1" # base_url for Model Studio

)

completion = client.embeddings.create(

model="text-embedding-v3",

input='The quality of the clothes is excellent, very beautiful, worth the wait, I like it and will buy here again',

dimensions=1024,

encoding_format="float"

)

print(completion.model_dump_json())맞춤화가 필요한 고급 사용 사례(예: 분야별 미세 조정)의 경우 PAI-EAS(Elastic Accelerated Service)에 Qwen3-Embedding-8B 또는 기타 Qwen3 변형을 배포하십시오. 다음은 최신 PAI 도구 및 인터페이스를 기반으로 한 단계별 가이드입니다.

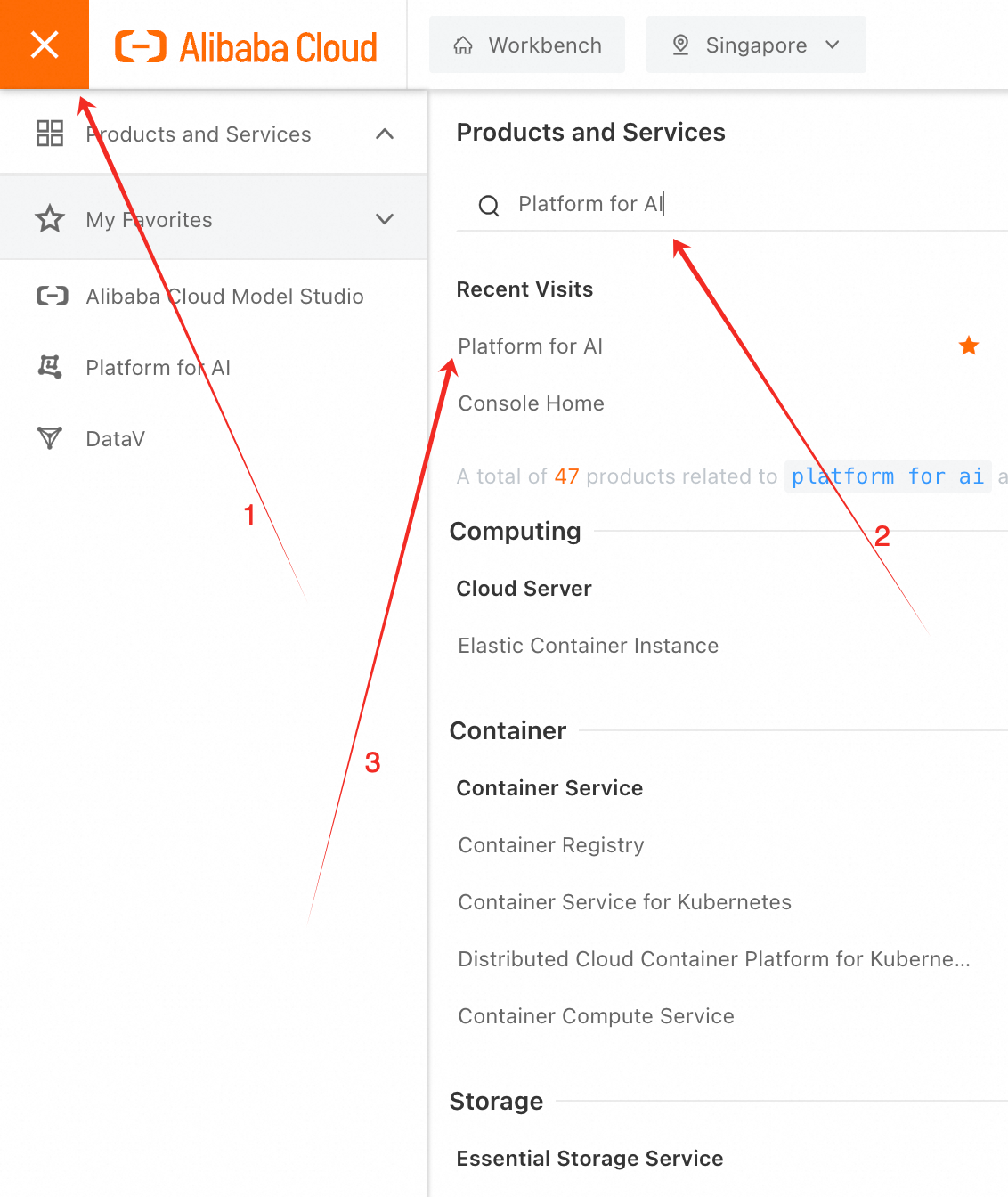

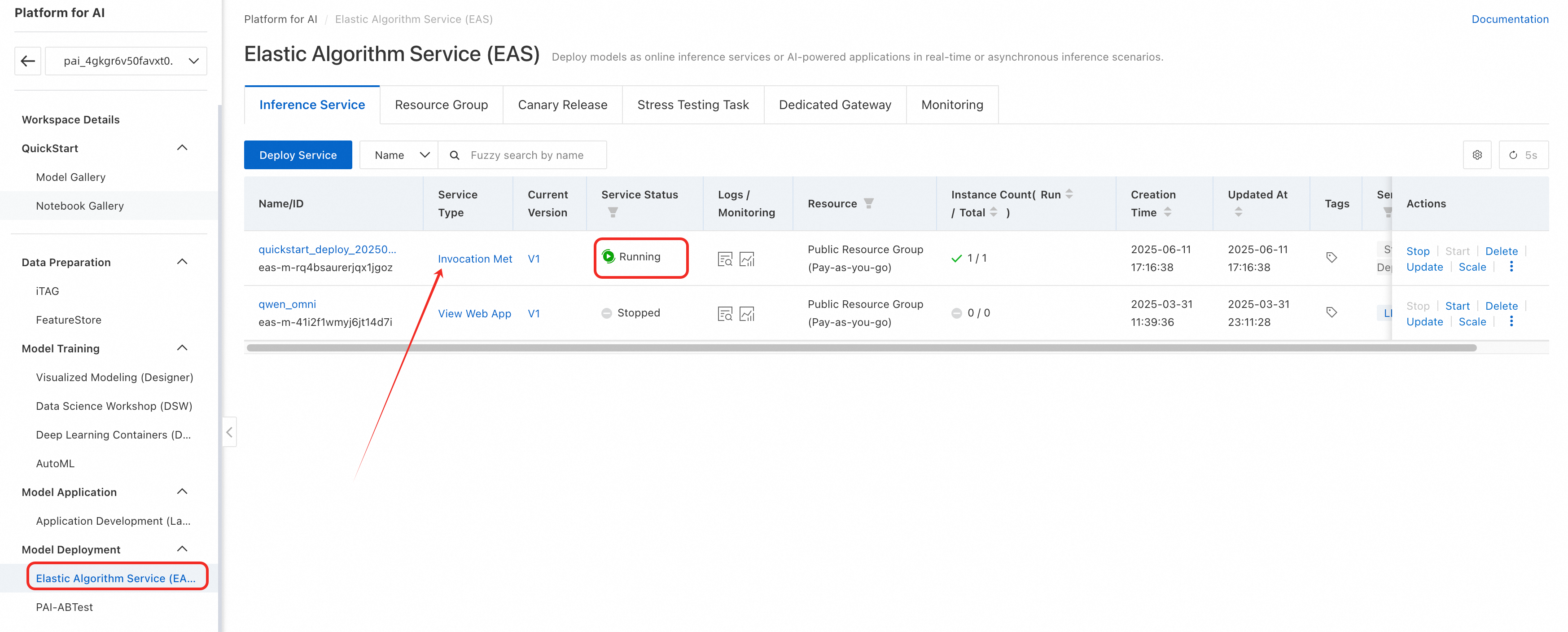

1. PAI 콘솔에 로그인합니다.

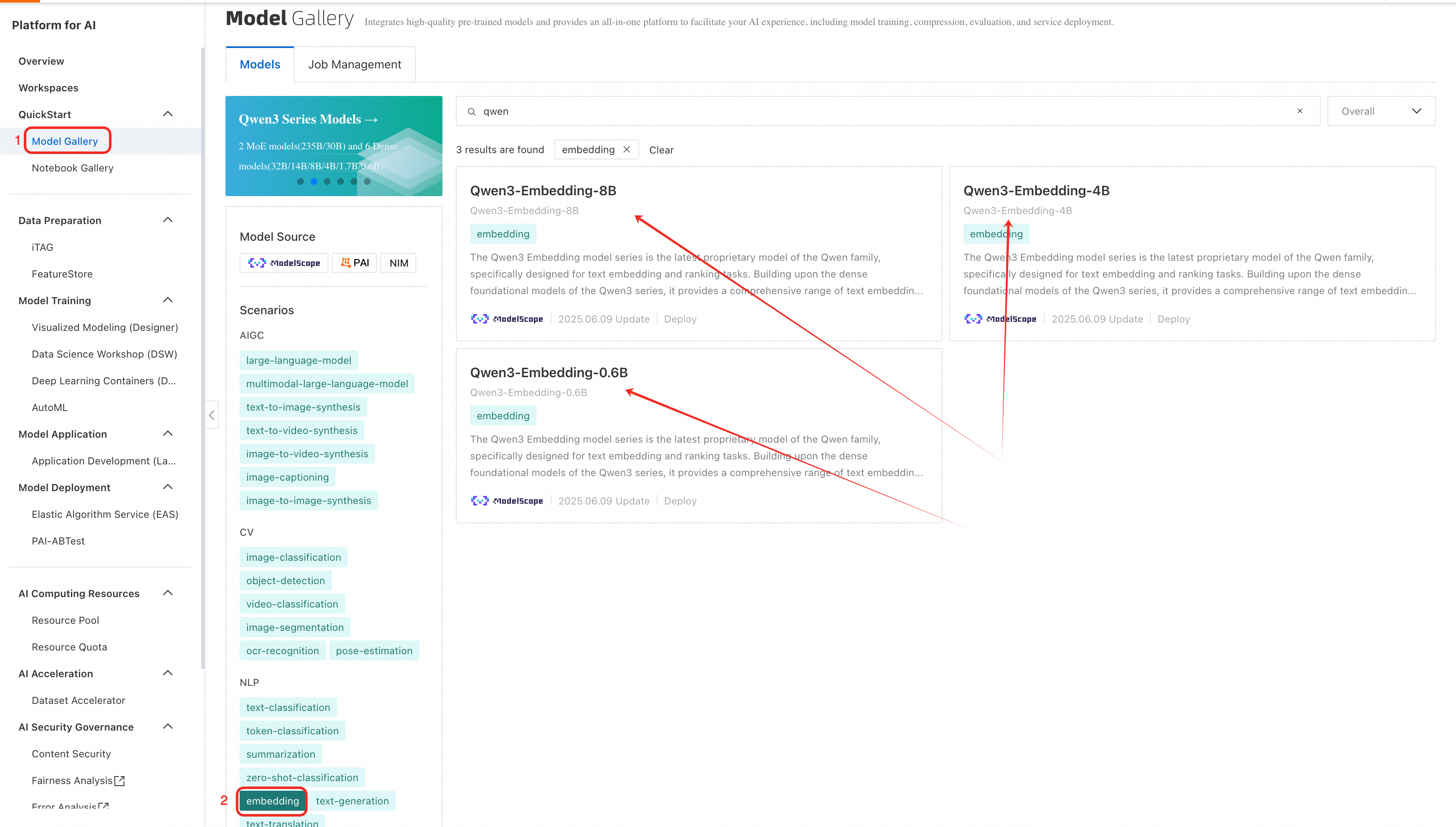

2. 작업 공간을 선택하고 _QuickStart > Model Gallery > NLP> 임베딩_을 선택하여 Qwen3-Embedding 모델을 찾거나 검색합니다.

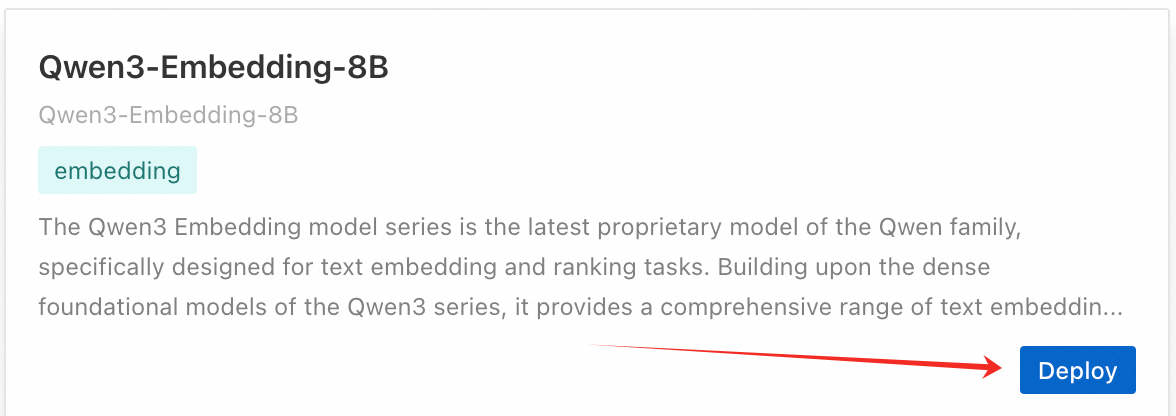

3. 원하는 모델 옆의 배포(예: Qwen3-Embedding-8B)를 클릭합니다.

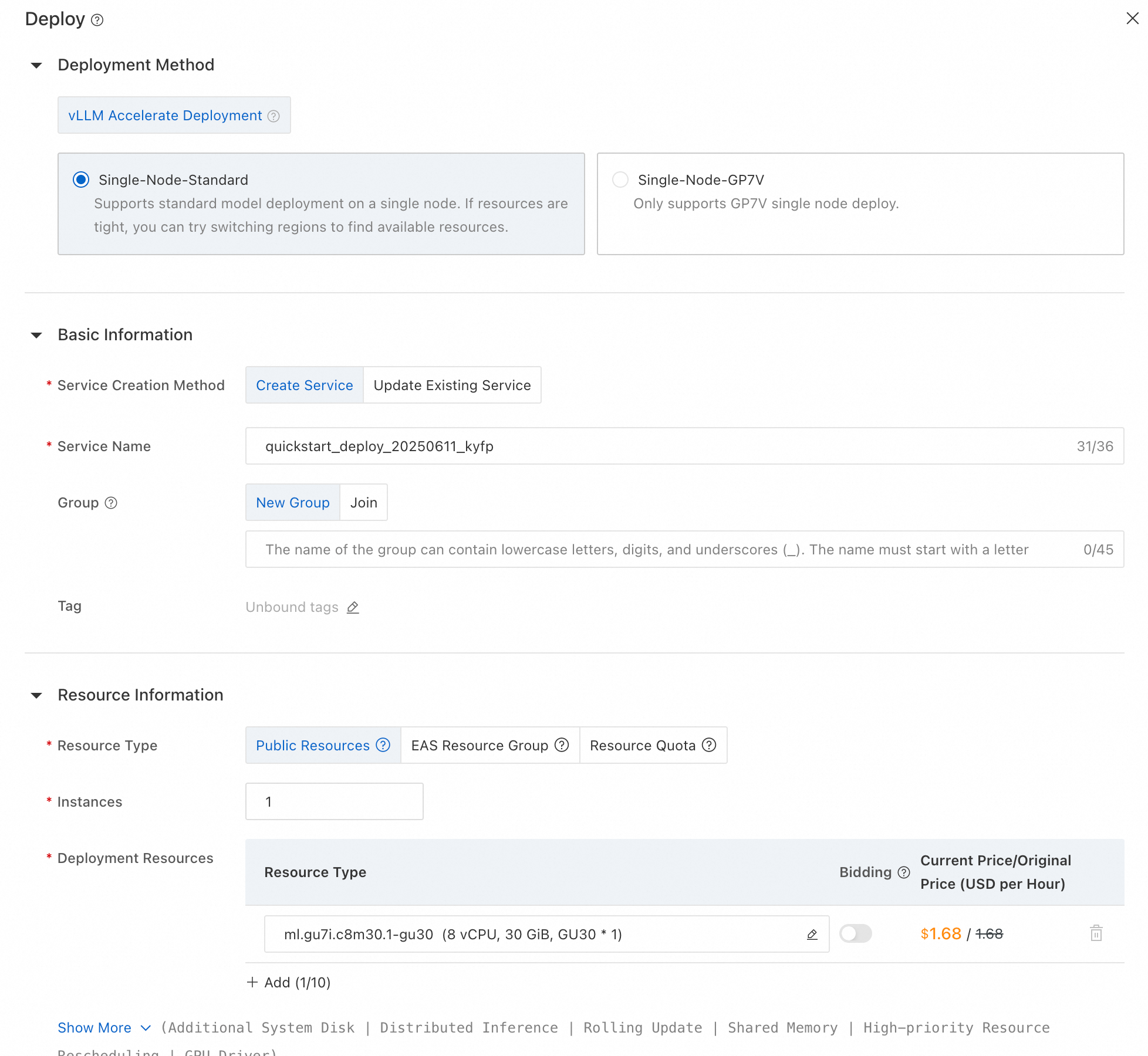

4. 인스턴스 유형, 자동 스케일링 및 기타 파라미터를 구성합니다.

5. 최근에 배포된 모델에 액세스하려면 모델 배포 섹션으로 이동하여 EAS(Elastic Algorithm Service)를 선택합니다. '서비스 상태'가 '실행 중'이 되면 모델 사용을 시작할 수 있습니다.

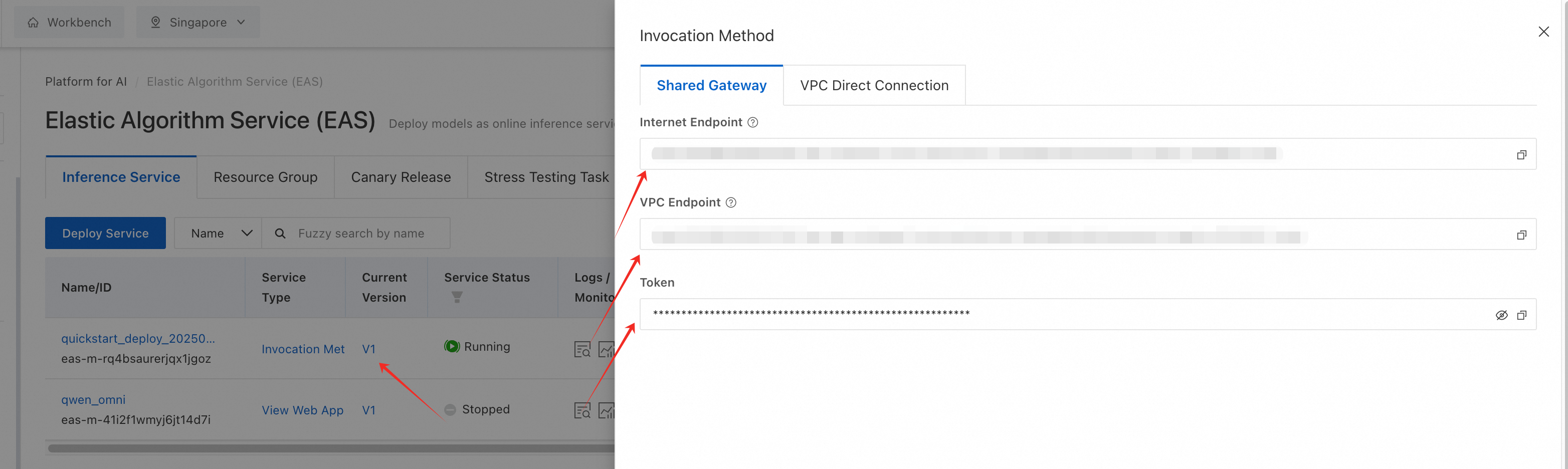

6. 발동 방법을 클릭하고 통합을 위해 생성된 API 엔드포인트를 복사합니다.

이 간소화 된 워크플로는 고급 맞춤화를 위한 유연성을 유지하면서 빠른 배포를 보장합니다.

PAI-EAS는 기본적으로 OpenAI의 API 형식을 지원하여 LangChain또는OpenAI와 같은 도구와의 원활한 통합을 가능하게 합니다.

from openai import OpenAI

# Initialize client with PAI-EAS endpoint

client = OpenAI(

base_url="https://<pai-eas-endpoint>/v1",

api_key="<your-pai-api-key>"

)

# Generate embeddings

embedding = client.embeddings.create(

input="How should I choose best LLM for the finance industry?",

model="qwen3-embedding-8b"

)

print(embedding.data[0].embedding) # Outputs a 4096D vector

# Rerank search results

rerank = client.rerank.create(

query="Renewable energy solutions",

documents=[

"Solar power adoption surged by 30% in 2024.",

"Wind energy faces challenges in urban areas.",

"Hydrogen fuel cells offer zero-emission transportation."

],

model="qwen3-reranker-4b"

)

print(rerank.results) # Returns relevance scores 1. 직접 API 호출(선택 사항) 낮은 수준의 제어의 경우 원시 HTTP 요청을 전송합니다.

import requests

# Example request

url = "<pai-eas-endpoint>/v1/embeddings"

headers = {"Authorization": "Bearer <your-api-key>"}

payload = {

"input": ["Quantum computing will revolutionize cryptography."],

"model": "qwen3-embedding-8b"

}

response = requests.post(url, headers=headers, json=payload)

print(response.json()) | 사용 사례 | Model Studio | PAI-EAS |

|---|---|---|

| 빠른 프로토타이핑 | ✅ 코드 없이 즉시 액세스 가능 | ❌ 배포 설정 요구 |

| 분야별 맞춤화 | ❌ 사전 훈련된 모델로 제한 | ✅ 미세 조정 및 맞춤형 모델 지원 |

| 비용 효율성 | ✅ 토큰당 비용 지불 | ✅ 유연한 GPU 인스턴스 가격 책정 |

| OpenAI SDK와 통합 | ✅ OpenAI 호환 API 지원 | ✅ OpenAI 호환 API 지원 |

Qwen3의 임베딩 및 리랭킹 모델은 업계 전반에 걸쳐 탁월한 유연성과 성능을 제공합니다. Alibaba Cloud의 PAI 에코시스템을 활용하면 이러한 모델을 배포하고 미세 조정하여 재무 위험 분석부터 의료 연구까지 분야별 과제를 해결할 수 있습니다. 향후 작업에는 멀티모달 기능 확장(예: 이미지 및 텍스트의 교차 모달 검색) 및 엣지 장치 최적화가 포함됩니다.

AI의 세계에서, 누구에게나 다 맞는 하나의 방법은 없습니다. Qwen3의 임베딩 및 리랭킹 모델은 다국어 텍스트 이해부터 코드 검색까지 일반적인 작업을 마스터하도록 사전 학습되어 있지만, 금융, 의료 또는 법률과 같은 분야에 맞춤화할 때 그 진정한 잠재력이 빛을 발합니다. 바로 이 지점에서 Alibaba Cloud의 대규모 훈련 플랫폼인 PAI-Lingjun이 혁신의 촉매제 역할을 합니다.

희귀 질환에 맞는 치료제를 찾기 위해 수백만 건의 임상 시험 자료를 샅샅이 뒤지는 제약 연구원이나 특정 조항을 찾기 위해 수천 건의 계약서를 훑어보는 변호사를 떠올려 보십시오. 일반 모델은 물론 강력하지만, 'EBITDA', '심근경색', '불가항력'과 같은 분야별 용어의 미묘한 차이를 놓치는 경우가 많기 때문에 정확성이 요구됩니다. 미세 조정은 이러한 격차를 해소하고, Qwen3의 아키텍처를 조정하여 신약 개발부터 재무 위험 평가에 이르기까지 전문 업무의 미묘한 차이를 파악할 수 있도록 합니다.

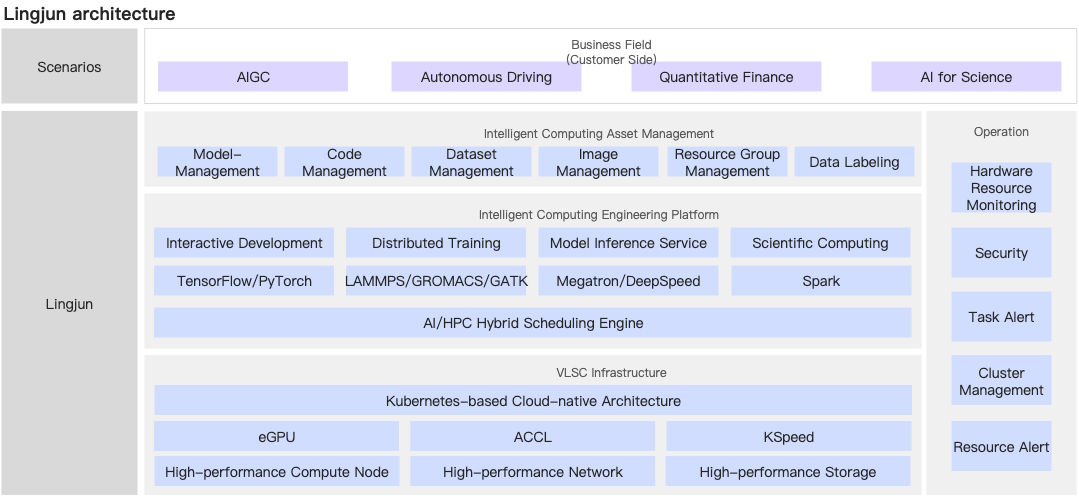

PAI-Lingjun은 Qwen3 모델을 정제하는 데 필요한 연산 수요를 처리하도록 설계된 강력한 솔루션입니다. GPU/TPU 전반에 걸친 분산 학습을 지원하므로 0.6B에서 8B의 파라미터 모델로 확장할 수 있어 가장 복잡한 분야에서도 속도와 정확도 사이의 이상적인 균형을 찾을 수 있습니다.

워크플로의 주요 구성 요소:

1. 약한 수준의 감독을 거친 사전 훈련:

여기서 Qwen3는 분야의 리듬을 학습합니다. 대출 신청서를 위한 쿼리를 만들거나 법률 전문 용어를 모방하는 등 합성 데이터를 생성함으로써 리소스가 부족한 시나리오에서도 이해를 위한 발판을 구축할 수 있습니다.

2. 감독을 거친 미세 조정:

이 모델은 선별된 데이터를 통해 전문성을 강화합니다. 은행은 모델이 1,200만 개의 금융 문서를 학습하여 대출 신청서의 위험 신호를 정확하게 찾아내도록 훈련할 수 있습니다.

3. 모델 병합:

팔레트에서 색상을 혼합하는 것처럼 구형 선형 보간(SLERP)은 체크포인트를 병합하여 일반화와 전문화의 균형을 맞춥니다. 결과는 어떨까요? 폭과 깊이를 모두 갖춘 모델입니다.

Qwen3-Embedding-8B를 미세 조정하는 것은 만일을 위한 불필요한 절차가 아닙니다. 8개의 NVIDIA A100 GPU와 3~5일의 훈련 시간이 필요합니다. 검색 정확도가 72%에서 89%로 뛰어오르고 분야 범위가 93%까지 치솟는 등 그 성과는 엄청납니다. Qwen3-Reranker-0.6B와 같은 소형 모델은 실시간 스코어링을 위한 민첩성을 제공하여 성능이 항상 크기에 좌우되지 않는다는 것을 증명합니다.

| 모델 파라미터 수 | 전체 파라미터 훈련 리소스 | 최소 추론 리소스 | 메가트론 기반 훈련을 위한 모델 병렬 처리 |

|---|---|---|---|

| 70억 | gu7xf GPU 8개 또는 gu7ef GPU 8개 | NVIDIA V100 GPU(32GB 메모리) 1개 또는 NVIDIA A10 GPU(24GB 메모리) 1개 | TP1 및 PP1 |

| 140억 | gu7xf GPU 8개 또는 gu7ef GPU 8개 | NVIDIA V100 GPU(32GB 메모리) 2개 또는 NVIDIA A10 GPU(24GB 메모리) 2개 | TP2 및 PP1 |

| 720억 | 각각 gu7xf GPU 8개 또는 gu7ef GPU 8개가 있는 4개의 서버 | NVIDIA V100 GPU(32GB 메모리) 6개 또는 gu7xf GPU 2개 | TP8 및 PP2 |

솔루션:

솔루션:

솔루션:

솔루션:

솔루션:

PAI-Lingjun 및 Qwen3을 사용하면 여러분의 손끝에서 업계를 혁신할 수 있습니다. 재무 위험 모델을 최적화하든 의료 혁신을 가속화하든, Qwen3의 임베딩 및 리랭킹 기능은 타의 추종을 불허하는 정밀도를 제공합니다. 어디까지 가능할지 함께 재정의해 봅시다.

질문이 있으습니까? 지금 바로 팀에 문의하거나 PAI-Lingjun을 살펴보고 무료 체험을 시작하십시오!

Qwen3의 미세 조정은 단순한 기술적 프로세스가 아니라 전략적 도약입니다. 금융, 의료, 재료 공학 등 어떤 분야에서 혁신을 이루든 PAI-Lingjun은 AI의 잠재력을 최대한 활용할 수 있도록 지원합니다.

Qwen3 임베딩 시리즈는 텍스트 표현 학습의 중요한 도약을 의미합니다. 하지만 대규모 언어 모델(LLM)의 지속적인 발전으로 새로운 지평이 열리고 있습니다. 아래는 향후 개발을 위한 주요 중점 영역으로, 지시 사항 인식 임베딩 및 MRL(Matryoshka Representation Learning)을 강조하고 있습니다.

기존 모델은 새로운 작업에 적응하기 위해 재훈련이 필요하지만, Qwen3의 지시 사항 인식 아키텍처는 작업별 프롬프트를 통해 동적으로 적응할 수 있습니다. 따라서 분야별로 미세 조정할 필요가 없으므로 비용 및 복잡성이 줄어듭니다.

핵심 개념:

Qwen3 임베딩 모델은 명시적인 지시 사항을 입력으로 받아 특정 작업에 맞는 임베딩을 생성하도록 모델을 안내합니다. 예:

def get_detailed_instruct(task_description: str, query: str) -> str:

return f'Instruct: {task_description}\nQuery: {query}'

# Example: Flag loan applications with geopolitical risk factors

task = "Identify loan applications with geopolitical risk factors"

query = "Loan application for a tech firm in Southeast Asia"

input_text = get_detailed_instruct(task, query) 이 방법은 입력 컨텍스트에 지시 사항을 삽입하여 모델이 재훈련 없이도 분야별 뉘앙스(예: '지정학적 위험')에 초점을 맞출 수 있도록 합니다.

쿼리에 작업별 지침을 추가함으로써 Qwen3은 최소한의 라벨이 지정된 데이터로 새로운 분야에 적응할 수 있습니다. 예를 들어, 화학 분야 리랭커는 다음과 같은 지침을 포함하여 특정 약물 대상과 관련된 분자의 우선순위를 지정할 수 있습니다:

task = "Find molecules similar to aspirin for anti-inflammatory use"

query = "C1CC(=O)NC(=O)C1" # Aspirin's SMILES string MRL을 사용하면 추론 중에 임베딩 차원을 동적으로 조정할 수 있으므로 재훈련 없이 유연하게 사용할 수 있습니다. 이러한 혁신을 통해 단일 모델로 여러 시나리오(예: 경량 엣지 장치 대 고정밀 서버)에 대응할 수 있습니다.

MRL 작동 방식:

Qwen3 임베딩 모델은 맞춤화 가능한 차원(예: 1024D, 2560D 또는 4096D)로 임베딩을 생성합니다.

output_dimension 파라미터를 통해 추론 중에 원하는 차원을 지정할 수 있습니다.

# Generate a 2560D vector for financial risk analysis

embeddings = model.encode(queries, output_dimension=2560) MRL의 장점:

예: 의료 분야의 MRL

제약 연구자는 정밀한 분자 검사를 위해 4096D 임베딩을 생성하고 실시간 환자 기록 클러스터링을 위해서는 1024D로 전환할 수 있습니다.

# High-precision molecule embedding

molecule_embedding = model.encode("C1CC(=O)NC(=O)C1", output_dimension=4096)

# Lightweight patient record clustering

patient_notes_embedding = model.encode("Patient presents with chest pain", output_dimension=1024) •어려움: 위험 신호(예: 연체 기록)가 있는 대출 신청의 우선순위를 정합니다.

•솔루션:

task = "Identify loans with delinquency risks"

query = "Loan application for a tech startup in India"

input_text = get_detailed_instruct(task, query) •성능 지표:

| 지표 | 기준선 | 최적화 이후 |

|---|---|---|

| 검색 정확도 | 72% | 89% |

| 리랭킹 Precision@10 | 65% | 84% |

솔루션:

# Generate embeddings for clinical notes

embeddings = model.encode(clinical_notes, output_dimension=256)

# Cluster notes with HDBSCAN

clusterer = HDBSCAN(min_cluster_size=50)

labels = clusterer.fit_predict(embeddings) 솔루션:

| 모델 | MTEB-Code 점수 | 쿼리 지연 시간(ms) |

|---|---|---|

| Qwen3-Embedding-8B | 80.68 | 150 |

| Qwen3-Embedding-8B(MRL) | 85.21(4096D) | 160(더 높은 정확도) |

솔루션: Qwen3의 지시 사항 인식 설계를 통해 개발자는 추론 시점에 작업별 지시 사항을 정의할 수 있습니다.

이점:

솔루션: MRL을 사용하면 차원을 동적으로 조정할 수 있습니다.

이점:

Qwen3 임베딩 모델은 지시 사항 인식 임베딩과 MRL 지원을 결합하여 유연성을 재정의하므로 분야별 미세 조정이 필요하지 않습니다.

이러한 혁신을 활용하여 조직은 다음을 이점을 얻을 수 있습니다.

참조 자료:

코드 저장공간:

연락처: 협업 또는 문의 사항은 Alibaba Cloud에 연락하십시오.

역사상 처음으로 기계가 산스크리트어 시와 파이썬 함수, 의학 진단 사이의 유전적 관계를 해독할 수 있게 되었으며, 이는 오픈 소스 혁신을 통해 모두가 이용할 수 있게 된 획기적인 성과입니다. DNA 시퀀싱이 생명의 보편적 코드를 밝혀내어 생물학에 혁명을 일으킨 것처럼, Qwen3 임베딩은 의미 자체의 분자 구조를 매핑하여 AI를 혁신합니다. 이 기술은 언어, 문화, 분야를 초월하여 AI 시스템이 정보를 이해하고 검색하는 방식을 재정의하는 숨겨진 연관성을 발견합니다.

기존의 AI 검색은 키워드 매칭 로봇처럼 표면 수준의 텍스트 일치에 국한되어 작동합니다. 하지만 Qwen3 임베딩은 250개 이상의 언어와 프로그래밍 패러다임에서 개념 간의 깊은 의미적 관계를 포착하여 언어의 DNA 시퀀서 역할을 합니다. 의료 진단, 법률 계약서, 양자 컴퓨팅 알고리즘을 분석할 때 Qwen3는 의미의 유전 암호를 해독하여 기계가 뉘앙스, 맥락, 학제 간 연관성을 파악할 수 있게 해줍니다. 이는 단순한 점진적 개선이 아니라 패러다임의 전환입니다.

Qwen3 임베딩의 다단계 훈련 파이프라인은 합성 데이터 생성, 감독 미세 조정, 모델 병합을 결합하여 최첨단 성능을 달성합니다. MTEB Multilingual에서 70.58점, MTEB Code에서 80.68점을 받은 Qwen3는 Google의 Gemini-Embedding과 같은 독점적인 거대 기업을 능가하며 오픈 소스 혁신이 폐쇄적인 생태계를 능가할 수 있음을 입증했습니다. Apache 2.0 라이선스에 따라 모델을 오픈 소스화하여 이 '의미의 유전 암호'에 대한 액세스를 대중화함으로써 전 세계 개발자들이 더 스마트하고 직관적인 시스템을 구축할 수 있도록 지원하고 있습니다.

Qwen3의 진정한 힘은 기술 사양뿐만 아니라 여러 세계를 연결하는 능력에 있습니다.

이는 가상의 시나리오가 아니라 Qwen3의 유전자 수준의 의미 이해에 의해 이미 형성되고 있는 현실입니다.

AI가 발전함에 따라 Qwen3 임베딩은 텍스트뿐만 아니라 이미지, 오디오, 비디오를 동일한 유전자 렌즈를 통해 디코딩하는 멀티모달 시스템의 기반을 마련합니다. 통합된 교차 모달 임베딩을 통해 생물의학 논문을 이해하고, 3D 단백질 모델에서 그 의미를 시각화하며, 그 동작을 시뮬레이션하는 코드를 생성하는 AI를 생각해 보십시오.

또한, 경량 0.6B 모델부터 고성능 8B 버전에 이르는 Qwen3의 효율성은 엣지 장치 및 클라우드 규모 애플리케이션 모두에 적합한 적응성을 보장합니다. 미래는 유기체처럼 학습하며 다양한 데이터 생태계에 노출되어 진화하는 시스템의 시대입니다. Qwen3 임베딩은 단순한 도구가 아니라 이러한 진화를 위한 청사진입니다.

이제 의미의 유전 암호를 파악할 수 있게 되었습니다. Hugging Face 및 ModelScope에서 Qwen3 임베딩 및 리랭킹 모델을 살펴보십시오. Alibaba Cloud의 PAI 에코시스템에 배포하거나 틈새 분야에 맞게 미세 조정할 수 있습니다. 연구자, 개발자, 기업 등 누구에게나 유전적 AI 이해의 시대는 오늘부터 시작됩니다.

_연락처_: 협업 또는 문의 사항은 Alibaba Cloud에 연락하십시오

이 문서는 영어에서 번역되었습니다. 원본 문서는 여기를 참조하십시오.

125 posts | 4 followers

FollowJJ Lim - January 20, 2025

Regional Content Hub - April 15, 2024

James Lee - December 30, 2025

Regional Content Hub - December 10, 2025

JJ Lim - December 31, 2021

JJ Lim - December 3, 2021

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub