Do Farruh viết

Tập dữ liệu là yếu tố cốt lõi của trí tuệ nhân tạo, đặc biệt là trong việc đào tạo các mô hình ngôn ngữ lớn (LLM) để hỗ trợ mọi thứ, từ chatbot đến trình tạo nội dung. Các tập dữ liệu này hình thành nền tảng để các mô hình AI học hỏi và phát triển chức năng của mình. Tuy nhiên, khi nhu cầu về các hệ thống AI tiên tiến hơn tăng lên, nhu cầu về các tập dữ liệu chất lượng cao, đa dạng và phong phú cũng tăng theo. Bài viết này tìm hiểu chi tiết về lịch sử sử dụng tập dữ liệu, các loại dữ liệu cần thiết ở các giai đoạn khác nhau trong quá trình đào tạo LLM và những thách thức gặp phải trong việc tìm nguồn và sử dụng các tập dữ liệu này.

Trong những ngày đầu nghiên cứu AI, các tập dữ liệu được tuyển chọn tỉ mỉ từ nhiều nguồn khác nhau, chẳng hạn như bách khoa toàn thư, biên bản họp quốc hội, bản ghi âm cuộc gọi điện thoại và dự báo thời tiết. Mỗi tập dữ liệu đều được thiết kế riêng để giải quyết các tác vụ cụ thể, đảm bảo sự phù hợp và chất lượng. Tuy nhiên, với sự ra đời của transformer vào năm 2017 - một kiến trúc mạng nơ-ron đóng vai trò quan trọng đối với các mô hình ngôn ngữ hiện đại - trọng tâm đã chuyển sang quy mô khổng lồ, đánh dấu sự thay đổi đáng kể trong phương pháp nghiên cứu AI. Các nhà nghiên cứu nhận ra rằng hiệu suất của LLM được cải thiện đáng kể với các mô hình và tập dữ liệu lớn hơn, dẫn đến việc thu thập dữ liệu tràn lan từ internet.

Đến năm 2018, internet đã trở thành nguồn dữ liệu chính cho mọi loại dữ liệu, bao gồm âm thanh, hình ảnh và video. Xu hướng này vẫn tiếp diễn, tạo ra khoảng cách đáng kể giữa dữ liệu lấy từ internet và các tập dữ liệu được chọn lọc thủ công. Nhu cầu mở rộng quy mô cũng dẫn đến việc sử dụng rộng rãi dữ liệu tổng hợp, nghĩa là dữ liệu được tạo ra bởi các thuật toán thay vì thu thập từ các hoạt động tương tác thực tế.

Đào tạo trước là giai đoạn ban đầu, trong đómô hình được tiếp xúc với lượng lớn dữ liệu văn bản để học hỏi các cấu trúc và mẫu ngôn ngữ chung. Trong giai đoạn này, mô hình cần có:

Tuy nhiên, vấn đề đạo đức sẽ phát sinh khi sử dụng tài liệu có bản quyền khi chưa được phép.

Đào tạo trước liên tục bao gồm việc cập nhật mô hình bằng dữ liệu mới để không bị lỗi thời và cải thiện cơ sở kiến thức của mô hình. Giai đoạn này yêu cầu:

Tinh chỉnh để điều chỉnh mô hình được đào tạo trước cho phù hợp với các tác vụ hoặc lĩnh vực cụ thể. Phương pháp này thường sử dụng các tập dữ liệu nhỏ hơn, có mục tiêu cụ thể hơn, được gắn nhãn cẩn thận và được chọn lọc chặt chẽ hơn. Ví dụ:

Dưới đây là các ví dụ về tập dữ liệu và phương pháp được sử dụng trong quy trình này.

Bằng cách kết hợp các tập dữ liệu đã chọn lọc với các phương pháp tiên tiến như PEFT, nhà nghiên cứu và nhà phát triển có thể tối ưu hóa LLM cho các ứng dụng trong lĩnh vực cụ thể, đồng thời giải quyết các hạn chế về tài nguyên và thách thức về khả năng mở rộng

Tăng cường học hỏi từ phản hồi của con người (RLHF) bao gồm việc đào tạo mô hình cho phù hợp hơn với sở thích của con người. Giai đoạn này cần:

Dưới đây là các ví dụ về tập dữ liệu và phương pháp quan trọng đối với RLHF:

Tập dữ liệu về sở thích: RLHF bắt đầu bằng cách thu thập dữ liệu về sở thích do con người gắn nhãn, trong đó con người xếp hạng hoặc đánh giá phản hồi do mô hình cung cấp. Ví dụ, các thí nghiệm RLHF ban đầu của OpenAI đã sử dụng các tập dữ liệu trong đó người cung cấp chú thích so sánh nhiều phản hồi do mô hình tạo với cùng một gợi ý, gắn nhãn phản hồi nào hữu ích hơn, chính xác hơn hoặc phù hợp hơn với các nguyên tắc đạo đức. Các tập dữ liệu này thường bao gồm các ví dụ tinh vi, chẳng hạn như phân biệt giữa câu trả lời thực tế và câu trả lời thiên lệch về các chủ đề nhạy cảm như chính trị hoặc y tế.

Bằng cách kết hợp các tập dữ liệu về sở thích, lập mô hình phần thưởng và liên tục thu thập phản hồi của con người, RLHF đảm bảo LLM phát triển từ công cụ tạo văn bản chung thành các hệ thống ưu tiên sự an toàn, liên quan và sự phù hợp với con người.

Một trong những vấn đề cấp bách nhất hiện nay là tình trạng cạn kiệt dữ liệu văn bản có sẵn. Theo báo cáo, các tập đoàn công nghệ lớn đã lập chỉ mục gần như tất cả dữ liệu văn bản có thể truy cập được từ web mở và web tối, bao gồm sách lậu, phụ đề phim, tin nhắn cá nhân và bài đăng trên mạng xã hội. Do thiếu hụt các nguồn dữ liệu mới để khai thác, ngành này đang bị chững lại trong việc tiến bộ hơn nữa.

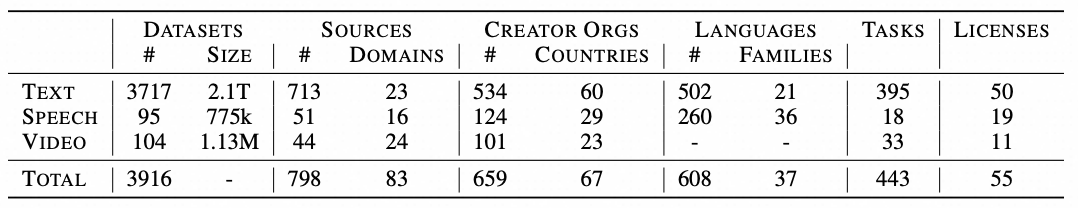

Tổng lượng dữ liệu tích lũy (theo thang logarit đối với văn bản, theo giờ đối với lời nói/video) từ mỗi danh mục nguồn, trên tất cả phương thức. Các danh mục nguồn trong chú thích được sắp xếp theo thứ tự giảm dần về số lượng.

Hầu hết các tập dữ liệu đều có nguồn gốc từ Châu Âu và Bắc Mỹ, phản ánh thế giới quan theo văn hóa phương Tây. Chưa đến 4% các tập dữ liệu được phân tích có nguồn gốc từ Châu Phi, điều này cho thấy sự bất đối xứng văn hóa rõ rệt. Sự thiên lệch này có thể dẫn đến nhận thức sai lệch và củng cố các khuôn mẫu định kiến, đặc biệt là trong các mô hình đa phương thức dùng để tạo hình ảnh và video.

Các tập đoàn lớn chiếm ưu thế trong việc thu thập và kiểm soát các tập dữ liệu có sức ảnh hưởng. Các nền tảng như YouTube cung cấp hơn 70% dữ liệu video dùng để đào tạo AI, tập trung quyền lực to lớn vào tay một số ít tổ chức. Tình trạng tập trung này gây cản trở đổi mới và tạo ra rào cản cho những công ty nhỏ hơn vốn thiếu quyền truy cập vào các tài nguyên này.

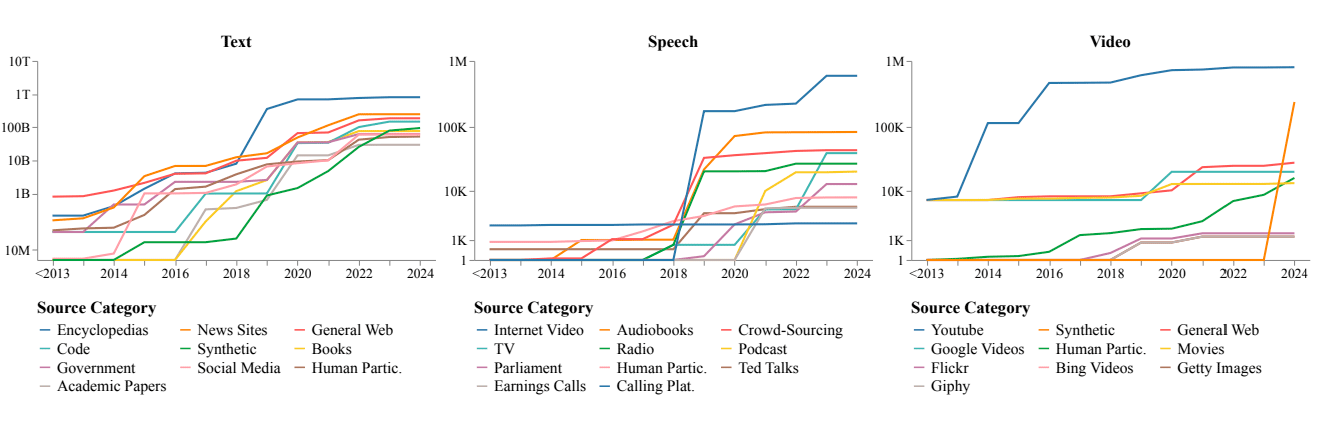

Bảng sau đây cho thấy các nguồn thu thập văn bản. Các thuộc tính bao gồm số lượng tập dữ liệu, tác vụ, ngôn ngữ và lĩnh vực văn bản. Cột Nguồn cho biết nội dung của tập dữ liệu được thu thập: văn bản do con người tạo trên web, phản hồi của mô hình ngôn ngữ hoặc cả hai. Cột cuối cùng cho biết trạng thái cấp phép của tập dữ liệu được thu thập: màu xanh dương cho biết mục đích sử dụng thương mại, màu đỏ cho biết mục đích nghiên cứu học thuật và phi thương mại, còn màu vàng cho biết giấy phép không rõ ràng. Cuối cùng, cột OAI cho biết các tập dữ liệu được thu thập bao gồm các thế hệ mô hình OpenAI. Các tập dữ liệu này được sắp xếp theo thứ tự thời gian để nhấn mạnh xu hướng theo thời gian. Nguồn tại đây

Thu thập dữ liệu văn bản:

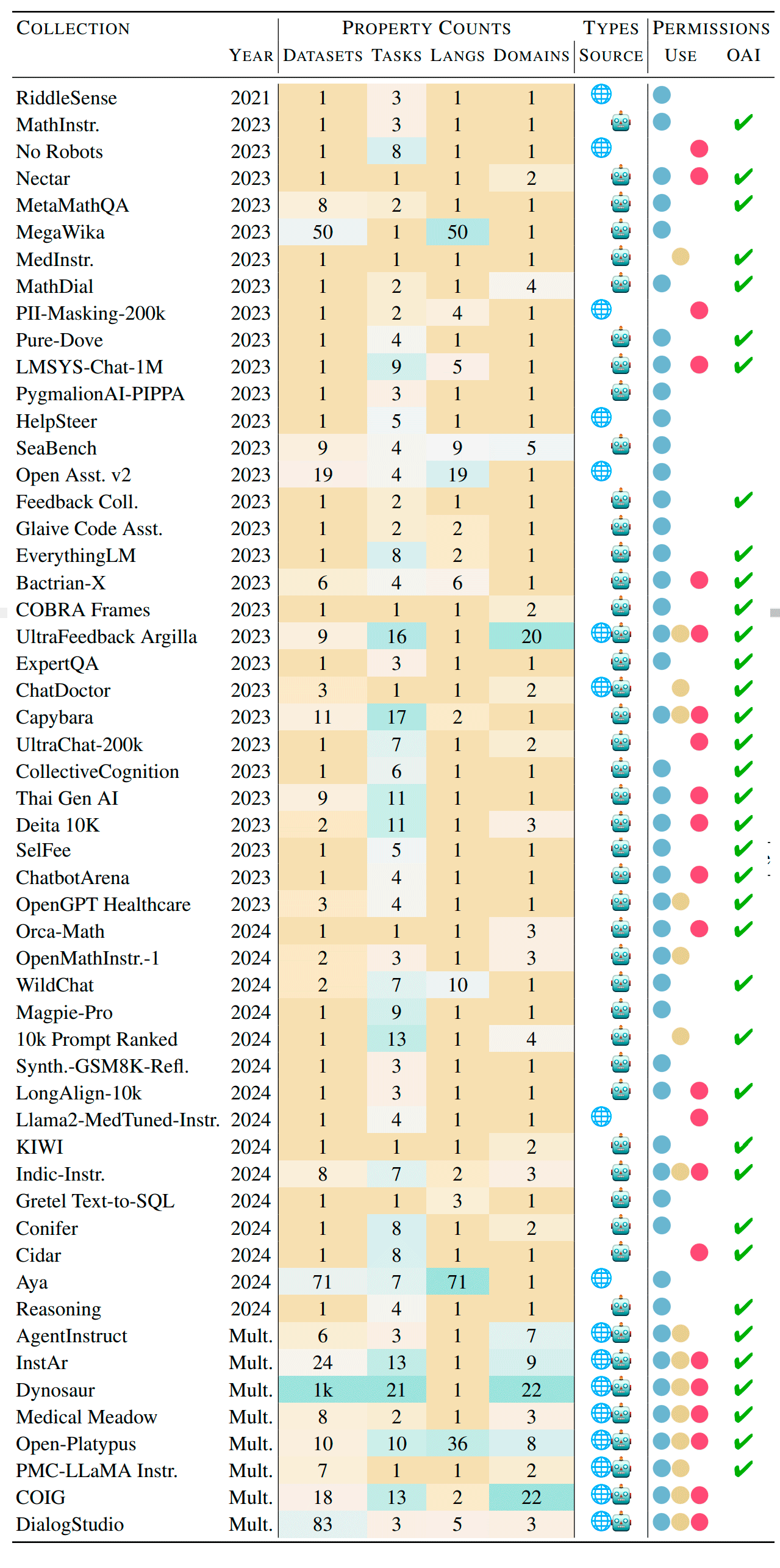

Thu thập dữ liệu video:

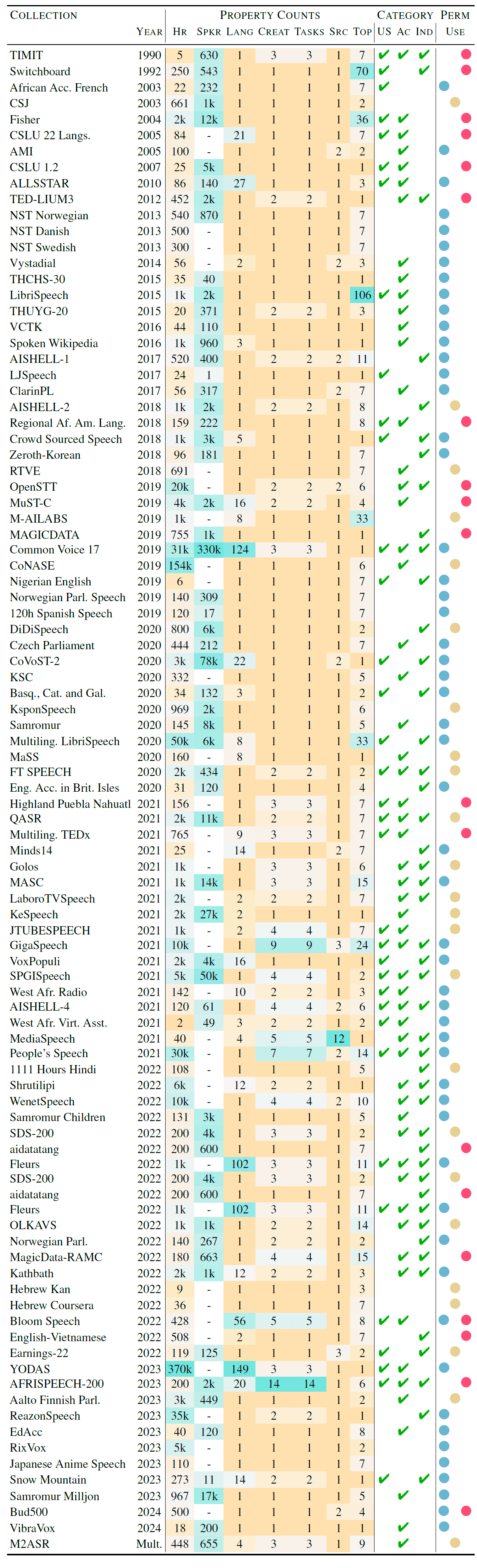

Thu thập dữ liệu âm thanh:

Mặc dù dữ liệu có thể tiếp cận dường như đã cạn kiệt, nhưng vẫn còn rất nhiều nguồn chưa được khai thác:

Các LLM nâng cao có thể giúp tạo cấu trúc và sử dụng các tập dữ liệu tiềm tàng này cho mục đích đào tạo trong tương lai.

Với giải pháp Học liên kết, chúng ta có thể đào tạo các mô hình trên dữ liệu nhạy cảm mà không cần chuyển dữ liệu ra bên ngoài môi trường bảo mật. Phương pháp này lý tưởng cho các ngành cần xử lý thông tin bí mật như y tế, tài chính và viễn thông. Bằng cách lưu giữ dữ liệu cục bộ, học liên kết đảm bảo quyền riêng tư đồng thời giúp cải thiện mô hình cộng tác.

Tạo dữ liệu tổng hợp và tăng cường dữ liệu là những phương pháp tiềm năng để mở rộng quy mô các tập dữ liệu đào tạo:

Khi lĩnh vực AI tiếp tục phát triển, vai trò của tập dữ liệu vẫn đóng vai trò tối quan trọng. Mặc dù việc cạn kiệt các nguồn dữ liệu có sẵn đặt ra nhiều thách thức, nhưng điều quan trọng là chúng ta — với vai trò là các nhà nghiên cứu và những người đam mê AI — cần nhận thức và có trách nhiệm trong việc giải quyết các vấn đề về bất đối xứng văn hóa và thực trạng tập trung hóa. Các giải pháp mới mẻ như tận dụng các nguồn chưa được khai thác, học liên kết và tạo dữ liệu tổng hợp mở ra những con đường phát triển. Bằng cách kết hợp các chiến lược này, chúng ta có thể đảm bảo phát triển AI công bằng và đa dạng, mở đường cho các hệ thống trí tuệ nhân tạo tinh vi và toàn diện hơn.

Bài viết này được dịch từ tiếng Anh. Xem bài viết gốc tại đây.

125 posts | 4 followers

FollowRegional Content Hub - May 13, 2024

Regional Content Hub - July 14, 2025

Regional Content Hub - July 28, 2025

Regional Content Hub - August 29, 2024

Regional Content Hub - December 15, 2025

Regional Content Hub - August 5, 2024

125 posts | 4 followers

Follow Bastionhost

Bastionhost

A unified, efficient, and secure platform that provides cloud-based O&M, access control, and operation audit.

Learn More Managed Service for Grafana

Managed Service for Grafana

Managed Service for Grafana displays a large amount of data in real time to provide an overview of business and O&M monitoring.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn MoreMore Posts by Regional Content Hub