Do Farruh Kushnazarov viết

Thế giới đã vô cùng kinh ngạc khi chứng kiến trí tuệ nhân tạo phát triển từ một lĩnh vực học thuật chuyên biệt thành một lực lượng mang tính cải cách định hình lại các ngành công nghiệp. Ở trung tâm của cuộc cách mạng này là các mô hình nền tảng — những mạng nơ-ron khổng lồ đã thể hiện những năng lực ấn tượng trong ngôn ngữ, lập luận và sáng tạo. Tuy nhiên, câu chuyện thành công của chúng gắn chặt và không thể tách rời với câu chuyện về cơ sở hạ tầng vận hành phía sau. Đây là câu chuyện về sự phát triển theo cấp số nhân, về việc đối mặt với những hạn chế vật lý và về sự đổi mới không ngừng nghỉ cần thiết để xây dựng nền tảng điện toán cho thế hệ trí tuệ tiếp theo.

Bài viết này khám phá lịch sử đầy biến động của hoạt động đào tạo AI, phân tích những nút thắt then chốt đang đe dọa làm chậm bước tiến, đồng thời phác họa tương lai của cơ sở hạ tầng đang được thiết kế để vượt qua những thách thức to lớn đó.

Hành trình dẫn đến những mô hình quy mô hàng nghìn tỷ tham số ngày nay không diễn ra một cách suôn sẻ, mà là một chuỗi những cân bằng ngắt quãng, nơi các bước đột phá về khái niệm chỉ xảy ra khi sức mạnh điện toán đạt đến những cấp độ mới. Trong nhiều thập kỷ, triển vọng của mạng nơ-ron bị hạn chế do thiếu dữ liệu và năng lực xử lý. Mọi chuyện đã thay đổi vào năm 2012.

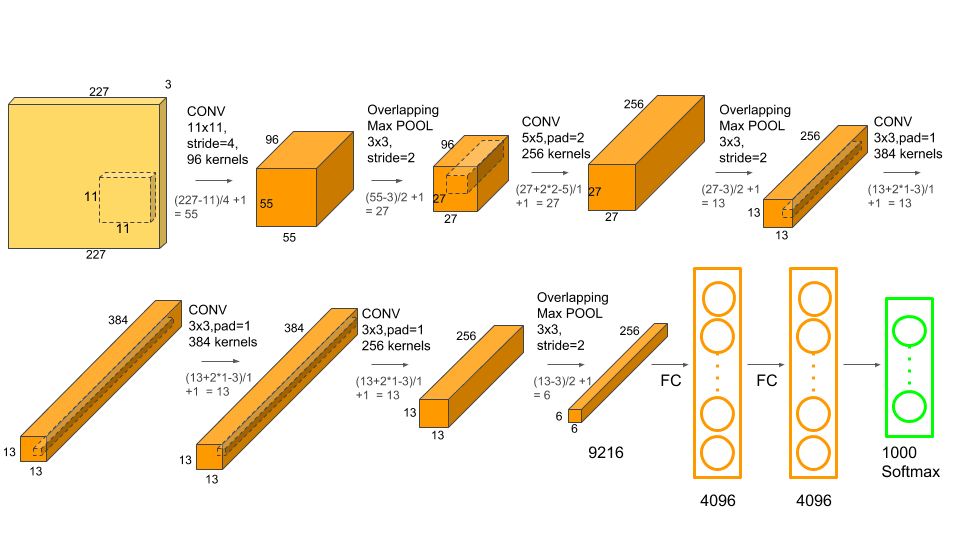

ImageNet Large Scale Visual Recognition Challenge (ILSVRC) năm 2012 được coi là “Vụ nổ khai sinh” của kỷ nguyên AI hiện đại. Mạng nơ-ron tích chập sâu (CNN) có tên AlexNet, do Alex Krizhevsky, Ilya Sutskever và Geoffrey Hinton phát triển, đã đạt được thành công rực rỡ [1]. Mạng này không chỉ giành chiến thắng mà còn phá vỡ kỷ lục với tỷ lệ lỗi 15,3%, một bước nhảy vọt so với tỷ lệ 26,2% của bài dự thi đứng thứ hai.

Thành công của AlexNet không chỉ nhờ vào kiến trúc mới lạ. Điều quan trọng là đây là một trong những mô hình đầu tiên được đào tạo trên Bộ xử lý đồ họa (GPU). Bằng cách tận dụng sức mạnh xử lý song song của hai GPU NVIDIA GTX 580, các nhà nghiên cứu đã có thể đào tạo một mô hình với 60 triệu tham số trên tập dữ liệu 1,2 triệu hình ảnh — một quy mô không thể tưởng tượng được trước đây. Khoảnh khắc này chứng minh rằng khi có đủ dữ liệu và năng lực điện toán, học sâu không chỉ khả thi mà còn vượt trội hơn hẳn các phương pháp truyền thống, thổi bùng một “cuộc bùng nổ kỷ Cambri” trong nghiên cứu AI.

Kiến trúc AlexNet kết hợp các lớp tích chập sâu với khả năng xử lý GPU để đạt được hiệu suất đột phá. Nguồn: Krizhevsky và cộng sự, 2012.

Kiến trúc AlexNet kết hợp các lớp tích chập sâu với khả năng xử lý GPU để đạt được hiệu suất đột phá. Nguồn: Krizhevsky và cộng sự, 2012.

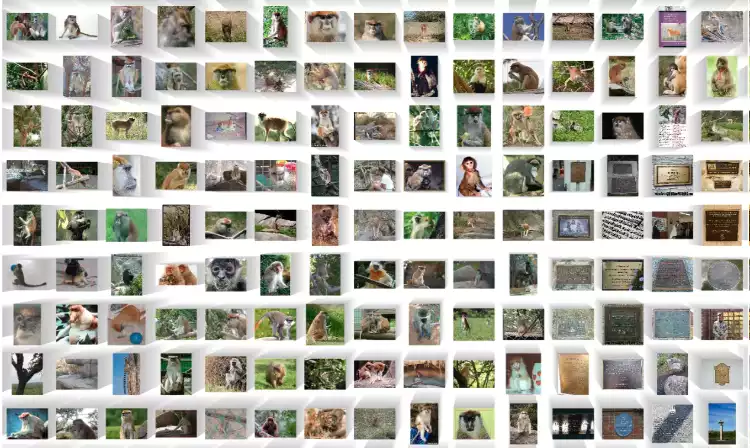

Một mẫu nhỏ trong số hàng triệu hình ảnh được gắn nhãn trong tập dữ liệu ImageNet đã tiếp sức cho cuộc cách mạng học sâu. Nguồn: ImageNet

Một mẫu nhỏ trong số hàng triệu hình ảnh được gắn nhãn trong tập dữ liệu ImageNet đã tiếp sức cho cuộc cách mạng học sâu. Nguồn: ImageNet

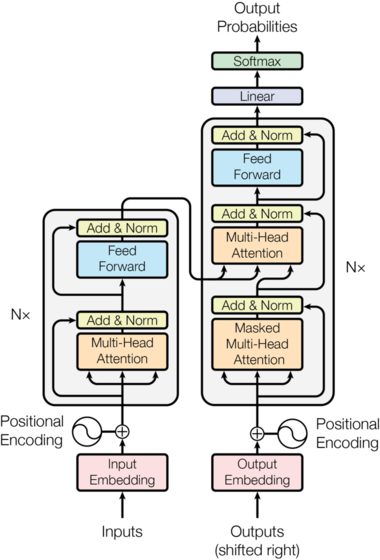

Năm năm sau, một sự thay đổi chấn động khác xảy ra. Năm 2017, một bài viết của Google có tựa đề “Attention Is All You Need” đã giới thiệu kiến trúc Transformer [2]. Thiết kế mới này loại bỏ hoàn toàn các cấu trúc hồi quy và tích chập vốn đã thống trị lĩnh vực trước đó. Thay vào đó, thiết kế này dựa vào một cơ chế gọi là “self-attention” (tự chú ý), cho phép mô hình đánh giá mức độ quan trọng của các từ khác nhau trong cùng một chuỗi thông tin đầu vào một cách đồng thời.

Điểm đổi mới cốt lõi chính là khả năng song song hóa. Không giống như Mạng nơ-ron hồi quy (RNN) xử lý dữ liệu theo trình tự, Transformer có thể xử lý tất cả các phần của thông tin đầu vào cùng một lúc. Sự thay đổi về kiến trúc này hoàn toàn phù hợp với bản chất song song khổng lồ của GPU, mở ra khả năng đào tạo các mô hình lớn hơn và phức tạp hơn rất nhiều với tốc độ chưa từng có. Transformer đã trở thành bản thiết kế nền tảng cho hầu hết các mô hình ngôn ngữ lớn (LLM) về sau, bao gồm dòng GPT.

Kiến trúc Transformer ban đầu được giới thiệu trong bài viết "Attention Is All You Need". Nguồn: Vaswani và cộng sự, 2017.

Kiến trúc Transformer ban đầu được giới thiệu trong bài viết "Attention Is All You Need". Nguồn: Vaswani và cộng sự, 2017.

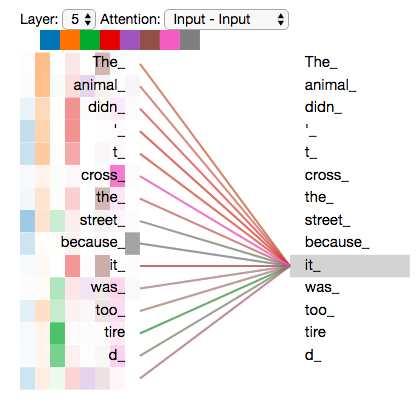

Hình ảnh trực quan về cơ chế tự chú ý, cho phép mô hình đánh giá tầm quan trọng của các từ khác nhau trong một câu. Nguồn: Jay Alammar

Hình ảnh trực quan về cơ chế tự chú ý, cho phép mô hình đánh giá tầm quan trọng của các từ khác nhau trong một câu. Nguồn: Jay Alammar

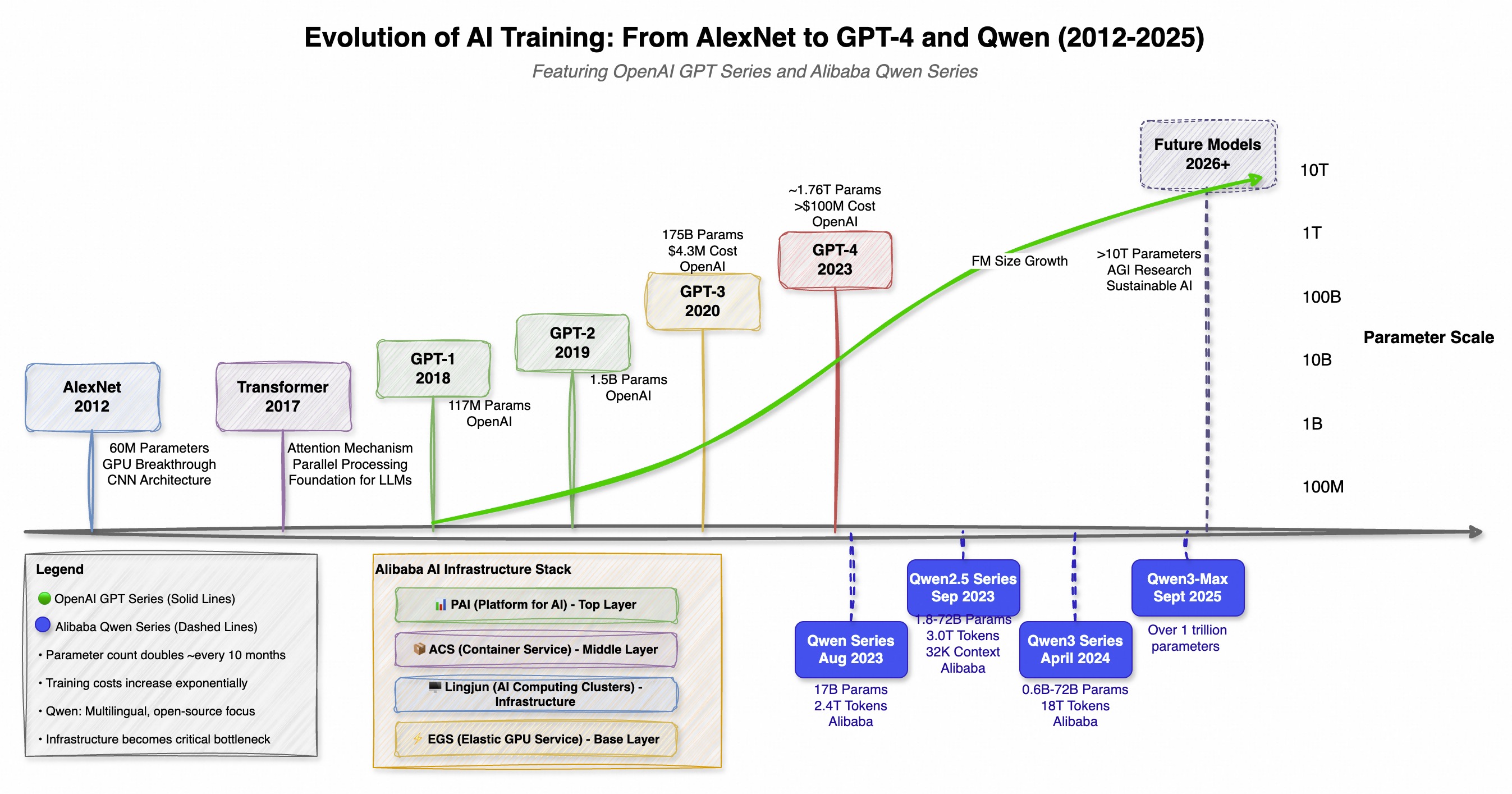

Sự ra đời của Transformer đã khởi động một cuộc chạy đua vũ trang về năng lực điện toán trên toàn cầu. Quy mô, chi phí và độ phức tạp của các mô hình AI bắt đầu tăng theo cấp số nhân. Xu hướng này không chỉ được minh chứng bởi một công ty, mà còn bởi những phát triển song song trên toàn cầu, đáng chú ý nhất là dòng GPT của OpenAI ở phương Tây và dòng Qwen (通义千问) của Alibaba ở phương Đông. Cả hai đều đã mở rộng ranh giới về quy mô, nhưng theo những triết lý khác nhau: GPT tập trung vào các chức năng đột phá, còn Qwen nhấn mạnh vào phương pháp tiếp cận đa ngôn ngữ và nguồn mở mạnh mẽ.

Sự phát triển theo hai hướng này làm nổi bật cuộc chạy đua nước rút toàn cầu hướng tới AI mạnh mẽ và hiệu quả hơn, trong đó mỗi lần ra mắt mô hình mới đều đặt ra tiêu chuẩn cao hơn cho phiên bản tiếp theo.

| Mô hình | Ngày phát hành | Tham số | Điểm đổi mới chính/Trọng tâm |

|---|---|---|---|

| GPT-1 | 2018 | 117 triệu | Tiền đào tạo không giám sát (OpenAI) |

| GPT-2 | 2019 | 1,5 tỷ | Hiệu suất thực hiện tác vụ chưa được đào tạo (OpenAI) |

| GPT-3 | 2020 | 175 tỷ | Học theo ngữ cảnh với ít hoặc không cần ví dụ mẫu (OpenAI) |

| Qwen-7B | 08/2023 | 7 tỷ | Cơ sở đa ngôn ngữ nguồn mở mạnh mẽ (Alibaba) |

| GPT-4 | 09/2023 | ~1,76 nghìn tỷ (MoE) | Lập luận nâng cao, đa phương thức (OpenAI) |

| Qwen-72B | 11/2023 | 5-72 tỷ | Dung lượng ngữ cảnh 32K, mã nguồn mở (Alibaba) |

| Qwen2.5 | 09/2024 | Lên đến 72 tỷ | Được đào tạo trên 18T token, cải thiện khả năng lập trình/toán học (Alibaba) |

| Qwen3-Max | 09/2025 | ~1 nghìn tỷ | Mô hình lớn nhất và năng lực nhất của Qwen cho đến nay (Alibaba) |

Sự phát triển bùng nổ này — khi nhu cầu điện toán tăng gấp đôi sau mỗi năm đến sáu tháng — đã đẩy việc phát triển AI tiên phong vào một lĩnh vực mà chỉ một số ít tập đoàn quy mô siêu lớn đủ vốn để xây dựng và vận hành những siêu máy tính tầm cỡ quy mô hành tinh mới có thể tiếp cận [5].

Dòng thời gian cho thấy sự phát triển song song của dòng GPT của OpenAI và dòng Qwen của Alibaba, làm nổi bật cuộc đua toàn cầu trong việc phát triển mô hình nền tảng.

Dòng thời gian cho thấy sự phát triển song song của dòng GPT của OpenAI và dòng Qwen của Alibaba, làm nổi bật cuộc đua toàn cầu trong việc phát triển mô hình nền tảng.

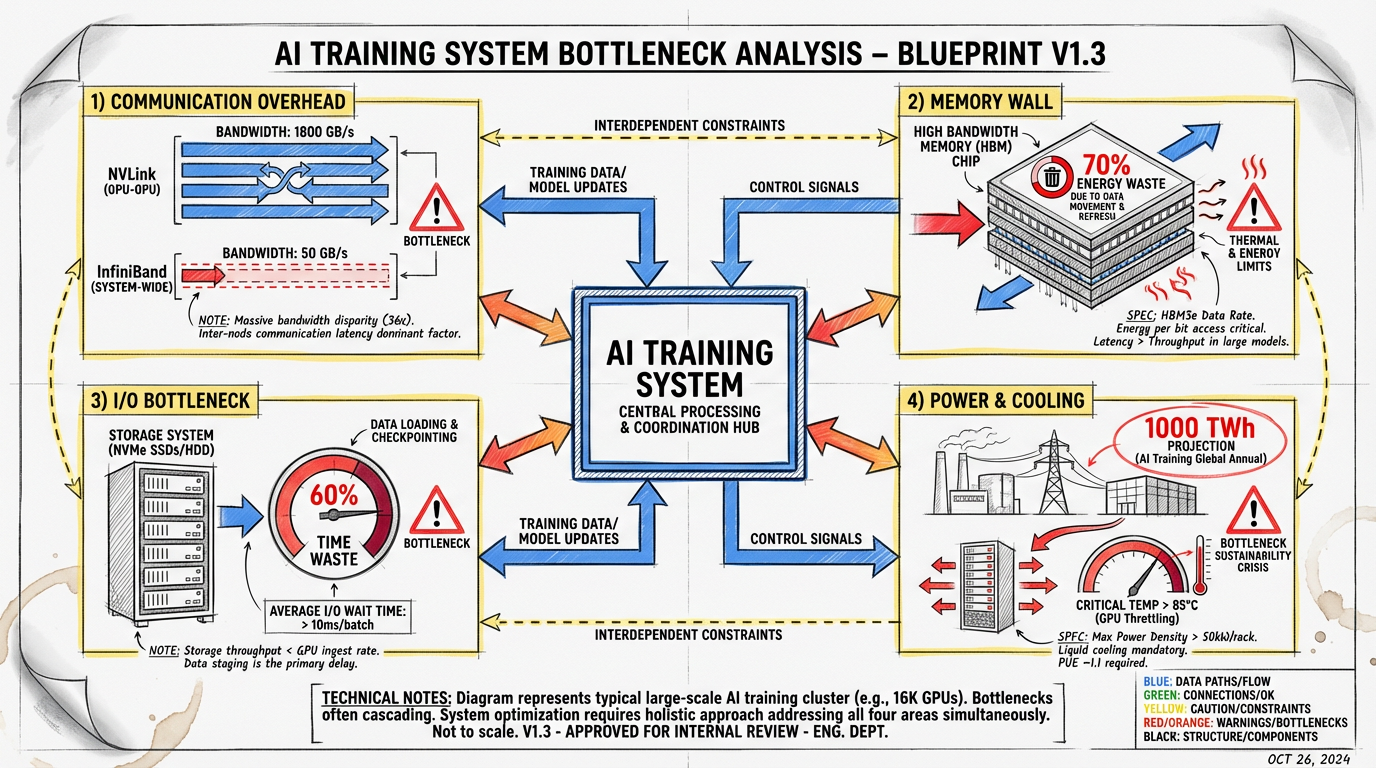

Cuộc chạy đua không ngừng về quy mô này đã đẩy cơ sở hạ tầng nền tảng đến gần điểm giới hạn. Việc đào tạo một mô hình nghìn tỷ tham số không chỉ đơn giản là bổ sung thêm nhiều GPU; đó là một thách thức kỹ thuật phức tạp, đầy rẫy những nút thắt về mặt vật lý và hệ thống. Mục tiêu chính là tận dụng tối đa mọi bộ xử lý đắt tiền, nhưng có rất nhiều vấn đề cản trở.

Các nhà máy AI hiện đại là những trung tâm dữ liệu khổng lồ chứa hàng nghìn GPU kết nối với nhau. Nguồn: NVIDIA

Các nhà máy AI hiện đại là những trung tâm dữ liệu khổng lồ chứa hàng nghìn GPU kết nối với nhau. Nguồn: NVIDIA

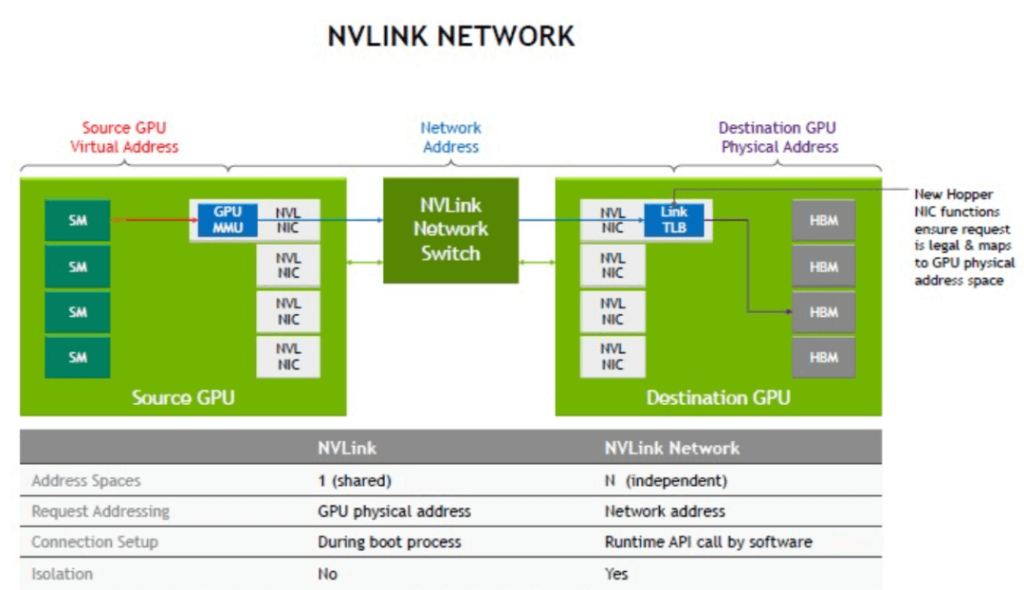

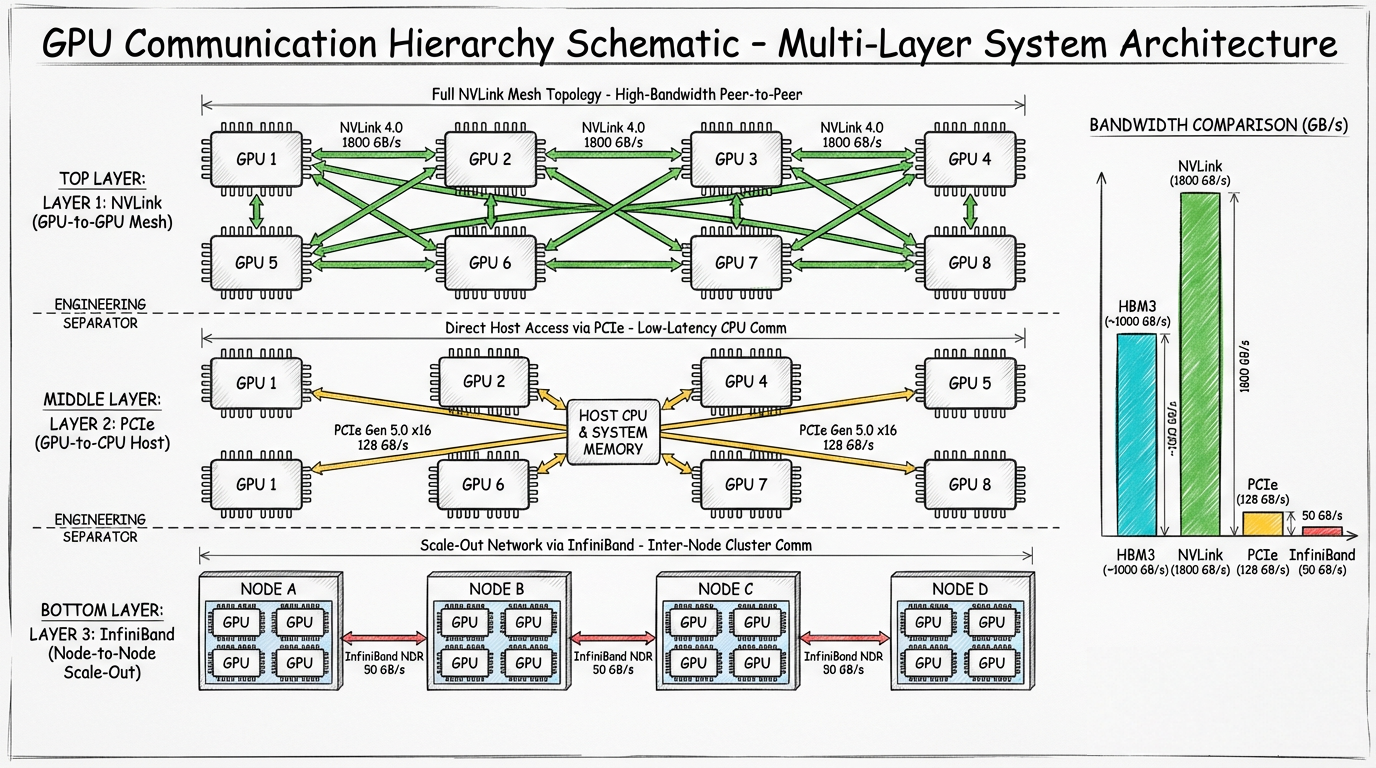

Trong đào tạo phân tán, một mô hình được phân bổ trên hàng nghìn GPU, mỗi GPU xử lý một phần của bức tranh tổng thể. Bước quan trọng và tốn thời gian nhất là đồng bộ gradient, trong đó tất cả GPU phải trao đổi kết quả của mình để thống nhất về đợt cập nhật tiếp theo cho trọng số của mô hình. Điều này tạo ra một nút thắt giao tiếp lớn.

Sơ đồ công nghệ NVLink của NVIDIA, cung cấp khả năng giao tiếp trực tiếp tốc độ cao giữa các GPU trong một máy chủ. Nguồn: NVIDIA

Sơ đồ công nghệ NVLink của NVIDIA, cung cấp khả năng giao tiếp trực tiếp tốc độ cao giữa các GPU trong một máy chủ. Nguồn: NVIDIA

Sơ đồ cho thấy tình trạng tắc nghẽn giao tiếp trong cách thiết lập đào tạo phân tán, trong đó các GPU giao tiếp với nhau và với cấu trúc mạng.

Sơ đồ cho thấy tình trạng tắc nghẽn giao tiếp trong cách thiết lập đào tạo phân tán, trong đó các GPU giao tiếp với nhau và với cấu trúc mạng.

Các mô hình AI hiện đại tiêu thụ bộ nhớ rất nhiều. Các tham số, trạng thái của bộ tối ưu hóa và hoạt động kích hoạt trung gian cho mô hình nghìn tỷ tham số có thể yêu cầu dung lượng lưu trữ lên tới hàng terabyte, vượt xa bộ nhớ có sẵn trên một GPU (thường là 80-120 GB). Điều này dẫn đến vấn đề “bức tường bộ nhớ”.

Dữ liệu phải liên tục được di chuyển qua lại giữa bộ nhớ băng thông cao (HBM) của GPU và RAM hệ thống chậm hơn hay thậm chí là bộ nhớ mạng. Hoạt động di chuyển dữ liệu này không chỉ chậm mà còn tiêu tốn rất nhiều năng lượng. Theo NVIDIA, có tới 70% năng lượng trong khối lượng công việc GPU thông thường được tiêu thụ chỉ để di chuyển dữ liệu [8].

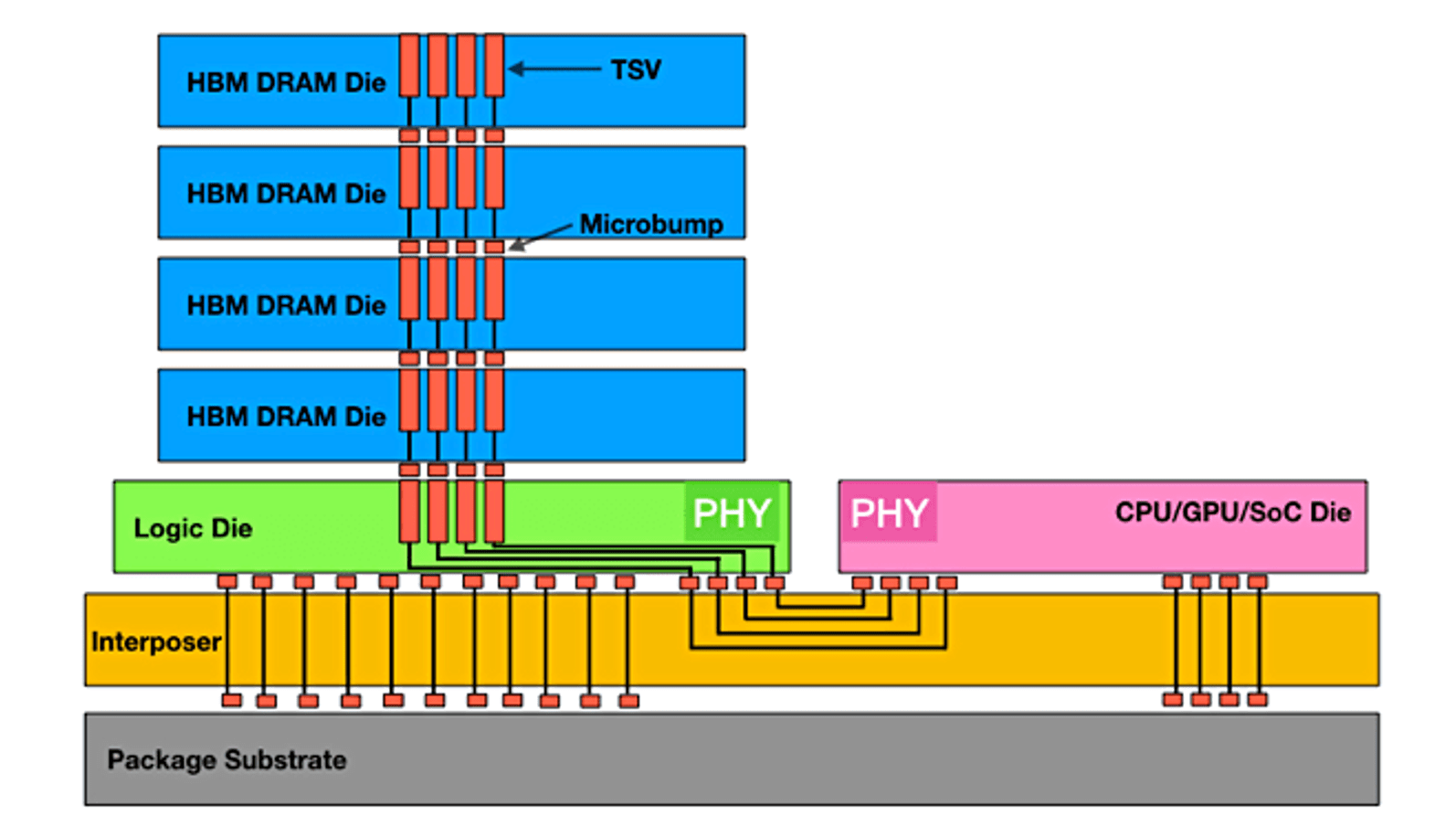

Bộ nhớ băng thông cao (HBM) xếp chồng các chip bộ nhớ theo chiều dọc để cung cấp băng thông lớn mà GPU hiện đại yêu cầu, nhưng đây vẫn là một nguồn tài nguyên hữu hạn và đắt đỏ. Nguồn: Semiconductor Engineering

Bộ nhớ băng thông cao (HBM) xếp chồng các chip bộ nhớ theo chiều dọc để cung cấp băng thông lớn mà GPU hiện đại yêu cầu, nhưng đây vẫn là một nguồn tài nguyên hữu hạn và đắt đỏ. Nguồn: Semiconductor Engineering

Trước khi có thể bắt đầu tính toán, GPU cần có dữ liệu. Trong nhiều tình huống đào tạo quy mô lớn, quy trình tải dữ liệu đào tạo từ bộ lưu trữ vào GPU có thể trở thành một nút thắt lớn. Hệ thống tệp song song hiệu suất cao được yêu cầu phải cung cấp dữ liệu ở tốc độ terabyte mỗi giây để cung cấp dữ liệu cho hàng chục nghìn GPU. Nếu không tối ưu hóa đường truyền dữ liệu một cách hoàn hảo, GPU có thể sẽ không hoạt động, gây lãng phí hàng triệu đô la tiềm năng điện toán. Trong một số trường hợp, việc tải dữ liệu có thể tiêu tốn hơn 60% tổng thời gian đào tạo, làm giảm một nửa hiệu quả của toàn bộ cụm [9].

Lượng năng lượng cần thiết để vận hành các nhà máy AI này thật sự khổng lồ. Một đợt đào tạo quy mô lớn có thể tiêu thụ lượng điện tương đương với một thành phố nhỏ. Cơ quan Năng lượng Quốc tế ước tính rằng lượng điện sử dụng tại trung tâm dữ liệu có thể tăng gấp đôi lên 1.000 terawatt-giờ vào năm 2026, chủ yếu do sự phát triển của AI [10]. Mức tiêu thụ điện khổng lồ này tạo ra một lượng nhiệt cực lớn, kéo theo một thách thức song song trong việc làm mát. Phương pháp làm mát bằng không khí truyền thống ngày càng không đủ, buộc ngành này phải chuyển sang các giải pháp đặc biệt hơn như làm mát bằng chất lỏng hoặc ngâm chìm, nhằm xử lý mật độ nhiệt cực cao của phần cứng AI hiện đại.

Các giá máy chủ GPU dày đặc tạo ra lượng nhiệt khổng lồ, khiến việc làm mát trở thành một thách thức cơ sở hạ tầng cực kỳ quan trọng. Nguồn: AMAX

Các giá máy chủ GPU dày đặc tạo ra lượng nhiệt khổng lồ, khiến việc làm mát trở thành một thách thức cơ sở hạ tầng cực kỳ quan trọng. Nguồn: AMAX

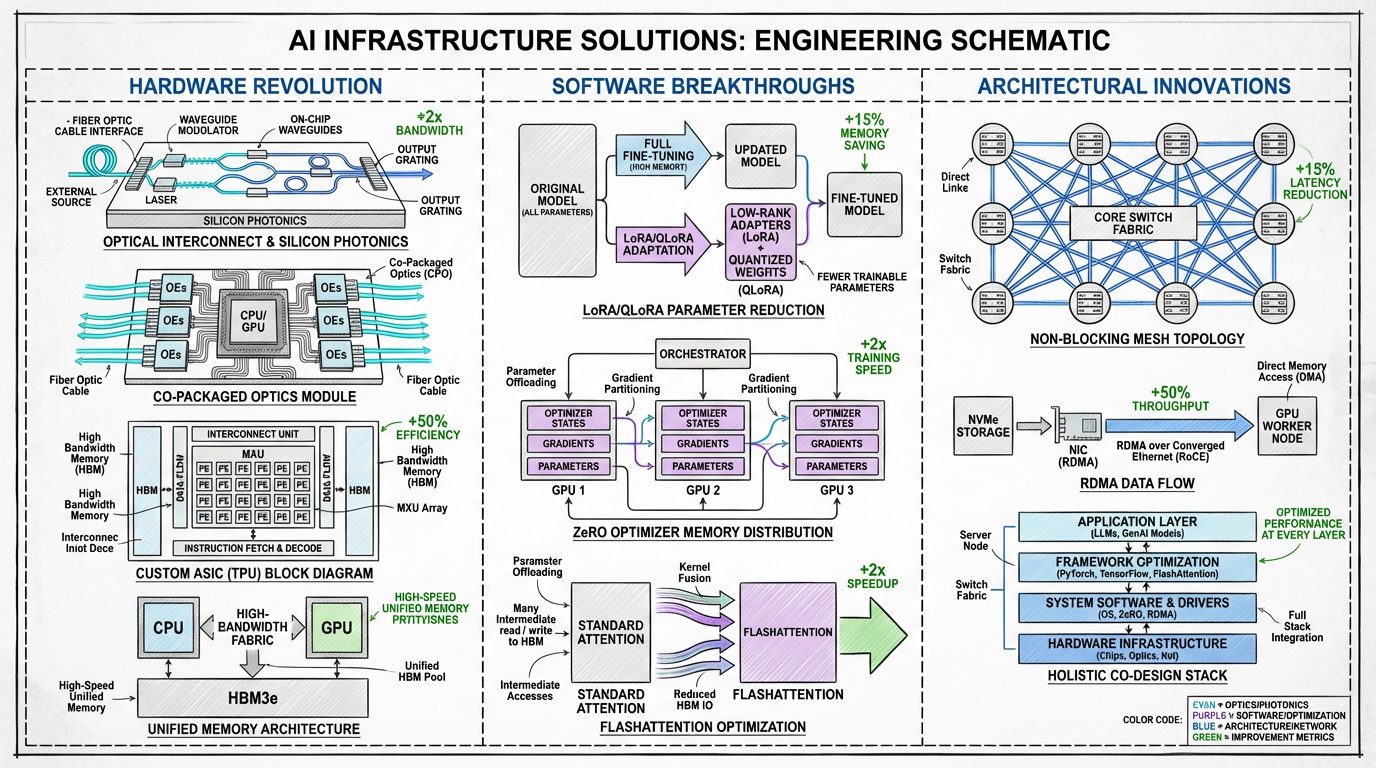

Ngành công nghiệp đang giải quyết những nút thắt này bằng phương pháp đa hướng, đổi mới cả phần cứng, phần mềm và kiến trúc hệ thống. Tương lai của cơ sở hạ tầng AI không chỉ là những con chip mạnh mẽ hơn, mà còn là hệ thống đồng thiết kế tổng thể, trong đó mọi thành phần đều được tối ưu hóa để đạt hiệu quả và quy mô.

Sơ đồ các giải pháp đề xuất để khắc phục nút thắt cơ sở hạ tầng.

Sơ đồ các giải pháp đề xuất để khắc phục nút thắt cơ sở hạ tầng.

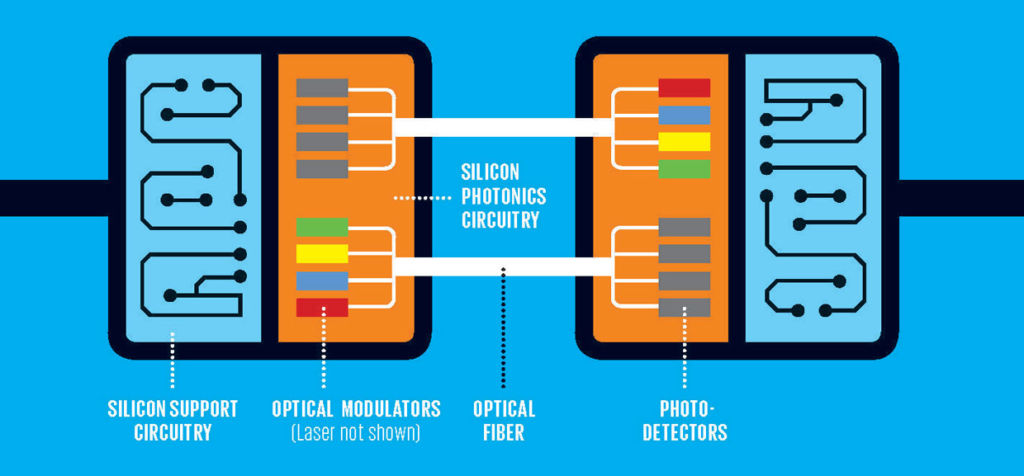

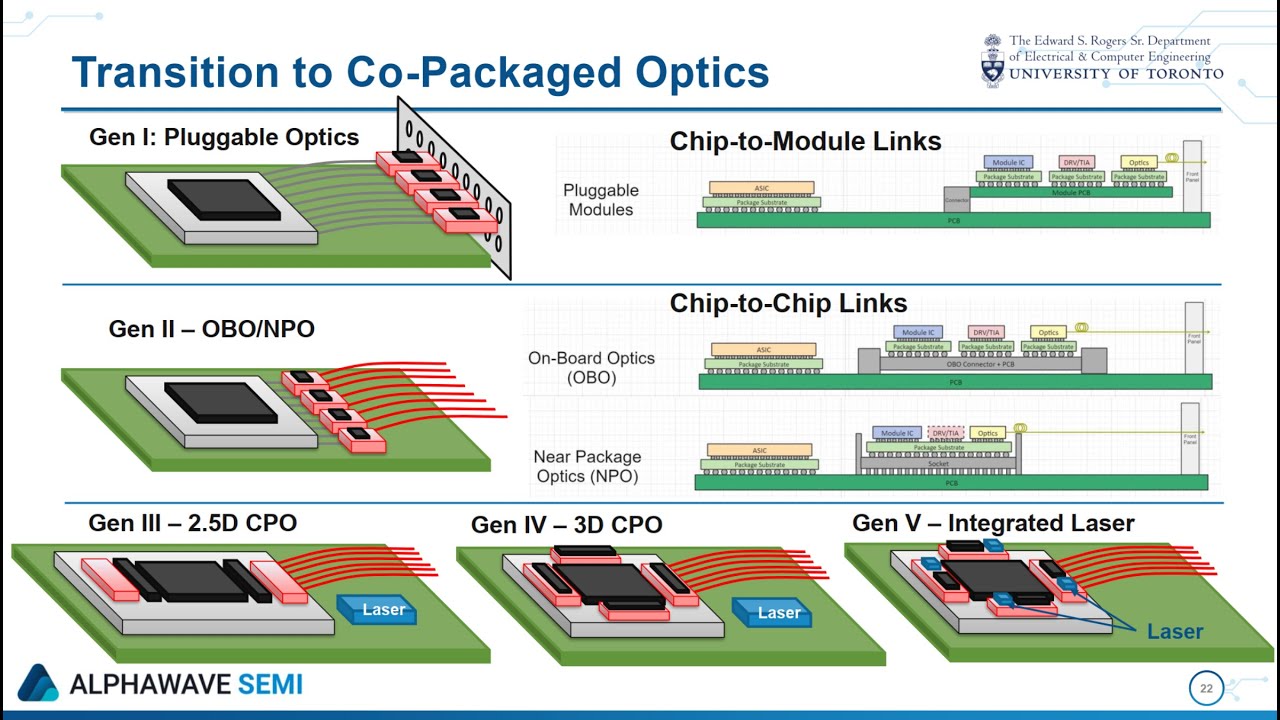

Kết nối quang học: Sự thay đổi sâu sắc nhất đang diễn ra là sự chuyển đổi từ kết nối điện (đồng) sang kết nối quang học (ánh sáng). Công nghệ quang tử silicon hứa hẹn có thể truyền dữ liệu ở tốc độ terabit mỗi giây với độ trễ và mức tiêu thụ điện năng thấp hơn đáng kể. Công nghệ quang đồng đóng gói, tích hợp trực tiếp các cổng quang vào cùng gói bộ xử lý, sẽ loại bỏ nhu cầu sử dụng các hình thức kết nối điện vốn chậm và tốn năng lượng, qua đó giải quyết trực tiếp các nút thắt về truyền thông và tiêu thụ điện năng [11].

Công nghệ quang tử silicon sử dụng ánh sáng để truyền dữ liệu, giúp tăng băng thông vượt trội và giảm đáng kể điện năng tiêu thụ so với dây dẫn đồng truyền thống. Nguồn: FindLight

Công nghệ quang tử silicon sử dụng ánh sáng để truyền dữ liệu, giúp tăng băng thông vượt trội và giảm đáng kể điện năng tiêu thụ so với dây dẫn đồng truyền thống. Nguồn: FindLight

Công nghệ quang đồng đóng gói (CPO) tích hợp bộ thu quang trực tiếp với chip xử lý, giảm thiểu khoảng cách truyền dữ liệu và tăng tối đa hiệu quả. Nguồn: Anritsu

Công nghệ quang đồng đóng gói (CPO) tích hợp bộ thu quang trực tiếp với chip xử lý, giảm thiểu khoảng cách truyền dữ liệu và tăng tối đa hiệu quả. Nguồn: Anritsu

Bộ tăng tốc thế hệ mới: Dù GPU vẫn giữ vị thế thống trị, bức tranh công nghệ đang dần trở nên đa dạng hơn. ASIC (Application-Specific Integrated Circuit) tùy chỉnh như TPU của Google và MTIA của Meta được thiết kế để xử lý khối lượng công việc AI cụ thể, mang lại hiệu suất và hiệu quả vượt trội cho các tác vụ mục tiêu tương ứng. Xu hướng này hướng tới các bộ tăng tốc dành riêng cho từng miền sẽ giúp có cơ sở hạ tầng được tối ưu hóa hơn, vượt ra khỏi khuôn mẫu một GPU dùng cho mọi thứ.

Kiến trúc bộ nhớ thống nhất: Để phá vỡ bức tường bộ nhớ, các công ty đang phát triển các chipset tích hợp chặt chẽ. Ví dụ, Grace Hopper Superchip của NVIDIA kết hợp CPU và GPU trên một mô-đun duy nhất với kết nối tốc độ cao và đồng bộ. Cách này cho phép cả hai bộ xử lý dùng chung một nhóm bộ nhớ duy nhất, làm giảm đáng kể việc di chuyển dữ liệu vốn tốn kém giữa các miền bộ nhớ của CPU và GPU.

Tinh chỉnh hiệu quả tham số (PEFT): Không phải mọi tác vụ đều yêu cầu đào tạo lại một mô hình trị giá hàng tỷ đô la từ đầu. Các kỹ thuật như LoRA (Low-Rank Adaptation) và QLoRA cho phép tinh chỉnh hiệu quả bằng cách chỉ cập nhật một phần nhỏ các tham số của mô hình [12]. Phương pháp này làm giảm đáng kể yêu cầu về điện toán và bộ nhớ, giúp nhiều người dùng và tổ chức hơn dễ dàng điều chỉnh mô hình.

Trình tối ưu hóa và thuật toán tiên tiến: Những cải tiến về phần mềm đang đóng vai trò quan trọng trong việc cải thiện hiệu quả. ZeRO (Zero Redundancy Optimizer) của Microsoft phân vùng trạng thái của mô hình trên các GPU có sẵn, cho phép đào tạo các mô hình lớn với bộ nhớ ít hơn đáng kể trên mỗi thiết bị [13]. Các thuật toán như FlashAttention thiết kế lại cơ chế chú ý để giảm số lần đọc/ghi bộ nhớ, từ đó tăng tốc đáng kể và giảm dung lượng bộ nhớ.

Các siêu máy tính AI chuyên dụng đang tích hợp các giải pháp phần cứng và phần mềm này thành một tổng thể thống nhất. Một xu hướng quan trọng trong lĩnh vực này là sự phát triển của kiến trúc siêu nút, nhằm mục đích tạo ra các đơn vị điện toán lớn hơn, mạnh hơn và hiệu quả hơn. Các kiến trúc này tái định hình giá đỡ máy chủ truyền thống nhằm tối ưu hóa cho khối lượng công việc chuyên biệt của AI.

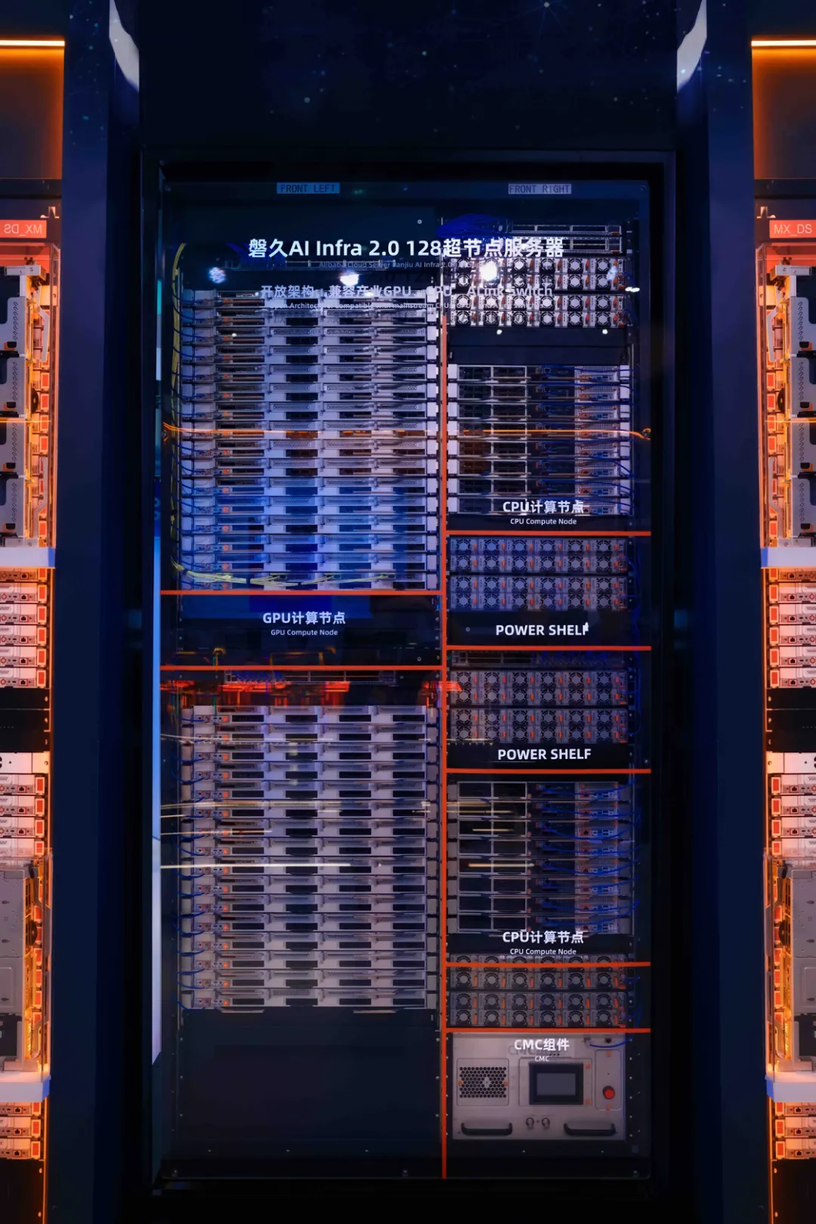

Một ví dụ nổi bật là nền tảng Lingjun của Alibaba Cloud, sử dụng thiết kế siêu nút Panjiu AL128. Kiến trúc này thể hiện sự chuyển dịch sang một hệ thống theo mô-đun và tách biệt hơn. Các tính năng chính bao gồm:

Kiến trúc siêu nút Panjiu AL128, có thiết kế kết nối trực giao và các mô-đun tách biệt cho CPU, GPU và điện năng. Nguồn: Alibaba Cloud

Kiến trúc siêu nút Panjiu AL128, có thiết kế kết nối trực giao và các mô-đun tách biệt cho CPU, GPU và điện năng. Nguồn: Alibaba Cloud

Mặc dù các hệ thống mật độ cao, tích hợp chặt chẽ như vậy giúp hiệu suất tăng đáng kể (Alibaba tuyên bố cải thiện 50% hiệu suất suy luận với cùng sức mạnh điện toán), nhưng chúng cũng đặt ra nhiều thách thức. Ưu điểm bao gồm hiệu quả cao hơn, độ trễ giao tiếp thấp hơn và khả năng mở rộng lớn hơn trong siêu nút. Tuy nhiên, nhược điểm gồm có độ phức tạp cao hơn, phụ thuộc vào phần cứng và kết nối tùy chỉnh (như UALink) và nhu cầu về cơ sở hạ tầng làm mát bằng chất lỏng và nguồn điện phức tạp, có thể làm tăng vốn và chi phí vận hành.

Những cải tiến về kiến trúc này, kết hợp với các kỹ thuật khác, đang tạo ra một bản thiết kế mới cho các nhà máy AI:

Để tìm hiểu chi tiết hơn về mặt kỹ thuật của kiến trúc Panjiu AL128, hãy xem phân tích chi tiết và video tổng quan từ Alibaba Cloud tại đây và tại đây.

Kỷ nguyên đầu tiên của cuộc cách mạng AI được định nghĩa bằng khả năng mở rộng mạnh mẽ — mô hình lớn hơn, nhiều dữ liệu hơn và khả năng điện toán cao hơn. Mặc dù quy mô luôn quan trọng, nhưng kỷ nguyên tiếp theo sẽ được xác định bằng hiệu quả và mức độ tinh tế. Tương lai của AI không chỉ là xây dựng các mô hình lớn hơn, mà còn là xây dựng cơ sở hạ tầng thông minh hơn, bền vững hơn và dễ tiếp cận hơn nhằm đào tạo và vận hành chúng.

Hành trình từ lần đầu tiên AlexNet sử dụng GPU cho đến các nhà máy AI quang học được đồng thiết kế của tương lai là minh chứng cho tốc độ đổi mới không ngừng nghỉ. Vượt qua các nút thắt về giao tiếp, bộ nhớ và điện năng là thách thức lớn của thời đại chúng ta, và những giải pháp đang được phát triển hôm nay sẽ đặt nền móng cho làn sóng trí tuệ nhân tạo tiếp theo.

[1] Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems 25.

[2] Vaswani, A., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems 30.

[3] Visual Capitalist. (2023). Charted: The Skyrocketing Cost of Training AI Models Over Time.

[4] Forbes. (2024). The Extreme Cost of Training AI Models.

[5] R&D World. (2024). AI’s great compression: 20 charts show vanishing gaps but still soaring costs.

[6] NVIDIA. (2024). NVIDIA GB200 NVL72.

[7] Zhai, E., et al. (2024). HPN: A Non-blocking, Dual-plane, Application-layer-agnostic High-performance Network for Large-scale AI Training. SIGCOMM 2024.

[8] Szasz, D. (2024). Understanding Bottlenecks in Multi-GPU AI Training. Medium.

[9] Alibaba Cloud. (2024). PAI-Lingjun Intelligent Computing Service Features.

[10] Forbes. (2025). Why Optical Infrastructure Is Becoming Core To The Future Of AI.

[11] Yole Group. (2023). Co-Packaged Optics for Datacenters 2023.

[12] Dettmers, T., et al. (2023). QLoRA: Efficient Finetuning of Quantized LLMs. Advances in Neural Information Processing Systems 36.

[13] Microsoft Research. (2020). ZeRO & DeepSpeed: New system optimizations enable training models with over 100 billion parameters.

[14] Alibaba Cloud. (2025). In-depth Analysis of Alibaba Cloud Panjiu AL128 Supernode AI Servers and Their Interconnect Architecture. Alibaba Cloud Blog.

[15] Alibaba Cloud. (2025). Panjiu AL128 Supernode AI Server Video Overview. YouTube.

Bài viết này là bản dịch của phiên bản tiếng Anh gốc. Để biết nội dung nguồn, vui lòng truy cập: https://www.alibabacloud.com/blog/from-brute-force-to-finesse-the-evolution-and-future-of-ai-training-infrastructure_602718

Dari Brute Force menjadi Finesse: Evolusi dan Masa Depan Infrastruktur Pelatihan AI

จากการทดลองทุกความเป็นไปได้สู่ความประณีต: วิวัฒนาการและอนาคตของโครงสร้างพื้นฐานการฝึก AI

127 posts | 4 followers

FollowRegional Content Hub - July 14, 2025

Regional Content Hub - May 7, 2025

Regional Content Hub - May 13, 2024

Regional Content Hub - June 3, 2024

Regional Content Hub - April 14, 2025

Regional Content Hub - January 6, 2025

127 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Bastionhost

Bastionhost

A unified, efficient, and secure platform that provides cloud-based O&M, access control, and operation audit.

Learn More Managed Service for Grafana

Managed Service for Grafana

Managed Service for Grafana displays a large amount of data in real time to provide an overview of business and O&M monitoring.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn MoreMore Posts by Regional Content Hub