本記事の作成者:Farruh Kushnazarov

世界の人々は、人工知能が一部の研究者だけが扱っていたニッチな学術領域から産業を再構築するほどの大きな波へと進化していく様子を驚きをもって見つめてきました。 この革命の中心にあるのは、基盤モデルです。これは、言語、推論、創造性において息を呑むような能力を実証した巨大なニューラルネットワークです。 しかし、この成功は、それを支えるインフラストラクチャの話と密接に関連しています。 今回は、指数関数的な成長、物理的限界に対する挑戦、そして次世代インテリジェンスのための計算基盤を構築するために必要だった絶え間ない革新の物語です。

この記事では、AI トレーニングのドラマチックな歴史を振り返り、進歩を停滞させる恐れのある重大なボトルネックを分析し、これらの大きな課題を克服するために開発が進められているインフラストラクチャの未来を探ります。

今日の 1 兆個のパラメーターモデルへの道のりは決して直線的なものではなく、ほとんど変化しなかった期間と急激に変化した期間の繰り返しであり、新しいレベルの計算能力によって概念的なブレークスルーがもたらされました。 何十年もの間、ニューラルネットワークの可能性は、限られたデータおよび処理能力によって制約されていました。 しかし、2012 年にすべてが変わりました。

2012 年の ImageNet Large Scale Visual Recognition Challenge (ILSVRC) は、現在の AI 時代の「ビッグバン」であったと広く考えられています。 Alex Krizhevsky、Ilya Sutskever、Geoffrey Hinton によって開発された AlexNet という名前の深層畳み込みニューラルネットワーク (CNN) が驚くべき勝利を収めました [1]。 しかも、ただ勝利しただけではなく、15.3% のエラー率で記録を打ち破りました。これは第 2 位の 26.2% を大きく引き離していました。

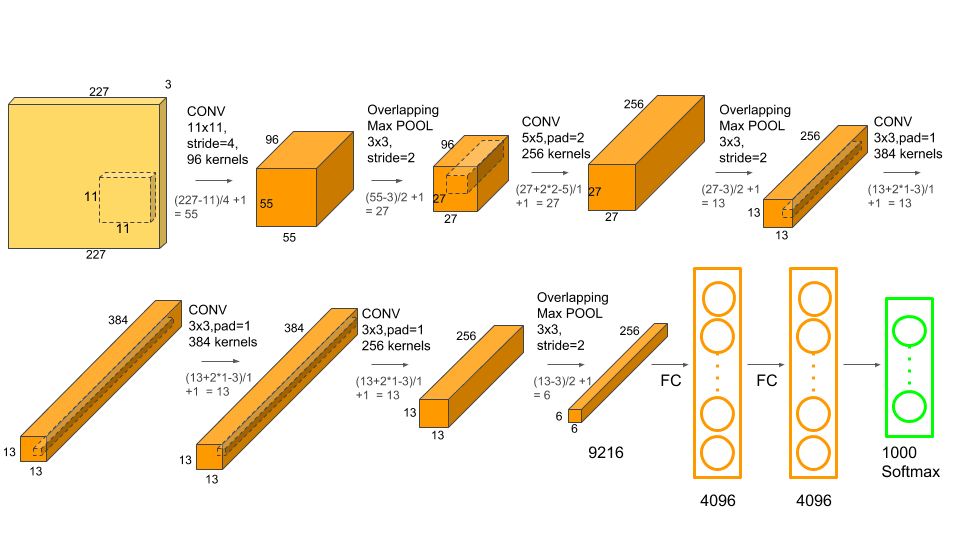

AlexNet の成功は、その斬新なアーキテクチャだけではありませんでした。 非常に重要なのは、これがグラフィックス処理装置 (GPU) でトレーニングされた最初のモデルの 1 つだったということです。 2 個の NVIDIA GTX 580 GPU の並列処理能力を活用することで、研究者はこれまで想像もできなかった 120 万画像のデータセットで、6,000 万のパラメーターを持つモデルをトレーニングすることができました。 このとき、十分なデータと計算により深層学習が実行可能であるだけでなく、従来の方法よりもはるかに優れていることが証明され、AI 研究におけるカンブリア爆発が起きました。

深層畳み込み層と GPU 処理を組み合わせて画期的なパフォーマンスを実現した AlexNet。 出典:Krizhevsky et al.、2012 年。

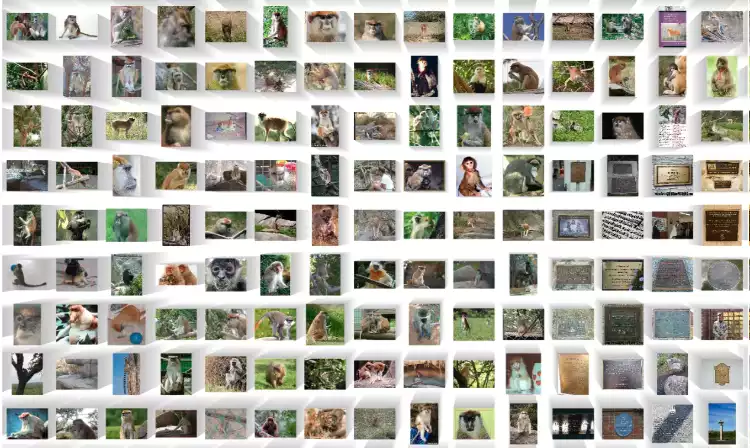

深層学習革命に火をつけた ImageNet データセット内の数百万のラベル付き画像のサンプルの一部。 出典:ImageNet

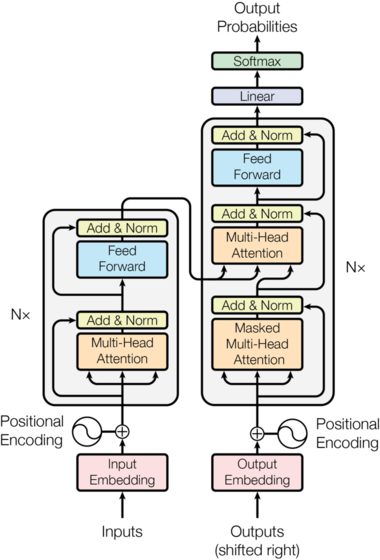

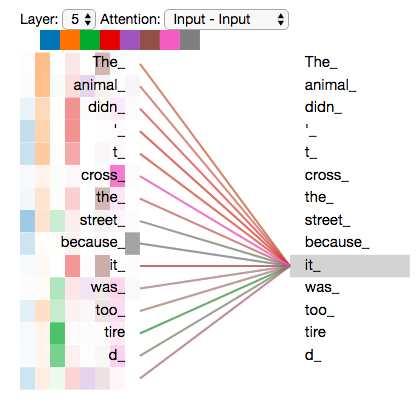

5 年後、新たな地殻変動が発生しました。 2017 年の Google の論文「Attention Is All You Need」で、トランスフォーマーアーキテクチャ [2] が紹介されました。 この新しい設計では、この分野を支配していた再帰構造と畳み込み構造を完全に不要とし、 その代わりに、「自己注意」と呼ばれるメカニズムに依存していました。これにより、モデルは入力シーケンス内のさまざまな単語の重要性を同時に評価することができました。

重要なイノベーションは並列化でした。 データを順次処理する再帰ニューラルネットワーク (RNN) とは異なり、トランスフォーマーは入力のすべての部分を一度に処理できます。 アーキテクチャ上のこの変更は、GPU の大規模な並列性に完全にマッチし、非常に大きく複雑なモデルを前例のない速度でトレーニングできるようになりました。 トランスフォーマーは、GPT シリーズを含む、その後のほぼすべての大規模言語モデル (LLM) の基本的な青写真になりました。

論文「Attention Is All You Need」で紹介されたオリジナルのトランスフォーマーアーキテクチャ。 出典:Vaswani et al.、2017年。

自己注意メカニズムを視覚化したもの。モデルは文内のさまざまな単語の重要性を比較検討できます。 出典:Jay Alammar

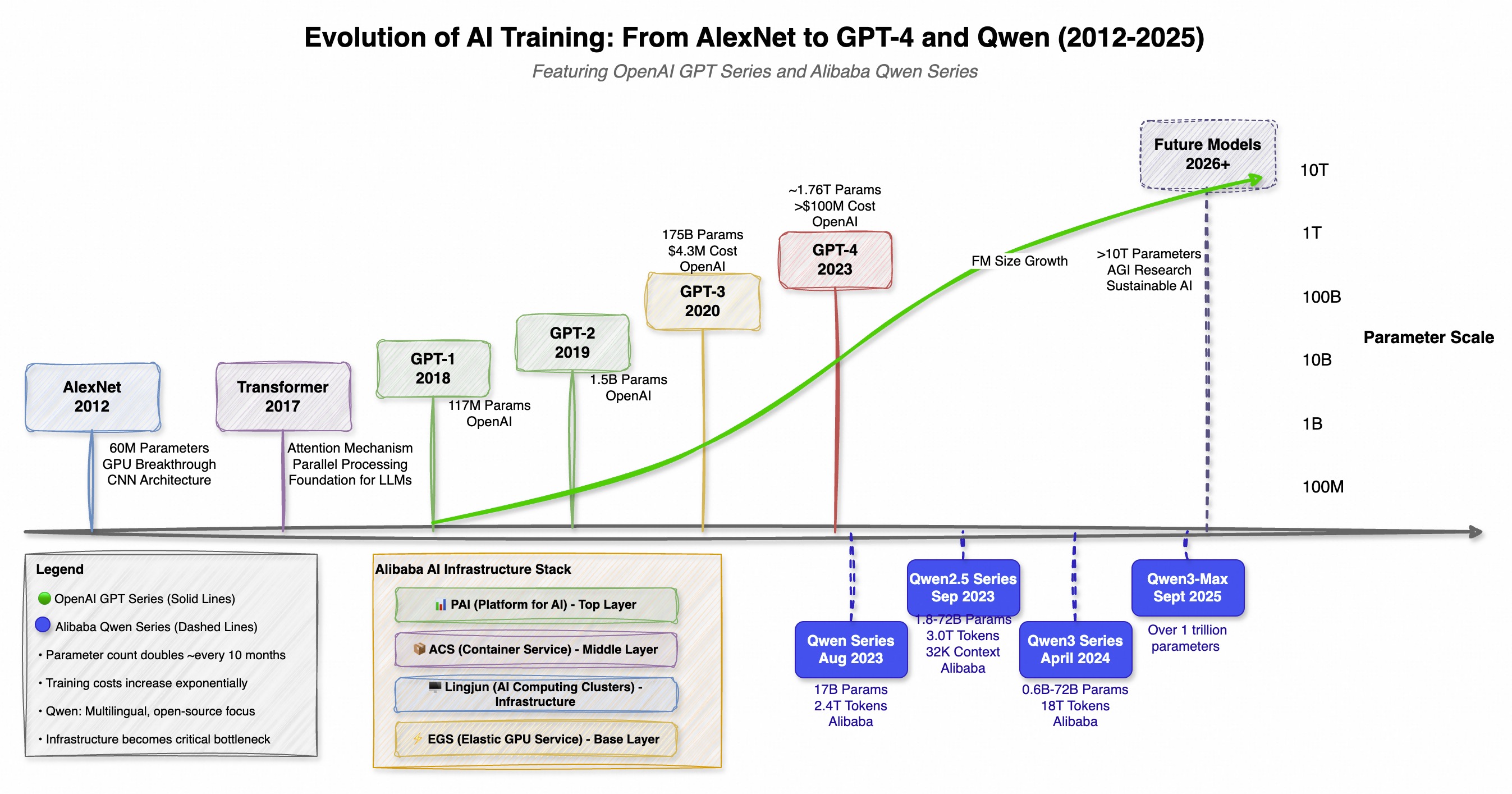

トランスフォーマーが紹介されたことで、世界規模で計算の競争が始まりました。 AI モデルのサイズ、コスト、複雑さは指数関数的に増加し始めました。 この傾向は、1 つの企業だけでなく、特に西側では OpenAI の GPT シリーズ、東側では Alibaba の Qwen (通义千问) シリーズなど、世界中で並行して開発がすすめられたことによっても実証されています。 両者ともに規模の限界を押し広げましたが、哲学は異なっています。GPT は画期的な機能に焦点を当て、Qwen は強力なオープンソース化と多言語のアプローチを強調しています。

この 2 つの面での進化は、より強力で効率的な AI の実現に向けた世界的な競争を示しており、新しいモデルのリリースごとに次のモデルに対するハードルは高く設定されました。

| モデル | リリース | パラメーター数 | 主なイノベーション / 特徴 |

|---|---|---|---|

| GPT-1 | 2018 | 1 億 1,700 万 | 教師なし事前トレーニング (OpenAI) |

| GPT-2 | 2019 | 15 億 | ゼロショットタスクのパフォーマンス (OpenAI) |

| GPT-3 | 2020 | 1,750 億 | 少数ショット、インコンテキスト学習 (OpenAI) |

| Qwen-7B | 2023 年 8 月 | 70 億 | 強力なオープンソース多言語ベース (Alibaba) |

| GPT-4 | 2023 年 9 月 | ~1 兆 7,600 億 (MoE) | 高度な推論、マルチモダリティ (OpenAI) |

| Qwen-72B | 2023 年 11 月 | 05 - 720億 | コンテキスト長 32 K、オープンソース (Alibaba) |

| Qwen2.5 | 2024 年 9 月 | 最大 720 億 | 18 兆のトークンで訓練、コーディング / 数学の強化 (Alibaba) |

| Qwen3-Max | 2025 年 9 月 | ~1 兆 | Qwen のこれまでで最も大きく、最も高性能なモデル (Alibaba) |

計算需要が 5 ~ 6 か月ごとに 2 倍になるこの爆発的な成長により、最先端の AI の開発は、惑星規模のスーパーコンピューターを構築および運用できるだけの資本を有する少数のハイパースケール企業 [5] のみがアクセスできる領域になりました。

*OpenAI の GPT シリーズと Alibaba の Qwen シリーズの並列進化を示すタイムラインで、基盤モデル開発における世界的な競争を示しています。

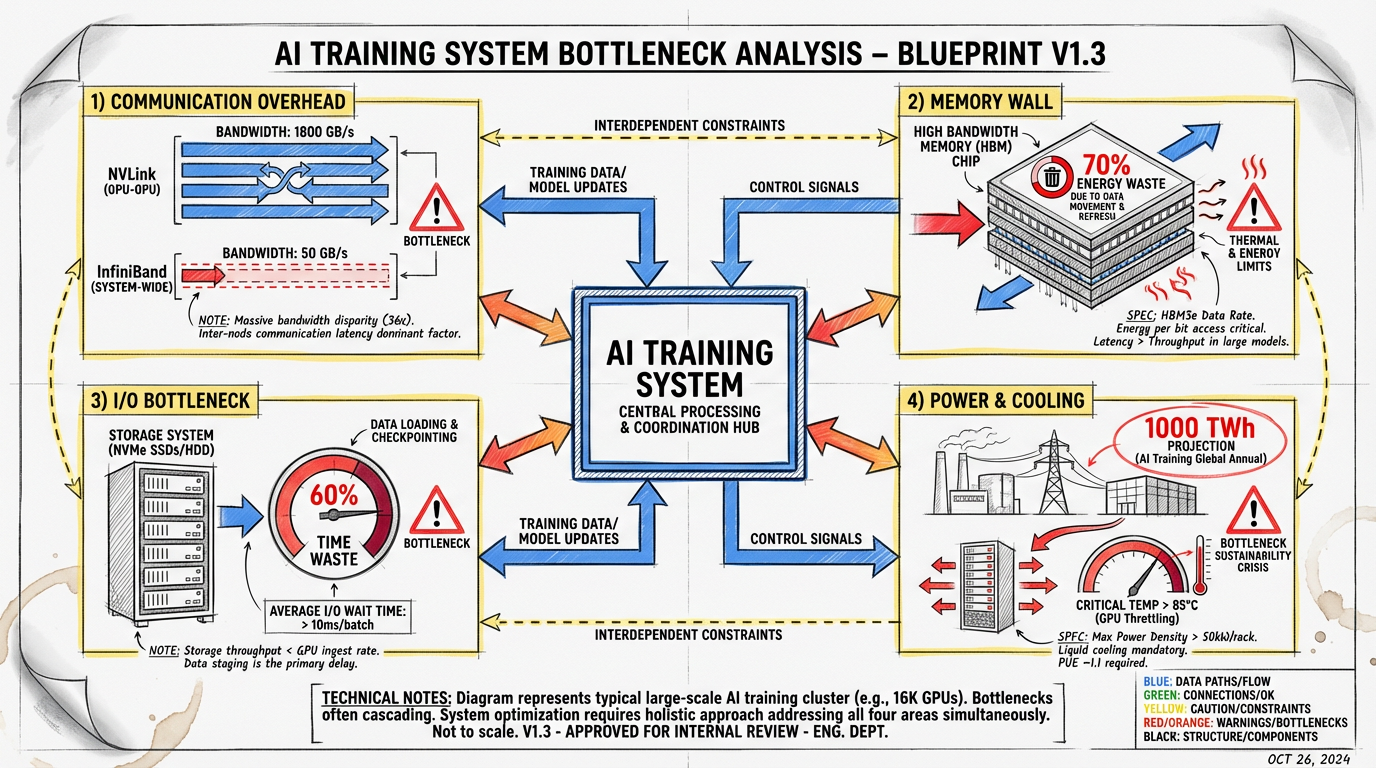

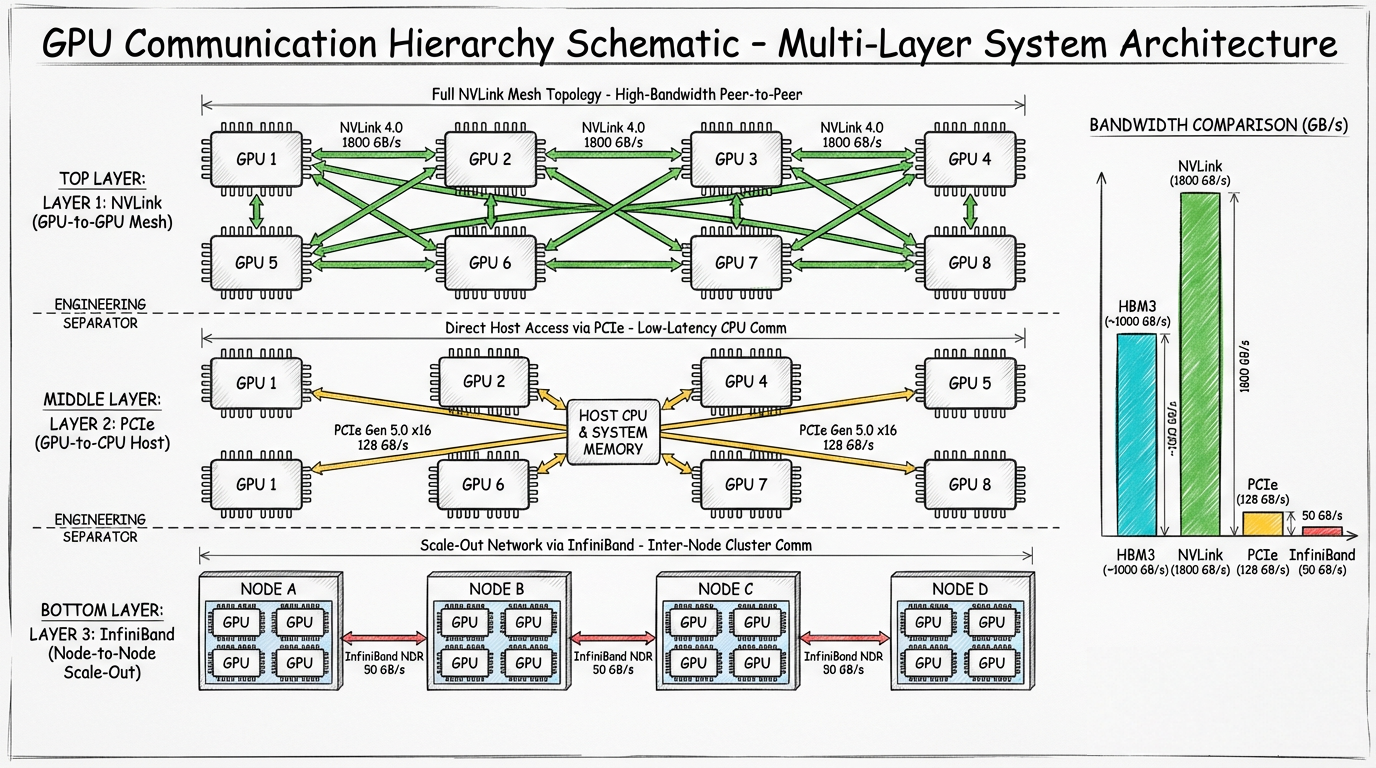

この絶え間ない規模の追求により、基盤となるインフラストラクチャが限界に達しました。 1 兆パラメーターのモデルをトレーニングすることは、単に GPU を追加することではありません。物理的および全体的なボトルネックに満ちた複雑なエンジニアリングの課題です。 主な目標は、すべての高価なプロセッサをフルに利用し続けることですが、多くの問題が邪魔をします。

最新の AI ファクトリーは、数千の相互接続された GPU を備えた広大なデータセンターです。 出典:NVIDIA

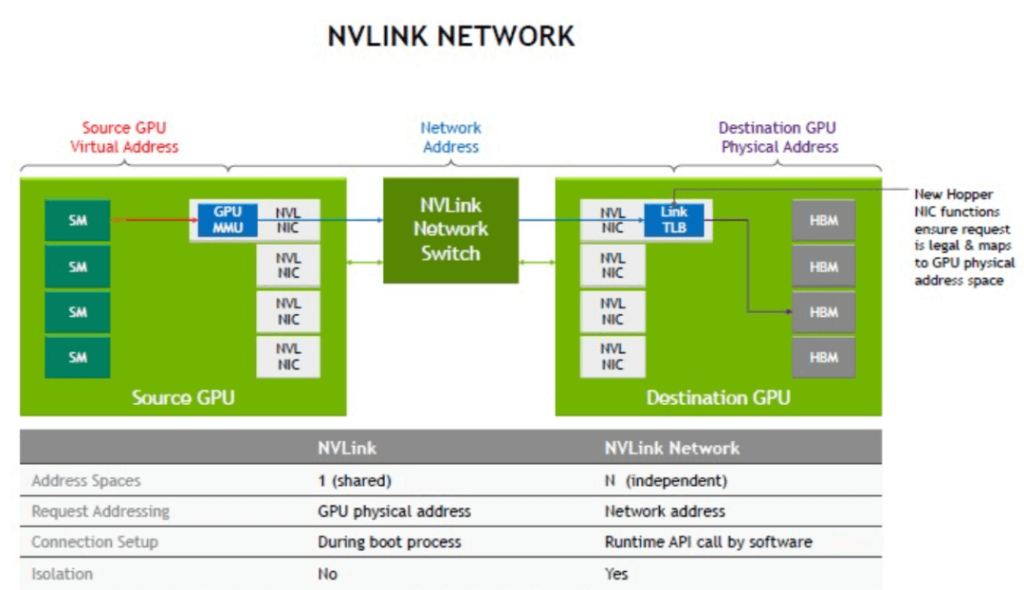

分散トレーニングでは、モデルは数千の GPU に分散され、それぞれがパズルのピースに取り組んでいます。 最も重要で時間のかかる手順は勾配同期です。この場合、すべての GPU はモデルの重みの次回の更新に同意するために結果をやり取りする必要があります。 これが大きな通信のボトルネックの発生を招きます。

NVIDIA の NVLink テクノロジーを示した図。サーバー内の GPU 間の高速で直接通信を提供します。 出典:NVIDIA

*GPU が相互に通信し、ネットワークファブリックと通信する、分散トレーニングセットアップにおける通信ボトルネックを示す概略図。

現代の AI モデルは、メモリを貪欲に消費します。 1 兆パラメーターモデルのパラメーター、オプティマイザーの状態、および中間層の活性化には、1 つの GPU で使用可能なメモリ (通常 80 ~ 120 GB) をはるかに超えるテラバイト級のストレージが必要になる場合があります。 これが、「メモリの壁」の問題につながります。

データは、GPU の高帯域幅メモリ (HBM) と低速のシステム RAM またはネットワークストレージの間で常に入れ替える必要があります。 このデータの移動は遅いだけでなく、非常にエネルギー集約的です。 NVIDIA によると、一般的な GPU ワークロードのエネルギーの最大 70% は、データを移動するだけで消費されています [8]。

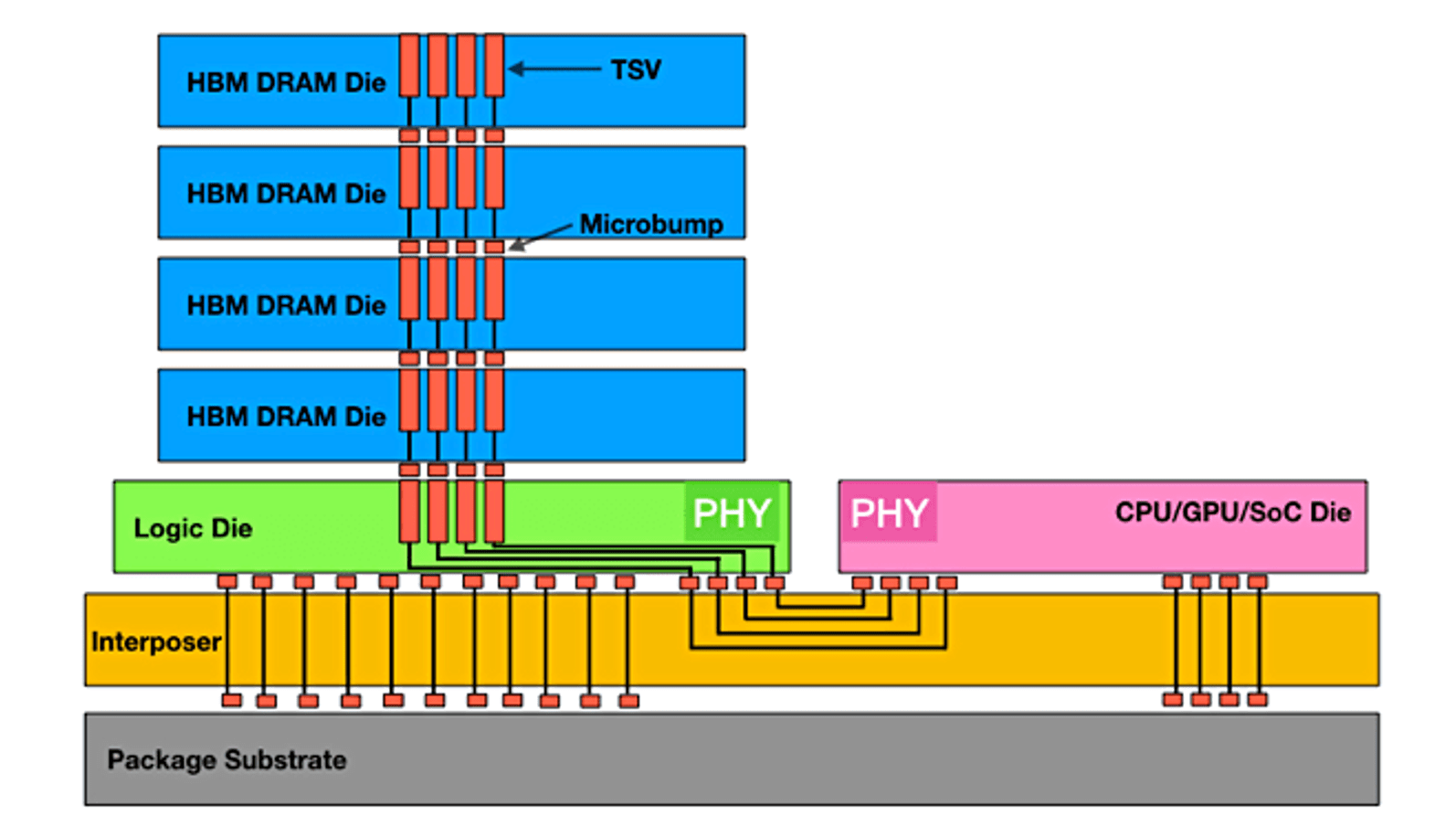

高帯域幅メモリ (HBM) は、最新の GPU が必要とする膨大な帯域幅を提供するためにメモリダイが垂直に積み重ねられていますが、それでも有限で高価なリソースです。 出典:Semiconductor Engineering

GPU が計算を開始する前に、まずデータが必要です。 多くの大規模なトレーニングシナリオでは、ストレージから GPU にトレーニングデータを読み込むプロセスが大きなボトルネックになる可能性があります。 数万個の GPU にデータを供給し続けるために 1 テラバイト / 秒でデータを配信するには、高性能の並列ファイルシステムが必要です。 データパイプラインが完全に最適化されていない場合、GPU はアイドル状態になり、数百万ドルの計算能力が浪費されます。 場合によっては、データの読み込みは、総トレーニング時間の 60% を超える時間を消費し、クラスター全体の効率を実質的に半減させる可能性があります [9]。

これらの AI ファクトリーに電力を供給するために必要なエネルギーは驚異的です。 1 回の大規模なトレーニングの実行で、小規模な都市に匹敵する多くの電力を消費する可能性があります。 国際エネルギー機関は、主に AI により、データセンターの電力使用量が 2026 年までに倍増し、1,000 テラワット時に達する可能性があると推定しています [10]。 この莫大な電力消費は、莫大な量の熱を生成し、冷却においても課題が発生します。 従来の空冷では不十分になりつつあり、最新の AI ハードウェアの極端な熱密度を管理するために、業界では液体冷却や液浸冷却などのより特殊なソリューションの採用が進められています。

GPU サーバーの高密度ラックは莫大な熱を発生するため、冷却がインフラストラクチャの重要課題になっています。 出典:AMAX

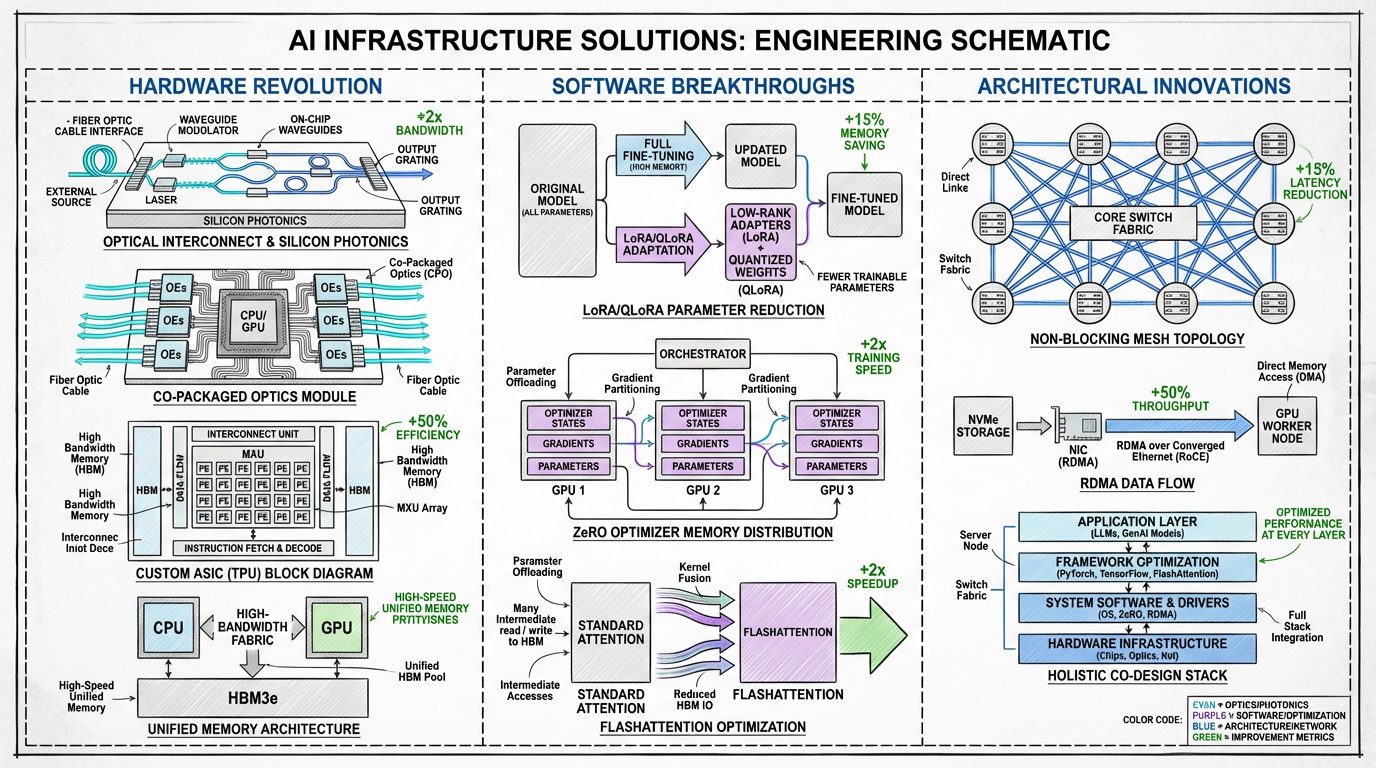

業界では、ハードウェア、ソフトウェア、およびシステムアーキテクチャ全体で革新する、多面的なアプローチでこれらのボトルネックの克服に取り組んでいます。 AI インフラストラクチャの未来は、より強力なチップだけでなく、すべてのコンポーネントが効率と規模に最適化された全体的な共同設計システムです。

インフラストラクチャのボトルネックを克服するために提案されたソリューションの概要。

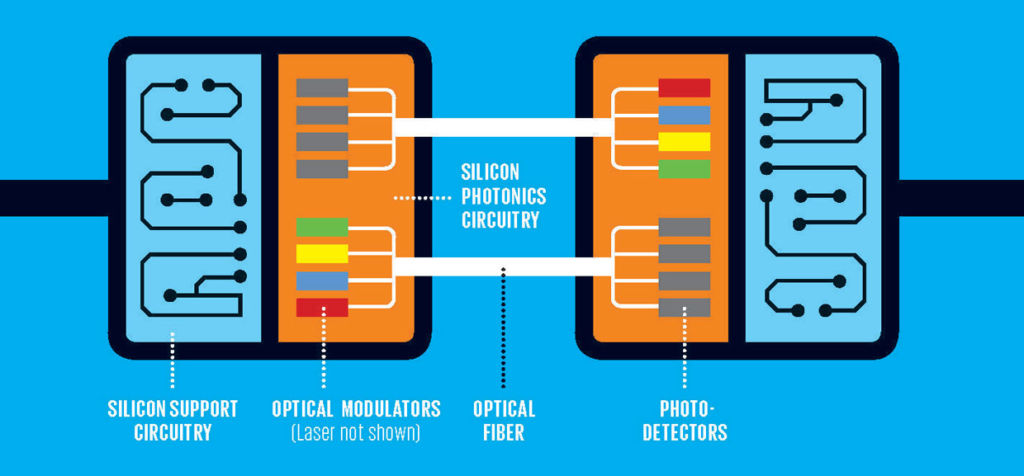

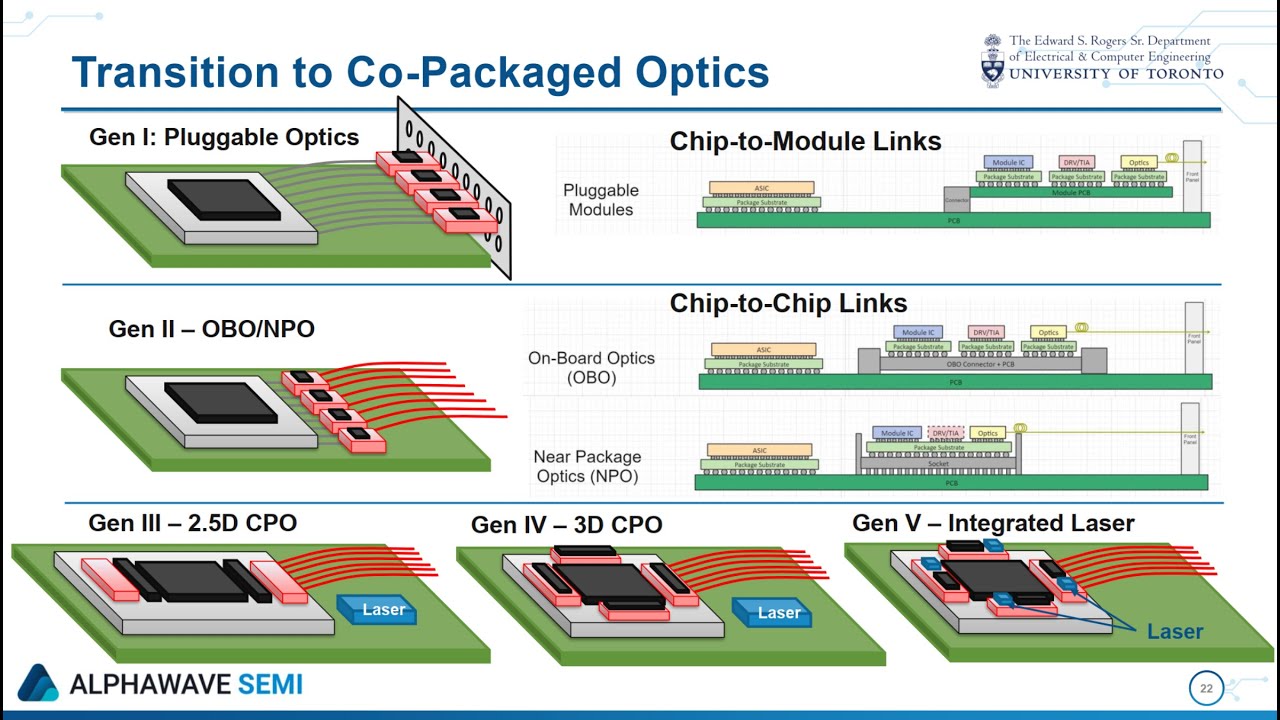

光相互接続: 業界で最も大きな変化は、電気 (銅) から光学 (光ベース) 相互接続への移行です。 シリコンフォトニクスは、テラビット級のデータを大幅に低い遅延と電力消費で送信することを約束します。 光 I/O をプロセッサパッケージに直接統合する共パッケージ光学系により、低速で電力を大量に消費する電気接続の必要性が排除され、通信およびエネルギーのボトルネックを直接克服できます [11]。

シリコンフォトニクスでは光を使用してデータが送信されるため、従来の銅配線と比較して劇的に高い帯域幅と低消費電力を実現します。 出典:FindLight

共パッケージ光学系 (CPO) では、光トランシーバーがプロセッサチップと直接統合され、データ移動距離が最小化されるとともに効率も最大化されます。 出典:Anritsu

次世代アクセラレーター: GPU が引き続き主流を占めていますが、状況は多様化しています。 Google の TPU や Meta の MTIA などのカスタム ASIC (特定用途向け集積回路) は、特定の AI ワークロード用に設計され、対象のタスクで優れたパフォーマンスと効率を発揮します。 特定の領域に特化されたアクセラレーターを使用する傾向が進むことで、万能の GPU を超えた、より最適化されたインフラストラクチャが可能になります。

統合メモリアーキテクチャ: メモリの壁を破壊するために、各社は緊密に統合されたチップセットを開発しています。 たとえば、NVIDIA の Grace Hopper Superchip では、単一モジュール上の CPU と GPU を、高速でコヒーレントな相互接続と組み合わせています。 これにより、両方のプロセッサが単一のメモリプールを共有できるため、CPU と GPU メモリドメイン間でのコストのかかるデータ移動が大幅に削減されます。

パラメーター効率的なファインチューニング: すべてのタスクで数十億ドルのモデルをゼロから再トレーニングする必要があるわけではありません。 LoRA (低ランク適応) や QLoRA のような技術により、モデルのパラメーターのごく一部を更新するだけで、効率的なファインチューニングが可能になります [12]。 これにより、計算要件とメモリ要件が大幅に緩和され、はるかに幅広いユーザーや組織でモデルを適応できるようになります。

高度なオプティマイザーとアルゴリズム: 効率の向上には、ソフトウェアの革新が重要な役割を果たしています。 Microsoft のZeRO (Zero Redundancy Optimizer) では、使用可能な GPU 全体でモデルの状態を分割し、デバイスあたりのメモリが大幅に少ない大規模なモデルのトレーニングが可能になります [13]。 FlashAttention のようなアルゴリズムでは、メモリの読み書きを削減するために注意メカニズムが再設計され、大幅な高速化とメモリ使用量の削減につながります。

専用の AI スーパーコンピューターでは、ハードウェアとソフトウェアソリューションが一体的に統合されています。 この分野の重要なトレンドは、より大きく、より強力で、より効率的な計算ユニットを作成することを目的とするスーパーノードアーキテクチャの開発です。 これらのアーキテクチャは、従来のサーバーラックを再考して AI 固有のワークロードに最適化するものです。

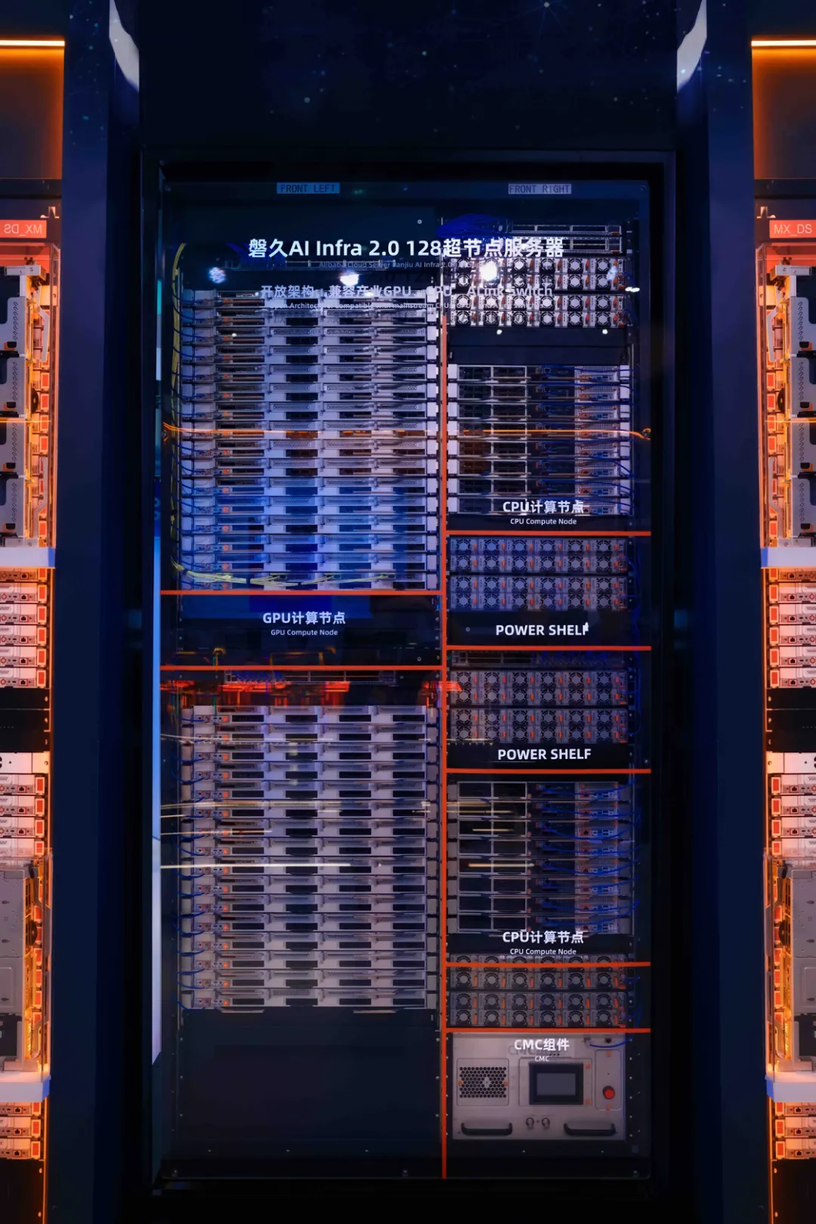

顕著な例の 1 つは、Panjiu AL128 スーパーノード設計を活用した Alibaba Cloud の Lingjun プラットフォームです。 このアーキテクチャは、よりモジュール化され、分離されたシステムへの移行を示しています。 主な機能は次のとおりです。

Panjiu AL128 スーパーノードアーキテクチャは、直交相互接続設計と CPU、GPU、および電源を分離したモジュールを備えています。 出典:Alibaba Cloud

このような緊密に統合された高密度システムでは、パフォーマンスが大幅に向上しています (アリババは、同じ計算能力での推論性能が 50% 向上したと主張しています) が、課題もあります。 長所には、より高い効率、より低い通信の遅延、およびスーパーノード内でのより高い拡張性が含まれます。 一方、短所としては、複雑さの増加、カスタムハードウェアと相互接続 (UALink など) への依存、および高度な液体冷却と電力インフラストラクチャの必要性が含まれます。これにより、資本コストと運用コストが増加する可能性があります。

これらのアーキテクチャの革新は、他の手法と組み合わせて、AI ファクトリーの新しい青写真を形成しています。

Panjiu AL128 アーキテクチャの詳細な技術については、Alibaba Cloud による詳細な分析と概要を説明したビデオ (こちらとこちら) をご覧ください。

AI 革命の最初の時代は、より大きなモデル、より多くのデータ、より多くの計算という、なりふり構わぬ拡大によって定義されていました。 拡大は常に重要ですが、次の時代は効率と洗練によって定義されていきます。 AI の未来は、より大きなモデルを構築することだけでなく、それらを訓練および実行するための、よりスマート、より持続可能、よりアクセスしやすいインフラストラクチャを構築することにあります。

AlexNet が初めて GPU を使用したときから、光学を活用し、共同設計された未来の AI ファクトリーまでの道のりは、絶え間ないイノベーションの道のりを示しています。 通信、メモリ、電力のボトルネックを克服することは、私たちの時代の大きな課題であり、今日開発されているソリューションは、人工知能の次の波の基礎を築くことでしょう。

[1] Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012 年)。 ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems 25.

[2] Vaswani, A., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems 30.

[3] Visual Capitalist. (2023). Charted: The Skyrocketing Cost of Training AI Models Over Time.

[4] Forbes. (2024). The Extreme Cost of Training AI Models.

[5] R&D World. (2024). AI’s great compression: 20 charts show vanishing gaps but still soaring costs.

[6] NVIDIA. (2024). NVIDIA GB200 NVL72.

[7] Zhai, E., et al. (2024). HPN: A Non-blocking, Dual-plane, Application-layer-agnostic High-performance Network for Large-scale AI Training. SIGCOMM 2024.

[8] Szasz, D. (2024). Understanding Bottlenecks in Multi-GPU AI Training. Medium.

[9] Alibaba Cloud. (2024). PAI-Lingjun Intelligent Computing Service Features.

[10] Forbes. (2025). Why Optical Infrastructure Is Becoming Core To The Future Of AI.

[11] Yole Group. (2023). Co-Packaged Optics for Datacenters 2023.

[12] Dettmers, T., et al. (2023). QLoRA: Efficient Finetuning of Quantized LLMs. Advances in Neural Information Processing Systems 36.

[13] Microsoft Research. (2020). ZeRO & DeepSpeed: New system optimizations enable training models with over 100 billion parameters.

[14] Alibaba Cloud. (2025). In-depth Analysis of Alibaba Cloud Panjiu AL128 Supernode AI Servers and Their Interconnect Architecture. Alibaba Cloud Blog.

[15] Alibaba Cloud. (2025). Panjiu AL128 Supernode AI Server Video Overview. YouTube.

本記事は英語原文の翻訳です。 原文については、https://www.alibabacloud.com/blog/from-brute-force-to-finesse-the-evolution-and-future-of-ai-training-infrastructure_602718 をご参照ください。

Dari Brute Force menjadi Finesse: Evolusi dan Masa Depan Infrastruktur Pelatihan AI

127 posts | 4 followers

FollowRegional Content Hub - July 7, 2025

Regional Content Hub - May 7, 2025

Regional Content Hub - March 8, 2024

Regional Content Hub - May 13, 2024

Regional Content Hub - February 26, 2024

Regional Content Hub - March 8, 2024

127 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub