本記事の作成者:Farruh

生成 AI (GenAI) の時代では、大規模言語モデル (LLM) はもはやテキストに限定されません。 Qwen2.5 Omni のようなマルチモーダルモデルは、テキスト、画像、オーディオ、およびビデオの間のギャップを埋め、AI が人間のように考え、見、聞き、話すことを可能にします。

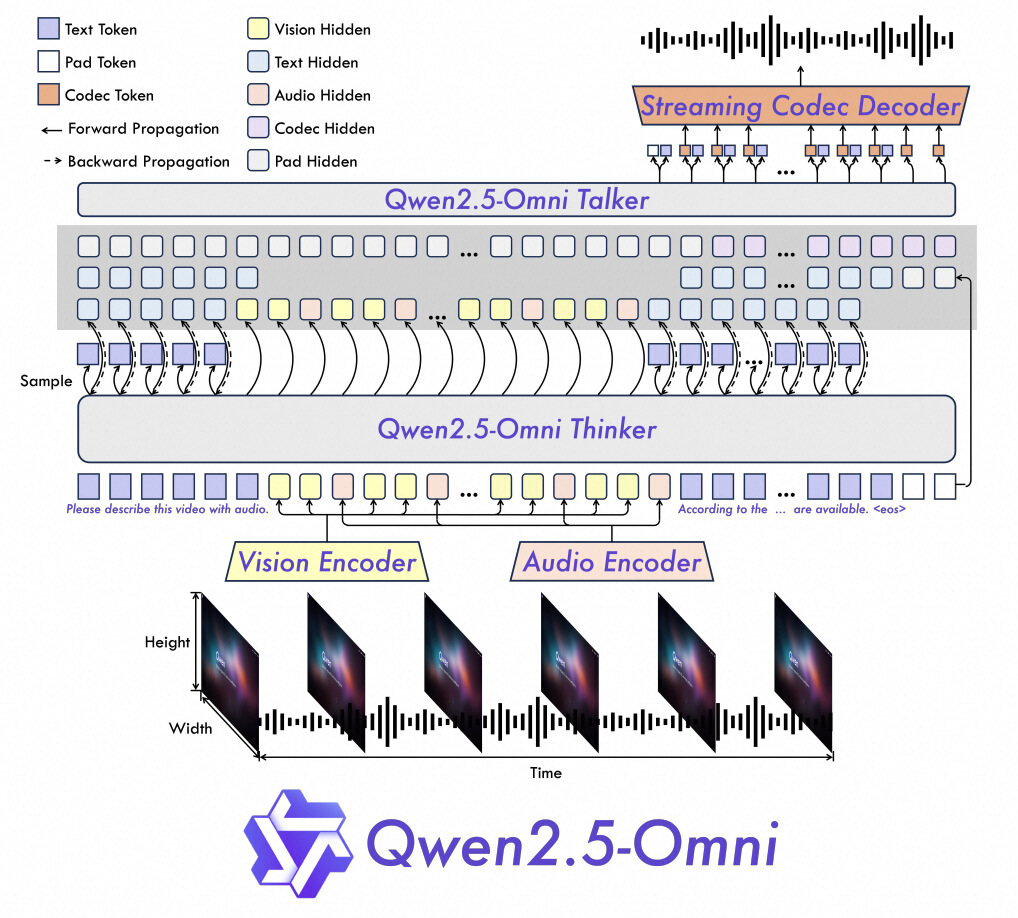

1. TMRoPE 位置符号化:

2. Thinker-Talker アーキテクチャ:

3. ストリーミング効率:

| タスク | Qwen2.5-Omni | Qwen2.5-VL | GPT-4o-Mini | SOTA |

|---|---|---|---|---|

| 画像 → テキスト | 59.2 (MMMUval) | 58.6 | 60.0 | 53.9 (その他) |

| ビデオ → テキスト | 72.4 (Video-MME) | 65.1 | 64.8 | 63.9 (その他) |

| マルチモーダル推論 | 81.8 (MMBench) | 非該当 | 76.0 | 80.5 (その他) |

| スピーチ生成 | 1.42% WER (中国語) | 非該当 | 非該当 | 2.33% (英語) |

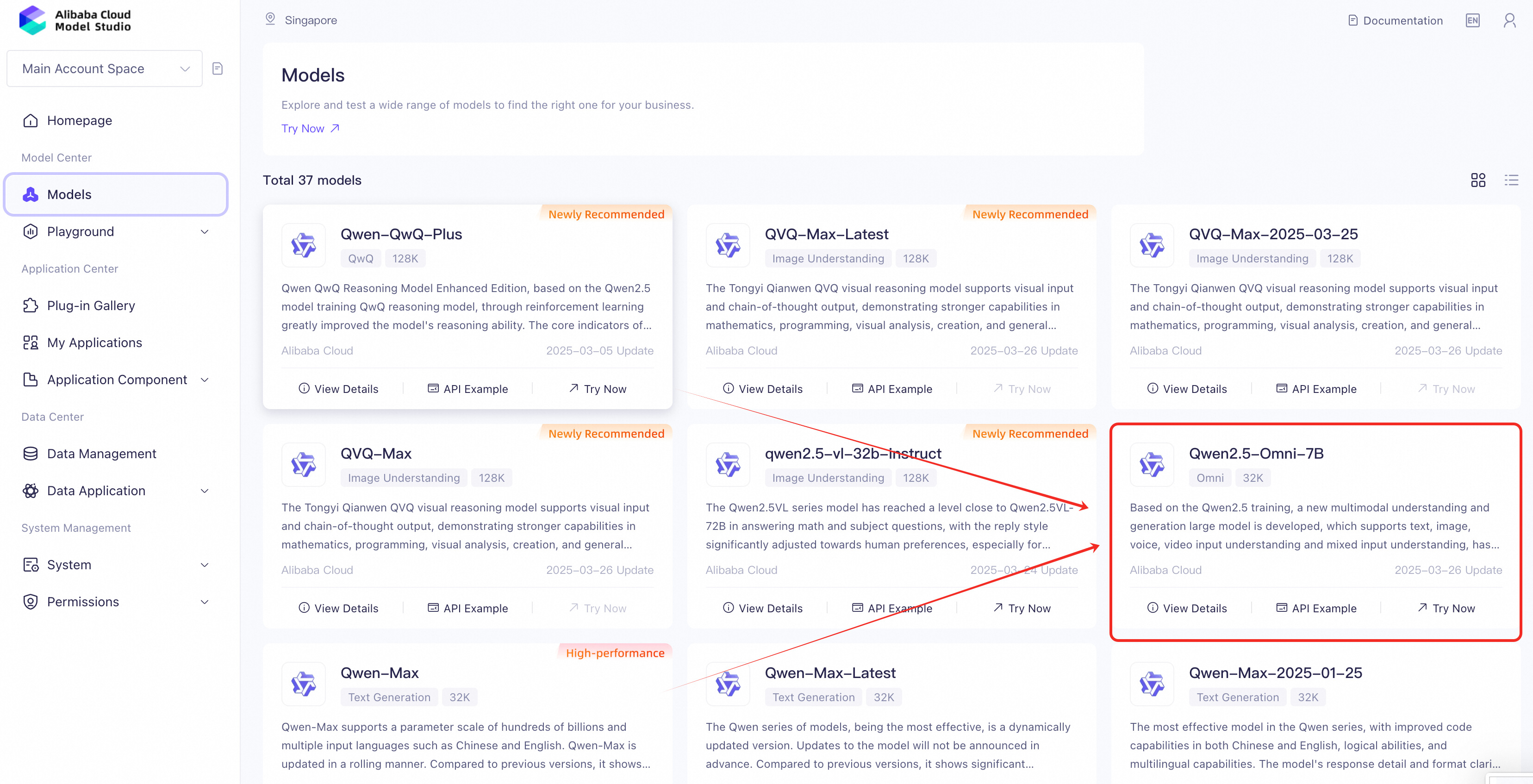

1. Alibaba Cloud ModelStudio または Model Studio 紹介ページに移動します。

2. “Qwen2.5-Omni” を検索してページに移動します。

3. モデルへのアクセスを許可します (基本機能の使用は無料) 。

セキュリティ優先のセットアップ:

1. 仮想環境を作成する (推奨):

python -m venv qwen-env

source qwen-env/bin/activate # Linux/MacOS | Windows: qwen-env\Scripts\activate2. 依存関係をインストールする

pip install openai3. API キーを安全に保存する: .env ファイルをプロジェクトディレクトリに作成します:

DASHSCOPE_API_KEY=your_api_key_hereOpenAI ライブラリを使用して Qwen2.5-Omni と対話します:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

# Example: Text + Audio Output

completion = client.chat.completions.create(

model="qwen2.5-omni-7b",

messages=[{"role": "user", "content": "Who are you?"}],

modalities=["text", "audio"], # Specify output formats (text/audio)

audio={"voice": "Chelsie", "format": "wav"},

stream=True, # Enable real-time streaming

stream_options={"include_usage": True},

)

# Process streaming responses

for chunk in completion:

if chunk.choices:

print("Partial response:", chunk.choices[0].delta)

else:

print("Usage stats:", chunk.usage)| 機能 | 詳細 |

|---|---|

| 入力タイプ | テキスト、画像、オーディオ、ビデオ (URL / Base64 経由) |

| 出力モダリティ |

modalities パラメーターの指定 (例:デュアル出力の場合は ["text", "audio"]) |

| ストリーミングのサポート |

stream=True によるリアルタイムの結果 |

| セキュリティ | API キーの環境変数 (.env ファイル) |

ユースケース:感情検出ありのライブイベントキャプション生成。

ユースケース:画像とユーザーレビューから製品の説明を生成する。

# Input: Product image + "Write a 5-star review in Spanish"

# Output: Text review + audio version in Spanish. 1. ファイルサイズの制限:

2. ストリーミングのための最適化:

stream=True を有効化します。

生成 AI が進化するにつれて、マルチモーダル機能がヘルスケアからエンターテインメントまでの業界を支配するようになります。 Qwen2.5 Omni をマスターすることで、人間と AI によるコラボレーションの次の時代に進むことができます。

今すぐ実験を始めて、革命に参加しましょう!

この記事は英語から翻訳されました。 元の記事は、こちらからご覧いただけます。

125 posts | 4 followers

FollowRegional Content Hub - May 13, 2024

Regional Content Hub - November 25, 2024

Regional Content Hub - August 5, 2024

Regional Content Hub - July 7, 2025

Regional Content Hub - December 10, 2025

Alibaba Cloud Native Community - February 26, 2025

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub