著者:Wang Chen、Liu Jun

2025 の春節には、中国トップクラスのオープンソース AI モデルの新バージョンが発表され、OpenAI のプロプライエタリモデルに匹敵する性能を示しました。

• 1 月 20 日、DeepSeek-R1 がリリースされ、数学、コーディング、および推論タスクにおいてOpenAI o1 に匹敵する性能を示しました [1]。

• 1 月 27 日、100 万トークンのコンテキストウィンドウをサポートする Qwen2.5-1M が登場しました。Qwen2.5-1M 14B は、短いコンテキストのタスクで GPT-4o-mini と同様の性能を実現しながら 8 倍のコンテキストウィンドウを提供し、長いコンテキストのタスクでは、複数のベンチマークデータセット全体で一貫して GPT-4o mini を上回っています [2]。

• 1 月 27 日、DeepSeek は、統一されたマルチモーダルな解釈・生成モデルである Janus-Pro を発表しました。ベンチマーク評価では、Janus-Pro-7B は、GenEval と DPG-Bench で、OpenAI の DALL-E 3 と Stability AI の Stable Diffusion の両方を上回りました [3]。

• 1 月 28 日、Qwen2.5-VL がリリースされました。このフラッグシップ VLM (視覚言語モデル) は、文書解釈、視覚質問応答、動画解釈、および視覚エージェントにおいて GPT-4o を上回っています [4]。

• 1 月 29 日、Qwen2.5-Max が発売され、Arena-Hard、LiveBench、LiveCodeBench、GPQA-Diamond などのベンチマーク評価で DeepSeek-V3 と GPT-4o を上回りました [5]。

この業界では、オープンソースモデルがクローズドソースのモデルを追随する段階を超え、AI 開発を主導する存在へと進化したという認識が高まっています。DeepSeek と Qwen は、現在のオープンソースプロジェクトの先頭に立っています。この記事では、AI モデルのデプロイとテストアプリケーションの構築のプロセスについて説明し、モデル機能を活用してタスクを実行します。

• 無料の計算処理:計算処理は自分のデバイスで行われます。

• 無料の API 呼び出し:API リクエストは自分のローカルネットワークで行われます。

• 機密データの保護:機密データはローカルに保存されるため、ローカルデプロイは個人開発者にとって理想的なオプションです。

• デバイスの制限:ローカルデバイスでは、DeepSeek-R1 の量子化バージョンまたは蒸留版のみがサポートされており、671 億のパラメータを持つ通常版はサポートされていません。DeepSeek-R1 FP4 をデプロイするには、デバイスに少なくとも 350 GB のメモリが必要です。

• アクセシビリティ:MIT ライセンスに基づいてリリースされた DeepSeek-R1 は、自由に蒸留できます。さらに、DeepSeek-R1 の蒸留版 Qwen モデルをダウンロードして使用することができます。

このセクションでは、ローカルデバイスに DeepSeek モデルをデプロイし、Spring AI Alibaba で DeepSeek を利用するアプリケーションを作成する方法について説明します。

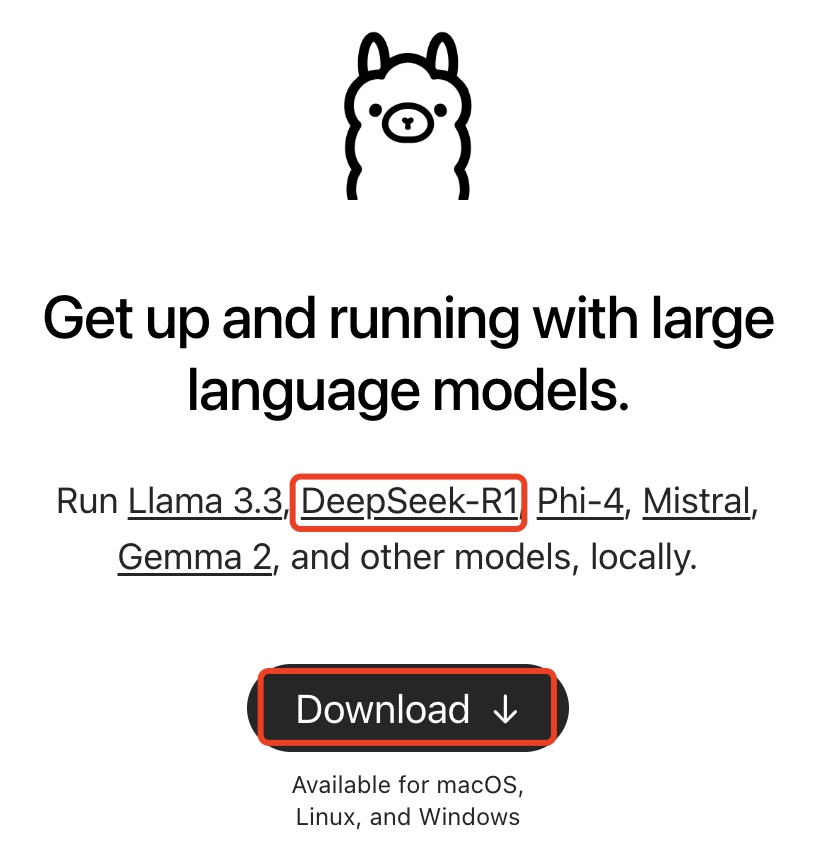

このページは、Ollama が DeepSeek-R1 のローカルデプロイをサポートしていることを示しています。

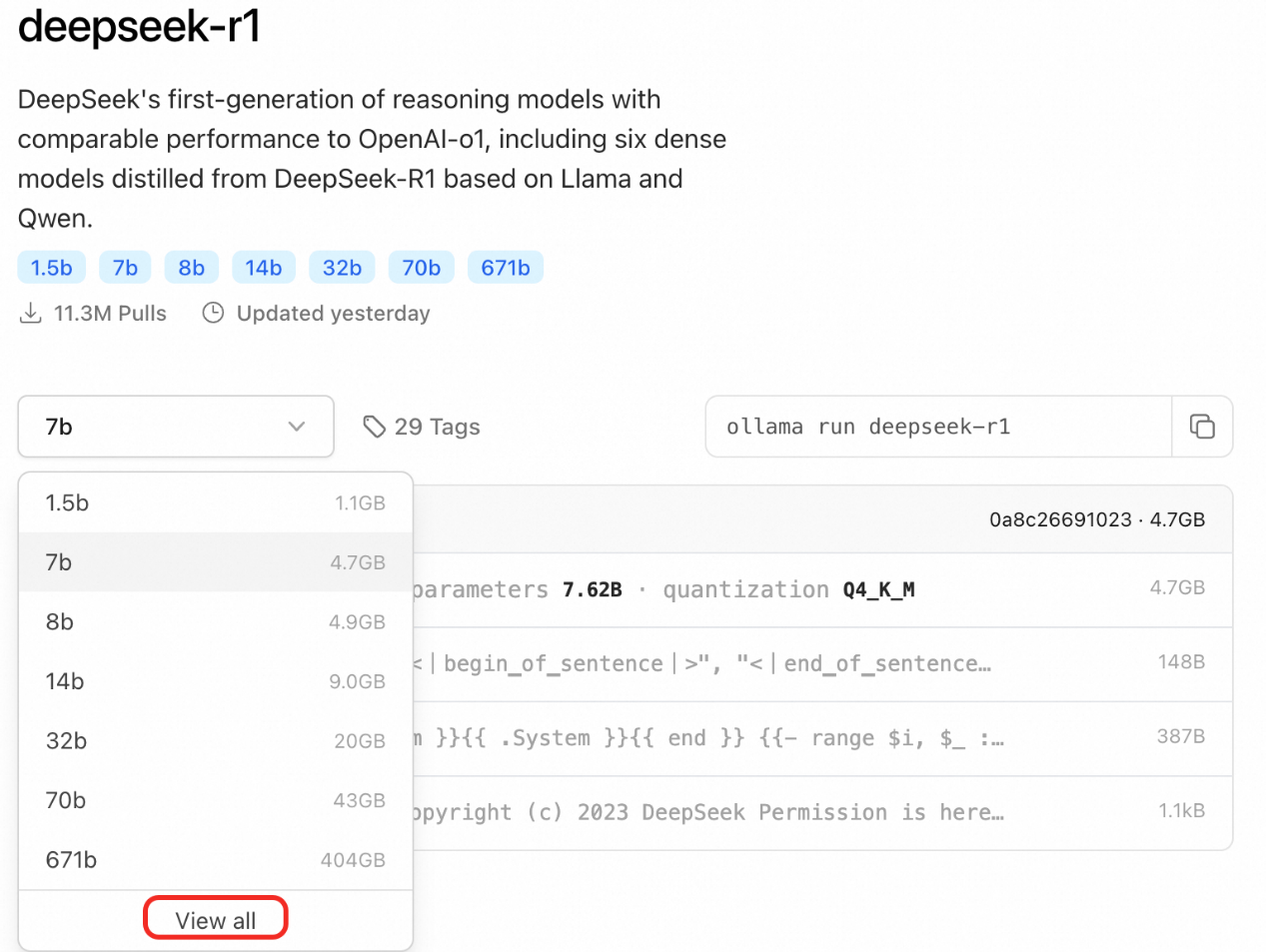

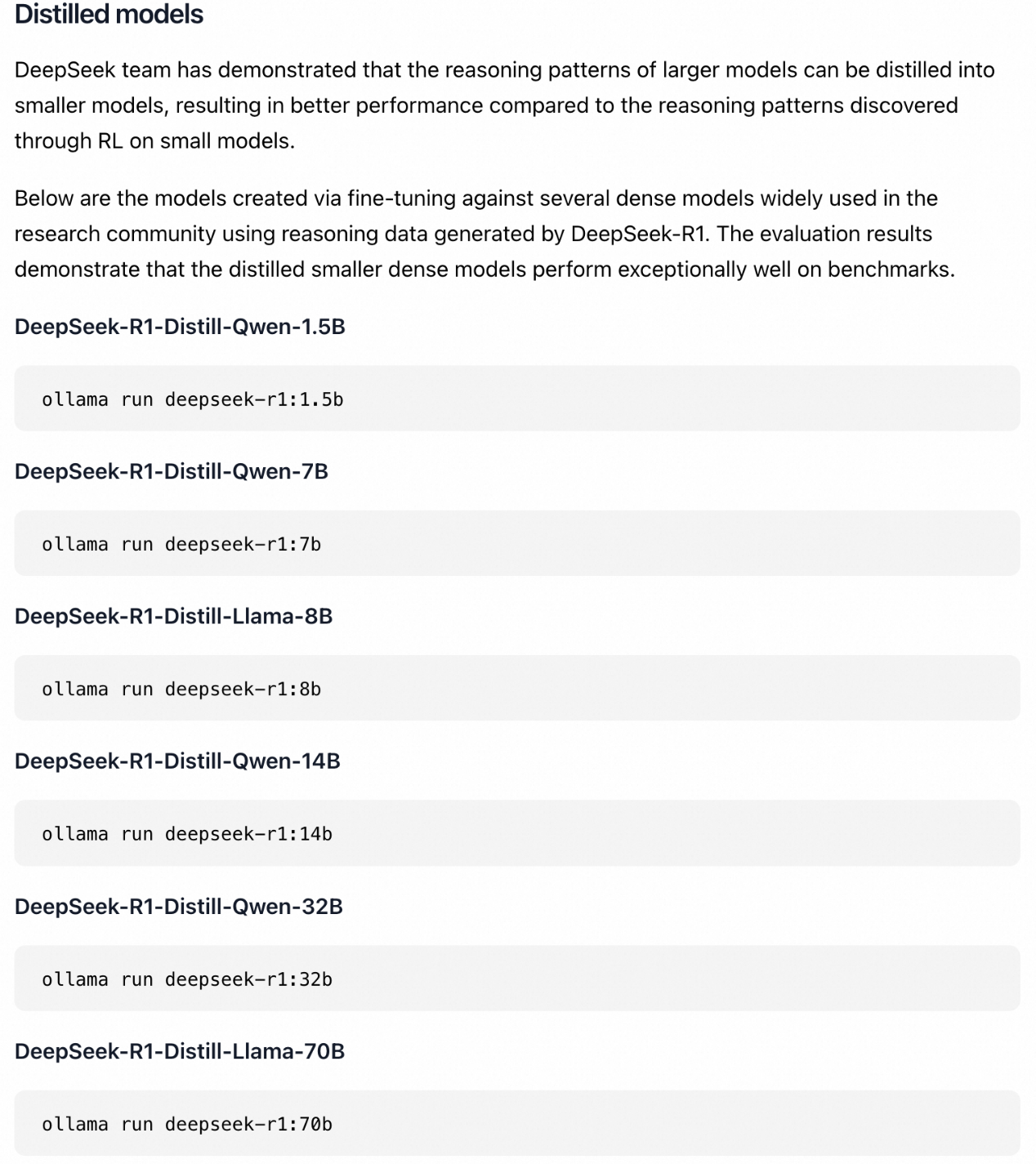

DeepSeek-R1 をクリックすると、詳細な紹介が表示されます。

2. [ダウンロード] をクリックして、Ollama をインストールします。インストール後、Command + Space を押してターミナルを開き、次のコマンドを実行します。

ターミナルウィンドウ

# DeepSeek-R1-Distill-Qwen-1.5B をインストールする

ollama run deepseek-r1:1.5bターミナルウィンドウ

# Ollma をインストールする

curl -fsSL https://ollama.com/install.sh | sh

# DeepSeek-R1-Distill-Qwen-1.5B をインストールする

ollama run deepseek-r1:1.5b3. デバイスに適したモデルサイズを選択します。

DeepSeek-R1 には、1.5B、7B、8B、14B、32B、70B、671B のサイズがあります。このガイドでは、1.5B モデルがデモ用に選択されています。一般に、8B モデルをデプロイするには 8 GB のメモリが必要で、32B モデルには 24 GB のメモリが必要です。

Spring AI Alibaba でアプリケーションを作成し、ローカルモデルを呼び出す

完全なコードについては、「https://github.com/springaialibaba/spring-ai-alibaba-examples/tree/main/spring-ai-alibaba-chat-example/ollama-deepseek-chat 」を参照してください。

サンプルコードをダウンロードします。

ターミナルウィンドウ

git clone https://github.com/springaialibaba/spring-ai-alibaba-examples.git

cd spring-ai-alibaba-examples/spring-ai-alibaba-chat-example/ollama-deepseek-chat/ollama-deepseek-chat-client

ターミナルウィンドウ

./mvnw compile exec:java -Dexec.mainClass="com.alibaba.cloud.ai.example.chat.deepseek.OllamaChatClientApplication"DeepSeek をローカルで使用するには、ブラウザで http://localhost:10006/ollama/chat-client/simple/chat と入力します。

Spring AI Alibaba を使用してアプリケーションをビルドする場合は、spring-ai-alibaba-starter 依存関係を追加し、ChatClient ビーンを挿入する必要があります。これは、Spring Boot を使用する場合には必要ありません。

spring-ai-alibaba-starter の依存関係を追加します。また、Ollama で DeepSeek モデルを実行するには、spring-ai-ollama-spring-boot-starter の依存関係を追加する必要があります。

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-ollama-spring-boot-starter</artifactId>

<version>1.0.0-M5</version>

</dependency>モデルのアドレスを設定します。アプリケーションプロパティでモデルのベース URL と名前を指定します。

spring.ai.ollama.base-url=http://localhost:11434

spring.ai.ollama.chat.model=deepseek-r1

ChatClient を注入します。

@RestController

public class ChatController {

private final ChatClient chatClient;

public ChatController(ChatClient.Builder builder) {

this.chatClient = builder.build();

}

@GetMapping("/chat")

public String chat(String input) {

return this.chatClient.prompt()

.user(input)

.call()

.content();

}

}Spring AI Alibaba DingTalk グループ ID: 105120009405

[1] https://github.com/deepseek-ai/DeepSeek-R1

[2] https://qwenlm.github.io/blog/qwen2.5-1m

[3] https://github.com/deepseek-ai/Janus?tab=readme-ov-file

[4] https://qwenlm.github.io/blog/qwen2.5-vl/

[5] https://qwenlm.github.io/zh/blog/qwen2.5-max/

642 posts | 55 followers

FollowRegional Content Hub - July 7, 2025

Regional Content Hub - August 4, 2025

Regional Content Hub - March 8, 2024

Regional Content Hub - March 8, 2024

Alibaba Cloud Native Community - February 26, 2025

Regional Content Hub - August 5, 2024

642 posts | 55 followers

Follow AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Offline Visual Intelligence Software Packages

Offline Visual Intelligence Software Packages

Offline SDKs for visual production, such as image segmentation, video segmentation, and character recognition, based on deep learning technologies developed by Alibaba Cloud.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Network Intelligence Service

Network Intelligence Service

Self-service network O&M service that features network status visualization and intelligent diagnostics capabilities

Learn MoreMore Posts by Alibaba Cloud Native Community