本記事の作成者:Farruh

データセットは、特にチャットボットからコンテンツジェネレーターまであらゆるものを強化する大規模言語モデル (LLM) のトレーニングにおいて、人工知能の生命線です。 これらのデータセットは、AI モデルがその機能を学習および開発する基盤を形成します。 しかし、より高度な AI システムの需要が高まるにつれて、高品質かつ多様で広範なデータセットの必要性も高まっています。 この記事では、これまでのデータセットの利用方法、LLM トレーニングのさまざまな段階で必要なデータの種類、およびこれらのデータセットの調達と利用で直面する課題について詳しく説明します。

AI 研究の初期段階では、データセットは百科事典、議会の議事録、電話の録音、天気予報など、さまざまなソースから細心の注意を払ってキュレーションされていました。 各データセットは特定のタスクに対処し、関連性と品質を確保するように調整されました。 しかし、2017 年に現代の言語モデルにとって極めて重要なニューラルネットワークアーキテクチャであるトランスフォーマーが登場したことで、圧倒的な量に注目が集まるようになり、AI 研究のアプローチに大きな変化が見られました。 研究者は、大規模なモデルとデータセットで LLM のパフォーマンスが大幅に向上することに気づき、インターネットから無差別にデータスクレイピングが行われるようになりました。

2018 年までに、インターネットはオーディオ、画像、ビデオを含むすべてのデータタイプの主要なソースになりました。 この傾向は今も続いており、インターネットから取得されたデータと手動でキュレーションされたデータセットとの間に大きなギャップが生じています。 また、規模に対する需要から、実際の相互作用から収集されるのではなく、アルゴリズムによって生成されたデータである合成データが広く使用されるようになりました。

事前トレーニングは初期段階であり、モデルは、一般的な言語パターンと構造を学習するために膨大な量のテキストデータにさらされます。 この段階でモデルに必要なものは以下の通りです。

しかし、著作権で保護された資料を許可なく使用した場合、倫理的な問題が発生します。

継続的な事前トレーニングでは、新しいデータでモデルを更新して最新の状態に保ち、知識ベースを改善します。 この段階で必要なものは以下の通りです。

ファインチューニングで、事前トレーニングされたモデルを特定のタスクまたはドメインに適応させます。 通常、より小さく、よりターゲットを絞った、慎重にラベル付けされ、キュレーションされたデータセットが使用されます。 例:

このプロセスで使用されるデータセットとメソッドの例を以下に示します。

キュレーションされたデータセットと PEFT などの高度な方法を組み合わせることで、研究者と開発者は、リソースの制約とスケーラビリティの課題に対処しながら、ニッチアプリケーション用に LLM を最適化できます。

人間のフィードバックによる強化学習 (RLHF) は、人間の好みによりよく一致するようにモデルをトレーニングすることを含みます。 この段階で必要なものは以下の通りです。

以下に、RLHF の中心となるデータセットとメソッドの例を示します。

選好データセット:RLHF は、人間がモデル出力をランク付けまたは評価した、人間によってラベル付けされた選好データを収集することから始まります。 たとえば、OpenAI の初期の RLHF の実験では、注釈者が複数のモデル生成応答を同じプロンプトと比較し、どの応答がより役立つか、真実であるか、または倫理的ガイドラインに沿っているかをラベル付けするデータセットを使用しました。 これらのデータセットには、政治やヘルスケアなどのデリケートなトピックにおける事実と偏った回答を区別するなど、慎重な取り扱いを要する例が含まれることがよくあります。

選好データセット、報酬モデリング、および反復的な人間のフィードバックを組み合わせることにより、RLHF では、LLM が一般的なテキスト生成器から、安全性、関連性、および人間との整合性を優先するシステムに進化することが保証されます。

今日最も差し迫った問題の 1 つは、すぐに利用できるテキストデータの枯渇です。 伝えられるところによると、主要なテクノロジー企業は、海賊版の本、映画の字幕、個人的なメッセージ、ソーシャルメディアの投稿など、オープン Web とダーク Web からアクセス可能なほとんどすべてのテキストデータにインデックスを付けています。 利用できる新しいソースが少ないため、業界はさらなる進歩のボトルネックに直面しています。

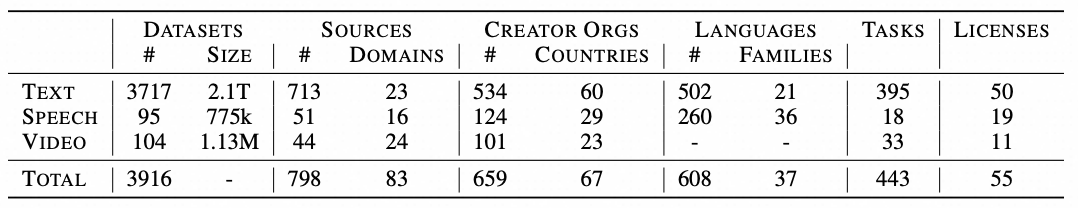

すべてのモダリティにわたる、各ソースカテゴリからのデータの累積量 (テキストの場合は対数スケール、音声 / ビデオの場合は時間) 。 凡例のソースカテゴリは、数量の降順に並べられています。

ほとんどのデータセットはヨーロッパと北アメリカで作成されているため、西洋中心の世界観が反映されています。 分析されたデータセットのうちアフリカからのものは 4% 未満で、重大な文化的不均衡が浮き彫りになっています。 このバイアスにより、特に画像やビデオを生成するマルチモーダルモデルでステレオタイプが強化されたり、歪んだ認識につながったりする可能性があります。

影響力のあるデータセットの取得と管理は、大企業によって支配されています。 YouTube のようなプラットフォームは、AI トレーニングで使用されるビデオデータの 70% 以上を提供し、少数の企業の手に莫大な力が集中します。 この集中化はイノベーションを妨げ、これらのリソースへのアクセスが不足している小規模なプレーヤーにとって障壁となります。

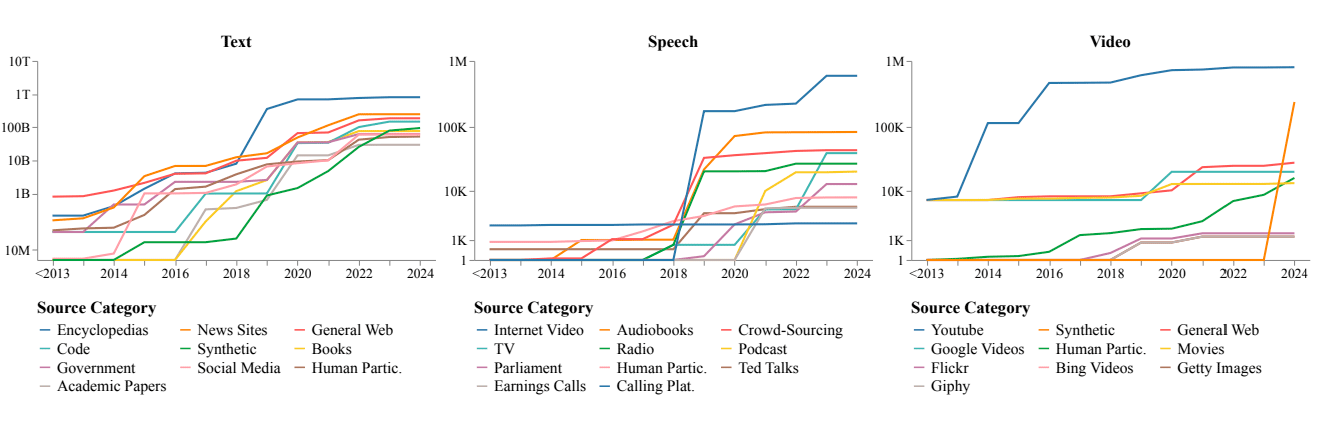

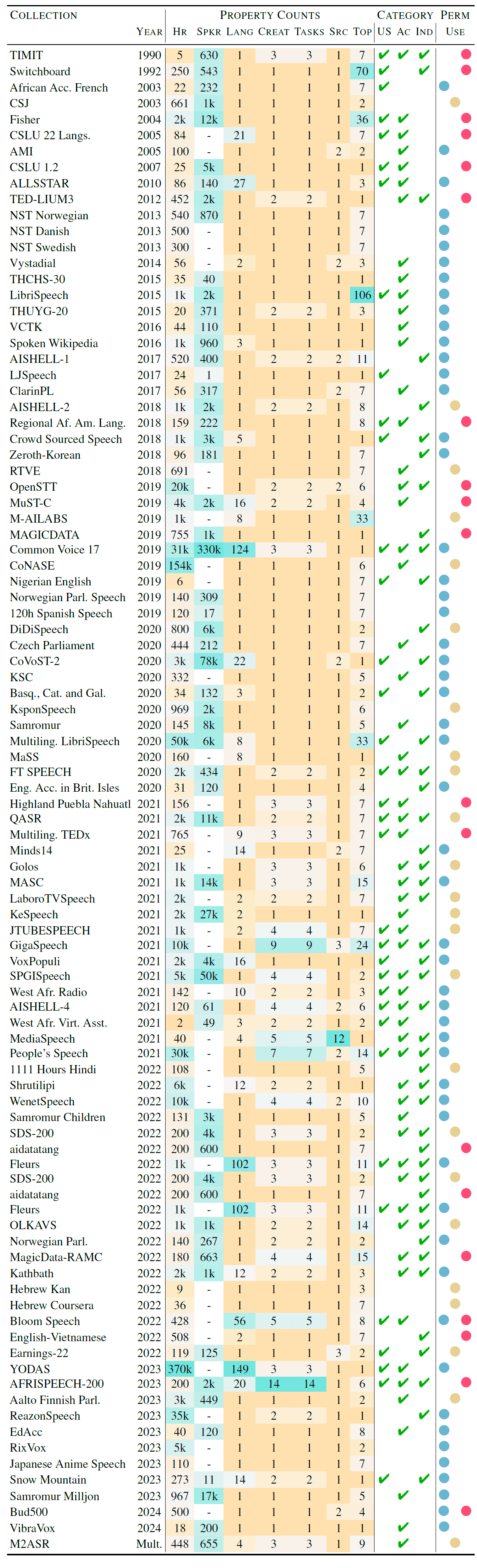

下表に、テキストコレクションのソースを示します。 プロパティには、データセット、タスク、言語、およびテキストドメインの数が含まれます。 ソース列は、人間が生成した Web 上のテキスト、言語モデルの出力、またはその両方のコレクションのコンテンツを示します。 最後の列は、コレクショのライセンスステータスを示しています。商用使用の場合は青、非商用および学術研究の場合は赤、ライセンスが不明な場合は黄色です。 最後に、OAI 列は、OpenAI モデルの世代を含むコレクションを示します。 データセットは、経時的な傾向を強調するために時系列にソートされています。 出典はこちらです。

テキストデータのコレクション:

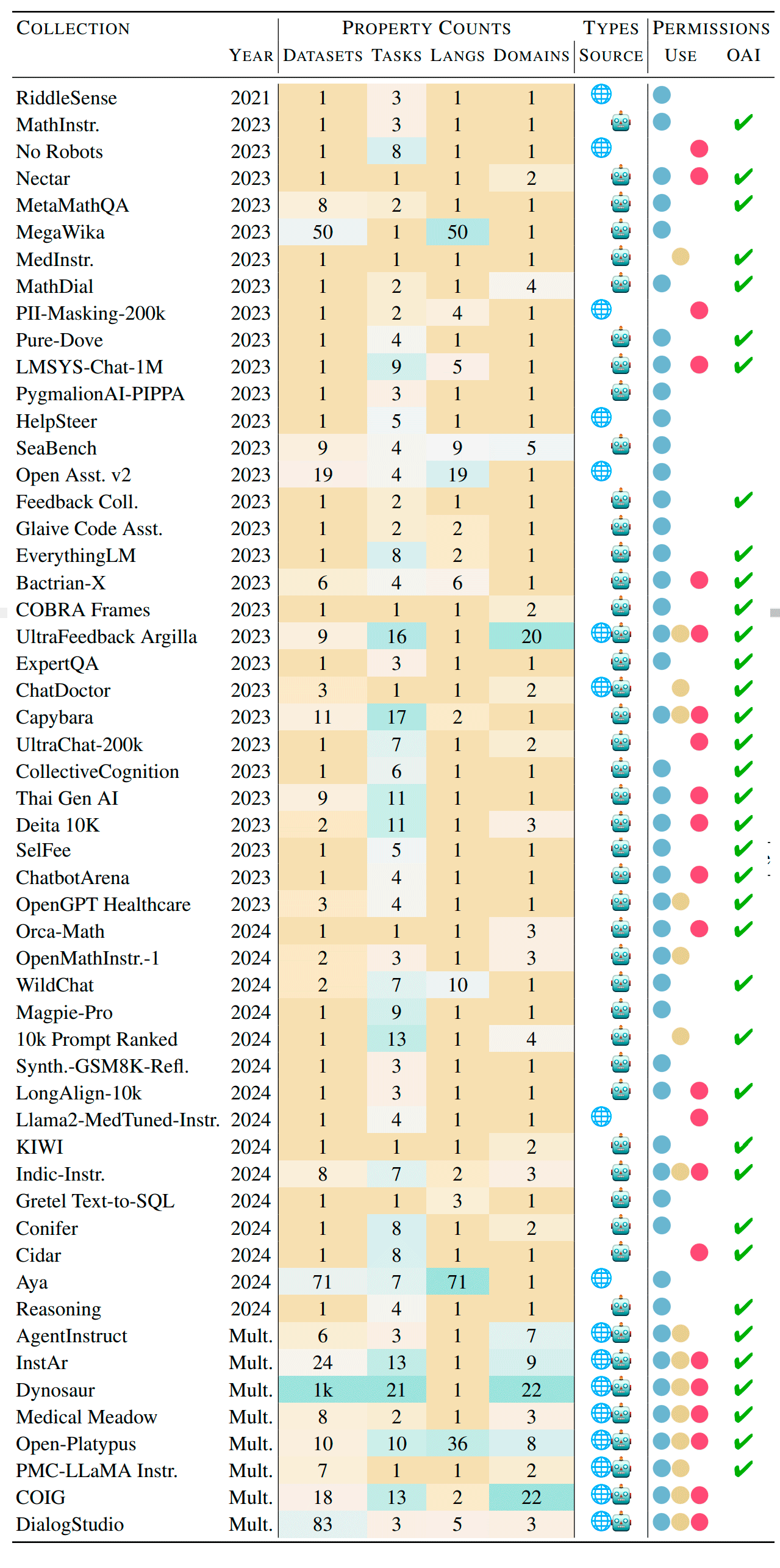

ビデオデータのコレクション:

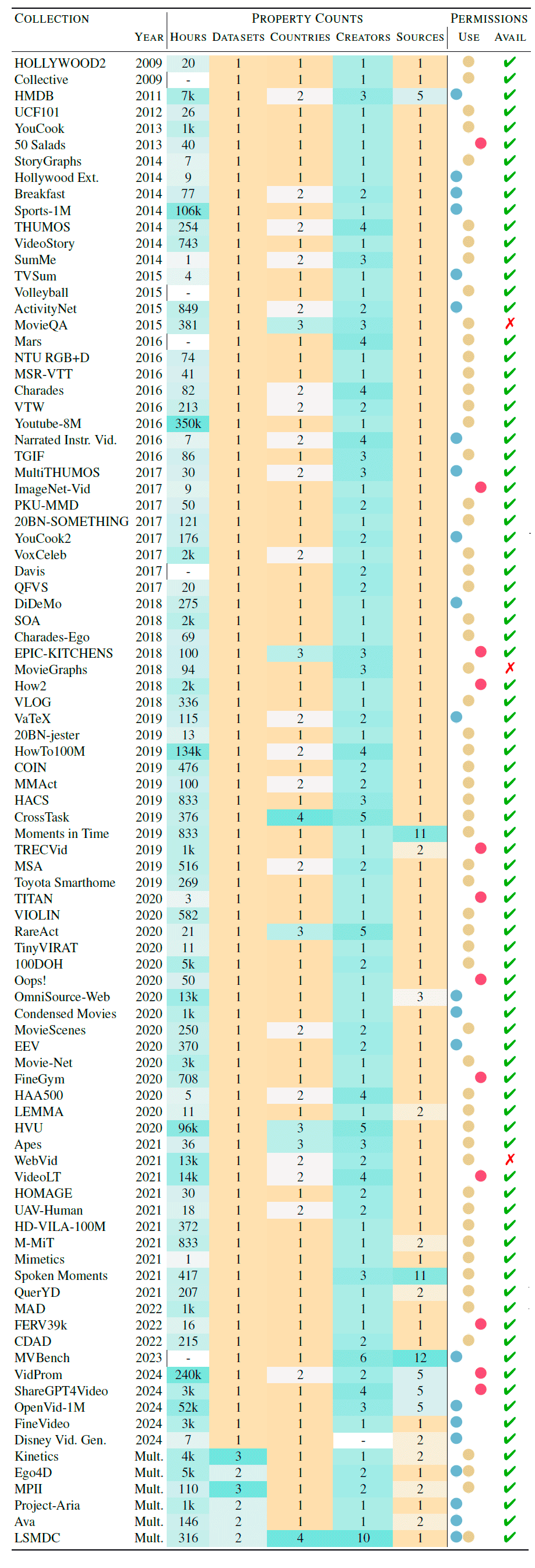

オーディオデータのコレクション:

簡単にアクセスできるデータが明らかに枯渇している一方で、未開発のソースが多数残っています。

高度な LLM は、これらの潜在的なデータセットを構造化して、将来のトレーニングに利用できます。

連合学習を使用すると、安全な環境の外に転送することなく、機密データでモデルをトレーニングできます。 この方法は、ヘルスケア、金融、電気通信などの機密情報を扱う業界に最適です。 データの局所化を維持することにより、連合学習ではプライバシーが保証され、共同モデルの改善が可能になります。

合成データの生成とデータ拡張は、トレーニングデータセットを拡大するための有望な手段です。

AI の分野が進化し続けるにつれて、データセットの役割は依然として非常に重要です。 簡単に入手できるデータの枯渇は課題を提起しますが、AI の研究者および愛好家として、文化の非対称性と中央集権化の問題を認識し、責任を負うことが重要です。 未開発のソース、連合学習、合成データ生成などの革新的なソリューションが、将来への道を示しています。 これらの戦略を組み合わせることで、公平で多様な AI 開発を確保し、より洗練された、包括的な人工知能システムへの道を開くことができます。

この記事は英語から翻訳されました。 元の記事はこちらからご覧いただけます。

129 posts | 4 followers

FollowRegional Content Hub - December 10, 2025

Regional Content Hub - July 7, 2025

Alibaba Cloud Native Community - February 26, 2025

Regional Content Hub - July 8, 2024

Regional Content Hub - May 13, 2024

Regional Content Hub - March 8, 2024

129 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub