Oleh Farruh

Himpunan data adalah sumber vital kecerdasan buatan, terutama dalam melatih model bahasa besar (LLM) yang mendukung semuanya dari chatbot hingga pembuat konten. Himpunan data ini menjadi fondasi tempat model AI mempelajari dan mengembangkan kemampuannya. Namun, seiring meningkatnya permintaan atas sistem AI yang lebih canggih, kebutuhan terhadap himpunan data berkualitas tinggi, beragam, dan luas pun meningkat. Artikel ini membahas sejarah penggunaan himpunan data, jenis data yang diperlukan di berbagai tahap pelatihan LLM, dan tantangan yang dihadapi dalam mencari sumber dan memanfaatkan himpunan data tersebut.

Pada masa-masa awal riset AI, himpunan data dikurasi dengan cermat dari berbagai sumber, seperti ensiklopedia, transkrip parlementer, rekaman panggilan telepon, dan ramalan cuaca. Setiap himpunan data disesuaikan untuk menangani tugas khusus, dengan memastikan relevansi dan kualitas. Namun, dengan kedatangan transformer pada 2017—arsitektur jaringan neural yang penting bagi model bahasa modern—fokus pun beralih ke volume saja, yang menandai perubahan signifikan dalam pendekatan riset AI. Peneliti menyadari bahwa performa LLM meningkat secara signifikan dengan model dan himpunan data yang lebih besar, yang menyebabkan scraping data yang sembarangan dari internet.

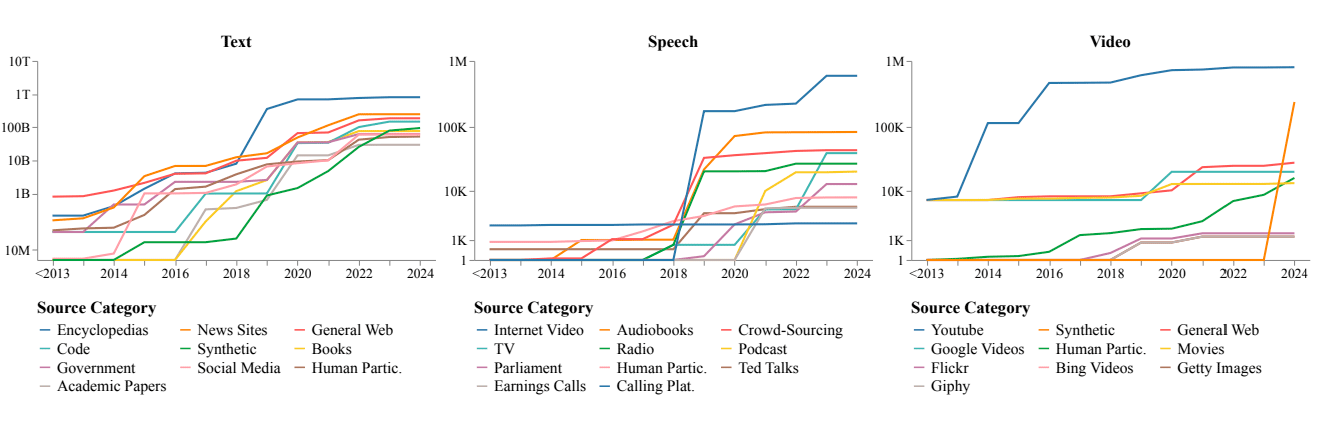

Hingga 2018, internet menjadi sumber dominan untuk semua jenis data, termasuk audio, gambar, dan video. Tren ini terus berlanjut, menghasilkan celah yang signifikan antara data bersumber internet dan himpunan data yang dikurasi secara manual. Permintaan untuk skala juga mengarah kepada penggunaan luas data sintetis—data yang dihasilkan oleh algoritma, bukan dikumpulkan dari interaksi dunia nyata.

Pra-pelatihan adalah fase awal, tempat model ini diperkenalkan dengan sejumlah besar data teks untuk mempelajari pola dan struktur bahasa umum. Selama tahap ini, model ini memerlukan:

Namun, pertimbangan etika muncul saat menggunakan materi hak cipta tanpa izin.

Pra-pelatihan kontinu mencakup pembaruan model dengan data baru agar tetap terkini dan meningkatkan basis pengetahuannya. Tahap ini memerlukan:

Penyempurnaan menyesuaikan model yang telah terlatih untuk tugas atau domain tertentu. Biasanya menggunakan himpunan data yang lebih kecil, lebih ditargetkan, diberi label dengan cermat, dan terkurasi. Contohnya:

Berikut adalah contoh himpunan data dan metode yang digunakan dalam proses ini.

Dengan menggabungkan himpunan data yang dikurasi dengan metode canggih seperti PEFT, peneliti dan pengembang dapat mengoptimalkan LLM untuk aplikasi ceruk selagi menangani kendala sumber daya dan tantangan skalabilitas

Pembelajaran penguatan dari umpan balik manusia (RLHF) mencakup pelatihan model untuk menyelaraskan dengan preferensi manusia secara lebih baik. Tahap ini memerlukan:

Berikut adalah contoh himpunan data dan metode yang menjadi inti RLHF.

Himpunan Data Preferensi: RLHF dimulai dengan mengumpulkan data preferensi berlabel manusia, dengan output model yang diberi peringkat atau nilai oleh manusia. Misalnya, eksperimen RLHF awal di OpenAI menggunakan himpunan data tempat anotator membandingkan beberapa respons yang dihasilkan model terhadap prompt yang sama, memberi label respons mana yang lebih membantu, jujur, atau selaras dengan pedoman etika. Himpunan data ini sering menyertakan contoh yang diberi nuansa, seperti membedakan antara jawaban faktual dan bias dalam topik sensitif seperti politik atau perawatan kesehatan.

Dengan menggabungkan himpunan data preferensi, pemodelan hadiah, dan umpan balik manusia berulang, RLHF memastikan LLM berkembang dari pembuat teks generik menjadi sistem yang memprioritaskan keamanan, relevansi, dan penyelarasan manusia.

Salah satu masalah yang paling menekan hari ini adalah kehabisan data tekstual yang mudah tersedia. Pemain teknologi besar dilaporkan telah mengindeks hampir semua data teks dari web terbuka dan gelap, termasuk buku bajakan, subtitel film, pesan pribadi, dan postingan media sosial. Dengan lebih sedikit sumber baru untuk dimanfaatkan, industri ini mengalami hambatan dalam kemajuan lebih lanjut.

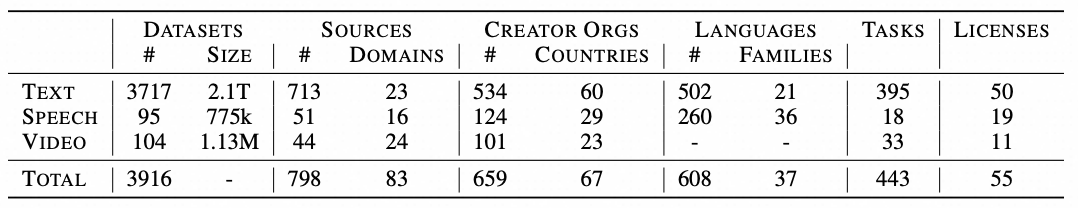

Jumlah data kumulatif (dalam skala logaritmik untuk teks, dalam jam untuk ucapan/video) dari setiap kategori sumber, di seluruh modalitas. Kategori sumber dalam legenda disusun urutan menurun berdasarkan kuantitas.

Sebagian besar himpunan data berasal dari Eropa dan Amerika Utara, yang mencerminkan pandangan dunia yang berpusat ke Barat. Kurang dari 4% himpunan data yang dianalisis berasal dari Afrika, yang menyoroti imbangan budaya yang signifikan. Bias ini dapat menyebabkan persepsi miring dan memperkuat stereotip, terutama dalam model multimodal yang menghasilkan gambar dan video.

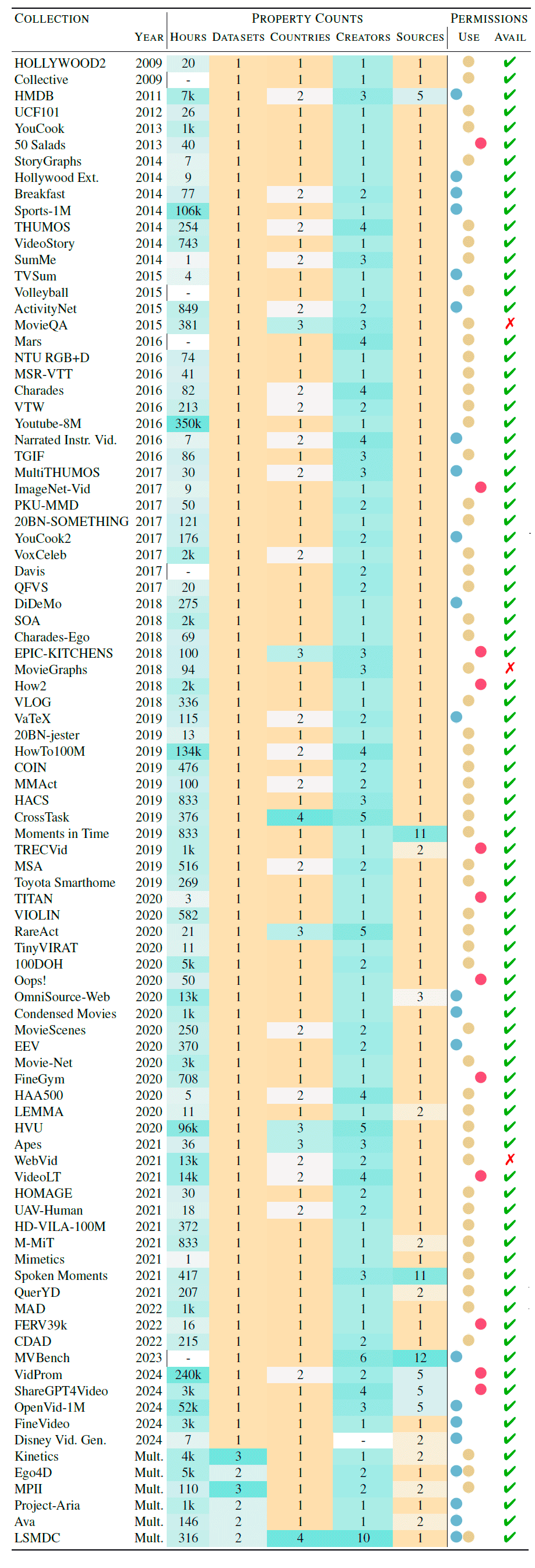

Perusahaan besar mendominasi akuisisi dan kontrol terhadap himpunan data yang berpengaruh. Platform seperti YouTube menyediakan lebih dari 70% data video yang digunakan dalam pelatihan AI, yang berkonsentrasi pada daya luar biasa yang dimiliki beberapa entitas. Sentralisasi ini menghambat inovasi dan menciptakan kendala bagi pemain yang lebih kecil yang kurang memiliki akses ke sumber daya ini.

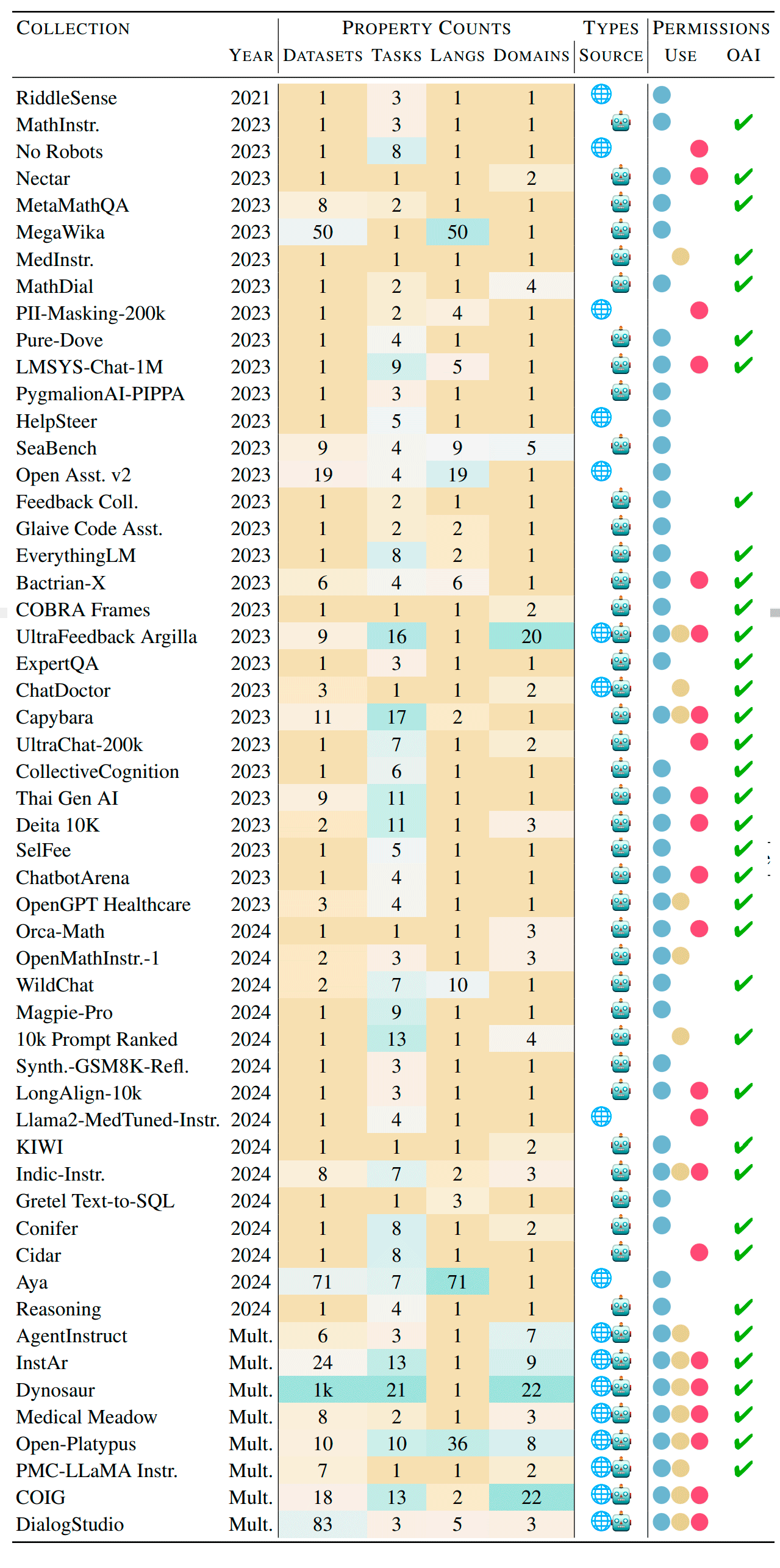

Tabel berikut menunjukkan sumber pengumpulan teks. Properti mencakup jumlah himpunan data, tugas, bahasa, dan domain teks. Kolom Sumber menunjukkan is dari kumpulan : teks yang dibuat manusia di web, output model bahasa, atau keduanya. Kolom akhir menunjukkan status lisensi kumpulan tersebut: biru untuk penggunaan komersial, merah untuk penelitian non-komersial dan akademis, serta kuning untuk lisensi yang tidak jelas. Terakhir, kolom OAI menunjukkan kumpulan yang mencakup pembuatan model OpenAI. Himpunan data tersebut diurutkan secara kronologi untuk menekankan tren seiring waktu. Sumber di sini

Kumpulan data teks:

Kumpulan data video:

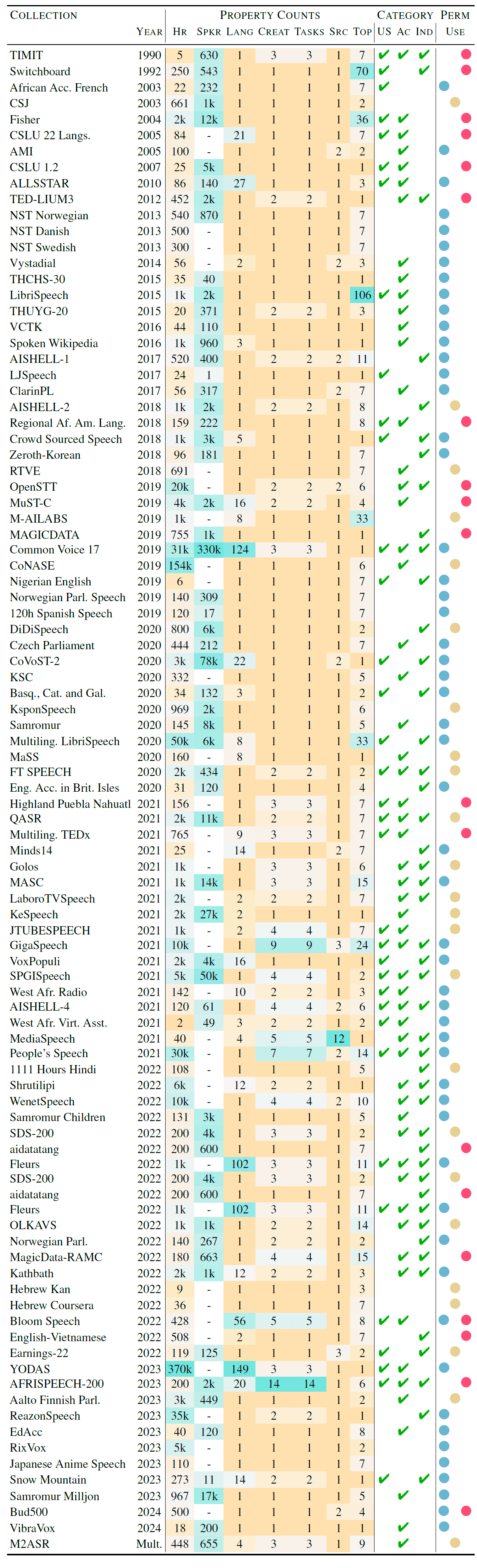

Kumpulan data audio:

Walaupun data yang mudah diakses jelas mulai habis, masih banyak sumber yang belum terpakai:

LLM canggih dapat membantu menyusun dan memanfaatkan himpunan data laten ini untuk pelatihan pada masa depan.

Pembelajaran gabungan memungkinkan model dilatih tentang data sensitif tanpa memindahkannya ke luar lingkungan yang aman. Metode ini sangat tepat untuk industri yang menangani informasi rahasia, seperti perawatan kesehatan, keuangan, dan telekomunikasi. Dengan menyimpan data di lokal, pembelajaran gabungan memastikan privasi selagi memungkinkan peningkatan model kolaboratif.

Pembuatan data sintetis dan augmentasi data menghadirkan jalan untuk memperluas himpunan data pelatihan:

Karena bidang AI terus berkembang, peran himpunan data pun tetap sangat penting. Walaupun kehabisan data yang mudah tersedia menimbulkan tantangan, sangat penting bahwa kita, sebagai peneliti dan peminat AI, sadar dan bertanggung jawab untuk menangani masalah asimetri dan sentralisasi budaya. Solusi inovatif seperti memanfaatkan sumber yang belum digunakan, pembelajaran gabungan, dan pembuatan data sintetis menawarkan jalan untuk maju. Dengan menggabungkan strategi ini, kita dapat memastikan pengembangan AI yang merata dan beragam, membangun jalan menuju sistem kecerdasan buatan yang lebih canggih dan inklusif.

Artikel ini diterjemahkan dari bahasa Inggris. Lihat artikel aslinya di sini.

125 posts | 4 followers

FollowRegional Content Hub - December 15, 2025

Regional Content Hub - July 14, 2025

Alibaba Cloud Community - December 13, 2023

Regional Content Hub - June 11, 2024

Regional Content Hub - April 1, 2024

Alibaba Cloud Community - December 14, 2023

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub