著者:Wang Chen

DeepSeek-R1 と Qwen2.5-Max のリリースによって、中国での AI 推論サービスの需要が高まっています。これにより、モデル性能競争の焦点は、学習から推論にシフトしています。

学習と推論の性能向上は、常に注目されてきました。なぜでしょうか。Web アプリケーションの経験がある人に聞けば、おそらく、性能の向上には、コンピューティングコストの削減とクライアントサイドでのコンテンツ生成の高速化という 2 つの明らかなメリットがあるからだという答えが返ってくるでしょう。

AI モデルが非常に多量のコンピューティングリソースを消費してユーザーへの応答をストリーミングするコンテキストでは、性能は特に重要です。

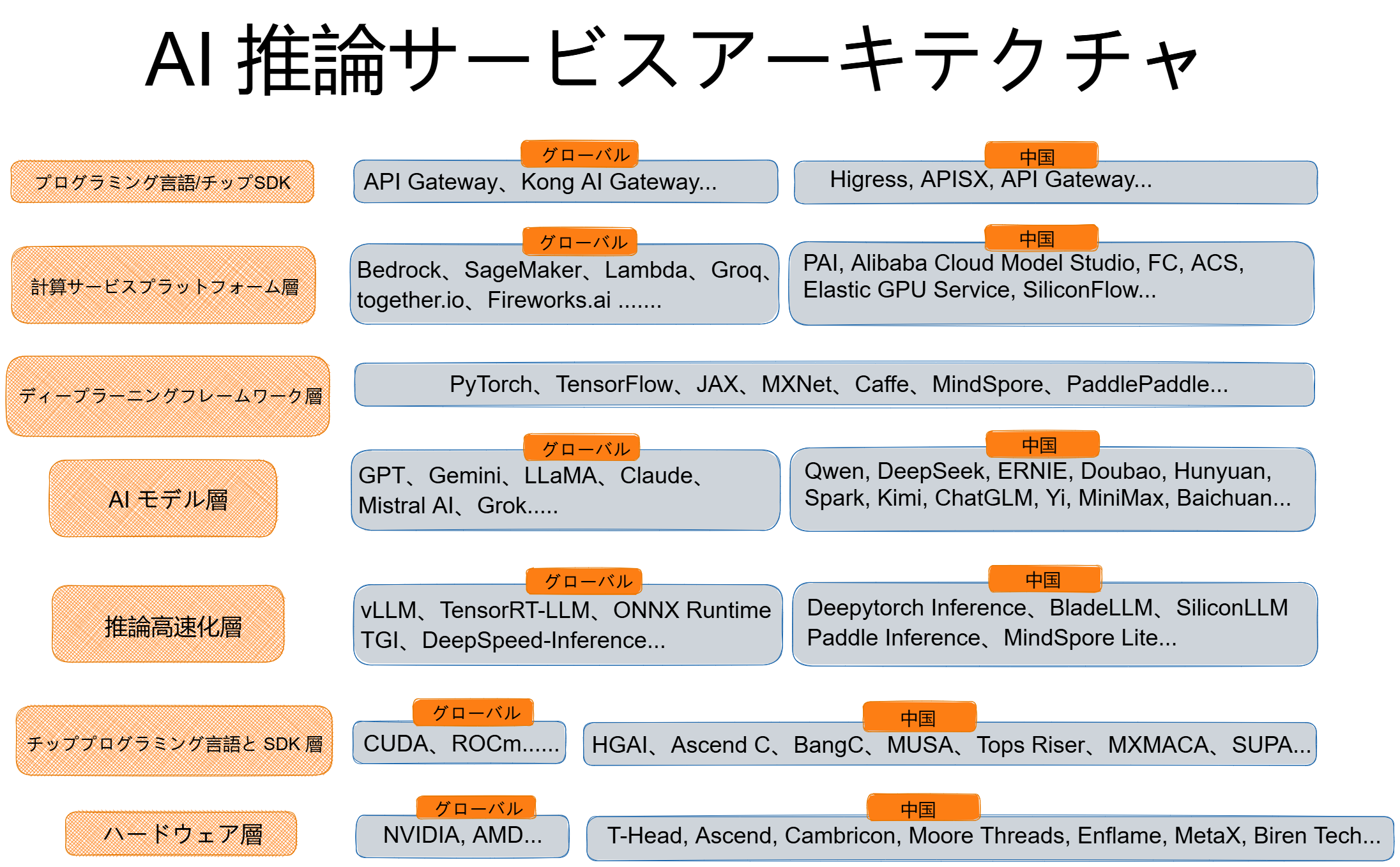

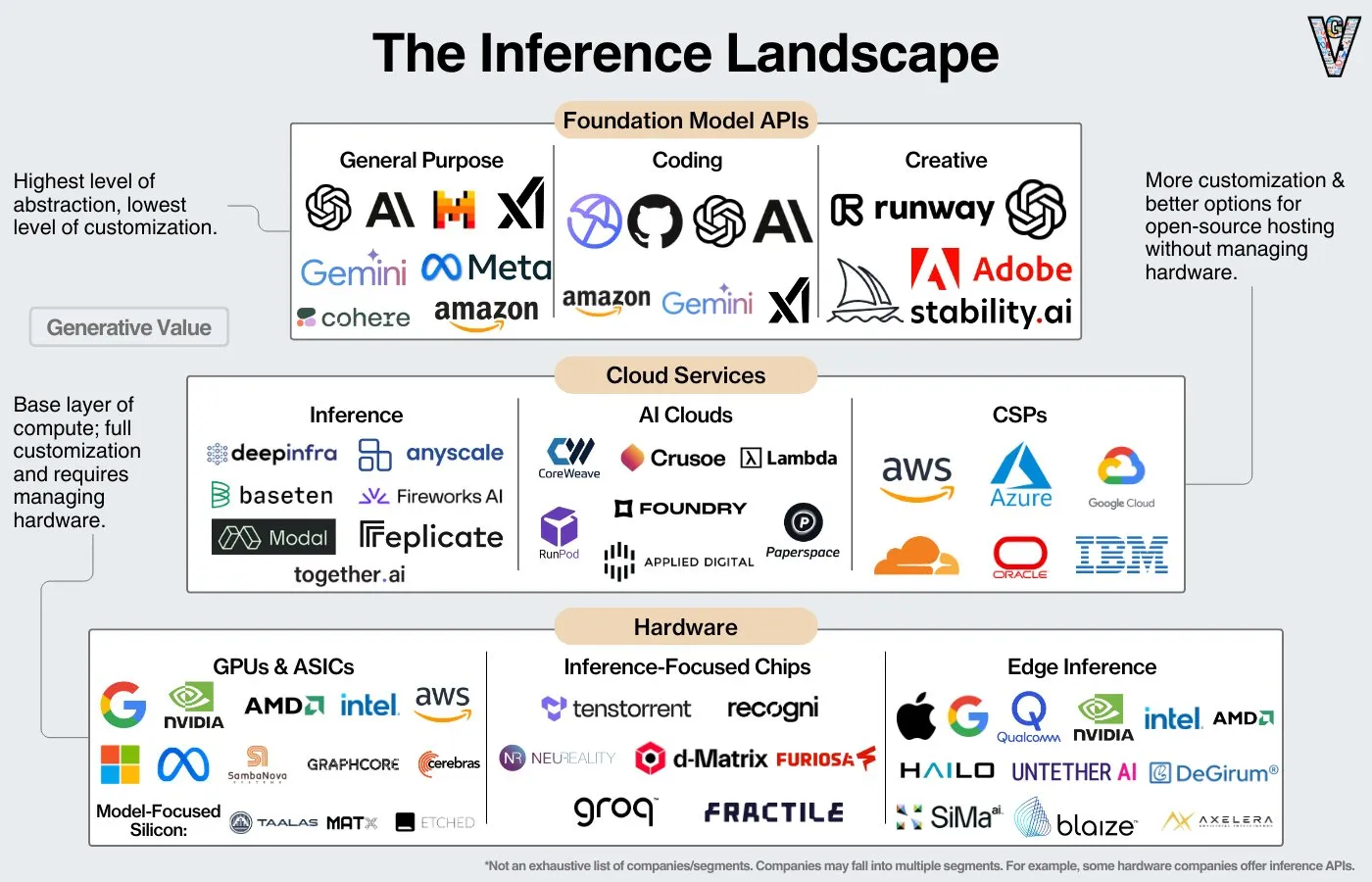

AI 推論サービスのアーキテクチャには、基盤となるハードウェア、AI モデル、および複数のミドルウェア層の連携機能が含まれます。したがって、アーキテクチャを俯瞰的に見ることで、AI の推論性能を最適化するためのソリューションの評価と選択が容易になります。

注:リストされたベンダーまたはアイテムは排他的ではありません。一部のベンダーは、複数の層に関与しています。

計算システムの物理的基盤として、ハードウェア層は、基本的な算術演算と論理演算を実行します。チップの設計は、計算能力の密度、エネルギー効率、および並列処理に直接影響を与えます。世界的に、この市場の主要なプレーヤーには、NVIDIA や AMD などの GPU 企業や、AI 推論用に特別に最適化された製品を提供する Groq などのチップメーカーが含まれています。中国での著名なチップメーカーには、Alibaba の T-Head、Huawei の Ascend、Cambricon などの確立された企業のほか、Moore Threads、Enflame、MetaX、Biren Tech などの新興企業も含まれています。

ハードウェアプログラミングは、基盤となるハードウェアとその上のソフトウェア間のインターフェイスとして機能します。主な考慮事項は、リソースの効率的なオーケストレーション、コマンドマッピング、およびプログラミングの利便性と計算効率のバランスです。この層の例には、NVIDIA CUDA、AMD ROCm、T-Head HGAI、Ascend C、Cambricon BANG C、Moore Threads MUSA、Enflame Tops Riser、MetaX MXMACA、BIRENSUPA などのプログラミング言語および関連するライブラリやツールキット、ドキュメントが含まれます。ただし、CUDA を中心する確立されたエコシステムにより、プログラマーが他の言語に切り替えるのにはコストがかかります。

この層は、AI モデルの開発、学習、デプロイを合理化する基本的なツールと機能で構成されています。経験豊富なパーソナルトレーナーがいればフィットネスの目標をより迅速に達成できるように、優れたフレームワークでモデルの性能を強化できます。以下は人気のフレームワークですが、PyTorch と TensorFlow が主要な選択肢です。

• PyTorch: 元々は Facebook の AI Research lab によって開発された PyTorch は、実行中にオンザフライで変更可能な動的計算グラフを備えています。Python と深く統合されており、直感的な API と柔軟なプログラミング体験が提供されています。このフレームワークは、迅速なプロトタイプの開発、研究、実験、特に頻繁なモデルの変更とイテレーションを伴うシナリオに最適です。

• TensorFlow: DistBelief に基づいて構築された Google の第 2 世代機械学習システムである Tensorflow は、JavaScript、C、Java などの複数のプログラミング言語をサポートしています。音声認識や画像認識など、機械学習やディープ・ラーニングのタスクに広く使用されています。サポートされているアルゴリズムには、CNN、RNN、および LSTM が含まれます。

• JAX: Google の JAX は、研究者がハードウェアアクセラレータの能力を完全に活用しながら、アルゴリズムのテストを簡単に実行できるように設計されています。JAX は、自動微分と並列コンピューティングに優れています。

• MindSpore: Huawei のディープ・ラーニングと推論のための新しいオープンソースフレームワークである MindSpore は、デバイスエッジクラウドシナリオに適しています。Ascend AI プロセッサとネイティブに連携し、ハードウェア・ソフトウェア協調設計を通じて性能を向上させます。

• PaddlePaddle: Baidu の PaddlePaddle は、ディープ・ラーニングモデルの学習効率を高めるオープンソースフレームワークです。複数の GPU を備えた複数のノードにわたる分散学習をサポートし、計算能力の使用を最適化します。

• Apache MXNet: MXNet は AWS の公式に採用されたディープ・ラーニングフレームワークで、ワシントン大学の Carlos Guestrin によって共同開発されました。C ++、Python、Java、Julia、MATLAB、JavaScript、Go、R、Scala などのさまざまなプログラミング言語をサポートしています。

• Caffe: Caffe は、Berkeley AI Research と Berkeley Vision and Learning Center により、コミュニティの貢献を得て開発されました。新しいデータ形式、ネットワーク層、および損失関数を簡単に拡張できるモジュール設計が特徴です。

この層は、AI モデル推論の計算効率とリソース使用率を最適化するために設計されています。コンパイル、量子化、バッチ処理などのテクノロジーを活用することで、遅延とコストを削減します。推論高速化の分野には、クラウドベンダー、ソフトウェアプロバイダー、モデルコミュニティ、研究機関など、さまざまなプレーヤーがおり、API 呼び出しを介してアクセス可能な AI モデルに接続するオープンソースや独自のソリューションを提供しています。

本質的に、推論高速化は、GPU メモリ使用量を最小限に抑えつつ、最大の計算能力を提供することに重点を置いています。推論高速化の理想的なソリューションは、より少ないリソースを必要としながら、より高いパフォーマンスを実現します。以下は、人気のソリューションのいくつかです。

• vLLM:LLM の推論とサービングを行うための使いやすいライブラリです。元々はカリフォルニア大学バークレー校の Sky Computing Lab で開発された vLLM は、Paged Attention メカニズムを使用してメモリの断片化を効果的に軽減し、メモリ利用率を高めます。vLLM は、Qwen や Llama などのさまざまな LLM をサポートし、Hugging Face エコシステムとうまく統合されているため、ユーザーは Hugging Face Hub から直接モデルの重みを読み込むことができます。

• TensorRT-LLM:NVIDIA TensorRT-LLM は、TensorRT を基盤とするオープンソースの LLM ライブラリです。Tensor コアなどの NVIDIA ハードウェア機能の可能性を最大限に活用し、CUDA、cuBLAS などの他の NVIDIA ツールやライブラリとシームレスに統合されています。Triton と統合することで、NVIDIA GPU で迅速な推論を実行できます。

• ONNX ランタイム:Microsoft によって開発および保守されている、軽量の、パフォーマンス専有型クロスプラットフォーム推論エンジンです。さまざまなディープ・ラーニングフレームワーク間のギャップを埋めるように設計されており、AI モデルがさまざまな環境で効率的に実行できるようにすることで、モデルの移植性とデプロイ効率を向上させます。

• テキスト生成推論 (TGI):TGI は、Hugging Face Transformers ライブラリを活用して、AI モデルのデプロイとサービングを容易にするツールキットです。TGI は、複数の GPU にまたがる分散推論をサポートし、モデルサービング機能を強化します。

• Deepytorch Inference:Alibaba Cloud の Elastic GPU Service チームによって開発された AI モデル推論アクセラレータである Deepytorch Inference は、PyTorch モデルのパフォーマンス専有型の推論高速化を提供するように設計されています。Deepytorch Inference は、計算グラフの分割、実装層の結合、およびパフォーマンス専有型演算子の実装を通じて、PyTorch モデルの推論性能を大幅に向上させます。

• BladeLLM:BladeLLM は、LLM 用に最適化された推論エンジンです。BladeLLM は、Alibaba Cloud の Platform for AI (PAI) チームによって開発され、モデル計算、生成エンジン、サービスフレームワーク、アプリケーション層を強化し、主流のオープンソースフレームワークを上回る性能を実現します。

• TurboMind:上海人工知能研究所によって開発された TurboMind は、LlamaLLM 向けのオープンソース推論高速化エンジンです。動的バッチ処理と連続バッチ処理をサポートしています。

• 中国以外の開発者からのトップティアモデル:OpenAI GPT、Google Gemini、Meta Llama、Anthropic Claude、Mistral AI、X Grok。Meta は Llama モデルのコアコンポーネントをオープンソース化しており、Mistral AI も同じことを行っています。他の AI モデルは、技術レポートや部分的オープンソース化の取り組みを通じてコミュニティに貢献しています。

• 中国のトップティアモデル:Alibaba Cloud Qwen、DeepSeek、Baidu ERNIE、ByteDance Doubao、Tencent Hunyuan、iFlytek Spark、Kimi。Qwen と DeepSeek はコアコンポーネントをオープンソース化しており、他の AI モデルは技術レポートや部分的オープンソース化の取り組みを通じてコミュニティに貢献しています。

オープンソース LLM は、クローズドソースの LLM の追随する存在ではなくなりました。むしろ、現在のオープンソースプロジェクトは AI 開発を主導し始めており、DeepSeek と Qwen はその先頭に立っています。

この層は、米国の輸出制御の対象となる GPU リソースに大きく依存しています。その結果、ほとんどの中国の主要プレーヤーは、PAI、Alibaba Cloud Model Studio、Function Compute (FC、サーバーレス GPU 機能を提供)、Container Compute Service (ACS)、Elastic GPU Service などのサービスを提供する、Alibaba Cloud などのパブリッククラウドベンダーとなっています。世界的には、AI モデルを中心とした本格的なエコシステムと GPU の購入に対するより緩い制限を背景に、クラウドベンダー、チップメーカー、ソフトウェアプロバイダーなど、さまざまなプロバイダーが存在します。注目すべき例には、Groq、Together AI、Fireworks AI が含まれます。

この層は、モデルを実際のビジネスユースケースで活用する上で重要です。モデル、ツールキット、データ、モデルサービングを統合し、複雑な AI プロセスの作成と実装を自動化し、生成能力を向上させます。

• LangChain:LangChain は、2022 年に Harrison Chase によって作成されたオープンソースプロジェクトで、ユーザーはチェーン、エージェント、メモリの 3 つのコアコンポーネントを介してツールを柔軟に組み合わせることができます。OpenAI を含む 30 以上の AI モデルをサポートし、Wikipedia や Wolfram Alpha などの 200 以上の外部サービスと統合されています。さらに、Chroma や Pinecone などのベクターデータベース向けの組み込み API を提供し、リアルタイムの RAG を容易にします。

• LlamaIndex:データ処理とインデックス作成に重点を置いた LlamaIndex は、ドメイン固有の Q&A など、大量のデータの効果的な管理と利用を必要とするユースケースに最適です。

LangChain と LlamaIndex はどちらも、Python 開発者向けのオープンソースプロジェクトです。

• Spring AI Alibaba:Spring および Java 開発者向けのオープンソースエージェント開発フレームワークであり、AI エージェント開発のための汎用パラダイムを提供し、基本機能 (チャットボット、プロンプトテンプレート、関数呼び出しなど) から高レベルの抽象化 (エージェントオーケストレーション、チャットメモリ管理など) まで、中国の AI モデルに最適化されています。さらに、Spring AI Alibaba はアプリケーションのデプロイと O&M のベストプラクティスを提供し、ゲートウェイ統合、構成管理、デプロイ、観察可能性などの側面をカバーしています。

LangChain、LlamaIndex、Spring AI Alibaba は、アプリケーション開発のためのコードレベルで柔軟性の高いフレームワークです。

• Dify:Dify は、AI エージェントの構築、AI ワークフローオーケストレーション、RAG、モデル管理をサポートするオープンソースの LLM アプリケーション開発プラットフォームです。ユーザーが GenAI アプリケーションを簡単に構築および操作できるようにします。

• Alibaba Cloud Model Studio:AI モデル開発およびアプリケーション構築のためのワンストッププラットフォームであり、開発者とビジネスプロフェッショナルの両方が AI アプリケーションを設計および作成できるようにします。ノーコード開発オプションを提供し、ユーザーはユーザーインターフェイスでマウスをクリックするだけで簡単に AI アプリケーションを構築できます。

さらに、Alibaba Cloud の Cloud Application Platform と FC により、ユーザーはコンピューティングリソースを活用し、サーバーレスで AI アプリケーションを調整できます。

Dify、Alibaba Cloud Model Studio、および Cloud Application Platform と FC の組み合わせは、ローコード AI プラットフォームであり、後者の 2 つは推論のためのコンピューティングリソースを提供しています。

AI モデルのデプロイと提供に不可欠なミドルウェアとして、この層はトラフィック、サービス、セキュリティ、API を管理し、ワークロードの急増時でも安定した低遅延の性能を保証します。トラフィック管理は、AI モデル学習アーキテクチャではオプションですが、Web アプリケーションアーキテクチャと同様、AI モデル推論アーキテクチャでは不可欠です。

従来の Web アプリケーションとは異なり、AI アプリケーションには次の特性と要件があります。

• 長期接続:AI アプリケーションのサービングで一般的に使用される Websocket と SSE は、長期接続を作成します。したがって、ゲートウェイ構成の更新は、これらの接続またはアプリケーションサービスへの影響を回避するために、中断しない必要があります。

• 高遅延:LLM 推論の応答時間は他のアプリケーションよりも大幅に長く、AI アプリケーションは持続的な遅延リクエストによる洪水攻撃などの攻撃に対して脆弱になります。この種の攻撃は、実行が容易でありながら、サーバーにかなりの負荷をかける可能性があります。

• 高帯域幅:LLM とユーザーの間でコンテキストが高遅延で交換されるため、AI アプリケーションは他のアプリケーションよりも多くの帯域幅を消費します。したがって、ゲートウェイは、メモリ使用の突然の急上昇を防ぐために、強力なストリーム処理能力と効果的なメモリ再利用メカニズムを備えている必要があります。

• サービス中断のリスク:Web アプリケーションと比較して、AI アプリケーションは、応答を配信するためにより多くの時間を必要とします。対話の継続性はユーザーエクスペリエンスにとって非常に重要であるため、トラフィック管理ツールはバックエンドプラグインの更新によるサービスの中断を防ぐ必要があります。

• 高いリソース消費量:Web アプリケーションと比較して、AI アプリケーションは、リクエストを処理するときに、クライアントよりもサーバー上ではるかに多くのリソースを消費します。したがって、低コストのクライアント攻撃によってサーバーが圧倒されるのを防ぐために、堅牢なアーキテクチャを導入する必要があります。

• グレーマーケットのリスク管理:多くの AI アプリケーションは、ユーザーを引き付けるために無料の使用枠を提供しています。この使用枠が金銭目的で販売されるのを防ぐための措置を講じる必要があります。

• コンプライアンスと安全性:既存の情報に基づいて結果を生成する Web アプリケーションとは異なり、AI アプリケーションは推論を通じてコンテンツを生成します。生成されるコンテンツのコンプライアンスと安全性を確保することが不可欠です。

• 互換性:アプリケーションが複数の AI モデルにアクセスする場合、API 呼び出しの違いを効果的に管理し、互換性コストを最小限に抑える必要があります。

NGINX を API Gateway として使用するだけでは、AI アプリケーションのこれらの特性や、それに伴って生じる新しい要件には対応できません。その結果、Envoy を搭載したオープンソースゲートウェイが世界中で注目を集めています。

• Higress:Istio と Envoy を搭載し、ビジネスニーズを満たすように最適化された Higress は、Web アプリケーションと AI アプリケーションにデプロイできるクラウドネイティブ API Gateway です。Tongyi Qwen アプリ、Alibaba Cloud Model Studio での API 呼び出し、PAI、FastGPT、China United Property Insurance の AI アプリケーションをサポートしています。

• Kong AI Gateway:Kong Gateway を基盤とした Kong AI Gateway は拡張性が高く、開発者はトラフィック制御、データ変換、モデルフレームワークのスケジューリングなど、さまざまなタスク用のカスタムプラグインを作成できます。

• Alibaba Cloud のクラウドネイティブ API Gateway:このサービスは、AI モデル API のライフサイクル全体を管理し、PAI や FC などの他の Alibaba Cloud プロダクトとシームレスに統合できます。さらに、Higress との互換性を通じて、オープンソース機能の強化を実現します。

AI 推論サービスのスタックには、もう一つの層として、アプリケーション実装層が存在します。この層のベンダーは、AI モデルインフラやそれぞれの業界の専門知識を持ち、オープンソースの AI モデルとミドルウェアを活かし、統合サービスやオンプレミスでデプロイできるサービスを提供しています。簡潔にするためにこの記事では詳しく説明しませんが、これらのベンダーは AI モデルのランドスケープとアプリケーションエコシステム全体で重要な役割を果たします。

DeepSeek と Spring AI を使用してローカルでAIエージェントを作成するためのステップバイステップガイド

639 posts | 55 followers

FollowRegional Content Hub - April 21, 2025

Regional Content Hub - August 5, 2024

Regional Content Hub - March 8, 2024

Regional Content Hub - August 28, 2024

Regional Content Hub - December 23, 2024

Regional Content Hub - January 19, 2024

639 posts | 55 followers

Follow AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Offline Visual Intelligence Software Packages

Offline Visual Intelligence Software Packages

Offline SDKs for visual production, such as image segmentation, video segmentation, and character recognition, based on deep learning technologies developed by Alibaba Cloud.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Network Intelligence Service

Network Intelligence Service

Self-service network O&M service that features network status visualization and intelligent diagnostics capabilities

Learn MoreMore Posts by Alibaba Cloud Native Community