By Jawad

Tongyi Qianwen-7B(Qwen-7B)는 Alibaba Cloud에서 개발한 Tongyi Qianwen 거대 모델 시리즈 중 70억 개 매개변수 규모의 모델입니다.

Qwen-7B는 초대형 사전 학습 데이터로 학습된 Transformer 기반의 거대 언어 모델(LLM)입니다. 사전 학습 데이터 유형은 다양하며 수많은 온라인 텍스트, 전문 서적, 코드 등 광범위한 영역을 포괄합니다.

모델에 대한 자세한 설명은 다음을 참조하십시오.

https://www.modelscope.cn/models/qwen/Qwen-7B-Chat/files

이 문서에서는 그래픽 사용자 인터페이스(GUI)와 명령줄 인터페이스(CLI)를 통해 Tongyi Qianwen-7B 모델과 상호 작용하는 두 가지 접근 방식을 살펴보겠습니다.

참고:

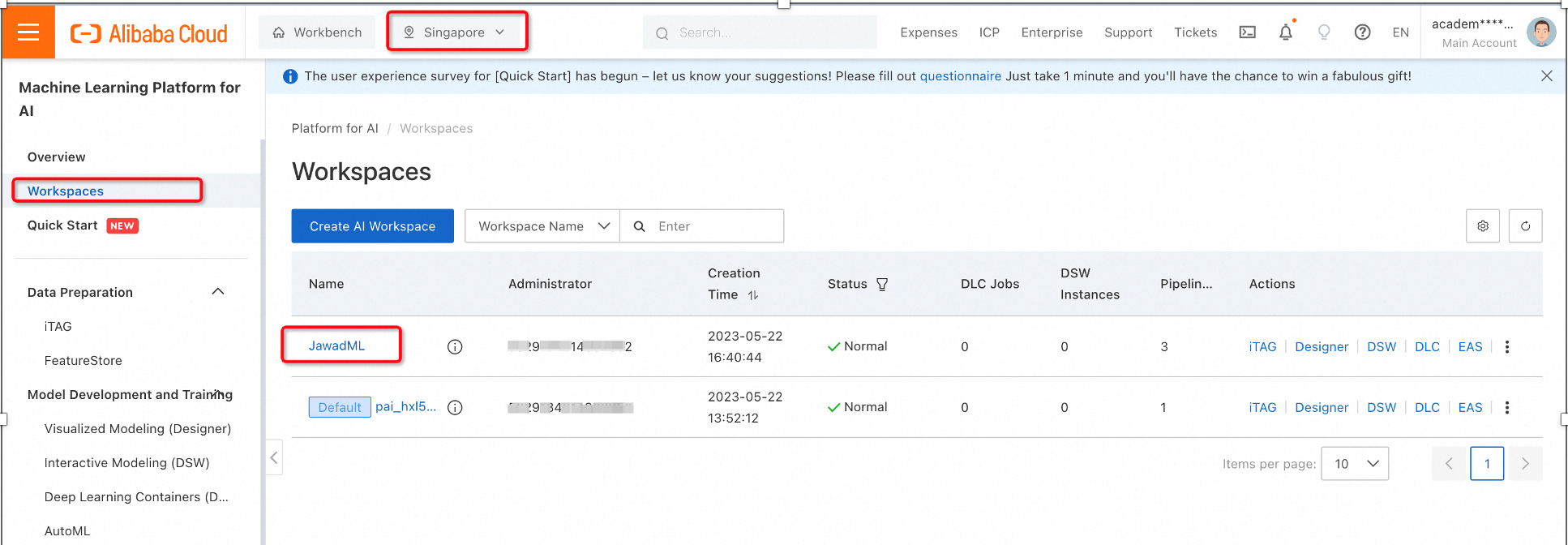

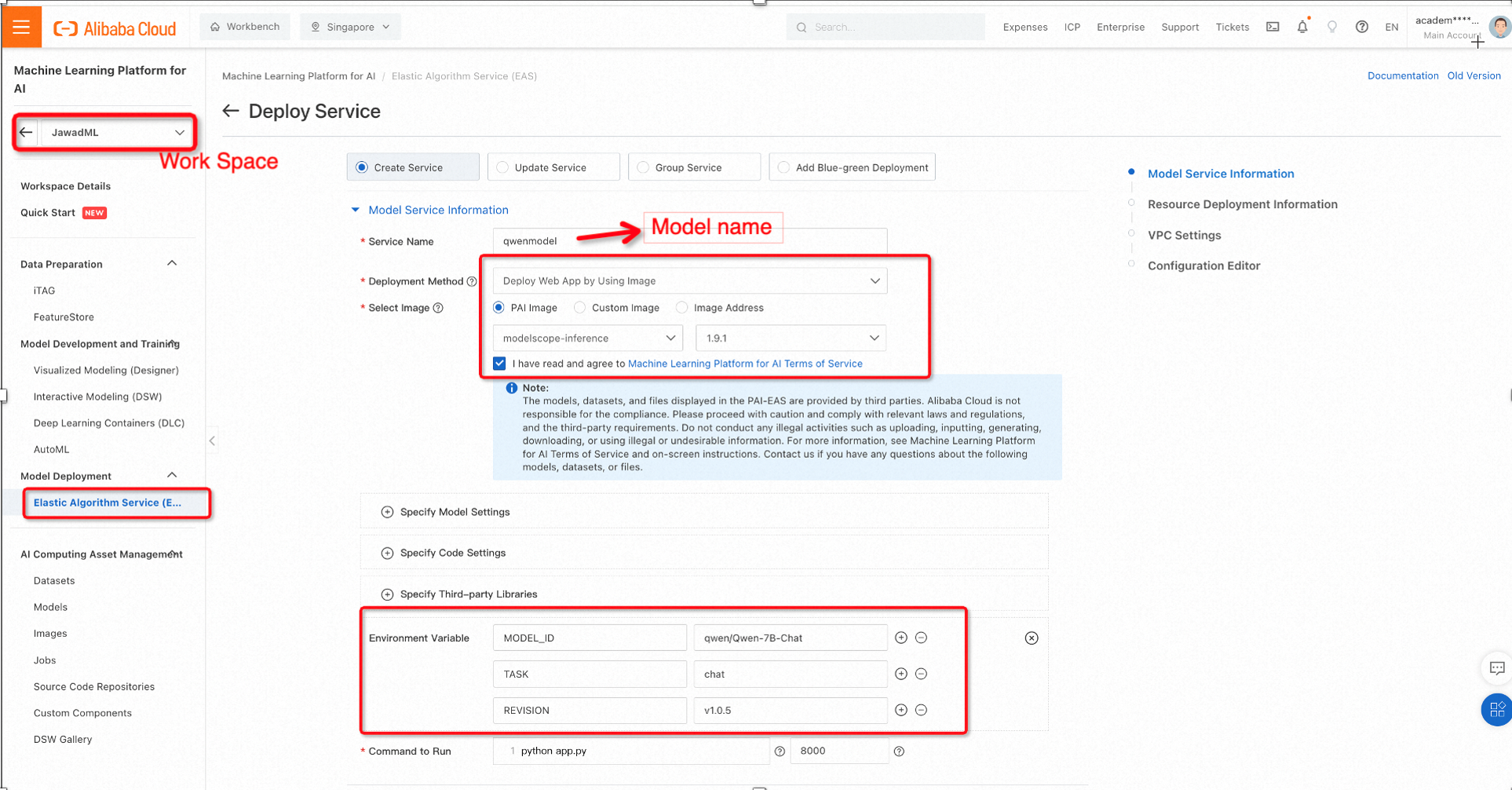

1. PAI 플랫폼에서 워크스페이스를 선택하고 모델 배포에서 Elastic Algorithm Service(EAS)를 선택한 다음 서비스 배포를 클릭합니다.

2. 이미지와 환경 변수를 선택하기 위해 다음 구성을 사용하여 ModelScope에서 사전 학습된 모델을 사용할 것입니다.

ModelScope는 Alibaba cloud에서 개발한 오픈소스 서비스형 모델(MaaS) 플랫폼으로, 글로벌 개발자와 연구자를 위해 사전 학습된 대규모 모델을 포함하여 수백 개의 AI 모델이 포함되어 있습니다.

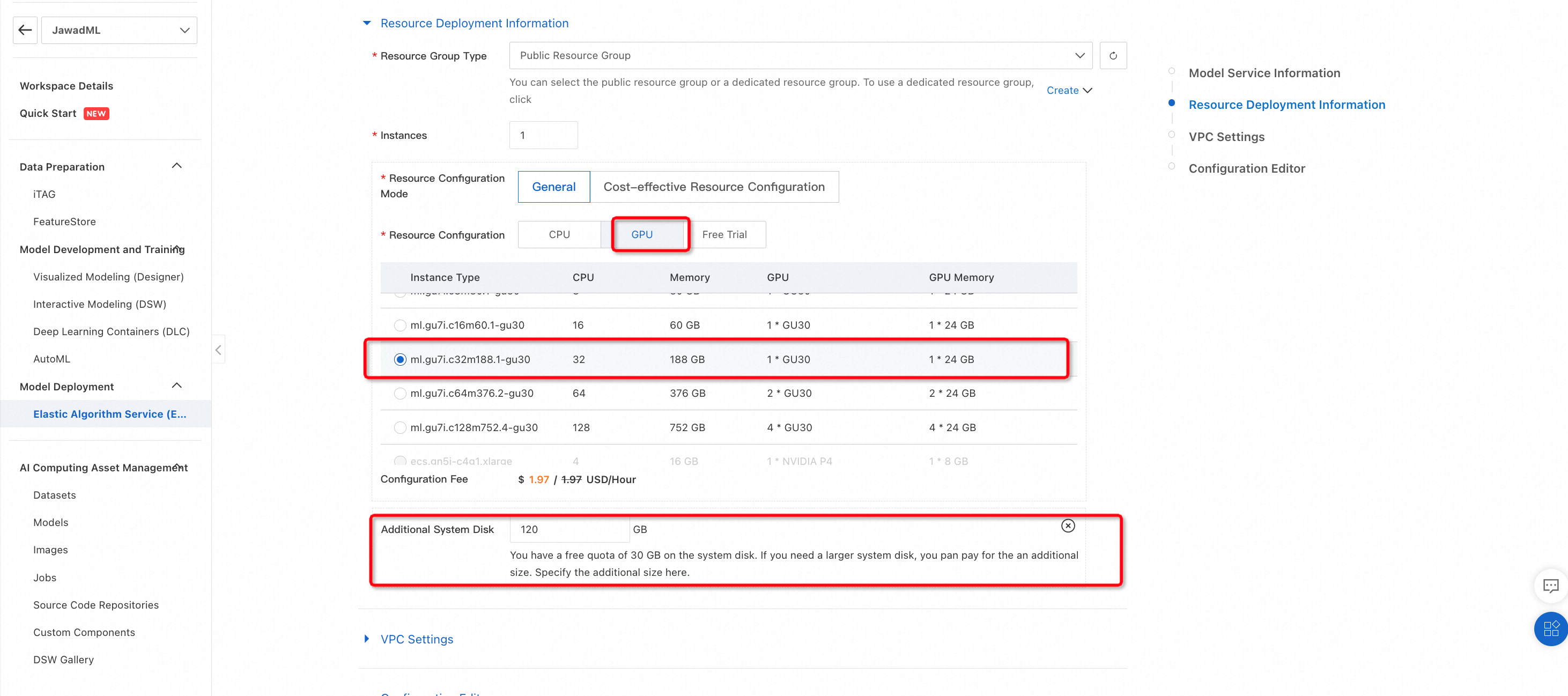

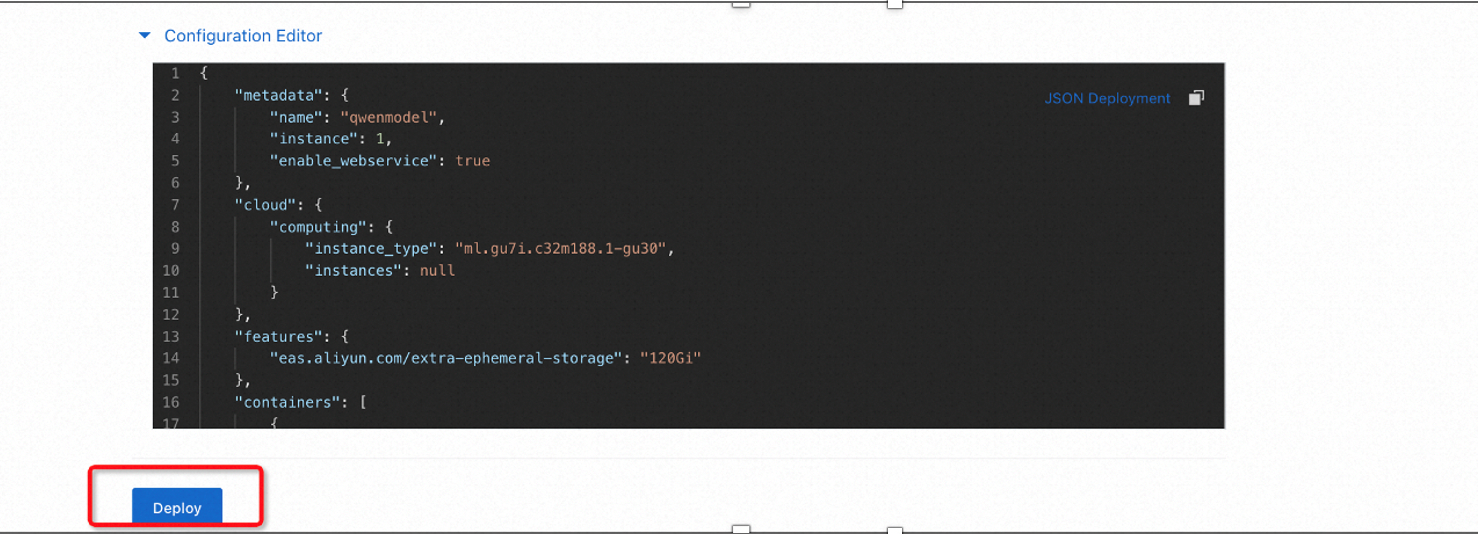

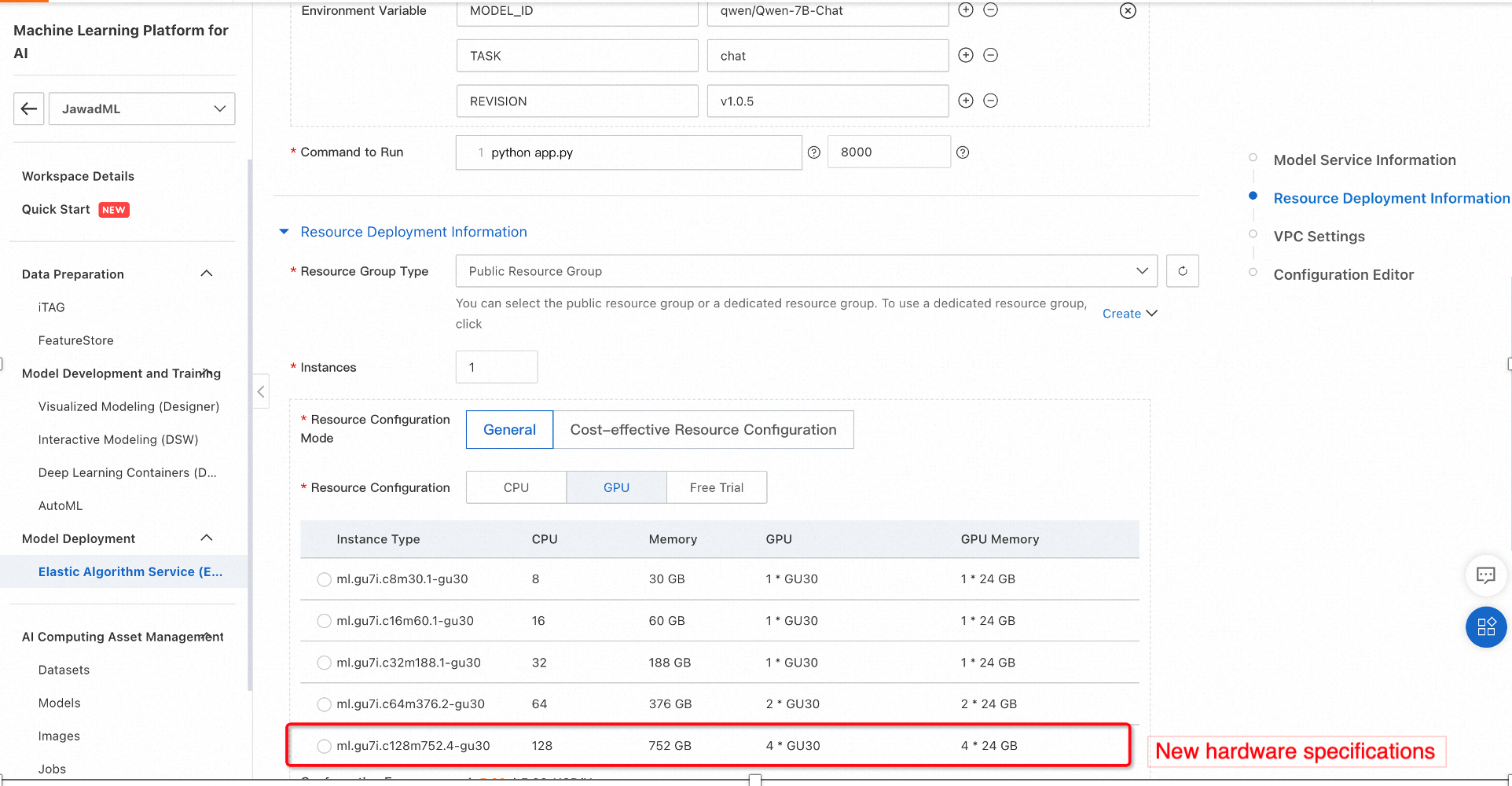

Alibaba Cloud PAI는 추론을 위해 머신러닝 모델을 실행할 수 있는 하드웨어에 대한 다양한 옵션을 제공합니다. 이 경우 충분한 메모리가 있는 GPU를 사용할 수 있습니다. 다음 구성을 선택하고 배포를 클릭합니다.

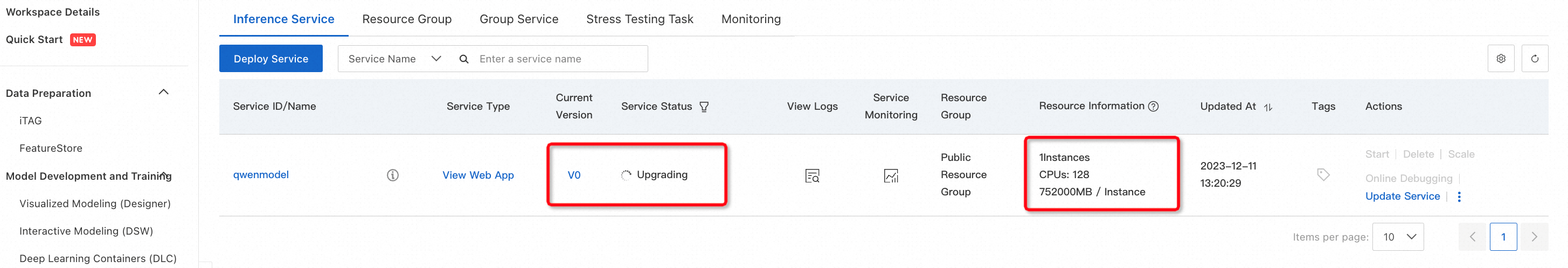

그러면 선택한 하드웨어에 사전 학습된 Qwen-7B 모델이 배포되기 시작합니다. 이 과정은 다소 시간이 걸릴 수 있으므로 배포 과정 중에 다양한 이벤트를 확인하는 것이 좋습니다.

3. 생성 프로세스 확인

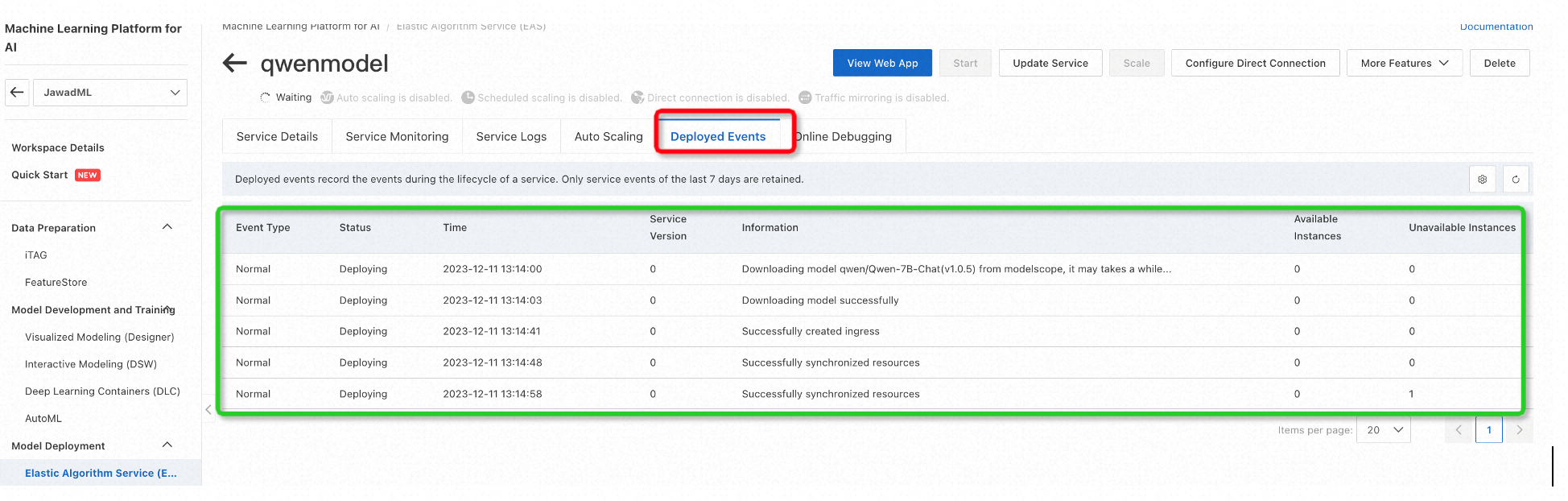

배포 이벤트를 확인하고 모든 것이 정상인지 확인하려면 서비스 ID/이름(이 경우 qwenmodel)을 클릭한 다음 배포 이벤트를 선택합니다.

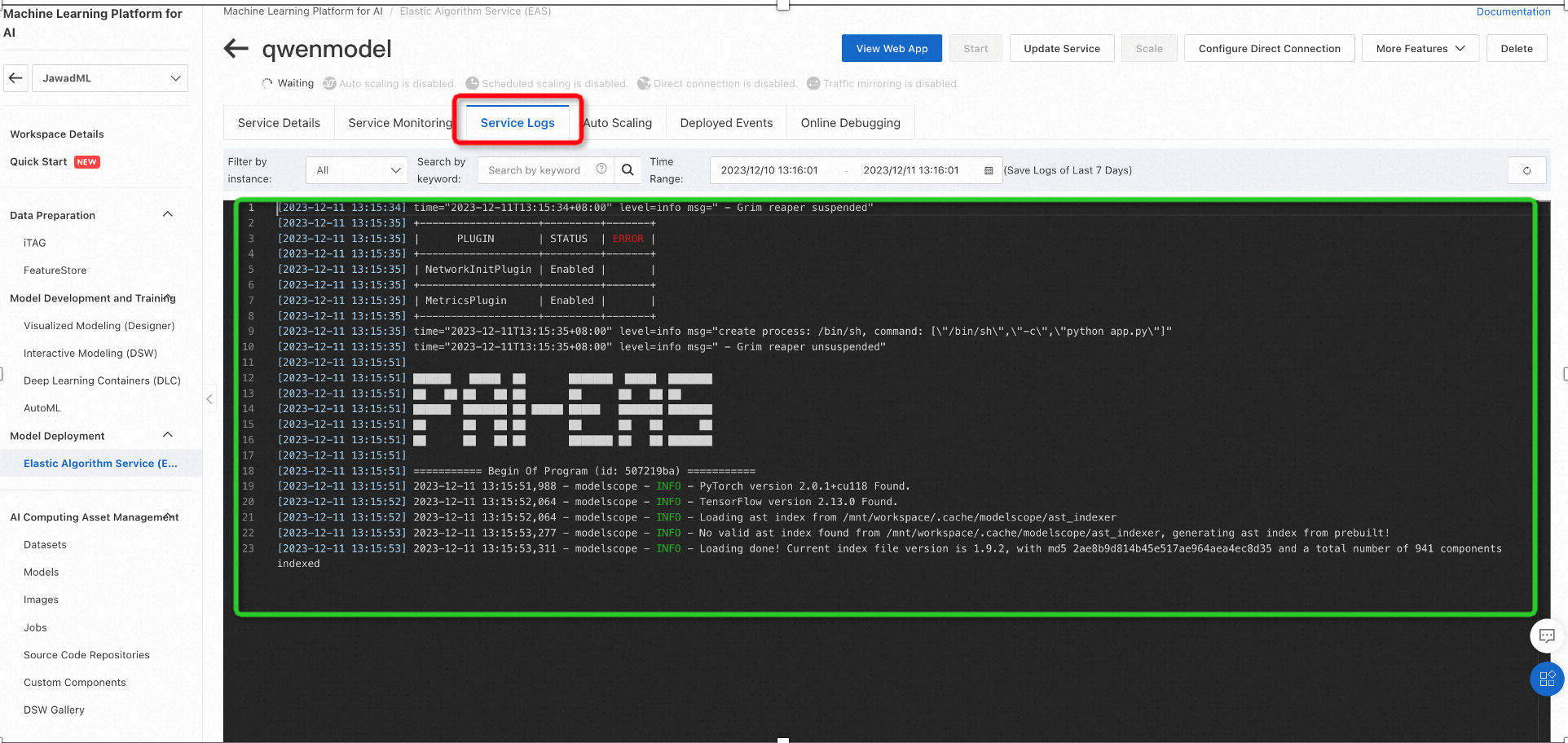

마찬가지로 Service Logs를 사용하면 아래와 같이 패키지 설치 관련 로그를 확인할 수 있습니다.

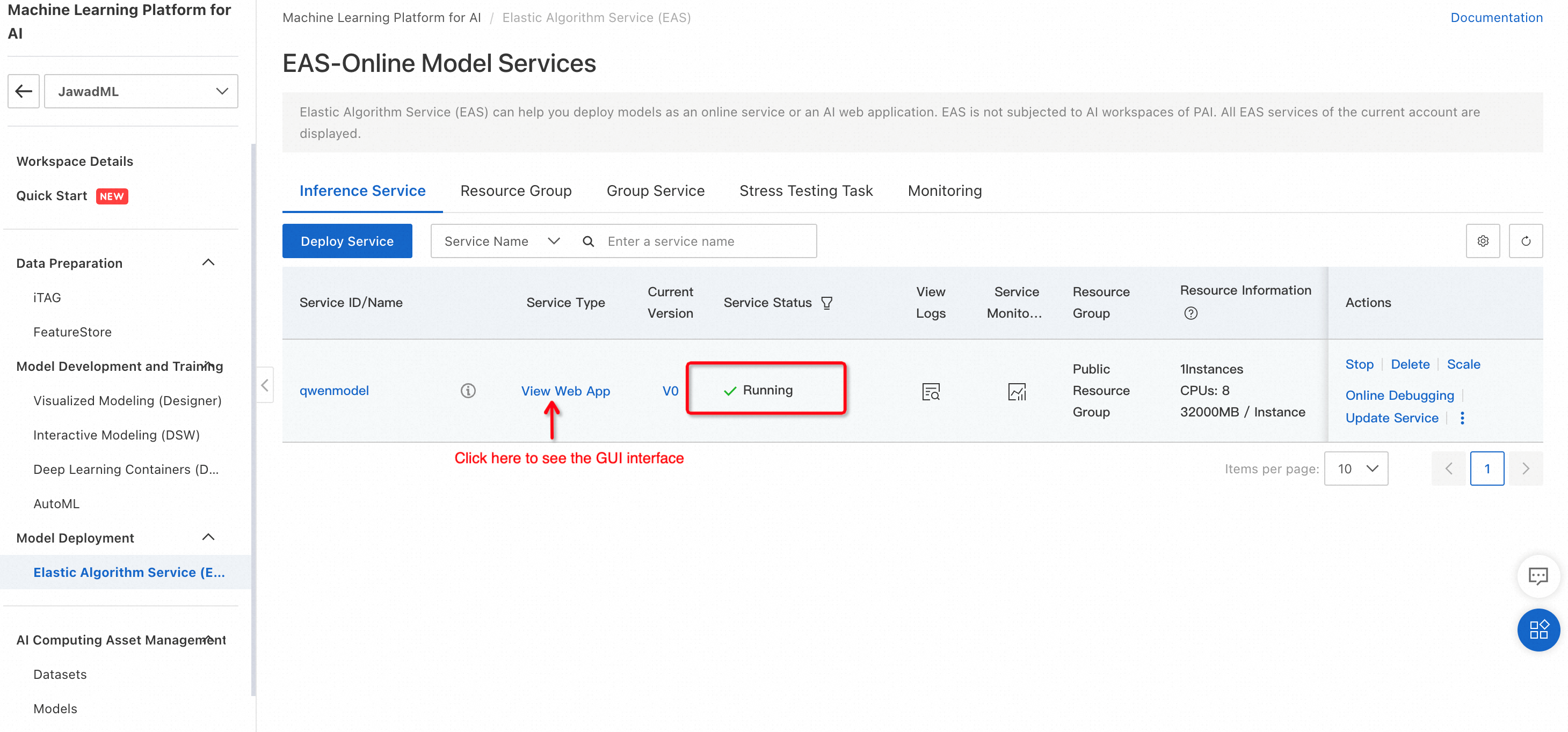

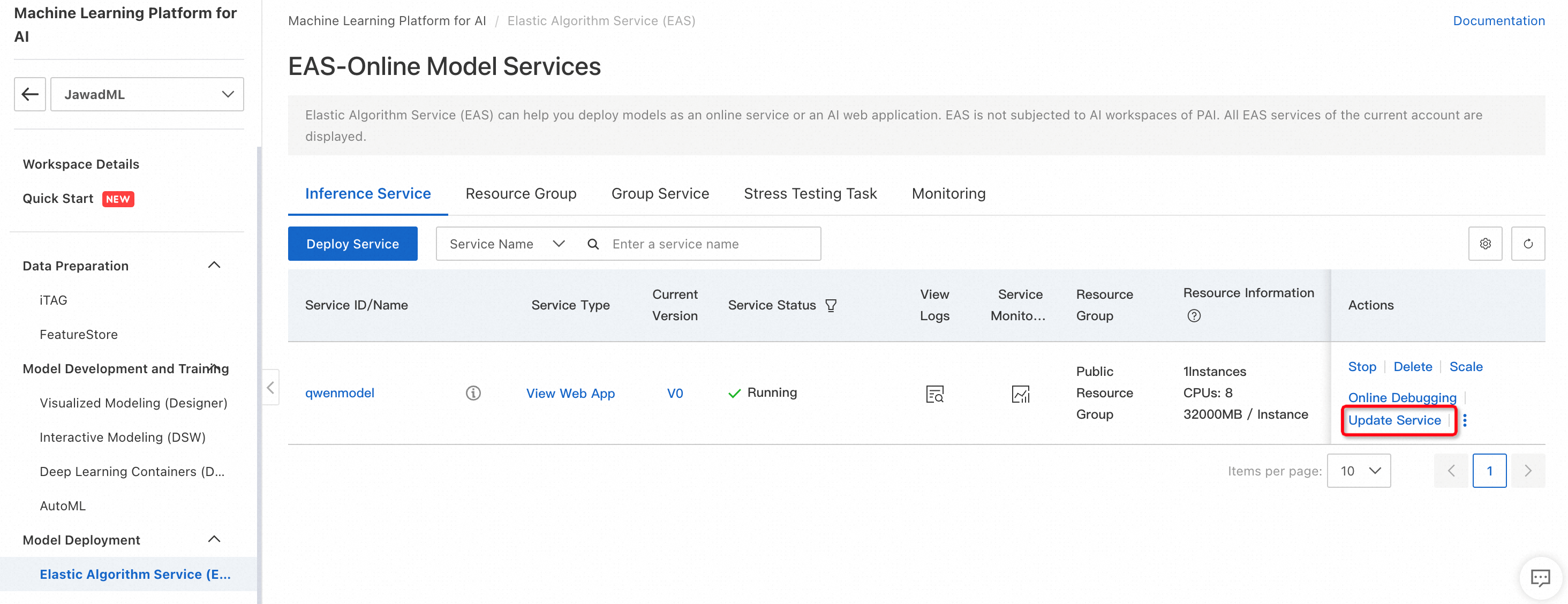

모델이 성공적으로 배포되면 서비스 상태가 Running으로 변경됩니다.

추론에 모델을 사용하려면 View Web App를 클릭합니다. 그러면 텍스트 생성을 위한 테스트에 사용할 수 있는 모델의 GUI 인터페이스가 열립니다.

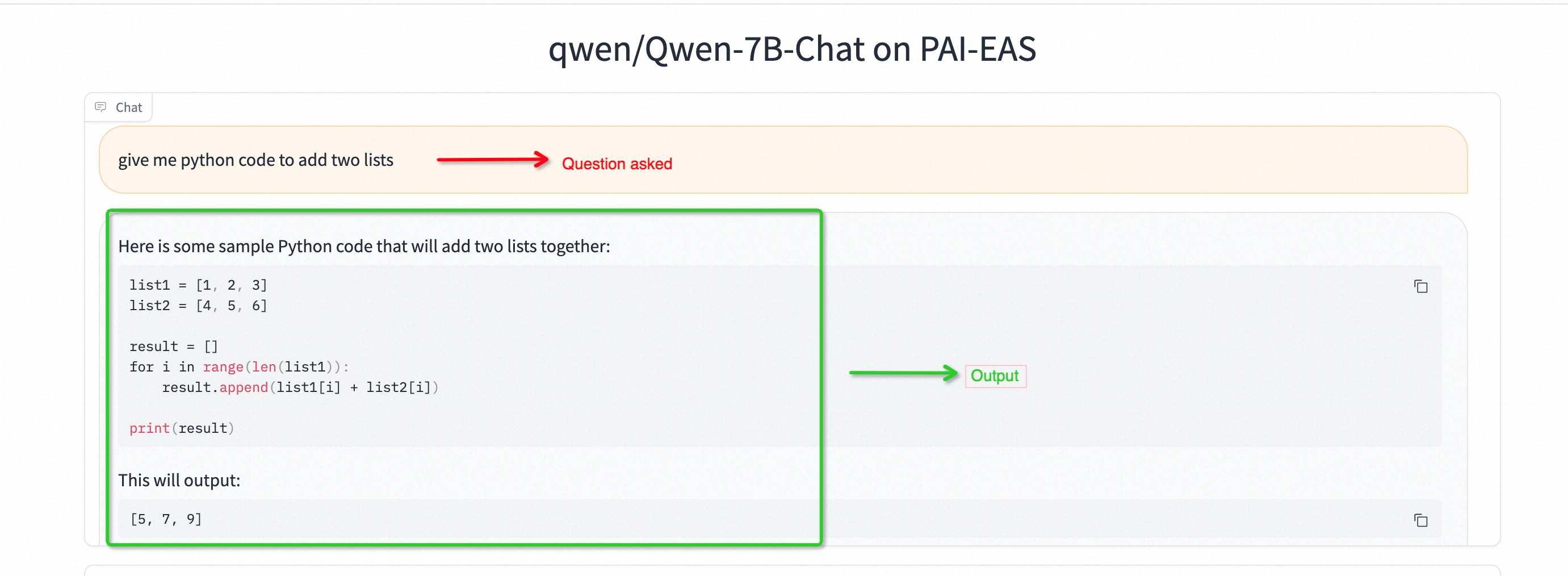

4. 테스트: python 코드 생성을 위한 Qwen-7B

GUI 모드를 사용하면 모델이 전체 입력 텍스트를 처리한 다음 전체 텍스트를 생성한다는 점에 유의해야 합니다.

5. 성능 향상을 원한다면 업그레이드하기(선택 사항)

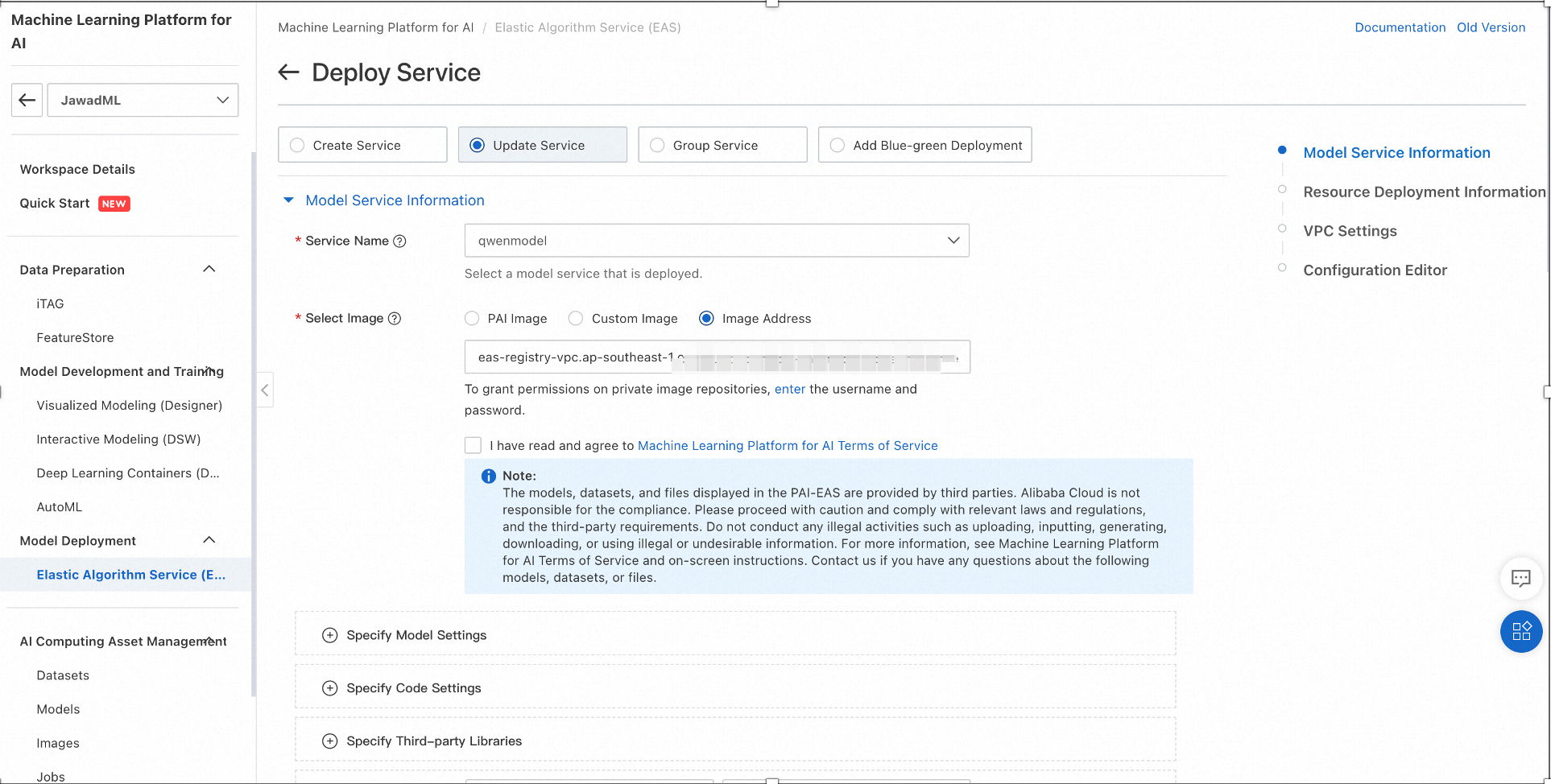

필요한 경우 하드웨어 구성을 변경할 수 있습니다. 아래 그림과 같이 Update Service를 클릭하면 설정 창이 열립니다.

아래 그림은 추론 엔진의 하드웨어 구성을 변경하는 방법을 보여줍니다. 설정이 변경되면 Deploy를 클릭합니다.

구성 변경에는 다소 시간이 걸립니다. 완료되면 서비스 상태가 Upgrading에서 Running으로 바뀝니다.

실행 중인 텍스트 응답을 생성할 수 있는 CLI 모드에서 Qwen 7-B를 구현할 수 있습니다. 이를 위해 PAI 대화형 모델링(DSW) 또는 ECS 인스턴스를 사용할 수 있습니다. 여기서는 DSW 기반 구현에 대해 설명하겠습니다.

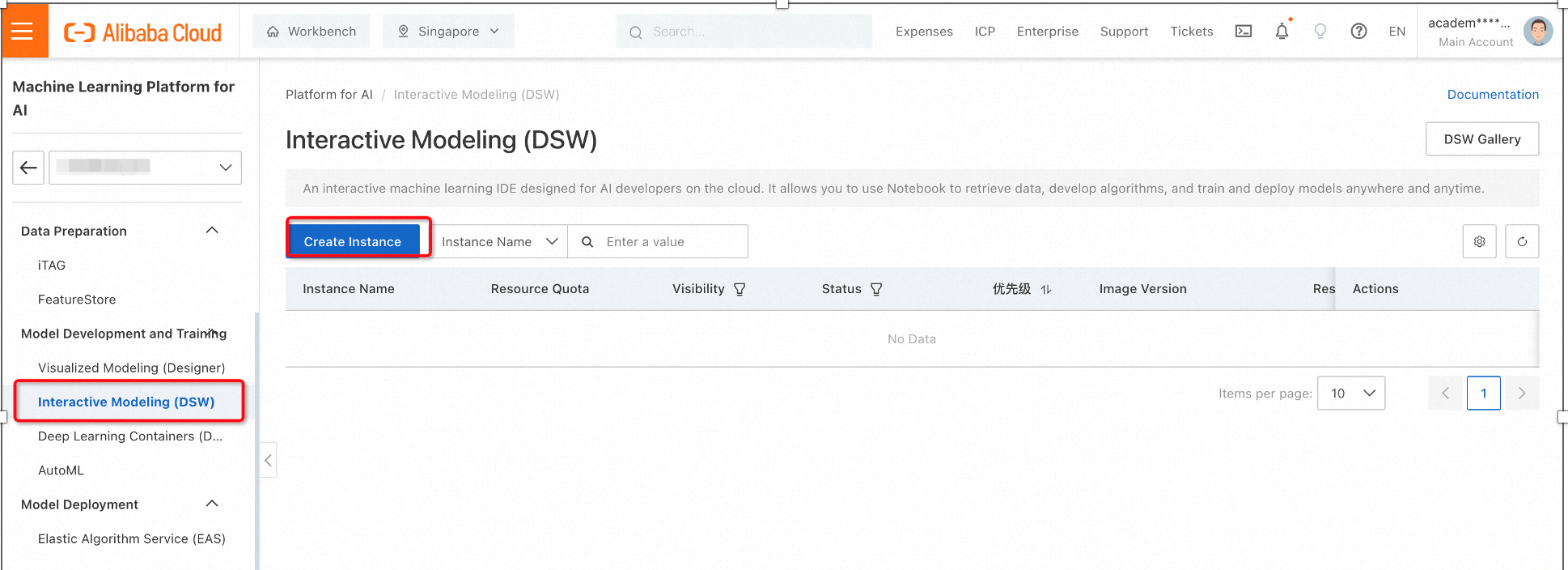

1. PAI에서 대화형 모델링(DSW)을 선택한 다음 Create Instance를 클릭합니다. 그러면 구성 창이 열립니다.

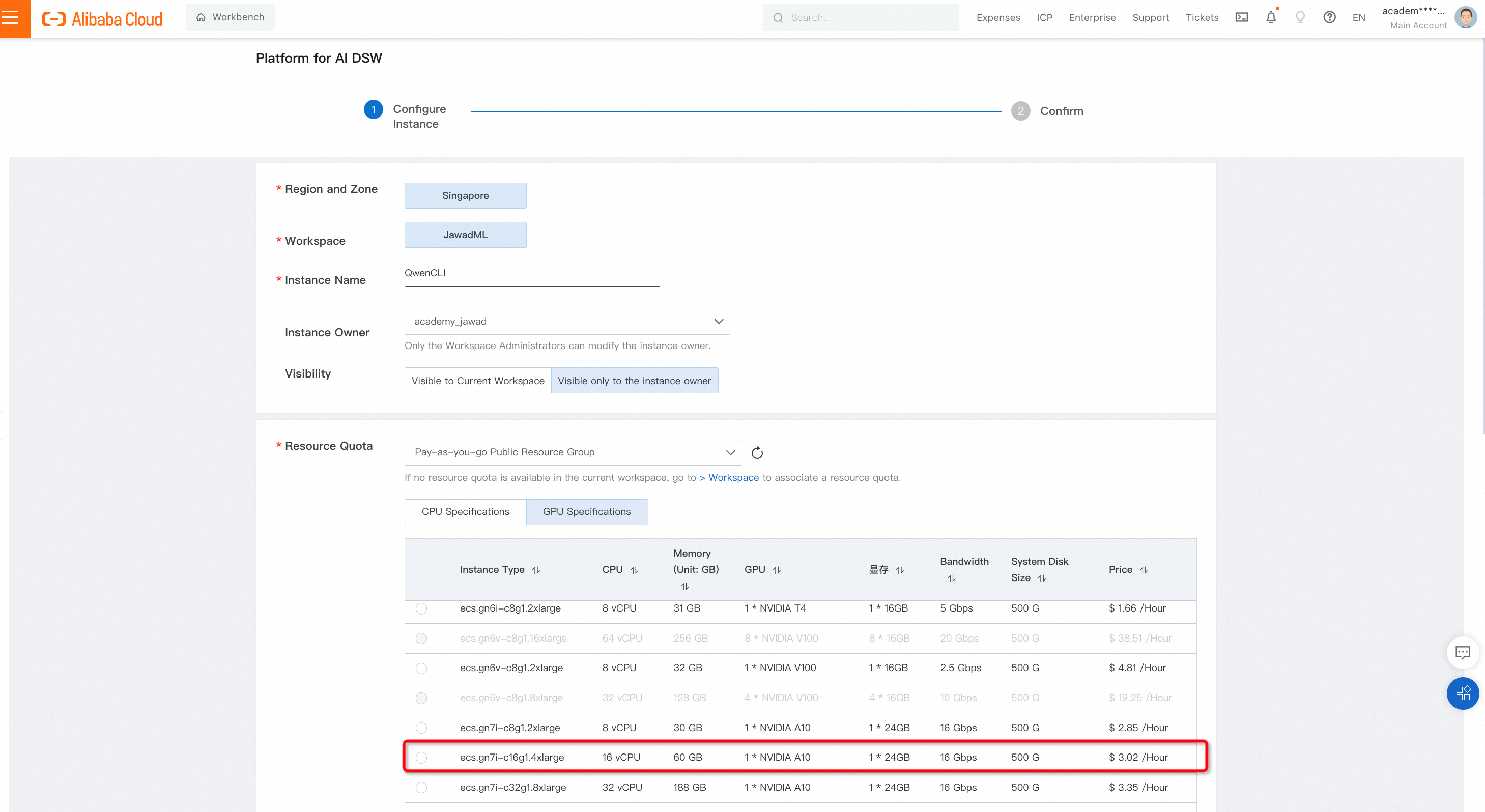

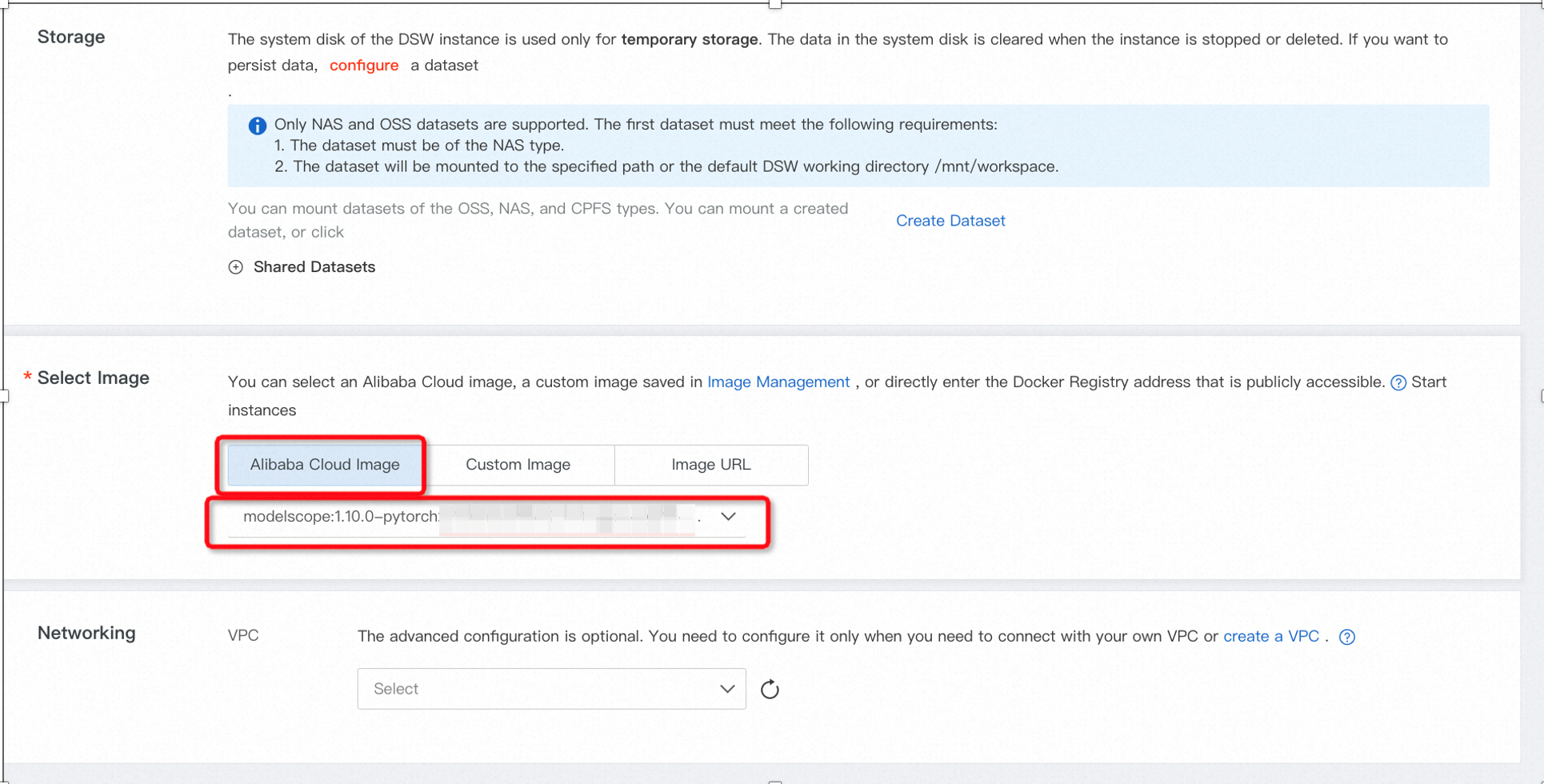

구성은 아래와 같이 적절한 GPU 사양과 이미지 유형을 선택합니다.

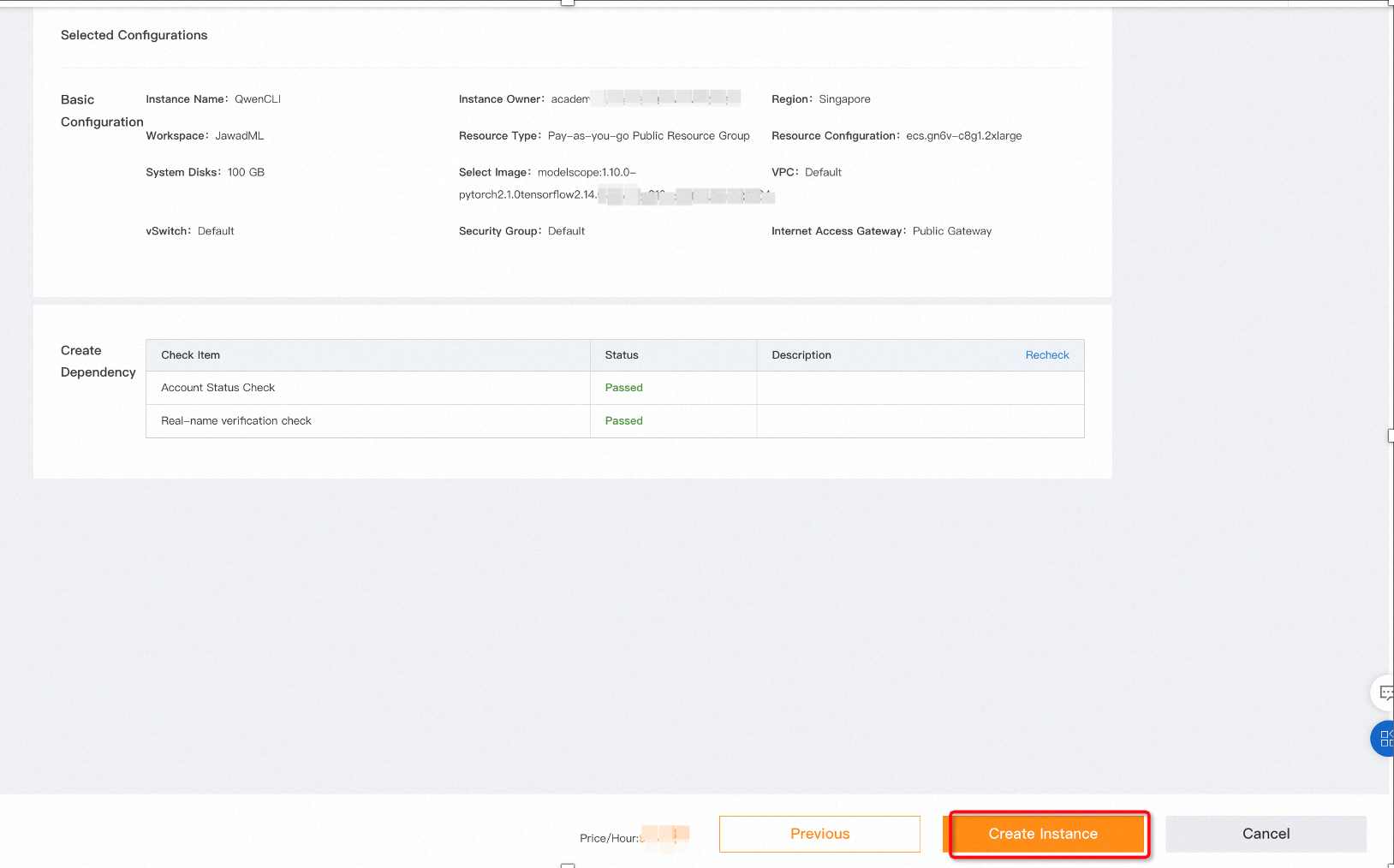

Next를 클릭하여 마지막 페이지로 이동합니다. 인스턴스 만들기를 선택하면 DSW 인스턴스가 시작됩니다.

인스턴스의 초기 상태는 Preparing Resources으로 표시됩니다.

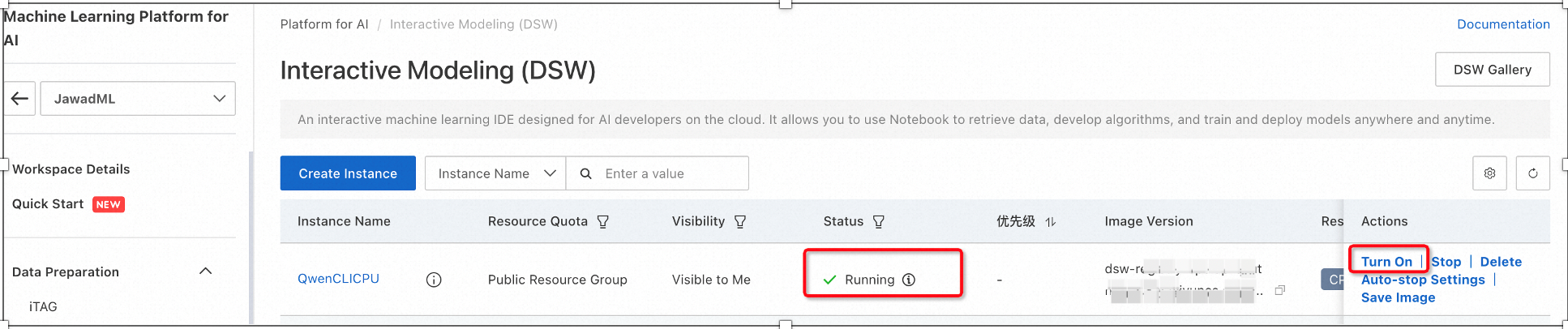

2. 인스턴스 상태가 실행 중으로 바뀌면 오른쪽의 Turn on 옵션을 클릭합니다. 그러면 Jupyter Lab이 시작됩니다.

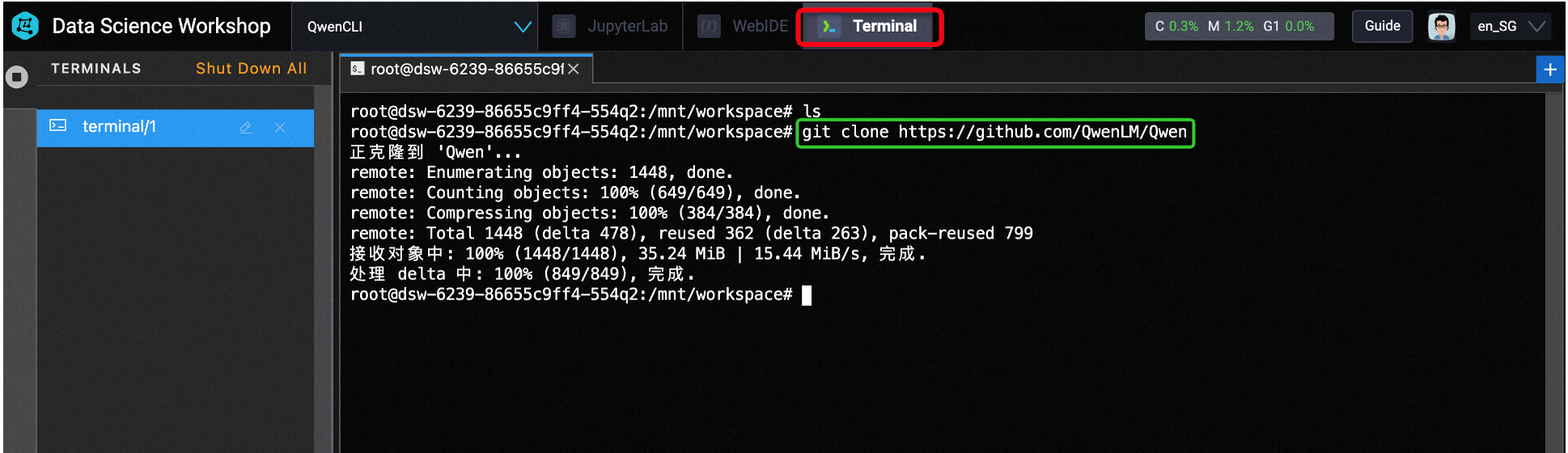

3. 여기서는 Jupyter Lab을 사용하지 않겠습니다. 대신 터미널로 이동하여 배포를 위해 Github에서 모델을 다운로드하겠습니다.

가장 좋은 방법은 먼저 python 환경을 만드는 것입니다. 가상 환경이 생성되면 이를 활성화하고 터미널에서 다음 명령을 사용합니다:

a) git clone https://github.com/QwenLM/Qwen

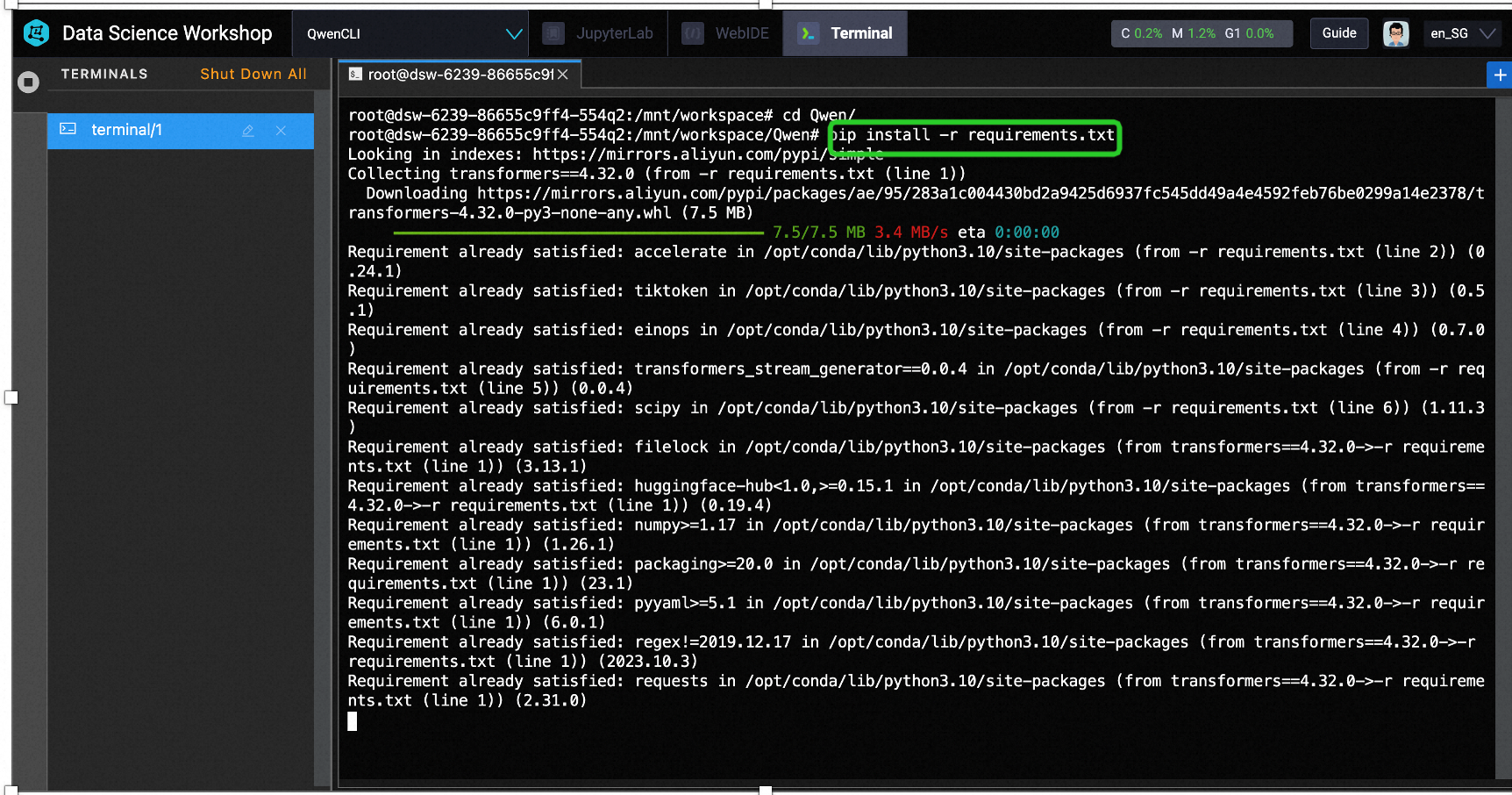

b) cd Qwen/

c) pip install -r requirements.txt

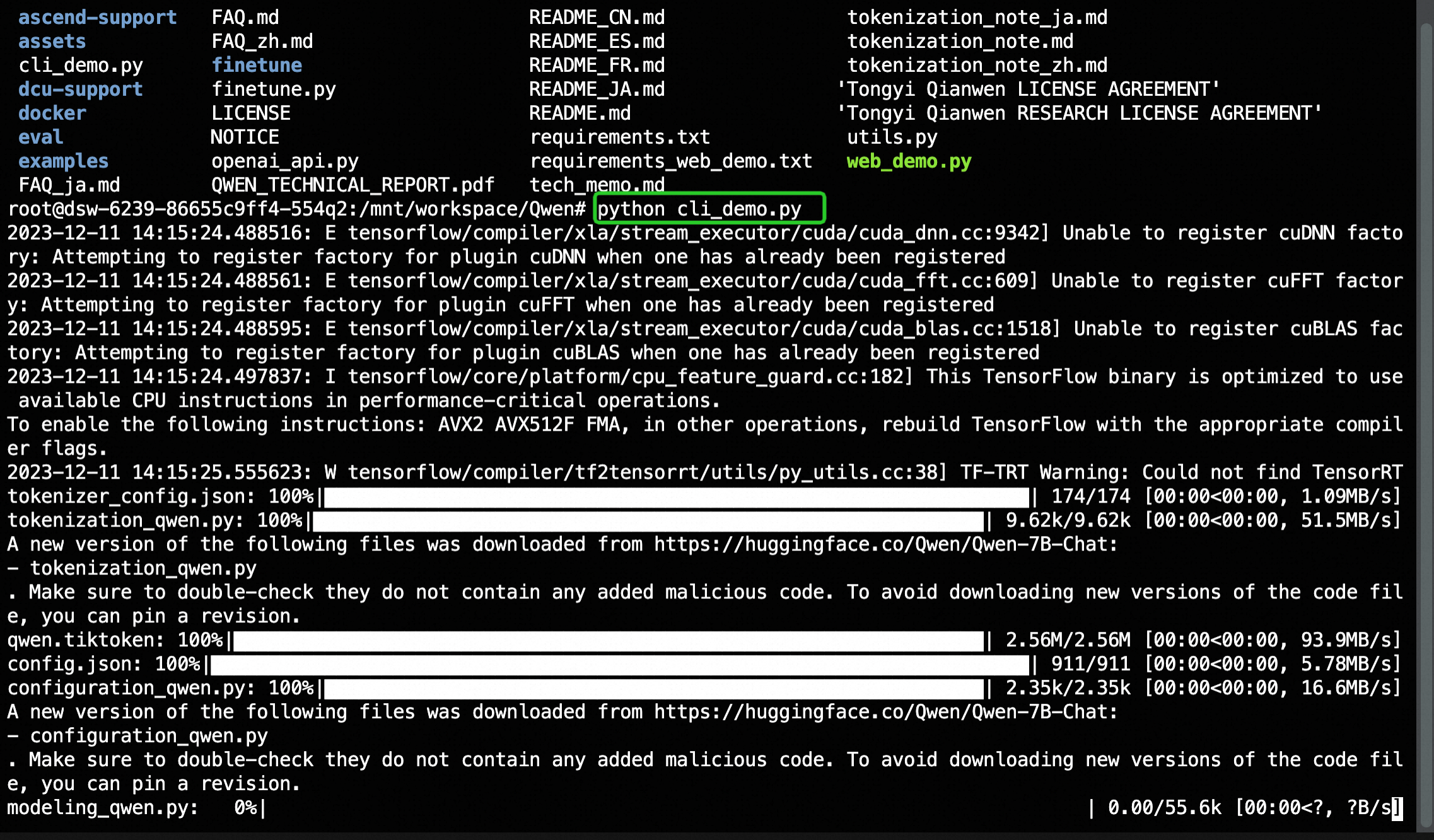

d) python3 cli_demo.py

커피 한 잔을 들고 설치가 완료될 때까지 조금만 기다려주세요.

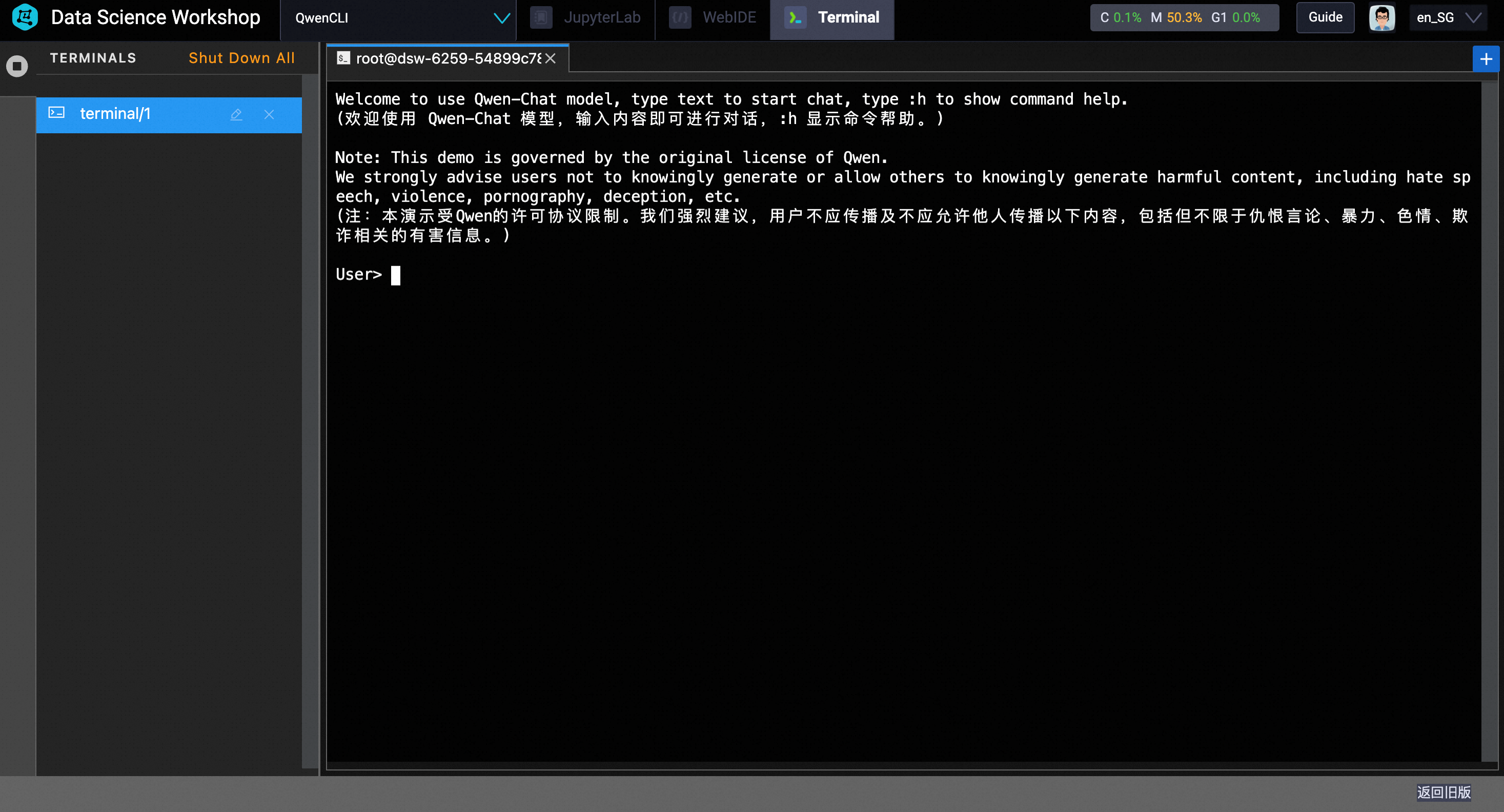

설치가 완료되면 명령줄 프롬프트가 표시됩니다:

4. 모델 테스트 중:

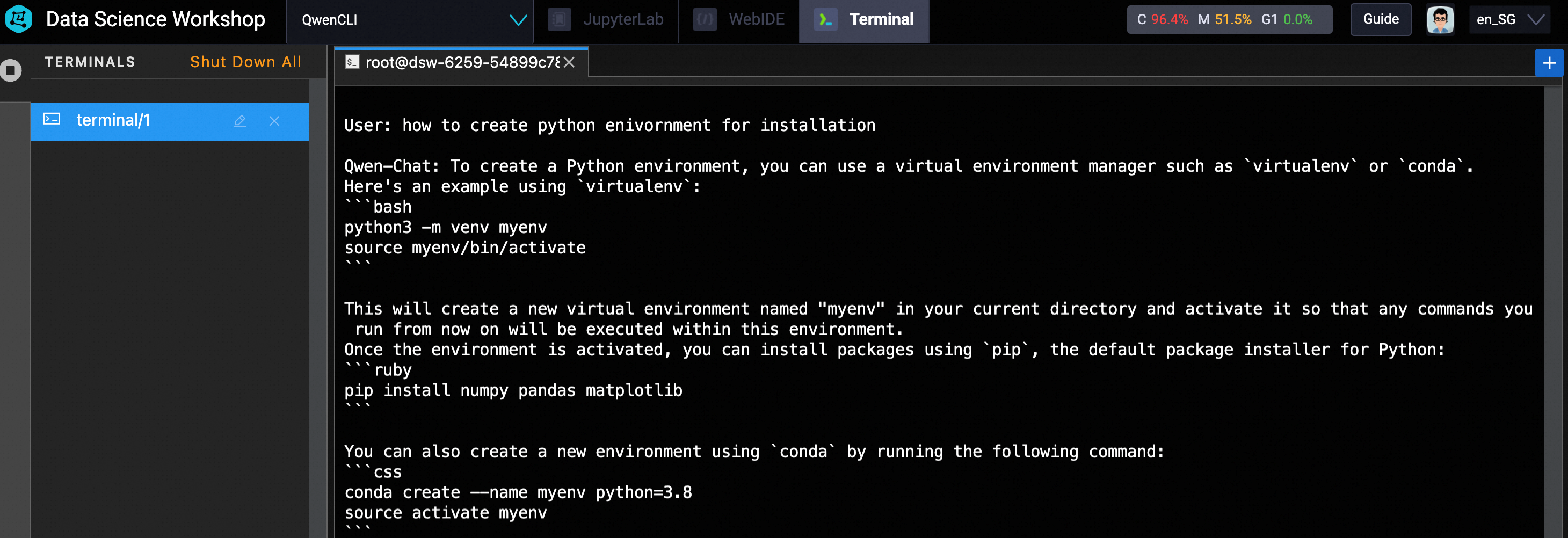

모델을 테스트하려면 CLI 인터페이스에서 직접 텍스트를 입력하세요. 제 경우에는 how to create python environment for installation이라는 프롬프트를 사용합니다.

아래와 같이 가상 환경을 생성하고 활성화하기 위한 python 코드가 생성됩니다.

다른 질문도 해보시고 Qwen과 함께 즐겨보세요. 😀

이 문서는 원래 영어로 작성되었습니다. 원본 문서는 여기를 참조하세요.

125 posts | 4 followers

FollowJJ Lim - December 3, 2021

JJ Lim - September 14, 2021

Regional Content Hub - May 13, 2025

JJ Lim - January 11, 2022

Regional Content Hub - July 23, 2025

Regional Content Hub - May 20, 2024

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Offline Visual Intelligence Software Packages

Offline Visual Intelligence Software Packages

Offline SDKs for visual production, such as image segmentation, video segmentation, and character recognition, based on deep learning technologies developed by Alibaba Cloud.

Learn MoreMore Posts by Regional Content Hub