Baiklah, Anda mengerti teknologi, bersiaplah untuk petualangan luar biasa ke dalam negeri kecerdasan buatan! Kami tidak hanya mencelupkan kaki ke air; kami menyelami lebih dalam dengan Model Obrolan Qwen. Apa agendanya? Menyiapkan chatbot yang lebih pintar dari rubah dan menghormati privasi seperti agen rahasia terkemuka. Tertarik? Sudah seharusnya! Mari mulai perjalanan kita dengan memahami AI Generatif dan LLM (Model Bahasa Besar).

Generative AI mengacu pada cabang kecerdasan buatan yang berfokus pada pembuatan konten baru, baik teks, gambar, musik, atau bentuk media lainnya. Tipe AI ini memanfaatkan model pembelajaran mesin, terutama model generatif, untuk memahami pola, fitur, dan hubungan dalam set data besar dan menghasilkan output yang baru dan sering kali tidak dapat dibedakan dari konten buatan manusia.

-Augmentasi Data: Ini dapat menghasilkan data pelatihan tambahan untuk model pembelajaran mesin, membantu meningkatkan akurasi dan ketahanan mereka.

-Personalisasi: Algoritma dapat menyesuaikan konten ke preferensi individu, meningkatkan keterlibatan pengguna.

-Penemuan Obat: Model generatif dapat mengusulkan struktur molekul baru untuk obat-obatan yang dapat efektif melawan penyakit spesifik.

-Kontrol Kualitas: Memastikan bahwa konten yang dihasilkan memenuhi standar kualitas dan bebas dari bias yang hadir dalam data pelatihan.

-Persyaratan Komputasi: Melatih model generatif seringkali memerlukan daya komputasi yang signifikan dan kumpulan data yang besar.

AI Generatif terus berkembang pesat, dan kemampuannya memperluas batasan kemampuan mesin untuk menciptakan, sehingga menawarkan peluang dan tantangan menarik yang perlu dikelola secara bertanggung jawab.

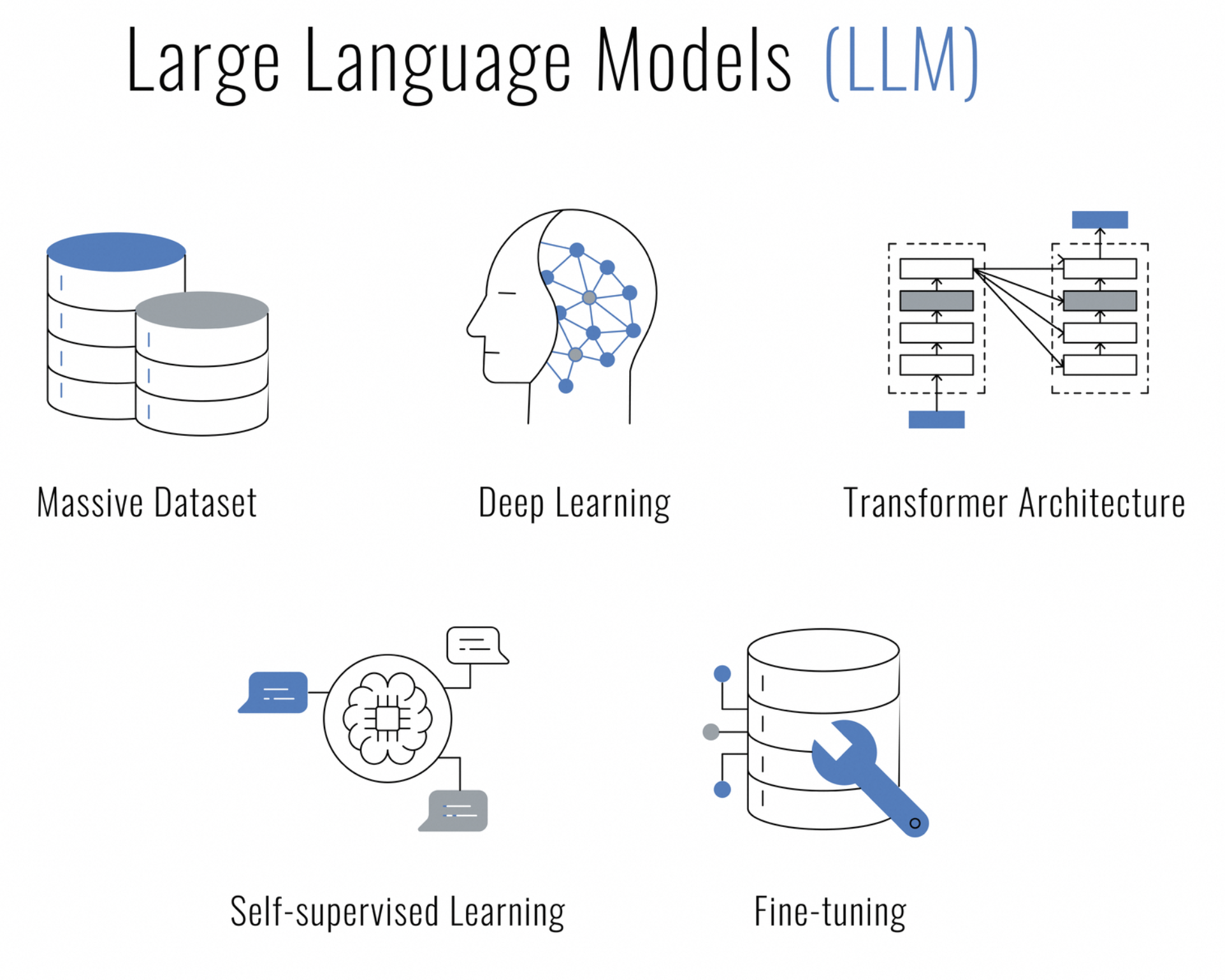

Apa itu Model Bahasa Besar (LLM)? LLM adalah jenis kecerdasan buatan berdasarkan teknik pembelajaran mendalam yang dirancang untuk memahami, menghasilkan, dan bekerja dengan bahasa manusia. Mereka disebut "besar" karena mereka terdiri dari banyak jutaan, atau bahkan miliaran parameter yang memungkinkan mereka untuk menangkap beragam nuansa dan konteks bahasa.

LLM dilatih pada data teks dalam jumlah besar dan menggunakan arsitektur seperti jaringan saraf Transformer, yang memiliki kemampuan untuk memproses rangkaian data (seperti kalimat) dan memperhatikan bagian-bagian berbeda dari rangkaian tersebut saat membuat prediksi. Hal ini menjadikannya sangat efektif untuk berbagai tugas pemrosesan bahasa alami (NLP), seperti:

Apakah Anda sedang mencari AI yang dapat mengobrol, membuat konten, meringkas, membuat kode, dan banyak lagi, sambil tetap menghormati hak privasi Anda? Tidak perlu mencari lagi, Model Obrolan Qwen hadir untuk mengubah pusat data Anda menjadi benteng interaksi aman yang didukung AI.

Qwen bukan chatbot biasa Anda. Qwen dibangun di atas model bahasa yang sangat besar dan telah dilatih pada 3 triliun token data multibahasa. Keajaiban AI ini memahami bahasa Inggris dan Mandarin dengan baik dan telah disesuaikan untuk interaksi mirip manusia.

Menyebarkan Qwen secara lokal di server Anda adalah tentang mengambil kendali. Ini tentang memastikan bahwa percakapan yang Anda lakukan, data yang diproses, dan privasi yang dijanjikan tetap berada dalam lingkup Anda. Baik Anda seorang pebisnis yang ingin mengintegrasikan sistem obrolan cerdas, pengembang yang tertarik pada penelitian AI, atau sekadar penggemar yang ingin menjelajahi batas-batas AI percakapan, Qwen adalah pilihan tepat Anda.

Sekarang, mengapa Anda ingin meng-hosting LLM ini secara lokal? Tiga kata: Kontrol, kecepatan, dan privasi. Anda menyimpan data, tanggapan datang secepat kilat, dan Anda bisa tenang mengetahui bahwa chatbot Anda tidak membocorkan rahasia Anda ke seluruh layanan publik.

Semangat inovasi dalam AI diperkuat oleh komunitas sumber terbuka. Sesuai dengan tradisi ini, kode sumber penuh untuk Model Obrolan Qwen tersedia di GitHub untuk siapa saja yang tertarik untuk mendalami mekanik modelnya, memanfaatkan pengembangannya, atau hanya sekedar menggunakannya sebagai sumber daya pembelajaran. Baik Anda seorang peneliti, pengembang, atau penghobi AI, Anda dapat mengakses kode sumber di Qwen.

Sebelum kita berlayar dalam pengembaraan teknologi ini, pastikan Anda sudah menyiapkan semuanya:

Anda memahami semuanya? Luar Biasa! Mari kita mengotori tangan kita (secara kiasan, tentu saja).

Baik Anda penggemar berat Visual Studio Code, penggemar PyCharm, atau seseorang yang menyukai bakat interaktif Jupyter Notebooks, kode Python untuk mengobrol dengan Qwen fleksibel dan agnostik IDE. Semua yang Anda perlukan hanyalah lingkungan yang mendukung Python, dan Anda siap menghidupkan teman ngobrol AI Anda.

Berikut tip profesional: Jika Anda menggunakan VSCode, manfaatkan terminal bawaan untuk menjalankan skrip Python Anda dengan lancar. Buka saja palet perintah (Ctrl+Shift+P), ketik Python: Jalankan File Python di Terminal, dan biarkan VSCode melakukan pekerjaan berat. Anda akan melihat respons Qwen di terminal terintegrasi Anda.

Bagi Anda yang lebih menyukai PyCharm, menjalankan kode Anda juga lancar. Klik kanan pada skrip Anda dan pilih Run 'script_name.py', dan lihat IDE menjalankan percakapan Anda dengan Qwen. Alat canggih dan fitur debugging PyCharm menjadikannya pilihan tepat untuk mengembangkan interaksi yang lebih kompleks.

Dan tidak berakhir di sini – ada banyak IDE dan editor kode yang menyambut Python dengan tangan terbuka. Pilih yang paling sesuai dengan alur kerja Anda, dan mulai mengobrol!

Yang pertama, mari kita siapkan server Linux Anda. Pastikan daftar paket Anda segar seperti udara pagi dan Python serta pip siap melakukan keajaibannya:

pembaruan sudo apt

sudo apt menginstal python3 python3-pipSekarang untuk bahan rahasia: lingkungan virtual. Seperti memiliki ruang kerja pribadi di mana Anda dapat membuat kekacauan tanpa seseorang meneriaki Anda untuk membersihkan:

Pemasangan pip --pengguna virtualenv

virtualenv qwen_env

sumber qwen_env/bin/activateSebelum kita menghidupkan Qwen, Anda memerlukan beberapa alat. Anggap saja ini sebagai bahan pengumpul untuk hidangan bintang Michelin:

pip instal torch torchvision torchaudio

pip instal transformersIngatlah untuk mencocokkan PyTorch dengan versi CUDA Anda – ini seperti memasangkan anggur berkualitas dengan keju yang tepat.

Kata-kata hanyalah kata sampai Qwen memberinya makna. Di situlah tokenizer berperan, mengubah renungan Anda menjadi sesuatu yang dapat dikunyah oleh Qwen:

dari transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)Pikiran Qwen luas dan siap untuk diisi dengan percakapan Anda. Berikut cara membangunkan raksasa yang sedang tidur:

dari transformers import AutoModelForCausalLM

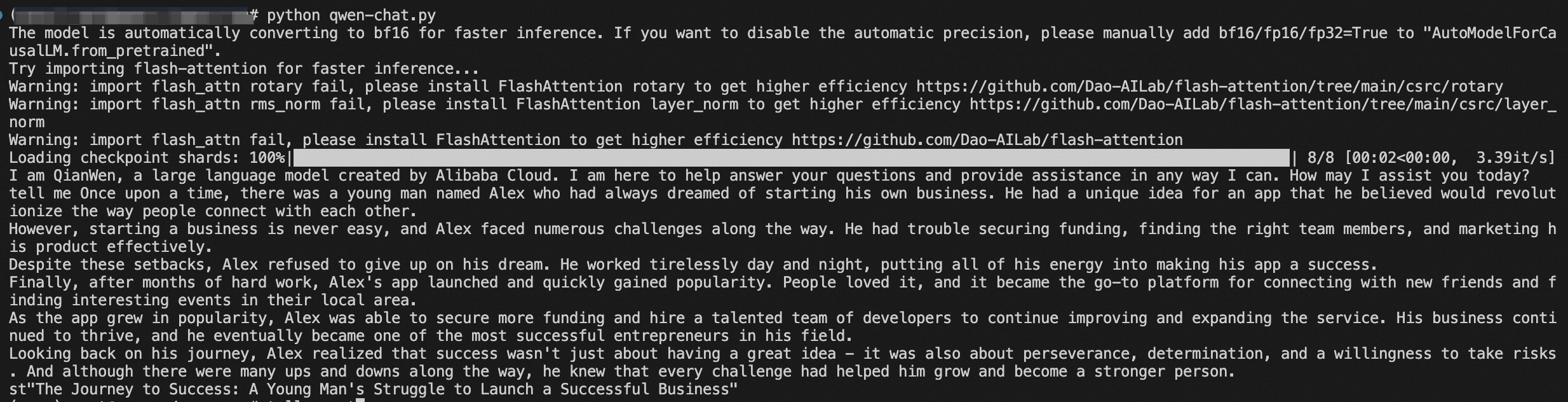

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()Tergantung pada perangkat keras Anda, Anda dapat memilih untuk mode presisi yang berbeda seperti BF16 atau FP16. Seperti menyetel gitar Anda untuk nada yang sempurna.

Kini sampai pada bagian yang menggetarkan hati – saatnya mengobrol dengan Gwen! Namun sebelum Anda terbawa maju mundur, mari kita bicara tentang sesuatu yang penting: seni kesinambungan percakapan.

Berikut cuplikan obrolan singkatyang dapat Anda harapkan:

response, history = model.chat(tokenizer, "Halo, Qwen! Bagaimana kabar dunia digital?", history=None)

print("Qwen:", response)Dalam langkah pembuka kami, kami menyapa Qwen tanpa pamrih – yaitu, tanpa riwayat percakapan. Dengan menyetel riwayat=None, kita memberi tahu Qwen, "Ini adalah awal obrolan kita." Qwen, hanya dengan perintah untuk melanjutkan, akan merespons dengan kesegaran interaksi baru.

Sekarang, saksikan keajaiban konteks:

respon, history = model.chat(tokenizer, "Apa pendapat Anda tentang arti kehidupan, alam semesta, dan segalanya?", history=history)

print("Qwen:", response)Pada babak ini, kami meneruskan riwayat yang kami terima dari obrolan kami sebelumnya. Ini seperti menyerahkan Qwen buku harian dari segala yang kita bicarakan sejauh ini. Dengan konteks riwayat ini, Qwen dapat menciptakan respons yang tidak hanya jenaka atau mendalam, namun juga terhubung dengan percakapan kita saat ini. Inilah perbedaan antara mengobrol dengan teman bijak yang mengenal Anda dan bertanya kepada orang asing.

Sekarang Anda adalah seorang profesional dalam konteks penting dengan parameter riwayat, nyalakan skrip demo tersebut dan bersiaplah untuk obrolan menarik dengan Qwen. Baik Anda sedang mendiskusikan alam semesta atau resep terbaik untuk kue digital, Qwen siap mengikuti alur percakapan Anda dengan segala keanggunan seorang pembicara berpengalaman.

Selain itu, Anda juga dapat menjalankan skrip itu dan memulai percakapan. Seperti membuka kotak Pandora, tapi bukannya kekacauan, Anda mendapatkan hadiah yang menyenangkan:

python qwen_chat.pyDan begitulah, sobat – Anda memiliki teman ngobrol AI sendiri, yang siap menaklukkan dunia percakapan.

Selamat! Anda telah menavigasi perairan berbahaya dalam penerapan AI seperti seorang kapten berpengalaman. Qwen sekarang terpasang pas di server Anda, dan data Anda seaman rumah.

Jelajahi kemampuan Qwen, berkontribusi pada pengembangannya, dan bergabunglah dengan komunitas orang-orang yang berpikiran sama dan bersemangat untuk memajukan percakapan AI.

Jadi, majulah dan terlibat dalam dialog epik dengan sisi AI baru Anda yang berkilau. Dan siapa tahu? Mungkin Qwen akan mengejutkan Anda dengan kebijaksanaan digitalnya atau membuat lelucon yang akan membuat Anda tertawa terbahak-bahak.

Artikel ini awalnya ditulis dalam bahasa Inggris. Lihat artikel asli di sini

การใช้ AI เพื่อนแชทของคุณเอง - การปรับใช้โมเดล Qwen Chat ด้วย HuggingFace Guide

125 posts | 4 followers

FollowRegional Content Hub - August 19, 2024

Regional Content Hub - September 2, 2024

Regional Content Hub - May 6, 2024

Regional Content Hub - October 21, 2024

Regional Content Hub - July 14, 2025

Regional Content Hub - July 23, 2025

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud Model Studio

Alibaba Cloud Model Studio

A one-stop generative AI platform to build intelligent applications that understand your business, based on Qwen model series such as Qwen-Max and other popular models

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub