Data Studio adalah platform pengembangan danau data terpadu (data lakehouse) cerdas yang dibangun berdasarkan pengalaman puluhan tahun Alibaba Cloud dalam bidang data besar. Platform ini mendukung berbagai layanan komputasi Alibaba Cloud dan menyediakan kemampuan untuk ekstrak, transformasi, dan muat (ETL) cerdas, manajemen katalog data, serta orkestrasi alur kerja lintas mesin. Dengan lingkungan pengembangan pribadi yang mendukung pengembangan Python, analisis Notebook, dan integrasi Git, serta ekosistem plugin yang kaya, Data Studio memungkinkan pemrosesan real-time dan offline terintegrasi, penyatuan data lakehouse, serta alur kerja data besar dan AI yang mulus—membantu Anda mengelola data sepanjang siklus hidup “Data+AI”.

Pengenalan Data Studio

Data Studio adalah platform pengembangan danau data terpadu cerdas yang mengadopsi metodologi konstruksi data besar Alibaba Cloud. Platform ini terintegrasi secara mendalam dengan puluhan layanan komputasi data besar dan AI Alibaba Cloud, seperti MaxCompute, EMR, Hologres, Flink, dan PAI, serta menyediakan layanan pengembangan ETL cerdas untuk arsitektur gudang data, data lake, dan data lakehouse OpenLake. Platform ini mendukung:

Dukungan data lakehouse dan multi-mesin

Akses data di data lake (seperti OSS) dan gudang data (seperti MaxCompute), lalu lakukan pengembangan hibrida multi-mesin melalui katalog data terpadu dan beragam node mesin.Alur kerja dan penjadwalan fleksibel

Menyediakan berbagai node kontrol alur untuk mengorkestrasikan tugas lintas mesin secara visual dalam alur kerja. Platform ini juga menawarkan penjadwalan berbasis waktu dan penjadwalan berbasis pemicu event.Lingkungan pengembangan Data+AI terbuka

Menyediakan lingkungan pengembangan pribadi dengan dependensi yang dapat dikustomisasi dan Notebook yang mendukung pemrograman campuran SQL dan Python. Fitur seperti dataset dan integrasi Git membantu Anda membangun stasiun kerja riset dan pengembangan AI yang terbuka dan fleksibel.Bantuan cerdas dan rekayasa AI

Asisten cerdas Copilot bawaan mendukung Anda sepanjang proses pengembangan kode. Node algoritma PAI profesional dan node LLM menyediakan dukungan native untuk rekayasa AI end-to-end.

Konsep dasar Data Studio

Konsep | Istilah | Nilai inti | Kata kunci |

Workflow | Unit organisasi dan orkestrasi untuk task | Mengelola dependensi dan mengotomatiskan penjadwalan untuk tugas kompleks. Bertindak sebagai "kontainer" untuk pengembangan dan penjadwalan. | Visualisasi, DAG, berulang/terpicu, orkestrasi |

Node | Unit eksekusi terkecil dalam workflow | Tempat Anda menulis kode dan menerapkan logika bisnis spesifik. Merupakan operasi atomik untuk pemrosesan data. | SQL, Python, Shell, integrasi data |

Custom image | Snapshot standar dari suatu lingkungan | Memastikan lingkungan bersifat ekstensibel, konsisten, dan dapat direproduksi. | Penguatan lingkungan, standardisasi, replikabilitas, konsistensi |

Scheduling | Aturan untuk memicu tugas secara otomatis | Mengotomatiskan produksi data dengan mengubah tugas manual menjadi tugas produksi yang dapat dijalankan secara otomatis. | Penjadwalan berulang, penjadwalan terpicu, dependensi, otomatisasi |

Data catalog | Workbench metadata terpadu | Mengorganisasi dan mengelola aset data (seperti tabel) serta sumber daya komputasi (seperti fungsi dan resource) secara terstruktur. | Metadata, manajemen tabel, eksplorasi data |

Dataset | Pemetaan logis ke penyimpanan eksternal | Terhubung ke data tidak terstruktur eksternal, seperti gambar dan dokumen. Merupakan jembatan data utama untuk pengembangan AI. | Akses OSS/NAS, pemasangan data, tidak terstruktur |

Notebook | Kanvas pengembangan Data+AI interaktif | Mengintegrasikan kode SQL dan Python untuk mempercepat eksplorasi data dan validasi algoritma. | Interaktif, multi-bahasa, visualisasi, analisis eksploratif |

Panduan proses Data Studio

Data Studio menyediakan proses untuk pengembangan gudang data dan pengembangan AI. Bagian berikut menunjukkan dua jalur umum. Jelajahi jalur lain sesuai kebutuhan.

Jalur umum: Proses pengembangan gudang data untuk tugas ETL berulang

Proses ini cocok untuk membangun gudang data tingkat enterprise guna mencapai pemrosesan data batch yang stabil dan otomatis.

Audience target: Insinyur data, developer ETL.

Tujuan inti: Membangun gudang data enterprise yang stabil, terstandarisasi, dan dapat dijadwalkan secara otomatis untuk pemrosesan data batch dan pembuatan laporan.

Teknologi utama: Katalog data, alur kerja berulang, node SQL, konfigurasi penjadwalan.

Langkah | Nama fase | Operasi inti dan tujuan | Jalur utama dan referensi |

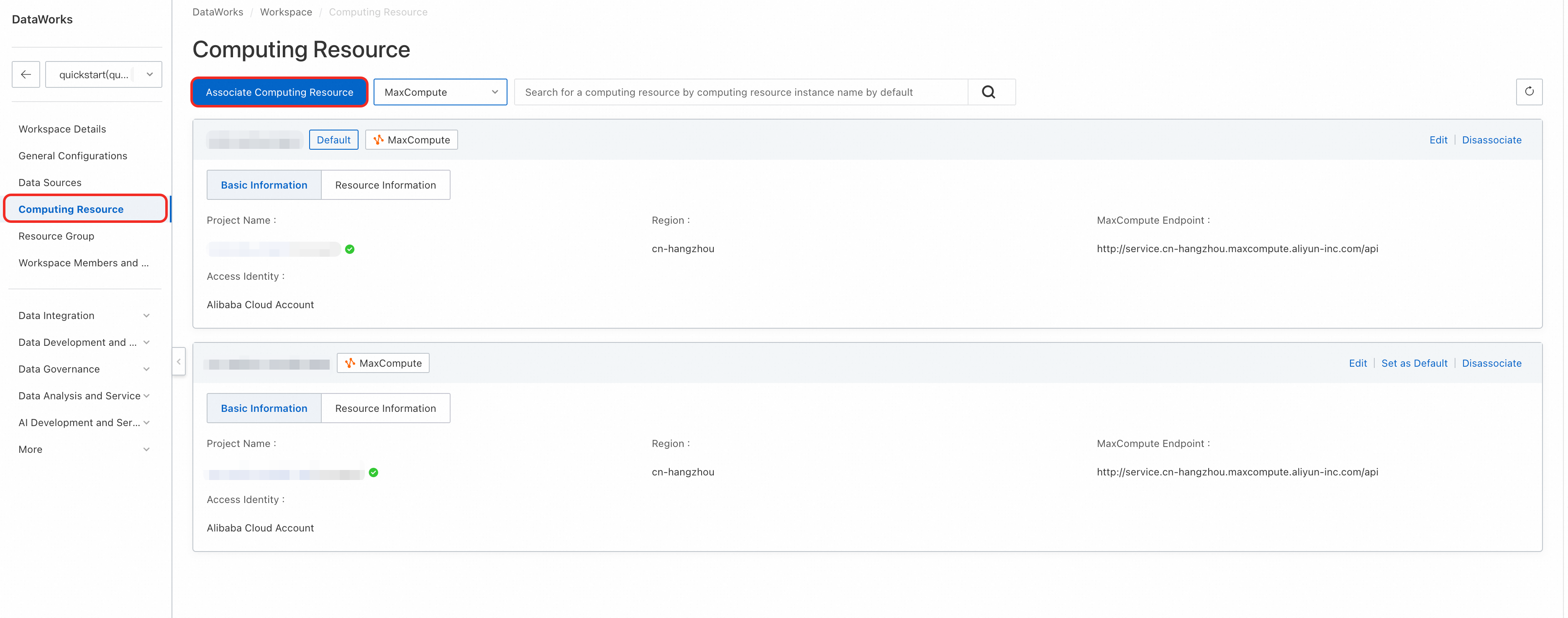

1 | Asosiasikan mesin komputasi | Asosiasikan satu atau beberapa mesin komputasi inti, seperti MaxCompute, dengan ruang kerja untuk berfungsi sebagai lingkungan eksekusi semua tugas SQL.

| Console > Workspace Configuration Untuk informasi selengkapnya, lihat Asosiasikan sumber daya komputasi. |

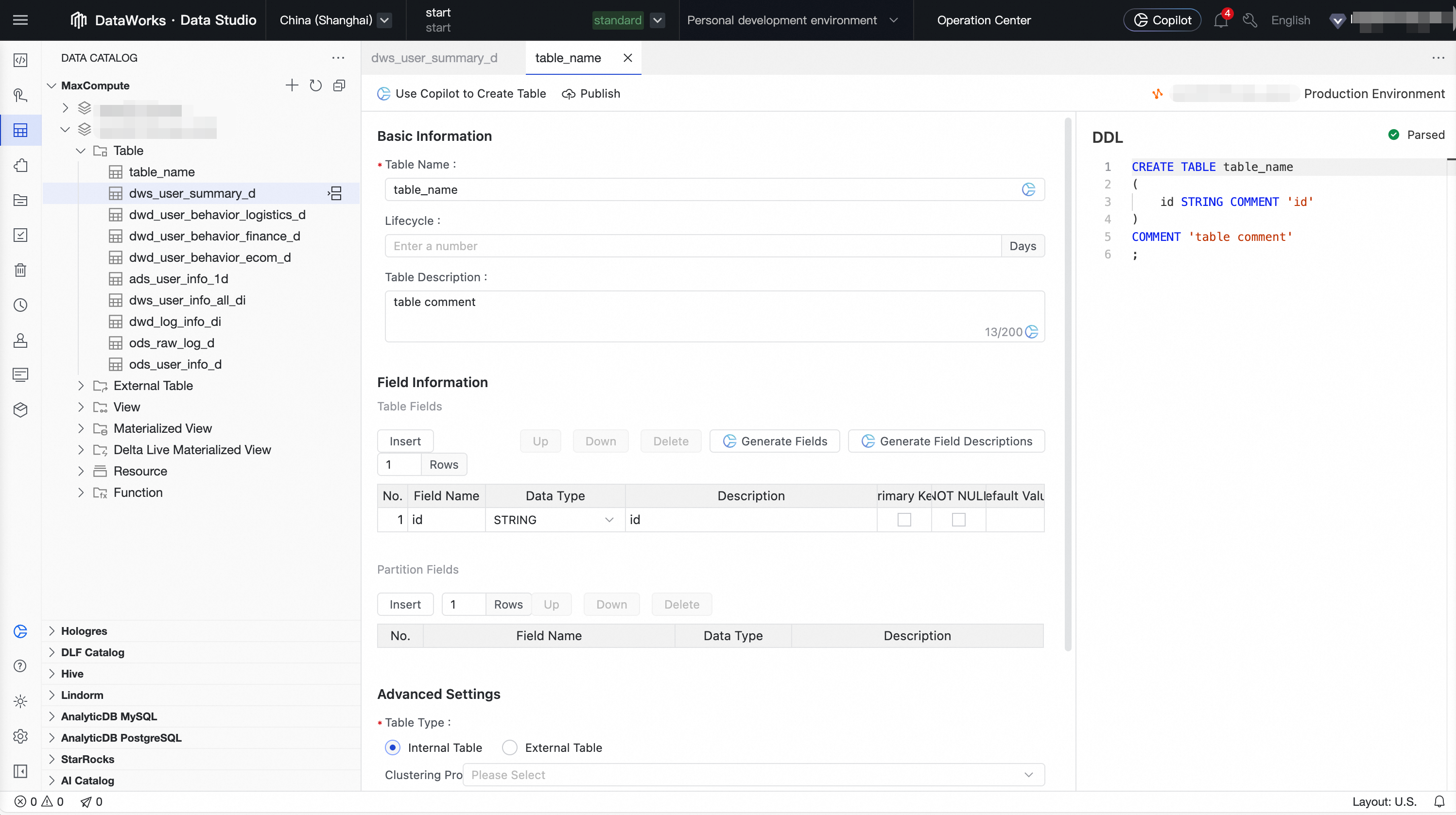

2 | Kelola katalog data | Buat atau jelajahi skema tabel yang diperlukan untuk setiap lapisan gudang data (seperti ODS, DWD, dan ADS) di katalog data. Hal ini menentukan input dan output untuk pemrosesan data. Kami merekomendasikan Anda menggunakan modul pemodelan data untuk membangun sistem gudang data Anda.

| Data Studio > Data Catalog Untuk informasi selengkapnya, lihat Katalog Data. |

3 | Buat alur kerja terjadwal | Buat alur kerja terjadwal di direktori ruang kerja untuk berfungsi sebagai kontainer pengorganisasian dan pengelolaan tugas ETL terkait. | Data Studio > Workspace Directory > Periodic Scheduling Untuk informasi selengkapnya, lihat Orkestrasikan alur kerja berulang. |

4 | Kembangkan dan debug node | Buat node seperti node ODPS SQL. Tulis logika ETL inti (pembersihan data, transformasi, dan agregasi) di editor, lalu debug node tersebut. |

Untuk informasi selengkapnya, lihat Pengembangan node. |

5 | Kembangkan dengan bantuan Copilot | Gunakan DataWorks Copilot untuk menghasilkan, memperbaiki, menulis ulang, dan mengonversi kode SQL dan Python. |

|

6 | Orkestrasikan dan jadwalkan node | Di kanvas DAG alur kerja, tentukan dependensi hulu dan hilir antar-node dengan menyeret dan menghubungkannya. Berbagai node kontrol alur didukung untuk memungkinkan orkestrasi alur kompleks. Konfigurasikan properti penjadwalan untuk alur kerja atau node di lingkungan produksi, seperti siklus penjadwalan, waktu, dan dependensi. Mendukung penjadwalan skala besar hingga puluhan juta tugas per hari. |

Untuk informasi selengkapnya, lihat Node kontrol alur umum dan Konfigurasi penjadwalan node. |

7 | Deploy dan O&M |

|

|

Untuk contoh mulai terkait, lihat Advanced: Analisis kategori produk terlaris.

Jalur lanjutan: Proses pengembangan data besar dan AI

Proses ini cocok untuk pengembangan model AI, eksplorasi ilmu data, dan membangun aplikasi AI real-time. Proses ini menekankan fleksibilitas dan interaktivitas lingkungan. Proses spesifik dapat bervariasi berdasarkan kebutuhan aktual.

Audience target: Insinyur AI, ilmuwan data, insinyur algoritma.

Tujuan inti: Melakukan eksplorasi data, pelatihan model, dan validasi algoritma, atau membangun aplikasi AI real-time seperti Generasi yang Diperkaya dengan Pengambilan Data (RAG) dan layanan inferensi real-time.

Teknologi utama: Lingkungan pengembangan pribadi, Notebook, alur kerja terpicu event, dataset, custom image.

Langkah | Nama tahap | Operasi inti dan tujuan | Jalur utama dan dokumen referensi |

1 | Buat lingkungan pengembangan pribadi | Buat instans kontainer cloud terisolasi dan dapat dikustomisasi untuk berfungsi sebagai lingkungan instalasi dependensi Python kompleks dan pengembangan AI profesional. | Data Studio > Personal Development Environment Untuk informasi selengkapnya, lihat Lingkungan pengembangan pribadi. |

2 | Buat alur kerja terpicu event | Buat alur kerja di direktori ruang kerja yang digerakkan oleh event eksternal. Ini menyediakan kontainer orkestrasi untuk aplikasi AI real-time. | Data Studio > Workspace Directory > Event-triggered Workflow Untuk informasi selengkapnya, lihat Alur kerja terpicu event. |

3 | Buat dan atur pemicu | Konfigurasikan pemicu di Operation Center untuk menentukan event eksternal mana, seperti event OSS atau event pesan Kafka, yang akan memulai alur kerja. |

Untuk informasi selengkapnya, lihat Kelola pemicu dan Rancang alur kerja terpicu event. |

4 | Buat node Notebook | Buat unit pengembangan inti untuk menulis kode AI/Python. Biasanya, eksplorasi pertama kali dilakukan di Notebook dalam folder pribadi. | Project Folder > Event-triggered Workflow > Notebook Node Untuk informasi selengkapnya, lihat Buat node. |

5 | Buat dan gunakan dataset | Daftarkan data tidak terstruktur (seperti gambar dan dokumen) yang disimpan di OSS/NAS sebagai dataset. Kemudian, pasang ke lingkungan pengembangan atau tugas agar dapat diakses oleh kode. |

Untuk informasi selengkapnya, lihat Kelola Dataset dan Gunakan dataset. |

6 | Kembangkan dan debug Notebook/node | Tulis logika algoritma, jelajahi data, validasi model, dan iterasi dengan cepat di lingkungan interaktif yang disediakan oleh lingkungan pengembangan pribadi. | Data Studio > Notebook Editor Untuk informasi selengkapnya, lihat Pengembangan Notebook dasar. |

7 | Instal paket dependensi kustom | Di terminal lingkungan pengembangan pribadi atau di sel Notebook, gunakan alat seperti | Data Studio > Personal Development Environment > Terminal Untuk informasi selengkapnya, lihat Lampiran: Lengkapi lingkungan pengembangan pribadi Anda. |

8 | Buat custom image | Perkuat lingkungan pengembangan pribadi dengan semua dependensi yang telah dikonfigurasi ke dalam image standar. Hal ini memastikan lingkungan produksi identik dengan lingkungan pengembangan. Jika Anda belum menginstal paket dependensi kustom, lewati langkah ini. |

Untuk informasi selengkapnya, lihat Buat image DataWorks dari lingkungan pengembangan pribadi. |

9 | Konfigurasikan penjadwalan node | Dalam konfigurasi penjadwalan node produksi, Anda harus menentukan custom image yang dibuat pada langkah sebelumnya sebagai lingkungan runtime dan memasang dataset yang diperlukan. | Data Studio > Notebook Node > Scheduling Untuk informasi selengkapnya, lihat Konfigurasi penjadwalan node. |

10 | Deploy dan O&M |

|

|

Modul inti Data Studio

Modul inti | Kemampuan utama |

Workflow orchestration | Menyediakan kanvas DAG visual yang memungkinkan Anda dengan mudah membangun dan mengelola proyek tugas kompleks melalui seret-dan-lepas. Mendukung orkestrasi alur kerja berulang, alur kerja terpicu event, dan alur kerja terpicu manual untuk memenuhi kebutuhan otomatisasi dalam berbagai skenario. |

Execution environments and modes | Menyediakan lingkungan pengembangan fleksibel dan terbuka untuk meningkatkan efisiensi dan kolaborasi pengembangan.

|

Node development | Mendukung berbagai jenis node dan mesin komputasi untuk pemrosesan dan analisis data yang fleksibel.

Untuk informasi selengkapnya, lihat Manajemen sumber daya komputasi dan Pengembangan node. |

Node scheduling | Menyediakan kemampuan penjadwalan otomatis yang kuat dan fleksibel untuk memastikan tugas dieksekusi tepat waktu dan berurutan.

|

Development resource management | Menyediakan manajemen terpadu berbagai aset yang terlibat dalam proses pengembangan data.

|

Quality control | Membangun berbagai mekanisme kontrol untuk memastikan standarisasi proses produksi data dan akurasi data keluaran.

|

Openness and extensibility | Menyediakan berbagai antarmuka terbuka dan titik ekstensi untuk integrasi mudah dengan sistem eksternal dan pengembangan kustom.

|

Penagihan Data Studio

Biaya DataWorks (biaya muncul di tagihan DataWorks)

Biaya kelompok sumber daya: Pengembangan node dan lingkungan developer pribadi memerlukan kelompok sumber daya. Bergantung pada jenis kelompok sumber daya, Anda dikenai biaya kelompok sumber daya Serverless atau biaya untuk kelompok sumber daya eksklusif untuk penjadwalan.

Jika Anda menggunakan layanan model besar, Anda juga dikenai biaya kelompok sumber daya Serverless.

Biaya penjadwalan tugas: Jika Anda memublikasikan tugas ke lingkungan produksi untuk eksekusi terjadwal, Anda dikenai biaya penjadwalan tugas (saat menggunakan kelompok sumber daya Serverless) atau biaya untuk kelompok sumber daya eksklusif untuk penjadwalan (saat menggunakan kelompok sumber daya eksklusif).

Biaya Kualitas Data: Jika Anda mengonfigurasi pemantauan kualitas untuk tugas periodik dan instans berhasil dipicu, Anda dikenai biaya instans Kualitas Data.

Biaya garis dasar cerdas: Jika Anda mengonfigurasi garis dasar cerdas untuk tugas periodik, Anda dikenai biaya instans garis dasar cerdas untuk garis dasar yang berada dalam status aktif.

Biaya pesan teks dan panggilan telepon alert: Jika Anda mengonfigurasi pemantauan alert untuk tugas periodik dan pesan teks atau panggilan telepon berhasil dipicu, Anda dikenai biaya pesan teks dan panggilan telepon alert.

CatatanBiaya ini terkait dengan modul Pengembangan Data, Kualitas Data, dan Pusat Operasi.

Biaya dari layanan lain (biaya tidak muncul di tagihan DataWorks)

Saat Anda menjalankan tugas node Pengembangan Data, Anda mungkin dikenai biaya mesin komputasi dan penyimpanan, seperti biaya penyimpanan OSS. Biaya ini tidak dikenakan oleh DataWorks.

Mulai menggunakan Data Studio

Buat atau aktifkan Data Studio yang baru

Saat membuat ruang kerja, pilih Use Data Studio (New Version). Untuk operasi spesifik, lihat Buat ruang kerja.

Versi lama DataStudio mendukung migrasi data ke Data Studio versi baru dengan mengklik tombol Upgrade to Data Studio di bagian atas halaman Data Development dan mengikuti petunjuk di layar. Untuk informasi selengkapnya, lihat Panduan peningkatan Data Studio.

Buka Data Studio yang baru

Buka halaman Workspaces di konsol DataWorks. Di bilah navigasi atas, pilih wilayah yang diinginkan. Temukan ruang kerja yang diinginkan dan pilih di kolom Actions.

FAQ

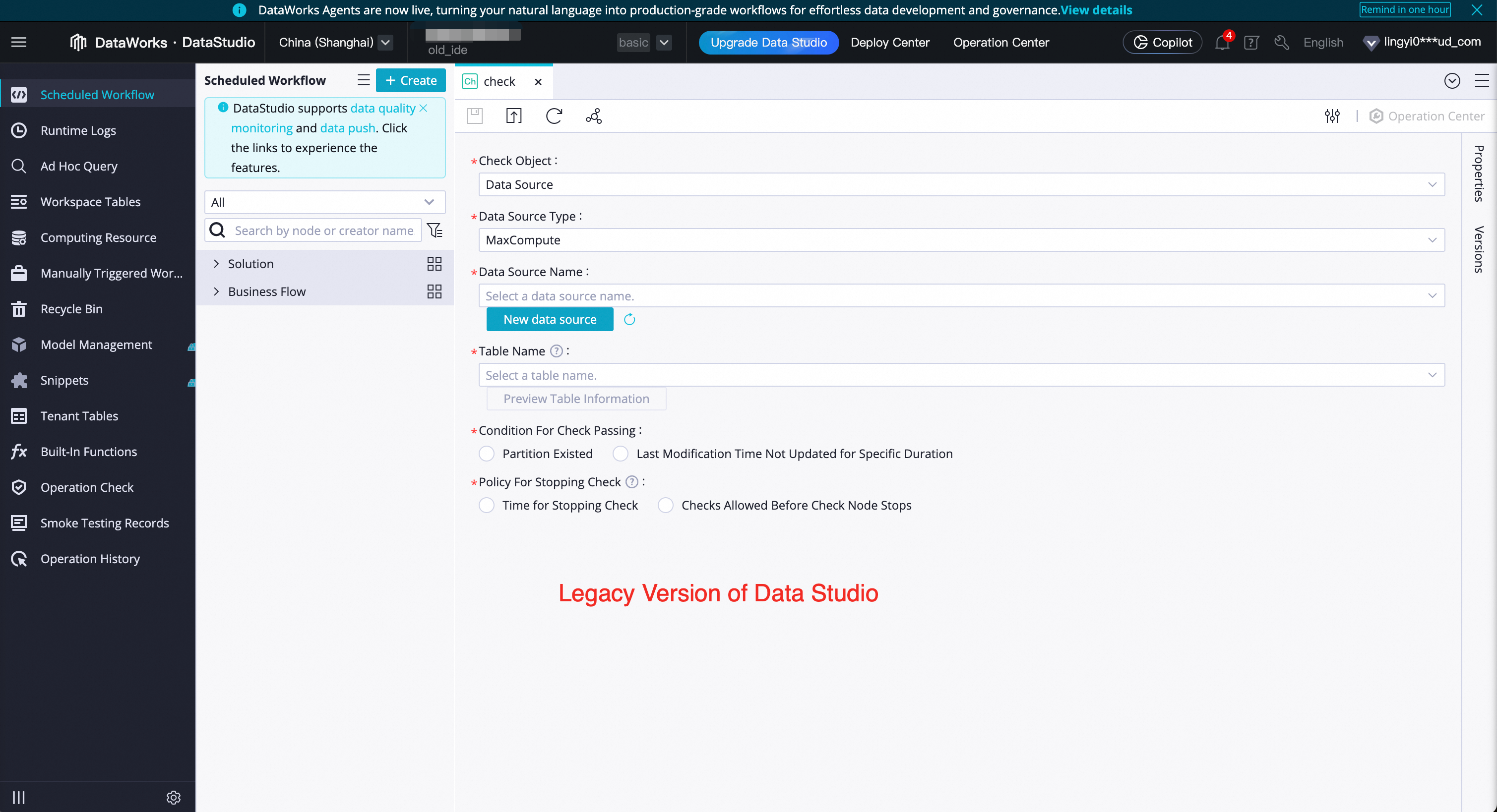

Q: Bagaimana cara menentukan apakah saya menggunakan versi baru atau lama Data Studio?

A: Gaya halaman sangat berbeda. Versi baru terlihat seperti tangkapan layar dalam dokumen ini, sedangkan versi lama ditunjukkan pada gambar di bawah.

Q: Apakah saya dapat kembali ke versi lama Data Studio setelah melakukan upgrade ke versi baru?

A: Upgrade dari versi lama ke versi baru merupakan operasi yang tidak dapat dikembalikan. Setelah upgrade berhasil, Anda tidak dapat kembali ke versi lama. Sebelum beralih, kami menyarankan Anda terlebih dahulu membuat ruang kerja dengan Data Studio versi baru diaktifkan untuk pengujian. Pastikan versi baru memenuhi kebutuhan bisnis Anda sebelum melakukan upgrade. Selain itu, data di versi baru dan lama Data Studio saling independen.

Q: Mengapa saya tidak melihat opsi Use Data Studio (New Version) saat membuat ruang kerja?

A: Jika Anda tidak melihat opsi ini di antarmuka, artinya ruang kerja Anda telah mengaktifkan Data Studio versi baru secara default.

PentingJika Anda mengalami masalah apa pun saat menggunakan Data Studio versi baru, Anda dapat bergabung dengan grup DingTalk eksklusif untuk dukungan peningkatan DataWorks Data Studio untuk mendapatkan bantuan.