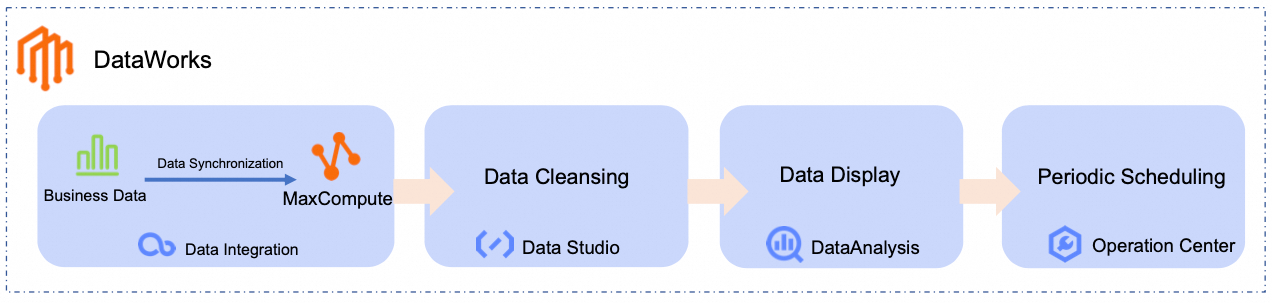

Tutorial ini mencakup ingesti data, pemrosesan, penjadwalan, dan visualisasi menggunakan fitur inti DataWorks.

Pendahuluan

Tutorial ini menunjukkan cara membangun pipa data—mulai dari ingesti data mentah hingga analisis dan visualisasi—menggunakan skenario e-commerce. Proses standar ini membantu Anda membangun alur data yang dapat digunakan ulang dengan cepat, dilengkapi penjadwalan dan observabilitas yang andal, sehingga menurunkan hambatan penerapan aplikasi data besar dan memungkinkan pengguna bisnis mengekstraksi nilai tanpa mengelola detail teknis.

Anda akan melakukan tugas-tugas berikut:

Sinkronisasi data: Buat tugas sinkronisasi batch di Data Integration untuk memindahkan data bisnis ke platform komputasi seperti MaxCompute.

Pembersihan data: Bersihkan, analisis, dan eksplorasi data di Data Studio.

Visualisasi data: Visualisasikan hasil analisis di Data Analysis agar lebih mudah diinterpretasi oleh pihak bisnis.

Penjadwalan: Jadwalkan tugas sinkronisasi dan pembersihan untuk berjalan secara otomatis.

Anda akan menyinkronkan data produk dan pesanan mentah dari sumber publik ke MaxCompute, lalu menganalisisnya untuk menghasilkan peringkat harian kategori terlaris:

Prasyarat

Gunakan Akun Alibaba Cloud atau Pengguna RAM dengan izin AliyunDataWorksFullAccess. Untuk informasi selengkapnya, lihat Persiapkan Akun Alibaba Cloud atau Persiapkan Pengguna RAM.

DataWorks mendukung kontrol izin granular pada tingkat produk dan modul. Untuk detailnya, lihat Ikhtisar sistem pengelolaan izin DataWorks.

Persiapan

Aktifkan DataWorks

Buat ruang kerja

Buat dan asosiasikan sumber daya

Aktifkan akses jaringan publik

Asosiasikan sumber daya MaxCompute

Prosedur

Tutorial ini menggunakan skenario berikut sebagai contoh untuk memandu Anda melalui pengalaman cepat fitur DataWorks:

Platform e-commerce menyimpan data produk dan pesanan di MySQL. Tujuannya adalah menganalisis data pesanan dan memvisualisasikan peringkat harian kategori terlaris.

Langkah 1: Sinkronisasi data

Buat sumber data

Buat sumber data MySQL untuk menghubungkan ke database yang menyimpan data sampel.

DataWorks menyediakan database MySQL publik dengan data sampel. Anda tidak perlu menyiapkan data mentah. Data tabel yang relevan disimpan di database MySQL publik, dan Anda hanya perlu membuat sumber data MySQL untuk mengaksesnya.

Buka halaman Pusat Manajemen DataWorks, alihkan ke wilayah Singapore, pilih ruang kerja yang telah dibuat dari kotak drop-down, lalu klik Go to Management Center.

Di panel navigasi kiri, klik Data Sources. Klik Add Data Source, pilih tipe MySQL, lalu konfigurasikan parameter sumber data MySQL.

CatatanGunakan nilai default untuk parameter yang tidak tercantum.

Pengguna pertama kali harus menyelesaikan otorisasi lintas layanan. Ikuti petunjuk untuk mengotorisasi AliyunDIDefaultRole.

Parameter

Deskripsi

Data Source Name

Dalam contoh ini, yaitu MySQL_Source.

Configuration Mode

Pilih Connection String Mode.

Endpoint

Host Address IP:

rm-bp1z69dodhh85z9qa.mysql.rds.aliyuncs.comPort Number:

3306.

PentingData yang disediakan dalam tutorial ini semata-mata untuk berlatih aplikasi data di DataWorks. Semua data merupakan data uji dan hanya mendukung pembacaan di modul Data Integration.

Database Name

Atur ke

retail_e_commerce.Username

Masukkan username

workshop.Password

Masukkan password

workshop#2017.Di bagian Connection Configuration, alihkan ke tab Data Integration, temukan kelompok sumber daya yang diasosiasikan dengan ruang kerja, lalu klik Test Network Connectivity di kolom Connectivity Status.

CatatanJika pengujian konektivitas sumber data MySQL gagal, lakukan operasi berikut:

Selesaikan operasi lanjutan dari tool diagnostik konektivitas.

Periksa apakah EIP telah dikonfigurasi untuk VPC yang terikat pada kelompok sumber daya, karena sumber data MySQL memerlukan kemampuan akses jaringan publik pada kelompok sumber daya. Untuk detailnya, lihat Aktifkan akses jaringan publik.

Klik Complete Creation.

Bangun pipa sinkronisasi

Pada langkah ini, Anda perlu membangun pipa sinkronisasi untuk menyinkronkan data pesanan produk dari platform e-commerce ke tabel di MaxCompute sebagai persiapan untuk pemrosesan data selanjutnya.

Klik ikon

di pojok kiri atas dan pilih untuk masuk ke halaman pengembangan data.

di pojok kiri atas dan pilih untuk masuk ke halaman pengembangan data.Alihkan ke ruang kerja yang dibuat dalam tutorial ini di bagian atas halaman, lalu klik

di panel navigasi kiri untuk masuk ke halaman Workspace Directories.

di panel navigasi kiri untuk masuk ke halaman Workspace Directories.Di area Workspace Directories, klik

, pilih Create Workflow, lalu atur nama alur kerja. Dalam tutorial ini, diatur menjadi

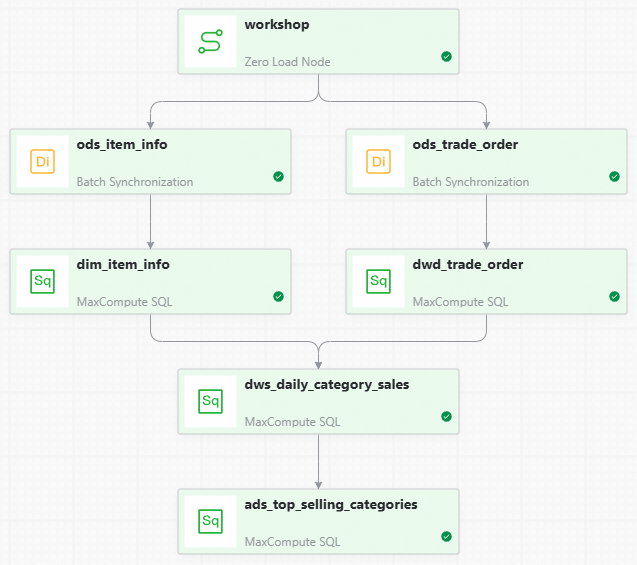

, pilih Create Workflow, lalu atur nama alur kerja. Dalam tutorial ini, diatur menjadi dw_quickstart.Di halaman orkestrasi alur kerja, seret node Zero Load dan Batch Synchronization dari sisi kiri ke kanvas, lalu atur nama node masing-masing.

Nama dan fungsi node dijelaskan di bawah ini:

Tipe Node

Nama Node

Fungsi Node

Zero Load

Zero LoadworkshopDigunakan untuk mengelola seluruh alur kerja analisis profil pengguna, sehingga jalur alur data menjadi lebih jelas. Node ini merupakan tugas dry run dan tidak memerlukan pengeditan kode.

Batch Synchronization Node

Batch Synchronization Nodeods_item_infoDigunakan untuk menyinkronkan tabel sumber informasi produk

item_infoyang disimpan di MySQL ke tabelods_item_infodi MaxCompute. Batch Synchronization Node

Batch Synchronization Nodeods_trade_orderDigunakan untuk menyinkronkan tabel sumber informasi pesanan

trade_orderyang disimpan di MySQL ke tabelods_trade_orderdi MaxCompute.Secara manual seret garis untuk mengatur node

workshopsebagai node hulu untuk dua node sinkronisasi batch. Hasil akhirnya adalah sebagai berikut:Konfigurasi penjadwalan alur kerja.

Klik Scheduling di sisi kanan halaman orkestrasi alur kerja untuk mengonfigurasi parameter yang relevan. Berikut adalah parameter utama yang diperlukan untuk tutorial ini. Gunakan nilai default untuk parameter yang tidak tercantum.

Parameter

Deskripsi

Scheduling Parameters

Atur parameter penjadwalan untuk seluruh alur kerja, yang dapat langsung digunakan oleh node internal dalam alur kerja.

Dalam tutorial ini, konfigurasikan sebagai

bizdate=$[yyyymmdd-1]untuk mendapatkan tanggal hari sebelumnya.CatatanDataWorks menyediakan parameter penjadwalan untuk memungkinkan input kode dinamis. Anda dapat mendefinisikan variabel dalam kode SQL menggunakan format

${Nama Variabel}dan memberikan nilai untuk variabel tersebut di Scheduling > Scheduling Parameters. Untuk detail format yang didukung untuk parameter penjadwalan, lihat Format yang didukung untuk parameter penjadwalan.Scheduling Cycle

Dalam tutorial ini, konfigurasikan sebagai

Day.Scheduling Time

Dalam tutorial ini, atur Scheduling Time ke

00:30. Alur kerja akan dimulai pada pukul00:30setiap hari.Scheduling Dependencies

Alur kerja tidak memiliki dependensi hulu, sehingga dapat dibiarkan tidak dikonfigurasi. Untuk manajemen terpadu yang lebih mudah, Anda dapat mengklik Use Workspace Root Node untuk memasang alur kerja di bawah node root ruang kerja.

Format penamaan untuk node root ruang kerja adalah:

WorkspaceName_root.

Konfigurasikan tugas sinkronisasi

Konfigurasikan node awal

Konfigurasikan pipa informasi produk

Konfigurasikan pipa data pesanan

Langkah 2: Pembersihan data

Setelah data disinkronkan dari MySQL ke MaxCompute, menghasilkan dua tabel data (tabel informasi produk ods_item_info dan tabel informasi pesanan ods_trade_order), Anda dapat membersihkan, memproses, dan menganalisis data di modul DataStudio DataWorks untuk mendapatkan peringkat harian kategori produk terlaris.

Bangun pipa pemrosesan data

Di panel navigasi kiri DataStudio, klik

untuk masuk ke halaman pengembangan data. Lalu, di area Workspace Directories, temukan alur kerja yang telah dibuat, klik untuk masuk ke halaman orkestrasi alur kerja, seret node MaxCompute SQL dari sisi kiri ke kanvas, lalu atur nama node masing-masing.

untuk masuk ke halaman pengembangan data. Lalu, di area Workspace Directories, temukan alur kerja yang telah dibuat, klik untuk masuk ke halaman orkestrasi alur kerja, seret node MaxCompute SQL dari sisi kiri ke kanvas, lalu atur nama node masing-masing.Nama dan fungsi node dijelaskan di bawah ini:

Tipe Node

Nama Node

Fungsi Node

MaxCompute SQL

MaxCompute SQLdim_item_infoMemproses data dimensi produk berdasarkan tabel

ods_item_infountuk menghasilkan tabel dimensi informasi dasar produkdim_item_info. MaxCompute SQL

MaxCompute SQLdwd_trade_orderMenjalankan pembersihan awal, transformasi, dan pemrosesan logika bisnis pada data transaksi pesanan detail berdasarkan tabel

ods_trade_orderuntuk menghasilkan tabel fakta detail transaksi pesanandwd_trade_order. MaxCompute SQL

MaxCompute SQLdws_daily_category_salesMengagregasi data detail yang telah dibersihkan dan distandardisasi dari lapisan DWD berdasarkan tabel

dwd_trade_orderdan tabeldim_item_infountuk menghasilkan tabel ringkasan penjualan kategori produk hariandws_daily_category_sales. MaxCompute SQL

MaxCompute SQLads_top_selling_categoriesMenghasilkan tabel peringkat kategori produk terlaris harian

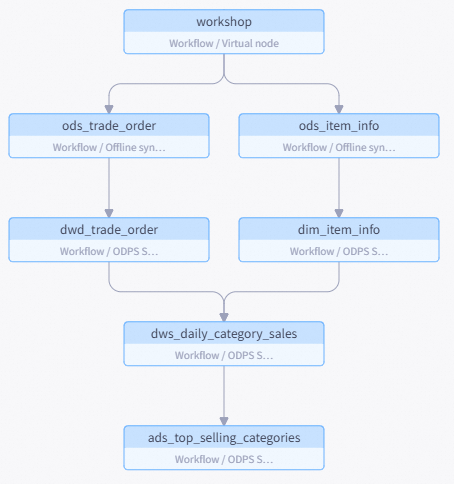

ads_top_selling_categoriesberdasarkan tabeldws_daily_category_sales.Secara manual seret garis untuk mengonfigurasi node hulu untuk setiap node. Hasil akhirnya adalah sebagai berikut:

CatatanAlur kerja mendukung pengaturan dependensi hulu dan hilir untuk setiap node melalui koneksi manual. Alur kerja juga mendukung penggunaan penguraian kode di dalam node anak untuk mengidentifikasi dependensi node secara otomatis. Tutorial ini menggunakan metode koneksi manual. Untuk informasi selengkapnya tentang penguraian kode, lihat Penguraian dependensi otomatis.

Konfigurasikan node pemrosesan data

Konfigurasikan dim_item_info

Konfigurasikan dwd_trad_order

Konfigurasikan dws_daily_category_sales

Konfigurasikan ads_top_selling_categories

Langkah 3: Debug dan jalankan

Setelah konfigurasi alur kerja selesai, Anda perlu menjalankan seluruh alur kerja untuk memverifikasi kebenaran konfigurasi sebelum menerapkannya ke lingkungan produksi.

Di panel navigasi kiri DataStudio, klik

untuk masuk ke halaman pengembangan data. Lalu, di area Workspace Directories, temukan alur kerja yang telah dibuat.

untuk masuk ke halaman pengembangan data. Lalu, di area Workspace Directories, temukan alur kerja yang telah dibuat.Klik Run di bilah alat node, lalu isi Value Used in This Run dengan tanggal hari sebelumnya (misalnya,

20250416).CatatanDalam konfigurasi node alur kerja, parameter penjadwalan DataWorks telah digunakan untuk mengimplementasikan input kode dinamis. Anda perlu memberikan nilai konstan ke parameter ini untuk pengujian selama debugging.

Klik OK untuk masuk ke halaman debug running.

Tunggu hingga proses selesai. Hasil yang diharapkan adalah sebagai berikut:

Langkah 4: Kueri dan visualisasi data

Anda telah memproses data uji mentah yang diperoleh dari MySQL melalui pengembangan data dan mengagregasikannya ke dalam tabel ads_top_selling_categories. Sekarang Anda dapat mengkueri data tabel untuk melihat hasil analisis data.

Klik ikon

di pojok kiri atas, lalu klik di halaman pop-up.

di pojok kiri atas, lalu klik di halaman pop-up.Klik di sebelah My Files, sesuaikan File Name, lalu klik OK.

Di halaman SQL Query, konfigurasikan SQL berikut.

SELECT * FROM ads_top_selling_categories WHERE pt=${bizdate};Pilih sumber data MaxCompute di pojok kanan atas lalu klik OK.

Klik tombol Run di bagian atas, lalu klik Run di halaman Cost Estimation.

Klik

pada hasil kueri untuk melihat hasil visualisasi grafik. Anda dapat mengklik

pada hasil kueri untuk melihat hasil visualisasi grafik. Anda dapat mengklik  di pojok kanan atas grafik untuk menyesuaikan gaya grafik tersebut.

di pojok kanan atas grafik untuk menyesuaikan gaya grafik tersebut. Anda juga dapat mengklik Save di pojok kanan atas grafik untuk menyimpan grafik sebagai kartu, lalu klik Card (

) di panel navigasi kiri untuk melihatnya.

) di panel navigasi kiri untuk melihatnya.

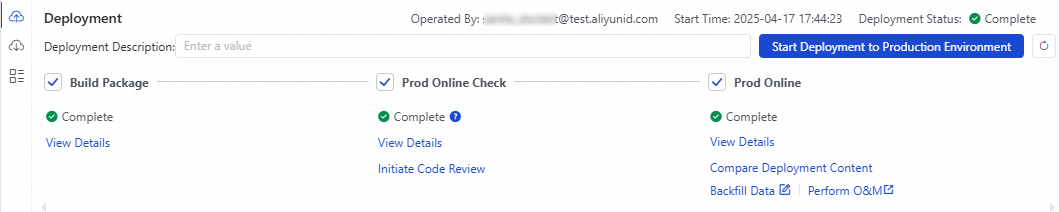

Langkah 5: Penjadwalan periodik

Dengan menyelesaikan langkah-langkah sebelumnya, Anda telah memperoleh data penjualan berbagai produk dari hari sebelumnya. Namun, jika Anda perlu memperoleh data penjualan terbaru setiap hari, Anda dapat menerapkan alur kerja ke lingkungan produksi agar dieksekusi secara periodik pada waktu yang dijadwalkan.

Parameter terkait penjadwalan telah dikonfigurasi untuk alur kerja, node sinkronisasi, dan node pemrosesan data saat mengonfigurasi sinkronisasi data dan pemrosesan data. Anda tidak perlu mengonfigurasinya lagi di sini; cukup terapkan alur kerja ke lingkungan produksi. Untuk informasi lebih rinci tentang konfigurasi penjadwalan, lihat Konfigurasi penjadwalan node.

Klik ikon

di pojok kiri atas, lalu klik di halaman pop-up.

di pojok kiri atas, lalu klik di halaman pop-up.Di panel navigasi kiri DataStudio, klik

untuk masuk ke halaman pengembangan data, alihkan ke ruang proyek yang digunakan dalam kasus ini, lalu temukan alur kerja yang telah dibuat di area Workspace Directories.

untuk masuk ke halaman pengembangan data, alihkan ke ruang proyek yang digunakan dalam kasus ini, lalu temukan alur kerja yang telah dibuat di area Workspace Directories.Klik Deploy di bilah alat node. Di panel deployment, klik Start Deployment to Production. Tunggu hingga Build Package dan Prod Online Check selesai, lalu klik Deploy.

Setelah status Prod Online menjadi Complete, klik Perform O&M untuk menuju ke Operation Center.

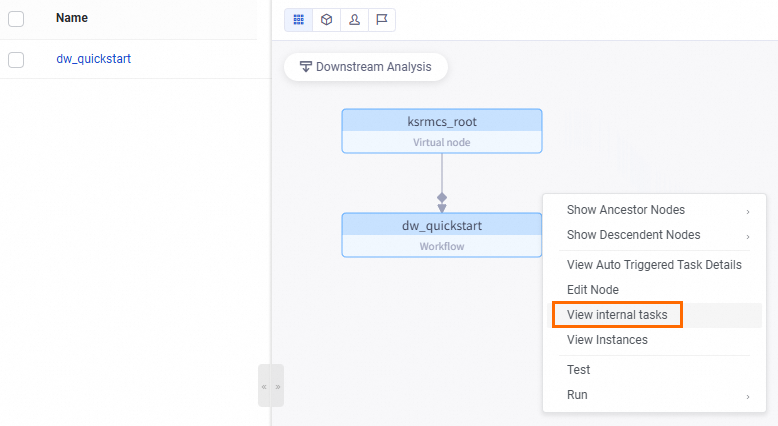

Di , Anda dapat melihat tugas periodik alur kerja (dalam tutorial ini, alur kerja diberi nama

dw_quickstart).Untuk melihat detail tugas periodik node anak dalam alur kerja, klik kanan tugas periodik alur kerja tersebut lalu pilih View Internal Tasks.

Hasil yang diharapkan adalah sebagai berikut:

Langkah selanjutnya

Untuk detail operasional dan penjelasan parameter setiap modul dalam tutorial ini, lihat Integrasi Data, Data Studio (Baru), Analisis Data, dan Konfigurasi penjadwalan node.

Selain modul yang diperkenalkan dalam tutorial ini, DataWorks juga mendukung berbagai modul lain seperti Pemodelan Data, Kualitas Data, Penjaga Keamanan Data, dan Studio Layanan Data, yang menyediakan pemantauan dan O&M data terpadu.

Anda juga dapat mencoba tutorial praktis DataWorks lainnya. Untuk detailnya, lihat Lebih banyak kasus penggunaan dan tutorial.