Humanos expertos en tecnología, ¡prepárense para un emocionante viaje al mundo de la inteligencia artificial! No daremos solo un vistazo; nos adentraremos en profundidad al modelo de chat de Qwen. ¿De qué hablaremos? Sobre la creación de un chatbot más inteligente que un zorro y que respete la privacidad como un superagente secreto. ¿Le interesa? ¡La respuesta debería ser “sí”! Comencemos nuestro viaje de comprensión de la IA generativa y los modelos de lenguaje grandes (LLM)

IA generativa es la rama de la inteligencia artificial cuyo objetivo es crear de nuevos contenidos, ya sean textos, imágenes, música u otras formas multimedia. Este tipo de IA utiliza modelos de machine learning, sobre todo los generativos, para comprender los patrones, las características y las relaciones de los conjuntos de datos grandes y generar resultados nuevos y que se distingan del contenido creado por humanos.

La IA generativa evoluciona rápidamente y sus capacidades se expanden más allá de los límites de la creación automática, lo que ofrece oportunidades y desafíos emocionantes que deben administrarse con responsabilidad.

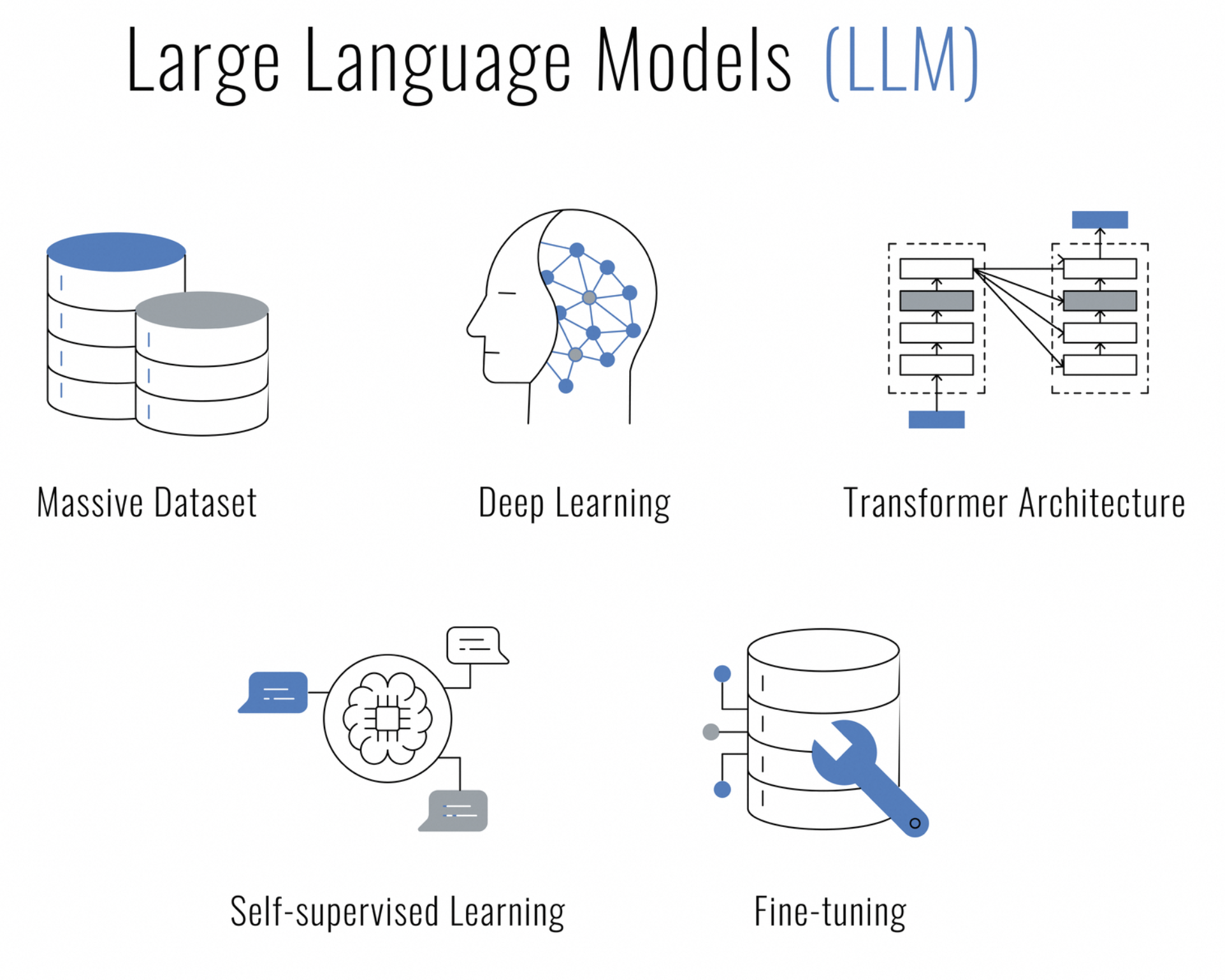

¿Qué son los modelos de lenguaje grandes (LLM)? Los LLM son un tipo de inteligencia artificial que se basan en técnicas de aprendizaje profundo diseñadas para la comprensión, la generación y el trabajo con el lenguaje humano. Son “grandes” porque contienen millones, o incluso miles de millones, de parámetros, lo que les permite capturar una gran cantidad de datos de los significados y los contextos

Los LLM están entrenados con una gran cantidad de datos de texto y utilizan arquitecturas como la red neuronal transformadora, la cual puede procesar secuencias de datos (como las oraciones) y prestarles atención a las distintas partes de la secuencia al hacer predicciones. Esto los convierte particularmente efectivos para varias tareas de natural language processing (NLP), las cuales incluyen:

-La traducción: Son capaces de traducir texto entre varios idiomas con un alto grado de precisión.

¿Se encuentra en la búsqueda de una IA que pueda, entre otras cosas, chatear, crear contenido, resumir y codificar y que respete el derecho a la privacidad? No busque más; el modelo de chat de Qwen llegó para transformar el centro de datos en un bastión de interacciones seguras con tecnología IA.

Qwen no es un chatbot más. Utiliza un modelo de lenguaje masivo y fue entrenado con la asombrosa cantidad de 3 billones de tokens de datos multilingües. Esta maravilla de la IA entiende a la perfección tanto el inglés como el chino y fue preparada para la interacción humana.

Desplegar Qwen de manera local en el servidor significa tomar el control. Significa garantizar que las conversaciones, los datos procesados y la privacidad prometida permanezcan bajo su alcance. Ya sea que se trate de una empresa que busca integrar un sistema de chat inteligente, un desarrollador aficionado a la investigación de IA o simplemente un entusiasta ansioso por explorar los límites de la IA conversacional, Qwen es la mejor opción.

¿Por qué alojar los LLM de manera local? La respuesta son tres palabras: control, velocidad y privacidad. Mantenga los datos bajo su control, obtenga respuestas a la velocidad de la luz y descanse tranquilo con la seguridad de que su chatbot no cuenta sus secretos en todos los servicios públicos.

La comunidad del código abierto amplifica el espíritu de innovación de la IA. De acuerdo con esta tradición, el código original completo para el modelo de chat de Qwen está disponible en GitHub para que cualquier persona interesada en sumergirse en la mecánica del modelo contribuya en el desarrollo o simplemente lo utilice como un recurso de aprendizaje. Los investigadores, los desarrolladores o los aficionados a la IA pueden acceder al código fuente en Qwen.

Antes de comenzar este viaje tecnológico, nos aseguremos de que cuente con todos los requisitos:

¿Tiene todo? ¡Maravilloso! Pongamos las manos en la masa (de manera figurada, por supuesto).

El código Python para chatear con Qwen es flexible, independiente de IDE y es la mejor opción para los fanáticos de Visual Studio Code, entusiastas de PyCharm o personas que disfrutan del estilo interactivo de los cuadernos de Jupyter. Con solo un entorno compatible con Python ya puede activar el compañero de chat con IA.

Un consejo profesional: Si utiliza VSCode, aproveche el terminal incorporado para ejecutar los scripts de Python sin problemas. Abra la paleta de comandos (Ctrl+Shift+P), escriba “Python: Python: Run Python File in Terminal” (ejecutar el archivo Python en el terminal) y VSCode hará el trabajo pesado. Las respuestas de Qwen aparecerán directamente en el terminal integrado.

Para quienes prefieren PyCharm, la ejecución del código es igual de fluida. Haga clic derecho en el script y seleccione “Ejecutar 'nombre_del_script.py'” e IDE ejecutará la conversación con Qwen. Las herramientas poderosas y las características de depuración de PyCharm lo convierten en la mejor opción para desarrollar interacciones más complejas.

Y esto no termina aquí. Hay una gran cantidad de editores de IDE y de códigos compatibles con Python. Seleccione el que mejor se adapte a los flujos de trabajo y comience a chatear.

Antes que nada, preparemos el servidor Linux. Asegúrese de que la lista de paquetes esté nueva y que Python y PIP estén listos para desplegar su magia.

sudo apt update

sudo apt install python3 python3-pipY ahora, el ingrediente secreto: un entorno virtual. Es como tener un espacio de trabajo propio donde nadie lo regaña por el desorden.

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateSe necesitan algunas herramientas para poder activar Qwen. Imagínese que busca los ingredientes para preparar un platillo digno de un reconocimiento.

pip install torch torchvision torchaudio

pip install transformersRecuerde que PyTorch debe combinarse con CUDA; es como combinar un buen vino con el queso correcto.

Qwen le brinda significado a las palabras. El “tokenizador” realiza su trabajo y convierte los pensamientos en algo con lo que Qwen puede trabajar.

Desde transformadores, importe AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)La mente de Qwen es amplia y está lista para llenarse de conversaciones. Así se despierta a este gigante dormido

Desde “transformadores”, importe “AutoModelForCausalLM”

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()Según su hardware, puede elegir utilizar distintos modos de precisión, como BF16 o FP16. Es como afinar una guitarra para tocar las notas perfectas.

Y ahora, la cereza del pastel: ¡A chatear con Qwen! Pero antes de que se deje llevar, hay algo crucial que debe conocer: el arte de la continuidad de la conversación.

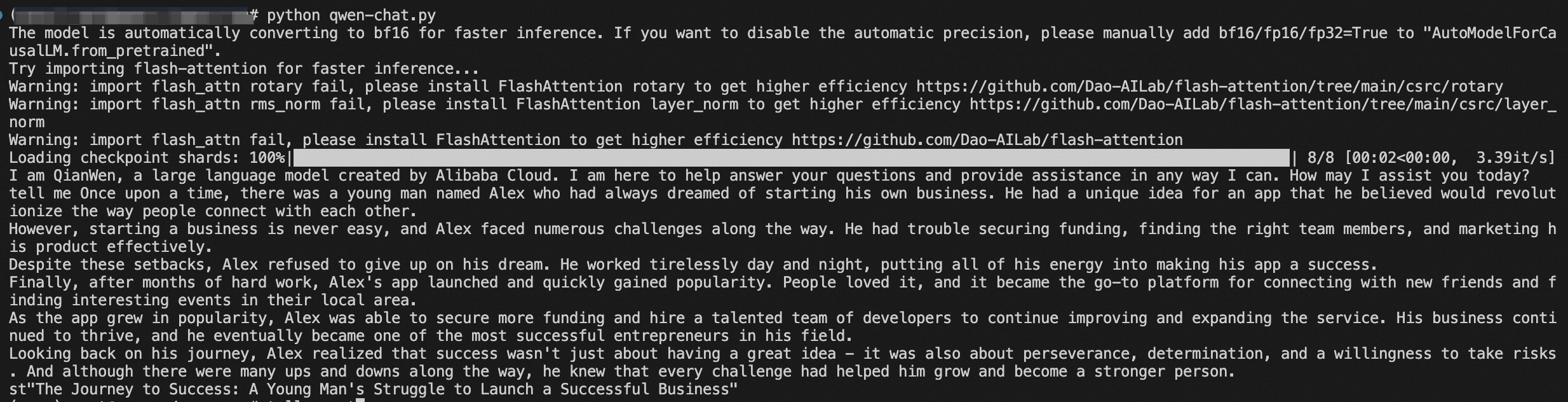

Aquí hay un adelanto del tipo de réplica que puede esperar:

response, history = model.chat(tokenizer, "¡Hola, Qwen! ¿Qué tal la vida en el reino digital?", history=None)

print("Qwen:", response)Lo primero que hacemos es saludar a Qwen sin ninguna interacción ni historial previo. Al establecer el historial en “None”, le decimos a Qwen: "Aquí comenzamos nuestra conversación". Qwen, con nada más que el impulso para continuar, responderá con la frescura de una nueva interacción.

Ahora, observe cómo se desarrolla la magia del contexto:

response, history = model.chat(tokenizer, "¿Qué opinas sobre el significado de la vida, del universo y de la existencia?", history=history)

print("Qwen:", response)Aquí utilizamos el historial que permanece de la conversación anterior. Esto es como entregar a Qwen un diario con todo lo que hablamos hasta ahora. Con este contexto, Qwen puede elaborar una respuesta que no solo sea ingeniosa o profunda, sino que también esté conectada a nuestra conversación. Esta es la diferencia entre las conversaciones con un amigo que le conoce y hacerle preguntas a un extraño.

Ahora que ya conoce la importancia del contexto con el parámetro del historial, comience a utilizar el script de demostración y prepárese para una gran conversación con Qwen. Ya sea para discutir sobre el universo o para aprender la mejor receta de galletas digitales, Qwen está preparado para responder sus solicitudes con la elegancia de un conversador experimentado.

También, puede utilizar el script y comenzar la conversación. Es como abrir una caja de Pandora, pero en lugar de caos, obtienes una maravillosa conversación:

python qwen_chat.pyY así llegamos al final. Su proprio compañero de chat de IA se encuentra listo para conquistar el mundo de las conversaciones.

¡Felicidades! Sobrevivió al tumultuoso viaje a través del despliegue de IA como un experimentado capitán. Qwen ya está cómodamente instalado en el servidor y sus datos están bien asegurados.

Conozca las capacidades de Qwen, contribuya en el desarrollo y únase a una comunidad de personas que compartan la misma pasión por mejorar las conversaciones de IA.

Participe en diálogos asombrosos con su nuevo y brillante compañero de IA. Y, ¿quién sabe? Tal vez Qwen lo sorprenda con su sabiduría digital o una broma que lo hará reír hasta que le duela.

Este artículo fue originalmente escrito en inglés. Vea el artículo original aquí

Die Bereitstellung des QWEN-Chat-Modells mit HuggingFace-Handbuch

Terapkan Teman Obrolan AI Anda Sendiri - Penerapan Model Obrolan Qwen dengan Panduan HuggingFace

125 posts | 4 followers

FollowRegional Content Hub - April 28, 2024

Alibaba Clouder - October 12, 2020

Regional Content Hub - April 28, 2024

Regional Content Hub - March 25, 2024

Tran Phuc Hau - July 12, 2024

Regional Content Hub - April 14, 2025

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud Model Studio

Alibaba Cloud Model Studio

A one-stop generative AI platform to build intelligent applications that understand your business, based on Qwen model series such as Qwen-Max and other popular models

Learn MoreMore Posts by Regional Content Hub