Okay, Sie sind ein technisch versierter Mensch, machen Sie sich bereit auf ein aufregendes Abenteuer in das Land der künstlichen Intelligenz! Wir tauchen hier nicht nur unsere Zehen ein; mit dem Qwen-Chat-Modell tauchen wir uns kopfüber ins kalte Wasser. Was steht auf der Tagesordnung? Einen klügeren Chatbot als einen Fuchs einrichten und die Privatsphäre wie ein erstklassiger Geheimagent respektieren. Fasziniert? Sie sollen es sein! Beginnen wir unsere Reise, indem wir Generative KI und LLM (Großes Sprachmodell) verstehen.

Generative KI bezieht sich auf den Zweig der künstlichen Intelligenz, der sich auf das Erstellen neuer Inhalte konzentriert, seien es Text, Bilder, Musik oder andere Medienformen. Diese Art von KI nutzt maschinelle Lernmodelle, insbesondere generative Modelle, um Muster, Merkmale und Beziehungen in großen Datensätzen zu verstehen und Ausgänge zu generieren, die neu und oft nicht von vom Menschen geschaffenen Inhalten zu unterscheiden sind.

Generative KI entwickelt sich schnell weiter und ihre Fähigkeiten erweitern die Grenzen dessen, was Maschinen schaffen können, und bieten sowohl aufregende Chancen als auch Herausforderungen, die verantwortungsbewusst verwaltet werden müssen.

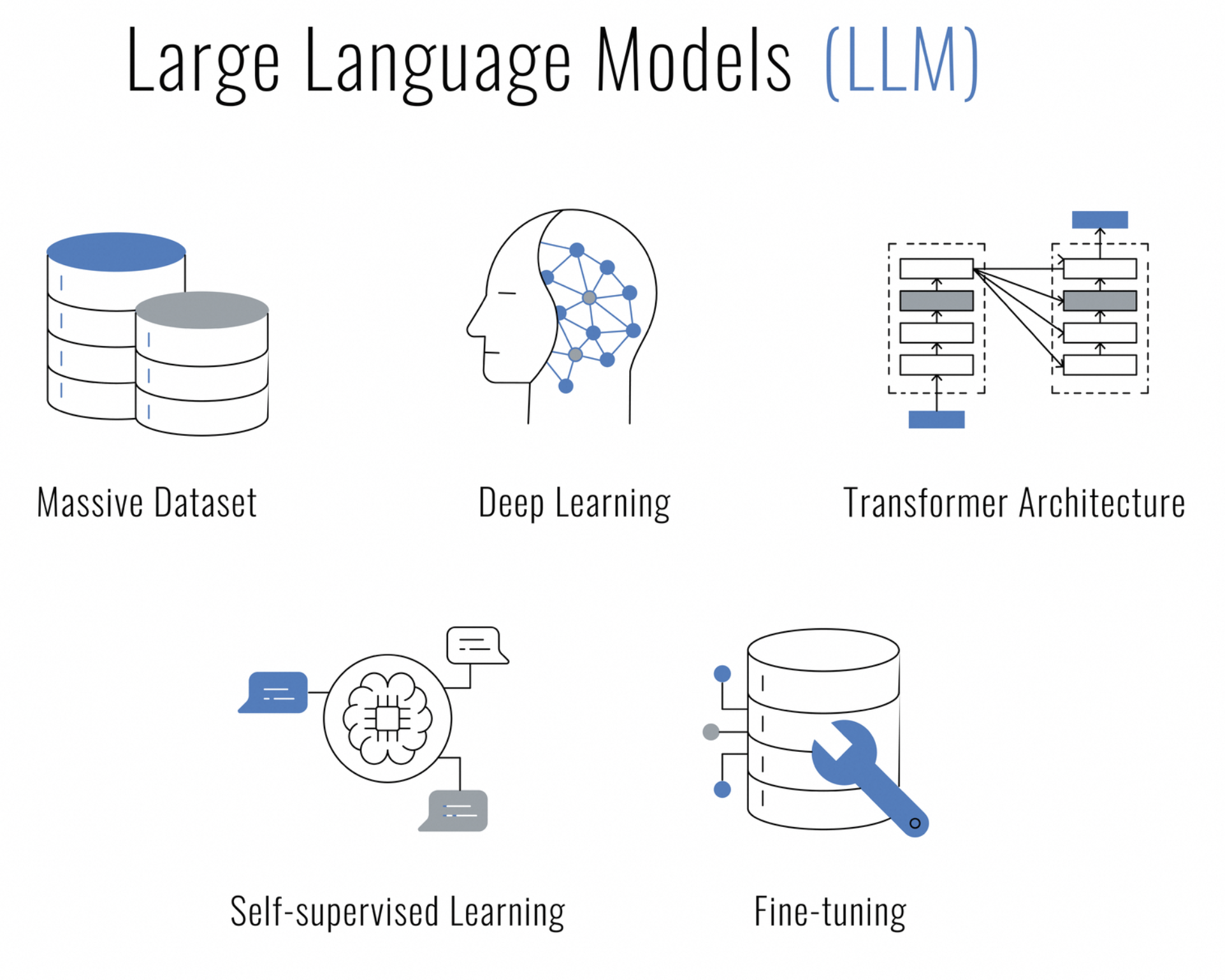

Was sind Große Sprachmodelle (LLMs)? Sie sind eine Art künstliche Intelligenz, die auf Deep-Learning-Techniken basiert, die zum Verständnis, Generieren und Arbeiten mit menschlicher Sprache entworfen wurden. Sie werden als "groß" bezeichnet, weil sie aus vielen Millionen oder sogar Milliarden von Parametern bestehen, die es ihnen ermöglichen, eine Vielzahl von Sprachnuancen und Kontexten zu erfassen.

LLMs werden mit großen Mengen an Textdaten trainiert und verwenden Architekturen wie neuronale Transformatornetzwerke, die in der Lage sind, Datensequenzen (wie Sätze) zu verarbeiten und bei Vorhersagen auf verschiedene Teile der Sequenz zu achten. Dies macht sie für eine Reihe von Aufgaben der natürlichen Sprachverarbeitung (NLP) besonders effektiv, wie beispielsweise:

Sind Sie auf der Suche nach einer KI, die chatten, Inhalte erstellen, zusammenfassen, codieren und vieles mehr kann, während Ihr Recht auf Privatsphäre respektiert wird? Suchen Sie nicht weiter, das Qwen-Chat-Modell ist hier, um Ihr Rechenzentrum in eine Bastion sicherer KI-betriebener Interaktionen zu verwandeln.

Qwen ist nicht Ihr durchschnittlicher Chatbot. Es basiert auf einem massiven Sprachmodell und wurde mit erstaunlichen 3 Billionen Token mehrsprachiger Daten trainiert. Dieses KI-Wunderwerk versteht sowohl Englisch als auch Chinesisch sehr gut und wurde auf eine menschenähnliche Interaktion abgestimmt.

Bei der lokalen Bereitstellung von Qwen auf Ihrem Server geht es darum, die Kontrolle zu übernehmen. Es geht darum, sicherzustellen, dass die von Ihnen geführten Gespräche, die verarbeiteten Daten und die versprochene Privatsphäre in Ihrem Zuständigkeitsbereich bleiben. Egal, ob Sie ein Unternehmen sind, das ein intelligentes Chat-System integrieren möchte, ein Entwickler, der sich für KI-Forschung interessiert, oder einfach ein Enthusiast, der die Grenzen der Gespräch-KI erkunden möchte, ist Qwen Ihre erste Wahl.

Warum sollten Sie diesen LLM vor Ort hosten wollen? Drei Wörter: Kontrolle, Geschwindigkeit und Privatsphäre. Sie halten Ihre Daten in der Nähe Ihrer Brust, die Antworten kommen blitzschnell und Sie können sich darauf verlassen, dass Ihr Chatbot Ihre Geheimnisse nicht überall in den öffentlichen Diensten ausplaudert.

Der Innovationsgeist in der KI wird durch die Open-Source-Gemeinschaft noch verstärkt. Im Einklang mit dieser Tradition ist der vollständige Quellcode für das Qwen-Chat-Modell auf GitHub für jeden, der sich für die Mechanismen des Modells interessiert, verfügbar zu seiner Entwicklung beitragen oder es einfach als Lernressource nutzen möchte. Egal ob Sie Forscher, Entwickler oder KI-Hobbyist sind, können Sie auf den Quellcode unter Qwen zugreifen.

Bevor wir uns auf diese Tech-Odyssee begeben, sollten wir sicherstellen, dass Sie alles bereit haben:

Haben Sie das alles? Fabelhaft! Lassen Sie uns die Hände schmutzig machen (im übertragenen Sinne natürlich).

Egal, ob Sie ein eingefleischter Fan von Visual Studio Code, ein PyCharm-Enthusiast oder jemand sind, der das interaktive Flair von Jupyter Notebooks genießt, ist der Python-Code für das Chatten mit Qwen flexibel und IDE-agnostisch. Alles, was Sie brauchen, ist eine Umgebung, die Python unterstützt, und Sie sind bereit, Ihren KI-Chat-Buddy zum Leben zu erwecken.

Hier ist ein Profi-Tipp: Wenn Sie VSCode verwenden, nutzen Sie die Vorteile des eingebauten Terminals, um Ihre Python-Skripte nahtlos auszuführen. Öffnen Sie einfach die Befehlspalette (Strg+Umschalt+P), geben Sie Python: Run Python File in Terminal ein, und lassen Sie VSCode die schwere Arbeit machen. Sie werden die Antworten von Qwen in Ihrem integrierten Terminal sehen.

Für diejenigen unter Ihnen, die PyCharm bevorzugen, ist die Ausführung Ihres Codes genauso reibungslos. Klicken Sie mit der rechten Maustaste auf Ihr Skript und wählen Sie Run 'script_name.py' aus und beobachten Sie, wie die IDE Ihr Gespräch mit Qwen ausführt. Die leistungsstarken Tools und Debugging-Merkmale von PyCharm machen es zu einer großartigen Wahl für die Entwicklung komplexerer Interaktionen.

Und es endet nicht dort – es gibt eine ganze Vielzahl von IDEs und Code-Editoren, die Python mit offenen Armen begrüßen. Wählen Sie diejenige, die am besten zu Ihrem Workflow passt, und fangen Sie an zu chatten!

Als Erstes müssen wir Ihren Linux-Server vorbereiten. Stellen Sie sicher, dass Ihre Paketliste so frisch ist wie die morgendliche Brise und dass Python und pip bereit sind, ihre Magie zu bearbeiten:

sudo apt update

sudo apt install python3 python3-pipNun zur geheimen Zutat: eine virtuelle Umgebung Es ist wie ein persönlicher Arbeitsbereich, in dem Sie ein Chaos schaffen können, ohne dass jemand Sie anschreit, dass Sie aufräumen sollen:

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateBevor wir Qwen zum Leben erwecken, brauchen Sie einige Tools. Stellen Sie sich dies als Sammeln von Zutaten für ein Michelin-Stern-Essen vor:

pip install torch torchvision torchaudio

pip install transformersDenken Sie daran, PyTorch mit Ihrer CUDA-Version abzustimmen – es ist, als würde man einen guten Wein mit dem richtigen Käse kombinieren.

Worte sind nur Wörter, bis Qwen ihnen eine Bedeutung gibt. Hier kommt der Tokenizer ins Spiel, der Ihre Gedanken in etwas verwandelt, an dem Qwen kauen kann:

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)Qwens Geist ist riesig und bereit, mit Ihren Gesprächen gefüllt zu werden. Hier erfahren Sie, wie Sie den schlafenden Riesen aufwecken:

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()Abhängig von Ihrer Hardware können Sie sich für verschiedene Präzisionsmodi wie BF16 oder FP16 entscheiden. Es ist, als würde man seine Gitarre auf die perfekte Tonhöhe stimmen.

Jetzt kommt der herzzerreißende Teil - es ist Zeit, mit Qwen zu chatten! Aber bevor Sie sich vom Hin und Her mitreißen lassen, lassen Sie uns über etwas Entscheidendes sprechen: die Kunst der Gesprächskontinuität.

Hier ist ein kleiner Vorgeschmack auf die Art von Schlagfertigkeit, die Sie erwarten können:

response, history = model.chat(tokenizer, "Hallo, Qwen! Wie ist das Leben in der digitalen Welt?", history=None)

print("Qwen:", response)In unserem Eröffnungsschachzug begrüßen wir Qwen ohne Bedingungen, d. h. ohne Gesprächsverlauf. Durch die Einstellung von history=None, sagen wir zu Qwen, "Dies ist der Beginn unseres Chats." Da Qwen nichts anderes als die aktuelle Eingabeaufforderung hat, um weiterzumachen, wird es mit der Frische einer neuen Interaktion antworten.

Beobachten Sie jetzt, wie sich die Magie des Kontexts entfaltet:

response, history = model.chat(tokenizer, "Irgendwelche Gedanken über den Sinn des Lebens, das Universum und alles?", history=history)

print("Qwen:", response)In dieser Runde geben wir den Verlauf weiter, den wir bei unserem letzten Austausch erhalten haben. Das ist, als würde man Qwen ein Tagebuch mit allem, worüber wir bisher gesprochen haben, geben. Mit diesem historischen Kontext kann Qwen eine Antwort, die nicht nur witzig oder tiefgreifend ist, sondern auch mit unserem laufenden Gespräch verbunden ist, erstellen. Es ist der Unterschied zwischen einem Gespräch mit einem klugen Freund, der Sie kennt und Fragen eines Fremden stellt.

- Das Gespräch im Fluss halten: Genau wie bei menschlichen Interaktionen sorgt die Bezugnahme auf frühere Kommentare, Witze oder Geschichten für spannende Scherze. Qwen, bewaffnet mit der Geschichte des Gesprächs, kann sich an den vergangenen Austausch erinnern und verweisen, was zu einem Chat führt, das so kontinuierlich wie faszinierend ist

Jetzt, da Sie ein Profi über die Wichtigkeit des Kontexts mit dem Verlaufsparameter sind, starten Sie das Demo-Skript und machen Sie sich bereit für einen spannenden Chat mit Qwen. Egal, ob Sie über den Kosmos oder das beste Rezept für digitale Cookies diskutieren, Qwen ist bereit, Ihrer Gesprächsführung mit aller Anmut eines erfahrenen Gesprächspartners zu folgen.

Sie können dieses Skript auch starten und das Gespräch beginnen. Es ist, als würde man die Büchse der Pandora öffnen, aber anstelle von Chaos bekommt man entzückende Scherze:

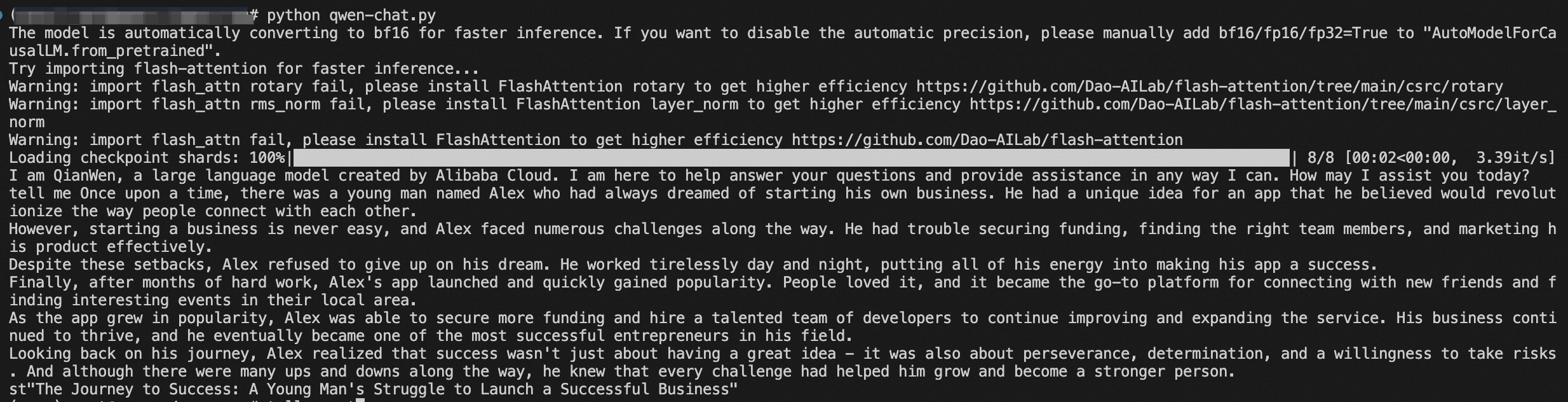

python qwen_chat.pyUnd da haben Sie es, mein Freund – Sie haben Ihren eigenen KI-Chat-Buddy, der bereit ist, die Welt des Gesprächs zu erobern.

Glückwunsch! Sie haben wie ein erfahrener Kapitän durch die tückischen Gewässer der KI-Bereitstellung navigiert. Qwen ist jetzt fest auf Ihrem Server eingerichtet, und Ihre Daten sind so sicher wie Häuser.

Erkunden Sie die Fähigkeiten von Qwen, tragen Sie zu seiner Entwicklung bei und treten Sie einer Gemeinschaft von gleichgesinnten Einzelpersonen bei, die sich leidenschaftlich für den Zustand der KI-Gespräche voranzutreiben.

Also, gehen Sie weiter und führen Sie epische Dialoge mit Ihrem glänzenden neuen KI-Kumpel. Und wer weiß? Vielleicht überrascht Qwen Sie mit seiner digitalen Weisheit oder einem Witz, der Sie zum ROFL bringt.

Dieser Artikel wurde ursprünglich auf Englisch verfasst. Sehen Sie sich den Originalartikel hier an.

125 posts | 4 followers

FollowRegional Content Hub - April 15, 2024

Alibaba Clouder - January 31, 2019

Alibaba Clouder - July 10, 2020

Regional Content Hub - April 28, 2024

Regional Content Hub - March 25, 2024

Alibaba Clouder - April 17, 2020

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud Model Studio

Alibaba Cloud Model Studio

A one-stop generative AI platform to build intelligent applications that understand your business, based on Qwen model series such as Qwen-Max and other popular models

Learn MoreMore Posts by Regional Content Hub