เอาล่ะ มนุษย์ผู้คลั่งไคล้เทคโนโลยี เตรียมตัวให้พร้อมสำหรับการผจญภัยอันน่าตื่นเต้นในดินแดนแห่งปัญญาประดิษฐ์กันได้แล้ว! เราจะไม่ดูแค่ผิวเผิน แต่เรากำลังจะเจาะลึกถึงทุกส่วนด้วยโมเดล Qwen Chat สิ่งที่เราจะได้รู้น่ะเหรอ? การตั้งค่าแชทบอทที่ฉลาดล้ำและเคารพความเป็นส่วนตัวเหมือนสายลับชั้นยอด ทึ่งล่ะสิ? มาลองกัน! มาเริ่มต้นการเดินทางของเราด้วยการทำความเข้าใจ Generative AI และ LLM (โมเดลภาษาขนาดใหญ่)

Generative AI เป็นปัญญาประดิษฐ์แขนงหนึ่งที่เน้นไปที่การสร้างเนื้อหาใหม่ๆ ไม่ว่าจะเป็นข้อความ รูปภาพ เพลง หรือสื่อรูปแบบอื่นๆ AI ประเภทนี้ใช้ประโยชน์จากโมเดลการเรียนรู้ของเครื่อง โดยเฉพาะโมเดล Generative เพื่อทำความเข้าใจรูปแบบ คุณสมบัติ และความสัมพันธ์ในชุดข้อมูลขนาดใหญ่กับการสร้างผลลัพธ์ที่ใหม่และมักจะเหมือนกับงานที่มนุษย์สร้างขึ้น

### แอปพลิเคชัน

Generative AI ยังคงพัฒนาอย่างรวดเร็ว และความสามารถของมันกำลังทำให้เครื่องจักรสามารถทำอะไรได้หลากหลายมากขึ้น ซึ่งเป็นทั้งทั้งโอกาสที่น่าจับตามองและความท้าทายที่จำเป็นต้องได้รับการจัดการอย่างมีความรับผิดชอบ

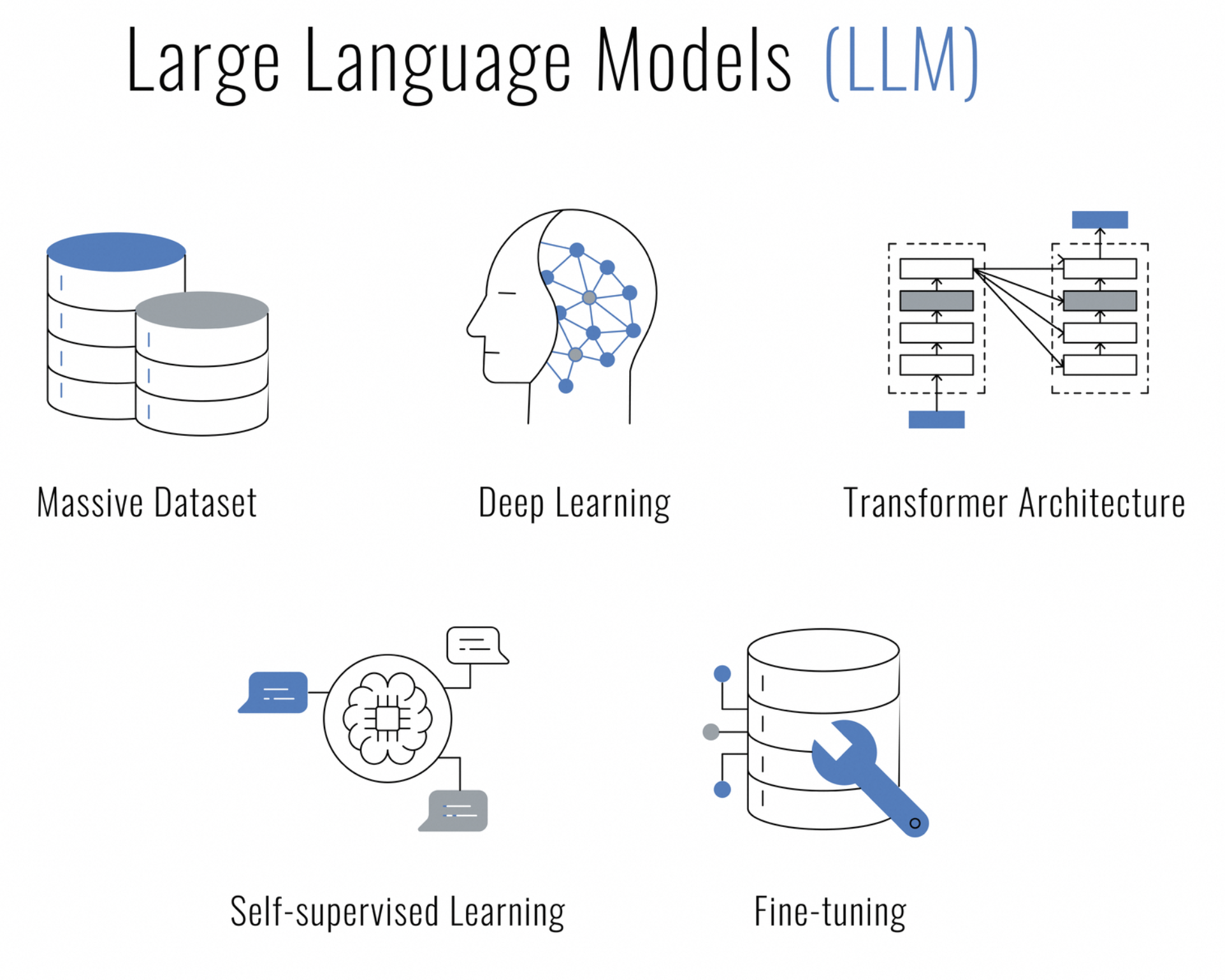

โมเดลภาษาขนาดใหญ่ (LLM) คืออะไร? เป็นปัญญาประดิษฐ์ประเภทหนึ่งที่ใช้เทคนิคการเรียนรู้เชิงลึกซึ่งออกแบบมาเพื่อทำความเข้าใจ สร้างงาน และทำงานกับภาษาของมนุษย์ สาเหตุที่ได้ชื่อว่า "ขนาดใหญ่" เพราะประกอบด้วยพารามิเตอร์หลายล้านหรืออาจถึงหลายพันล้านพารามิเตอร์ ซึ่งทำให้สามารถจับความแตกต่างและบริบทของภาษาได้หลากหลาย

LLM ได้รับการฝึกกับข้อมูลที่เป็นข้อความจำนวนมหาศาล และใช้สถาปัตยกรรม เช่น โครงข่ายของ Transformer ซึ่งมีความสามารถในการประมวลผลลำดับของข้อมูล (เช่น ประโยค) และให้ความสนใจกับส่วนต่างๆ ของลำดับเมื่อทำการคาดการณ์ ทำให้มีประสิทธิภาพโดยเฉพาะในงานประมวลผลภาษาธรรมชาติ (NLP) ต่างๆ เช่น

คุณกำลังมองหา AI ที่สามารถแชท สร้างเนื้อหา สรุป เขียนโค้ด และอื่นๆ อีกมากมาย ทั้งหมดนี้โดยเคารพสิทธิ์ในความเป็นส่วนตัวของคุณใช่ไหม? ไม่ต้องเหนื่อยหาอีกต่อไป เพราะโมเดล Qwen Chat มาเพื่อเปลี่ยนศูนย์ข้อมูลของคุณให้กลายเป็นการโต้ตอบที่ทำงานด้วย AI อย่างปลอดภัย

Qwen ไม่ใช่แชทบอททั่วไปของคุณ นี่คือแชทบอทสร้างขึ้นจากโมเดลภาษาขนาดใหญ่ และได้รับการฝึกอบรมด้วยข้อมูลหลายภาษาจำนวน 3 ล้านล้านโทเค็น AI มหัศจรรย์นี้เข้าใจทั้งภาษาอังกฤษและจีนอย่างลึกซึ้ง และได้รับการปรับแต่งเพื่อการโต้ตอบที่เหมือนมนุษย์อีกด้วย

การปรับใช้ Qwen ในเครื่องบนเซิร์ฟเวอร์ของคุณเป็นเรื่องของการควบคุม ซึ่งจะเกี่ยวกับการรับรองว่าการสนทนาที่คุณมี ข้อมูลที่ประมวลผล และความเป็นส่วนตัวที่ตกลงไว้ยังคงอยู่ภายใต้ขอบเขตของคุณ Qwen คือทางเลือกของคุณ ไม่ว่าคุณจะเป็นธุรกิจที่ต้องการผสานการทำงานกับระบบแชทอัจฉริยะ นักพัฒนาผู้กระตือรือร้นในการวิจัย AI หรือเป็นเพียงผู้มุ่งมั่นที่จะสำรวจขอบเขตของ AI เชิงสนทนา

ทำไมตอนนี้คุณถึงต้องการโฮสต์ LLM นี้ในเครื่อง? คำตอบคือสามคำอย่าง "การควบคุม" "ความเร็ว" และ "ความเป็นส่วนตัว" คุณเก็บข้อมูลของคุณไว้ใกล้ตัว ตอบสนองเร็วดุจสายฟ้าแลบ และสบายใจได้เมื่อรู้ว่าแชทบอทของคุณไม่ได้เอาความลับของคุณไปเปิดเผยทั่วสาธารณะ

จิตวิญญาณแห่งนวัตกรรมใน AI ได้รับการขยายให้กว้างขึ้นโดยชุมชนโอเพ่นซอร์ส เพื่อให้เป็นไปตามธรรมเนียมนี้ ซอร์สโค้ดแบบเต็มสำหรับ โมเดล Qwen Chat พร้อมให้ทุกคนใช้งานได้บน GitHub สำหรับผู้ที่สนใจเจาะลึกกลไกของโมเดล ซึ่งจะมีส่วนช่วยในการพัฒนา หรือจะเพียงแค่ใช้เป็นทรัพยากรการเรียนรู้ก็ได้ ไม่ว่าคุณจะเป็นนักวิจัย นักพัฒนา หรือผู้ที่ชื่นชอบ AI คุณก็เข้าถึงซอร์สโค้ดได้ที่ Qwen

ก่อนที่เราจะออกผจญภัยสู่การเดินทางแห่งเทคโนโลยีนี้ เรามาตรวจสอบให้แน่ใจว่าคุณพร้อมแล้วหรือยังดีกว่า

มีหมดแล้วเหรอ? เยี่ยมไปเลย! มาทำให้มือของเราสกปรกกันเถอะ (แค่เปรียบเปรยเฉยๆ น่ะ)

ไม่ว่าคุณจะเป็นแฟนตัวยงของ Visual Studio Code หรือเป็นผู้ชื่นชอบ PyCharm หรือเป็นผู้ที่เพลิดเพลินกับการโต้ตอบของ Jupyter Notebooks โค้ด Python สำหรับการแชทกับ Qwen นั้นมีความยืดหยุ่นและไม่ยึดติดกับ IDE สิ่งที่คุณต้องมีคือสภาพแวดล้อมที่รองรับ Python และคุณพร้อมที่จะทำให้คู่หูแชท AI ของคุณมีชีวิตขึ้นมา

เคล็ดลับสำหรับมือโปร: หากคุณใช้ VSCode ให้ใช้ประโยชน์จากเทอร์มินัลในตัวเพื่อเรียกใช้สคริปต์ Python ได้อย่างราบรื่น เพียงเปิดชุดคำสั่ง (Ctrl+Shift+P) พิมพ์ Python: เรียกใช้ไฟล์ Python ใน Terminal แล้วปล่อยให้ VSCode จัดการงานหนัก คุณจะเห็นคำตอบของ Qwen ในเทอร์มินัลรวมของคุณ

สำหรับผู้ที่ชอบ PyCharm การรันโค้ดของคุณก็จะราบรื่นเช่นกัน คลิกขวาที่สคริปต์ของคุณแล้วเลือกเรียกใช้ 'script_name.py' และดูว่า IDE ดำเนินการสนทนาของคุณกับ Qwen ด้วยเครื่องมืออันทรงพลังและคุณสมบัติการแก้ไขข้อบกพร่องของ PyCharm นี่คือตัวเลือกที่ยอดเยี่ยมสำหรับการพัฒนาการโต้ตอบที่ซับซ้อนมากขึ้น

และมันไม่ได้จบเพียงแค่นั้น มี IDE และโปรแกรมแก้ไขโค้ดมากมายที่ยินดีอ้าแขนต้อนรับ Python เลือกอันที่เหมาะกับขั้นตอนการทำงานของคุณที่สุดแล้วเริ่มแชทได้เลย!

ก่อนอื่นมาเตรียมเซิร์ฟเวอร์ Linux ของคุณกันก่อน ตรวจสอบให้แน่ใจว่ารายการแพ็คเกจของคุณสดใหม่ราวกับสายลมยามเช้า ส่วน Python และ pip ก็พร้อมที่จะร่ายเวทมนตร์

sudo apt update

sudo apt install python3 python3-pipตอนนี้ถึงเวลาสำหรับส่วนผสมลับอย่างสภาพแวดล้อมเสมือนจริง มันเหมือนกับการมีพื้นที่ทำงานส่วนตัวที่คุณสามารถทำอะไรเละเทะได้โดยไม่มีใครตะโกนสั่งให้คุณทำความสะอาด

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateก่อนที่เราจะทำให้ Qwen ใช้งานได้ คุณจะต้องมีเครื่องมือบางอย่างก่อน คิดซะว่านี่เป็นการรวบรวมวัตถุดิบสำหรับมื้ออาหารระดับดาวมิชลินละกัน

pip install torch torchvision torchaudio

pip install transformersอย่าลืมจับคู่ PyTorch กับเวอร์ชัน CUDA ของคุณ มันเหมือนกับการจับคู่ชีสที่ใช่กับไวน์ชั้นดี

คำพูดจะเป็นเพียงคำพูด จนกว่า Qwen จะทำให้มีความหมาย นี่คือสิ่งที่โทเค็นไนเซอร์เข้ามาเปลี่ยนความคิดของคุณให้เป็นสิ่งที่ Qwen สามารถย่อยได้

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)จิตใจของ Qwen นั้นกว้างใหญ่และพร้อมที่จะเติมเต็มการสนทนาของคุณ นี่คือวิธีปลุกยักษ์หลับให้ตื่นขึ้นมา

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()คุณอาจเลือกใช้โหมดความแม่นยำที่แตกต่างกัน เช่น BF16 หรือ FP16 ทั้งนี้ขึ้นอยู่กับฮาร์ดแวร์ของคุณ มันเหมือนกับการตั้งสายกีตาร์เพื่อให้ได้ระดับเสียงที่สมบูรณ์แบบ

นี่คือช่วงที่ทำให้หัวใจเต้นแรง – ถึงเวลาพูดคุยกับ Qwen แล้ว! แต่ก่อนที่คุณจะถูกลากกลับไปกลับมา เรามาพูดถึงสิ่งที่สำคัญกันดีกว่าอย่างศิลปะของการสนทนาอย่างต่อเนื่อง

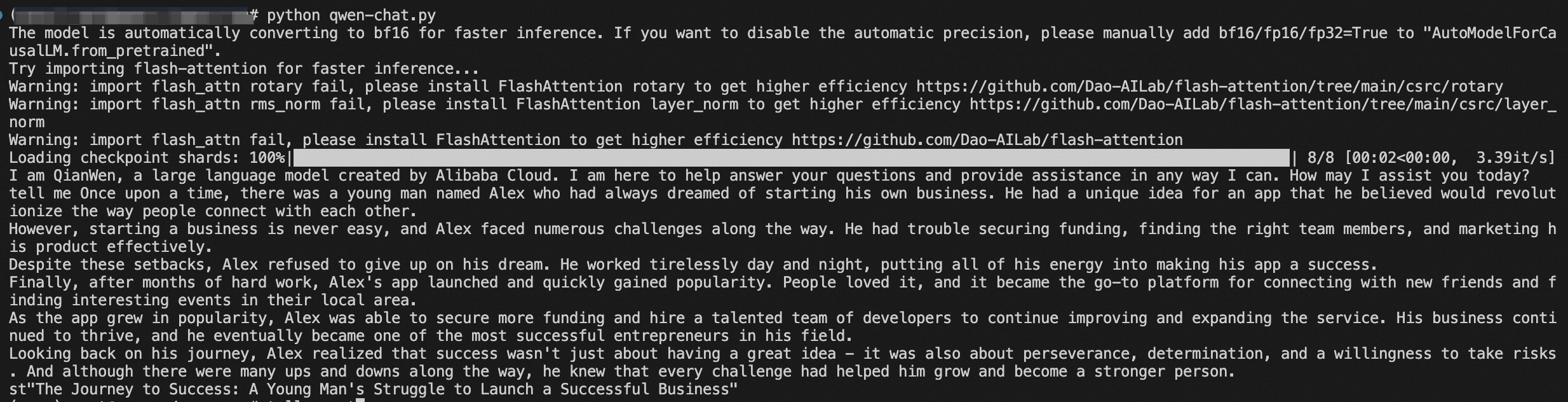

ต่อไปนี้เป็นตัวอย่างการโต้ตอบที่คุณคาดหวังได้

response, history = model.chat(tokenizer, "Greetings, Qwen! How's life in the digital realm?", history=None)

print("Qwen:", response)ในกลเม็ดการเปิดของเรา เรากำลังทักทาย Qwen โดยไม่มีเงื่อนไขใดๆ กล่าวคือ ไม่มีประวัติการสนทนา โดยการตั้งค่า history=None เรากำลังบอก Qwen ว่า "นี่คือจุดเริ่มต้นของการแชทของเรา" Qwen ไม่มีอะไรนอกจากพรอมต์ปัจจุบันที่จะดำเนินต่อไป จงตอบสนองด้วยความสดใหม่ในปฏิสัมพันธ์ครั้งใหม่

ตอนนี้มาดูความมหัศจรรย์ของบริบทที่ถูกเปิดเผย

response, history = model.chat(tokenizer, "Any thoughts on the meaning of life, the universe, and everything?", history=history)

print("Qwen:", response)รอบนี้เราขอเล่าประวัติที่เราได้รับจากการแลกเปลี่ยนครั้งที่แล้ว มันเหมือนกับการมอบไดอารี่ของทุกสิ่งที่เราพูดจนถึงตอนนี้ให้กับ Qwen ด้วยบริบทจากประวัติสนทนา Qwen จะสามารถสร้างคำตอบที่ไม่ใช่แค่มีไหวพริบหรือลึกซึ้งเท่านั้น แต่ยังเชื่อมโยงกับการสนทนาที่กำลังดำเนินอยู่ของเราด้วย มันคือความแตกต่างระหว่างการพูดคุยกับเพื่อนสุดฉลาดที่รู้จักคุณกับการถามคำถามกับคนแปลกหน้า

ตอนนี้คุณเป็นผู้เชี่ยวชาญด้านความสำคัญของบริบทด้วยพารามิเตอร์ประวัติแล้ว มาเริ่มใช้สคริปต์สาธิตนั้นและเตรียมพร้อมสำหรับการสนทนาที่น่าดึงดูดกับ Qwen กันเลย ไม่ว่าคุณจะกำลังพูดคุยเกี่ยวกับจักรวาลหรือสูตรคุกกี้ดิจิทัลที่ดีที่สุด Qwen ก็พร้อมที่จะติดตามการสนทนาของคุณด้วยความสง่างามในแบบของนักสนทนาที่ช่ำชอง

นอกจากนี้คุณยังสามารถเริ่มสคริปต์นั้นและเริ่มการสนทนาได้ มันเหมือนกับการเปิดกล่องแพนโดร่า แต่แทนที่จะวุ่นวาย กลับกลายเป็นเรื่องล้อเล่นที่น่าเบิกบาน

python qwen_chat.pyในที่สุดคุณก็มีแล้ว คุณมีเพื่อนแชท AI ของคุณเองที่พร้อมที่จะพิชิตโลกแห่งการสนทนา

ยินดีด้วย! คุณได้ออกท่องโลกในน่านน้ำอันตรายของการติดตั้ง AI ประหนึ่งกัปตันผู้ช่ำชอง ตอนนี้ Qwen ได้รับการติดตั้งอย่างอบอุ่นบนเซิร์ฟเวอร์ของคุณ และข้อมูลของคุณก็ปลอดภัยเสมือนบ้าน

สำรวจความสามารถต่างๆ ของ Qwen มีส่วนร่วมในการพัฒนา และเข้าร่วมชุมชนที่มีความคิดเหมือนกันซึ่งหลงใหลในการพัฒนาสถานะของการสนทนา AI

ถ้ายังงั้นแล้วก็ออกไปมีส่วนร่วมในบทสนทนาครั้งยิ่งใหญ่กับเพื่อนสนิท AI คนใหม่ของคุณเลย บางที Qwen อาจทำให้คุณประหลาดใจกับสติปัญญาดิจิทัลหรือเรื่องตลกที่จะทำให้คุณก็ได้ ใครจะไปรู้?

บทความนี้เดิมเป็นภาษาอังกฤษ ดูบทความต้นฉบับ ที่นี่

Terapkan Teman Obrolan AI Anda Sendiri - Penerapan Model Obrolan Qwen dengan Panduan HuggingFace

Руководство по развертыванию модели чата Qwen с помощью HuggingFace

125 posts | 4 followers

FollowRegional Content Hub - April 22, 2024

Regional Content Hub - September 18, 2024

Regional Content Hub - April 14, 2025

Yossavadee.Sak - July 13, 2024

Regional Content Hub - July 28, 2025

Regional Content Hub - August 12, 2024

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub