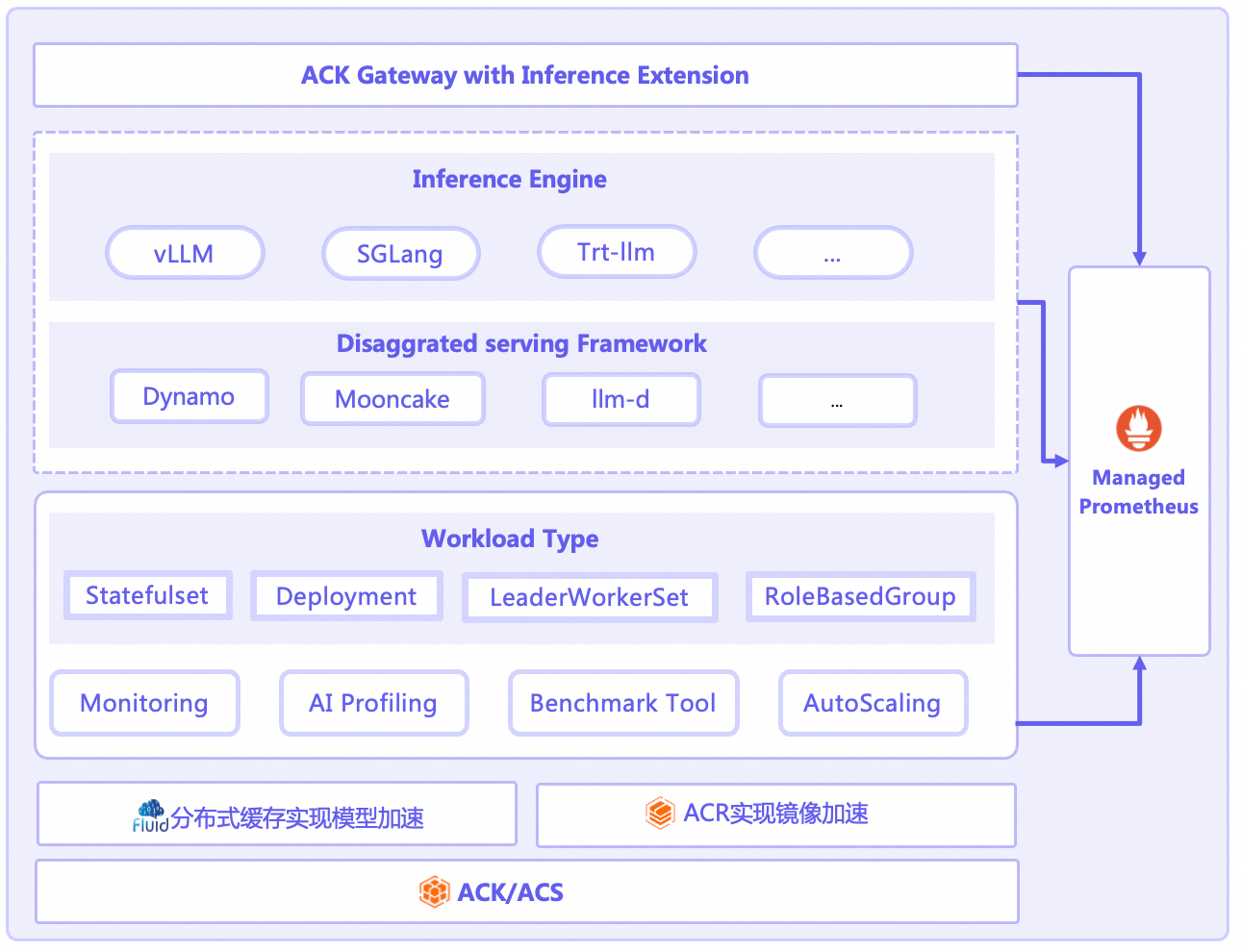

隨著大語言模型(LLM)的廣泛應用,如何在生產環境中實現其高效、穩定且大規模的部署與營運,已成為企業面臨的核心挑戰。雲原生 AI 推理套件(AI Serving Stack)基於阿里雲Container Service,專為雲原生AI推理而設計的端到端解決方案。該套件致力於解決LLM推理的全生命週期問題,提供從部署管理、智能路由、Auto Scaling、深度可觀測的一體化能力。無論是剛剛起步還是已經擁有大規模AI業務,雲原生AI推理套件都能輕鬆駕馭複雜的雲原生AI推理情境。

核心功能

雲原生AI推理套件通過其創新的工作負載設計、精細化的彈效能力、深度的可觀測性以及強大的擴充機制,為使用者在Kubernetes上運行LLM推理服務推理提供了前所未有的便捷與效能。AI推理套件具有以下核心功能。

功能項 | 說明 | 相關文檔 |

支援單機LLM推理 | 使用StatefulSet部署LLM推理服務,支援單機單卡和單機多卡部署。 | |

支援多機分布式LLM推理 | 使用LeaderWorkerSet部署多機多卡的分布式推理服務。 | |

支援多種推理引擎的PD分離部署 | 各種推理引擎實現PD分離的架構各不相同,部署方案各異,因此AI推理套件使用RoleBasedGroup作為工作負載,統一部署各種推理引擎的PD分離架構。 | |

彈性擴縮容 | 成本與效能的平衡是LLM服務的關鍵。AI推理套件提供了業界領先的多維度、多層次Auto Scaling能力。

| |

可觀測性 | 黑盒化的推理過程是效能最佳化的巨大障礙。AI推理套件提供了開箱即用的深度可觀測性方案。

| |

推理網關 | ACK Gateway with Inference Extension組件是基於Kubernetes社區Gateway API及其Inference Extension規範實現的增強型組件,支援Kubernetes四層/七層路由服務,並提供面向產生式AI推理情境的一系列增強能力。它能夠簡化產生式AI推理服務的管理流程,並最佳化在多個推理服務工作負載之間的負載平衡效能。 | |

模型加速 | 在AI推理情境中,LLM模型載入慢導致應用冷啟動耗時高、Auto Scaling受阻等問題。Fluid通過構建分布式緩衝將遠端模型檔案快取到節點本地,實現極速啟動、零冗餘、極致彈性。 | |

效能剖析 | 為了進行更深層次的效能分析,可使用AI Profiling工具,它允許開發人員在不中斷服務、不修改代碼的前提下,通過GPU容器進程資料的採集,對線上啟動並執行訓練推理服務進行效能觀測剖析。

|

免責聲明

AI推理套件為開源推理引擎及其PD分離架構提供部署管理的能力,阿里雲為AI推理套件提供支援人員,但對於使用者在使用過程中因開源引擎和開源PD分離架構本身產生的缺陷從而導致使用者業務受損的情況,阿里雲不提供賠償或者補償等商務服務。