本文以Qwen3-32B模型為例,示範如何在ACK中使用vLLM架構及SGLang架構部署多機分布式模型推理服務。

背景知識

Qwen3-32B

Qwen3-32B 是通義千問系列最新一代的大型語言模型,基於328億參數的密集模型架構,兼具卓越的推理能力與高效的對話效能。其最大特色在於支援思考模式與非思考模式的無縫切換。在複雜邏輯推理、數學計算和代碼產生任務中表現出眾,而在日常對話情境下也可高效響應。模型具備出色的指令遵循、多輪對話、角色扮演和創意寫作能力,並在Agent任務中實現領先的工具調用表現。原生支援32K上下文,結合YaRN技術可擴充至131K。同時,支援100多種語言,具備強大的多語言理解與翻譯能力,適用於全球化應用情境。有關更多詳細資料,請參閱部落格、GitHub和文檔。

vLLM

vLLM是一個高效、輕量的大型語言模型推理引擎,它採用創新的 PagedAttention 技術,高效管理KV緩衝,支援連續批處理、CUDA/HIP 圖加速、chunked prefill和Speculative decoding,顯著提升服務吞吐與響應速度。支援多種量化格式(如 GPTQ、AWQ、INT4/8、FP8)及 FlashAttention 等最佳化核心。vLLM 相容 Hugging Face和ModeScope模型,支援TP、PP、DP和EP並行,提供流式輸出和 OpenAI 相容 API。支援 NVIDIA、AMD、Intel 等多種硬體,覆蓋 Qwen、Deepseek、Llama、E5-Mistral等主流模型,廣泛應用於對話系統、內容產生、AI Agent 等情境,是構建大模型應用的理想選擇。更多關於vLLM架構的資訊,請參見vLLM GitHub。

SGLang

SGLang 是一個高效能的大型語言模型與多模態模型服務推理引擎,通過前後端協同設計,提升模型互動速度與控制能力。其後端支援 RadixAttention(首碼緩衝)、零開銷 CPU 調度、PD分離、Speculative decoding、連續批處理、PagedAttention、TP/DP/PP/EP並行、結構化輸出、chunked prefill及多種量化技術(FP8/INT4/AWQ/GPTQ)和多LoRA批處理,顯著提升推理效率。前端提供靈活編程介面,支援鏈式產生、進階提示、控制流程、多模態輸入、平行處理和外部互動,便於構建複雜應用。支援 Qwen、DeepSeek、Llama等產生模型,E5-Mistral等嵌入模型以及 Skywork 等獎勵模型,易於擴充新模型。更多關於SGLang推理引擎的資訊,請參見SGLang GitHub。

多機分布式部署

LLM模型參數越來越大,單個GPU卡無法載入全部模型,需要通過各種並行策略,將一個龐大而緩慢的LLM推理任務,拆分成多個子任務,分配給多個計算單元(GPU),然後將結果高效地匯總起來,從而快速地完成LLM推理任務。常見的並行策略有如下四種。

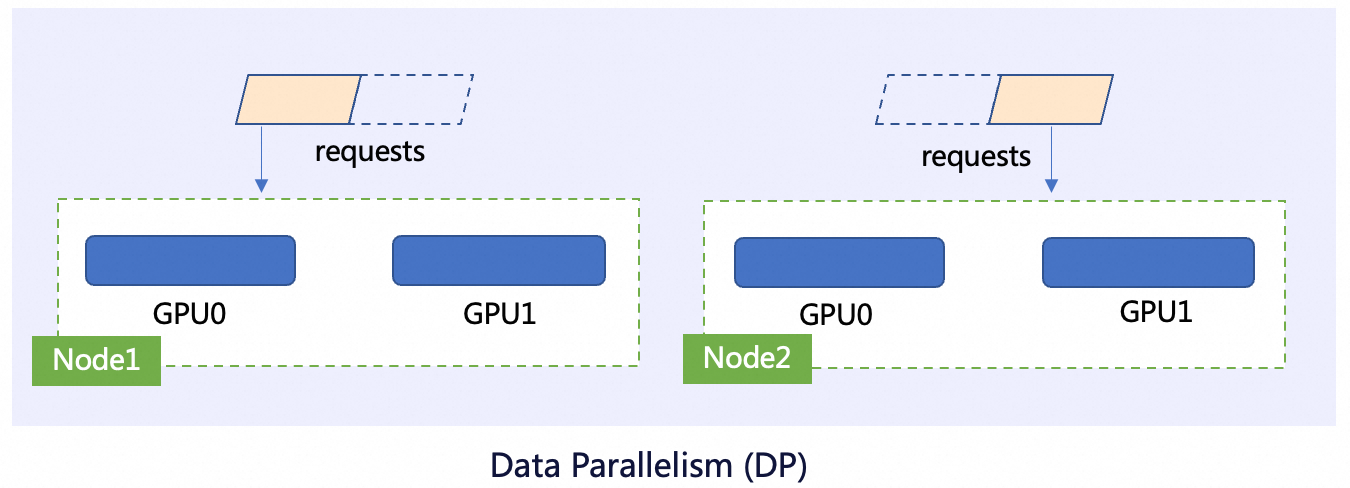

資料並行(Data Parallelism, DP)

其核心思想是每個GPU上都有一套完整的模型副本,但處理不同的資料。這是最簡單、最常見的並行方式。

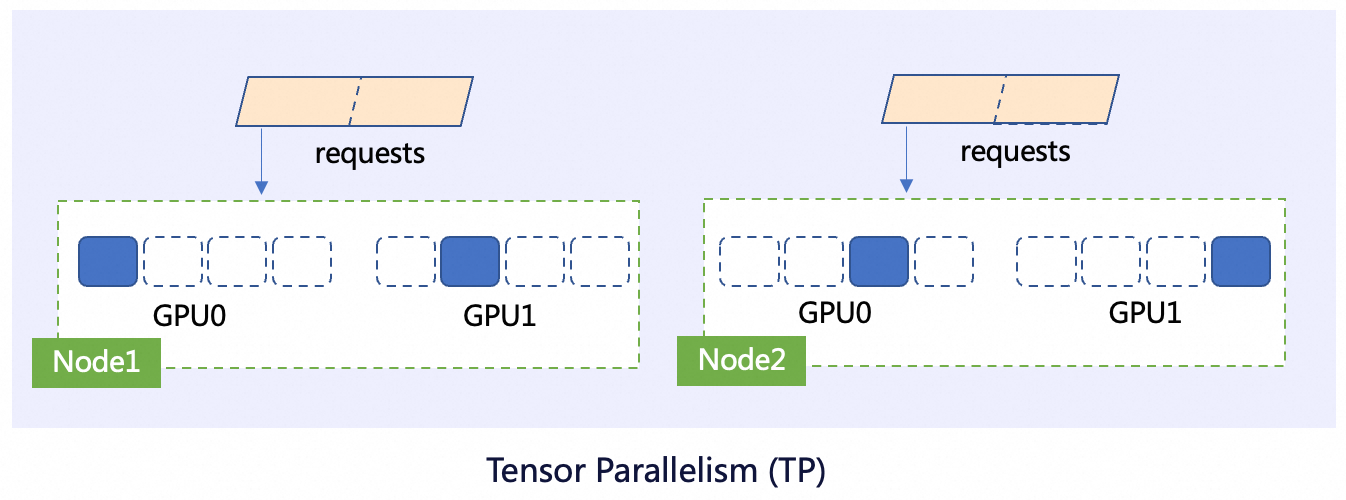

張量並行(Tensor Parallelism, TP)

其核心思想是把模型權重切分開,讓每個GPU只載入並計算一部分權重。

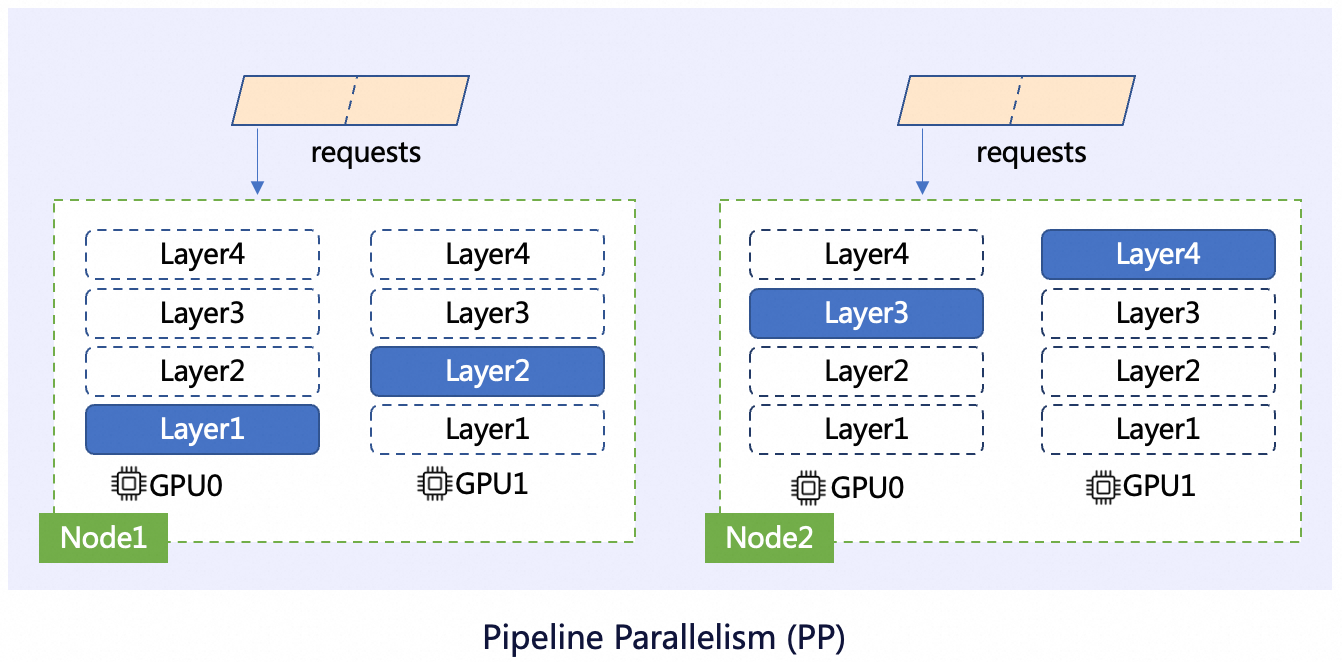

流水線並行(Pipeline Parallelism, PP)

其核心思想是像工廠流水線一樣,把模型的“層”分配給不同的GPU。每個GPU負責計算一部分的模型層,並將計算的中間結果傳遞給下一個GPU。

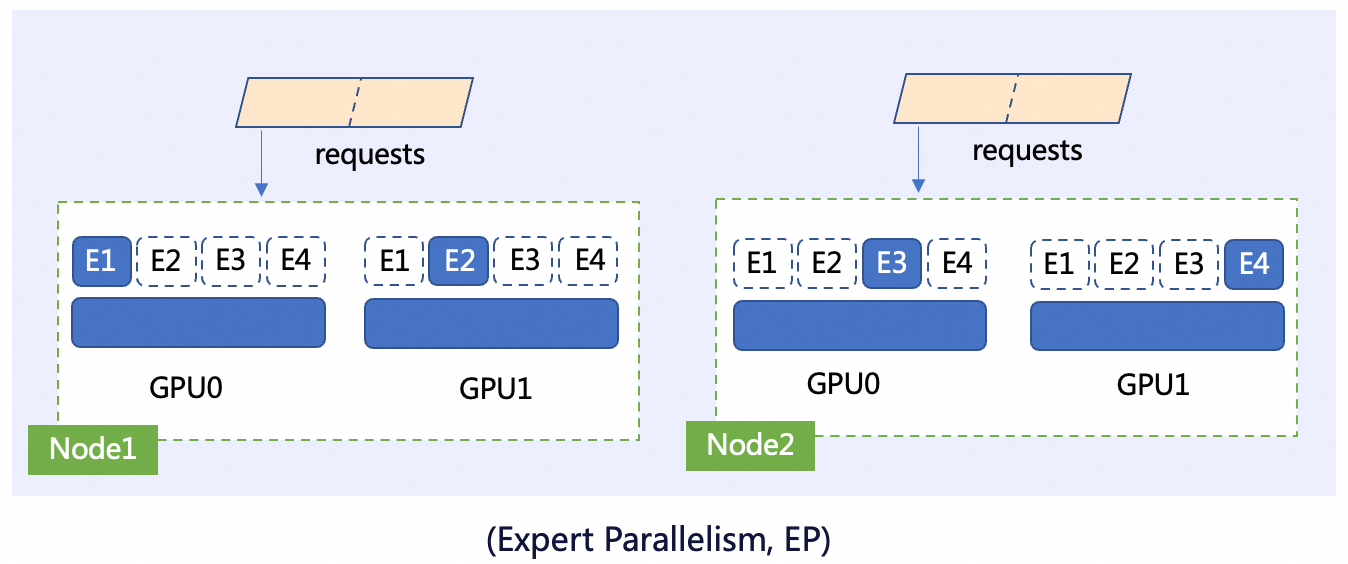

專家並行(Expert Parallelism, EP)

MoE(Mixture-of-Experts)架構的模型中包含很多專家模型,每次只啟用其中一部分專家來處理。因此可以將這些專家模型存放在不同的GPU上。當推理計算需要用到某個專家時,資料會被路由到對應的GPU上。

前提條件

已建立ACK叢集且叢集版本為1.28及以上,並且已經為叢集添加GPU節點。具體操作,請參見建立ACK託管叢集,及為叢集添加GPU節點。

本文要求叢集中至少有兩個GPU節點,且單GPU節點顯存需大於32GB,推薦使用ecs.gn8is.4xlarge規格,更多規格資訊可參考GPU計算型執行個體規格類型系列gn8is。

已安裝LeaderWorkerSet組件,組件版本大於等於v0.6.0,組件安裝步驟如下。

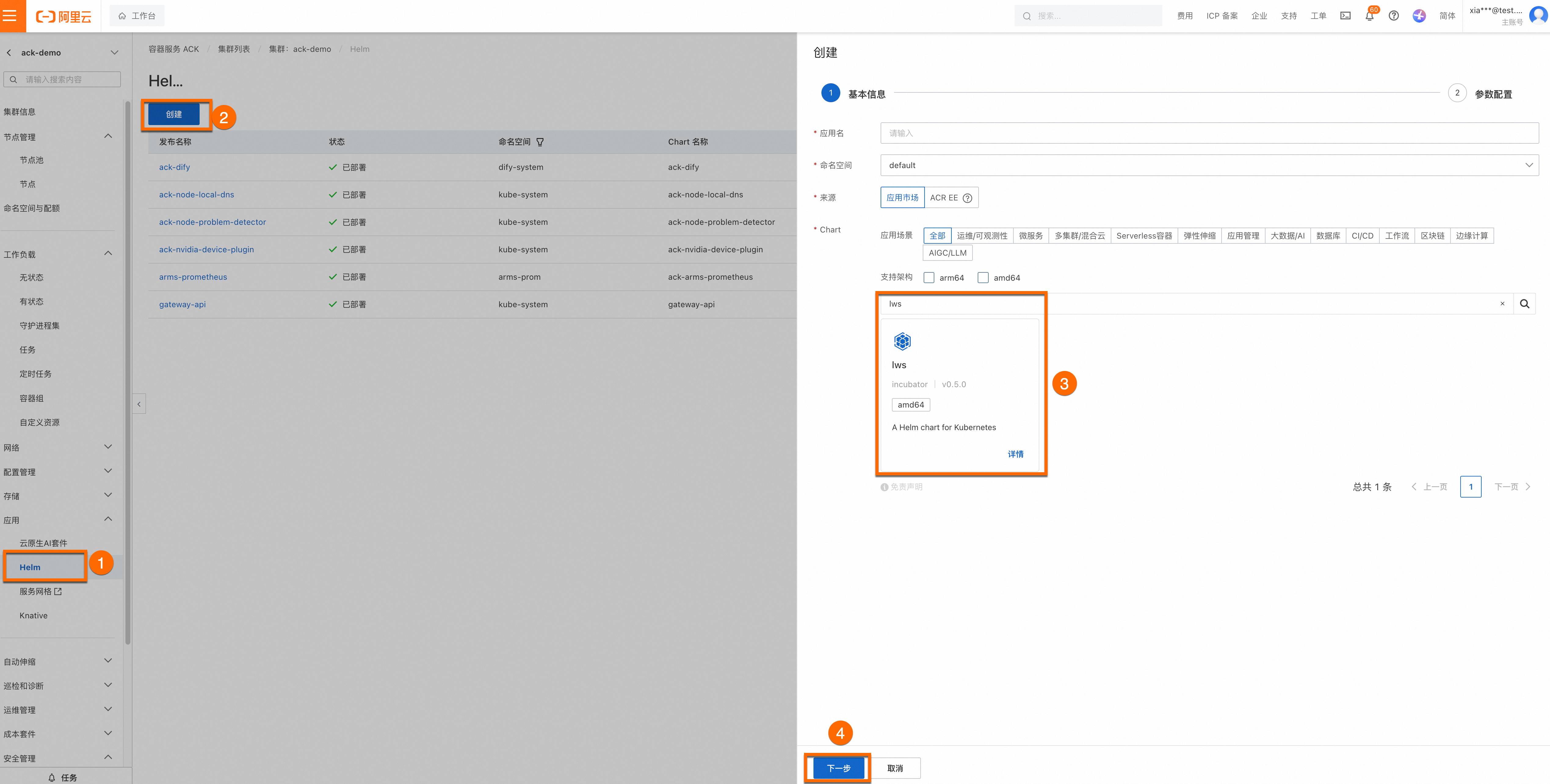

登入Container Service管理主控台,在左側導覽列選擇叢集列表。單擊目的地組群名稱,進入叢集詳情頁面,使用Helm為目的地組群安裝lws。您無需為組件配置應用程式名稱和命名空間,單擊下一步後會出現一個請確認的彈框,單擊是,即可使用預設的應用程式名稱(lws)和命名空間(lws-system)。然後選擇Chart 版本為最新版本,單擊確定即可完成lws的安裝。

模型部署

步驟一:準備Qwen3-32B模型檔案

執行以下命令從ModelScope下載Qwen-32B模型。

請確認是否已安裝git-lfs外掛程式,如未安裝可執行

yum install git-lfs或者apt-get install git-lfs安裝。更多的安裝方式,請參見安裝git-lfs。git lfs install GIT_LFS_SKIP_SMUDGE=1 git clone https://www.modelscope.cn/Qwen/Qwen3-32B.git cd Qwen3-32B/ git lfs pull登入OSS控制台,查看並記錄已建立的Bucket名稱。如何建立Bucket,請參見建立儲存空間。在OSS中建立目錄,將模型上傳至OSS。

關於ossutil工具的安裝和使用方法,請參見安裝ossutil。

ossutil mkdir oss://<your-bucket-name>/Qwen3-32B ossutil cp -r ./Qwen3-32B oss://<your-bucket-name>/Qwen3-32B建立PV和PVC。為目的地組群配置名為

llm-model的儲存卷PV和儲存聲明PVC。具體操作,請參見建立PV和PVC。控制台操作樣本

建立PV。

登入Container Service管理主控台,在左側導覽列選擇叢集列表。

在叢集列表頁面,單擊目的地組群名稱,然後在左側導覽列,選擇。

在儲存卷頁面,單擊右上方的建立。

在建立儲存卷對話方塊中配置參數。

以下為樣本PV的基本配置資訊:

配置項

說明

儲存卷類型

OSS

名稱

llm-model

訪問認證

配置用於訪問OSS的AccessKey ID和AccessKey Secret。

Bucket ID

選擇上一步所建立的OSS Bucket。

OSS Path

選擇模型所在的路徑,如

/Qwen3-32B。

建立PVC。

在叢集列表頁面,單擊目的地組群名稱,然後在左側導覽列,選擇。

在儲存聲明頁面,單擊右上方的建立。

在建立儲存聲明頁面中,填寫介面參數。

以下為樣本PVC的基本配置資訊:

配置項

說明

儲存宣告類型

OSS

名稱

llm-model

分配模式

選擇已有儲存卷。

已有儲存卷

單擊選擇已有儲存卷連結,選擇已建立的儲存卷PV。

kubectl操作樣本

建立

llm-model.yaml檔案,該YAML檔案包含Secret、靜態卷PV、靜態卷PVC等配置,樣本YAML檔案如下所示。apiVersion: v1 kind: Secret metadata: name: oss-secret stringData: akId: <your-oss-ak> # 配置用於訪問OSS的AccessKey ID akSecret: <your-oss-sk> # 配置用於訪問OSS的AccessKey Secret --- apiVersion: v1 kind: PersistentVolume metadata: name: llm-model labels: alicloud-pvname: llm-model spec: capacity: storage: 30Gi accessModes: - ReadOnlyMany persistentVolumeReclaimPolicy: Retain csi: driver: ossplugin.csi.alibabacloud.com volumeHandle: llm-model nodePublishSecretRef: name: oss-secret namespace: default volumeAttributes: bucket: <your-bucket-name> # bucket名稱 url: <your-bucket-endpoint> # Endpoint資訊,如oss-cn-hangzhou-internal.aliyuncs.com otherOpts: "-o umask=022 -o max_stat_cache_size=0 -o allow_other" path: <your-model-path> # 本樣本中為/Qwen3-32B/ --- apiVersion: v1 kind: PersistentVolumeClaim metadata: name: llm-model spec: accessModes: - ReadOnlyMany resources: requests: storage: 30Gi selector: matchLabels: alicloud-pvname: llm-model建立Secret、建立靜態卷PV、建立靜態卷PVC。

kubectl create -f llm-model.yaml

步驟二:部署推理服務

本文使用LeaderWorkerSet作為工作負載,採用TP=2的並行策略,在兩個GPU節點上部署分布式推理服務。

vLLM架構部署多機推理服務

建立

vllm_multi.yaml檔案。使用vLLM架構部署多機LLM推理服務。

kubectl create -f vllm_multi.yaml

SGLang架構部署多機推理服務

建立

sglang_multi.yaml檔案。使用SGLang架構部署多機LLM推理服務。

kubectl create -f sglang_multi.yaml

步驟三:驗證推理服務

執行以下命令,在推理服務與本地環境之間建立連接埠轉寄。

重要kubectl port-forward建立的連接埠轉寄不具備生產層級的可靠性、安全性和擴充性,因此僅適用於開發和調試目的,不適合在生產環境使用。更多關於Kubernetes叢集內生產可用的網路方案的資訊,請參見Ingress管理。kubectl port-forward svc/multi-nodes-service 8000:8000預期輸出:

Forwarding from 127.0.0.1:8000 -> 8000 Forwarding from [::1]:8000 -> 8000執行以下命令,向模型推理服務發送了一條樣本的模型推理請求。

curl http://localhost:8000/v1/chat/completions -H "Content-Type: application/json" -d '{"model": "/models/Qwen3-32B", "messages": [{"role": "user", "content": "測試一下"}], "max_tokens": 30, "temperature": 0.7, "top_p": 0.9, "seed": 10}'預期輸出:

{"id":"chatcmpl-ee6b347a8bd049f9a502669db0817938","object":"chat.completion","created":1753685847,"model":"/models/Qwen3-32B","choices":[{"index":0,"message":{"role":"assistant","reasoning_content":null,"content":"<think>\n好的,使用者發來“測試一下”,我需要先確認他們的需求。可能是在測試我的功能,或者想看看我的反應。","tool_calls":[]},"logprobs":null,"finish_reason":"length","stop_reason":null}],"usage":{"prompt_tokens":10,"total_tokens":40,"completion_tokens":30,"prompt_tokens_details":null},"prompt_logprobs":null,"kv_transfer_params":null}輸出結果表明模型可以根據給定的輸入(在這個例子中是一條測試訊息)產生相應的回複。