モデル圧縮は、予測精度を維持することを目的として、さまざまな戦略を通じて機械学習モデルのサイズと計算の複雑さを最小限に抑える手法です。 これは、ディープラーニングモデルの複雑さとサイズが大きくなるにつれて、特にリソースが限られている環境では、モデルの圧縮によりストレージとコンピューティングリソースの使用量が大幅に削減されるため、ますます重要になります。

概要

AI用プラットフォームのモデルギャラリー (PAI) は、重みのみの量子化技術を使用したモデル量子化を提供します。 モデルの浮動小数点パラメータを8ビットまたは4ビットの整数に変換する、MinMax-8BitおよびMinMax-4Bitの量子化戦略をサポートします。 このアプローチは、モデルのサイズと計算の複雑さを減らし、堅牢なパフォーマンスを維持しながら、リソースが限られている環境でのディープラーニングモデルの効率的な展開を容易にすることを目的としています。

モデルの圧縮

モデルを訓練します。

モデルを圧縮するには、まずトレーニングする必要があります。 詳細については、「鉄道モデル」をご参照ください。

モデルをトレーニングした後、ジョブの詳細ページの右上隅にある [圧縮] をクリックします。

圧縮タスクを設定します。

次の表に、主要なパラメーターを示します。

パラメーター

説明

圧縮方法

重みのみの量子化技術に基づくモデル量子化のみがサポートされています。 この技法は、モデルの重みパラメータを低減されたビット幅に変換し、それによって、推論中のビデオメモリ要件を低減します。

圧縮戦略

MinMax-8Bit: min-maxスケーリングを使用して、モデルを8ビット整数形式に量子化します。

MinMax-4Bit: min-maxスケーリングを使用して、モデルを4ビット整数形式に量子化します。

その他のパラメーターについては、「トレーニングモデル」をご参照ください。

[圧縮] をクリックします。

画面の指示に従って [タスクの詳細] ページに移動し、圧縮タスクの基本情報、リアルタイムステータス、タスクログ、その他の詳細を表示できます。

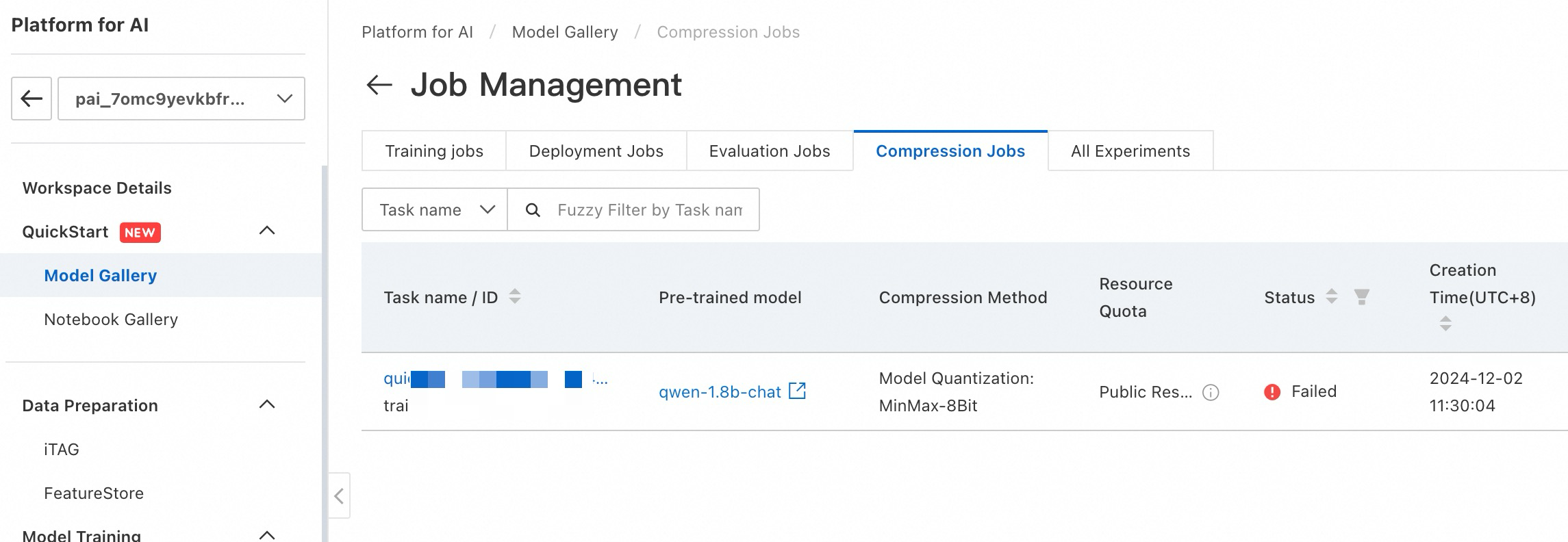

圧縮タスクの表示

圧縮タスクを表示するには、モデルギャラリー > ジョブ管理 > 圧縮ジョブに移動します。