モデルギャラリーでは、PAI を使用したモデルのトレーニングとデプロイメントをすぐに開始できるように、さまざまな事前学習済みモデルを提供しています。このトピックでは、モデルギャラリーでビジネスニーズに合ったモデルを見つけ、デプロイメント、デバッグ、ファインチューニングを行う方法について説明します。

前提条件

ファインチューニングまたは増分トレーニングを実行する前に、OSS バケットを作成します。詳細については、「コンソールでのバケットの作成」をご参照ください。

料金

モデルギャラリーは無料です。ただし、モデルのデプロイメントとトレーニングには、Elastic Algorithm Service (EAS) と Deep Learning Containers (DLC) の料金が発生します。詳細については、「EAS の課金」および「DLC の課金」をご参照ください。

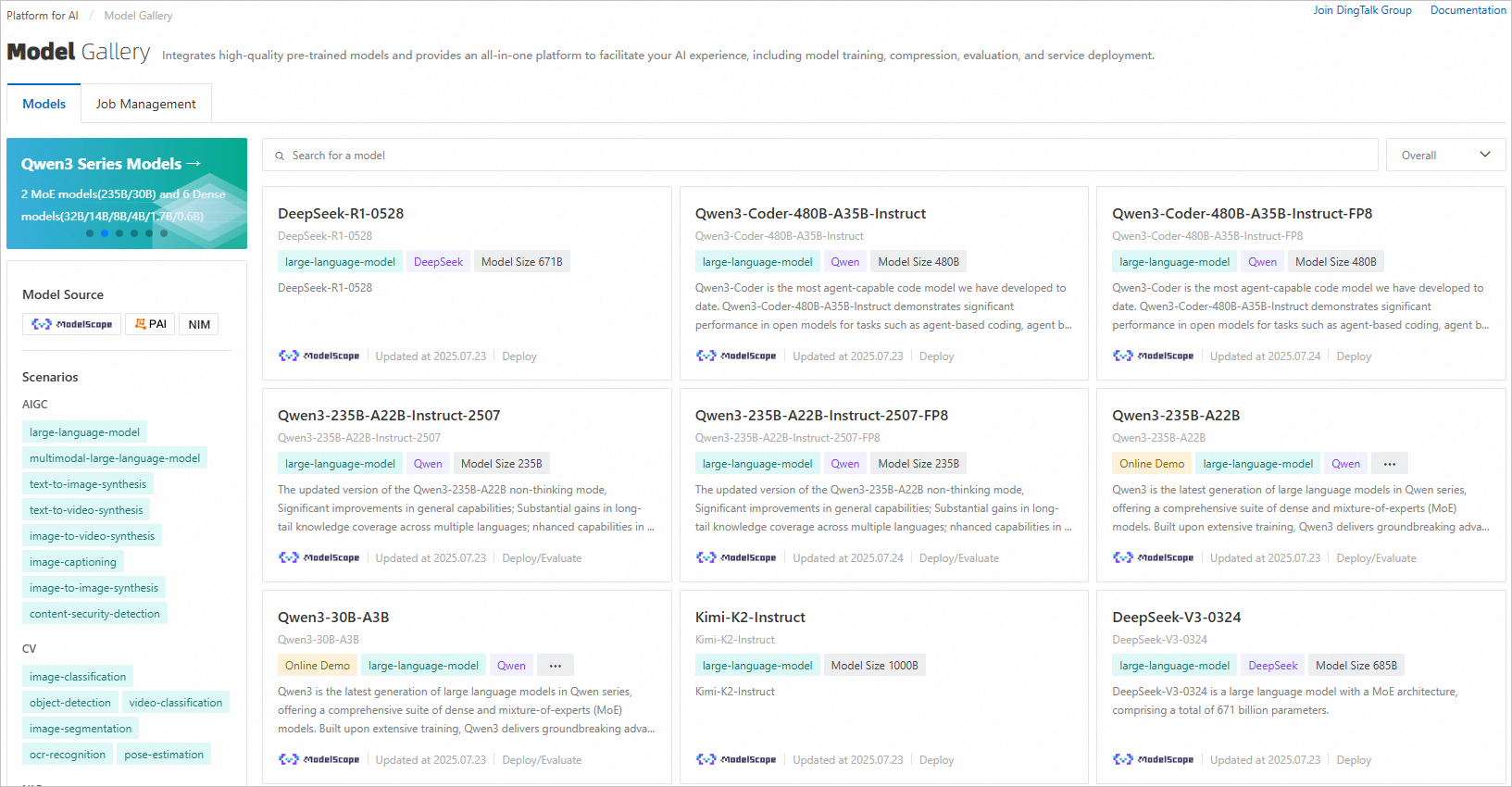

ビジネスに適したモデルの検索

モデルギャラリーでは、実際のシナリオでビジネス上の問題を解決するのに役立つさまざまなモデルを提供しています。以下のガイダンスに従って、ビジネスに最適なモデルをすばやく見つけます。

必要なドメインとタスクに基づいてモデルを検索します。

ほとんどのモデルには、使用された事前学習済みデータセットが示されています。事前学習済みデータセットが実際のユースケースに近いほど、直接デプロイメントやファインチューニングの結果が向上します。モデルの事前学習済みデータセットに関する詳細は、モデル詳細ページで確認できます。

一般的に、パラメーターが多いモデルほどパフォーマンスは向上します。ただし、モデルサービスの実行コストが高くなり、ファインチューニングに必要なデータも多くなります。

モデルを検索するには、次のステップを実行します。

モデルギャラリーページに移動します。

PAI コンソールにログインします。

左側のナビゲーションウィンドウで Workspaces をクリックします。ワークスペースリストページで、ご利用のワークスペースの名前をクリックしてワークスペースに入ります。

左側のナビゲーションウィンドウで、QuickStart > Model Gallery をクリックします。モデルギャラリーページが開きます。

ビジネスに適したモデルを検索します。

次に、選択したモデルを直接デプロイし、オンラインでデバッグしてモデルの推論結果を検証します。詳細については、「モデルのデプロイメントとデバッグ」をご参照ください。

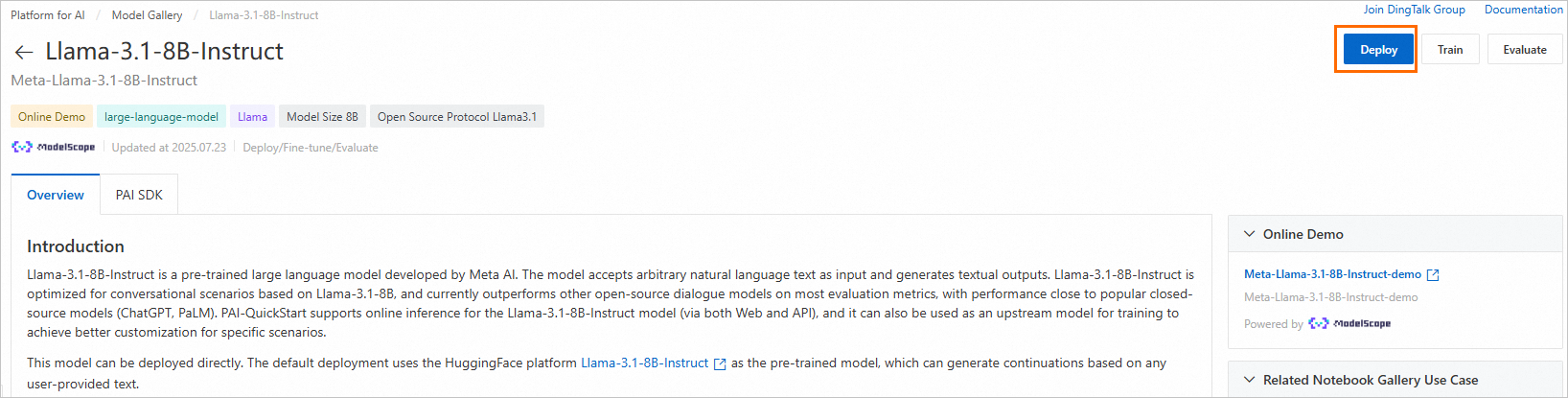

モデルのデプロイメントとデバッグ

Llama-3.1-8B-Instruct モデルを例に説明します。適切なモデルを見つけたら、そのモデルカードをクリックしてモデル詳細ページに移動し、モデルのデプロイメントとデバッグを行います。

モデルサービスの直接デプロイメント

モデル詳細ページで、Deploy をクリックします。

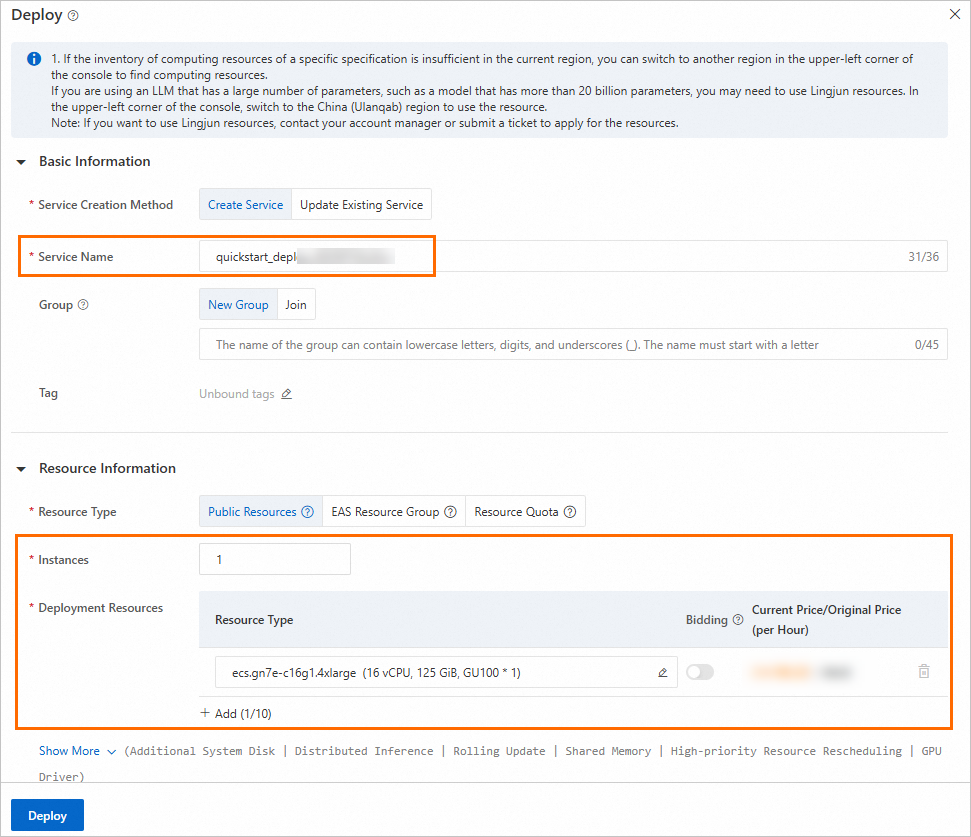

(任意) モデルサービス情報とリソースデプロイメント情報を設定します。

モデルギャラリーでは、モデルの特性に基づいて、各モデルのデプロイメント用に [基本情報] と [リソース情報] が事前設定されています。デフォルト設定を使用するか、必要に応じて変更します。

パラメーター

説明

Service Name

「Basic Information」セクションでは、サービス名がデフォルトで設定されており、画面上のプロンプトに従って変更することもできます。これにより、同一リージョン内で一意になることが保証されます。

Resource Type

「Resource Information」エリアでは、パブリックリソース、専用リソース、またはリソースクォータを使用できます。

Deployment Resources

「Resource Information」エリアでは、リソース仕様がデフォルトで事前に構成されています。デフォルトの構成を使用するか、別のリソース仕様を選択できます(選択した仕様の計算能力は、デフォルト構成の計算能力よりも高いことを推奨します。そうでないと、マシンのパフォーマンスが不十分になる可能性があります)。

モデルデプロイメント詳細ページの下部で、Deploy をクリックします。ポップアップ表示される Billing Notification ダイアログボックスで、OK をクリックします。

ページは自動的に Service details ページにリダイレクトされます。このページで、サービスの Basic Information と Resource Information を表示します。Status が In operation に変わると、サービスのデプロイメントは成功です。

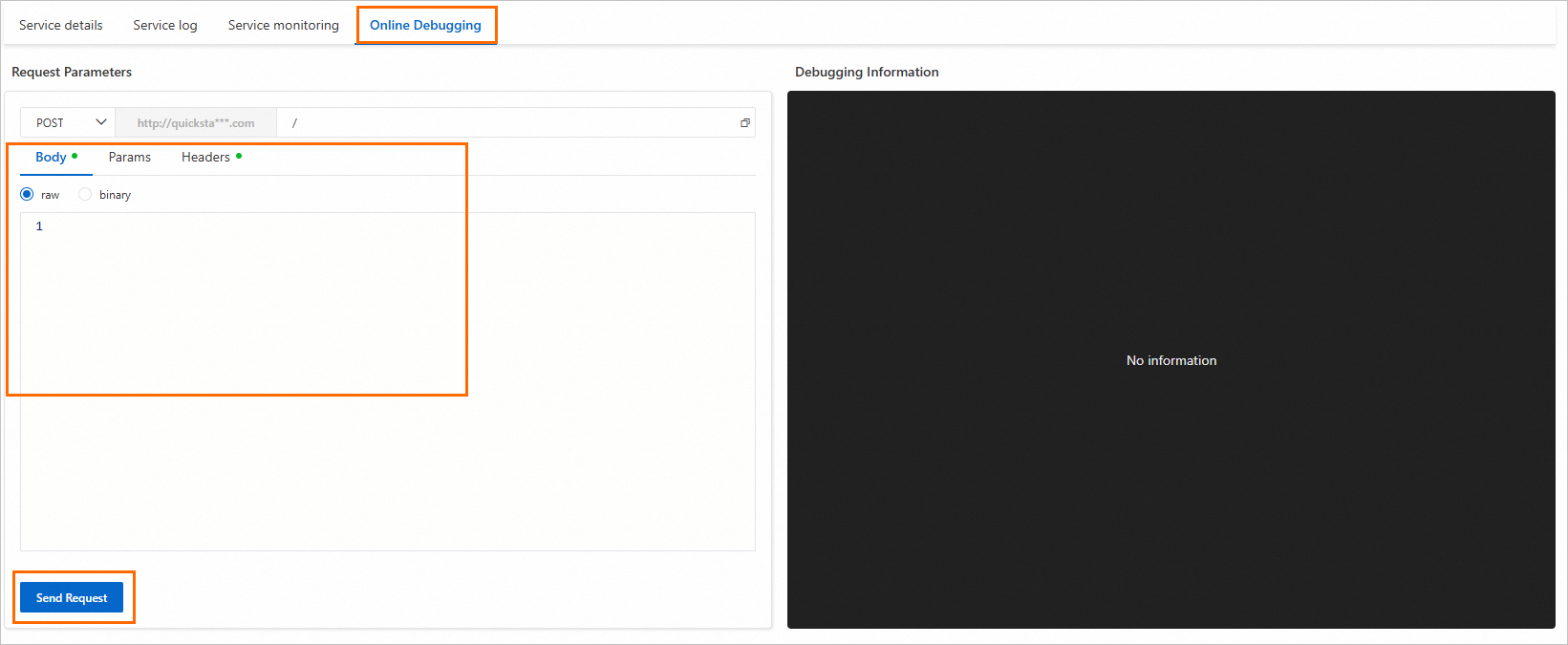

モデルサービスのオンラインデバッグ

Online Debugging タブに切り替えます。[本文] の下にある編集ボックスにリクエストデータを入力します。Send Request をクリックします。下に表示される応答に基づいて、モデルサービスの推論結果を検証します。

大規模言語モデル (LLM) サービスのオンラインデバッグは、対話形式のインターフェイス操作もサポートしています。

モデルドキュメントで指定されたデータ入力フォーマットに従ってリクエストデータを構築します。一部のモデル (Stable Diffusion V1.5 など) は、[デプロイメントタスク詳細] ページの右上隅にある View Web App をクリックして WebUI アプリケーションを起動することをサポートしています。これにより、WebUI ページでモデルの推論をより簡単に検証できます。

事前学習済みデータセットが実際のビジネスシナリオと完全に一致しない場合、実際のアプリケーションでのモデルのパフォーマンスは理論上の期待と異なる可能性があります。モデルの予測結果がビジネスニーズを満たさない場合は、モデルをファインチューニングして、特定のアプリケーションシナリオにより適したモデルを取得します。詳細については、「モデルのトレーニング」をご参照ください。

モデルのトレーニング

PAI で独自のデータセットを使用して、事前学習済みモデルをファインチューニングします。Llama-3.1-8B-Instruct モデルを例に、次のステップを実行します。

モデル詳細ページで、Fine-tune をクリックします。

ファインチューニングトレーニング詳細ページで、次のパラメーターを設定します。

説明モデルによってサポートされるパラメーターが異なる場合があります。特定のモデルに基づいて設定してください。

パラメータータイプ

パラメーター

説明

Training Mode

SFT 教師ありファインチューニング

サポートされているトレーニングメソッド:

教師ありファインチューニング:LLM の入力と出力を指定して、大規模言語モデル (LLM) のパラメーターをファインチューニングします。

直接プリファレンス最適化:人間のプリファレンスに合わせて言語モデルを直接最適化します。これは RLHF アルゴリズムと同じ最適化目標を意味します。

どちらのトレーニングメソッドも、全パラメーターファインチューニング、LoRA、および QLoRA を使用したファインチューニングをサポートしています。

[DPO 直接プリファレンス最適化]

Job Configuration

Task name

タスク名は事前設定されています。プロンプトに従ってタスク名を変更します。

Maximum running time

タスク実行の最大時間を設定します。設定後、タスクがこの時間を超えて実行された場合、タスクは戻って停止します。

デフォルト設定を維持する場合、タスクの実行時間はこのパラメーターによって制限されません。

Dataset Configuration

Training dataset

モデルギャラリーはデフォルトのトレーニングデータを提供します。デフォルトのデータセットを使用しない場合は、モデルドキュメントのトレーニングデータ形式に従ってトレーニングデータを準備します。次に、次の 2 つのメソッドのいずれかを使用してトレーニングデータをアップロードします。

OSS file or directory

をクリックし、データセットが配置されている OSS パスを選択します。Select OSS folder or file ダイアログボックスで、既存のデータファイルを選択するか、Upload file を選択します。

をクリックし、データセットが配置されている OSS パスを選択します。Select OSS folder or file ダイアログボックスで、既存のデータファイルを選択するか、Upload file を選択します。Custom Dataset

OSS などのクラウドストレージからデータセットを選択します。

をクリックして既存のデータセットを選択します。データセットが存在しない場合は、「データセットの作成と管理」ドキュメントを参照して作成します。

をクリックして既存のデータセットを選択します。データセットが存在しない場合は、「データセットの作成と管理」ドキュメントを参照して作成します。

Validate dataset

Add validation dataset をクリックして追加します。Training dataset と同じ方法で検証データセットを設定します。

Output Configuration

トレーニング済みモデルと TensorBoard ログファイルを保存するための出力クラウドストレージパスを選択します。

説明ワークスペース詳細ページでワークスペースのデフォルトの OSS ストレージパスを設定した場合、このパスは自動的に入力されます。手動での設定は不要です。ワークスペースのストレージパスの設定方法については、「ワークスペースの管理」をご参照ください。

Computing Resources

Resource Type

[一般コンピューティング] と [Lingjun インテリジェントコンピューティング] をサポートします。

Source

Public Resources:

課金モード:従量課金。

シナリオ:パブリックリソースではキューイング遅延が発生する可能性があります。そのため、データ量が比較的小さく、時間的制約が低いタスクに使用します。

Resource Quota:一般コンピューティングリソースまたは Lingjun リソースが含まれます。

課金モード:サブスクリプション。

シナリオ:データ量が比較的大きく、実行保証要件が高いタスクに使用します。

Preemptible Resources:

課金モード:従量課金。

シナリオ:リソースコストを削減したい場合は、通常大幅な割引が提供されるプリエンプティブルリソースを使用します。

制限:安定した可用性は保証されません。プリエンプティブルリソースはすぐに利用できない場合や、回収される場合があります。詳細については、「プリエンプティブルタスクの使用」をご参照ください。

Hyperparameters

設定できるハイパーパラメーターはモデルによって異なります。デフォルト値を使用するか、必要に応じてパラメーター設定を変更できます。

Fine-tune をクリックします。

ページは自動的に Task details ページにリダイレクトされます。トレーニングタスクの基本情報、リアルタイムステータス、タスクログ、モニタリング情報を表示します。

説明トレーニング済みのモデルは、AI アセット - モデル管理に自動的に登録されます。対応するモデルを表示またはデプロイできます。詳細については、「モデルの登録と管理」をご参照ください。