PAI 上で Llama2 シリーズの大規模言語モデルをゼロコードでトレーニングおよび推論を実行するには、QuickStart を使用してワンクリックでデプロイできます。これにより、Llama2 シリーズモデルのオンライン推論サービスを迅速に起動し、WebUI または API を使用して呼び出すことができます。また、独自のデータセットを使用して、カスタマイズされたシナリオやタスクのために事前学習済みモデルをファインチューニングすることもできます。

背景情報

Llama2 は、Meta が開発したオープンソースの英語中心の事前学習済み大規模言語モデルです。任意の自然言語テキストを入力として受け取り、テキストを出力として生成します。Llama2 モデルのパラメーターサイズは 70 億から 700 億の範囲で、7b、13b、70b のバージョンがあります。各バージョンには、会話シナリオに特化して最適化されたモデルである Llama2-chat もあります。QuickStart は、Llama2 シリーズモデルのオンライン推論をサポートしています。これらのモデルは、カスタマイズされたシナリオでより良い結果を達成するためのトレーニングの上流モデルとしても使用できます。

QuickStart で提供される llama-2-7b-chat モデルは、Hugging Face の Llama-2-7b-chat モデルをソースとしています。これは主に Transformer アーキテクチャに基づいた大規模言語モデルであり、複数のオープンソースデータセットのミックスでトレーニングされています。そのため、ほとんどの汎用的な英語シナリオに適しています。

このトピックでは、llama-2-7b-chat モデルを例として、QuickStart を使用してモデルを Elastic Algorithm Service (EAS) にデプロイし、推論サービスを作成して呼び出す方法について説明します。

制限事項

現在、QuickStart は、中国 (北京)、中国 (上海)、中国 (杭州)、中国 (深圳)、中国 (ウランチャブ) のリージョンで利用できます。

中国 (ウランチャブ) リージョンを有効にするには、ビジネス マネージャーにお問い合わせください。

費用

OSS ストレージの使用には料金がかかります。詳細については、「OSS の課金の概要」をご参照ください。

QuickStart は無料です。ただし、QuickStart を使用してモデルをデプロイおよびトレーニングする場合、モデルのデプロイ (EAS) とタスクのトレーニング (Deep Learning Containers (DLC)) に料金がかかります。詳細については、「Elastic Algorithm Service (EAS) の課金」および「Deep Learning Containers (DLC) の課金」をご参照ください。

前提条件

PAI が有効化され、Elastic Algorithm Service (EAS) と Deep Learning Containers (DLC) が有効になっています。デフォルトのワークスペースが作成されています。詳細については、「PAI の有効化とデフォルトワークスペースの作成」をご参照ください。

- 説明

バケットのリージョンは PAI のリージョンと同じである必要があります。バケットを作成した後、そのリージョンを変更することはできません。

Llama モデルのカスタム商用利用可能なオープンソースライセンスを読み、同意していること。

説明ページにアクセスできない場合は、プロキシを設定して再試行する必要がある場合があります。

手順

llama-2-7b-chat モデルは、ほとんどの非専門的なシナリオに適しています。直接モデルをデプロイした結果がビジネス要件を満たさない場合、またはドメイン固有の知識を適用するには、モデルをファインチューニングできます。これにより、カスタムドメインでのモデルの能力が向上し、実際のビジネスニーズにより適したものになります。

大規模言語モデルは、会話中に比較的単純な知識を直接学習できます。ニーズに応じてモデルをトレーニングするかどうかを決定できます。現在 QuickStart でサポートされているトレーニング方法は、LoRA に基づいています。Supervised Fine-Tuning (SFT) などの他のトレーニング方法と比較して、LoRA トレーニングはトレーニングコストと時間を大幅に削減します。

モデルを直接デプロイする

モデルギャラリーページに移動します。

PAI コンソールにログインします。

左側のナビゲーションウィンドウで、ワークスペースリストをクリックします。ワークスペースリストページで、管理するワークスペースの名前をクリックします。

左側のナビゲーションウィンドウで、[QuickStart] > [モデルギャラリー] をクリックします。

右側のモデルリストの検索ボックスに llama-2-7b-chat と入力し、Enter キーを押します。

説明必要に応じて他のモデルを選択することもできます。モデルには少なくとも 64 GiB のメモリと 24 GiB 以上のビデオメモリが必要です。選択した計算リソースがこれらの要件を満たしていることを確認してください。そうでない場合、デプロイが失敗する可能性があります。

[llama-2-7b-chat] モデルカードをクリックしてモデル詳細ページを開きます。右上隅にある [デプロイ] をクリックします。

デプロイページの下部で、[デプロイ] をクリックします。

表示される [課金リマインダー] ダイアログボックスで、[OK] をクリックします。

ページは自動的に [サービス詳細] ページにリダイレクトされます。サービスの [ステータス] が [実行中] に変わると、推論サービスは正常にデプロイされます。

サービスがデプロイされた後、WebUI または API を使用して呼び出すことができます。

[サービス詳細] ページの右上隅にある [WEB アプリの表示] をクリックします。

推論サービスを呼び出します。

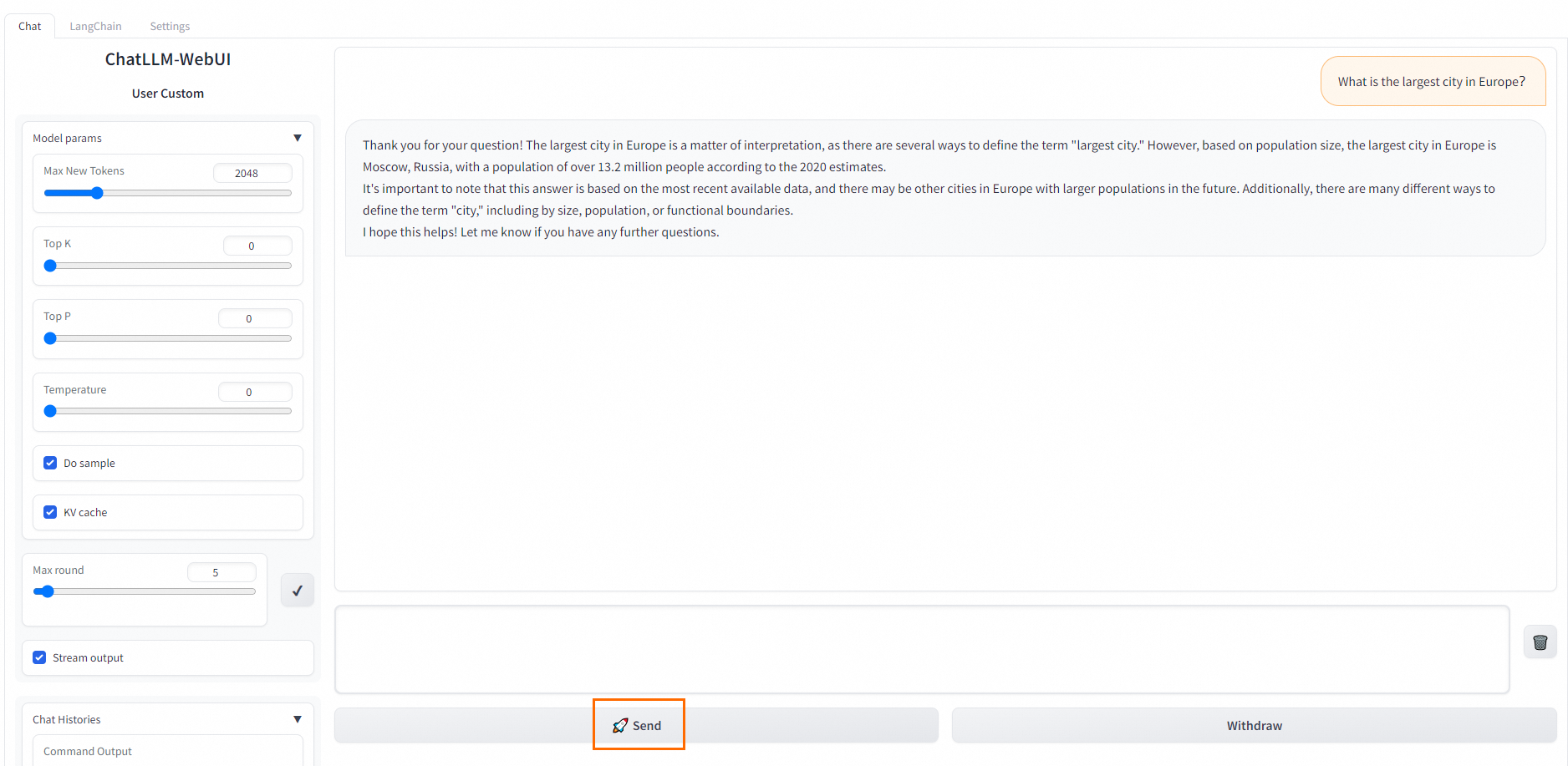

WebUI: [チャット] タブで、ダイアログボックスに会話内容を入力し、[送信] をクリックして会話を開始します。

API: WebUI ページの下部にある [API 経由で使用] をクリックして、API 呼び出しの詳細を表示します。

モデルのファインチューニング

モデルギャラリーページに移動します。

PAI コンソールにログインします。

左側のナビゲーションウィンドウで、ワークスペースリストをクリックします。ワークスペースリストページで、管理するワークスペースの名前をクリックします。

左側のナビゲーションウィンドウで、[QuickStart] > [モデルギャラリー] をクリックします。

右側のモデルリストの検索ボックスに llama-2-7b-chat と入力し、Enter キーを押します。

説明必要に応じて他のモデルを選択することもできます。モデルには少なくとも 64 GiB のメモリと 24 GiB 以上のビデオメモリが必要です。選択した計算リソースがこれらの要件を満たしていることを確認してください。そうでない場合、デプロイが失敗する可能性があります。

[llama-2-7b-chat] モデルカードをクリックしてモデル詳細ページを開き、[トレーニング] をクリックします。

モデルトレーニングのパラメーターを設定します。

QuickStart は、[計算リソース設定] と [ハイパーパラメーター設定] のデフォルト設定を提供しており、ほとんどの使用シナリオに対応しています。必要に応じて変更することもできます。次の表に、このチュートリアルで設定する必要がある主要なパラメーターを示します。

パラメーター

説明

出力設定

モデル出力パス

トレーニング中に生成されたモデルファイルを保存する OSS バケットパスを選択します。

説明ワークスペース詳細ページでワークスペースのストレージパスを設定している場合、このパスは自動的に入力されるため、手動で設定する必要はありません。ワークスペースのストレージパスの設定方法の詳細については、「ワークスペースの管理」をご参照ください。

データセット設定

トレーニングデータセット

Llama2 モデルを試すために、QuickStart は直接使用できるデフォルトのトレーニングデータセットを提供しています。デフォルトのデータセットを使用しない場合は、モデルドキュメントで指定された形式でトレーニングデータを準備し、次の 2 つの方法のいずれかでトレーニングデータをアップロードする必要があります。

データセットの選択: パブリックデータセットとカスタムデータセットを使用できます。カスタムデータセットの作成方法の詳細については、「データセットの作成と管理」をご参照ください。

OSS ファイルまたはディレクトリ: OSS を介してデータをアップロードします。詳細については、「OSS の概要」をご参照ください。

トレーニングデータは JSON 形式である必要があります。各データ入力は、質問、回答、および ID で構成され、それぞれ

instruction、output、およびidフィールドで表されます。例:[ { "instruction": "Does the following text belong to the world topic? Why do Americans rarely hold military parades?", "output": "Yes", "id": 0 }, { "instruction": "Does the following text belong to the world topic? Breaking news! The timetable for vehicle reform in public institutions has been released!", "output": "No", "id": 1 } ]モデルトレーニングの効果をより良く検証するために、PAI が提供するトレーニングデータセットに加えて、検証データセットも準備することをお勧めします。このデータセットは、トレーニングプロセス中にモデルトレーニングの効果を評価し、トレーニングパラメーターを最適化するために使用されます。

[トレーニング] をクリックしてトレーニングジョブを送信します。

表示される [課金リマインダー] ダイアログボックスで、[OK] をクリックします。

ページは自動的に [ジョブ詳細] ページにリダイレクトされます。ジョブステータスが成功に変わると、モデルのトレーニングは完了です。

トレーニングされたモデルは OSS に保存されます。[基本情報] セクションの [出力パス] フィールドでその特定の場所を表示できます。

説明デフォルトのデータセット、ハイパーパラメーター、および計算リソース設定を使用する場合、トレーニングには約 1 時間 30 分かかります。カスタムトレーニングデータセットと設定項目を使用する場合、トレーニング時間は異なる場合がありますが、通常は数時間以内です。

ファインチューニングされたモデルをデプロイします。

ファインチューニングされたモデルのデプロイと呼び出しの手順は、モデルを直接デプロイする場合と同じです。詳細については、「モデルを直接デプロイする」をご参照ください。

次のステップ

QuickStart > モデルギャラリーページで、[ジョブ管理] ページに移動し、[トレーニングジョブ] タブと [デプロイメントジョブ] タブをクリックしてジョブの詳細を表示できます。