Anda dapat menggunakan layanan Data Integration di DataWorks untuk mengekspor data lengkap dari Tablestore ke OSS. Hal ini memungkinkan Anda mencadangkan data dengan biaya lebih rendah atau mengekspor data sebagai file ke mesin lokal. Setelah data lengkap diekspor ke OSS, Anda dapat mengunduh file tersebut ke mesin lokal untuk diproses lebih lanjut.

Prasyarat

Sebelum mengekspor data, pastikan prasyarat berikut terpenuhi:

Dapatkan nama instans, titik akhir, ID wilayah, dan informasi lainnya untuk tabel Tablestore sumber.

Buat AccessKey untuk akun Alibaba Cloud Anda atau pengguna Resource Access Management (RAM) yang memiliki izin untuk Tablestore dan OSS.

Aktifkan DataWorks dan buat ruang kerja di wilayah tempat bucket OSS atau instans Tablestore Anda berada.

Buat kelompok sumber daya Serverless dan sambungkan ke ruang kerja. Untuk informasi tentang penagihan, lihat Penagihan kelompok sumber daya Serverless.

Jika ruang kerja DataWorks dan instans Tablestore Anda berada di wilayah yang berbeda, Anda harus membuat koneksi peering VPC untuk mengaktifkan konektivitas jaringan lintas wilayah.

Prosedur

Ikuti langkah-langkah berikut untuk mengonfigurasi dan menjalankan tugas ekspor data.

Langkah 1: Tambahkan sumber data Tablestore

Pertama, konfigurasikan sumber data Tablestore di DataWorks untuk menghubungkan ke data sumber.

Masuk ke Konsol DataWorks. Alihkan ke wilayah tujuan. Di panel navigasi sebelah kiri, pilih . Dari daftar tarik-turun, pilih ruang kerja dan klik Go To Data Integration.

Di panel navigasi sebelah kiri, klik Data Source.

Di halaman Data Source List, klik Add Data Source.

Di kotak dialog Add Data Source, cari dan pilih Tablestore sebagai jenis sumber data.

Di kotak dialog Add OTS Data Source, konfigurasikan parameter sumber data seperti yang dijelaskan dalam tabel berikut.

Parameter

Deskripsi

Data Source Name

Nama sumber data harus merupakan kombinasi huruf, angka, dan garis bawah (_). Nama tidak boleh diawali dengan angka atau garis bawah (_).

Data Source Description

Deskripsi singkat tentang sumber data. Panjang deskripsi tidak boleh melebihi 80 karakter.

Region

Pilih wilayah tempat instans Tablestore berada.

Tablestore Instance Name

Nama instans Tablestore.

Endpoint

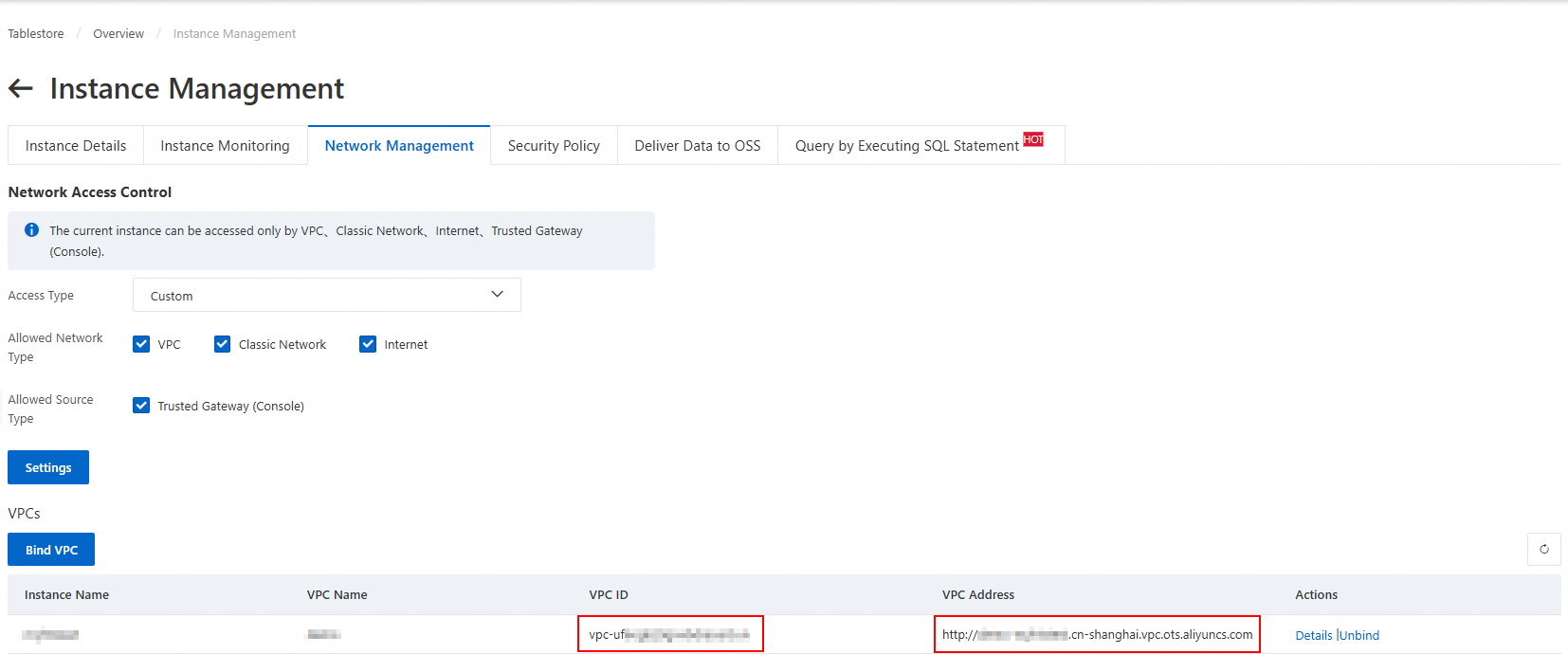

Titik akhir instans Tablestore. Gunakan titik akhir VPC.

AccessKey ID

ID AccessKey dan Rahasia AccessKey dari akun Alibaba Cloud atau pengguna RAM.

AccessKey Secret

Uji konektivitas kelompok sumber daya.

Saat membuat sumber data, Anda harus menguji konektivitas kelompok sumber daya untuk memastikan bahwa kelompok sumber daya untuk tugas sinkronisasi dapat terhubung ke sumber data. Jika tidak, tugas sinkronisasi data tidak dapat dijalankan.

Di bagian Connection Configuration, klik Test Connectivity di kolom Connectivity Status untuk kelompok sumber daya.

Setelah uji konektivitas berhasil, Connectivity Status berubah menjadi Connected. Klik Selesai. Sumber data baru muncul dalam daftar sumber data.

Jika uji konektivitas Fails, gunakan Connectivity Diagnostic Tool untuk memecahkan masalah.

Langkah 2: Tambahkan sumber data OSS

Konfigurasikan sumber data OSS sebagai tujuan ekspor data.

Klik lagi Add Data Source. Di kotak dialog, cari dan pilih OSS sebagai jenis sumber data, lalu konfigurasikan parameter sumber data.

Parameter

Deskripsi

Data Source Name

Nama sumber data harus terdiri dari huruf, angka, dan garis bawah (_). Nama tidak boleh diawali dengan angka atau garis bawah (_).

Data Source Description

Deskripsi singkat tentang sumber data. Panjang deskripsi tidak boleh melebihi 80 karakter.

Access Mode

RAM Role Authorization: Akun layanan DataWorks mengakses sumber data dengan mengasumsikan peran RAM. Jika ini pertama kalinya Anda memilih mode ini, ikuti petunjuk di layar untuk memberikan izin yang diperlukan.

Mode Access Key: Akses sumber data menggunakan ID AccessKey dan Rahasia AccessKey dari akun Alibaba Cloud atau pengguna RAM.

Select Role

Parameter ini hanya diperlukan jika Anda mengatur Access Mode ke RAM Role Authorization.

AccessKey ID

Parameter ini hanya diperlukan jika Anda mengatur Access Mode ke Access Key Mode. ID AccessKey dan Rahasia AccessKey dari akun Alibaba Cloud atau pengguna RAM.

AccessKey Secret

Region

Wilayah tempat bucket berada.

Endpoint

Nama domain OSS. Untuk informasi selengkapnya, lihat Wilayah dan titik akhir.

Bucket

Nama bucket.

Setelah Anda mengonfigurasi parameter dan uji konektivitas berhasil, klik Complete untuk menambahkan sumber data.

Langkah 3: Konfigurasi tugas sinkronisasi offline

Buat dan konfigurasikan tugas sinkronisasi data untuk menentukan aturan transfer data dari Tablestore ke OSS.

Buat node tugas

Buka halaman Data Development.

Masuk ke Konsol DataWorks.

Di bilah navigasi atas, pilih kelompok sumber daya dan wilayah.

Di panel navigasi sebelah kiri, pilih .

Pilih ruang kerja yang sesuai dan klik Go To DataStudio.

Di halaman Data Development di Konsol DataStudio, klik ikon

di sebelah kanan Project Folder dan pilih .

di sebelah kanan Project Folder dan pilih .Di kotak dialog Create Node, Anda dapat memilih Path, mengatur Sumber Data ke Tablestore dan Tujuan Data ke OSS, memasukkan Name, lalu klik Confirm.

Konfigurasi tugas sinkronisasi

Di bawah Project Folder, klik node tugas sinkronisasi offline Anda dan konfigurasikan tugas sinkronisasi di antarmuka tanpa kode atau editor kode.

Antarmuka tanpa kode (default)

Konfigurasikan item berikut:

Data Source: Pilih sumber dan tujuan data.

Runtime Resource: Pilih kelompok sumber daya. Setelah Anda membuat pilihan, sistem secara otomatis menguji konektivitas sumber data.

Data Source:

Table: Anda dapat memilih tabel sumber dari daftar tarik-turun.

Primary Key Range (Start): Kunci primer awal dari rentang yang akan dibaca. Nilainya adalah larik JSON.

inf_minmerepresentasikan tak hingga negatif.Jika kunci primer mencakup kolom

intbernamaiddan kolomstringbernamaname, konfigurasi berikut adalah contohnya:Rentang kunci primer yang ditentukan

Data lengkap

[ { "type": "int", "value": "000" }, { "type": "string", "value": "aaa" } ][ { "type": "inf_min" }, { "type": "inf_min" } ]Primary Key Range (End): Akhir dari rentang kunci primer untuk data yang dibaca, ditentukan sebagai larik JSON.

inf_maxmerepresentasikan tak hingga positif.Jika kunci primer mencakup kolom

intbernamaiddan kolomstringbernamaname, konfigurasi berikut adalah contohnya:Rentang kunci primer yang ditentukan

Data lengkap

[ { "type": "int", "value": "999" }, { "type": "string", "value": "zzz" } ][ { "type": "inf_max" }, { "type": "inf_max" } ]Shard Configuration: Konfigurasi shard kustom dalam format larik JSON. Biasanya, Anda dapat membiarkan parameter ini tidak dikonfigurasi dengan mengaturnya ke

[].Jika terjadi hotspot dalam penyimpanan data Tablestore dan kebijakan sharding otomatis Tablestore Reader tidak efektif, kami menyarankan agar Anda menggunakan aturan sharding kustom. Aturan sharding kustom memungkinkan Anda menentukan kunci shard dalam rentang kunci primer. Anda hanya perlu mengonfigurasi kunci shard, bukan semua kunci primer.

Data Destination: Pilih Text Type dan konfigurasikan parameter yang sesuai.

Text Type: Nilai yang valid adalah csv, text, orc, dan parquet.

File Name (including Path): Jalur lengkap ke file di bucket OSS. Misalnya,

tablestore/resource_table.csv.Column Delimiter: Nilai default adalah

,. Jika pemisah adalah karakter non-printable, masukkan pengkodean Unicode-nya, seperti\u001batau\u007c.File Path: Jalur file di bucket OSS. Parameter ini hanya diperlukan untuk jenis file parquet.

File Name: Nama file di bucket OSS. Parameter ini hanya diperlukan untuk file dalam format parquet.

Destination Field Mapping: Memetakan bidang dari tabel sumber ke file tujuan. Setiap baris merepresentasikan satu bidang dalam format JSON.

Source Field: Bidang kunci primer dan kolom atribut dari tabel sumber.

Jika kunci primer mencakup kolom

intbernamaiddan kolomstringbernamaname, serta kolom atribut mencakup bidangintbernamaage, konfigurasi berikut adalah contohnya:{"name":"id","type":"int"} {"name":"name","type":"string"} {"name":"age","type":"int"}Destination Field: Bidang kunci primer dan kolom atribut dari tabel sumber.

Jika kunci primer mencakup kolom

intbernamaiddan kolomstringbernamaname, serta kolom atribut mencakup bidangintbernamaage, konfigurasi berikut adalah contohnya:{"name":"id","type":"int"} {"name":"name","type":"string"} {"name":"age","type":"int"}

Untuk menyimpan konfigurasi, klik Save di bagian atas halaman.

Editor kode

Klik Code Editor di bagian atas halaman. Editor kode akan terbuka. Edit skrip.

Contoh berikut menunjukkan konfigurasi di mana jenis file tujuan adalah CSV. Tabel sumber memiliki kunci primer yang mencakup kolomintbernamaiddan kolomstringbernamaname. Kolom atribut adalah bidangintbernamaage. Saat mengonfigurasi skrip, gantidatasource, nama tabeltable, dan nama file tujuanobjectdalam contoh skrip dengan nilai aktual Anda.

{

"type": "job",

"version": "2.0",

"steps": [

{

"stepType": "ots",

"parameter": {

"datasource": "source_data",

"column": [

{

"name": "id",

"type": "int"

},

{

"name": "name",

"type": "string"

},

{

"name": "age",

"type": "int"

}

],

"range": {

"begin": [

{

"type": "inf_min"

},

{

"type": "inf_min"

}

],

"end": [

{

"type": "inf_max"

},

{

"type": "inf_max"

}

],

"split": []

},

"table": "source_table",

"newVersion": "true"

},

"name": "Reader",

"category": "reader"

},

{

"stepType": "oss",

"parameter": {

"dateFormat": "yyyy-MM-dd HH:mm:ss",

"datasource": "target_data",

"writeSingleObject": false,

"column": [

{

"name": "id",

"type": "int"

},

{

"name": "name",

"type": "string"

},

{

"name": "age",

"type": "int"

}

],

"writeMode": "truncate",

"encoding": "UTF-8",

"fieldDelimiter": ",",

"fileFormat": "csv",

"object": "tablestore/source_table.csv"

},

"name": "Writer",

"category": "writer"

}

],

"setting": {

"errorLimit": {

"record": "0"

},

"speed": {

"concurrent": 2,

"throttle": false

}

},

"order": {

"hops": [

{

"from": "Reader",

"to": "Writer"

}

]

}

}Setelah mengedit skrip, klik Save di bagian atas halaman.

Jalankan tugas sinkronisasi

Klik Run di bagian atas halaman untuk memulai tugas sinkronisasi. Pertama kali menjalankan tugas, Anda harus mengonfirmasi Debug Configuration.

Langkah 4: Lihat hasil sinkronisasi

Setelah tugas sinkronisasi selesai, Anda dapat melihat status eksekusi di log dan memeriksa file hasil di bucket OSS.

Lihat status dan hasil tugas di bagian bawah halaman. Informasi log berikut menunjukkan bahwa tugas sinkronisasi berhasil dijalankan.

2025-11-18 11:16:23 INFO Shell run successfully! 2025-11-18 11:16:23 INFO Current task status: FINISH 2025-11-18 11:16:23 INFO Cost time is: 77.208sLihat file di bucket tujuan.

Buka Daftar Bucket. Klik bucket tujuan untuk melihat atau mengunduh file hasil.