Fitur Agentic SOC memungkinkan Anda mengumpulkan log secara terpusat dari berbagai saluran, seperti Kafka, Amazon S3, dan Alibaba Cloud Object Storage Service (OSS), sehingga membantu membangun pusat analisis log dan operasi keamanan terpadu untuk manajemen keamanan yang konsisten di seluruh lingkungan cloud.

Alur Kerja

Memilih solusi

Sebelum memulai konfigurasi, pilih saluran impor log yang paling sesuai berdasarkan jenis sumber data, pertimbangan biaya, dan kebutuhan data real-time Anda.

Saluran impor | Kasus penggunaan | Fitur |

Kafka |

|

|

S3 (atau penyimpanan objek kompatibel S3) |

|

|

OSS (Alibaba Cloud Object Storage Service) | Data log sudah disimpan di Alibaba Cloud OSS. | Terkompatibilitas tinggi dengan ekosistem Alibaba Cloud sehingga mudah dikonfigurasi. |

Kirimkan log ke saluran perantara

Fitur impor Agentic SOC mengambil data dari saluran seperti Kafka, S3, atau OSS. Oleh karena itu, Anda harus terlebih dahulu mengirimkan data log sumber ke saluran perantara yang telah Anda pilih.

Contoh metode pengiriman:

OSS: Simpan data log di bucket Alibaba Cloud OSS. Untuk informasi selengkapnya, lihat OSS Quick Start.

Huawei Cloud: Gunakan fitur log dump dari Huawei Cloud Log Tank Service (LTS) untuk menyimpan data di Kafka atau OBS. Untuk informasi selengkapnya, lihat Impor data log Huawei Cloud.

Tencent Cloud: Gunakan fitur log dump dari Tencent Cloud Log Service (CLS) untuk menyimpan data di Kafka atau COS. Untuk informasi selengkapnya, lihat Impor data log Tencent Cloud.

Azure: Gunakan kompatibilitas Azure Event Hub dengan protokol Apache Kafka. Perlakukan Event Hub sebagai layanan Kafka yang dapat diambil datanya oleh Agentic SOC. Untuk informasi selengkapnya, lihat Impor data log Azure.

Simpan informasi akses: Simpan secara aman kredensial akses Anda (seperti pasangan AccessKey dan password) serta informasi titik akhir (seperti endpoint dan nama bucket).

Berikan izin Security Center untuk mengakses layanan pihak ketiga

Jika Anda menggunakan saluran data pihak ketiga, Anda harus memberikan izin kepada Agentic SOC untuk mengakses resource mereka agar dapat membaca data log dari layanan tersebut.

Kafka dan S3 (penyimpanan objek)

Masuk ke Konsol Security Center dan navigasikan ke Threat Detection and Response > Integration Center. Di pojok kiri atas halaman, pilih wilayah tempat aset Anda berada: Chinese Mainland atau Outside Chinese Mainland.

Pada tab Multi-cloud Configuration Management, pilih Multi-cloud Assets, lalu klik Grant Permission. Pada panel yang muncul, pilih IDC dari daftar drop-down dan konfigurasikan parameter berikut:

CatatanUntuk nilai spesifik item konfigurasi, seperti endpoint, lihat dokumentasi resmi masing-masing penyedia cloud.

Pada versi saat ini, ketika Anda mengonfigurasi layanan penyimpanan generik Kafka atau kompatibel S3 (seperti AWS S3, Tencent Cloud COS, atau Huawei Cloud OBS), pilih IDC. Ini hanya untuk klasifikasi UI dan tidak memengaruhi fitur sebenarnya.

Kafka

Vendor: Pilih Apache.

Connection Type: Pilih Kafka.

Endpoint: Titik akhir publik Kafka.

CatatanEndpoint Event Hub adalah:

<YOUR-NAMESPACE>.servicebus.windows.net:9093.Username/Password: Username dan password untuk Kafka.

CatatanUsername Kafka default untuk Event Hub adalah

$ConnectionString, dan password-nya adalah primary connection string.Communication Protocol: security.protocol dalam konfigurasi Kafka. Nilai yang didukung meliputi plaintext (default), sasl_plaintext, sasl_ssl, dan ssl.

SASL Authentication Mechanism: sasl.mechanism dalam konfigurasi Kafka. Nilai yang didukung meliputi plain, SCRAM-SHA-256, dan SCRAM-SHA-512.

S3

Vendor: Pilih AWS-S3.

Connection Type: Pilih S3.

Endpoint: Titik akhir layanan penyimpanan objek.

Access Key Id/Secret Access Key: Masukkan pasangan AccessKey untuk mengakses S3.

Konfigurasikan Kebijakan Sinkronisasi

AK Service Status Check: Menentukan interval pemeriksaan otomatis oleh Security Center terhadap validitas pasangan AccessKey Anda. Anda dapat memilih "Disable" untuk menonaktifkan pemeriksaan ini.

OSS

Buka halaman Cloud Resource Access Authorization dan klik Authorize untuk memberikan izin role sistem mengakses resource OSS.

Jika Anda adalah pengguna Resource Access Management (RAM), Anda juga harus mengonfigurasi izin berikut. Untuk informasi selengkapnya, lihat Buat kebijakan kustom dan Kelola izin pengguna RAM.

{ "Statement": [ { "Effect": "Allow", "Action": "ram:PassRole", "Resource": "acs:ram:*:*:role/aliyunlogimportossrole" }, { "Effect": "Allow", "Action": "oss:GetBucketWebsite", "Resource": "*" }, { "Effect": "Allow", "Action": "oss:ListBuckets", "Resource": "*" } ], "Version": "1" }

Buat tugas impor data

Buat sumber data

Buat sumber data Agentic SOC khusus untuk data log Anda. Jika Anda sudah membuatnya, lewati langkah ini.

Masuk ke Konsol Security Center dan navigasikan ke Agentic SOC > Integration Center. Di pojok kiri atas halaman, pilih wilayah tempat aset Anda berada: Chinese Mainland atau Outside Chinese Mainland.

Pada tab Data Source, buat sumber data untuk menerima log. Untuk informasi selengkapnya, lihat Buat sumber data untuk Simple Log Service (SLS).

Source Data Source Type: Pilih Agentic SOC Dedicated Collection Channel (Direkomendasikan) atau User Log Service.

Add Instances: Kami menyarankan Anda membuat Logstore baru untuk mengisolasi data.

Pada tab Data Import, klik Add Data. Pada panel yang terbuka, konfigurasikan pengaturan berikut berdasarkan Data Source Type:

CatatanUntuk nilai spesifik item konfigurasi, lihat dokumentasi resmi masing-masing penyedia cloud.

Kafka

Endpoint: Pilih titik akhir publik Kafka yang Anda masukkan saat memberikan izin Security Center mengakses layanan pihak ketiga.

Topics: Pilih topik di Kafka tempat log disimpan.

CatatanNama Event Hub adalah topik Kafka.

Value Type: Format penyimpanan log. Hubungan umumnya sebagai berikut:

Format penyimpanan pihak ketiga

Value Type

Format JSON

json

Format log mentah

text

S3

Endpoint: Titik akhir bucket S3.

S3 Bucket: ID bucket S3.

File Path Prefix Filter: Memfilter objek S3 berdasarkan awalan path file untuk menemukan objek yang ingin Anda impor secara akurat. Misalnya, jika objek S3 yang ingin Anda impor disimpan di direktori csv/, Anda dapat mengatur parameter ini menjadi csv/.

PeringatanAtur parameter ini. Jika Anda membiarkannya kosong, sistem akan melakukan traversal seluruh bucket S3. Jika bucket berisi banyak file, traversal penuh akan sangat menurunkan performa impor.

File Path Regex Filter: Memfilter file menggunakan ekspresi reguler untuk menemukan file yang ingin Anda impor secara akurat. Secara default, parameter ini dibiarkan kosong, yang berarti tidak ada pemfilteran. Misalnya, jika file S3 adalah

testdata/csv/bill.csv, Anda dapat mengatur ekspresi reguler menjadi(testdata/csv/)(.*).CatatanKami menyarankan Anda mengonfigurasi pengaturan ini bersama dengan File Path Prefix Filter untuk meningkatkan efisiensi. Pengaturan ini dan File Path Prefix Filter dievaluasi dengan logika AND.

Untuk informasi selengkapnya tentang cara men-debug ekspresi reguler, lihat Cara men-debug ekspresi reguler.

Data Format: Format penguraian untuk file, seperti di bawah ini.

CSV: File teks yang dibatasi oleh pemisah. Anda dapat menentukan baris pertama dalam file sebagai nama field atau menentukan nama field secara manual. Setiap baris kecuali nama field diurai sebagai nilai field log.

JSON: Membaca file S3 baris demi baris dan memperlakukan setiap baris sebagai objek JSON untuk diurai. Setelah diurai, field dalam objek JSON sesuai dengan field dalam log.

Text: Mengurai setiap baris dalam file S3 sebagai satu entri log.

Multi-line Text: Mode multi-baris yang mendukung penguraian log dengan menentukan ekspresi reguler untuk baris pertama atau terakhir.

Jika Anda memilih CSV atau Multi-line Text, Anda harus mengatur parameter tambahan yang dijelaskan di bawah ini.

CSV

Parameter

Deskripsi

Separator

Atur pemisah untuk log. Nilai default adalah koma (,).

Quote character

Karakter quote yang digunakan dalam string CSV.

Escape Character

Konfigurasikan karakter escape untuk log. Nilai default adalah backslash (\).

Max Line Span

Ketika entri log mencakup beberapa baris, Anda perlu menentukan jumlah maksimum baris. Nilai default adalah 1.

First Row as Header

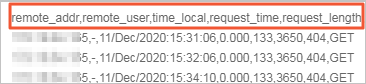

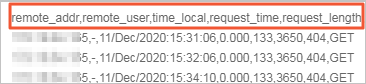

Jika Anda mengaktifkan sakelar ini, baris pertama file CSV digunakan sebagai nama field. Misalnya, baris pertama pada gambar berikut diekstraksi sebagai nama field log.

Skip rows

Tentukan jumlah baris log yang dilewati. Misalnya, jika Anda mengaturnya menjadi 1, pengumpulan log dimulai dari baris kedua file CSV.

Multi-line Text

Parameter

Deskripsi

Regex Match Position

Atur posisi pencocokan ekspresi reguler, seperti dijelaskan di bawah ini:

Prefix Regex: Menggunakan ekspresi reguler untuk mencocokkan baris pertama entri log. Baris berikutnya yang tidak cocok dengan ekspresi tersebut dianggap sebagai bagian dari entri log tersebut hingga jumlah maksimum baris tercapai.

Suffix Regex: Menggunakan ekspresi reguler untuk mencocokkan akhir baris entri log. Bagian yang tidak cocok dianggap sebagai bagian dari entri log berikutnya hingga jumlah maksimum baris tercapai.

Regex

Atur ekspresi reguler yang benar berdasarkan konten log. Untuk informasi selengkapnya tentang cara menyesuaikan ekspresi reguler, lihat Cara men-debug ekspresi reguler.

Max Lines

Jumlah maksimum baris untuk satu entri log.

Encoding Format: Format encoding file S3 yang akan diimpor. Format yang didukung adalah GBK dan UTF-8.

Compression format: Secara otomatis dideteksi oleh sistem berdasarkan pengaturan format kompresi data S3.

Modified Time: Mengimpor semua file yang dimodifikasi mulai 30 menit sebelum tugas dimulai (termasuk file yang baru ditambahkan).

New File Check Cycle: Menentukan interval waktu tugas impor secara berkala memindai file baru. Tugas tersebut secara otomatis memindai dan mengimpor file baru pada interval ini.

OSS

PentingSaat ini, hanya file OSS hingga 5 GB yang dapat diimpor. Ukuran file terkompresi dihitung berdasarkan ukurannya setelah dikompresi.

OSS Region: Wilayah penyimpanan data OSS.

CatatanAkses lintas wilayah menimbulkan biaya transfer data. Biaya ini dikenakan oleh layanan OSS. Untuk informasi selengkapnya, lihat Detail penagihan.

Bucket: Bucket OSS yang berisi file yang akan diimpor.

File Path Prefix Filter: Memfilter objek OSS berdasarkan awalan path file untuk menemukan objek yang ingin Anda impor secara akurat. Misalnya, jika file yang ingin Anda impor disimpan di direktori csv/, Anda dapat mengatur parameter ini menjadi csv/.

PeringatanAtur parameter ini. Jika Anda membiarkannya kosong, sistem akan melakukan traversal seluruh bucket OSS. Jika bucket berisi banyak file, traversal penuh akan menurunkan performa impor dan menimbulkan biaya yang tidak perlu.

File Path Regex Filter: Menentukan ekspresi reguler untuk memfilter file dan menemukan file yang ingin Anda impor secara akurat. Secara default, parameter ini dibiarkan kosong, yang berarti tidak ada pemfilteran. Misalnya, jika file OSS berada di

testdata/csv/bill.csv, Anda dapat mengatur ekspresi reguler menjadi(testdata/csv/)(.*).CatatanKami menyarankan Anda mengonfigurasi pengaturan ini bersama dengan File Path Prefix Filter untuk meningkatkan efisiensi. Pengaturan ini dan File Path Prefix Filter dievaluasi menggunakan logika AND.

Untuk informasi selengkapnya tentang cara men-debug ekspresi reguler, lihat Cara men-debug ekspresi reguler.

Modified Time: Mengatur waktu mulai menjadi 30 menit sebelum tugas dimulai dan mengimpor semua file yang dimodifikasi setelah waktu ini, termasuk file yang baru ditambahkan.

Data Format: Format yang digunakan untuk mengurai file, sebagai berikut.

CSV: File teks yang dibatasi oleh pemisah. Anda dapat menentukan baris pertama dalam file sebagai nama field atau menentukan nama field secara manual. Setiap baris kecuali nama field diurai sebagai nilai field log.

Single-Line JSON: Membaca file OSS baris demi baris dan mengurai setiap baris sebagai objek JSON. Field dalam objek JSON adalah field log.

Text: Mengurai setiap baris dalam file OSS sebagai satu entri log.

Multi-line Text: Mode multi-baris yang mendukung penguraian log berdasarkan ekspresi reguler yang ditentukan untuk baris pertama atau terakhir.

ORC: Format file ORC. Tidak perlu konfigurasi. Secara otomatis diurai menjadi format log.

Parquet: Format Parquet. Tidak perlu konfigurasi. Secara otomatis diurai menjadi format log.

OSS Access Log: Format untuk log akses Alibaba Cloud OSS. Untuk informasi selengkapnya, lihat Penyimpanan log.

Download Alibaba Cloud CDN logs: Format log unduhan untuk Alibaba Cloud CDN. Untuk informasi selengkapnya, lihat Quick Start.

Jika Anda memilih CSV atau Multi-line Text, Anda perlu mengatur parameter tambahan seperti dijelaskan di bawah ini.

CSV

Parameter

Deskripsi

Separator

Atur pemisah untuk log. Nilai default adalah koma (,).

Quote character

Karakter quote yang digunakan dalam string CSV.

Escape Character

Konfigurasikan karakter escape untuk log. Nilai default adalah backslash (\).

Max Line Span

Ketika entri log mencakup beberapa baris, Anda perlu menentukan jumlah maksimum baris. Nilai default adalah 1.

First Row as Header

Jika Anda mengaktifkan sakelar ini, baris pertama file CSV digunakan sebagai nama field. Misalnya, baris pertama pada gambar berikut diekstraksi sebagai nama field log.

Skip rows

Tentukan jumlah baris log yang dilewati. Misalnya, jika Anda mengaturnya menjadi 1, pengumpulan log dimulai dari baris kedua file CSV.

Multi-line Text

Parameter

Deskripsi

Regex Match Position

Atur posisi pencocokan ekspresi reguler, seperti dijelaskan di bawah ini:

Prefix Regex: Menggunakan ekspresi reguler untuk mencocokkan baris pertama entri log. Baris berikutnya yang tidak cocok dengan ekspresi tersebut dianggap sebagai bagian dari entri log tersebut hingga jumlah maksimum baris tercapai.

Suffix Regex: Menggunakan ekspresi reguler untuk mencocokkan akhir baris entri log. Bagian yang tidak cocok dianggap sebagai bagian dari entri log berikutnya hingga jumlah maksimum baris tercapai.

Regex

Atur ekspresi reguler yang benar berdasarkan konten log. Untuk informasi selengkapnya tentang cara menyesuaikan ekspresi reguler, lihat Cara men-debug ekspresi reguler.

Max Lines

Jumlah maksimum baris untuk satu entri log.

Encoding Format: Format encoding file OSS yang akan diimpor. Format yang didukung meliputi GBK dan UTF-8.

Compression format: Secara otomatis dideteksi oleh sistem berdasarkan format kompresi data OSS yang dikonfigurasi.

New File Check Cycle: Menentukan interval waktu tugas impor secara berkala memindai file baru. Tugas tersebut kemudian secara otomatis memindai dan mengimpor file yang baru ditambahkan.

Konfigurasikan sumber data tujuan

Data Source Name: Pilih sumber data yang dibuat pada Langkah 1.

Target Logstore: Logstore yang Anda atur pada Langkah 1.

Klik OK untuk menyimpan konfigurasi. Security Center kemudian akan secara otomatis menarik log dari saluran impor data.

Analisis data yang diimpor

Setelah data berhasil diingest, Anda harus mengonfigurasi aturan penguraian dan deteksi agar Security Center dapat menganalisis log tersebut.

Buat kebijakan integrasi baru

Untuk informasi selengkapnya, lihat Integrasi produk. Buat kebijakan integrasi baru dan konfigurasikan parameter berikut:

Data Source: Pilih sumber data tujuan yang dikonfigurasi dalam tugas impor data.

Standardized Rule: Agentic SOC menyediakan aturan standar bawaan untuk beberapa produk cloud yang dapat Anda gunakan langsung.

Standardization Method: Saat mengonversi log akses menjadi log alert, hanya metode "Real-time Consumption" yang didukung.

Konfigurasikan aturan deteksi ancaman

Berdasarkan kebutuhan keamanan Anda, aktifkan atau buat aturan deteksi log dalam manajemen aturan untuk menganalisis log, menghasilkan alert, dan membuat event keamanan. Untuk informasi selengkapnya, lihat Manajemen aturan.

Biaya dan pengeluaran

Penagihan Agentic SOC dan SLS: Pihak yang bertanggung jawab atas biaya bergantung pada metode penyimpanan data yang dipilih.

CatatanUntuk informasi selengkapnya tentang penagihan Agentic SOC, lihat Langganan Threat Detection and Response dan Threat Detection and Response bayar sesuai penggunaan.

Untuk informasi selengkapnya tentang penagihan Simple Log Service (SLS), lihat Ikhtisar penagihan.

Jenis Sumber Data

Item yang dapat ditagih oleh Agentic SOC

Item yang dapat ditagih oleh SLS

Petunjuk khusus

Agentic SOC Dedicated Collection Channel

Biaya ingest log.

Biaya penyimpanan dan penulisan log.

CatatanItem-item di atas mengonsumsi Log Ingestion Traffic.

Biaya selain penyimpanan dan penulisan log (seperti Lalu lintas internet).

Agentic SOC membuat dan mengelola resource SLS. Oleh karena itu, Agentic SOC ditagih untuk biaya penyimpanan dan penulisan Logstore.

User Log Service

Biaya ingest log dikenakan dengan mengonsumsi Log Ingestion Traffic.

Semua biaya terkait log (termasuk penyimpanan dan penulisan log, biaya transfer data, dll.).

Semua resource log dikelola oleh Simple Log Service (SLS). Oleh karena itu, SLS ditagih untuk semua biaya terkait log.

Biaya terkait OSS: Saat Anda mengimpor data dari OSS, OSS mengenakan biaya untuk traffic dan permintaan. Untuk informasi harga item yang dapat ditagih ini, lihat Harga OSS.

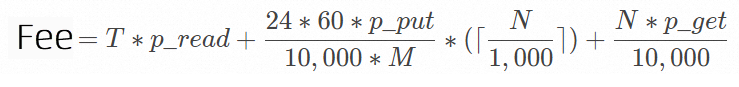

Rumus perhitungan biaya

Field

Deskripsi

NJumlah objek yang diimpor dari OSS ke Simple Log Service per hari.

TTotal ukuran data yang diimpor dari OSS ke Simple Log Service per hari. Satuan: GB.

p_readBiaya traffic per GB data.

Jika Anda mengimpor data dari OSS ke Simple Log Service dalam wilayah yang sama, lalu lintas keluar melalui jaringan internal akan dihasilkan. Anda tidak dikenakan biaya untuk lalu lintas keluar tersebut.

Jika Anda mengimpor data dari OSS ke Simple Log Service lintas wilayah, lalu lintas keluar melalui Internet akan dihasilkan.

p_putBiaya per 10.000 permintaan PUT.

Simple Log Service memanggil operasi ListObjects untuk mengkueri objek dalam bucket. Anda dikenakan biaya untuk permintaan PUT. Biaya tersebut termasuk dalam tagihan OSS Anda. Setiap panggilan dapat mengembalikan hingga 1.000 entri data. Jika Anda memiliki 1 juta objek baru untuk diimpor, diperlukan 1.000 panggilan.

p_getBiaya per 10.000 permintaan GET.

MInterval sistem mendeteksi objek baru. Satuan: menit.

Anda dapat mengonfigurasi New File Check Cycle untuk menentukan interval saat membuat konfigurasi impor data.

Contoh penagihan

Biaya pihak ketiga: