マルチクラウド環境では、セキュリティログがさまざまなクラウドプラットフォームに散在していることが多く、脅威の統一的な検出とインシデントレスポンスが複雑になります。Security Center は Agentic SOC 機能を提供し、Web Application Firewall (WAF) や Cloud Firewall (CFW) などの Huawei Cloud 製品のセキュリティログを一元的にインポートして分析します。この機能により、マルチクラウド環境全体で統一されたセキュリティ管理を実現できます。

仕組み

ソースでのログ集約:WAF や CFW などの Huawei Cloud 製品からのログは、まず Huawei Cloud の Log Tank Service (LTS) に集約されます。

データエクスポート:LTS を使用して、ログデータは Distributed Message Service (DMS) for Kafka または Object Storage Service (OBS) にエクスポートされます。これらはクラウド間のデータ転送の中継ノードとして機能します。

クラウド間のデータインポート:Agentic SOC プラットフォームはコンシューマーとして機能し、標準の Kafka または S3 プロトコルを使用して DMS for Kafka または OBS からログデータをサブスクライブし、プルします。データはその後、指定されたデータソースに取り込まれます。

取り込みと標準化:Agentic SOC プラットフォーム内で、取り込みポリシーを作成し、標準化ルールを適用します。プラットフォームは、データウェアハウスに保存する前に、生ログを解析して正規化します。

サポートされるログ

このソリューションは、Huawei Cloud からの以下のログタイプのインポートをサポートしています:

Web Application Firewall (WAF) のアラートログ

Cloud Firewall (CFW) のアラートログ

LTS へのログ送信

ログをインポートする前に、Huawei Cloud のすべてのセキュリティ製品ログを LTS に送信する必要があります。

Web Application Firewall

詳細な手順については、Huawei Cloud の公式ドキュメントをご参照ください:LTS を使用した WAF ログの記録。

コンソールへのログイン

Web Application Firewall コンソールにログインします。左上の隅でリージョンまたはプロジェクトを選択し、左側のナビゲーションウィンドウで [イベント] をクリックします。

LTS の設定

[ログ設定] タブで、[LTS に接続] をクリックします。次のパラメーターを設定します:

重要設定が有効になるまで約 10 分かかります。

[ログタイプ]:WAF アクセスログと WAF 攻撃ログ。

[ロググループ]:ログを保存するロググループを選択します。[ロググループの作成] をクリックして新しいロググループを作成することもできます。

[WAF アクセスログストリーム]:[ログタイプ] で WAF アクセスログ を選択した場合、WAF アクセスログストリームを選択します。[ログストリームの作成] をクリックして新しいログストリームを作成することもできます。

[WAF 攻撃ログストリーム]:[ログタイプ] で WAF 攻撃ログ を選択した場合、WAF 攻撃ログストリームを選択します。[ログストリームの作成] をクリックして新しいログストリームを作成することもできます。

Cloud Firewall

詳細な手順については、Huawei Cloud の公式ドキュメントをご参照ください:CFW ログの LTS への取り込み。

ロググループとログストリームの作成

Log Service コンソールにログインします。[ログ取り込み] ページで、[ロググループの作成] をクリックします。

[ロググループの作成] ページで、[ロググループ名] と [ログ保持期間 (日)] を設定します。

説明識別しやすくするために、ロググループ名にサフィックス

-cfwを追加することをお勧めします (例:mylog-cfw)。ロググループが作成されたら、リスト内でそのグループを見つけ、

アイコンの下にある[ログストリームの作成]をクリックします。

アイコンの下にある[ログストリームの作成]をクリックします。[ログストリームの作成] ページで、[ログストリーム名] と [ログ保存期間 (日)] を設定します。

説明攻撃イベントログ、アクセス制御ログ、トラフィックログには、それぞれ

-attack、-access、-flowなどのサフィックスを使用することをお勧めします。攻撃ログ:イベントタイプ、保護ルール、アクション、5タプル、攻撃ペイロードなどの詳細を含む攻撃アラートを記録します。

アクセスログ:ACL ポリシーに一致するトラフィック情報を記録します。ヒット時間、5タプル、レスポンスアクション、アクセス制御ルールなどの詳細が含まれます。

トラフィックログ:Cloud Firewall を通過するすべてのトラフィックを記録します。開始時刻、終了時刻、5タプル、バイト数、パケット数などの詳細が含まれます。

LTS 同期の設定

Cloud Firewall コンソールにログインします。左上の隅でリージョンとファイアウォールインスタンスを選択します。左側のナビゲーションウィンドウで、 を選択します。

[ログ管理] ページで、[LTS 同期の設定] をクリックします。[ロググループ] と [ログソース] を、前のステップで作成したロググループとログストリームに設定します。

インポート方法の選択

Kafka 方式または OBS 方式のいずれかを使用して、Huawei Cloud LTS ログを Security Center にインポートできます。各方式には、リアルタイム性能、コスト、設定の複雑さの点で異なるトレードオフがあります。ニーズに最も適した方式を選択してください。

側面 | Kafka (DMS) | OBS |

リアルタイム性能 | ほぼリアルタイム (リアルタイム転送を設定可能) | 分レベルのレイテンシー |

設定の複雑さ | 高い。Kafka インスタンス、Elastic IP Address (EIP)、セキュリティグループなどの設定が必要です。 | 低い。転送タスクの設定のみが必要です。 |

コスト構造 |

|

|

最適なシナリオ | ストリームベースのセキュリティコンピューティングや迅速なアラート対応など、高度なリアルタイムログ分析を必要とするシナリオ。 | リアルタイム性能が重要ではなく、コスト効率、ログのアーカイブ、またはバッチオフライン分析に重点を置くシナリオ。 |

データインポートの設定

Kafka (DMS) を使用したデータインポート

ステップ 1:Huawei Cloud での Kafka データチャネルの準備

Kafka インスタンスの設定

Kafka インスタンスの作成

説明詳細については、Huawei Cloud の公式ドキュメントをご参照ください:Kafka インスタンスの購入。

インスタンス仕様と Virtual Private Cloud (VPC) の設定:Kafka インスタンスの購入ページに移動します。[クイック設定] タブで、基本設定とネットワーク設定を完了します。

パブリックアクセスの設定:[アクセスモード] エリアで、パブリックネットワークアクセスを選択し、次のパラメーターを設定します:

[パブリックネットワークアクセス]:[暗号化アクセス]。

[パブリック IP アドレス]:アクセス可能な Elastic IP Address (EIP) を選択します。十分な EIP がない場合は、以下の手順に従って購入してください。詳細については、Huawei Cloud のドキュメントをご参照ください:EIP の申請。

[Elastic IP の作成] をクリックして EIP 購入ページに移動します。

重要少なくとも 3 つの EIP を購入する必要があります。

購入完了後、[Elastic IP アドレス] の横にある

アイコンをクリックし、ドロップダウンリストから新しく購入した EIP を選択します。

アイコンをクリックし、ドロップダウンリストから新しく購入した EIP を選択します。

[Kafka セキュリティプロトコル]:

SASL_SSL:SASL を使用して認証し、SSL 証明書を使用してデータを暗号化します。

SASL_PLAINTEXT:SASL を使用して認証し、パフォーマンス向上のためにデータをプレーンテキストで送信します。

[SASL PLAIN メカニズム]:[Kafka セキュリティプロトコル] を SASL_PLAINTEXT に設定した場合、CRAM-SHA-512 メカニズムを選択することをお勧めします。

[ユーザー名]/[パスワード]:クライアントが Kafka インスタンスに接続するためのユーザー名とパスワード。暗号化アクセスを有効にした後、ユーザー名は変更できません。

重要ユーザー名とパスワードは安全に保管してください。後で Security Center に Kafka へのアクセスを許可する 際に必要になります。

トピックの作成

Huawei Cloud - Kafka 管理ページに移動します。左上の隅で、Kafka インスタンスが配置されているリージョンを選択します。

左側のナビゲーションウィンドウで [Kafka インスタンス] をクリックします。対象のインスタンス名をクリックして詳細ページに移動し、[トピック管理] をクリックします。

トピックリストページで、[トピックの作成] をクリックし、ビジネスニーズに基づいてパラメーターを設定します。特別な要件がない場合は、デフォルト設定を使用できます。

説明詳細については、Huawei Cloud の公式ドキュメントをご参照ください:トピックパラメーターの説明。

セキュリティルールの設定

パブリックアクセスを有効にした後、Kafka への接続を許可するためにセキュリティグループルールを設定する必要があります。

Kafka インスタンスの詳細ページで、左側のナビゲーションウィンドウの [概要] をクリックします。[概要] ページの [ネットワーク] セクションで、[セキュリティグループ] の横にある

アイコンをクリックします。

アイコンをクリックします。ポリシー設定ページで、[インバウンドルール] タブに移動し、[ルールの追加] をクリックして、次のようにパラメーターを設定します:

ポリシー:許可

タイプ:IPv4

プロトコル:カスタム TCP

ポート:9095

ソース:0.0.0.0/0

Kafka 接続パラメーターの取得

Kafka インスタンスの [概要] ページで、[アドレス (パブリックネットワーク、暗号化)]、有効な [セキュリティプロトコル]、および [SASL PLAIN メカニズム] を記録します。

LTS から Kafka への転送タスクの作成

詳細な手順については、Huawei Cloud の公式ドキュメントをご参照ください:ログを DMS に転送。

Log Service コンソールにログインします。左側のナビゲーションウィンドウで [ログ転送] を選択し、右上の隅にある [ログ転送の設定] をクリックします。

以下のようにログ転送パラメーターを設定します。

[転送モード]:定期的転送。

[転送先]:DMS。

[ロググループ名]/[ログストリーム名]:LTS へのログ送信 ステップで設定したロググループ/ログストリーム (例:WAF 攻撃ログ) を選択します。

[Kafka インスタンス]:Kafka インスタンスの設定 ステップで設定したインスタンスを選択します。

[トピック]:トピックの作成 ステップで設定したトピックを選択します。

[転送間隔]:リアルタイム。

[フォーマット]:[生ログ形式] または [JSON] を選択できます。

ステップ 2:Alibaba Cloud での Kafka ログインポートの設定

Security Center への Kafka アクセス権の付与

Security Center コンソール > Agentic SOC > 統合センターに移動します。左上の隅で、資産リージョンを選択します:Outside Chinese Mainland または Outside Chinese Mainland。

マルチクラウドの設定と管理 タブで マルチクラウドアセット を選択し、権限の新規付与 をクリックして、ドロップダウンリストから IDC を選択します。表示されるパネルで、次のパラメーターを設定します:

ベンダー:Apache を選択します。

接続タイプ:Kafka を選択します。

エンドポイント:Huawei Cloud から取得した Kafka の IPv4 暗号化パブリックエンドポイントを入力します。

ユーザー名/パスワード:Huawei Cloud で Kafka 用に設定したユーザー名とパスワードを入力します。

通信プロトコル:Huawei Cloud で Kafka 用に設定した有効なセキュリティプロトコルを入力します。

SASL 認証メカニズム:Huawei Cloud で Kafka 用に設定したSASL PLAIN メカニズムを入力します。

同期ポリシーの設定

AK サービスのステータスチェック:Security Center が Huawei Cloud アクセスキーの有効性を自動的にチェックする間隔を設定します。「無効」を選択してこのチェックをオフにすることもできます。

データインポートタスクの作成

データソースの作成

Huawei Cloud ログデータ専用の Agentic SOC データソースを作成します。すでに作成済みの場合は、このステップをスキップしてください。

Security Center コンソール > Agentic SOC > 統合センターに移動します。左上の隅で、資産リージョンを選択します:Chinese Mainland または Outside Chinese Mainland。

Data Source タブで、Huawei Cloud ログ用のデータソースを作成します。詳細な手順については、「データソースの作成:ログが Simple Log Service (SLS) に取り込まれない場合」をご参照ください。

Source Data Source Type:User Log Service または Agentic SOC Dedicated Collection Channel を選択できます。

インスタンス接続:データを分離するために、新しい Logstore を作成することをお勧めします。

Data Import タブで、Add Data をクリックします。表示されるパネルで、次のパラメーターを設定します:

エンドポイント:Huawei Cloud から取得した Kafka の IPv4 暗号化パブリックエンドポイントを入力します。

トピック:Huawei Cloud で作成したトピックを選択します。

値のタイプ:LTS ログに設定した転送フォーマットに基づいて値を選択します。マッピングは次のとおりです:

転送フォーマット

値のタイプ

JSON フォーマット

json

生ログ形式

text

宛先データソースの設定

データソース名:ステップ 1 で作成したデータソースを選択します。

宛先 Logstore:選択したデータソース配下の Logstore が自動的に読み込まれます。

[OK] をクリックして設定を保存します。インポートが設定されると、Security Center は自動的に Huawei Cloud からログをプルします。

OBS を使用したデータインポート

ステップ 1:Huawei Cloud での OBS データの準備とアクセスキーの取得

LTS から OBS へのログ転送設定

転送タスクの作成

説明詳細な手順については、Huawei Cloud の公式ドキュメントをご参照ください:ログを OBS に転送。

Log Service コンソールにログインします。左側のナビゲーションウィンドウで [ログ転送] を選択し、右上の隅にある [ログ転送の設定] をクリックします。

以下のようにログ転送パラメーターを設定します。

[転送モード]:定期的転送。

[転送先]:OBS バケット。

[ロググループ名]/[ログストリーム名]:LTS へのログ送信 ステップで設定したロググループ/ログストリーム (例:WAF アクセスログストリーム) を選択します。

[OBS バケット]:既存の OBS バケットを選択するか、Huawei Cloud - バケットリストページで新しいバケットを作成します。

説明LTS は、標準ストレージまたは復元済みアーカイブストレージクラスを使用する OBS バケットにログを転送できます。

カスタムログ転送パス:

有効:カスタムパスを設定できます。フォーマットは

/LogTanks/RegionName/%GroupName/%StreamName/<custom_transfer_path>です。デフォルトのカスタムパスはlts/%Y/%m/%dです。無効:ログはデフォルトのシステムパス (

LogTanks/RegionName/2019/01/01/<Log_Group>/<Log_Stream>/<log_file_name>) に転送されます。

[圧縮形式]:

uncompressed、gzip、またはzipを選択します。警告警告

現在、Security Center は

snappy形式で圧縮されたログファイルの解析をサポートしていません。

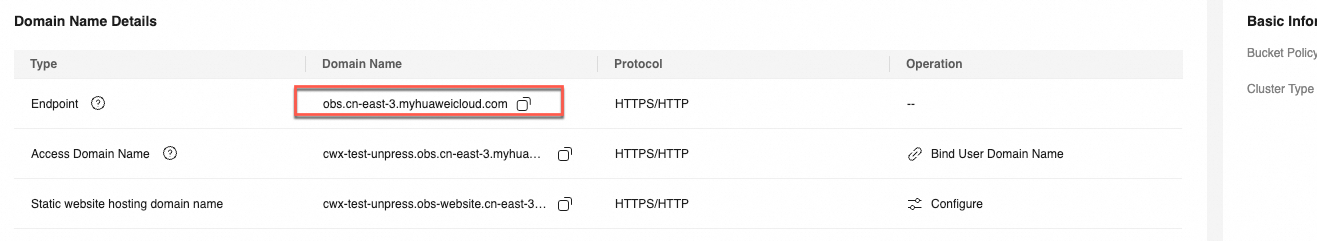

OBS バケットエンドポイントの取得

Huawei Cloud - バケットリストページに移動し、前のステップで設定した LTS ログ転送用の OBS バケットを見つけます。バケット詳細ページの左側のナビゲーションウィンドウで、[概要] をクリックします。

[ドメイン名] エリアで、[エンドポイント] を表示します。フォーマットは

obs.${region}.myhuaweicloud.comです。

アクセスキーの作成

または Huawei Cloud - 認証情報ページに移動し、左側のナビゲーションウィンドウで [アクセスキー] を選択します。

[アクセスキーの作成] をクリックします。[CSV ファイルのダウンロード] をクリックするか、

アクセスキー IDとシークレットアクセスキーをローカルファイルにコピーして安全に保管します。詳細については、「」または「アクセスキー」をご参照ください。

ステップ 2:Alibaba Cloud での OBS ログインポートの設定

Security Center への Huawei Cloud OBS アクセス権の付与

Security Center コンソール > Agentic SOC > 統合センターに移動します。左上の隅で、資産リージョンを選択します:Chinese Mainland または Outside Chinese Mainland。

マルチクラウドの設定と管理 タブで マルチクラウドアセット を選択し、権限の新規付与 をクリックして、ドロップダウンリストから IDC を選択します。表示されるパネルで、次のパラメーターを設定します:

同期ポリシーの設定

AK サービスのステータスチェック:Security Center が Huawei Cloud アクセスキーの有効性を自動的にチェックする間隔を設定します。「無効」を選択してこのチェックをオフにすることもできます。

データインポートタスクの作成

Security Center コンソール > Agentic SOC > 統合センターに移動します。左上の隅で、資産リージョンを選択します:Chinese Mainland または Outside Chinese Mainland。

Data Import タブで、Add Data をクリックします。表示されるパネルで、次のパラメーターを設定します:

エンドポイント:OBS バケットのエンドポイントを入力します。

OBS バケット:LTS がログを転送する OBS バケット。

宛先データソースの設定

データソース名:通常ステータスのカスタムデータソース (Custom Log Capability または Agentic SOC Dedicated Data Collection Channel) を選択します。適切なデータソースがない場合は、「データソース」の指示に従って作成します。

宛先 Logstore:選択したデータソース配下の Logstore が自動的に読み込まれます。

[OK] をクリックして設定を保存します。インポートが設定されると、Security Center は自動的に Huawei Cloud からログをプルします。

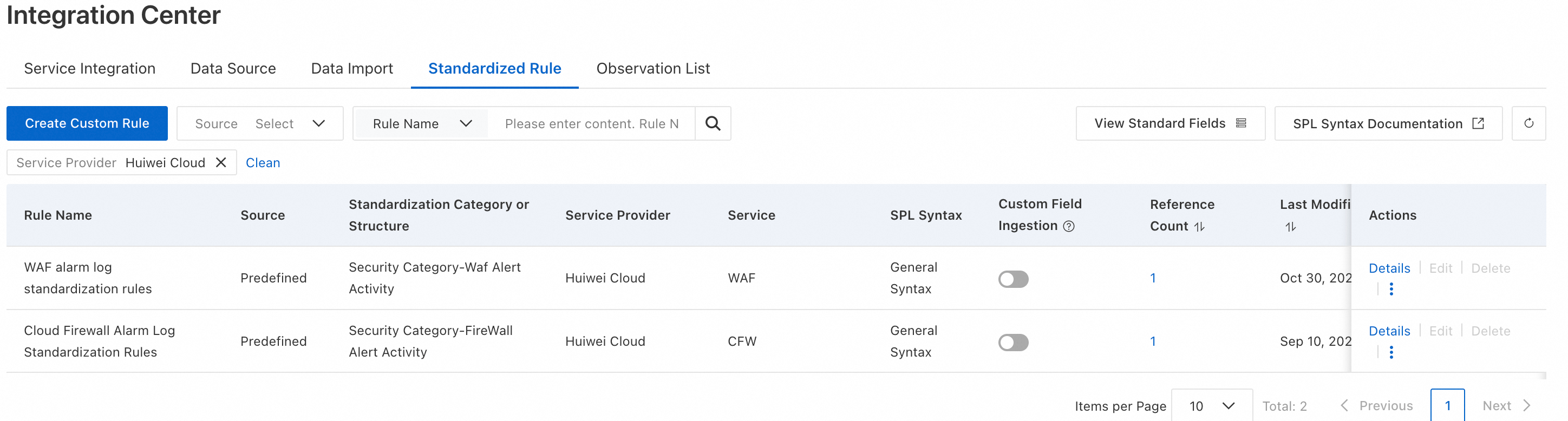

インポートされたデータの分析

データが正常に取り込まれた後、Security Center がログを分析できるように、解析および検出ルールを設定する必要があります。

新しい取り込みポリシーの作成

「Agentic SOC 2.0 への製品接続」の指示に従って、次の設定で新しい取り込みポリシーを作成します:

Data Source:データインポートタスクで設定した宛先データソースを選択します。

Standardized Rule:Agentic SOC は、直接選択できる Huawei Cloud 製品用の組み込み標準化ルールを提供します。

Standardization Method:アラートログを取り込んでいるため、これはデフォルトで Real-time Consumption に設定されており、変更できません。

脅威検出ルールの設定

セキュリティ要件に基づいて、ルール管理でログ検出ルールを有効化または作成し、ログを分析し、アラートを生成し、セキュリティイベントを作成します。詳細な手順については、「脅威検出ルールの設定」をご参照ください。

課金

このソリューションでは、以下のサービスからコストが発生します。続行する前に、各製品の課金ドキュメントを注意深く読み、コストを見積もってください:

Huawei Cloud 側:コストは主にデータ転送とストレージに関するものです:

サービス

課金項目

課金ドキュメント

LTS

ログストレージ、読み取り/書き込み操作など。

DMS for Kafka

インスタンス仕様、パブリックネットワークトラフィックなど。

OBS

ストレージ容量、リクエスト数、パブリックネットワークトラフィックなど。

Alibaba Cloud 側:コストは選択したデータストレージ方法によって異なります。

説明Agentic SOC の課金については、「課金の詳細」および「脅威分析とレスポンスの従量課金」をご参照ください。

Simple Log Service (SLS) の課金については、「SLS 課金概要」をご参照ください。

データソースタイプ

Agentic SOC 課金項目

SLS 課金項目

注

Agentic SOC Dedicated Collection Channel

ログ取り込み料金。

ログストレージおよび書き込み料金。

説明両方の項目で ログアクセストラフィック が消費されます。

ログストレージと書き込み以外の項目 (パブリックネットワークトラフィックなど) の料金。

Agentic SOC が SLS リソースを作成および管理します。そのため、Logstore のストレージおよび書き込み料金は Agentic SOC を通じて課金されます。

User Log Service

ログ取り込み料金。ログアクセストラフィック を消費します。

すべてのログ関連料金 (ストレージ、書き込み、パブリックネットワークトラフィックなど)。

すべてのログリソースは Simple Log Service (SLS) によって管理されます。そのため、すべてのログ関連料金は SLS を通じて課金されます。

よくある質問

データインポートタスクを作成した後、SLS にログデータが表示されない場合はどうすればよいですか?

サードパーティクラウド側の確認:Huawei Cloud コンソールにログインし、ログが生成され、設定された LTS、Kafka トピック、または OBS バケットに配信または転送されていることを確認します。

認証情報の確認:Security Center で、[マルチクラウド資産] ページに移動し、権限付与ステータスが正常であることを確認します。アクセスキーが有効で、パスワードが正しいことを確認します。

ネットワーク接続の確認:Kafka 方式を使用している場合は、サードパーティクラウドの Kafka サービスでパブリックアクセスが有効になっており、セキュリティグループまたはファイアウォールルールが Security Center のサービス IP アドレスからのトラフィックを正しく許可していることを確認します。

データインポートタスクの確認:Security Center で、[データインポート] ページに移動してタスクのステータスとエラーログを表示します。提供された情報に基づいて修正します。

権限を付与する際に、

Huawei CloudではなくApacheまたはAWS-S3を選択するのはなぜですか?これは、ログインポート機能がベンダー固有の API ではなく、標準の互換プロトコルを使用するためです。

IDC はプロトコルベンダーを表します。

Apacheは Kafka を表し、AWS-S3はオブジェクトストレージを表します。Huawei Cloud の権限付与は、Agentic SOC の脅威検出ルールを使用して Huawei Cloud とのセキュリティイベントレスポンス (IP アドレスのブロックなど) を連携させるためのものであり、ログのインポートを有効にするものではありません。