このトピックでは、Kohya ツールの使用方法について説明します。

PAI ArtLab コンソールにログインします。

前提条件

PAI ArtLab のアクティベーションと権限付与が完了していること。

(任意) 無料トライアルリソースまたはバウチャーを申請したか、リソースプランを購入済みであること。 詳細については、「PAI ArtLab の課金」をご参照ください。

リソース、バウチャー、またはリソースプランは有効期限が切れる前に使用してください。 詳細については、「使用量クォータと有効期間の表示」をご参照ください。

操作手順

このトピックでは、Kohya (専用) を使用して油絵モデルをトレーニングし、そのモデルに基づいて油絵風のイメージを生成する例を示します。 モデルのトレーニングには、解像度 768×768 ピクセルの自然風景の油絵イメージを 15 枚以上含むデータセットを準備します。 以下の手順に従ってトレーニングを完了します。

ステップ 1: データセットの作成

PAI ArtLab にログインします。 右上隅のアイコン

にカーソルを合わせ、China (Shanghai) リージョンを選択します。

にカーソルを合わせ、China (Shanghai) リージョンを選択します。Dataset ページで Create Dataset をクリックし、データセット名を入力します。

データセットを開き、New Folder をクリックします。 フォルダー名を入力します。

フォルダー名のフォーマット: number_any name。 number はトレーニング中の繰り返し値を表します。 例:

30_test。作成したフォルダーにイメージをアップロードします。 イメージの要件は次のとおりです。

イメージは鮮明である必要があります。 15 枚以上のイメージを使用してください。

解像度が高すぎないようにしてください。 SD 1.5 ベースモデルに基づく LoRA トレーニングでは、512×512 または 512×768 ピクセルのサイズのイメージを使用します。

ウォーターマーク、低解像度、異常な照明、複雑または認識不能な主題、奇妙なアングルのイメージは避けてください。

ステップ 2: データの注釈付け

[ツールボックス] ページで、[Kohya (専用)] カードをクリックしてツールを起動します。

[Utilities] > [Captioning] > [WD14 Captioning] タブに移動し、次のパラメーターを設定します。

パラメーター

説明

キャプションを付けるイメージフォルダー

作成したフォルダーを選択します。 ターゲットフォルダーがドロップダウンメニューに表示されない場合は、そのパスを手動で入力します。

例:

/data-oss/datasets/test/30_test。不要なタグ

ネガティブプロンプトを入力します。

WD14 キャプションに追加するプレフィックス

目的の LoRA トリガーワードを「データセット名 + 番号」のフォーマットで入力します。

例:

test1。[イメージにキャプションを付ける] をクリックして、自動バッチ注釈を開始します。

2〜3 分待ちます。 ログエリアに captioning done と表示されたら、注釈は完了です。

Datasets ページで、作成したフォルダーを開き、イメージをクリックしてその注釈を表示します。

注釈を編集することもできます。

ステップ 3: モデルのトレーニング

[モデル] > [モデルギャラリー] ページで、Checkpoint モデルを選択し、[マイモデル] に追加します。

[Kohya (専用)] ページで、[LoRA] > [トレーニング] に移動し、次の設定を完了します。

[ソースモデル] タブで、次のパラメーターを設定します。

パラメーター

説明

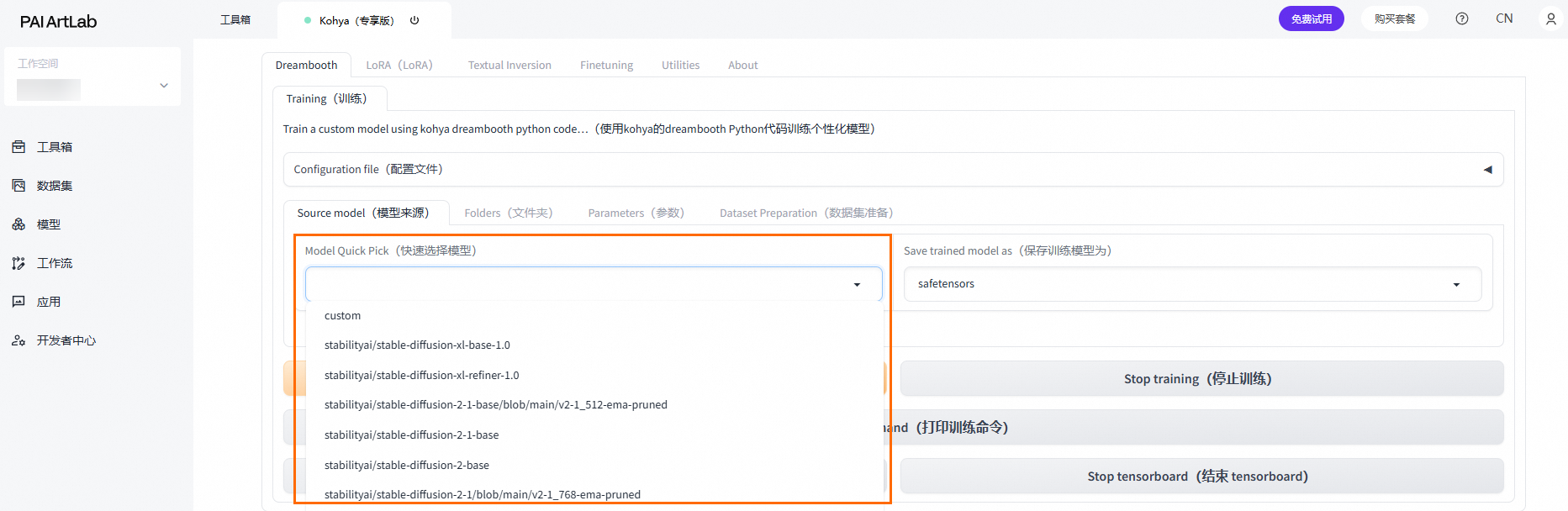

モデルクイックピック

[カスタム] を選択します。

事前トレーニング済みモデル名またはパス

右側の更新アイコン

をクリックして、モデルリストを更新します。

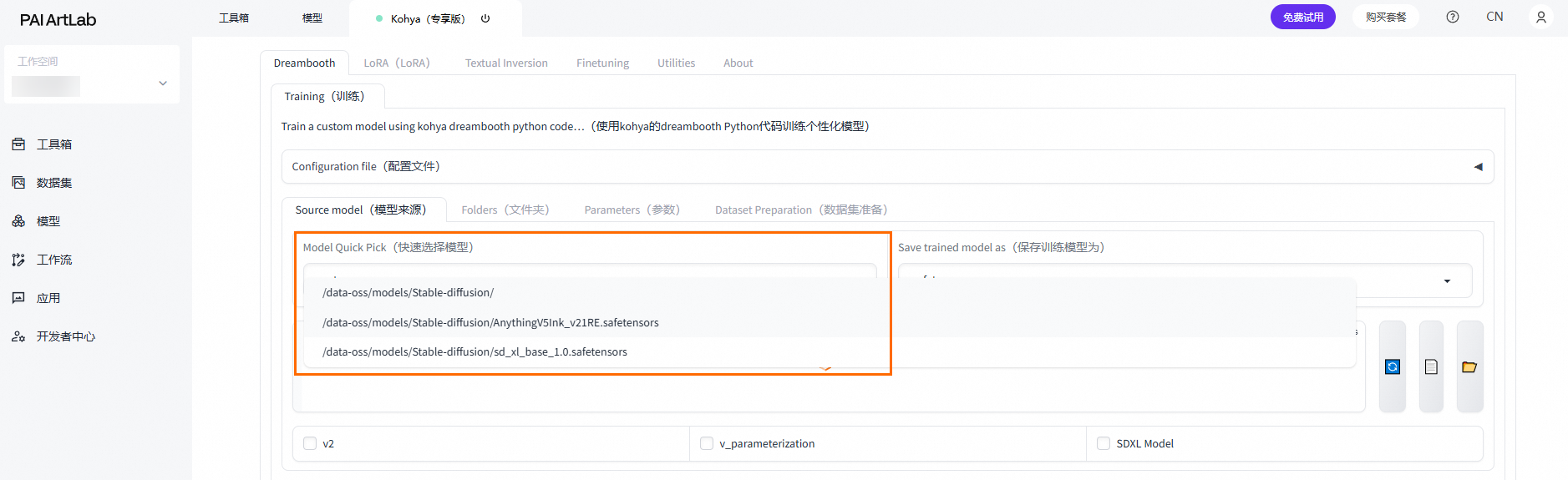

をクリックして、モデルリストを更新します。ドロップダウンメニューで、[/data-oss/models/Stable-diffusion] を選択します。

このパスの後に

/を入力し、追加したモデルを選択します。

[フォルダー] タブで、次のパラメーターを設定します。

パラメーター

説明

出力フォルダー

作成したデータセットを選択します。

モデル出力名

トレーニング済み LoRA の名前を入力します。 例:

test。[パラメーター] タブで、次のパラメーターを設定します。

パラメーター

説明

トレーニングエポック数

20 に設定します。

最大解像度

768,768 に設定します。

バケットを有効にする

チェックボックスをオフにします。

データセット内のすべてのイメージが同じディメンションである場合は、このオプションをオフにします。

テキストエンコーダーの学習率

0.00001 に設定します。

ネットワークランク (ディメンション)

128 に設定します。

ネットワークアルファ

64 に設定します。

[トレーニングを開始] をクリックします。 ログエリアに model saved と表示されたら、トレーニングは完了です。

トレーニング中にコードが生成されます。 損失値は、モデルの予測と実際の結果との差を測定する主要なメトリックです。 損失値はモデルタイプによって異なります。 参考範囲は次のとおりです。

モデルタイプ

損失値

キャラクターモデル

0.06–0.09

物理モデル

0.07–0.09

スタイルモデル

0.08–0.13

機能モデル

0.003–0.05

ステップ 4: モデル結果の表示

[モデル] > [マイモデル] ページで、モデルカードの右側にあるアイコン

をクリックして、Checkpoint モデルと生成された LoRA モデルの両方を [Stable Diffusion (共有)] に追加します。

をクリックして、Checkpoint モデルと生成された LoRA モデルの両方を [Stable Diffusion (共有)] に追加します。[ツールボックス] ページで、[Stable Diffusion (共有)] カードをクリックしてツールを起動します。

[Stable Diffusion モデル] の右側にある

をクリックし、Checkpoint モデルを選択します。

をクリックし、Checkpoint モデルを選択します。[Text-to-image] タブで、次の設定を完了します。

[生成] タブで、次のパラメーターを設定します。

パラメーター

説明

ステップ

30 に設定します。

スクリプト

[X/Y/Z プロット] を選択します。

X 軸タイプ: Prompt S/R

X 軸の値: NUM,000001,000002,000003

Y 軸タイプ: Prompt S/R

Y 軸の値: STRENGTH,0.3,0.5,0.6,0.7,0.8,0.9,1

[Lora] タブで [更新] をクリックし、次に追加した LoRA モデルをクリックします。

LoRA モデルが見つからない場合は、トレーニング済みの LoRA モデルのいずれかを選択し、プロンプトを修正します。

例えば、

<lora:test-000002:1>を<lora:test-NUM:STRENGTH>に変更します。プロンプトを入力します。

パラメーター

説明

ポジティブプロンプト

test1, outdoors, sky, day, cloud, water, tree, blue sky, no humans, traditional media, grass, building, nature, scenery, house, castle,ネガティブプロンプト

lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry, (worst quality:1.4), (low quality:1.4), (monochrome:1.1), Eagetive,

[生成] をクリックし、イメージが作成されるのを待ちます。

XYZ プロットが生成されます。 [X/Y/Z プロット] を使用して、トレーニング済みのすべてのモデルをテストし、その効果と重みを比較します。

関連操作

トレーニング用の Checkpoint ベースモデルの選択

方法 1: プラットフォームが提供する組み込みの Checkpoint ベースモデル (SD 1.5 や XL など) を選択します。

方法 2: カスタムベースモデルを選択します

[モデルクイックピック] を [カスタム] に設定します。 [事前トレーニング済みモデル名またはパス] で、[/data-oss/models/Stable--diffusion] を選択し、

/を入力して、[マイモデル] に追加またはアップロードした Checkpoint モデルを選択します。