このガイドでは、音声/ビデオ通話用のエージェントを作成する方法について説明します。

サービスの有効化

開始する前に、次の要件を満たしていることを確認してください。

リアルタイム対話型 AI が有効になっていること。この機能を有効にするには、購入ページに移動します。

ステップ 1:ワークフローの作成

IMS コンソールで リアルタイムワークフローテンプレートページに移動し、[ワークフローテンプレートの作成] をクリックします。

必要に応じて、[音声通話]、[アバター通話]、[ビジョン通話]、または [ビデオ通話] のいずれかのワークフロータイプを選択します。

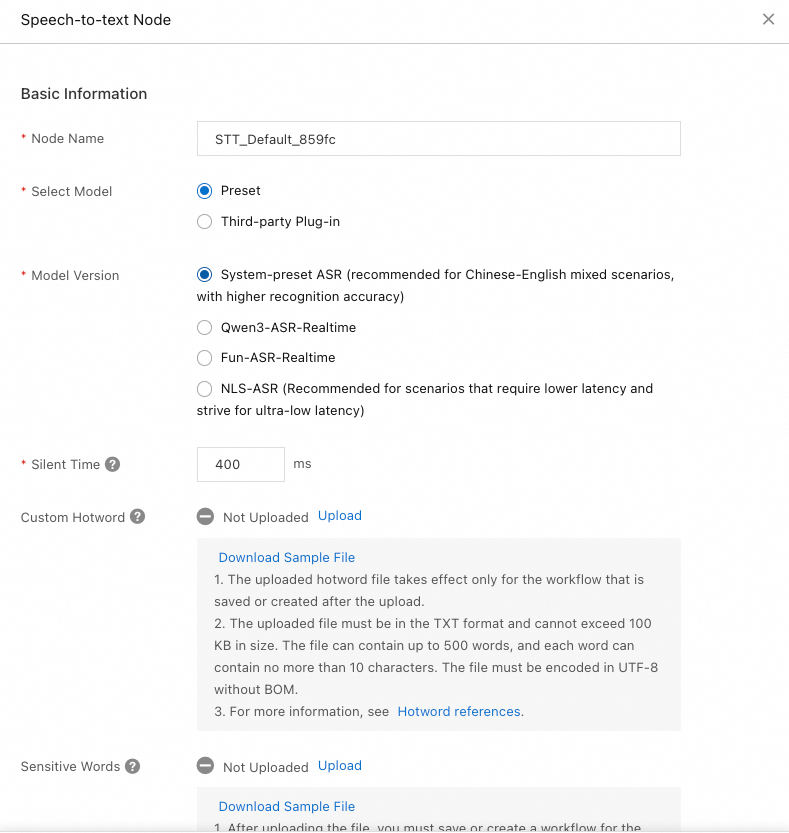

音声認識 (STT)

このノードは、音声入力をテキストに変換し、多言語をサポートします。

プリセット:システムのプリセットモデルは、ソース言語の選択、無音時間の設定、カスタムホットワードの設定をサポートします。

言語モデル: 必要に応じてソース言語を選択します。

[無音時間]:エージェントがユーザーの音声入力を待機し、タイムアウトするまでの時間です。

[カスタムホットワード]:ドメイン固有の用語の認識精度を向上させるために、ホットワードを設定します。詳細については、「音声認識のホットワード」をご参照ください。

[禁止用語]:禁止用語を設定すると、システムはクライアント側の出力でそれらを自動的にアスタリスク (*) でマスクします。詳細については、「カスタム禁止用語」をご参照ください。

[サードパーティプラグイン]:現在、[iFLYTEK] プラグインのみがサポートされています。iFLYTEK で必須パラメーターを取得します。

大規模言語モデル (LLM)

LLM ノードは、STT ノードからのテキストと大規模言語モデルを使用して、自然言語を理解し、生成します。

リアルタイム対話型 AI は、Qwen (システムプリセット)、Alibaba Cloud Model Studio、Tongyi Xingchen、および自己開発モデル (OpenAI 互換) との統合をサポートしています。

Alibaba Cloud Model Studio

Alibaba Cloud Model Studio は、モデル開発とアプリケーション構築のためのワンストッププラットフォームです。Alibaba Cloud Model Studio からモデルとサービスを選択して統合します。

モデル:[モデル] ページに移動し、モデルを選択して、そのコードを ModelId としてコピーします。

アプリケーション:[マイアプリケーション] ページに移動し、アプリケーションを作成して、そのアプリケーション ID をコピーします。

[キー管理] ページに移動し、API キーを作成してコピーします。

Tongyi Xingchen

Tongyi Xingchen を使用すると、それぞれが独自のペルソナとスタイルを持つ、高度にパーソナライズされたエージェントを作成できます。リアルタイムの音声対話機能と組み合わせることで、これらのエージェントはさまざまなシナリオでリッチでインタラクティブな体験を提供できます。

ModelId:Tongyi Xingchen は、

xingchen-lite、xingchen-base、xingchen-plus、xingchen-plus-v2、xingchen-maxの 5 つのモデルを提供しています。API-KEY:Tongyi Xingchen コンソールにアクセスして API キーを作成し、取得します。

自己開発モデル (OpenAI 互換)

リアルタイム対話型 AI は、OpenAI 仕様に準拠した自己開発 LLM をサポートしています。

OpenAI 仕様:OpenAI 仕様を使用してモデルを接続するには、次のパラメーターを指定します。

名前

説明

例

ModelId

モデル名。このパラメーターは、OpenAI 仕様の model フィールドに対応します。

abc

API-KEY

認証情報です。このパラメーターは、OpenAPI 仕様の api_key フィールドに対応します。

AUJH-pfnTNMPBm6iWXcJAcWsrscb5KYaLitQhHBLKrI

モデル URL (HTTPS)

サービスリクエスト URL。このパラメーターは、OpenAPI 仕様の base_url フィールドに対応します。

http://www.abc.com

カスタム LLM の統合に関する詳細については、「LLM へのアクセス」をご参照ください。

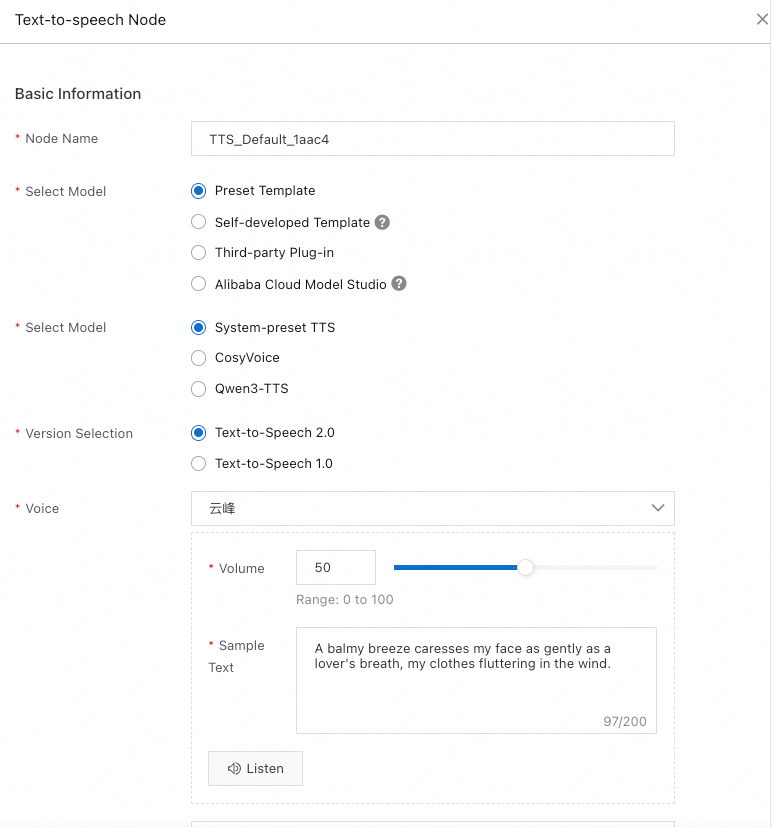

音声合成 (TTS)

このノードはテキストを音声に変換し、ユーザーがシステムの応答を聞くことができるようにします。

アプリケーションに適した TTS モデルを選択できます。

[プリセットテンプレート]:プリセットテンプレートの場合、音声を設定する必要があります。さまざまな音声効果の例については、「インテリジェント音声サンプル」をご参照ください。

[自己開発テンプレート]:標準化されたプロトコルに従って、独自のモデルをワークフローに統合します。詳細については、「TTS モデルへのアクセス」をご参照ください。

[サードパーティプラグイン]:現在、MiniMax Speech Model のみがサポートされています。複数のバージョンが利用可能であり、最新バージョンの使用を推奨します。詳細については、「MiniMax Speech Model」をご参照ください。

[フィルター]:LLM の出力から特定の記号をフィルタリングしてから、音声に変換します。

[テキスト正規化]:数字、記号、その他の非標準的な単語を統一された話し言葉の形式に変換して、音声合成をより自然に聞こえるようにします。たとえば、「$100」を「百ドル」に変換します。

アバター

このノードは、処理されたテキストと音声に従って、豊かな表情で動き、話すアバターのビデオストリームを生成します。

ノードで次のいずれかのオプションを選択します。

ビデオフレーム抽出

このノードは、ビデオから単一または複数のフレームを抽出します。

ビデオコンテンツ認識

このノードは、ビデオ内の特定のアクションを識別します。

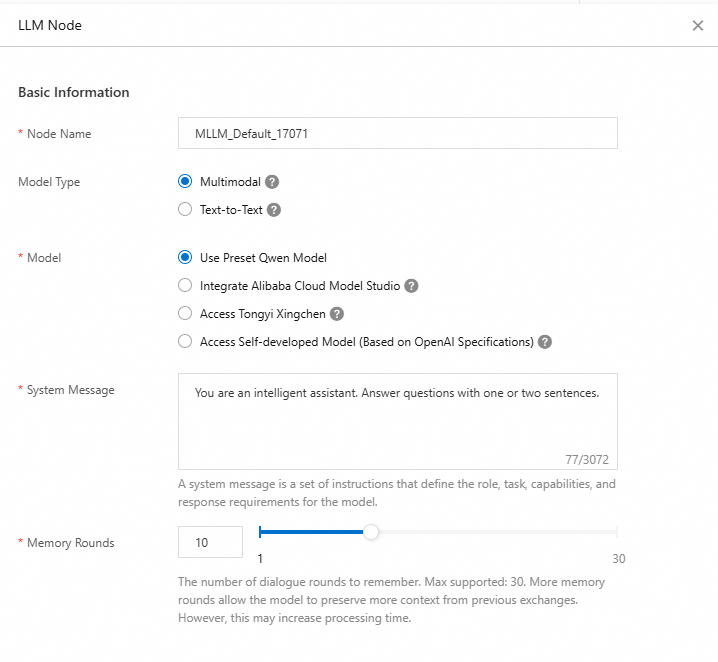

マルチモーダル大規模言語モデル (MLLM)

MLLM は、前のノードからのデータを使用して入力画像とテキストを理解し、自然言語の応答を生成します。さまざまなモデルタイプを選択することで、モデルの入力を制御できます。

リアルタイム対話型 AI は、Qwen (システムプリセット)、Alibaba Cloud Model Studio、Tongyi Xingchen、および自己開発モデル (OpenAI 互換) との統合をサポートしています。

Alibaba Cloud Model Studio Alibaba Cloud Model Studio は、モデル開発とアプリケーション構築のためのワンストッププラットフォームです。Alibaba Cloud Model Studio からモデルとサービスを選択して統合します。

モデル:[モデル] ページに移動し、モデルを選択して、そのコードを ModelId としてコピーします。

アプリケーション:[マイアプリケーション] ページに移動し、アプリケーションを作成して、そのアプリケーション ID をコピーします。

[キー管理] ページに移動し、API キーを作成してコピーします。

Tongyi Xingchen

Tongyi Xingchen を使用すると、それぞれが独自のペルソナとスタイルを持つ、高度にパーソナライズされたエージェントを作成できます。リアルタイムの音声対話機能と組み合わせることで、これらのエージェントはさまざまなシナリオでリッチでインタラクティブな体験を提供できます。

ModelId:Tongyi Xingchen は、

xingchen-lite、xingchen-base、xingchen-plus、xingchen-plus-v2、xingchen-maxの 5 つのモデルを提供しています。API-KEY:Tongyi Xingchen コンソールにアクセスして API キーを作成し、取得します。

自己開発モデル (OpenAI 互換)

リアルタイム対話型 AI は、OpenAI 仕様に準拠した自己開発 LLM もサポートしています。

OpenAI 仕様:OpenAI 仕様を使用してモデルを接続するには、次のパラメーターを指定します。

パラメーター

タイプ

必須

説明

例

ModelId

String

はい

モデル名。このパラメーターは、OpenAI 仕様の model フィールドに対応します。

abc

API-KEY

String

はい

認証情報。このパラメーターは、OpenAI 仕様の api_key フィールドに対応します。

AUJH-pfnTNMPBm6iWXcJAcWsrscb5KYaLitQhHBLKrI

モデル URL (HTTPS)

String

はい

サービスリクエスト URL。このパラメーターは、OpenAPI 仕様の base_url フィールドに対応します。

http://www.abc.com

1 回の呼び出しあたりの最大画像数

Integer

はい

一部のマルチモーダル大規模モデルでは、1 回のリクエストで受信できる画像フレームの数が制限されています。このパラメーターを設定して、さまざまなモデルに適応させることができます。リクエスト中に、この値に従ってビデオフレームが自動的にサンプリングされます。

15

カスタム LLM の統合に関する詳細については、「LLM へのアクセス」をご参照ください。

[保存] をクリックしてワークフローを作成します。

ステップ 2:AI エージェントの作成

IMS コンソールで [AI エージェント] ページに移動し、[AI エージェントの作成] をクリックします。

基本情報を設定し、音声/ビデオ通話ワークフローをバインドします。

ワークフローをバインドします。AI エージェントはワークフローに従って実行されます。

アカウントでリアルタイム音声・映像 (ARTC) アプリケーションを選択します。ARTC アプリケーションがない場合、システムは自動的に作成します。ARTC の詳細については、「ARTC の概要」をご参照ください。

説明

説明ARTC アプリケーションは、会話に必要なリアルタイム通信を処理します。

音声通話ワークフローをバインドすると、[高度な機能] セクションでカスタムプロフィール画像をアップロードできます。システムは音声通話中に画像を表示します。

[送信] をクリックしてエージェントを作成します。

ステップ 3:エージェントのテスト

エージェントを作成した後、デモ用の QR コードをスキャンしてテストできます。

[AI エージェント] ページで、デモ用の QR コードを生成します。

DingTalk、WeChat、またはブラウザで QR コードをスキャンするか、デモ URL をブラウザにコピーします。

ステップ 4:エージェントの統合

統合には次のパラメーターが必要です。エージェントをプロジェクトに統合して音声/ビデオ通話を実装する方法については、「音声/ビデオ通話エージェントの統合」をご参照ください。

リージョン ID:IMS コンソールに表示される、ワークフローとエージェントが配置されているリージョンです。

リージョン名

リージョン ID

中国 (杭州)

cn-hangzhou

中国 (上海)

cn-shanghai

中国 (北京)

cn-beijing

中国 (深セン)

cn-shenzhen

シンガポール

ap-southeast-1

ARTC アプリケーションの AppID と AppKey

AccessKey ペア:AccessKey ID と AccessKey Secret を取得するには、「AccessKey ペアの作成」をご参照ください。