ApsaraDB RDS untuk SQL Server menyediakan solusi untuk memigrasikan database SQL Server lokal ke instance ApsaraDB RDS untuk SQL Server. Anda dapat mengunggah data cadangan penuh dari database SQL Server lokal ke Alibaba Cloud Object Storage Service (OSS), lalu menggunakan konsol ApsaraDB RDS untuk memigrasikan data tersebut ke instance ApsaraDB RDS untuk SQL Server yang ditentukan. Solusi ini cocok untuk skenario seperti pencadangan data, migrasi data, dan pemulihan bencana.

Prasyarat

Instance ApsaraDB RDS untuk SQL Server harus memenuhi persyaratan berikut:

Ruang penyimpanan tersisa pada instance harus lebih besar dari ukuran file data yang akan dimigrasikan. Jika ruang penyimpanan tidak mencukupi, Anda dapat meningkatkan kapasitas penyimpanan instance.

Untuk instance yang menjalankan SQL Server 2012 atau versi lebih baru, atau SQL Server 2008 R2 dengan disk cloud: Pastikan instance tidak berisi database dengan nama yang sama seperti database yang akan dimigrasikan.

Untuk instance yang menjalankan SQL Server 2008 R2 dengan disk lokal berkinerja tinggi: Pastikan database dengan nama yang sama seperti database yang akan dimigrasikan telah dibuat pada instance tersebut.

Jika Anda menggunakan pengguna Resource Access Management (RAM), kondisi berikut harus dipenuhi:

Pengguna RAM memiliki izin AliyunOSSFullAccess dan AliyunRDSFullAccess. Untuk informasi selengkapnya tentang cara memberikan izin kepada pengguna RAM, lihat Kelola izin OSS menggunakan RAM dan Kelola izin ApsaraDB RDS menggunakan RAM.

Akun Alibaba Cloud Anda telah memberikan izin akun layanan ApsaraDB RDS untuk mengakses sumber daya OSS Anda.

Akun Alibaba Cloud Anda harus secara manual membuat kebijakan akses lalu menambahkan kebijakan tersebut ke pengguna RAM.

Catatan

Tingkat migrasi: Solusi ini hanya mendukung migrasi tingkat database. Untuk memigrasikan beberapa atau semua database, gunakan solusi migrasi tingkat instance.

Kompatibilitas versi: Anda tidak dapat memigrasikan data dari file cadangan instance SQL Server lokal ke instance ApsaraDB RDS untuk SQL Server yang menjalankan versi SQL Server yang lebih lama.

Manajemen izin: Setelah Anda memberikan izin akun layanan ApsaraDB RDS untuk mengakses OSS, peran bernama

AliyunRDSImportRoledibuat di Manajemen Peran pada konsol RAM. Jangan mengubah atau menghapus peran ini. Jika tidak, tugas migrasi akan gagal. Jika Anda melakukan kesalahan, Anda harus memberikan kembali izin tersebut menggunakan wizard migrasi data.Manajemen akun: Setelah migrasi selesai, akun database asli menjadi tidak tersedia. Anda harus membuat akun baru di konsol ApsaraDB RDS.

Retensi file OSS: Jangan menghapus file cadangan dari OSS sebelum tugas migrasi selesai. Jika tidak, tugas akan gagal.

Persyaratan file cadangan:

Batasan nama file: Nama file tidak boleh mengandung karakter khusus, seperti

!@#$%^&*()_+-=. Jika tidak, migrasi akan gagal.Ekstensi nama file: ApsaraDB RDS mendukung file cadangan dengan ekstensi

.bak(cadangan penuh),.diff(backup diferensial),.trn, atau.log(cadangan log). Sistem tidak dapat mengenali jenis file lainnya.Jenis file: Hanya file cadangan penuh yang dapat diunggah. Cadangan diferensial dan cadangan log tidak didukung.

Sumber file: Jika data sumber adalah file cadangan penuh yang diunduh dari ApsaraDB RDS untuk SQL Server, yang secara default dalam format

.zip, Anda harus mengekstrak file tersebut menjadi file.baksebelum memigrasikan data.

Penagihan

Solusi ini hanya menimbulkan biaya terkait OSS, seperti yang ditunjukkan pada tabel berikut.

Skenario | Deskripsi |

Unggah file cadangan data lokal ke OSS | Tidak ada biaya yang dikenakan. |

Simpan file cadangan di OSS | Biaya penyimpanan OSS dikenakan. Untuk informasi selengkapnya, lihat Harga OSS. |

Migrasikan file cadangan dari OSS ke ApsaraDB RDS |

|

Persiapan

Di lingkungan database lokal Anda, jalankan pernyataan DBCC CHECKDB untuk memastikan bahwa database tidak memiliki allocation errors atau consistency errors. Hasil berikut menunjukkan bahwa perintah berhasil dieksekusi:

...

CHECKDB found 0 allocation errors and 0 consistency errors in database 'xxx'.

DBCC execution completed. If DBCC printed error messages, contact your system administrator.1. Cadangkan database lokal

Pilih metode berdasarkan versi instance ApsaraDB RDS untuk SQL Server Anda.

SQL Server 2012 atau versi lebih baru, atau SQL Server 2008 R2 dengan disk cloud

Sebelum melakukan cadangan penuh database lokal, hentikan penulisan data ke database. Data yang ditulis selama proses pencadangan tidak akan dicadangkan.

Unduh skrip pencadangan dan buka di SQL Server Management Studio (SSMS).

Pada skrip, ubah parameter dalam pernyataan SELECT yang terletak di bawah

YOU HAVE TO INIT PUBLIC VARIABLES HERE.Item konfigurasi

Deskripsi

@backup_databases_list

Database yang akan dicadangkan. Pisahkan beberapa database dengan titik koma (;) atau koma (,).

@backup_type

Jenis pencadangan. Nilai yang valid:

FULL: cadangan penuh.

DIFF: backup diferensial.

LOG: cadangan log.

@backup_folder

Direktori lokal tempat file cadangan disimpan. Jika direktori tidak ada, direktori tersebut akan dibuat secara otomatis.

@is_run

Menentukan apakah pencadangan dilakukan. Nilai yang valid:

1: Lakukan pencadangan.

0: Lakukan hanya pemeriksaan dan jangan lakukan pencadangan.

Jalankan skrip pencadangan.

SQL Server 2008 R2 dengan disk lokal berkinerja-tinggi

Buka klien Microsoft SQL Server Management Studio (SSMS).

Login ke database yang ingin Anda migrasikan.

Jalankan perintah berikut untuk memeriksa model pemulihan saat ini dari database sumber.

USE master; GO SELECT name, CASE recovery_model WHEN 1 THEN 'FULL' WHEN 2 THEN 'BULK_LOGGED' WHEN 3 THEN 'SIMPLE' END model FROM sys.databases WHERE name NOT IN ('master','tempdb','model','msdb'); GOJika nilai

modelpada hasil bukanFULL, lanjutkan ke Langkah 4.Jika nilai

modelpada hasil adalahFULL, lanjutkan ke Langkah 5.

Jalankan perintah berikut untuk mengatur model pemulihan database sumber menjadi

FULL.ALTER DATABASE [dbname] SET RECOVERY FULL; GO ALTER DATABASE [dbname] SET AUTO_CLOSE OFF; GOPentingSetelah Anda mengatur model pemulihan menjadi

FULL, jumlah informasi log di SQL Server meningkat. Pastikan Anda memiliki ruang disk yang cukup.Jalankan perintah berikut untuk mencadangkan database sumber.

Contoh berikut menunjukkan cara mencadangkan database dbtest ke file backup.bak.

USE master; GO BACKUP DATABASE [dbtest] to disk ='d:\backup\backup.bak' WITH COMPRESSION,INIT; GOJalankan perintah berikut untuk memverifikasi integritas file cadangan.

USE master GO RESTORE FILELISTONLY FROM DISK = N'D:\backup\backup.bak';PentingJika set hasil dikembalikan, file cadangan valid.

Jika terjadi kesalahan, lakukan pencadangan ulang.

Opsional: Jalankan perintah berikut untuk mengembalikan model pemulihan asli database.

PentingJika model pemulihan database sudah

FULL, Anda tidak perlu melakukan langkah ini.ALTER DATABASE [dbname] SET RECOVERY SIMPLE; GO

2. Unggah file cadangan ke OSS

Pilih metode berdasarkan versi instance ApsaraDB RDS untuk SQL Server Anda.

SQL Server 2012 atau versi lebih baru, atau SQL Server 2008 R2 dengan disk cloud

Sebelum mengunggah file cadangan ke OSS, Anda harus membuat bucket di OSS.

Jika bucket sudah ada di OSS, pastikan bucket tersebut memenuhi persyaratan berikut:

kelas penyimpanan bucket adalah Standard. Kelas penyimpanan lainnya, seperti Infrequent Access, Archive, Cold Archive, dan Deep Cold Archive, tidak didukung.

Enkripsi sisi server dinonaktifkan untuk bucket tersebut.

Jika belum ada bucket di OSS, Anda harus membuat satu. (Pastikan Anda telah mengaktifkan OSS.)

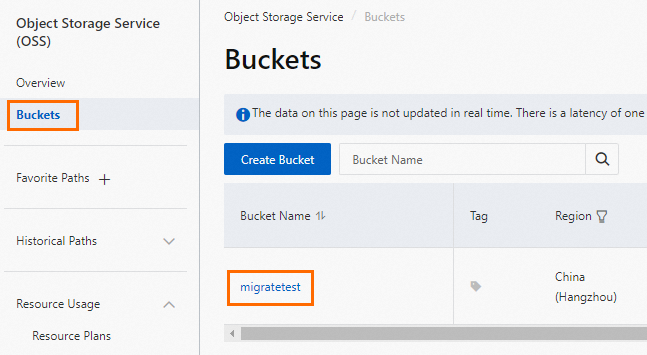

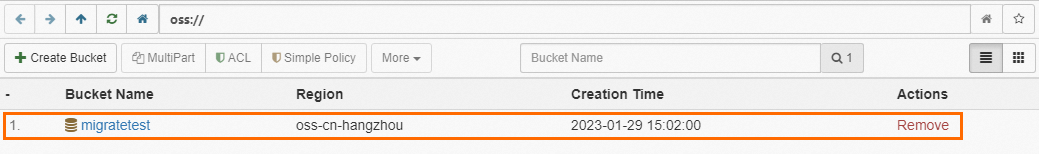

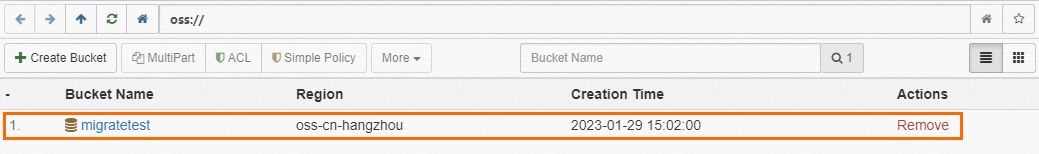

Login ke konsol OSS, klik Buckets, lalu klik Create Bucket.

Konfigurasikan parameter utama berikut. Anda dapat mempertahankan nilai default untuk parameter lainnya.

PentingBucket dibuat terutama untuk migrasi data ini. Anda hanya perlu mengonfigurasi parameter utama. Anda dapat menghapus bucket setelah migrasi selesai untuk mencegah kebocoran data dan mengurangi biaya.

Saat membuat bucket, jangan aktifkan enkripsi sisi server.

Parameter

Deskripsi

Contoh

Bucket Name

Nama bucket. Nama harus unik secara global dan tidak dapat diubah setelah bucket dibuat.

Konvensi penamaan:

Nama hanya boleh berisi huruf kecil, angka, dan tanda hubung (-).

Nama harus dimulai dan diakhiri dengan huruf kecil atau angka.

Nama harus terdiri dari 3 hingga 63 karakter.

migratetest

Region

Wilayah tempat bucket berada. Jika Anda mengunggah data ke bucket dari instance ECS melalui jaringan internal dan memulihkan data ke instance ApsaraDB RDS melalui jaringan internal, bucket, instance ECS, dan instance ApsaraDB RDS harus berada di wilayah yang sama.

China (Hangzhou)

Storage Class

Pilih Standard. Operasi migrasi dalam topik ini tidak mendukung bucket dengan kelas penyimpanan lainnya.

Standard

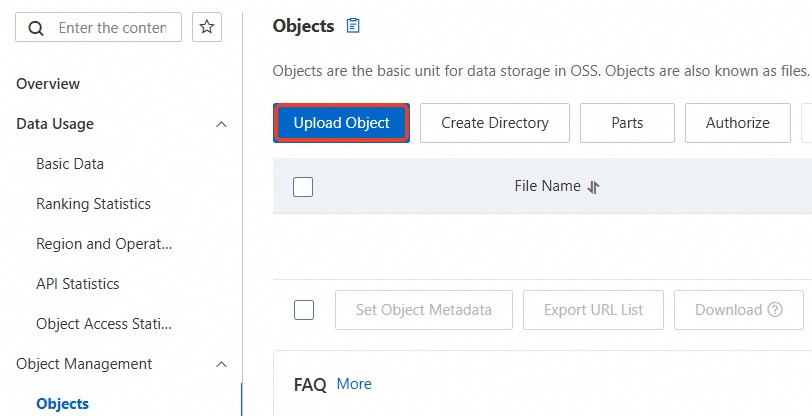

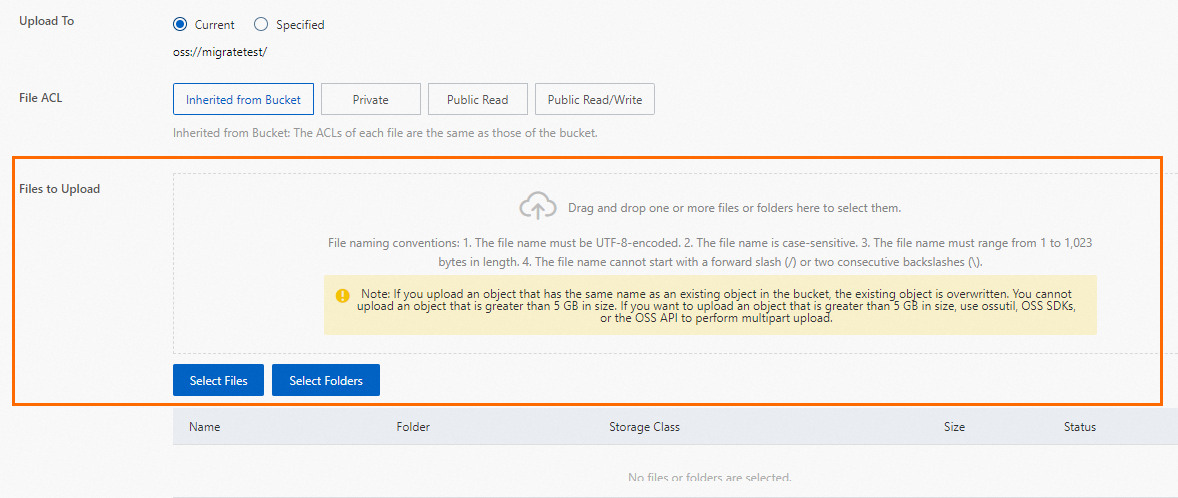

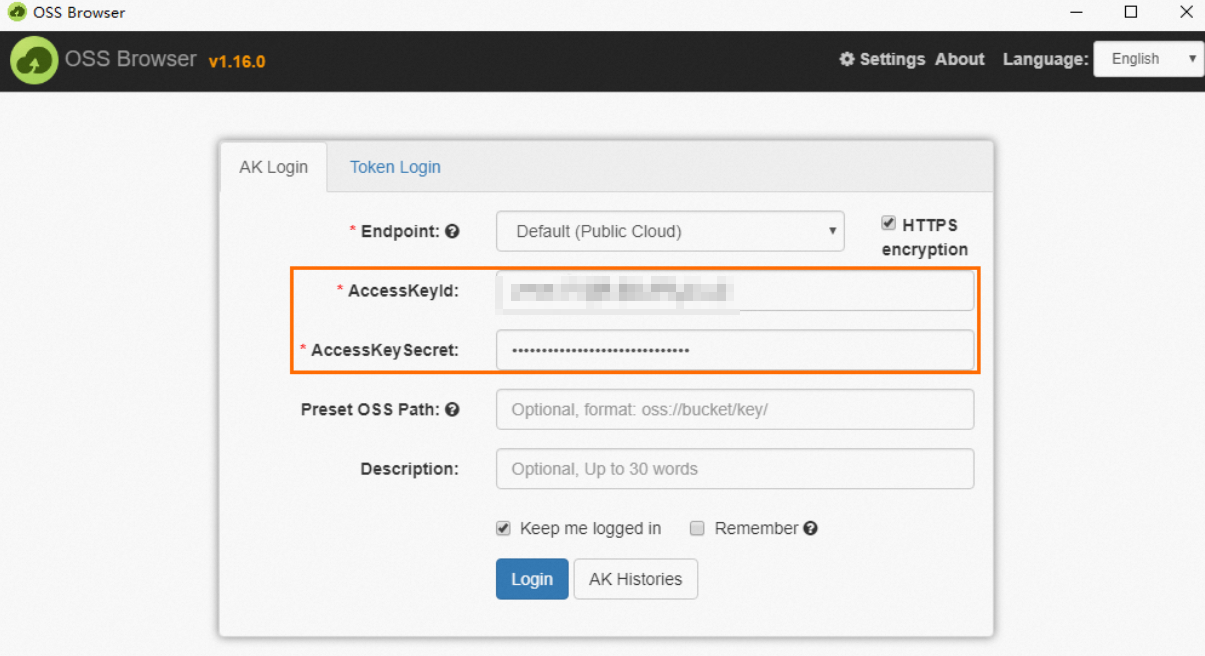

Unggah file cadangan ke OSS.

Setelah mencadangkan database lokal, unggah file cadangan ke bucket OSS yang berada di wilayah yang sama dengan instance ApsaraDB RDS Anda. Jika bucket dan instance berada di wilayah yang sama, Anda dapat menggunakan jaringan internal untuk interkoneksi layanan. Metode ini bebas biaya untuk lalu lintas keluar internet dan memberikan kecepatan unggah data yang lebih cepat. Anda dapat menggunakan salah satu metode berikut:

SQL Server 2008 R2 dengan disk lokal berkinerja-tinggi

Sebelum mengunggah file cadangan ke OSS, Anda harus membuat bucket di OSS.

Jika bucket sudah ada di OSS, pastikan bucket tersebut memenuhi persyaratan berikut:

kelas penyimpanan bucket adalah Standard. Kelas penyimpanan lainnya, seperti Infrequent Access, Archive, Cold Archive, dan Deep Cold Archive, tidak didukung.

Enkripsi sisi server dinonaktifkan untuk bucket tersebut.

Jika belum ada bucket di OSS, Anda harus membuat satu. (Pastikan Anda telah mengaktifkan OSS.)

Login ke konsol OSS, klik Buckets, lalu klik Create Bucket.

Konfigurasikan parameter utama berikut. Anda dapat mempertahankan nilai default untuk parameter lainnya.

PentingBucket dibuat terutama untuk migrasi data ini. Anda hanya perlu mengonfigurasi parameter utama. Anda dapat menghapus bucket setelah migrasi selesai untuk mencegah kebocoran data dan mengurangi biaya.

Saat membuat bucket, jangan aktifkan enkripsi sisi server.

Parameter

Deskripsi

Contoh

Bucket Name

Nama bucket. Nama harus unik secara global dan tidak dapat diubah setelah bucket dibuat.

Konvensi penamaan:

Nama hanya boleh berisi huruf kecil, angka, dan tanda hubung (-).

Nama harus dimulai dan diakhiri dengan huruf kecil atau angka.

Nama harus terdiri dari 3 hingga 63 karakter.

migratetest

Region

Wilayah tempat bucket berada. Jika Anda mengunggah data ke bucket dari instance ECS melalui jaringan internal dan memulihkan data ke instance ApsaraDB RDS melalui jaringan internal, bucket, instance ECS, dan instance ApsaraDB RDS harus berada di wilayah yang sama.

China (Hangzhou)

Storage Class

Pilih Standard. Operasi migrasi dalam topik ini tidak mendukung bucket dengan kelas penyimpanan lainnya.

Standard

Unggah file cadangan ke OSS.

Setelah mencadangkan database lokal, unggah file cadangan ke bucket OSS yang berada di wilayah yang sama dengan instance ApsaraDB RDS Anda. Jika bucket dan instance berada di wilayah yang sama, Anda dapat menggunakan jaringan internal untuk interkoneksi layanan. Metode ini bebas biaya untuk lalu lintas keluar internet dan memberikan kecepatan unggah data yang lebih cepat. Anda dapat menggunakan salah satu metode berikut:

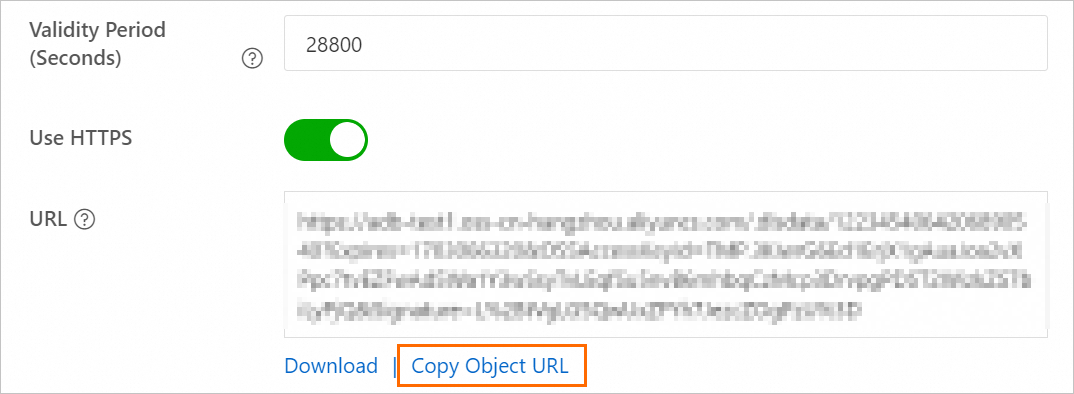

Tetapkan periode validitas untuk tautan file cadangan dan dapatkan URL file tersebut.

Login ke konsol OSS.

Klik Buckets. Lalu, klik nama bucket tujuan.

Pada panel navigasi di sebelah kiri, pilih File Management > Files.

Pada kolom Tindakan untuk file cadangan database tujuan, klik Details. Pada panel yang muncul, atur Expiration (Seconds) menjadi 28800 (8 jam).

PentingSaat Anda memigrasikan file cadangan dari OSS ke ApsaraDB RDS, Anda harus menggunakan URL file cadangan tersebut. Migrasi data gagal jika tautan kedaluwarsa.

Klik Copy File URL untuk menyalin URL file.

Ubah URL file cadangan data yang diperoleh.

Secara default, titik akhir publik file diambil. Untuk memigrasikan data melalui jaringan internal, Anda harus mengubah titik akhir dalam URL file menjadi titik akhir internal.

Sebagai contoh, jika URL file cadangan adalah

http://rdstest.oss-cn-shanghai.aliyuncs.com/testmigraterds_20170906143807_FULL.bak?Expires=15141****&OSSAccessKeyId=TMP****, Anda harus mengubahoss-cn-shanghai.aliyuncs.comdalam URL menjadioss-cn-shanghai-internal.aliyuncs.com.PentingTitik akhir internal bervariasi berdasarkan jenis jaringan dan wilayah. Untuk informasi selengkapnya, lihat Titik Akhir dan Pusat Data.

3. Impor data cadangan OSS ke ApsaraDB RDS

Pilih metode berdasarkan versi instance ApsaraDB RDS untuk SQL Server Anda.

SQL Server 2012 atau versi lebih baru, atau SQL Server 2008 R2 dengan disk cloud

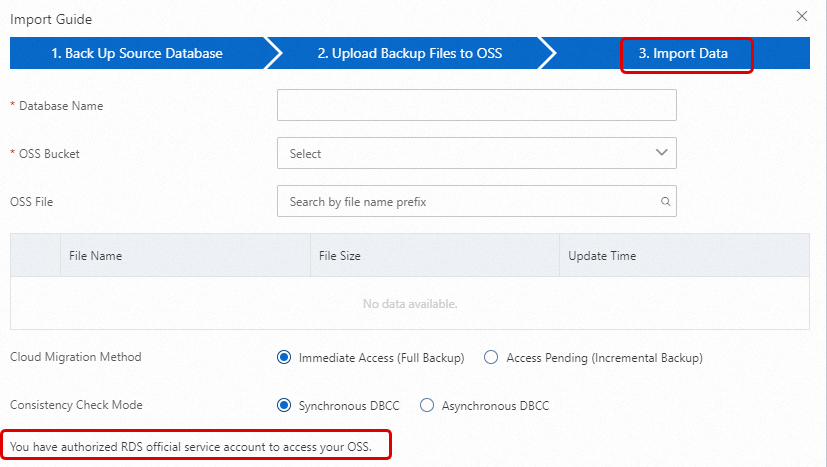

Buka halaman Instances. Pada bilah navigasi atas, pilih wilayah tempat instance RDS berada. Lalu, temukan instance RDS dan klik ID instance tersebut.

Pada panel navigasi di sebelah kiri, klik Backup and Restore.

Di bagian atas halaman, klik tombol Restore From OSS Backup.

Pada Data Import Wizard, klik Next dua kali untuk melanjutkan ke langkah impor data.

CatatanSaat pertama kali menggunakan fitur Restore from OSS Backup, Anda harus memberikan otorisasi kepada ApsaraDB RDS untuk mengakses OSS. Klik Authorization URL dan berikan izin yang diperlukan. Jika otorisasi ini tidak diberikan, daftar drop-down OSS Bucket akan kosong.

Jika Anda tidak dapat menemukan file tujuan pada halaman ini, periksa apakah ekstensi nama file cadangan di OSS memenuhi persyaratan. Untuk informasi selengkapnya, lihat bagian Catatan dalam topik ini. Pastikan juga instance ApsaraDB RDS dan bucket OSS berada di wilayah yang sama.

Atur parameter berikut.

Item konfigurasi

Deskripsi

Database Name

Masukkan nama database tujuan pada instance RDS Anda. Database tujuan digunakan untuk menyimpan data yang dimigrasikan dari database sumber pada instance SQL Server yang dikelola sendiri. Nama database tujuan harus memenuhi persyaratan SQL Server open source.

PentingSebelum migrasi, Anda harus memastikan bahwa nama database pada instance RDS tujuan berbeda dari nama database yang ingin Anda pulihkan menggunakan file cadangan yang ditentukan. Selain itu, pastikan file database dengan nama yang sama seperti database yang ingin Anda pulihkan menggunakan file cadangan yang ditentukan tidak ditambahkan ke database pada instance RDS tujuan. Jika kedua persyaratan di atas terpenuhi, Anda dapat memulihkan database menggunakan file database dalam set cadangan. Perhatikan bahwa file database harus memiliki nama yang sama dengan database yang ingin Anda pulihkan.

Jika database dengan nama yang sama seperti database yang ditentukan dalam file cadangan sudah ada pada instance tujuan, atau jika ada file database yang tidak terpasang dengan nama yang sama, operasi pemulihan akan gagal.

OSS Bucket

Pilih bucket OSS tempat file cadangan disimpan.

OSS File List

Klik tombol

di sebelah kanan untuk melakukan pencarian fuzzy berdasarkan awalan nama file cadangan. Nama file, ukuran file, dan waktu pembaruan ditampilkan. Pilih file cadangan yang ingin Anda migrasikan.

di sebelah kanan untuk melakukan pencarian fuzzy berdasarkan awalan nama file cadangan. Nama file, ukuran file, dan waktu pembaruan ditampilkan. Pilih file cadangan yang ingin Anda migrasikan.Migration Solution

Open database (only one full backup file): Opsi ini untuk migrasi penuh dan cocok untuk skenario di mana hanya satu file cadangan penuh yang dimigrasikan. Dalam kasus ini, pilih Open Database. Parameter BackupMode dalam operasi CreateMigrateTask diatur ke

FULL, dan parameter IsOnlineDB diatur keTrue.Do not open database (differential backups or log files exist): Opsi ini untuk migrasi inkremental dan cocok untuk skenario di mana file cadangan penuh ditambah cadangan log (atau file cadangan diferensial) dimigrasikan. Dalam kasus ini, parameter BackupMode dalam operasi CreateMigrateTask diatur ke

UPDF, dan parameter IsOnlineDB diatur keFalse.

Consistency Check Method

Asynchronously execute DBCC: Sistem tidak menjalankan DBCC CheckDB saat membuka database. Sebaliknya, sistem menjalankan DBCC CheckDB secara asinkron setelah database dibuka. Ini mengurangi overhead waktu membuka database (DBCC CheckDB sangat memakan waktu untuk database besar) dan meminimalkan downtime bisnis Anda. Jika Anda sangat sensitif terhadap downtime bisnis dan tidak peduli dengan hasil DBCC CheckDB, kami sarankan Anda menggunakan opsi ini. Dalam kasus ini, parameter CheckDBMode dalam operasi CreateMigrateTask diatur ke

AsyncExecuteDBCheck.Synchronously execute DBCC: Dibandingkan dengan eksekusi asinkron, beberapa pengguna sangat memperhatikan hasil DBCC CheckDB untuk mengidentifikasi kesalahan konsistensi data di database on-premises mereka. Dalam kasus ini, kami sarankan Anda memilih opsi ini. Dampaknya adalah akan memperpanjang waktu yang dibutuhkan untuk membuka database. Dalam kasus ini, parameter CheckDBMode dalam operasi CreateMigrateTask diatur ke

SyncExecuteDBCheck.

Klik OK.

Tunggu hingga tugas migrasi selesai. Anda dapat mengklik Refresh untuk memeriksa status tugas. Jika tugas gagal, gunakan deskripsinya untuk memecahkan masalah. Untuk informasi selengkapnya, lihat bagian Kesalahan umum dalam topik ini.

CatatanSetelah migrasi data selesai, sistem mencadangkan instance ApsaraDB RDS pada waktu cadangan yang ditentukan berdasarkan kebijakan pencadangan otomatis. Anda dapat menyesuaikan waktu pencadangan secara manual. Set cadangan yang dihasilkan berisi data yang dimigrasikan dan tersedia di halaman Backup and Restoration instance ApsaraDB RDS.

Untuk menghasilkan cadangan di cloud sebelum waktu pencadangan terjadwal, Anda juga dapat melakukan pencadangan manual.

SQL Server 2008 R2 dengan disk lokal berkinerja-tinggi

Login ke konsol ApsaraDB RDS dan buka halaman Instances. Pada bilah navigasi atas, pilih wilayah tempat instance RDS berada. Lalu, temukan instance RDS dan klik ID instance tersebut.

Pada panel navigasi kiri, klik Database Management.

Untuk database tujuan, klik Import From OSS Backup File pada kolom Actions.

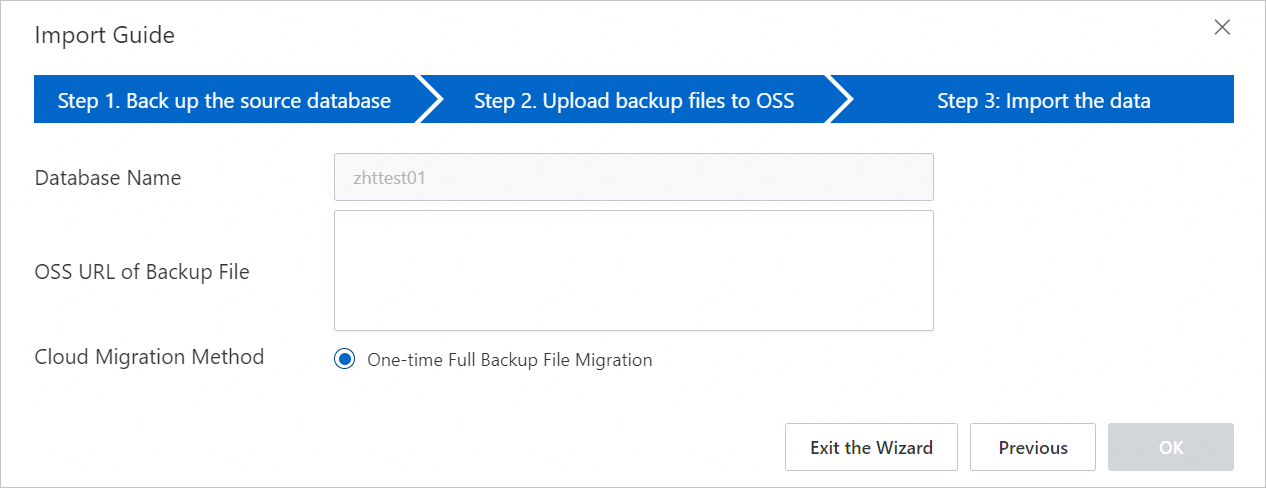

Pada kotak dialog Data Import Wizard, tinjau informasi dan klik Next.

Tinjau petunjuk untuk unggah OSS dan klik Next.

Pada kolom OSS URL Of Backup File, masukkan URL OSS file cadangan dan klik OK.

Catatan

CatatanInstance ApsaraDB RDS untuk SQL Server 2008 R2 dengan disk lokal berkinerja tinggi hanya mendukung impor satu kali file cadangan penuh.

4. Lihat progres migrasi

Pilih metode berdasarkan versi instance ApsaraDB RDS untuk SQL Server Anda.

SQL Server 2012 atau versi lebih baru, atau SQL Server 2008 R2 dengan disk cloud

Buka halaman Backup and Restoration instance ApsaraDB RDS. Pada tab Data Migration to Cloud Records, Anda dapat melihat catatan migrasi, termasuk status tugas, waktu mulai, dan waktu selesai. Secara default, catatan dari minggu lalu ditampilkan. Anda dapat menyesuaikan rentang waktu sesuai kebutuhan.

Jika Task Status adalah Failed, periksa Task Description atau klik View File Details untuk mengidentifikasi penyebab kegagalan. Setelah menyelesaikan masalah, jalankan ulang tugas migrasi data.

SQL Server 2008 R2 dengan disk lokal berkinerja-tinggi

Pada halaman Data Migration To Cloud instance ApsaraDB RDS, temukan tugas migrasi tujuan untuk melihat progresnya.

Jika Task Status adalah Failed, periksa Task Description atau klik View File Details untuk menentukan penyebab kegagalan. Setelah menyelesaikan masalah, jalankan ulang tugas migrasi data.

Kesalahan umum

Setiap catatan migrasi berisi deskripsi tugas yang dapat Anda gunakan untuk mengidentifikasi penyebab kegagalan tugas. Berikut adalah pesan kesalahan umum:

Database dengan nama yang sama sudah ada

Pesan kesalahan 1: Database (xxx) sudah ada di RDS. Harap cadangkan dan hapus, lalu coba lagi.

Pesan kesalahan 2: Database 'xxx' sudah ada. Pilih nama database yang berbeda.

Penyebab: Untuk memastikan keamanan data, ApsaraDB RDS untuk SQL Server tidak mendukung migrasi database dengan nama yang sama seperti database yang sudah ada.

Solusi: Untuk menimpa database yang sudah ada, cadangkan data yang ada, hapus database tersebut, lalu jalankan ulang tugas migrasi data.

Menggunakan file cadangan diferensial

Pesan kesalahan: Backup set (xxx.bak) is a Database Differential backup, we only accept a FULL Backup.

Penyebab: File cadangan yang diberikan adalah cadangan diferensial, bukan cadangan penuh. Metode migrasi ini hanya mendukung file cadangan penuh.

Menggunakan file cadangan log

Pesan kesalahan: Set backup (xxx.trn) merupakan backup log transaksi; kami hanya menerima backup PENUH.

Penyebab: File cadangan yang diberikan adalah cadangan log, bukan cadangan penuh. Metode migrasi ini hanya mendukung file cadangan penuh.

Verifikasi file cadangan gagal

Pesan kesalahan: Gagal memverifikasi xxx.bak. File cadangan rusak atau berasal dari edisi RDS yang lebih baru.

Penyebab: File cadangan rusak, atau versi SQL Server database sumber lebih baru daripada versi instance ApsaraDB RDS untuk SQL Server tujuan. Ketidakcocokan versi ini menyebabkan verifikasi gagal. Misalnya, kesalahan ini dilaporkan saat Anda memulihkan cadangan SQL Server 2016 ke instance ApsaraDB RDS untuk SQL Server 2012.

Solusi: Jika file cadangan rusak, buat cadangan penuh baru dari database sumber lalu buat tugas migrasi baru. Jika versi tidak kompatibel, gunakan instance ApsaraDB RDS untuk SQL Server yang menjalankan versi yang sama atau lebih baru dari versi database sumber.

CatatanUntuk meningkatkan instance ApsaraDB RDS untuk SQL Server yang ada ke versi yang lebih baru, lihat Tingkatkan versi mesin database.

DBCC CHECKDB gagal

Pesan kesalahan: DBCC checkdb failed.

Penyebab: Terjadi kesalahan selama operasi DBCC CHECKDB, yang menunjukkan adanya kesalahan pada database sumber.

Solusi: Jalankan perintah berikut untuk memperbaiki kesalahan pada database sumber lalu migrasikan data lagi.

PentingMenjalankan perintah ini untuk memperbaiki kesalahan dapat menyebabkan kehilangan data.

DBCC CHECKDB (DBName, REPAIR_ALLOW_DATA_LOSS) WITH NO_INFOMSGS, ALL_ERRORMSGS

Ruang tidak mencukupi 1

Pesan kesalahan: Ruang disk tidak mencukupi untuk pemulihan; ruang tersisa (xxx MB) < ruang yang dibutuhkan (xxx MB).

Penyebab: Ruang penyimpanan tersisa pada instance ApsaraDB RDS tidak mencukupi untuk memigrasikan file cadangan.

Ruang tidak mencukupi 2

Pesan kesalahan: Not Enough Disk Space, space left xxx MB < bak file xxx MB.

Penyebab: Ruang penyimpanan tersisa pada instance ApsaraDB RDS lebih kecil dari ukuran file cadangan.

Izin akun login tidak mencukupi

Pesan kesalahan: Tidak dapat membuka database "xxx" yang diminta oleh login. Login gagal.

Penyebab: Akun pengguna yang digunakan untuk login ke instance ApsaraDB RDS tidak memiliki izin akses ke database.

Solusi: Pada halaman Account Management instance ApsaraDB RDS, berikan izin akses atau operasi database ke akun pengguna. Untuk informasi selengkapnya, lihat Berikan izin ke akun dan Izin yang didukung oleh berbagai jenis akun.

Tidak ada akun istimewa

Pesan kesalahan: RDS Anda belum memiliki akun init. Harap buat akun tersebut dan berikan izin di Konsol RDS pada database yang dimigrasikan ini (xxx).

Penyebab: Instance ApsaraDB RDS tidak memiliki akun istimewa, sehingga tugas migrasi data tidak tahu pengguna mana yang harus diberikan izin. Namun, file cadangan berhasil dipulihkan ke instance tujuan, sehingga status tugas berhasil.

Solusi: Buat akun istimewa.

Izin operasi pengguna RAM tidak mencukupi

Q1: Pada langkah 5 membuat tugas migrasi data, saya telah memasukkan semua parameter konfigurasi, tetapi tombol OK berwarna abu-abu. Mengapa?

A1: Tombol mungkin tidak tersedia karena Anda menggunakan pengguna RAM yang memiliki izin tidak mencukupi. Untuk informasi selengkapnya, lihat bagian Prasyarat dalam topik ini untuk memastikan izin yang diperlukan telah diberikan.

Q2: Saat saya menggunakan pengguna RAM untuk memberikan izin untuk

AliyunRDSImportRole, kesalahanpermission denieddikembalikan. Bagaimana cara menyelesaikannya?A2: Gunakan akun Alibaba Cloud Anda untuk sementara memberikan izin AliyunRAMFullAccess kepada pengguna RAM.

Pesan balasan umum

Jenis tugas | Status tugas | Deskripsi tugas | Deskripsi |

Impor satu kali file cadangan penuh | Success |

| Migrasi berhasil. |

Failed |

| Migrasi gagal karena URL unduhan OSS kedaluwarsa. | |

| Migrasi gagal karena file cadangan rusak atau berasal dari versi yang lebih baru daripada instance ApsaraDB RDS. | ||

| Migrasi gagal karena perintah DBCC CHECKDB gagal. | ||

| Migrasi gagal karena file tersebut adalah cadangan log. | ||

| Migrasi gagal karena file tersebut adalah cadangan diferensial. |

Operasi API terkait

API | Deskripsi |

Memulihkan file cadangan dari OSS ke instance ApsaraDB RDS untuk SQL Server dan membuat tugas migrasi data. | |

Membuka database dari tugas migrasi data ApsaraDB RDS untuk SQL Server. | |

Menanyakan daftar tugas migrasi data untuk instance ApsaraDB RDS untuk SQL Server. | |

Menanyakan detail file dari tugas migrasi data ApsaraDB RDS untuk SQL Server. |

, pilih file cadangan yang ingin Anda unggah, lalu klik Open. File lokal diunggah ke OSS.

, pilih file cadangan yang ingin Anda unggah, lalu klik Open. File lokal diunggah ke OSS.