JMeter adalah alat pengujian kinerja open source yang dikembangkan oleh Apache. Alat ini mendukung fitur seperti parameterisasi dan asersi. Dengan ekosistem open-source yang luas, Apache JMeter menyediakan berbagai macam ekstensi protokol dan kontroler, serta kemampuan untuk menulis skrip kustom untuk penanganan parameter. Di PTS, Anda dapat langsung menggunakan JMeter untuk pengujian kinerja. Ekspansi sumber daya tanpa batas dan integrasi dengan pemantauan cloud meningkatkan kemampuan JMeter dalam mensimulasikan konkurensi tinggi dan mengidentifikasi hambatan serta masalah. Topik ini menjelaskan manfaat dan prosedur pengujian kinerja JMeter di PTS.

Langkah 1: Buat skenario JMeter

Unggah file pengujian JMeter.

Masuk ke Konsol PTS, pilih , lalu klik JMeter.

Dalam kotak dialog Create a JMeter Scenario, masukkan Scenario Name.

Dalam bagian Scenario Settings, unggah file pengujian JMeter dalam format YAML. Nama file harus berakhiran

jmxdan tidak boleh mengandung spasi.Setelah file diunggah, PTS secara otomatis menyelesaikan Plugin. Untuk informasi lebih lanjut, lihat Penyelesaian Otomatis Plugin JMeter.

Klik Unggah File untuk mengunggah file lainnya, seperti file data dalam format CSV dan plugin dalam format JAR.

PentingFile-file ini mungkin menimpa file yang sebelumnya diunggah dengan nama yang sama. Untuk memastikan apakah akan menimpa, Anda dapat melihat nilai hash MD5 dari file di kolom Actions dan membandingkannya dengan nilai hash MD5 file lokal Anda.

Limits:

JMX script file: Ukuran file tidak boleh melebihi 2 MB. Anda dapat mengunggah beberapa file skrip JMX. Namun, Anda hanya dapat menggunakan satu file skrip JMX untuk pengujian JMeter. Anda harus memilih satu file skrip JMX sebelum memulai pengujian.

JAR file: Ukuran file tidak boleh melebihi 10 MB. Debug file JAR yang akan diunggah di lingkungan JMeter lokal untuk memastikan debugging berhasil.

CSV file: Ukuran file CSV tidak boleh melebihi 60 MB. Anda dapat menggunakan fitur Sumber Data OSS untuk mengunggah file lebih besar dari 60 MB. Jumlah total file non-JMX tidak boleh melebihi 20.

PentingJangan langsung mengubah akhiran file XLSX menjadi CSV. Kami sarankan Anda menggunakan Excel, Numbers, dan perangkat lunak lainnya untuk mengekspor file CSV atau menggunakan Apache Commons CSV untuk menghasilkan file CSV.

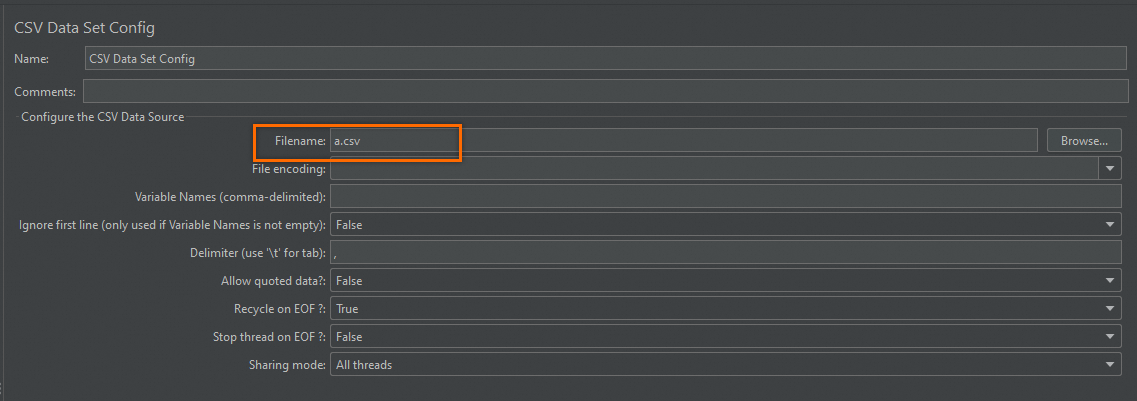

Jika file data terkait dengan skrip JMX, Anda harus memasukkan nama file di Filename di CSV Data Set Config. The file name cannot contain the file path. Gambar berikut menunjukkan contohnya. Jika tidak, file data tidak dapat dibaca. Demikian juga, jika Anda menggunakan __CSVRead untuk membaca data dari file CSV atau menentukan file dalam paket JAR, Anda harus memasukkan nama file.

Jika Anda telah mengunggah beberapa file JMX, Anda harus memilih satu file JMX sebagai skrip JMeter yang digunakan untuk memulai pengujian JMeter.

(Opsional) Pilih Split File untuk file CSV untuk memastikan bahwa data dalam file unik untuk setiap generator beban. Jika tidak, data yang sama akan digunakan di generator yang berbeda. Untuk informasi lebih lanjut, lihat Gunakan File Parameter CSV di JMeter.

(Opsional) Jika skrip yang Anda unggah berisi komponen adaptasi terdistribusi, seperti timer dan kontroler, Anda dapat mengonfigurasi komponen-komponen ini berdasarkan alamat IP yang berbeda dari beberapa pengujian JMeter. Ini membantu memastikan pengujian kinerja yang akurat dan efektif.

Atur Synchronous Timer. Jika timer disediakan dalam skrip JMeter yang diunggah, Anda harus mengonfigurasi parameter timer ke Global atau Single Generator.

Atur Constant Throughput Timer. Jika kontroler disediakan dalam skrip JMeter yang diunggah, Anda harus mengonfigurasi parameter kontroler ke Global atau Single Generator. Untuk informasi lebih lanjut, lihat Contoh Penggunaan Terdistribusi Timer Laju Konstan.

Tentukan apakah akan mengaktifkan Use Dependency Environment. Untuk informasi lebih lanjut, lihat Manajemen Lingkungan JMeter.

Jika Anda memilih Yes, Anda harus memilih lingkungan yang ada.

Jika Anda memilih No, Anda harus memilih versi JMeter. Apache JMeter 5.0 dan Java 11 didukung.

Konfigurasi Beban

Untuk informasi lebih lanjut tentang cara menyetel beban, lihat Konfigurasikan Model dan Level Beban.

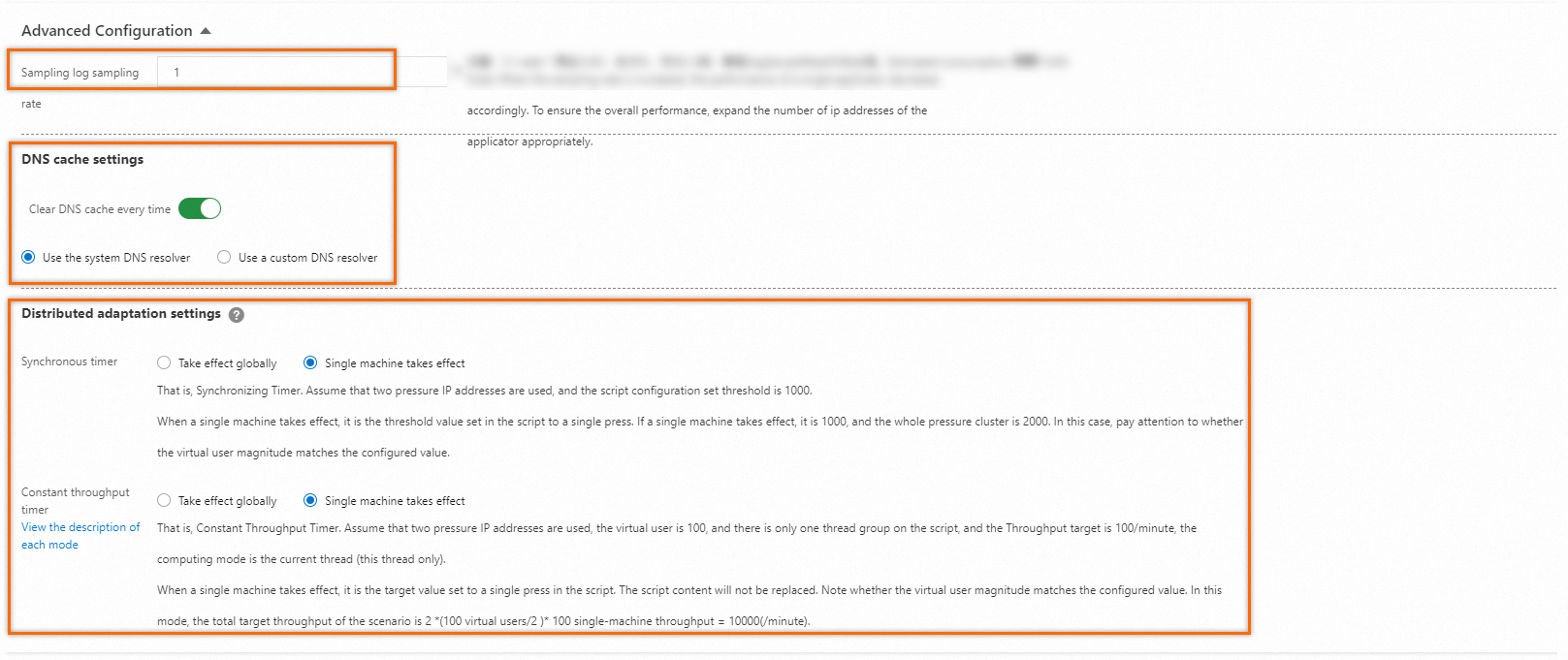

(Opsional) Pengaturan Lanjutan.

Pengaturan lanjutan mencakup pengaturan laju sampling log, konfigurasi DNS, dan pengaturan komponen adaptasi terdistribusi. Secara default, fitur ini dinonaktifkan. Anda dapat mengaktifkan fitur ini untuk melakukan konfigurasi.

Status dengan pengaturan lanjutan dinonaktifkan

Dalam hal ini, konfigurasi default didukung. Laju sampling log adalah 1%. Auto DNS Cache Clear dinonaktifkan untuk setiap siklus. Gunakan resolver DNS default. Baik timer sinkronisasi maupun timer laju konstan berlaku untuk pengujian tunggal.

Status dengan pengaturan lanjutan diaktifkan

Pengaturan Laju Sampling Log

Laju sampling default adalah 1%. Anda dapat menentukan laju sampling log. Untuk mengurangi laju sampling, masukkan nilai dalam interval

(0,1]. Untuk meningkatkan laju sampling, masukkan angka yang habis dibagi 10 dalam interval(1,50], misalnya 20.PentingJika Anda menentukan laju sampling lebih dari 1%, biaya tambahan akan dikenakan. Misalnya, jika Anda menyetel laju sampling ke 20%, biaya tambahan sebesar 20%×VUM akan dikenakan. Untuk informasi lebih lanjut, lihat Bayar Sesuai Pemakaian.

Pengaturan Cache DNS

Anda dapat memilih apakah akan membersihkan cache DNS untuk setiap permintaan akses. Anda dapat menggunakan resolver DNS default atau resolver DNS kustom untuk membersihkan cache DNS.

Situasi di mana Anda mungkin perlu menggunakan resolver DNS kustom:

Pengujian Kinerja di Internet

Untuk menguji layanan di Internet, Anda dapat mengikat nama domain publik layanan ke alamat IP lingkungan pengujian untuk mengisolasi trafik pengujian dari trafik online.

Pengujian Kinerja di VPC Alibaba Cloud

Untuk menguji layanan di VPC Alibaba Cloud, Anda dapat mengikat nama domain API ke alamat internal VPC. Untuk informasi lebih lanjut, lihat Pengujian Kinerja di VPC Alibaba Cloud.

Pengaturan Komponen Adaptasi Terdistribusi

Jika skrip yang Anda unggah berisi komponen adaptasi terdistribusi, seperti timer dan kontroler, Anda dapat mengonfigurasi komponen-komponen ini berdasarkan alamat IP yang berbeda dari beberapa pengujian JMeter. Ini membantu memastikan pengujian kinerja yang akurat dan efektif.

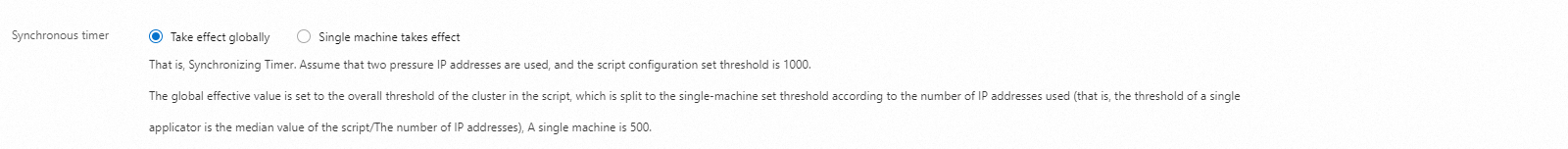

Atur Timer Sinkronisasi. Jika timer disediakan dalam skrip JMeter yang diunggah, Anda harus mengonfigurasi parameter timer ke Global atau Generator Tunggal.

Global menentukan bahwa ambang batas dalam skrip berlaku sebagai ambang batas total semua generator beban. Ambang batas untuk generator tunggal = (Ambang batas dalam skrip)/(Jumlah alamat IP). Sebagai contoh, dua alamat IP digunakan, dan ambang batas adalah 1.000 dalam skrip. Dalam contoh ini, ambang batas untuk generator tunggal adalah 500.

Generator Tunggal menentukan bahwa ambang batas dalam skrip berlaku untuk setiap generator beban, yang tidak menimpa skrip. Perhatikan bahwa jumlah pengguna konkuren harus sesuai dengan nilai yang dikonfigurasi. Sebagai contoh, dua alamat IP digunakan, dan ambang batas adalah 1.000 dalam skrip. Dalam contoh ini, ambang batas untuk generator tunggal dan untuk semua generator masing-masing adalah 1.000 dan 2.000.

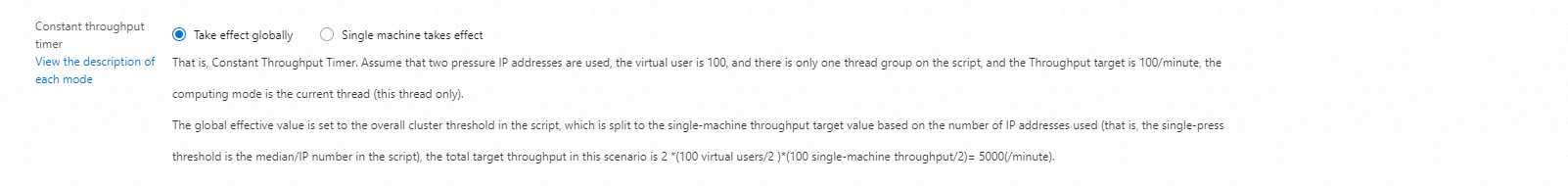

Atur Timer Laju Konstan. Jika kontroler disediakan dalam skrip JMeter yang diunggah, Anda harus mengonfigurasi parameter kontroler ke Global atau Generator Tunggal.

Global menentukan bahwa ambang batas dalam skrip berlaku sebagai ambang batas total semua generator beban. Ambang batas untuk generator tunggal = (Ambang batas dalam skrip)/(Jumlah alamat IP). Anggaplah pengujian kinerja menggunakan dua alamat IP untuk mensimulasikan 100 pengguna konkuren dalam grup utas. Dalam skrip, laju throughput target diatur ke 100 permintaan per menit dalam mode Hanya Utas Ini. Dalam hal ini, total target TPS per menit dari skenario adalah 2 × (100 pengguna konkuren/2) × (100/2) = 5.000.

Generator Tunggal menentukan bahwa ambang batas dalam skrip berlaku untuk setiap generator beban, yang tidak menimpa skrip. Perhatikan bahwa jumlah pengguna konkuren harus sesuai dengan nilai yang dikonfigurasi. Anggaplah pengujian kinerja menggunakan dua alamat IP untuk mensimulasikan 100 pengguna konkuren dalam grup utas. Dalam skrip, laju throughput target diatur ke 100 permintaan per menit dalam mode Hanya Utas Ini. Dalam hal ini, total target TPS per menit dari skenario adalah 2 × (100 pengguna konkuren/2) × 100 = 10.000.

(Opsional) Tambahkan Pemantauan Sumber Daya Cloud.

Anda dapat mengaktifkan fitur ini untuk melihat data pemantauan yang sesuai dalam laporan pengujian selama pengujian. Secara default, fitur ini dinonaktifkan. Anda perlu mengaktifkan fitur ini secara manual.

(Opsional) Tambahkan Informasi Tambahan.

Anda dapat menambahkan pemilik pengujian kinerja dan catatan terkait. Secara default, fitur ini dinonaktifkan. Anda perlu mengaktifkan fitur ini secara manual.

Langkah 2: Mulai pengujian

Untuk memastikan pengujian kinerja yang lancar, Anda dapat memeriksa konektivitas jaringan, integritas plugin, dan konfigurasi skrip dalam skenario debug.Untuk men-debug skenario, klik Debug Scenario. Untuk informasi lebih lanjut, lihat Debug Skenario.

Klik Save and Start. Di halaman Tips, pilih Execute Now dan klik The test is permitted and complies with the applicable laws and regulations, lalu klik Start.

(Opsional) Anda dapat memantau data pengujian kinerja dan menyesuaikan kecepatan pengujian.

Data Information

Informasi Data

Deskripsi

Real-time VUM

Jumlah total sumber daya yang dikonsumsi oleh setiap pengujian kinerja. Unit: VUM (per pengguna virtual per menit).

Request Success Rate (%)

Tingkat keberhasilan semua permintaan skenario untuk semua agen dalam periode statistik.

Average RT (Successful requests/Failed requests)

RT Rata-rata Berhasil (ms): RT rata-rata dari semua permintaan yang berhasil.

RT Rata-rata Gagal (ms): RT rata-rata dari semua permintaan yang gagal.

TPS

Sama dengan jumlah total permintaan untuk semua agen dalam periode statistik dibagi dengan durasi (unit: detik (s)).

Number of Exceptions

Jumlah pengecualian permintaan. Pengecualian permintaan terjadi karena berbagai penyebab, termasuk timeout koneksi dan timeout permintaan.

Traffic (request/response)

Trafik yang dikonsumsi oleh generator beban untuk mengirim permintaan dan menerima respons.

Concurrency (current/maximum)

Konkurensi untuk pengujian beban. Jika Penyesuaian Kecepatan dikonfigurasi untuk pengujian kinerja, sistem akan menampilkan konkurensi saat ini dan konkurensi maksimum yang dikonfigurasi. Jika konkurensi maksimum yang dikonfigurasi tidak tercapai selama fase pemanasan, konkurensi saat ini digunakan sebagai konkurensi yang dikonfigurasi setelah pemanasan selesai.

Klik Speed Regulation dan masukkan jumlah permintaan konkuren yang diperlukan. Anda dapat menyesuaikan jumlah selama pengujian.

Total Requests

Jumlah total permintaan yang dikirim selama pengujian kinerja untuk skenario.

CatatanAgregat dan hitung sumber data pemantauan dengan Backend Listener. Periode waktu untuk sampling statistik dan agregasi data adalah 15 detik. Oleh karena itu, latensi data mungkin terjadi.

Settings

Halaman ini mencantumkan informasi dasar dalam konfigurasi skenario, termasuk sumber beban, durasi konfigurasi, model trafik, dan jumlah alamat IP yang ditentukan.

Load testing

Di tab Test Details, klik View Chart di sebelah kanan tautan untuk melihat data real-time seperti TPS, tingkat keberhasilan, waktu respons, dan trafik.

Klik tab Load Generator Performance untuk melihat kurva deret waktu dari utilitas CPU, Load 5, utilitas memori, dan trafik jaringan untuk semua generator beban. Anda dapat melihat performa berdasarkan jenis generator.

Jika Anda telah menambahkan pemantauan ECS, pemantauan SLB, pemantauan RDS, dan pemantauan ARMS, Anda dapat mengklik tab Cloud Resource Monitoring untuk melihat informasi pemantauan untuk setiap generator.

Sampling Log

Di tab Sampling Logs, Anda dapat memfilter log berdasarkan Sampler, status respons, dan rentang RT selama pengujian, serta melihat detail log.

Filter log berdasarkan Sampler dan status respons selama pengujian. Klik View Details di kolom Actions yang sesuai dengan log.

Di tab General dari kotak dialog Log Details, lihat bidang log dan nilai bidang. Di sudut kanan atas kotak dialog, ubah format tampilan: Common atau HTTP.

Jika Embedded Resources from HTML Files dikonfigurasi dalam skrip JMeter, tab Sub-request Details akan muncul dalam detail log.

Anda dapat memilih sub-permintaan tertentu untuk memfilter log permintaan yang sesuai.

Tab Timing Waterfall menampilkan waktu yang dikonsumsi untuk semua permintaan dan untuk setiap sub-permintaan.

Tab Trace View merinci jejak hulu dan hilir dari API pengujian.

Langkah 3: Lihat laporan pengujian

Setelah pengujian dihentikan, sistem secara otomatis mengumpulkan data selama pengujian dan membentuk laporan. Laporan ini mencakup berbagai skenario JMeter dan tren dinamis untuk skenario-skenario tersebut.

Masuk ke Konsol PTS dan pilih .

Di halaman Report List, pilih skenario dari daftar drop-down. Temukan laporan yang ingin Anda lihat dan klik View Report di kolom Actions. Untuk informasi lebih lanjut, lihat Lihat Laporan Pengujian JMeter.

CatatanDalam grafik tren, periode sampling data statistik untuk setiap titik adalah 15 detik, dan laporan data akhir mungkin menunjukkan latensi data di awal. Jumlah hari maksimum untuk penyimpanan data laporan adalah 30 hari. Jika perlu, Anda dapat mengekspor laporan ke komputer Anda.

(Opsional) Langkah 4: Ekspor laporan pengujian

Anda dapat mengekspor laporan pengujian saat ini ke komputer Anda.

Di halaman Report Details, klik Export Report.

Pilih Watermark Version atau No Watermark Version, dan unduh laporan pengujian (PDF) ke komputer Anda.

Contoh skenario

Anda dapat menggunakan pengujian kinerja JMeter dalam skenario berikut:

Skenario di mana pengujian terdistribusi konkurensi tinggi diperlukan.

Skenario di mana pemantauan presisi tinggi real-time diperlukan selama pengujian, dan laporan pengujian dihasilkan secara otomatis setelah pengujian selesai.

Skenario di mana skrip JMeter dan file dependensi lingkungan JMeter perlu dikelola.

Untuk informasi lebih lanjut tentang cara menggunakan JMeter, lihat Gunakan JMeter untuk Mensimulasikan Unggahan.