Pelatihan dan inferensi model bahasa besar (LLM) memerlukan konsumsi energi tinggi serta waktu respons yang lama, sehingga membatasi penerapannya di lingkungan dengan sumber daya terbatas. Untuk mengatasi tantangan tersebut, PAI menyediakan fitur distilasi model yang mentransfer pengetahuan dari LLM ke model yang lebih kecil, sehingga secara signifikan mengurangi ukuran model dan kebutuhan sumber daya komputasi sambil mempertahankan sebagian besar performanya. Hal ini memungkinkan penerapan dalam berbagai skenario aplikasi dunia nyata yang lebih luas. Topik ini menjelaskan alur kerja pengembangan lengkap solusi augmentasi data dan distilasi model untuk LLM, menggunakan LLM Qwen2 sebagai contoh.

Alur kerja

Alur kerja pengembangan solusi adalah sebagai berikut:

Siapkan set data pelatihan sesuai persyaratan format data dan strategi persiapan data.

(Opsional) Tambahkan instruksi menggunakan model augmentasi instruksi

Di PAI-Model Gallery, Anda dapat menggunakan model augmentasi instruksi bawaan Qwen2-1.5B-Instruct-Exp atau Qwen2-7B-Instruct-Exp untuk secara otomatis menghasilkan lebih banyak instruksi berdasarkan semantik set data yang telah Anda siapkan. Augmentasi instruksi membantu meningkatkan generalisasi pelatihan distilasi untuk LLM.

(Opsional) Optimalkan instruksi menggunakan model optimisasi instruksi

Di PAI-Model Gallery, Anda dapat menggunakan model optimisasi instruksi bawaan Qwen2-1.5B-Instruct-Refine atau Qwen2-7B-Instruct-Refine untuk mengoptimalkan dan memperbaiki instruksi (serta instruksi yang telah diaugmentasi) dalam set data yang telah Anda siapkan. Optimisasi instruksi membantu meningkatkan kemampuan generasi bahasa LLM.

Terapkan LLM guru untuk menghasilkan tanggapan yang sesuai

Di PAI-Model Gallery, Anda dapat menggunakan LLM guru bawaan Qwen2-72B-Instruct untuk menghasilkan tanggapan terhadap instruksi dalam set data pelatihan. Proses ini menyuling pengetahuan dari LLM guru.

Mendistilasi dan melatih model siswa yang lebih kecil

Di PAI-Model Gallery, Anda dapat menggunakan set data instruksi-tanggapan yang dihasilkan untuk menyuling dan melatih model siswa yang lebih kecil guna digunakan dalam skenario aplikasi dunia nyata.

Prasyarat

Sebelum memulai, lengkapi persiapan berikut:

Deep Learning Containers (DLC) dan EAS dari PAI diaktifkan dengan basis bayar sesuai penggunaan dan ruang kerja default telah dibuat. Untuk informasi selengkapnya, lihat Aktifkan PAI dan buat ruang kerja default.

Bucket Object Storage Service (OSS) telah dibuat untuk menyimpan data pelatihan dan file model yang diperoleh dari pelatihan model. Untuk informasi tentang cara membuat bucket, lihat Panduan Cepat Mulai.

Siapkan data instruksi

Untuk informasi tentang cara menyiapkan data instruksi, lihat Strategi persiapan data dan Persyaratan format data.

Strategi persiapan data

Untuk meningkatkan efektivitas dan stabilitas distilasi model, siapkan data Anda berdasarkan strategi berikut:

Siapkan setidaknya beberapa ratus entri data. Set data yang lebih besar membantu meningkatkan efektivitas model.

Distribusi set data seed harus seluas dan seimbang mungkin. Misalnya, skenario tugas harus beragam, dan panjang input serta output data harus mencakup skenario pendek maupun panjang. Jika data mencakup lebih dari satu bahasa, seperti Bahasa Mandarin dan Bahasa Inggris, pastikan distribusi bahasa relatif seimbang.

Hapus data abnormal. Bahkan jumlah kecil data abnormal dapat berdampak signifikan pada hasil fine-tuning. Gunakan metode berbasis aturan untuk membersihkan data dan menyaring entri abnormal dari set data.

Persyaratan format data

Set data pelatihan harus berupa file JSON yang berisi bidang `instruction` untuk instruksi input. Kode berikut menunjukkan contoh data instruksi:

[

{

"instruction": "What were the main measures taken by governments to stabilize financial markets during the 2008 financial crisis?"

},

{

"instruction": "In the context of increasing climate change, what important actions have governments taken to promote sustainable development?"

},

{

"instruction": "What were the main measures taken by governments to support economic recovery during the bursting of the tech bubble in 2001?"

}

](Opsional) Tambahkan instruksi menggunakan model augmentasi instruksi

Augmentasi instruksi adalah teknik rekayasa prompt umum untuk LLM yang secara otomatis memperluas set data instruksi yang disediakan pengguna.

Sebagai contoh, jika Anda memberikan input berikut:

How to make fish-fragrant shredded pork? How to prepare for the GRE exam? What should I do if a friend misunderstands me?Output model adalah sebagai berikut:

Teach me how to make mapo tofu? Provide a detailed guide on how to prepare for the Test of English as a Foreign Language (TOEFL) exam? How will you adjust your mindset if you encounter setbacks in your work?

Karena keragaman instruksi secara langsung memengaruhi kemampuan generalisasi LLM, augmentasi instruksi dapat secara efektif meningkatkan performa model siswa akhir. Berdasarkan model dasar Qwen2, PAI menyediakan dua model augmentasi instruksi buatan sendiri: Qwen2-1.5B-Instruct-Exp dan Qwen2-7B-Instruct-Exp. Anda dapat menerapkan layanan model dengan satu klik di PAI-Model Gallery. Ikuti langkah-langkah berikut:

Terapkan layanan model

Ikuti langkah-langkah berikut untuk menerapkan model augmentasi instruksi sebagai layanan online EAS:

Buka halaman Model Gallery.

Login ke Konsol PAI.

Di pojok kiri atas, pilih Wilayah.

Di panel navigasi sebelah kiri, klik Workspaces. Klik nama ruang kerja target.

Di panel navigasi sebelah kiri, pilih .

Di halaman Model Gallery, cari Qwen2-1.5B-Instruct-Exp atau Qwen2-7B-Instruct-Exp di daftar model di sebelah kanan, lalu klik tombol Deploy pada kartu yang sesuai.

Di panel konfigurasi Deploy, informasi Model Service Information dan Resource Deployment Information telah dikonfigurasi secara default. Anda dapat mengubah parameter sesuai kebutuhan. Setelah selesai mengonfigurasi parameter, klik tombol Deploy.

Di kotak dialog Billing Notification, klik OK.

Anda akan dialihkan secara otomatis ke halaman Deployment Tasks. Status Running menandakan penyebaran yang berhasil.

Panggil layanan model

Setelah layanan model diterapkan, Anda dapat menggunakan API untuk inferensi model. Untuk informasi selengkapnya, lihat Terapkan model bahasa besar. Contoh berikut menunjukkan cara mengirim permintaan layanan model dari klien:

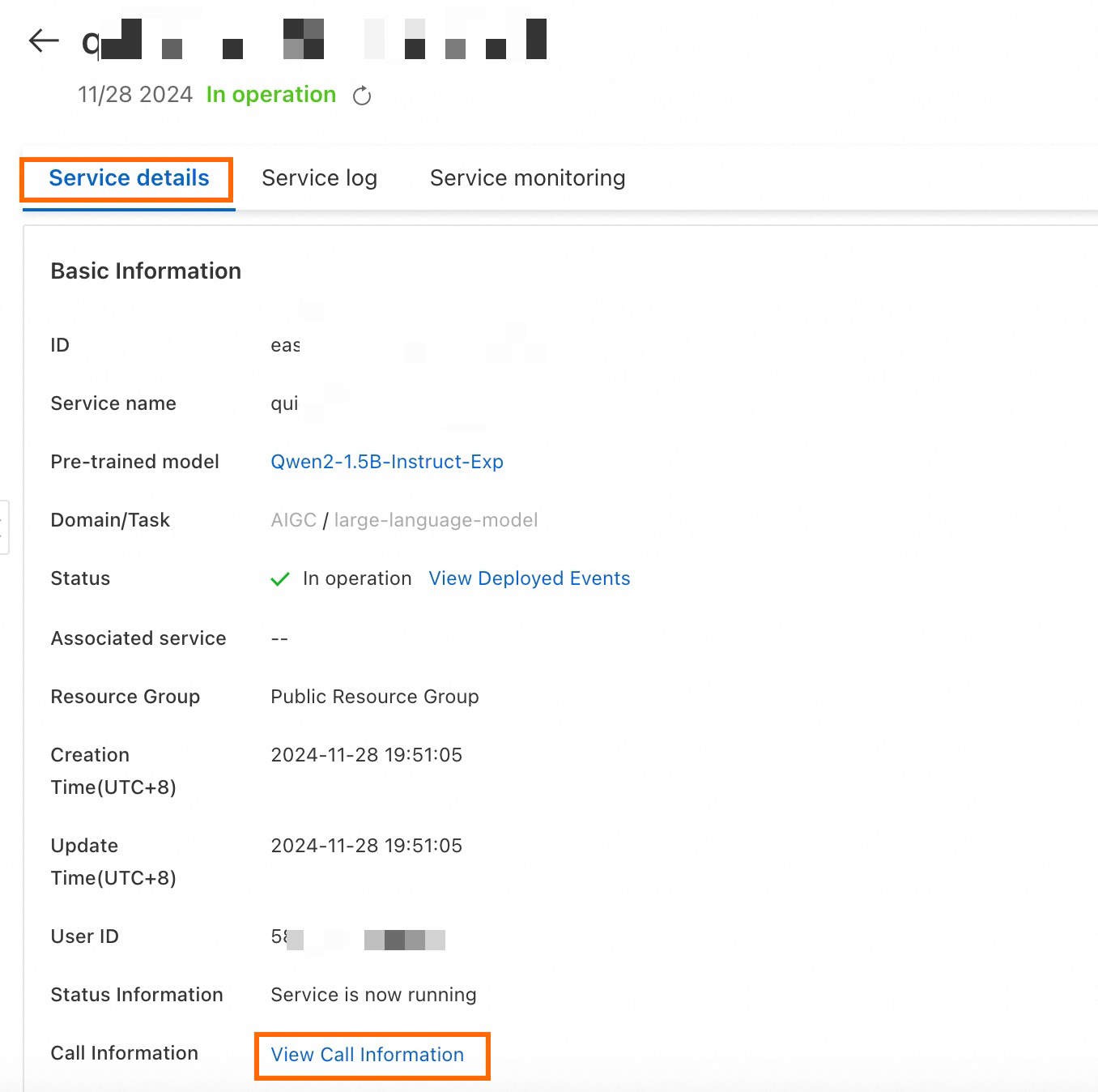

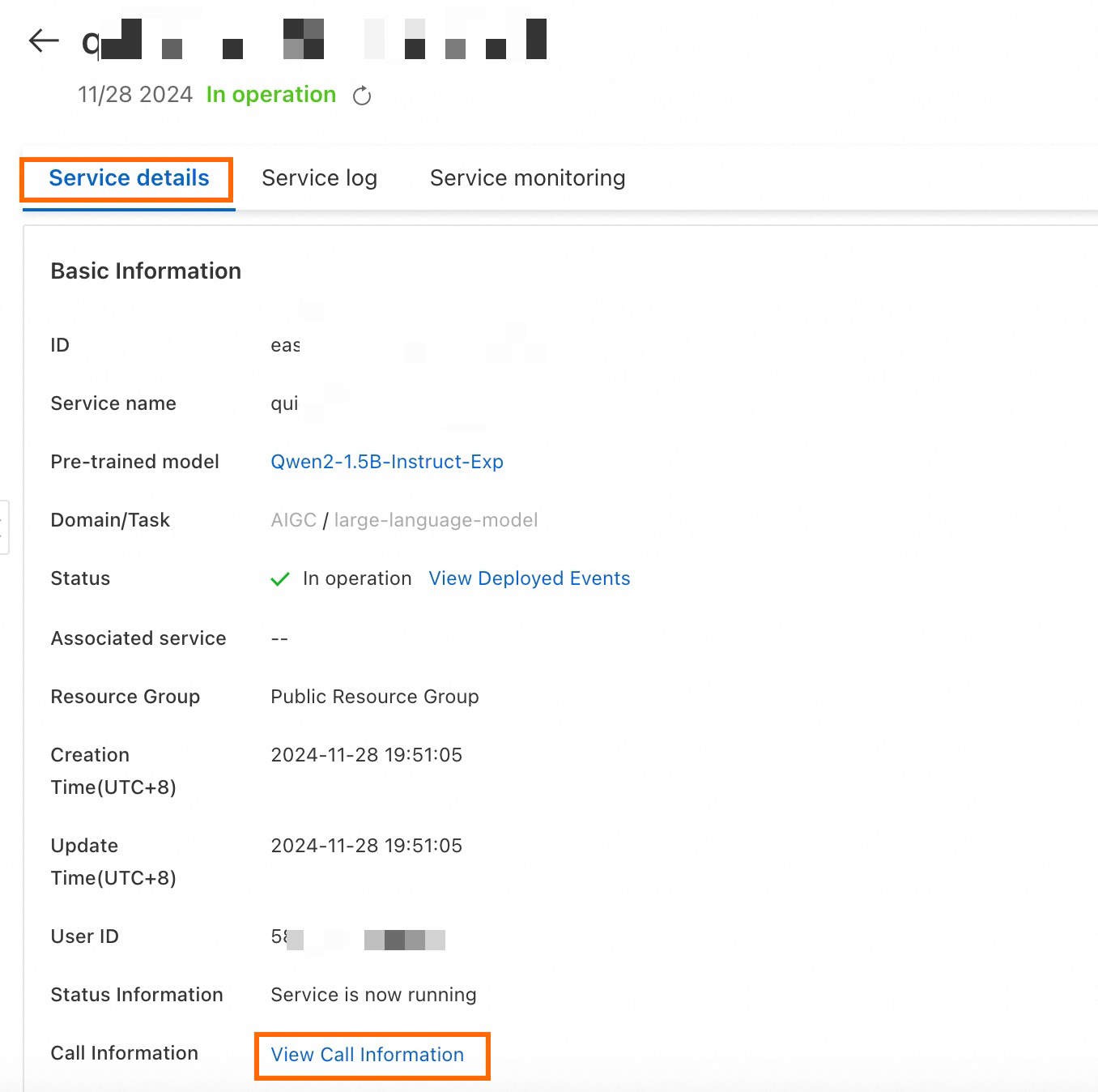

Dapatkan titik akhir layanan dan token.

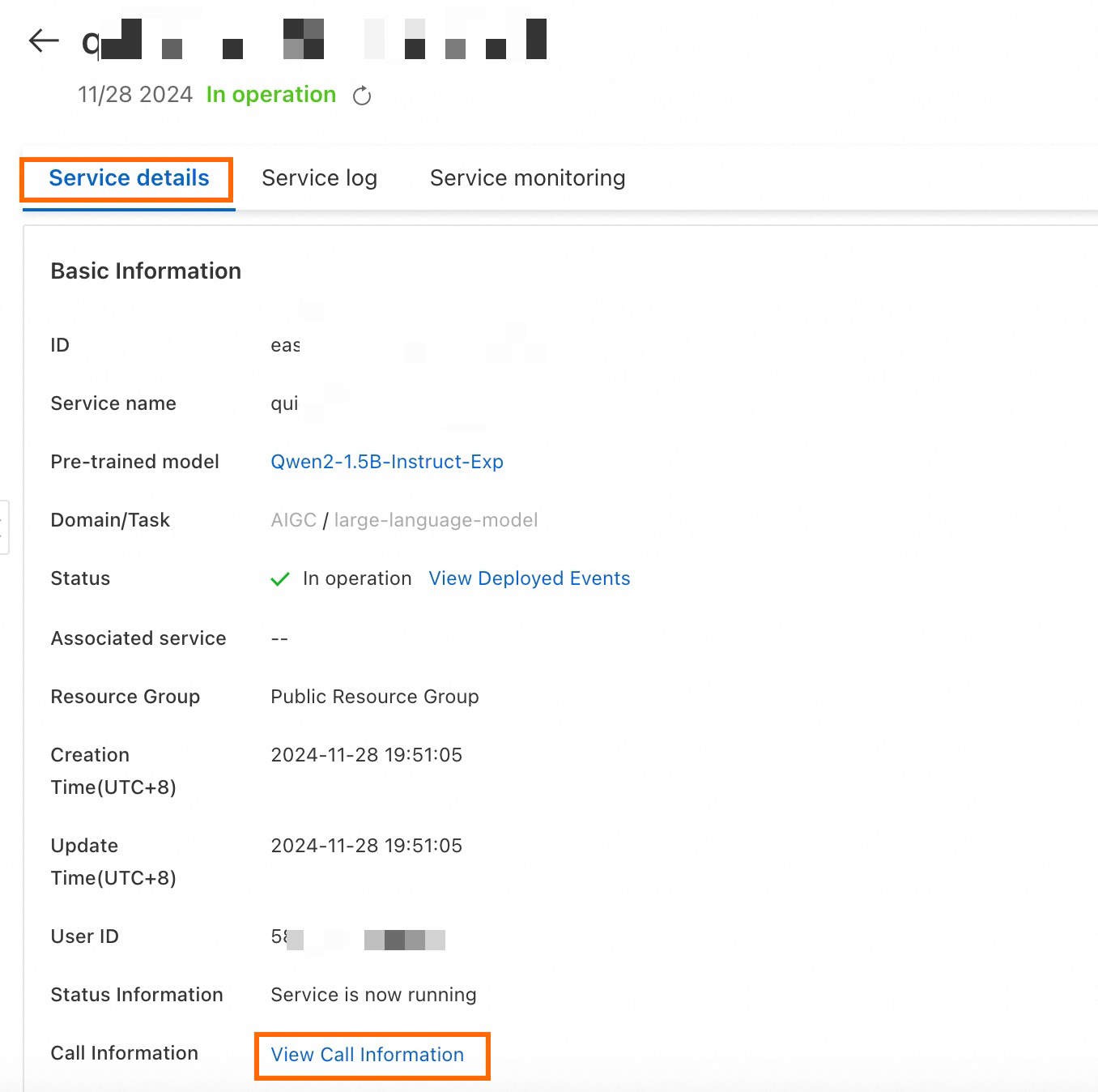

Di halaman Service Details, klik View Endpoint Information di area Basic Information.

Di kotak dialog Endpoint Information, salin titik akhir layanan dan token.

Di terminal, buat dan jalankan skrip Python berikut untuk memanggil layanan.

import argparse import json import requests from typing import List def post_http_request(prompt: str, system_prompt: str, host: str, authorization: str, max_new_tokens: int, temperature: float, top_k: int, top_p: float) -> requests.Response: headers = { "User-Agent": "Test Client", "Authorization": f"{authorization}" } pload = { "prompt": prompt, "system_prompt": system_prompt, "top_k": top_k, "top_p": top_p, "temperature": temperature, "max_new_tokens": max_new_tokens, "do_sample": True, "eos_token_id": 151645 } response = requests.post(host, headers=headers, json=pload) return response def get_response(response: requests.Response) -> List[str]: data = json.loads(response.content) output = data["response"] return output if __name__ == "__main__": parser = argparse.ArgumentParser() parser.add_argument("--top-k", type=int, default=50) parser.add_argument("--top-p", type=float, default=0.95) parser.add_argument("--max-new-tokens", type=int, default=2048) parser.add_argument("--temperature", type=float, default=1) parser.add_argument("--prompt", type=str, default="Sing me a song.") args = parser.parse_args() prompt = args.prompt top_k = args.top_k top_p = args.top_p temperature = args.temperature max_new_tokens = args.max_new_tokens host = "EAS HOST" authorization = "EAS TOKEN" print(f" --- input: {prompt}\n", flush=True) system_prompt = "I want you to act as an instruction creator. Your goal is to draw inspiration from the [given instruction] to create a brand new instruction." response = post_http_request( prompt, system_prompt, host, authorization, max_new_tokens, temperature, top_k, top_p) output = get_response(response) print(f" --- output: {output}\n", flush=True)Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

Tambahkan instruksi secara batch

Anda dapat menggunakan layanan online EAS untuk melakukan panggilan batch dan menambahkan instruksi. Kode berikut menunjukkan cara membaca set data JSON kustom dan memanggil antarmuka model secara batch untuk augmentasi instruksi. Di terminal, buat dan jalankan skrip Python berikut untuk memanggil layanan model secara batch.

import requests

import json

import random

from tqdm import tqdm

from typing import List

input_file_path = "input.json" # Nama file input.

with open(input_file_path) as fp:

data = json.load(fp)

total_size = 10 # Jumlah total entri data yang diharapkan setelah ekspansi.

pbar = tqdm(total=total_size)

while len(data) < total_size:

prompt = random.sample(data, 1)[0]["instruction"]

system_prompt = "I want you to act as an instruction creator. Your goal is to draw inspiration from the [given instruction] to create a brand new instruction."

top_k = 50

top_p = 0.95

temperature = 1

max_new_tokens = 2048

host = "EAS HOST"

authorization = "EAS TOKEN"

response = post_http_request(

prompt, system_prompt,

host, authorization,

max_new_tokens, temperature, top_k, top_p)

output = get_response(response)

temp = {

"instruction": output

}

data.append(temp)

pbar.update(1)

pbar.close()

output_file_path = "output.json" # Nama file output.

with open(output_file_path, 'w') as f:

json.dump(data, f, ensure_ascii=False)Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

file_path: Jalur lokal ke file set data Anda.

Definisi fungsi

post_http_requestdanget_responsesama dengan definisi yang sesuai dalam skrip Python di Panggil layanan model.

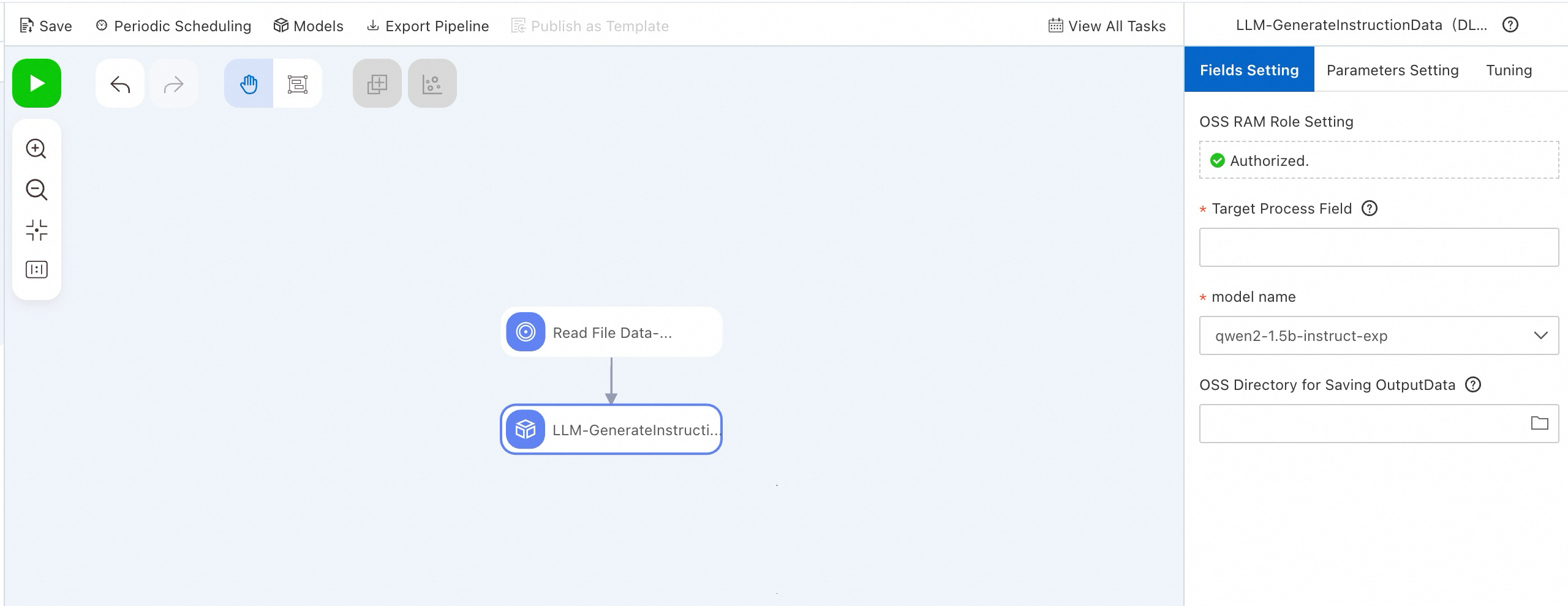

Sebagai alternatif, Anda dapat menggunakan komponen LLM-Instruction Augmentation (DLC) di PAI-Designer untuk melakukan fungsi ini tanpa menulis kode. Untuk informasi selengkapnya, lihat Custom pipelines.

(Opsional) Optimalkan instruksi menggunakan model optimisasi instruksi

Optimisasi instruksi adalah teknik rekayasa prompt umum lainnya untuk LLM. Teknik ini digunakan untuk secara otomatis mengoptimalkan set data instruksi yang disediakan pengguna guna menghasilkan instruksi yang lebih detail, sehingga memungkinkan LLM memberikan tanggapan yang lebih rinci.

Sebagai contoh, jika Anda memberikan input berikut ke model optimisasi instruksi:

How to make fish-fragrant shredded pork? How to prepare for the GRE exam? What should I do if a friend misunderstands me?Output model adalah sebagai berikut:

Provide a detailed recipe of Chinese Sichuan-style fish-fragrant shredded pork. The recipe contains a list of specific ingredients, such as vegetables, pork, and spices, and detailed cooking instructions. If possible, recommend side dishes and other main courses that pair well with this dish. Provide a detailed guide, including registration for the GRE test, required materials, test preparation strategies, and recommended review materials. If possible, recommend some effective practice questions and mock exams to help me prepare for the exam. Provide a detailed guide to teach me how to be calm and rational, and communicate effectively to solve the problem when I am misunderstood by my friends. Provide some practical suggestions, such as how to express my thoughts and feelings, and how to avoid aggravating misunderstandings, and provide specific dialogue scenarios and situations so that I can better understand and practice.

Karena tingkat detail dalam instruksi secara langsung memengaruhi output LLM, optimisasi instruksi dapat secara efektif meningkatkan performa model siswa akhir. Berdasarkan model dasar Qwen2, PAI menyediakan dua model optimisasi instruksi: Qwen2-1.5B-Instruct-Refine dan Qwen2-7B-Instruct-Refine. Anda dapat menerapkan layanan model dengan satu klik di PAI-Model Gallery. Ikuti langkah-langkah berikut:

Terapkan layanan model

Buka halaman Model Gallery.

Login ke Konsol PAI.

Di pojok kiri atas, pilih Wilayah.

Di panel navigasi sebelah kiri, klik Workspaces. Klik nama ruang kerja target.

Di panel navigasi sebelah kiri, pilih .

Di halaman Model Gallery, cari Qwen2-1.5B-Instruct-Refine atau Qwen2-7B-Instruct-Refine, lalu klik tombol Deploy pada kartu model yang sesuai.

Di panel konfigurasi Deploy, informasi Model Service Information dan Resource Deployment Information telah dikonfigurasi secara default. Anda dapat mengubah parameter sesuai kebutuhan. Setelah selesai mengonfigurasi parameter, klik tombol Deploy.

Di kotak dialog Billing Notification, klik OK.

Anda secara otomatis dialihkan ke halaman Deployment Tasks. Status Running menunjukkan bahwa penerapan telah berhasil.

Panggil layanan model

Setelah layanan model diterapkan, Anda dapat menggunakan API untuk inferensi model. Untuk informasi selengkapnya, lihat Terapkan model bahasa besar. Contoh berikut menunjukkan cara mengirim permintaan layanan model dari klien:

Dapatkan titik akhir layanan dan token.

Di halaman Service Details, klik View Endpoint Information di area Basic Information.

Di kotak dialog Endpoint Information, salin titik akhir layanan dan token.

Di terminal, buat dan jalankan skrip Python berikut untuk memanggil layanan.

import argparse import json import requests from typing import List def post_http_request(prompt: str, system_prompt: str, host: str, authorization: str, max_new_tokens: int, temperature: float, top_k: int, top_p: float) -> requests.Response: headers = { "User-Agent": "Test Client", "Authorization": f"{authorization}" } pload = { "prompt": prompt, "system_prompt": system_prompt, "top_k": top_k, "top_p": top_p, "temperature": temperature, "max_new_tokens": max_new_tokens, "do_sample": True, "eos_token_id": 151645 } response = requests.post(host, headers=headers, json=pload) return response def get_response(response: requests.Response) -> List[str]: data = json.loads(response.content) output = data["response"] return output if __name__ == "__main__": parser = argparse.ArgumentParser() parser.add_argument("--top-k", type=int, default=2) parser.add_argument("--top-p", type=float, default=0.95) parser.add_argument("--max-new-tokens", type=int, default=256) parser.add_argument("--temperature", type=float, default=0.5) parser.add_argument("--prompt", type=str, default="Sing me a song.") args = parser.parse_args() prompt = args.prompt top_k = args.top_k top_p = args.top_p temperature = args.temperature max_new_tokens = args.max_new_tokens host = "EAS HOST" authorization = "EAS TOKEN" print(f" --- input: {prompt}\n", flush=True) system_prompt = "Optimize this instruction to make it more detailed and specific." response = post_http_request( prompt, system_prompt, host, authorization, max_new_tokens, temperature, top_k, top_p) output = get_response(response) print(f" --- output: {output}\n", flush=True)Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

Optimalkan instruksi secara batch

Anda dapat menggunakan layanan online EAS di atas untuk melakukan panggilan dan mengoptimalkan instruksi secara batch. Contoh kode berikut menunjukkan cara membaca set data JSON kustom dan memanggil antarmuka model secara batch untuk optimisasi kualitas. Di terminal, buat dan jalankan file Python berikut untuk memanggil layanan model secara batch.

import requests

import json

import random

from tqdm import tqdm

from typing import List

input_file_path = "input.json" # Nama file input.

with open(input_file_path) as fp:

data = json.load(fp)

pbar = tqdm(total=len(data))

new_data = []

for d in data:

prompt = d["instruction"]

system_prompt = "Optimize the following instruction."

top_k = 50

top_p = 0.95

temperature = 1

max_new_tokens = 2048

host = "EAS HOST"

authorization = "EAS TOKEN"

response = post_http_request(

prompt, system_prompt,

host, authorization,

max_new_tokens, temperature, top_k, top_p)

output = get_response(response)

temp = {

"instruction": output

}

new_data.append(temp)

pbar.update(1)

pbar.close()

output_file_path = "output.json" # Nama file output.

with open(output_file_path, 'w') as f:

json.dump(new_data, f, ensure_ascii=False)

Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

file_path: Jalur lokal ke file set data Anda.

Definisi fungsi

post_http_requestdanget_responsesama dengan yang ada dalam skrip Python di Panggil layanan model.

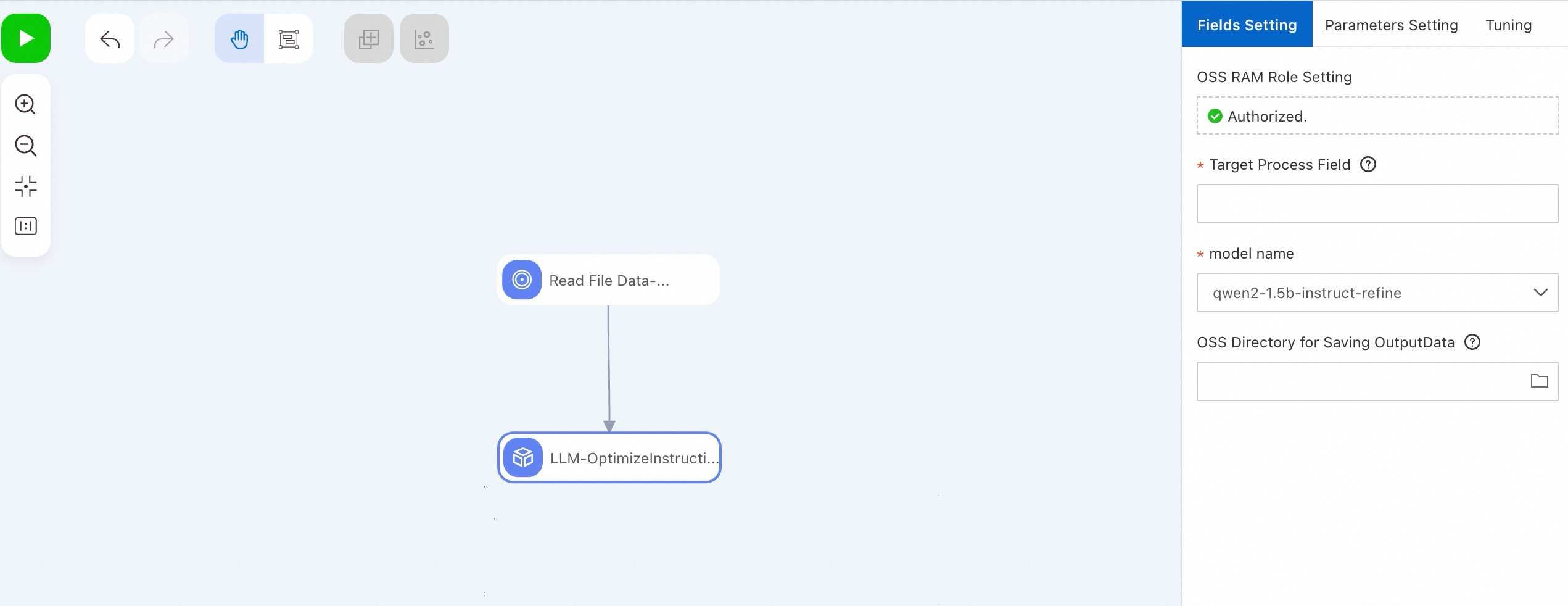

Anda juga dapat menggunakan komponen LLM-Instruction Optimization (DLC) di PAI-Designer untuk melakukan fungsi yang sama tanpa menulis kode. Untuk informasi selengkapnya, lihat Custom pipelines.

Terapkan LLM guru untuk menghasilkan tanggapan yang sesuai

Terapkan layanan model

Setelah mengoptimalkan instruksi dalam set data, ikuti langkah-langkah berikut untuk menerapkan LLM guru guna menghasilkan tanggapan yang sesuai.

Buka halaman Model Gallery.

Login ke Konsol PAI.

Di pojok kiri atas, pilih Wilayah.

Di panel navigasi sebelah kiri, klik Workspaces. Klik nama ruang kerja target.

Di panel navigasi sebelah kiri, pilih .

Di halaman Model Gallery, cari Qwen2-72B-Instruct di daftar model, lalu klik tombol Deploy pada kartu yang sesuai.

Di panel konfigurasi Deploy, informasi Model Service Information dan Resource Deployment Information telah dikonfigurasi secara default. Anda dapat mengubah parameter sesuai kebutuhan. Setelah selesai mengonfigurasi parameter, klik tombol Deploy.

Di kotak dialog Billing Notification, klik OK.

Anda secara otomatis dialihkan ke halaman Deployment Tasks. Status Running menunjukkan penerapan yang berhasil.

Panggil layanan model

Setelah layanan model diterapkan, Anda dapat menggunakan API untuk inferensi model. Untuk informasi selengkapnya, lihat Terapkan model bahasa besar. Contoh berikut menunjukkan cara mengirim permintaan layanan model dari klien:

Dapatkan titik akhir layanan dan token.

Di halaman Service Details, klik View Endpoint Information di area Basic Information.

Di kotak dialog Endpoint Information, salin titik akhir layanan dan token.

Di terminal, buat dan jalankan file Python dengan kode berikut untuk memanggil layanan.

import argparse import json import requests from typing import List def post_http_request(prompt: str, system_prompt: str, host: str, authorization: str, max_new_tokens: int, temperature: float, top_k: int, top_p: float) -> requests.Response: headers = { "User-Agent": "Test Client", "Authorization": f"{authorization}" } pload = { "prompt": prompt, "system_prompt": system_prompt, "top_k": top_k, "top_p": top_p, "temperature": temperature, "max_new_tokens": max_new_tokens, "do_sample": True, } response = requests.post(host, headers=headers, json=pload) return response def get_response(response: requests.Response) -> List[str]: data = json.loads(response.content) output = data["response"] return output if __name__ == "__main__": parser = argparse.ArgumentParser() parser.add_argument("--top-k", type=int, default=50) parser.add_argument("--top-p", type=float, default=0.95) parser.add_argument("--max-new-tokens", type=int, default=2048) parser.add_argument("--temperature", type=float, default=0.5) parser.add_argument("--prompt", type=str) parser.add_argument("--system_prompt", type=str) args = parser.parse_args() prompt = args.prompt system_prompt = args.system_prompt top_k = args.top_k top_p = args.top_p temperature = args.temperature max_new_tokens = args.max_new_tokens host = "EAS HOST" authorization = "EAS TOKEN" print(f" --- input: {prompt}\n", flush=True) response = post_http_request( prompt, system_prompt, host, authorization, max_new_tokens, temperature, top_k, top_p) output = get_response(response) print(f" --- output: {output}\n", flush=True)Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

Beri label instruksi secara batch menggunakan model guru

Kode berikut menunjukkan cara membaca set data JSON kustom dan memanggil model guru secara batch untuk memberi label instruksi. Di terminal, buat dan jalankan file Python berikut untuk memanggil layanan model.

import json

from tqdm import tqdm

import requests

from typing import List

input_file_path = "input.json" # Nama file input.

with open(input_file_path) as fp:

data = json.load(fp)

pbar = tqdm(total=len(data))

new_data = []

for d in data:

system_prompt = "You are a helpful assistant."

prompt = d["instruction"]

print(prompt)

top_k = 50

top_p = 0.95

temperature = 0.5

max_new_tokens = 2048

host = "EAS HOST"

authorization = "EAS TOKEN"

response = post_http_request(

prompt, system_prompt,

host, authorization,

max_new_tokens, temperature, top_k, top_p)

output = get_response(response)

temp = {

"instruction": prompt,

"output": output

}

new_data.append(temp)

pbar.update(1)

pbar.close()

output_file_path = "output.json" # Nama file output.

with open(output_file_path, 'w') as f:

json.dump(new_data, f, ensure_ascii=False)Keterangan:

host: Titik akhir layanan yang Anda peroleh.

authorization: Token layanan yang Anda peroleh.

file_path: Jalur lokal ke file set data Anda.

Definisi fungsi

post_http_requestdanget_responsesama dengan yang ada dalam skrip di Panggil layanan model.

Distilasi dan latih model siswa yang lebih kecil

Latih model

Setelah Anda memperoleh tanggapan dari model guru, Anda dapat melatih model siswa di PAI-Model Gallery tanpa menulis kode. Hal ini sangat menyederhanakan proses pengembangan model. Solusi ini menggunakan model Qwen2-7B-Instruct sebagai contoh untuk menunjukkan cara melatih model di PAI-Model Gallery dengan data pelatihan yang telah disiapkan. Prosedurnya adalah sebagai berikut:

Buka halaman Model Gallery.

Login ke Konsol PAI.

Di pojok kiri atas, pilih Wilayah.

Di panel navigasi sebelah kiri, klik Workspaces. Klik nama ruang kerja target.

Di panel navigasi sebelah kiri, pilih .

Di halaman Model Gallery, cari dan klik kartu model Qwen2-7B-Instruct untuk membuka halaman detail model.

Di halaman detail model, klik tombol Fine-tune di pojok kanan atas.

Di panel Fine-tune, konfigurasikan parameter utama berikut. Gunakan nilai default untuk parameter lainnya.

Parameter

Description

Default value

Dataset Configuration

Training dataset

Pilih OSS file or directory dari daftar tarik-turun, lalu ikuti langkah-langkah berikut untuk memilih jalur penyimpanan OSS tempat file set data berada:

Klik

dan pilih bucket OSS yang telah dibuat.

dan pilih bucket OSS yang telah dibuat.Klik Upload File dan ikuti petunjuk di konsol untuk mengunggah file set data yang diperoleh dari langkah-langkah sebelumnya ke direktori OSS.

Klik OK.

None

Training Output Configuration

model

Klik

dan pilih direktori OSS yang sudah ada.

dan pilih direktori OSS yang sudah ada.None

tensorboard

Klik

dan pilih direktori OSS yang sudah ada.

dan pilih direktori OSS yang sudah ada.None

Compute Resource Configuration

Task resource

Pilih spesifikasi sumber daya. Sistem secara otomatis merekomendasikan spesifikasi yang sesuai.

None

Hyperparameter Configuration

learning_rate

Tingkat pembelajaran untuk pelatihan model. Tipe data adalah float.

5e-5

num_train_epochs

Jumlah epoch pelatihan. Tipe data adalah integer.

1

per_device_train_batch_size

Jumlah data pada setiap kartu GPU dalam satu iterasi pelatihan. Tipe data adalah integer.

1

seq_length

Panjang urutan teks. Tipe data adalah integer.

128

lora_dim

Dimensi LoRA. Tipe data adalah integer. Ketika lora_dim > 0, pelatihan ringan LoRA/QLoRA digunakan.

32

lora_alpha

Bobot LoRA. Tipe data adalah integer. Parameter ini berlaku ketika lora_dim > 0 untuk pelatihan ringan LoRA/QLoRA.

32

load_in_4bit

Menentukan apakah model dimuat dalam kuantisasi 4-bit. Tipe data adalah boolean. Nilai yang valid:

true

false

Ketika lora_dim > 0, load_in_4bit bernilai true, dan load_in_8bit bernilai false, pelatihan ringan QLoRA 4-bit digunakan.

true

load_in_8bit

Menentukan apakah model dimuat dalam kuantisasi 8-bit. Tipe data adalah boolean. Nilai yang valid:

true

false

Ketika lora_dim > 0, load_in_4bit bernilai false, dan load_in_8bit bernilai true, pelatihan ringan QLoRA 8-bit digunakan.

false

gradient_accumulation_steps

Jumlah langkah akumulasi gradien. Tipe data adalah integer.

8

apply_chat_template

Menentukan apakah algoritma menggabungkan data pelatihan dengan templat chat default untuk mengoptimalkan output model. Tipe data adalah boolean. Nilai yang valid:

true

false

Untuk model seri Qwen2, formatnya adalah sebagai berikut:

Question:

<|im_end|>\n<|im_start|>user\n + instruction + <|im_end|>\nAnswer:

<|im_start|>assistant\n + output + <|im_end|>\n

true

system_prompt

Prompt sistem yang digunakan untuk pelatihan model. Tipe data adalah string.

You are a helpful assistant

Setelah mengonfigurasi parameter, klik tombol Train.

Di kotak dialog Billing Notification, klik OK.

Anda akan diarahkan secara otomatis ke halaman tugas pelatihan.

Terapkan layanan model

Setelah model dilatih, Anda dapat mengikuti langkah-langkah berikut untuk menerapkannya sebagai layanan online EAS.

Di sisi kanan halaman tugas pelatihan, klik tombol Deploy.

Di panel konfigurasi penerapan, informasi Model Service Information dan Resource Deployment Information telah dikonfigurasi secara default. Anda dapat mengubah konfigurasi ini sesuai kebutuhan. Setelah mengonfigurasi parameter, klik tombol Deploy.

Di kotak dialog Billing Notification, klik OK.

Sistem secara otomatis menavigasi ke halaman Deployment Tasks. Ketika Status berubah menjadi Running, layanan berhasil diterapkan.

Panggil layanan model

Setelah Anda menerapkan layanan model, Anda dapat menggunakan API untuk melakukan inferensi model. Untuk informasi selengkapnya, lihat Terapkan model bahasa besar.

Dokumen terkait

Untuk informasi selengkapnya tentang EAS, lihat Ikhtisar EAS.

Dengan menggunakan fitur PAI Model Gallery, Anda dapat dengan mudah menerapkan dan melakukan fine-tuning model dari seri Llama-3, Qwen1.5, dan Stable Diffusion V1.5 untuk berbagai skenario. Untuk informasi selengkapnya, lihat Studi kasus Model Gallery.