Topik ini menjelaskan cara melatih dan melakukan inferensi pada model bahasa besar (LLM) seri Llama 2 di Platform for AI (PAI) tanpa menulis kode. Anda dapat menggunakan Panduan Cepat Mulai untuk menerapkan layanan inferensi online untuk model Llama 2 serta memanggilnya melalui antarmuka web atau API. Selain itu, Anda juga dapat melakukan fine-tuning pada model yang telah dilatih sebelumnya dengan dataset Anda sendiri agar sesuai dengan skenario dan tugas tertentu.

Informasi latar belakang

Llama2 adalah LLM open-source berbasis bahasa Inggris yang dirilis oleh Meta. Model ini menerima teks bahasa alami sebagai masukan dan menghasilkan teks sebagai keluaran. Llama 2 tersedia dalam ukuran 7 miliar hingga 70 miliar parameter, dengan varian 7b, 13b, dan 70b. Setiap versi juga memiliki varian yang dioptimalkan untuk percakapan bernama Llama-2-chat. Panduan Cepat Mulai mendukung inferensi online untuk model seri Llama 2, serta memungkinkan penggunaan model tersebut sebagai model dasar untuk fine-tuning guna mencapai hasil yang lebih baik dalam skenario kustom.

Model llama-2-7b-chat yang disediakan dalam Panduan Cepat Mulai berasal dari model Llama-2-7b-chat di Hugging Face. Model ini merupakan LLM berbasis arsitektur Transformer yang dilatih pada campuran beragam dataset open-source, sehingga cocok untuk sebagian besar skenario umum berbahasa Inggris.

Topik ini menggunakan model llama-2-7b-chat sebagai contoh untuk menunjukkan cara menggunakan Panduan Cepat Mulai guna menerapkan model ke Elastic Algorithm Service (EAS) serta membuat dan memanggil layanan inferensi.

Batasan

Saat ini, Panduan Cepat Mulai tersedia di wilayah berikut: Tiongkok (Beijing), Tiongkok (Shanghai), Tiongkok (Hangzhou), Tiongkok (Shenzhen), dan Tiongkok (Ulanqab).

Untuk mengaktifkan wilayah Tiongkok (Ulanqab), hubungi manajer bisnis Anda.

Penagihan

Anda dikenai biaya untuk penggunaan penyimpanan Object Storage Service (OSS). Untuk informasi selengkapnya, lihat Ikhtisar Tagihan OSS.

Panduan Cepat Mulai itu sendiri tidak dikenai biaya. Namun, saat Anda menggunakannya untuk penerapan model dan pelatihan, Anda akan dikenai biaya untuk penerapan model (Elastic Algorithm Service/EAS) dan pekerjaan pelatihan (Deep Learning Containers/DLC). Untuk informasi selengkapnya, lihat Tagihan Elastic Algorithm Service (EAS) dan Tagihan Deep Learning Containers (DLC).

Prasyarat

Anda telah mengaktifkan PAI, yang mencakup EAS dan DLC, serta membuat ruang kerja default. Untuk informasi selengkapnya, lihat Aktifkan PAI dan buat ruang kerja default.

Anda telah mengaktifkan OSS dan membuat bucket.

CatatanBucket harus berada di wilayah yang sama dengan ruang kerja PAI Anda. Wilayah bucket tidak dapat diubah setelah bucket dibuat.

Anda telah membaca dan menyetujui lisensi open-source komersial kustom dari model Llama.

CatatanJika Anda tidak dapat mengakses tautan tersebut, Anda mungkin perlu menggunakan proxy dan mencoba lagi.

Prosedur

Model llama-2-7b-chat cocok untuk sebagian besar skenario non-spesialis. Untuk meningkatkan hasil prediksi atau menerapkan pengetahuan dari domain tertentu, Anda dapat melakukan fine-tuning pada model tersebut. Fine-tuning membantu meningkatkan kemampuan model dalam domain kustom Anda, sehingga lebih sesuai dengan kebutuhan bisnis Anda.

LLM dapat mempelajari pengetahuan sederhana secara langsung selama percakapan, sehingga Anda dapat memilih apakah akan melakukan fine-tuning pada model tersebut. Panduan Cepat Mulai menggunakan metode pelatihan LoRA. Dibandingkan dengan metode lain seperti Supervised Fine-Tuning (SFT), LoRA secara signifikan mengurangi biaya dan waktu pelatihan.

Terapkan model secara langsung

Buka halaman Model Gallery.

Masuk ke Konsol PAI.

Di panel navigasi kiri, klik daftar ruang kerja. Di halaman daftar ruang kerja, klik nama ruang kerja yang ingin Anda kelola.

Di panel navigasi kiri, klik QuickStart > Model Gallery.

Di kotak pencarian, masukkan llama-2-7b-chat lalu tekan Enter.

CatatanAnda juga dapat memilih model lain sesuai kebutuhan bisnis Anda. Model ini memerlukan setidaknya memori 64 GiB dan memori GPU 24 GiB atau lebih. Pastikan sumber daya yang Anda pilih memenuhi persyaratan ini; jika tidak, penerapan dapat gagal.

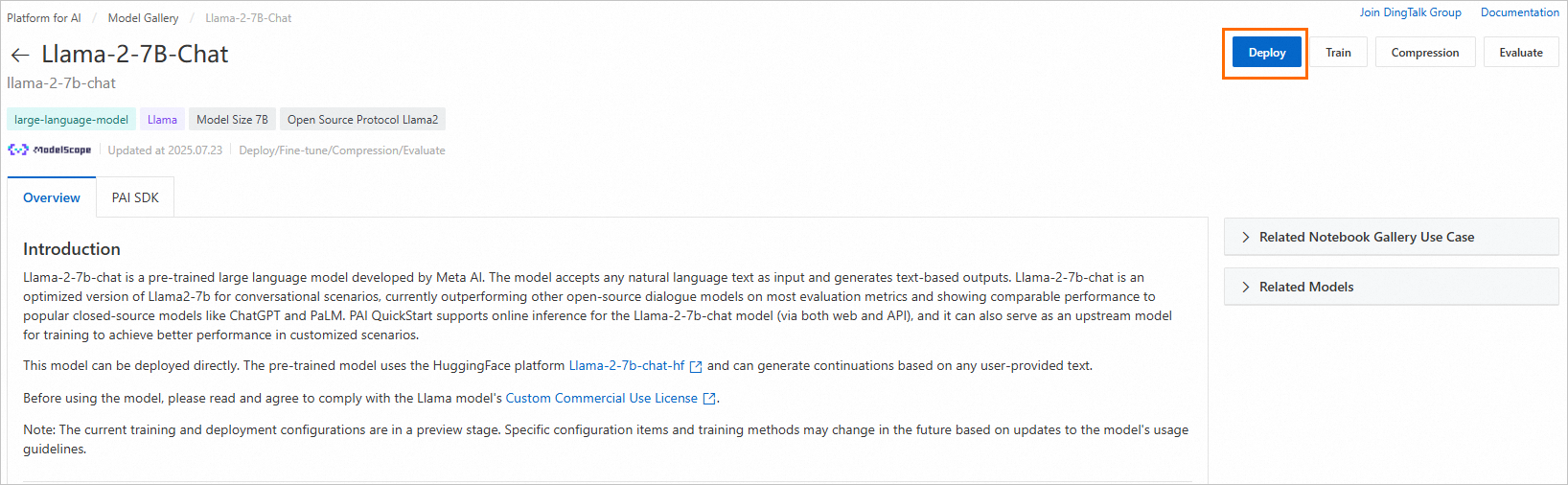

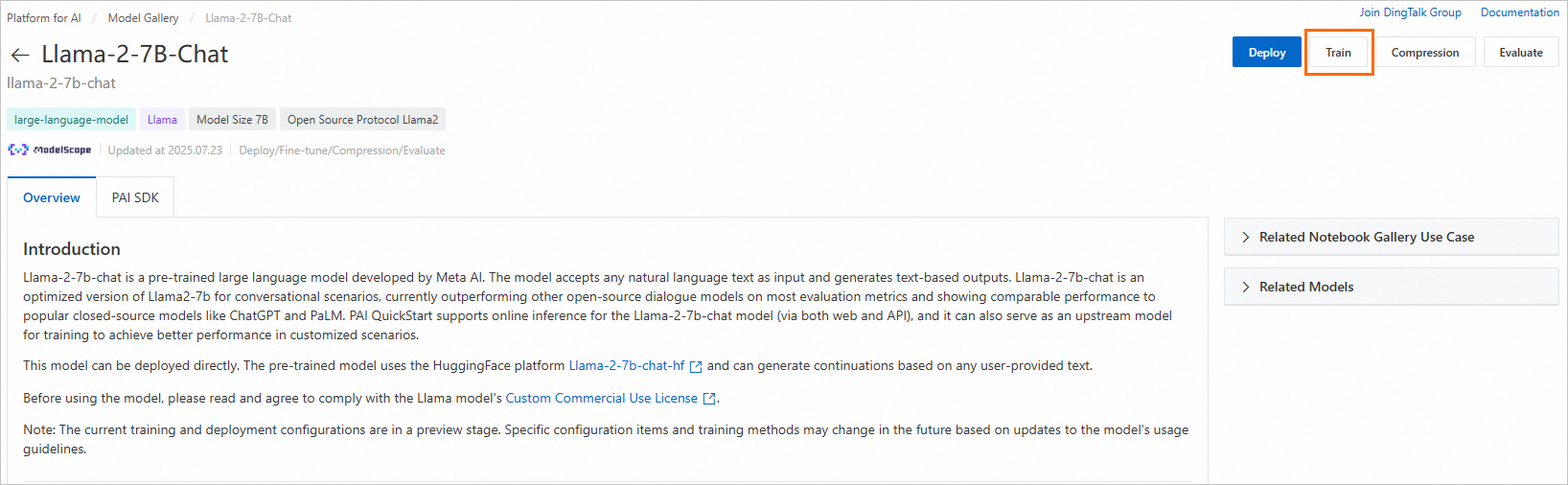

Klik kartu model llama-2-7b-chat untuk membuka halaman detail model. Di pojok kanan atas, klik Deploy.

Di bagian bawah halaman penerapan, klik Deploy.

Pada kotak dialog Billing Notification yang muncul, klik OK.

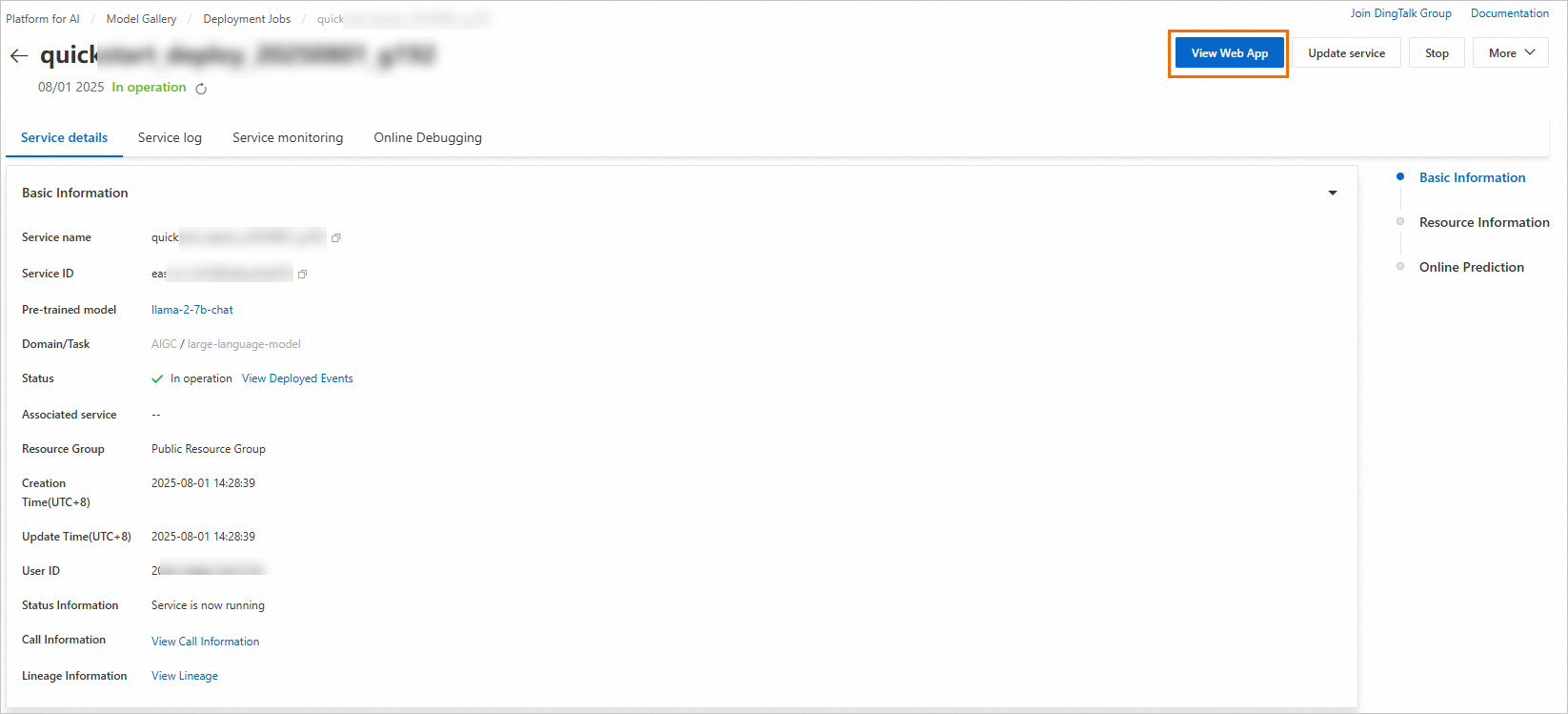

Halaman akan secara otomatis dialihkan ke halaman Service details. Saat Status layanan berubah menjadi In operation, layanan inferensi berhasil diterapkan.

Setelah layanan diterapkan, Anda dapat memanggilnya melalui antarmuka web atau API.

Di pojok kanan atas halaman Service Details, klik View Web App.

Panggil layanan inferensi.

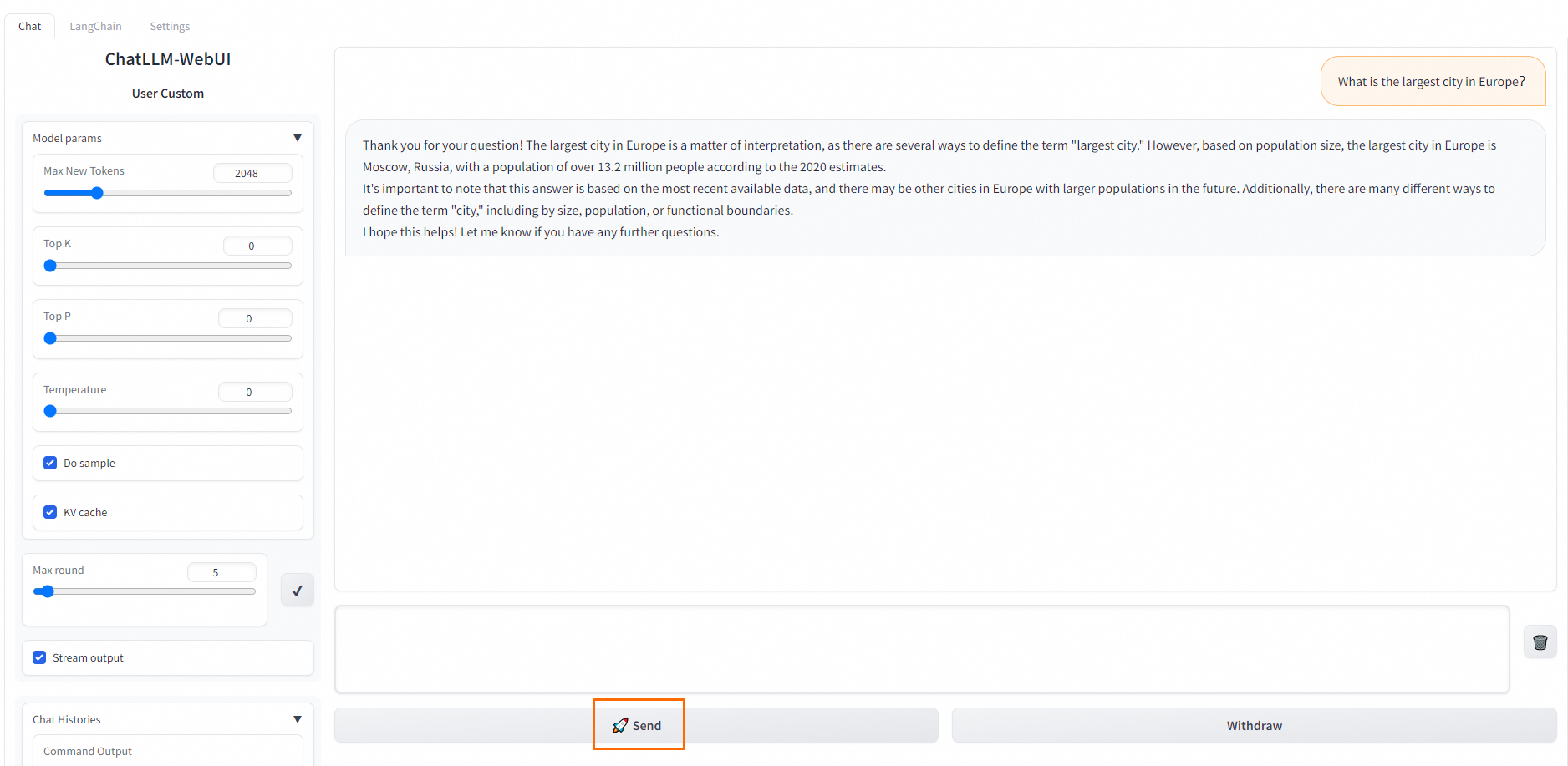

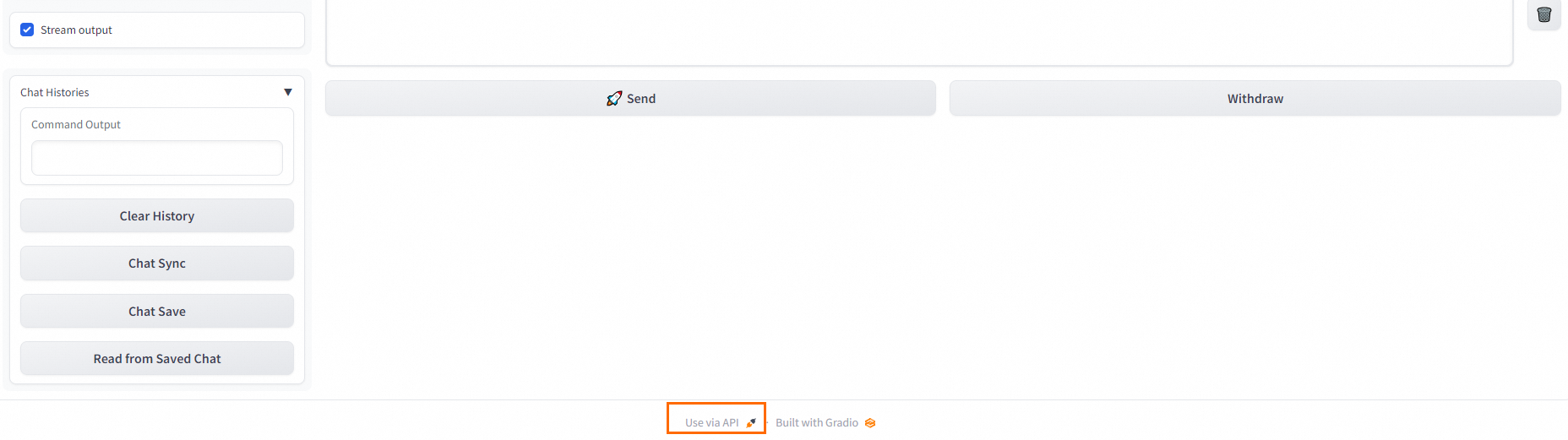

WebUI: Di tab Chat, masukkan prompt Anda di kotak dialog lalu klik Send untuk memulai percakapan multi-putaran.

API: Di bagian bawah halaman WebUI, klik Use via API untuk melihat detail pemanggilan API.

Lakukan fine-tuning pada model

Buka halaman Model Gallery.

Masuk ke Konsol PAI.

Di panel navigasi kiri, klik daftar ruang kerja. Di halaman daftar ruang kerja, klik nama ruang kerja yang ingin Anda kelola.

Di panel navigasi kiri, klik QuickStart > Model Gallery.

Di kotak pencarian, masukkan llama-2-7b-chat lalu tekan Enter.

CatatanAnda juga dapat memilih model lain sesuai kebutuhan bisnis Anda. Model ini memerlukan setidaknya memori 64 GiB dan memori GPU 24 GiB atau lebih. Pastikan sumber daya yang Anda pilih memenuhi persyaratan ini; jika tidak, penerapan dapat gagal.

Klik kartu model llama-2-7b-chat untuk membuka halaman detail model, lalu klik Train.

Konfigurasikan parameter pelatihan model.

Panduan Cepat Mulai menyediakan konfigurasi default untuk Computing Resources dan Hyperparameters yang sesuai untuk sebagian besar kasus penggunaan. Anda dapat memodifikasinya sesuai kebutuhan bisnis Anda. Tabel berikut menjelaskan parameter utama untuk tutorial ini.

Parameter

Deskripsi

Konfigurasi Keluaran

Jalur Keluaran Model

Pilih jalur bucket OSS untuk menyimpan file model yang telah dilatih.

CatatanJika Anda telah mengonfigurasi jalur penyimpanan di halaman detail ruang kerja, jalur ini akan diisi secara otomatis. Untuk informasi selengkapnya tentang cara mengonfigurasi jalur penyimpanan ruang kerja, lihat Kelola ruang kerja.

Konfigurasi Dataset

Training Dataset

Untuk membantu Anda mencoba model Llama2, Panduan Cepat Mulai menyediakan training dataset default yang dapat Anda gunakan langsung. Untuk menggunakan data pelatihan Anda sendiri, siapkan dalam format yang ditentukan dalam dokumentasi model lalu unggah dengan salah satu cara berikut:

Pemilihan Dataset: Anda dapat menggunakan dataset publik atau kustom. Untuk informasi selengkapnya tentang cara membuat dataset kustom, lihat Buat dan kelola dataset.

File atau Direktori OSS: Unggah data melalui OSS. Untuk informasi selengkapnya, lihat Memulai OSS.

Data pelatihan harus dalam format JSON. Setiap entri terdiri dari instruksi, keluaran, dan ID, yang masing-masing direpresentasikan oleh bidang

instruction,output, danid.[ { "instruction": "Does the following text belong to the world topic? Why do Americans rarely hold military parades?", "output": "Yes", "id": 0 }, { "instruction": "Does the following text belong to the world topic? Breaking news! The timetable for vehicle reform in public institutions has been released!", "output": "No", "id": 1 } ]Untuk memvalidasi performa pelatihan model dengan lebih baik, kami merekomendasikan Anda juga menyiapkan dataset validasi. Dataset ini mengevaluasi performa model selama pelatihan dan membantu mengoptimalkan parameter pelatihan.

Klik Train untuk mengirimkan pekerjaan pelatihan.

Pada kotak dialog Billing Notification yang muncul, klik OK.

Halaman akan otomatis dialihkan ke halaman Task Details. Ketika status pekerjaan (Job Status) berubah menjadi Succeeded, pelatihan model selesai.

Model yang telah dilatih disimpan ke OSS. Lokasi spesifiknya dapat dilihat di bidang Output Path pada bagian Basic Information.

CatatanJika Anda menggunakan dataset default, hiperparameter, dan konfigurasi sumber daya komputasi default, pekerjaan pelatihan memerlukan waktu sekitar 1 jam 30 menit. Jika Anda menggunakan data dan konfigurasi kustom, waktu penyelesaian dapat bervariasi tetapi biasanya dalam hitungan beberapa jam.

Terapkan model yang telah difine-tuned.

Prosedur untuk menerapkan dan memanggil model yang telah difine-tune sama seperti model dasar. Untuk informasi selengkapnya, lihat Terapkan model secara langsung.

Apa yang harus dilakukan selanjutnya

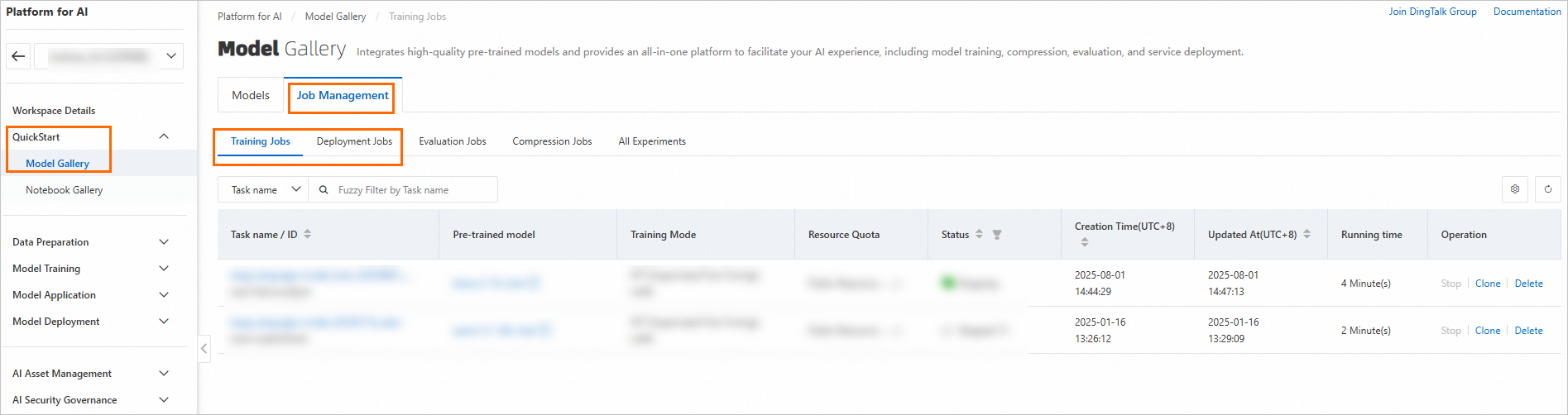

Di halaman QuickStart > Model Gallery, Anda dapat membuka halaman Job Management, lalu mengklik tab Training Jobs dan Deployment Jobs untuk melihat detail pekerjaan Anda.