EMR Serverless Spark kompatibel dengan parameter baris perintah `spark-submit`, yang menyederhanakan eksekusi tugas. Topik ini menyediakan contoh pengembangan Spark Submit untuk membantu Anda memulai.

Prasyarat

Anda telah membuat ruang kerja. Untuk informasi selengkapnya, lihat Manajemen Ruang Kerja.

Anda telah mengembangkan aplikasi bisnis dan membuat paket JAR.

Prosedur

Langkah 1: Mengembangkan paket JAR

Panduan Memulai Cepat ini membantu Anda memahami tugas Spark Submit dengan menyediakan file proyek dan paket JAR uji coba yang dapat diunduh untuk digunakan pada langkah-langkah berikutnya.

Klik spark-examples_2.12-3.3.1.jar untuk mengunduh paket JAR uji coba.

Paket JAR ini merupakan contoh sederhana dari Spark yang digunakan untuk menghitung nilai Pi (π).

Langkah 2: Mengunggah paket JAR ke OSS

Pada contoh ini, unggah paket spark-examples_2.12-3.3.1.jar. Untuk informasi selengkapnya mengenai operasi pengunggahan, lihat Pengunggahan sederhana.

Langkah 3: Mengembangkan dan menjalankan pekerjaan

Pada halaman EMR Serverless Spark, klik Data Development di panel navigasi sebelah kiri.

Pada tab Development, klik ikon

.

.Masukkan nama, pilih sebagai Jenis, lalu klik OK.

Di pojok kanan atas, pilih antrian.

Untuk informasi selengkapnya tentang cara menambahkan antrian, lihat Kelola antrian sumber daya.

Pada panel pengembangan pekerjaan, konfigurasikan informasi berikut. Anda tidak perlu mengonfigurasi parameter lainnya. Kemudian, klik Run.

Parameter

Deskripsi

Script

Skrip spark-submit.

Kode contoh berikut memberikan contoh skrip spark-submit:

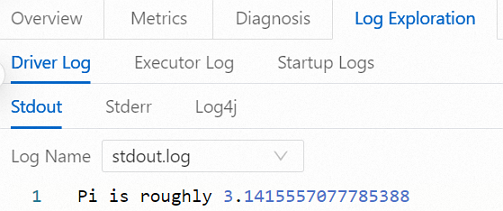

--class org.apache.spark.examples.SparkPi \ --conf spark.executor.memory=2g \ oss://<YourBucket>/spark-examples_2.12-3.3.1.jarPada area Execution Records, klik Log Exploration di kolom Tindakan untuk pekerjaan tersebut.

Pada tab Log Exploration, Anda dapat melihat informasi log.

Langkah 4: Publikasikan pekerjaan

Pekerjaan yang dipublikasikan dapat digunakan sebagai node dalam alur kerja.

Setelah pekerjaan berhasil dijalankan, klik Publish di sebelah kanan.

Pada kotak dialog publikasi pekerjaan, masukkan informasi yang diperlukan dan klik OK.

(Opsional) Langkah 5: Melihat Spark UI

Setelah pekerjaan berhasil dijalankan, Anda dapat melihat statusnya di Spark UI.

Di panel navigasi sebelah kiri, klik Job History.

Pada halaman Application, klik Spark UI di kolom Tindakan untuk pekerjaan yang dituju.

Halaman Spark UI terbuka, tempat Anda dapat melihat detail pekerjaan.

Referensi

Setelah pekerjaan dipublikasikan, Anda dapat menggunakannya untuk penjadwalan alur kerja. Untuk informasi selengkapnya, lihat Kelola alur kerja. Untuk contoh proses pengembangan orkestrasi pekerjaan lengkap, lihat Panduan memulai cepat pengembangan SparkSQL.