DataWorks memungkinkan Anda membuat dan mengelola task Data Integration secara langsung dalam modul Data Studio. Pendekatan ini menyediakan lingkungan terpadu untuk seluruh pipeline ETL/ELT, sehingga Anda tidak perlu berpindah antar modul.

Ikhtisar

DataWorks memungkinkan Anda mendefinisikan dan mengelola task Data Integration di modul Data Studio, mirip dengan node task standar. Pendekatan ini menyatukan seluruh pipa data ke dalam satu tampilan, sehingga Anda tidak perlu berpindah antar modul fungsional.

Task sinkronisasi batch tabel tunggal dapat ditambahkan ke workflow dengan dependensi, sedangkan jenis task integrasi lainnya dijalankan sebagai node mandiri.

Mekanisme inti:

Konsistensi konfigurasi: Baik Anda membuat task di Data Studio maupun di modul Data Integration, antarmuka konfigurasi, pengaturan parameter, dan fungsionalitas dasarnya identik.

Sinkronisasi dua arah: Task yang dibuat di modul Data Integration secara otomatis disinkronkan dan ditampilkan di direktori

data_integration_jobsdalam Data Studio. Task-task tersebut dikategorikan berdasarkan saluransource-type-destination-typeuntuk pengelolaan terpadu.

Prasyarat

Persiapan sumber data

Anda telah membuat sumber data dan tujuan data. Untuk detail konfigurasi sumber data, lihat: Manajemen Sumber Data.

Pastikan sumber data Anda mendukung sinkronisasi real-time. Lihat: Sumber data yang didukung dan solusi sinkronisasi.

Beberapa sumber data, seperti Hologres dan Oracle, memerlukan logging yang diaktifkan. Metode pengaktifan log bervariasi tergantung pada sumber datanya. Untuk detailnya, lihat dokumentasi konfigurasi sumber data: Daftar sumber data.

Kelompok sumber daya: Anda telah membeli dan mengonfigurasi serverless resource group.

Konektivitas jaringan: Anda telah menetapkan konektivitas jaringan antara kelompok sumber daya dan sumber data Anda. Konfigurasi konektivitas jaringan.

Buat task integrasi di Data Studio

Bagian ini menjelaskan cara membuat task Data Integration di Data Studio, menggunakan contoh sinkronisasi batch tabel tunggal dari MySQL ke MaxCompute.

Buat node

Buka halaman Workspaces di konsol DataWorks. Pada bilah navigasi atas, pilih wilayah yang diinginkan. Temukan workspace yang sesuai, lalu pilih di kolom Actions.

Klik ikon + di bagian atas, atau pada toolbar di bagian atas workflow, pilih .

Konfigurasi informasi dasar

Pertama, tentukan apakah akan menggunakan sinkronisasi batch atau real-time berdasarkan kebutuhan Anda terhadap latensi, volume data, dan kompleksitas. Kemudian, pilih mode sinkronisasi yang kompatibel (misalnya, sinkronisasi batch tabel tunggal, sinkronisasi real-time database penuh, atau sinkronisasi full-incremental untuk seluruh database) berdasarkan jenis database sumber dan tujuan, lingkungan jaringan, serta fitur yang didukung.

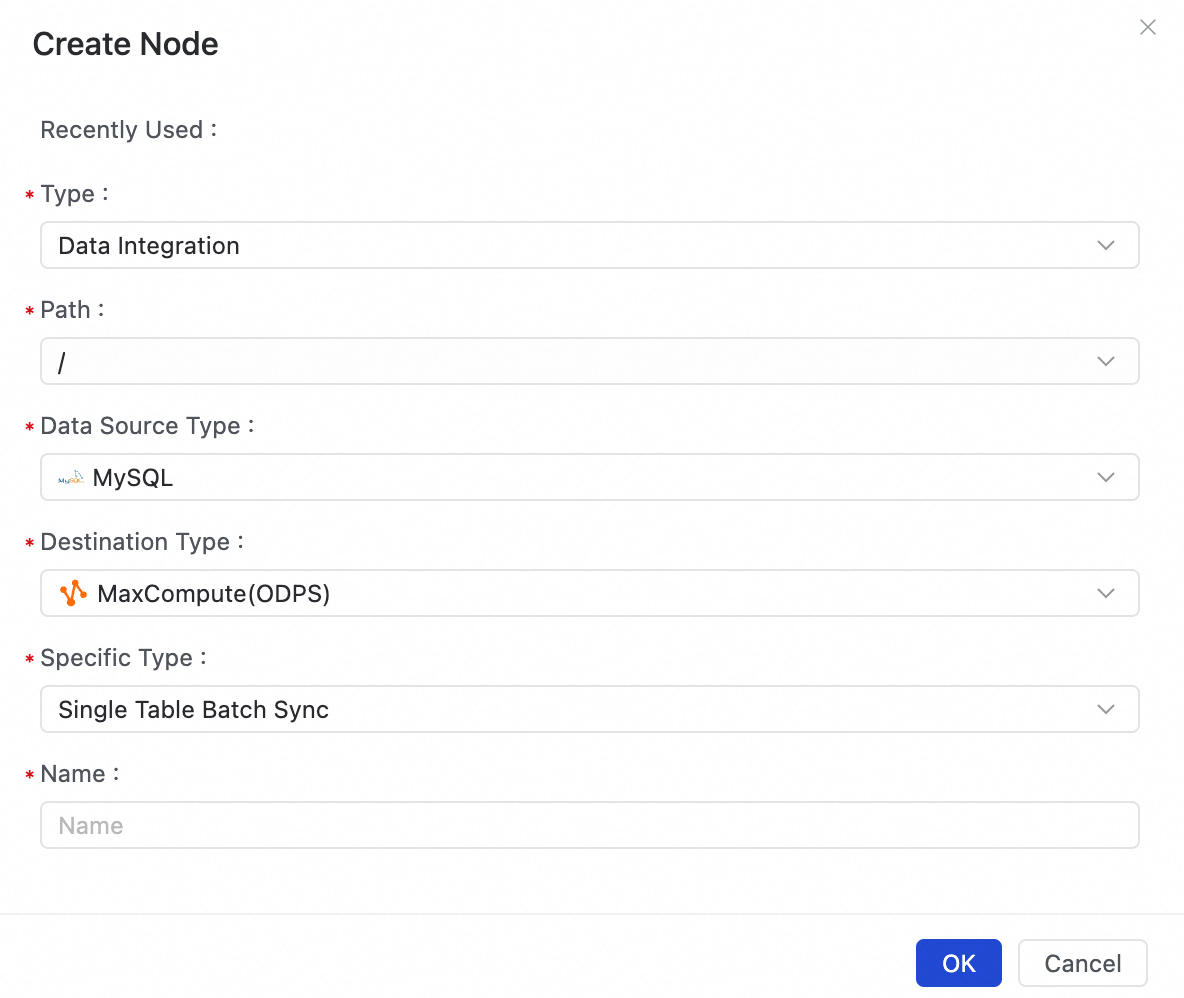

Pada kotak dialog Create Node, konfigurasikan pengaturan berikut:

Path: Pilih lokasi dalam struktur direktori Data Studio tempat Anda ingin menyimpan node task.

Data Source Type: Pilih sumber data Anda, misalnya

MySQL.Destination Type: Pilih tujuan data Anda, misalnya

MaxCompute (ODPS).Specific Type: Pilih mode sinkronisasi.

Name: Masukkan nama untuk node task Anda, misalnya

mysql_to_mc_user_table.

Klik OK. Task dibuat, dan Anda dialihkan ke halaman konfigurasi visualnya.

Konfigurasi detail task

Selain proses pembuatan, konfigurasi task identik dengan proses di modul Data Integration dan tidak dijelaskan ulang di sini.

Konfigurasi penjadwalan (hanya untuk sinkronisasi batch tabel tunggal)

Konfigurasikan properti node, seperti waktu jadwal, kebijakan penjadwalan, dan dependensi penjadwalan, agar sistem penjadwalan dapat menjalankannya secara otomatis dalam interval tertentu. Anda juga dapat mengatur parameter penjadwalan untuk meneruskan variabel dinamis ke instance node saat runtime.

Publish and Operate

Setelah mengonfigurasi task, klik tombol Publish pada toolbar task untuk mengirimkan task integrasi ke lingkungan produksi. Task tersebut kemudian dikelola oleh sistem penjadwalan dan pemantauan terpadu di Operation Center.

Setelah task dipublikasikan, Anda dapat melihat status running, log, alert, dan dependensinya di Operation Center. Untuk informasi tentang operasi seperti manajemen instance, menjalankan ulang task yang gagal, tuning performa, dan penanganan dirty data, lihat O&M dan tuning task.

Memilih jenis tugas

Memahami kasus penggunaan untuk setiap mode sinkronisasi dan perilakunya terhadap penjadwalan serta dependensi merupakan kunci untuk membangun workflow yang efisien dan andal.

Sinkronisasi batch tabel tunggal

Untuk detail konfigurasi, lihat: Konfigurasi task di antarmuka tanpa kode dan Konfigurasi task di editor kode.

Deskripsi: Menyinkronkan data secara berkala dalam batch dari satu tabel sumber ke satu tabel tujuan. Task dijalankan berdasarkan siklus penjadwalan yang ditentukan (misalnya, harian atau per jam).

Kasus penggunaan:

Menyinkronkan data bisnis harian (T+1) untuk membangun layer ODS atau DWD pada gudang data.

Mengarsipkan tabel bisnis secara berkala dari database produksi ke data lake atau gudang data.

Memigrasikan data secara berkala untuk laporan lintas berbagai sumber data.

Sinkronisasi real-time tabel tunggal

Untuk detail konfigurasi, lihat: Konfigurasi task real-time tabel tunggal.

Deskripsi: Proses ini biasanya menggunakan change data capture (CDC) dari log atau mengonsumsi data dari message queue.

Use case:

Menyinkronkan perubahan real-time dari database bisnis ke gudang data, seperti MaxCompute atau Hologres, untuk membangun gudang data real-time.

Menyediakan sumber data untuk dasbor pemantauan real-time atau sistem rekomendasi.

Menerapkan replikasi data real-time untuk satu tabel antara instans database yang berbeda.

Sinkronisasi batch database penuh

Untuk detail konfigurasi, lihat: Task sinkronisasi batch database penuh.

Deskripsi: Melakukan sinkronisasi data batch satu kali atau berkala untuk semua atau beberapa tabel dalam database sumber.

Kasus penggunaan:

Melakukan migrasi awal penuh seluruh database bisnis ke gudang data cloud.

Menjalankan backup penuh atau inkremental rutin untuk seluruh database.

Mengimpor seluruh data historis dalam satu operasi untuk menginisialisasi lingkungan analitik data baru.

Sinkronisasi real-time database penuh

Untuk detail konfigurasi, lihat: Task sinkronisasi real-time database penuh.

Deskripsi: Menangkap perubahan skema dan data secara real-time dari semua atau tabel tertentu dalam database sumber, lalu menyinkronkannya ke tujuan.

Use Cases:

Mereplikasi seluruh database Online Transaction Processing (OLTP) produksi ke database analitik secara real-time untuk mengaktifkan pemisahan baca/tulis dan analitik real-time.

Membangun solusi pemulihan bencana real-time untuk database.

Menjaga konsistensi data real-time antara data lake atau platform data dengan berbagai sistem bisnis hulu.

Sinkronisasi full-incremental untuk seluruh database

Untuk detail konfigurasi, lihat: Task sinkronisasi full dan inkremental untuk seluruh database.

Deskripsi: Data CDC yang ditangkap selama sinkronisasi real-time mencakup tiga jenis operasi:

Insert,Update, danDelete. Untuk sistem penyimpanan append-only, seperti tabel MaxCompute non-Delta, operasiUpdateatauDeletefisik tidak didukung secara native. Menulis aliran CDC langsung ke sistem ini dapat menyebabkan inkonsistensi data (misalnya, operasi delete tidak tercermin). Mode ini mengatasi masalah tersebut dengan membuat tabelBaseuntuk snapshot lengkap dan tabelLoguntuk log inkremental di tujuan.Kasus penggunaan:

Tabel tujuan adalah tabel MaxCompute non-Delta, dan tabel sumber tidak memiliki kolom auto-increment, sehingga mencegah penggunaan sinkronisasi inkremental batch. Dalam skenario ini, Anda dapat menggunakan task full-incremental untuk seluruh database guna menulis data inkremental dalam hitungan menit. Status akhir yang digabungkan akan terlihat secara T+1.

Perbandingan fitur

Jenis tugas | Lokasi pembuatan | Orkestrasi workflow | Konfigurasi penjadwalan | Debugging Data Studio | Isolasi sumber data |

Single-table batch synchronization | Hanya di Data Studio | ||||

Real-time single-table synchronization | Data Studio / Data Integration |

(hanya sebagai node mandiri) | (Harus dipublikasikan ke Operation Center untuk dijalankan) | ||

Full-database batch synchronization | Data Studio / Data Integration | (hanya sebagai node mandiri) | (penjadwalan dapat diatur untuk sub-task) | (Harus dipublikasikan ke Operation Center untuk dijalankan) | |

Full-database real-time synchronization | Data Studio / Data Integration | (hanya sebagai node mandiri) | (Harus dipublikasikan ke Operation Center untuk dijalankan) | ||

Full-incremental synchronization for entire databases | Data Studio / Data Integration | (hanya sebagai node mandiri) | (penjadwalan dapat diatur untuk sub-task) | (Harus dipublikasikan ke Operation Center untuk dijalankan) |

FAQ

Untuk pertanyaan umum tentang Data Integration, lihat FAQ Data Integration.