Node Spark SQL memungkinkan Anda menggunakan mesin query SQL terdistribusi untuk memproses data terstruktur, meningkatkan efisiensi operasi pekerjaan. DataWorks menyediakan node CDH Spark SQL yang dapat digunakan untuk mengembangkan dan menjadwalkan tugas CDH Spark SQL secara berkala serta mengintegrasikannya dengan jenis tugas lainnya. Topik ini menjelaskan cara membuat dan menggunakan node CDH Spark SQL.

Prasyarat

Sebuah alur kerja dibuat di DataStudio.

Operasi pengembangan di berbagai jenis mesin komputasi dilakukan berdasarkan alur kerja di DataStudio. Oleh karena itu, sebelum membuat node, Anda harus membuat alur kerja. Untuk informasi lebih lanjut, lihat Buat Alur Kerja.

Sebuah kluster CDH Alibaba Cloud dibuat dan didaftarkan ke DataWorks.

Sebelum membuat node CDH dan menggunakan node CDH untuk mengembangkan tugas CDH di DataWorks, Anda harus mendaftarkan kluster CDH ke ruang kerja DataWorks. Untuk informasi lebih lanjut, lihat Daftarkan Kluster CDH atau CDP ke DataWorks.

Grup sumber daya tanpa server dibeli dan dikonfigurasi, termasuk asosiasi dengan ruang kerja dan konfigurasi jaringan. Untuk informasi lebih lanjut, lihat Buat dan Gunakan Grup Sumber Daya Tanpa Server.

Batasan

Tugas pada node CDH Spark SQL dapat dijalankan pada grup sumber daya tanpa server atau grup sumber daya eksklusif versi lama untuk penjadwalan. Kami menyarankan Anda menjalankan tugas pada grup sumber daya tanpa server.

Langkah 1: Buat node CDH Spark SQL

Pergi ke halaman DataStudio.

Masuk ke Konsol DataWorks. Di bilah navigasi atas, pilih wilayah yang diinginkan. Di panel navigasi kiri, pilih . Pada halaman yang muncul, pilih ruang kerja yang diinginkan dari daftar drop-down dan klik Go to Data Development.

Di halaman DataStudio, temukan alur kerja yang diinginkan, klik kanan nama alur kerja, dan pilih .

Di kotak dialog Create Node, konfigurasikan parameter Name dan klik Confirm. Kemudian, Anda dapat menggunakan node yang telah dibuat untuk mengembangkan dan mengonfigurasi tugas CDH Spark SQL.

Langkah 2: Kembangkan tugas CDH Spark SQL

(Opsional) Pilih kluster CDH

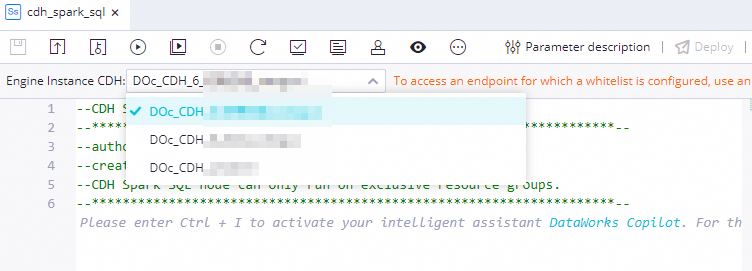

Jika beberapa kluster Cloudera's Distribution termasuk Apache Hadoop (CDH) didaftarkan ke ruang kerja saat ini, Anda harus memilih kluster dari daftar drop-down Engine Instance CDH berdasarkan kebutuhan bisnis Anda. Jika hanya satu kluster CDH yang didaftarkan ke ruang kerja saat ini, kluster tersebut akan digunakan secara otomatis untuk pengembangan.

Kembangkan kode SQL

Kembangkan kode SQL: Contoh sederhana

Di editor kode pada tab konfigurasi node CDH Spark SQL, tulis kode tugas.

Dalam contoh ini, Anda dapat membuat tabel test_lineage_table_f1 dan test_lineage_table_t2 dalam database test_spark dan menyalin data dari tabel test_lineage_table_f1 ke tabel test_lineage_table_t2. Contoh kode:

Contoh ini hanya untuk referensi. Anda dapat menulis kode berdasarkan kebutuhan bisnis Anda.

CREATE TABLE IF NOT EXISTS test_spark.test_lineage_table_f1 (`id` BIGINT, `name` STRING)

PARTITIONED BY (`ds` STRING);

CREATE TABLE IF NOT EXISTS test_spark.test_lineage_table_t2 AS SELECT * FROM test_spark.test_lineage_table_f1;

INSERT into test_spark.test_lineage_table_t2 SELECT * FROM test_spark.test_lineage_table_f1;Kembangkan kode SQL: Gunakan parameter penjadwalan

DataWorks menyediakan scheduling parameters yang nilainya diganti secara dinamis dalam kode tugas berdasarkan konfigurasi parameter penjadwalan dalam skenario penjadwalan periodik. Anda dapat mendefinisikan variabel dalam kode tugas dalam format ${Variable} dan memberikan nilai kepada variabel di bagian Scheduling Parameter pada tab Properties. Untuk informasi tentang format yang didukung dari parameter penjadwalan dan cara mengonfigurasi parameter penjadwalan, lihat Format yang Didukung dari Parameter Penjadwalan dan Konfigurasikan dan Gunakan Parameter Penjadwalan.

Contoh kode:

SELECT '${var}'; -- Anda dapat menetapkan parameter penjadwalan tertentu ke variabel var.(Opsional) Konfigurasikan parameter lanjutan

Di editor kode pada tab konfigurasi node CDH Spark SQL, klik Advanced Settings di panel navigasi kanan untuk mengonfigurasi parameter lanjutan. Kode berikut memberikan contoh:

"spark.driver.memory": "2g": menentukan ukuran memori yang dialokasikan ke node driver Spark."spark.yarn.queue": "haha": menentukan antrian Yarn ke mana aplikasi dikirimkan.

Untuk informasi lebih lanjut tentang cara mengonfigurasi parameter lanjutan, lihat Konfigurasi Spark.

Langkah 3: Konfigurasikan properti penjadwalan tugas

Jika Anda ingin sistem secara berkala menjalankan tugas pada node, Anda dapat mengklik Properties di panel navigasi kanan pada tab konfigurasi node untuk mengonfigurasi properti penjadwalan tugas berdasarkan kebutuhan bisnis Anda. Untuk informasi lebih lanjut, lihat Ikhtisar.

Anda harus mengonfigurasi parameter Rerun dan Parent Nodes pada tab Properti sebelum Anda mengirimkan tugas.

Langkah 4: Debug kode tugas

Anda dapat melakukan operasi berikut untuk memeriksa apakah tugas dikonfigurasi sesuai harapan berdasarkan kebutuhan bisnis Anda:

Opsional. Pilih grup sumber daya dan tetapkan parameter kustom ke variabel.

Klik ikon

di bilah alat atas pada tab konfigurasi node. Dalam kotak dialog Parameters, pilih grup sumber daya untuk penjadwalan yang ingin Anda gunakan untuk men-debug dan menjalankan kode tugas.

di bilah alat atas pada tab konfigurasi node. Dalam kotak dialog Parameters, pilih grup sumber daya untuk penjadwalan yang ingin Anda gunakan untuk men-debug dan menjalankan kode tugas.Jika Anda menggunakan parameter penjadwalan dalam kode tugas Anda, tetapkan parameter penjadwalan ke variabel sebagai nilai dalam kode tugas untuk debugging. Untuk informasi lebih lanjut tentang logika penetapan nilai parameter penjadwalan, lihat Prosedur Debugging.

Simpan dan jalankan kode tugas.

Di bilah alat atas, klik ikon

untuk menyimpan kode tugas. Lalu, klik ikon

untuk menyimpan kode tugas. Lalu, klik ikon  untuk menjalankan kode tugas.

untuk menjalankan kode tugas.Opsional. Lakukan pengujian asap.

Saat Anda mengirimkan node atau setelah Anda mengirimkan node, Anda dapat melakukan pengujian asap pada node di lingkungan pengembangan untuk memeriksa apakah node dijalankan sesuai harapan. Untuk informasi lebih lanjut, lihat Lakukan Pengujian Asap.

Langkah 5: Kirim dan deploy tugas

Setelah tugas pada node dikonfigurasi, Anda harus mengirim dan mendeploy tugas tersebut. Setelah Anda mengirim dan mendeploy tugas, sistem menjalankan tugas secara berkala berdasarkan konfigurasi penjadwalan.

Klik ikon

di bilah alat atas untuk menyimpan tugas.

di bilah alat atas untuk menyimpan tugas.Klik ikon

di bilah alat atas untuk mengirimkan tugas pada node.

di bilah alat atas untuk mengirimkan tugas pada node.Di kotak dialog Submit, konfigurasikan parameter Change description. Lalu, tentukan apakah akan meninjau kode tugas setelah Anda mengirimkan tugas berdasarkan kebutuhan bisnis Anda.

CatatanAnda harus mengonfigurasi parameter Rerun dan Parent Nodes pada tab Properti sebelum Anda mengirimkan tugas.

Anda dapat menggunakan fitur tinjauan kode untuk memastikan kualitas kode tugas dan mencegah kesalahan eksekusi tugas yang disebabkan oleh kode tugas yang tidak valid. Jika Anda mengaktifkan fitur tinjauan kode, kode node yang dikirimkan hanya dapat dideploy setelah kode node lolos tinjauan kode. Untuk informasi lebih lanjut, lihat Tinjauan Kode.

Jika Anda menggunakan ruang kerja dalam mode standar, Anda harus mendeploy tugas di lingkungan produksi setelah Anda mengirimkan tugas. Untuk mendeploy tugas pada node, klik Deploy di pojok kanan atas tab konfigurasi node. Untuk informasi lebih lanjut, lihat Deploy Tugas.

Apa yang harus dilakukan selanjutnya

O&M Tugas: Setelah Anda mengirim dan mendeploy tugas, tugas dijalankan secara berkala berdasarkan konfigurasi penjadwalan. Anda dapat mengklik Operation Center di pojok kanan atas tab konfigurasi node yang sesuai untuk pergi ke Pusat Operasi dan melihat status penjadwalan tugas. Untuk informasi lebih lanjut, lihat Lihat dan Kelola Tugas yang Dipicu Otomatis.

Lihat Garis Keturunan: Setelah Anda mengirim dan mendeploy tugas, Anda dapat melihat garis keturunan tugas di halaman Peta Data. Sebagai contoh, Anda dapat melihat sumber data asli dan basis data ke mana data tabel mengalir. Lalu, Anda dapat menganalisis dampak dari berbagai tingkat garis keturunan berdasarkan kebutuhan bisnis Anda. Untuk informasi lebih lanjut, lihat Lihat Garis Keturunan.