시장이 변하고 있습니다.

기존 IT 기반의 워크로드는 DT 기반의 워크로드로 변하고 있으며 이에 따라 CPU 기반의 서비스에서 GPU 기반의 서비스로 점차 변화하고 있습니다.

특히 GPU는 일반적인 서비스 워크로드가 아닌, 데이터를 활용한 AI에 많이 활용이 되고 있습니다.

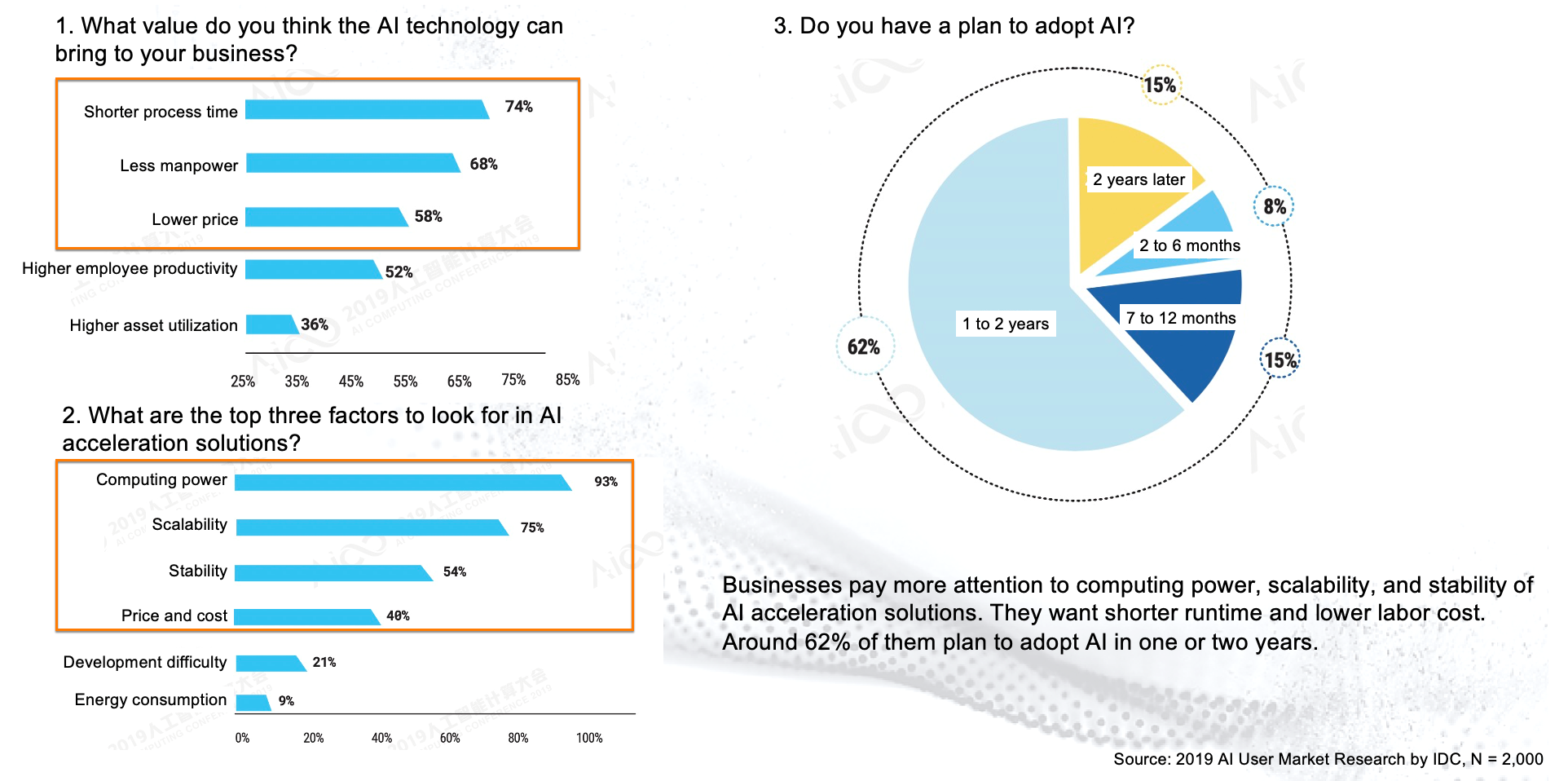

알리바바 클라우드에서는 AI영역에서 일하고 있는 엔지니어를 대상으로 AI 워크로드를 활용하는데 어떤 어려움이 있는지 조사했습니다.

먼저 AI 가 가져올 이점이 어떤 것이 있을까에 대한 질문에 (1. 짧은 프로세스 타임, 2. 인력 절감, 3. 비용 절감)을 답했으며, AI 솔루션이 가져야할 중요 기능에 대한 질문에 (1. 컴퓨팅 파워, 2. 확장성, 3. 안정성 및 가격)으로 답했습니다.

이러한 시장의 요구사항을 만족할 수 있는 알리바바 클라우드 GPU 서비스들에 대해 설명하겠습니다.

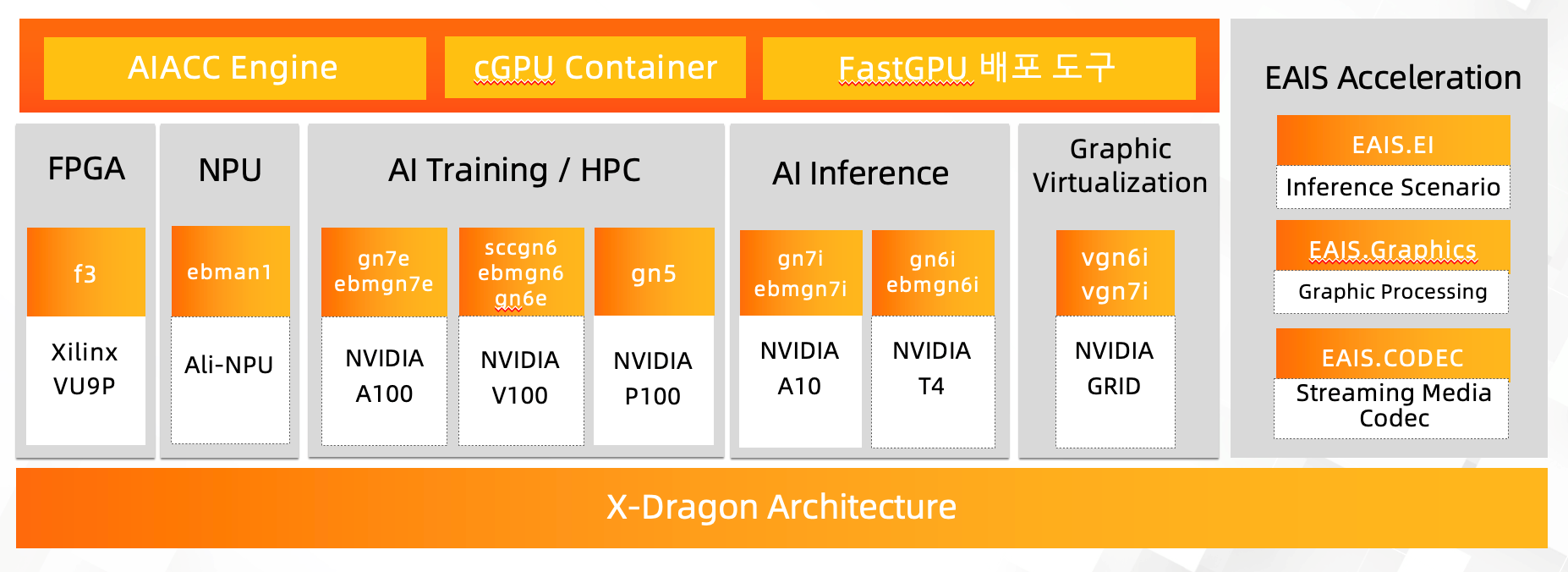

알리바바 클라우드는 X-Dragon 가상화 아키텍쳐를 기반으로 여러 종류의 GPU 클러스터와 GPU 리소스를 효율적으로 활용하기 위한 소프트웨어 기능을 가지고 있습니다.

여기서 집중해볼 만한 서비스들에 대해 정리해보겠습니다.

Alibaba Cloud는 인공 지능, 기계 학습 및 데이터 분석과 같은 컴퓨팅 집약적인 워크로드에 최적화된 FPGA 기반 Elastic Compute Service(ECS) 인스턴스를 제공합니다. 이러한 인스턴스는 Xilinx Virtex UltraScale+ FPGA로 구동되며 복잡한 알고리즘 및 계산을 위한 고성능, 저지연 처리를 제공하도록 설계되었습니다.

Alibaba Cloud에서 FPGA를 사용하면 사용자는 더 빠른 처리 속도와 더 짧은 대기 시간을 달성하여 애플리케이션 성능을 개선하고 클라우드 컴퓨팅 인프라 비용을 줄일 수 있습니다.

Alibaba Cloud는 이미지 및 음성 인식, 자연어 처리, 추천 시스템과 같은 딥 러닝 워크로드에 최적화된 NPU 기반 Elastic Compute Service(ECS) 인스턴스를 제공합니다. 이러한 인스턴스에는 매트릭스 곱셈 및 기타 일반적인 신경망 작업을 고효율 및 짧은 대기 시간으로 수행할 수 있는 전용 NPU가 장착되어 있습니다.

사용자는 Alibaba Cloud에서 NPU를 사용하여 딥 러닝 워크로드의 처리 속도를 높이고 대기 시간을 단축하여 애플리케이션 성능을 개선하고 클라우드 컴퓨팅 인프라 비용을 절감할 수 있습니다. 또한 Alibaba Cloud는 NPU 기반 ECS 인스턴스에 쉽게 배포할 수 있는 다양한 사전 구축 딥 러닝 모델을 제공하여 사용자가 딥 러닝을 쉽게 시작할 수 있도록 합니다.

AI 전용 Nvidia GPU 클러스터를 활용하여 GPU를 활용한 딥러닝 알고리즘을 가속화 할 수 있습니다.

NVIDIA V100 및 P100은 서로 다른 워크로드 및 사용 사례를 위해 설계된 서로 다른 세대의 NVIDIA GPU 가속기입니다.

NVIDIA P100은 NVIDIA Pascal 아키텍처의 1세대이며 고성능 컴퓨팅(HPC) 워크로드용으로 설계되었습니다. 최대 3584개의 CUDA 코어와 16GB 또는 12GB의 고대역폭 메모리(HBM2)를 갖추고 있어 최대 9.3테라플롭의 단정밀도 부동 소수점 성능을 제공합니다.

NVIDIA V100은 NVIDIA Volta 아키텍처의 2세대이며 HPC 및 딥 러닝 워크로드를 위해 설계되었습니다. 최대 5120개의 CUDA 코어와 16GB 또는 32GB의 HBM2를 탑재하여 최대 7.8테라플롭의 배정밀도 부동 소수점 성능 또는 최대 15.7테라플롭의 단정밀도 부동 소수점 성능을 제공합니다.

전반적으로 이러한 GPU 간의 주요 차이점은 성능, 메모리 용량 및 특수 하드웨어 기능입니다. P100은 HPC 워크로드에 최적화되어 있지만 V100은 HPC 및 AI 워크로드 모두에 최적화되어 있으며 P100보다 더 높은 성능과 더 많은 메모리 용량을 제공합니다.

비교적 비용 효율적인 A10/T4 클러스터를 이용하여 Ai inference, 렌더링, 미디어 인코딩/디코딩에 대한 업무를 수행할 수 있습니다.

NVIDIA T4와 A10은 모두 데이터 센터 애플리케이션용으로 설계된 GPU이지만 둘 사이에는 몇 가지 중요한 차이점이 있습니다.

NVIDIA T4는 Turing 아키텍처를 기반으로 하는 GPU이며 인공 지능, 기계 학습 및 데이터 분석을 포함한 광범위한 워크로드를 위해 설계되었습니다. 16GB의 GDDR6 메모리와 딥 러닝 워크로드를 가속화하도록 특별히 설계된 320개의 튜링 텐서 코어가 특징입니다. T4에는 딥 러닝 워크로드를 가속화하도록 설계된 320개의 튜링 텐서 코어도 포함되어 있습니다.

반면 NVIDIA A10은 Ampere 아키텍처를 기반으로 하는 GPU이며 AI 및 HPC 워크로드용으로 특별히 설계되었습니다. 24GB의 GDDR6 메모리와 640개의 Tensor 코어가 특징이며 딥 러닝을 위한 훈련 및 추론 워크로드를 가속화하도록 설계되었습니다. A10에는 실시간 렌더링 및 기타 그래픽 집약적인 애플리케이션을 가속화할 수 있는 64개의 전용 RT(레이 트레이싱) 코어도 포함되어 있습니다.

성능면에서 A10은 AI 및 딥 러닝 워크로드, 특히 대형 모델 훈련에 대해 T4보다 높은 성능을 제공합니다. A10에는 또한 더 많은 메모리 용량이 포함되어 있어 더 큰 워크로드에 유용할 수 있습니다. 그러나 T4는 AI와 딥 러닝을 넘어 더 넓은 범위의 워크로드에 사용할 수 있는 보다 다재다능한 GPU입니다.

알리바바 클라우드는 위에서 설명한 많은 종류의 GPU를 효율적으로 활용할 수 있는 다양한 기능을 제공하고 있습니다. 이 기능 중 가장 주목할만한 4가지 기능에 대해 소개해보겠습니다.

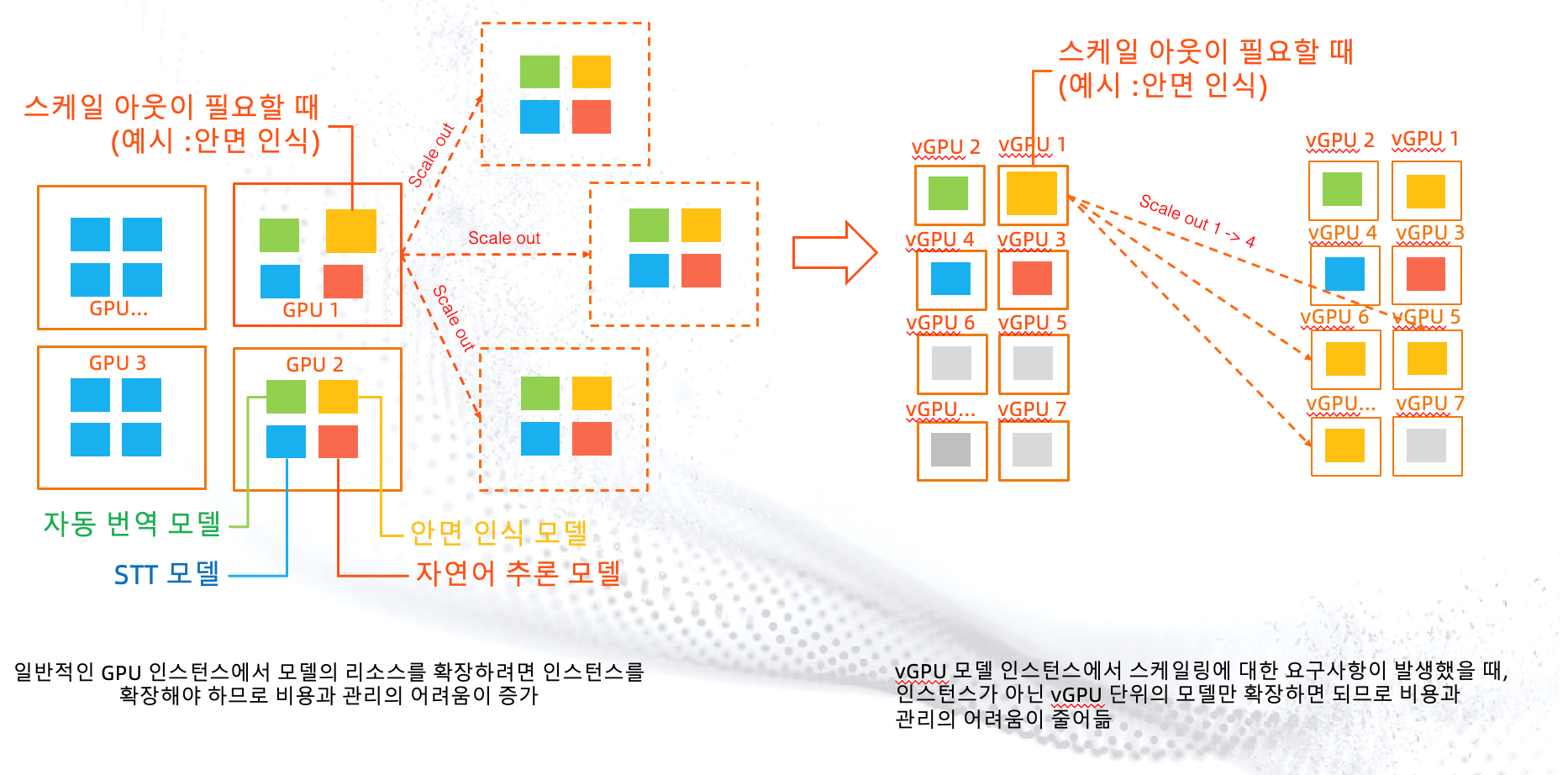

vGPU는 Nvidia의 Grid 가상화 기술을 활용한 아키텍쳐입니다. GPU와 데이터사이언티스트간의 비율이 1:1로만 활용 가능하던 제한을 깨기 위해, 한장의 GPU 카드를 여러명의 데이터사이언티스트가 사용할 수 있도록 만들어주는 아키텍쳐입니다.

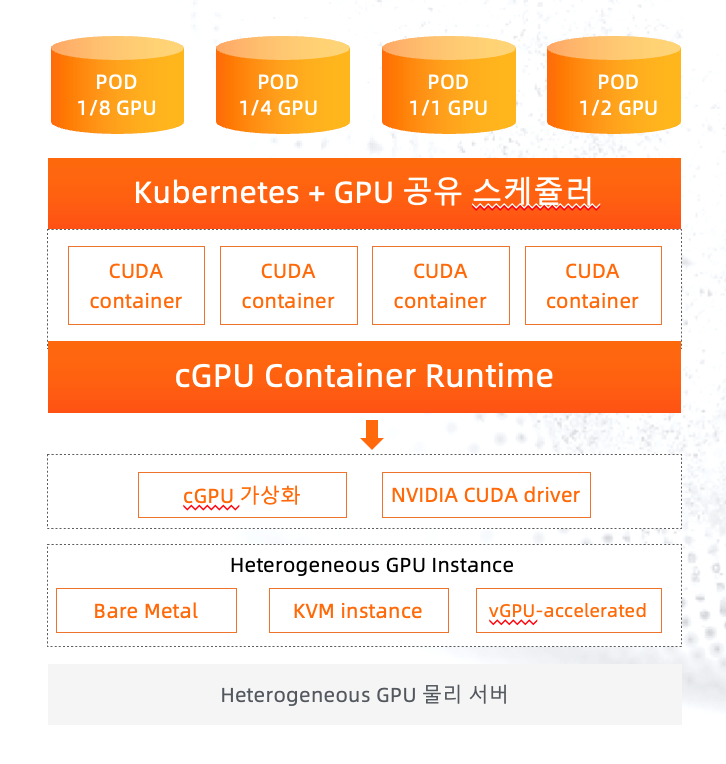

cGPU는 인스턴스 단위가 아닌 컨테이너에서 GPU 가상화를 활용하기 위한 기술입니다. 이 기술은 알리바바 클라우드에서 cuda driver를 활용하여 만든 기술로, 알리바바 클라우드의 쿠버네티스 기술인 ACK에서 활용될 수 있습니다.

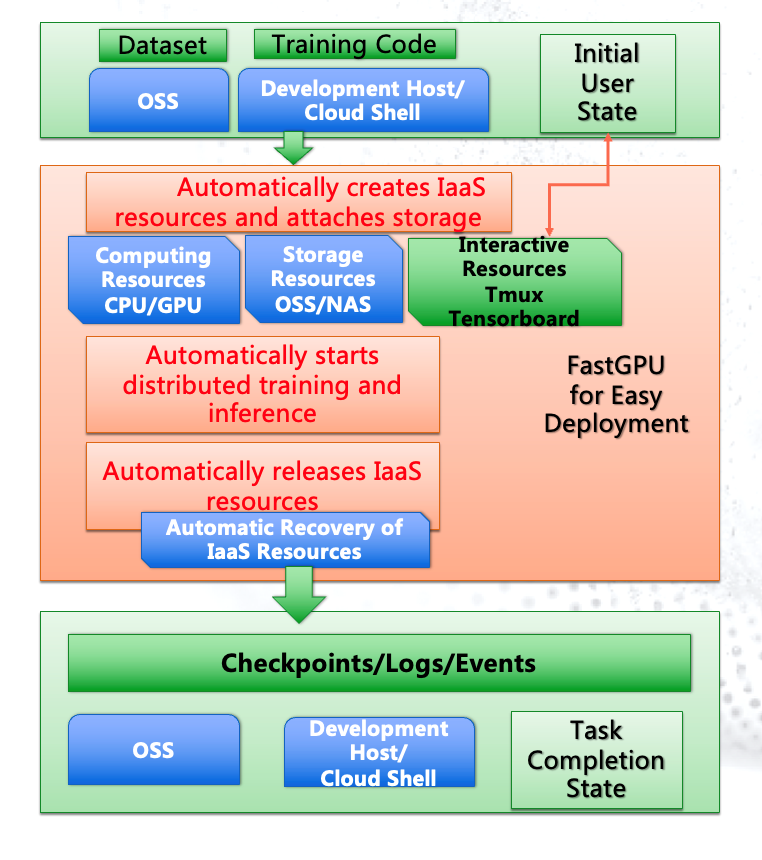

FastGPU는 다수의 GPU 인스턴스를 클러스터링하여 비즈니스에 활용하려는 목적이 있을 때 유용한 기술입니다.

기존에는 여러개의 GPU를 클러스터링을 하기 위해서는 ecluster create 명령어 등을 활용하여 셋업을 하고, 공유 스토리지를 연결하고 단일 엔드포인트를 만드는 등 여러가지 작업으로 인해 몇 일~몇 주간의 시간이 소요되었습니다.

하지만 이 FastGPU 기술을 활용한다면 GPU 클러스터링 부터 공유스토리, Shell 환경 셋업까지 자동으로 수행할 수 있어 비즈니스 가속화에 도움을 받을 수 있습니다.

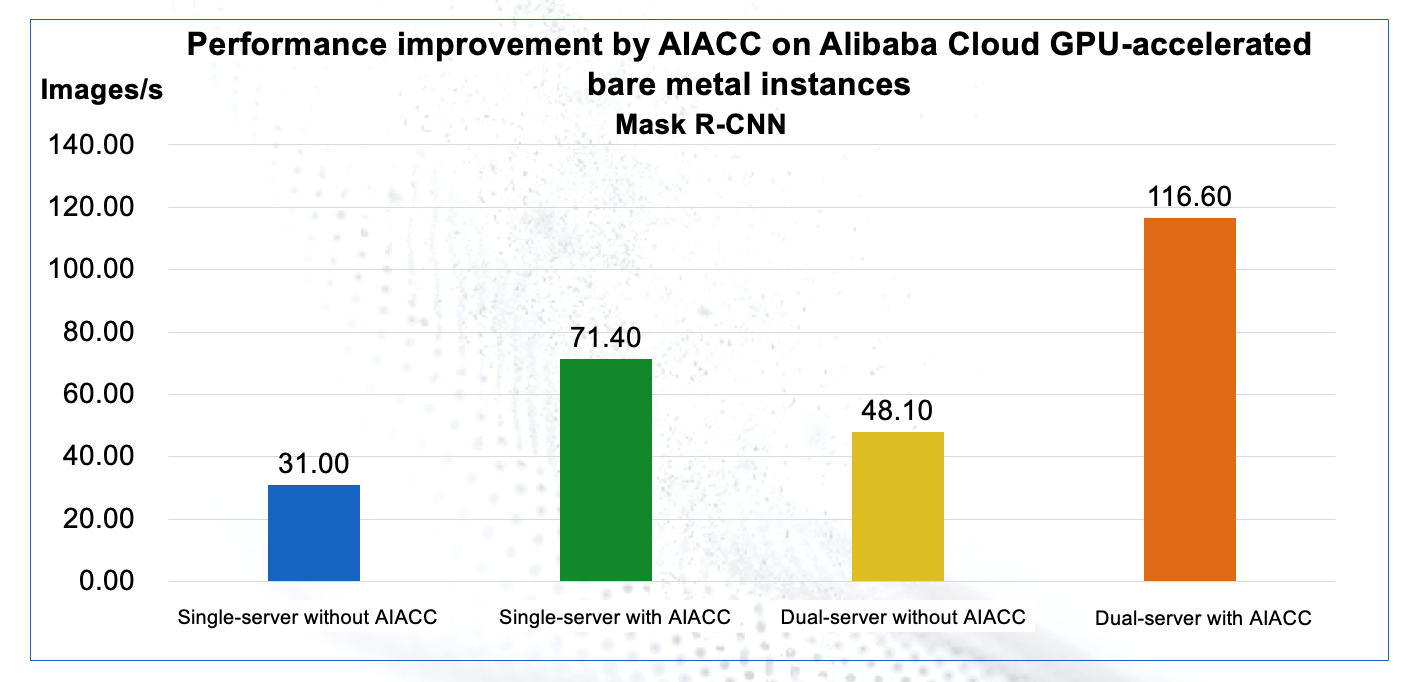

AIACC는 GPU를 활용한 딥러닝 워크로드에서 추론 및 인지 학습을 가속화하기 위한 소프트웨어 아키텍쳐입니다.

AIACC는 GPU 클러스터에 몇 가지 configuration만 추가하면 바로 사용할 수 있을 정도로 쉬운 사용성을 가지고 있습니다. 특히 1장의 카드를 가진 Single instance가 아닌 여러장의 GPU를 활용한 인스턴스에서 비약적인 효과를 얻을 수 있습니다.

알리바바 클라우드의 GPU서비스는 VFX, 메타버스, 게이밍 비즈니스에서의 3D Rendering / 게이밍, 엔터프라이즈 비즈니스에서의 AI Deep Learning / 비디오, 오디오 원본의 Encoding, Decoding / 자율 주행을 위한 Machine Learning 등에서 많이 활용되고 있습니다.

최근 알리바바 클라우드 서울리전에 최신 GPU 칩셋인 A10 타입의 인스턴스가 다수 배포되었습니다. 알리바바 클라우드 한국팀은 한국의 엔터프라이즈 고객에게 최고의 로컬 서비스를 제공하기 위해 노력하고 있습니다.

알리바바 클라우드의 GPU 서비스에 대해 추가적으로 궁금하신 부분이 있으시면 abckr@list.alibaba-inc.com 으로 문의 메일을 주시기 바랍니다.

알리바바 클라우드 자격증(Alibaba Cloud Professional Certificate) 소개 및 수험 절차 가이드

Regional Content Hub - December 10, 2025

Edwin Tack - February 21, 2024

Regional Content Hub - July 23, 2025

JJ Lim - October 28, 2025

JJ Lim - December 29, 2023

JJ Lim - December 3, 2021

GPU(Elastic GPU Service)

GPU(Elastic GPU Service)

Powerful parallel computing capabilities based on GPU technology.

Learn More Deploy NVIDIA on Alibaba Cloud

Deploy NVIDIA on Alibaba Cloud

Fueled by the insatiable demand for better 3D graphics, and the massive scale of the gaming market, NVIDIA has evolved the GPU into a computer brain at the exciting intersection of virtual reality, high performance computing, and artificial intelligence.

Learn More ECS(Elastic Compute Service)

ECS(Elastic Compute Service)

Elastic and secure virtual cloud servers to cater all your cloud hosting needs.

Learn More Elastic Desktop Service

Elastic Desktop Service

A convenient and secure cloud-based Desktop-as-a-Service (DaaS) solution

Learn MoreMore Posts by JJ Lim

Dikky Ryan Pratama June 26, 2023 at 12:44 am

Awesome!