자, 최신 기술에 능한 여러분, 인공지능의 세계로 떠나는 스릴 넘치는 모험을 준비하세요! 저희는 발끝만 담그는 것이 아니라, Qwen Chat 모델과 함께 보다 깊숙히 뛰어들려고 합니다. 과제는 무엇일까요? 여우보다 더 영리한 챗봇을 설정하고 최고의 비밀 요원처럼 프라이버시를 존중해야 합니다. 흥미가 생기시나요? 그러실 거예요! 생성형 AI와 LLM(거대언어모델)을 이해하는 것으로 여정을 시작해 보겠습니다.

생성형 AI는 텍스트, 이미지, 음악 또는 기타 형태의 미디어 등 새로운 콘텐츠를 만드는 데 중점을 둔 인공지능 분야를 말합니다. 이러한 유형의 AI는 머신러닝 모델, 특히 생성형 모델을 활용하여 대규모 데이터 세트의 패턴, 특징 및 관계를 이해하고 사람이 만든 콘텐츠와 구별할 수 없는 새로운 결과물을 생성합니다.

생성형 AI는 계속해서 빠르게 진화하고 있으며, 그 기능은 기계가 만들어낼 수 있는 것의 경계를 확장하여 흥미로운 기회와 책임감 있게 관리해야 하는 과제를 동시에 제공하고 있습니다.

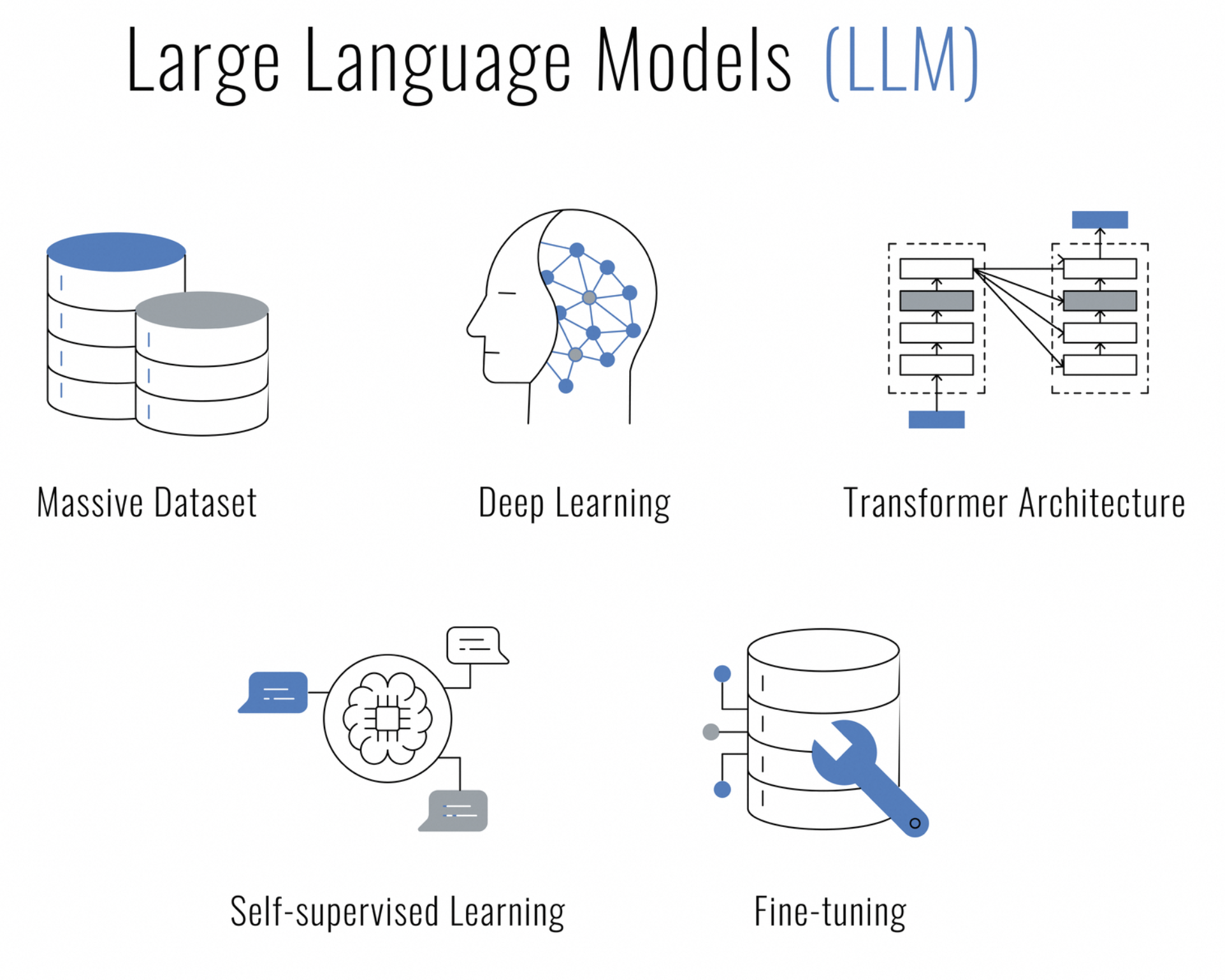

거대언어모델(LLM)이란 무엇일까요? 거대언어모델은 인간의 언어를 이해하고, 생성하고, 작업하도록 설계된 딥러닝 기술을 기반으로 하는 일종의 인공지능입니다. 수백만 개 또는 수십억 개의 매개변수로 구성되어 다양한 언어 뉘앙스와 문맥을 포착할 수 있기 때문에 '거대'라고 불립니다.

LLM은 방대한 양의 텍스트 데이터로 학습되며, 문장과 같은 데이터의 시퀀스를 처리하고 예측을 할 때 시퀀스의 여러 부분에 주의를 기울이는 능력을 갖춘 트랜스포머 신경망과 같은 아키텍처를 사용합니다. 따라서 다음과 같은 다양한 자연어 처리(NLP) 작업에 특히 효과적입니다.

개인 정보 보호 권리를 존중하면서 채팅, 콘텐츠 제작, 요약, 코딩 등 다양한 작업을 수행할 수 있는 AI를 찾고 계신가요? 더 이상 고민하지 마세요. Qwen Chat 모델은 데이터 센터를 안전한 AI 기반 상호 작용의 보루로 바꿔줄 것입니다.

Qwen은 일반적인 챗봇이 아닙니다. 방대한 언어 모델을 기반으로 구축되었으며 무려 3조 개에 달하는 다국어 데이터로 학습되었습니다. 이 놀라운 인공지능은 영어와 중국어를 모두 정교하게 이해하며 사람과 같은 상호작용을 위해 세밀하게 조정되었습니다.

서버에 로컬로 Qwen을 배포하는 것은 제어권을 확보하는 것입니다. 즉, 사용자가 나누는 대화, 처리되는 데이터, 약속된 개인정보 보호가 사용자의 권한 하에 유지되도록 보장하는 것입니다. 인텔리전트 채팅 시스템을 통합하고자 하는 기업, AI 연구에 관심이 많은 개발자, 대화형 AI의 한계를 탐구하고자 하는 열성 팬 모두에게 Qwen은 최고의 선택입니다.

그렇다면 이 LLM을 로컬에서 호스팅하려는 이유는 무엇인가요? 세 단어로 요약할 수 있습니다. 제어, 속도, 개인정보 보호. 데이터를 안전하게 보호하고, 빠른 속도로 응답하며, 챗봇이 공개 서비스 전체에 내 비밀을 누설하지 않아 안심할 수 있습니다.

AI의 혁신 정신은 오픈 소스 커뮤니티에 의해 더욱 증폭됩니다. 이러한 전통을 이어받아, Qwen Chat 모델의 전체 소스 코드는 모델의 메커니즘을 자세히 살펴보고, 개발에 기여하거나, 단순히 학습 리소스로 사용하는 데 관심이 있는 사람이라면 누구나 GitHub에서 쉽게 이용할 수 있습니다. 연구자, 개발자 또는 AI 애호가라면 누구나 Qwen에서 소스 코드에 접근할 수 있습니다.

이 기술 오디세이를 시작하기 전에 모든 준비가 완료되었는지 확인해 보겠습니다.

전부 준비하셨나요? 좋습니다! 이제 본격적으로 시작해 보겠습니다.

Visual Studio Code의 열렬한 팬이든, PyCharm 애호가이든, Jupyter Notebooks의 대화형 감각을 즐기는 사람이든, Qwen과의 채팅을 위한 Python 코드는 유연하고 IDE에 구애받지 않습니다. Python을 지원하는 환경만 있으면 인공지능 채팅 친구를 만들 수 있습니다.

전문가 팁: VSCode를 사용하는 경우, 내장된 터미널을 활용하여 Python 스크립트를 원활하게 실행하세요. 명령 팔레트를 열고(Ctrl+Shift+P) Python을 입력하기만 하면 됩니다. 터미널에서 Run Python File을 입력하면 VSCode가 알아서 처리합니다. 통합 터미널에서 Qwen의 응답을 바로 확인할 수 있습니다.

PyCharm을 선호하는 분들의 경우 코드 실행이 그만큼 매끄러워집니다. 스크립트를 마우스 오른쪽 버튼으로 클릭하고 Run 'script_name.py'을 선택한 다음 IDE가 Qwen과의 대화를 실행하는 것을 지켜보세요. PyCharm의 강력한 도구와 디버깅 기능은 보다 복잡한 인터랙션을 개발하는 데 탁월한 선택입니다.

Python을 두 팔 벌려 환영하는 수많은 IDE와 코드 편집기가 있습니다. 여러분의 워크플로에 가장 적합한 것을 골라 채팅을 시작해 보세요!

먼저 Linux 서버를 준비해 보겠습니다. 패키지 목록이 아침 산들바람처럼 신선한 상태인지, Python과 pip가 마법처럼 작동할 준비가 되었는지 확인하세요.

sudo apt update

sudo apt install python3 python3-pip이제 비밀스러운 요소인 가상 환경을 소개합니다. 이것은 정리하라고 소리치는 사람 없이 마음놓고 엉망으로 만들 수 있는 개인 작업 공간을 갖는 것과 같습니다.

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateQwen에 생명을 불어넣기 전에 몇 가지 도구가 필요합니다. 미슐랭 스타 요리를 위한 재료를 모은다고 생각하면 됩니다.

pip install torch torchvision torchaudio

pip install transformersPyTorch와 CUDA 버전을 매치하는 것은 고급 와인과 적절한 치즈를 페어링하는 것과 같습니다.

Qwen이 의미를 부여하기 전까지는 단어는 그저 단어일 뿐입니다. 이때 토큰화 도구가 등장하여 여러분의 생각을 Qwen이 이해할 수 있는 언어로 바꿔줍니다.

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)Qwen의 머릿속은 여러분의 대화로 채워질 준비가 되어 있습니다. 잠자는 거인을 깨우는 방법은 다음과 같습니다.

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()하드웨어에 따라 BF16 또는 FP16과 같은 다양한 정밀 모드를 선택할 수 있습니다. 완벽한 음정을 위해 기타를 튜닝하는 것과 같습니다.

이제 가슴이 두근거리는 부분인 Qwen과 대화할 시간입니다! 하지만 대화를 주고받기 전에 중요한 것, 즉 대화의 연속성을 유지하는 기술에 대해 이야기해 보겠습니다.

어떤 대화가 이어질지 살짝 엿볼 수 있습니다.

response, history = model.chat(tokenizer, "Greetings, Qwen! How's life in the digital realm?", history=None)

print("Qwen:", response)첫 시작에서는 아무런 조건 없이, 즉 대화 기록이 없는 상태로 Qwen에게 인사를 건네고 있습니다. history=None으로 설정하면 Qwen에게 "지금부터 채팅을 시작하겠습니다."라고 말하는 것입니다. 계속 진행하라는 현재 프롬프트만 있으면 Qwen은 새로운 상호작용의 신선함을 가지고 응답할 것입니다.

이제 문맥의 마법이 펼쳐지는 것을 지켜보세요.

response, history = model.chat(tokenizer, "Any thoughts on the meaning of life, the universe, and everything?", history=history)

print("Qwen:", response)이번 라운드에서는 이전 대화에서 받은 기록을 전달합니다. 이것은 마치 지금까지 우리가 나눈 모든 이야기가 담긴 일기장을 Qwen에게 건네주는 것과 같습니다. 이러한 과거 맥락을 통해 Qwen은 재치 있고 심오할 뿐만 아니라 현재 진행 중인 대화와도 연결되는 답변을 작성할 수 있습니다. 이는 나를 잘 아는 현명한 친구와 대화하는 것과 모르는 사람에게 질문하는 것의 차이입니다.

이제 히스토리 매개변수를 통해 맥락의 중요성에 대한 전문가가 되었으니 데모 스크립트를 실행하고 Qwen과 흥미로운 채팅을 시작할 준비를 하세요. 우주에 대해 이야기하든 디지털 쿠키를 만드는 최고의 레시피에 대해 이야기하든, Qwen은 노련한 대화 전문가처럼 우아하게 대화를 이끌어갈 준비가 되어 있습니다.

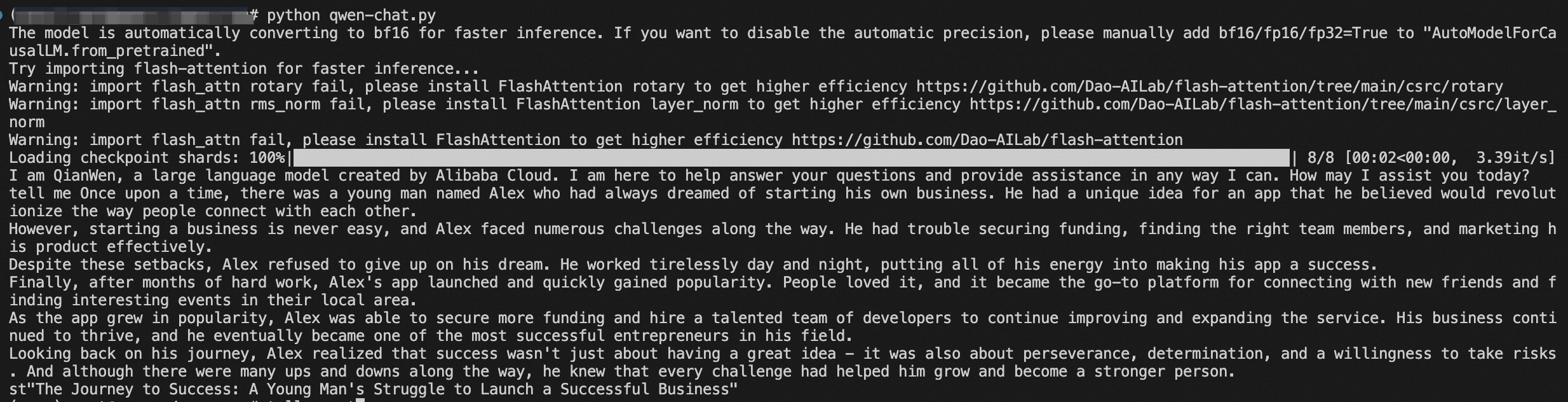

또한 스크립트를 실행하여 대화를 시작할 수도 있습니다. 판도라의 상자를 여는 것과 같지만, 혼돈 대신 유쾌한 농담을 들을 수 있습니다.

python qwen_chat.py이제 대화의 세계를 정복할 준비가 된 나만의 인공지능 채팅 친구가 생겼습니다.

축하합니다! 여러분은 노련한 선장처럼 AI 배포라는 위험한 바다를 항해해 왔습니다. 이제 Qwen이 서버에 안정적으로 정착했으며 데이터는 집처럼 안전하게 보호됩니다.

Qwen의 기능을 살펴보고, 개발에 기여하고, AI 대화의 발전에 열정을 가진 같은 생각을 가진 사람들로 구성된 커뮤니티에 가입하세요.

이제 멋진 새 AI 조수와 함께 멋진 대화를 나눠보세요. 그리고 누가 알겠어요? Qwen이 디지털 지혜로 여러분을 놀라게 하거나 웃음을 자아내는 농담을 던질지도 모르죠.

이 기사는 원래 영어로 작성되었습니다. 원본 기사는 여기에서 확인하실 수 있습니다.

125 posts | 4 followers

FollowRegional Content Hub - September 9, 2024

Regional Content Hub - July 23, 2025

Regional Content Hub - August 12, 2024

Regional Content Hub - April 15, 2024

Regional Content Hub - December 10, 2025

JJ Lim - December 3, 2021

125 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub