在多雲環境中,安全日誌分散在不同雲廠商平台,導致難以進行統一的威脅檢測和應急響應。Security Center的Agentic SOC功能支援集中匯入並分析華為雲的安全產品日誌(如 WAF、Cloud Firewall),協助您實現跨雲環境的統一安全管理。

工作流程

源端日誌匯聚:華為雲產品(如 WAF、CFW)的日誌統一匯聚到華為雲Log Service (LTS)。

資料匯出外發:通過 LTS 將日誌資料匯出至訊息佇列 (DMS Kafka) 或Object Storage Service (OBS),作為跨雲資料轉送的中轉節點。

跨雲資料匯入:Agentic SOC 平台作為消費端,通過標準的 Kafka 或 S3 協議,從 DMS 或 OBS 中訂閱並拉取日誌資料至指定資料來源。

接入與標準化:在 Agentic SOC 平台內建立接入策略,並應用標準化規則,對拉取到的原始日誌進行解析、範式化處理後,最終存入資料倉儲。

適用範圍

本方案僅支援匯入華為雲的以下日誌類型:

Web Application Firewall (WAF) 警示日誌

Cloud Firewall (CFW) 警示日誌

投遞日誌到 LTS

在匯入前,必須先將華為雲上分散的安全產品日誌統一投遞至雲Log Service(LTS)。

Web Application Firewall

詳細指引請參考華為雲官方文檔:通過LTS記錄WAF全量日誌。

登入控制台

登入Web Application Firewall控制台,在左上方選擇地區或專案後,單擊左側防護事件。

配置LTS

在全量日誌頁簽,單擊對接LTS配置。參照如下說明,完成配置。

重要配置完成後,不會立即生效,存在10分鐘左右的時延。

日誌類型:WAF訪問日誌、WAF攻擊日誌。

日誌組:選擇要轉存的日誌組。可單擊建立日誌組,建立一個日誌組。

WAF訪問日誌流:日誌類型選擇WAF訪問日誌,請選擇需要WAF訪問日誌流。也可以單擊建立日誌流,建立一個WAF訪問日誌流。

WAF攻擊日誌流:日誌類型選擇WAF攻擊日誌時,請選擇需要WAF攻擊日誌流。也可以單擊建立日誌流,建立一個WAF攻擊日誌流

Cloud Firewall

詳細指引請參考華為雲官方文檔:、Cloud FirewallCFW接入LTS。

建立日誌組和日誌流

登入雲Log Service控制台,在日誌管理頁面,單擊建立日誌組。

在建立日誌組頁面,配置日誌組名稱、日誌儲存時間(天)。

說明建議在建立日誌組時,名稱以 -cfw 為尾碼(例如 mylog-cfw),以便後續尋找和管理。

建立日誌組成功後,單擊日誌組名稱對應的

下的建立日誌流。

下的建立日誌流。在建立日誌流頁面,配置日誌流名稱、日誌儲存時間(天)。

說明分別為攻擊事件記錄、存取控制日誌、流量日誌加入-attack、-access、-flow為尾碼。

攻擊日誌:記錄攻擊警示資訊,包括攻擊事件類型、防護規則、防護動作、五元組、攻擊payload等資訊。

訪問日誌:記錄命中ACL策略的流量資訊,包括命中時間、五元組、響應動作、存取控制規則等資訊。

流量日誌:記錄所有通過Cloud Firewall的流量資訊,包括開始時間、結束時間、五元組、位元組數、報文數等資訊。

設定LTS同步

登入Cloud Firewall控制台,在左上方選擇地區和防火牆執行個體。在左側導航中選擇。

在日誌管理頁面,單擊LTS同步設定。將日誌組和日誌源設定為上一步建立日誌組和日誌流。

選擇匯入方案

將華為雲 LTS 日誌匯入Security Center,可選擇 Kafka 或Object Storage Service (OBS) 方案。兩種方案在即時性、成本和配置複雜度上各有側重,可根據具體業務情境選擇。

對比項 | Kafka (DMS) 方案 | Object Storage Service (OBS) 方案 |

即時性 | 准即時(可配置即時轉儲) | 分鐘級延遲 |

配置複雜度 | 較高,需配置 Kafka 執行個體、公網 IP、安全性群組等。 | 較低,配置轉儲任務即可。 |

成本構成 |

|

|

適用情境 | 對日誌分析即時性要求高,如需進行流式安全計算或快速警示響應。 | 對即時性要求不高,側重於成本效益、日誌歸檔或批量離線分析。 |

配置資料匯入

通過 Kafka (DMS) 匯入

步驟一:在【華為雲】準備 Kafka 資料通道

配置 Kafka 執行個體

建立Kafka執行個體

說明更多內容,請參見華為雲官方文檔:建立Kafka執行個體。

配置執行個體規格及私人雲端網路:進入購買Kafka執行個體頁面,在快速購買頁簽中,根據實際需求完成基礎配置和網路設定。

配置公網訪問:在訪問方式地區,勾選公網訪問,參考如下說明完成配置:

公網接入方式:密文接入。

公網IP地址:

選擇可訪問的Elastic IP Address地址。如果可用的彈性公網 IP 數量不足,請參考以下步驟購買。更多內容,請參見華為雲官方文檔:申請Elastic IP Address

請單擊建立彈性IP,跳轉至Elastic IP Address購買頁。

重要至少需要購買3個Elastic IP Address。

購買完成後,單擊彈性IP地址後的

,然後在下拉框中選擇新購彈性IP地址。

,然後在下拉框中選擇新購彈性IP地址。

kafka安全性通訊協定:

SASL_SSL:採用SASL方式進行認證,資料通過SSL認證進行加密傳輸。

SASL_PLAINTEXT:採用SASL方式進行認證,資料通過明文傳輸,效能更好。

SASL PLAIN機制:若安全性通訊協定為SASL_PLAINTEXT,建議選擇CRAM-SHA-512機制。

使用者名稱/密碼:用戶端用於串連Kafka執行個體的使用者名稱和密碼,密文接入成功開啟後,使用者名稱不支援修改。

重要請妥善保管使用者名稱、密碼在後續在Security Center授權訪問 Kafka需要使用。

建立Topic

訪問華為雲- Kafka管理頁面,在左上方選擇Kafka執行個體對應的目標地區。

在左側導覽列選擇Kafka執行個體。單擊目標執行個體名稱,進入執行個體詳情。然後單擊Topic管理。

在Topic列表頁,單擊建立Topic,根據業務需求完成相關配置。若無特殊要求,選擇預設配置即可。

說明更多資訊,請參考華為雲官方文檔:Topic參數說明。

配置安全規則

開啟公網訪問後,需要設定對應的安全性群組規則,才能成功串連Kafka。

在kafka執行個體詳情頁,單擊左側概覽,在概覽頁的網路地區安全性群組配置項default後的

表徵圖。

表徵圖。在策略配置頁的入方向規則,單擊添加規則後,請參考如下說明完成配置。

策略:允許

類型:IPv4

協議:自訂TCP

連接埠:9095

源地址:0.0.0.0/0

擷取串連 Kafka 服務所需的參數

在 Kafka 執行個體概覽頁,記錄公網密文串連地址、啟用的安全性通訊協定、SASL PLAIN機制等資訊。

建立從 LTS 到 Kafka 的轉儲任務

詳細指引請參考華為雲官方文檔:日誌轉儲至DMS。

登入雲Log Service控制台,左側導航選擇日誌轉儲後,單擊右上方配置轉儲。

參考如下說明,完成轉儲日誌相關參數的配置。

轉儲方式:周期性轉儲。

轉儲對象:DMS。

日誌組名稱/日誌流名稱:投遞日誌到 LTS中設定的日誌組/日誌流(如waf攻擊日誌)。

Kafka執行個體:選擇配置 Kafka 執行個體中的執行個體。

Topic:選擇建立Topic中的設定topic。

轉儲周期:即時。

轉儲格式:可選擇原始日誌格式和JSON格式。

步驟二:在【阿里雲】配置 Kafka日誌匯入

在Security Center授權訪問 Kafka

訪問Security Center控制台-Agentic SOC-接入中心,在頁面左側頂部,選擇需防護資產所在的地區:中國內地或非中國內地。

在多云配置管理頁簽,選擇多云资产後,單擊新增授权,下拉選擇IDC。在彈出的面板中進行如下配置:

廠商:選擇 Apache。

接入方式:選擇 Kafka。

存取點:填寫在華為雲設定的Kafka公網密文串連地址IPv4。

使用者名稱/密碼:填寫在華為雲設定Kafka的使用者名稱/密碼。

通訊協定:填寫在華為雲設定Kafka的安全性通訊協定。

SASL 認證機制:填寫在華為雲設定Kafka的SASL PLAIN機制。

配置同步策略

AK服務狀態檢查:設定Security Center自動檢查華為雲存取金鑰有效性的時間間隔。可選“關閉”,表示不進行檢測。

建立資料匯入任務

建立資料來源

為華為雲日誌資料建立一個專屬Agentic SOC 資料來源,若已建立請跳過此步驟。

訪問Security Center控制台-Agentic SOC-接入中心,在頁面左側頂部,選擇需防護資產所在的地區:中國內地或非中國內地。

在資料來源頁簽,建立接收日誌的資料來源。具體操作請參見建立資料來源:日誌未接入Log Service(SLS)。

來源資料源類型:可選擇CTDR專屬資料擷取通道(推薦)或使用者側Log Service。

接入執行個體:建議建立日誌庫(Logstore),進行資料隔離。

在數據匯入頁簽,單擊新增數據匯入。在彈出的面板中進行如下配置:

資料來源類型:Kafka。

終端節點:填寫在華為雲設定的Kafka公網密文串連地址IPv4。

Topics:選擇在華為雲建立的Topic。

實值型別:參考設定LTS日誌的轉儲格式,對應關係如下:

轉儲格式

實值型別

JSON格式

json

原始日誌格式

text

配置目標資料來源

資料來源名稱:選擇在本節建立資料來源步驟中建立的資料來源。

目標Logstore:選擇在本節建立資料來源步驟中設定的日誌庫(Logstore)。

單擊確定儲存配置:匯入配置完成後,Security Center將自動從華為雲拉取日誌。

通過Object Storage Service (OBS) 匯入

步驟一:在【華為雲】準備 OBS 資料並擷取存取金鑰

配置 LTS 轉儲至 OBS

建立轉儲任務。

說明詳細指引請參考華為雲官方文檔:日誌轉儲至OBS。

登入雲Log Service控制台,左側導航選擇日誌轉儲後,單擊右上方配置轉儲。

參考如下說明,完成轉儲日誌相關參數的配置。

轉儲方式:周期性轉儲。

轉儲對象:OBS桶。

日誌組名稱/日誌流名稱:投遞日誌到 LTS中設定的日誌組/日誌流(如WAF訪問日誌流)。

OBS桶:選擇已建立的OBS桶或在華為雲-桶列表建立一個桶。

說明LTS支援OBS桶的儲存類別為標準儲存、已恢複的Archive Storage的OBS桶。

自訂轉儲路徑:

開啟:可設定自訂路徑。格式為:/LogTanks/RegionName/%GroupName/%StreamName/自訂轉儲路徑。自訂轉儲路徑預設為lts/%Y/%m/%d。

不開啟:將日誌轉儲至系統預設路徑(LogTanks/RegionName/2019/01/01/日誌組/日誌流/記錄檔名稱)中。

壓縮格式:選擇不壓縮、壓縮gzip、壓縮zip。

警告Security Center目前不支援 snappy 壓縮格式的記錄檔解析。

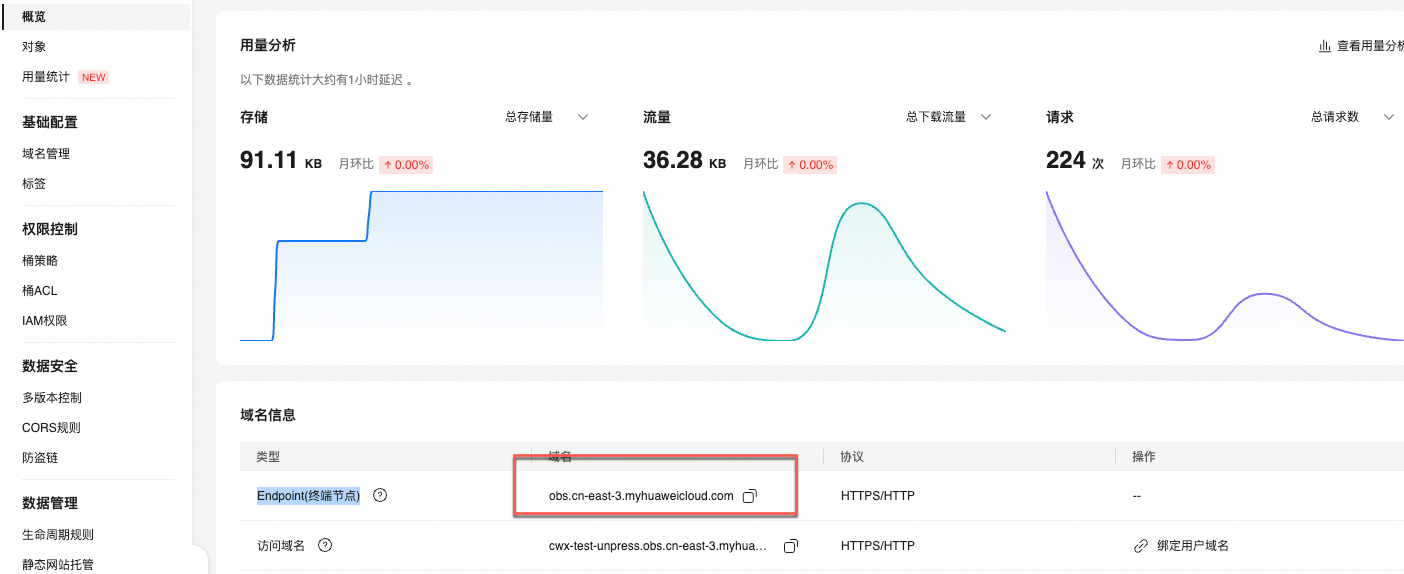

擷取OBS儲存桶的Endpoint

設定存取金鑰

步驟二:在【阿里雲】配置 OBS 日誌匯入

授權Security Center訪問華為雲 OBS

訪問Security Center控制台-Agentic SOC-接入中心,在頁面左側頂部,選擇需防護資產所在的地區:中國內地或非中國內地。

在多云配置管理頁簽,選擇多云资产後,單擊新增授权,下拉選擇IDC。在彈出的面板中進行如下配置:

廠商:選擇 AWS-S3。

接入方式:選擇S3 。

存取點:OBS 儲存桶的 Endpoint。

Access Key Id/Secret Access Key:填入在華為雲設定的存取金鑰。

配置同步策略

AK服務狀態檢查:設定Security Center自動檢查華為雲存取金鑰有效性的時間間隔。可選“關閉”,表示不進行檢測。

建立資料匯入任務

訪問Security Center控制台-Agentic SOC-接入中心,在頁面左側頂部,選擇需防護資產所在的地區:中國內地或非中國內地。

在數據匯入頁簽,單擊新增數據匯入。在彈出的面板中進行如下配置:

資料來源類型:S3。

終端節點:OBS 儲存桶的 Endpoint。

OBS桶(Bucket):LTS日誌轉存OBS。

檔案路徑首碼過濾:通過檔案路徑首碼過濾S3檔案,用於準確定位待匯入的檔案。例如待匯入的檔案都在csv/目錄下,則可以指定首碼為csv/。檔案具體路徑,請參見自訂轉儲路徑。

說明強烈建議設定此參數。如果不設定,系統將遍曆整個 S3 Bucket。當 Bucket 內檔案數量巨大時,全量遍曆會嚴重影響匯入效率。

檔案路徑正則過濾:通過Regex篩選檔案,用於準確定位待匯入的檔案。預設為空白,表示不過濾。例如S3檔案為

testdata/csv/bill.csv,可以設定Regex為(testdata/csv/)(.*)。說明推薦與檔案路徑首碼過濾一起設定,提高效率。此配置與檔案路徑首碼過濾之前為“且(and)”的關係。

調整Regex的方法,請參見如何調試Regex。

資料格式:檔案的解析格式,如下所示。

CSV:分隔字元分割的文字檔,支援指定檔案中的首行為欄位名稱或手動指定欄位名稱。除欄位名稱外的每一行都會被解析為日誌欄位的值。

JSON:逐行讀取S3檔案,將每一行看作一個JSON對象進行解析。解析後,JSON對象中的各個欄位對應為日誌中的各個欄位。

單行文本:將S3檔案中的每一行解析為一條日誌。

跨行文本:多行模式,支援指定首行或者尾行的Regex解析日誌。

若選擇為CSV或跨行文本時,需額外設定相關參數,具體說明如下所示。

CSV

參數

說明

分隔字元

設定日誌的分隔字元,預設值為半形逗號(,)。

引號

CSV字串所使用的引號字元。

轉義符

配置日誌的轉義符,預設值為反斜線(\)。

日誌最大跨行數

當一條日誌跨多行時,需要指定最大行數,預設值為1。

首行作為欄位名稱

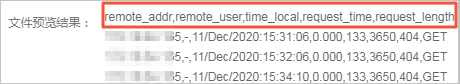

開啟開關後,將使用CSV檔案中的首行作為欄位名稱。例如提取下圖中的首行為日誌欄位的名稱。

跳過行數

指定跳過的日誌行數。例如設定為1,則表示從CSV檔案中的第2行開始採集日誌。

跨行文本

參數

說明

正則匹配位置

設定Regex匹配的位置,具體說明如下:

首行正則:使用Regex匹配一條日誌的行首,未匹配部分為該條日誌的一部分,直到達到最大行數。

尾行正則:使用Regex匹配一條日誌的行尾,未匹配部分為下一條日誌的一部分,直到達到最大行數。

Regex

根據日誌內容,設定正確的Regex。調整Regex的方法,請參見如何調試Regex。

最大行數

一條日誌最大的行數。

編碼格式:待匯入的S3檔案的編碼格式。支援GBK、UTF-8。

壓縮格式:根據OBS轉存設定的壓縮格式,由系統自動檢測。

檔案修改時間過濾:從任務啟動時刻回溯30分鐘作為起始時間,匯入此後修改的所有檔案(含未來新增檔案)。

檢查新檔案周期:用於設定匯入任務定期掃描新檔案的時間間隔,任務將按此時間間隔自動掃描並匯入新增的檔案。

配置目標資料來源

資料來源名稱:選擇狀態正常的自訂資料來源(自訂Log Service/CTDR專屬資料擷取通道)。若無合適的資料來源,請參考資料來源,建立新的資料來源。

目標Logstore:根據選擇的資料來源,自動拉取該資料來源下的日誌庫。

單擊確定儲存配置:匯入配置完成後,Security Center將自動從華為雲拉取日誌。

分析匯入資料

資料成功接入後,需配置相應的解析和檢測規則,才能讓Security Center對這些日誌進行分析。

建立新的接入策略

參考產品接入,建立新的接入策略,配置如下:

資料來源:選擇資料匯入任務中配置的目標資料來源。

標準化規則:Agentic SOC提供了適配部分雲產品的內建標準化規則,可直接選用。

標準化方式:當接入日誌標準化為警示日誌時,僅支援“即時消費”方式標準化。

配置威脅檢測規則

根據安全需求,在規則管理中啟用或建立日誌檢測規則,才能對日誌進行分析、產出警示並產生安全事件。具體操作,請參見規則管理。

費用與成本

本方案會涉及以下服務的費用,實施前請仔細閱讀各產品的計費文檔,做好成本預估。

華為雲側:在華為雲側,主要為資料中轉和儲存費用。

服務名稱

涉及費用項

計費參考文檔

Log Service(LTS)

日誌的儲存、讀寫費用等。

訊息佇列(DMS Kafka)

執行個體規格、公網流量等。

Object Storage Service(OBS)

儲存容量、請求次數、公網流量等。

阿里雲側:費用組成取決於選擇的資料存放區方式。

說明Agentic SOC計費說明,請參見Agentic SOC訂用帳戶、Agentic SOC隨用隨付。

Log Service(SLS)計費說明,請參見計費概述。

資料來源類型

Agentic SOC 計費項目

SLS 計費項目

特別說明

CTDR專屬資料擷取通道

日誌接入費用。

日誌儲存、寫入費用。

說明以上均消耗日志接入流量。

除日誌儲存和寫入外的其他費用(如公網流量等)。

由Agentic SOC 建立並管理 SLS 資源,因此日誌庫儲存和寫入費用由Agentic SOC出賬。

使用者側Log Service

日誌接入費用,消耗日志接入流量。

日誌相關所有費用(包含日誌儲存和寫入、公網流量費用等)。

日誌資源全部由Log Service(SLS)管理,因此日誌相關費用,均由SLS出賬。

常見問題

資料匯入任務建立後,在 SLS 中看不到日誌資料怎麼辦?

檢查第三方雲側:登入華為雲控制台,確認日誌是否已成功產生並投遞/轉儲到您配置的 LTS、Kafka Topic 或Object Storage Service桶中。

檢查授權憑證:在Security Center的多雲資產頁面,檢查授權狀態是否正常。確認 Access Key 是否有效,密碼是否正確。

檢查網路連通性:如果是 Kafka 方案,請確認第三方雲的 Kafka 服務公網訪問已開啟,且安全性群組/防火牆規則已正確允許存取Security Center的服務 IP。

檢查資料匯入任務:在Security Center的資料匯入頁面,查看任務狀態和錯誤記錄檔,根據提示進行修正。

為什麼在阿里雲側新增授權時,要選擇

Apache或AWS-S3而不是華為雲?這是因為日誌匯入功能利用的是標準的相容協議,而非廠商特定的 API。

IDC 代表協議廠商,

Apache代表 Kafka,AWS-S3代表Object Storage Service。華為雲授權,僅用於Agentic SOC的威脅檢測規則與華為雲進行安全事件聯動(如封鎖 IP),不能實現日誌匯入。