如果您想通過可視化的介面,更直觀地查看和分析模型訓練過程及結果,可以在訓練代碼中使用Tensorboard儲存訓練過程中的日誌,然後使用分布式訓練(DLC)的Tensorboard功能進行可視化的查看。本文為您介紹如何建立和管理Tensorboard執行個體。

前提條件

DLC任務必須配置資料集才可以使用Tensorboard查看分析報告。您可以在DLC工作清單頁單擊任務名稱,進入概览頁面查看任務是否配置了資料集。

在訓練代碼中使用Tensorboard儲存了Summary日誌。您可以參考下文案例中的範例程式碼,儲存Summary記錄檔。

使用Tensorboard的DLC任務案例

本文提供如下DLC任務案例,資料集和Tensorboard具體配置如下:

配置OSS類型資料集:

OSS地址:

oss://w*********.oss-cn-hangzhou-internal.aliyuncs.com/dlc_dataset_1/掛載地址:

/mnt/data/

通過Tensorboard的SummaryWriter設定Summary記錄檔儲存地址:

SummaryWriter('/mnt/data/output/runs/mnist_experiment')。完整訓練程式碼範例如下:

建立Tensorboard執行個體

登入PAI控制台,在頁面上方選擇目標地區,並在右側選擇目標工作空間,然後單擊進入任務。

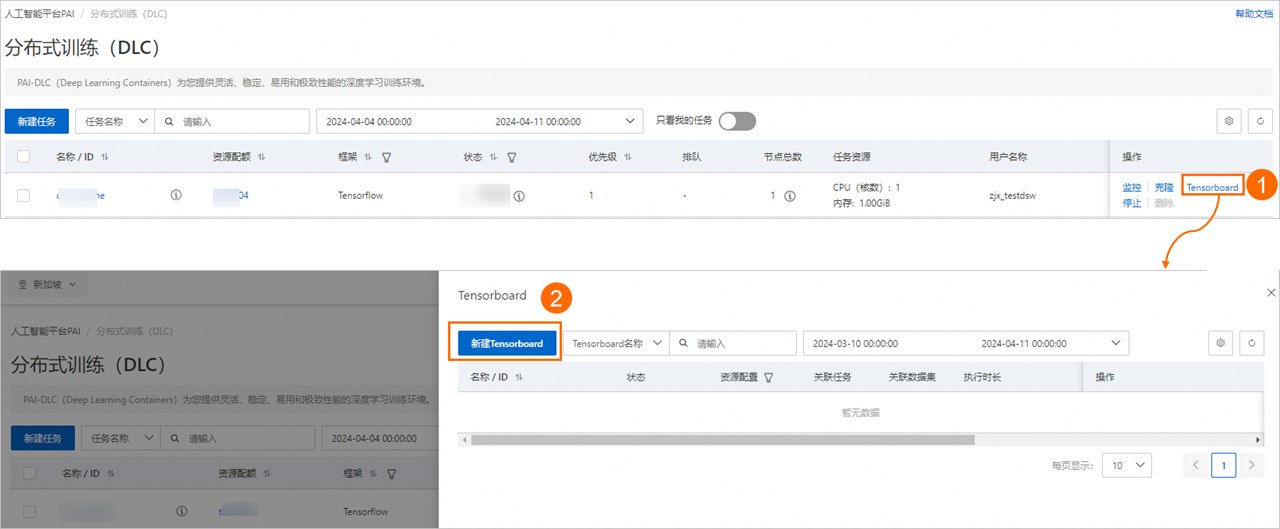

在目標任務操作列下,單擊Tensorboard,在彈出的Tensorboard面板中,單擊新建Tensorboard。

在新建Tensorboard頁面中,配置以下參數,然後單擊确定。

基本資料

參數

描述

名称

自訂Tensorboard執行個體名稱。

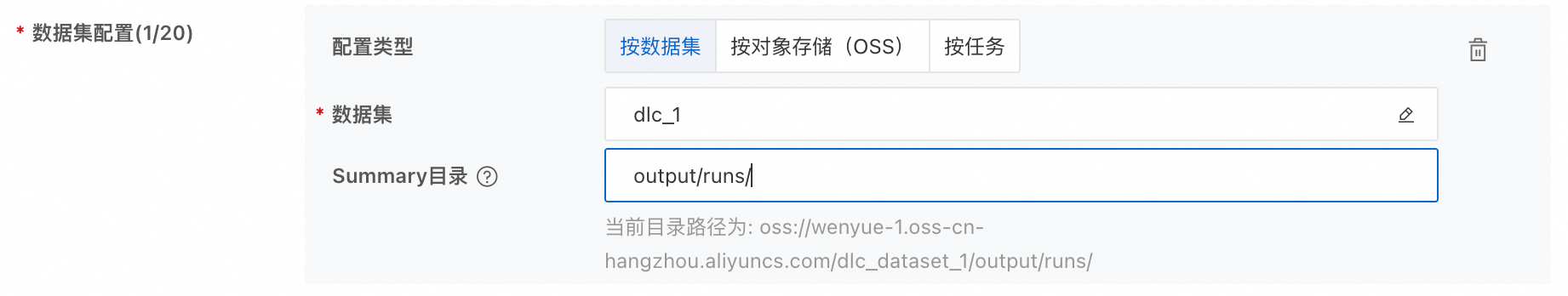

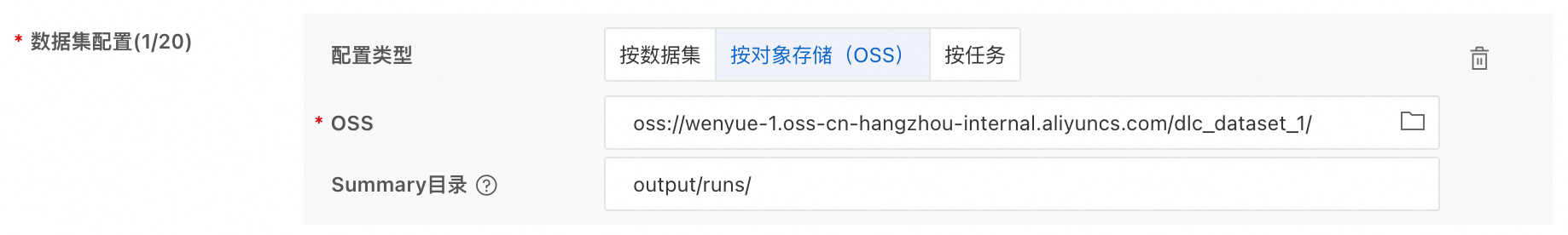

数据集配置

配置类型:支援的類型包括:按数据集 (推薦)、按对象存储(OSS)、按任务。

Summary目录:即訓練代碼中您指定的Tensorboard Summary記錄檔儲存位置,您可以尋找代碼中的SummaryWriter擷取Summary的完整路徑。

上文任務案例的三種填寫樣本如下:

按資料集:選擇任務配置的資料集,Summary目錄只需填寫記錄檔在資料集中的相對路徑

按Object Storage Service:填寫相應OSS路徑,Summary目錄只需填寫記錄檔在OSS中的相對路徑

按任務:選擇目標DLC任務,Summary目錄需填寫記錄檔在容器中的完整路徑

資源配置

支援配置以下幾種資源類型:

資源類型

描述

免费资源

系統為您提供一定額度的免費資源,每個執行個體支援使用的資源上限為2vCPU,4 GiB記憶體。當免費額度不能滿足您的需求時,您可以關閉運行中的其他免費執行個體,釋放額度,以繼續建立新的Tensorboard執行個體。

灵骏智算

通用计算

專用網路配置

當使用公共资源建立Tensorboard執行個體時,支援配置該參數。

不配置專用網路,將使用公網串連。由於公網串連的頻寬有限,在Tensorboard執行個體啟動過程或查看報告時,可能會出現卡頓或無法正常進行的情況。

配置專用網路,以確保充足的網路頻寬和更穩定的效能。

選擇當前地區可用的專用網路,並選擇對應的交換器與安全性群組。配置完成後,Tensorboard執行個體啟動並執行叢集將能夠直接存取此專用網路內的服務,並使用此處選擇的安全性群組進行安全訪問限制。

重要如果Tensorboard執行個體使用了需要配置專用網路的資料集(例如CPFS類型的資料集,或掛載點在專用網路內的NAS類型資料集等),則必須設定專用網路。

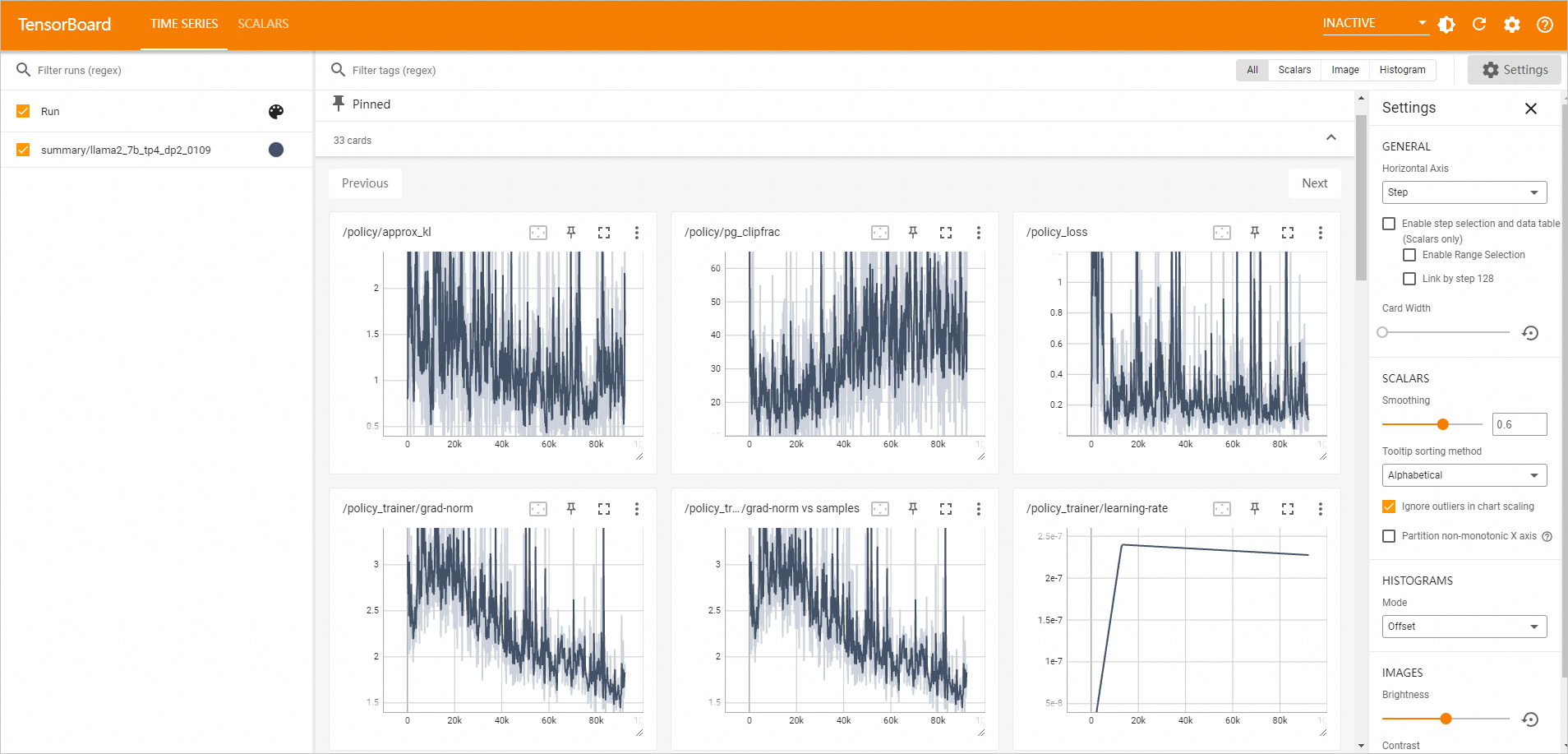

前往Tensorboard頁面查看分析報告。

在工作空間頁面的左側導覽列選擇。

切換到Tensorboard頁簽,當目標Tensorboard執行個體的状态為运行中時,單擊操作列下的查看Tensorboard。頁面自動跳轉到TensorBoard頁面。

管理Tensorboard執行個體

您可以按照以下操作步驟,對已建立的Tensorboard執行個體進行管理操作。

登入PAI控制台,在頁面上方選擇目標地區,並在右側選擇目標工作空間,然後單擊進入任務。

在Tensorboard頁簽,管理Tensorboard執行個體。

啟動Tensorboard執行個體

單擊启动,可啟動已停止的Tensorboard執行個體。

查看Tensorboard執行個體詳情

單擊目標執行個體名稱,查看基本資料和配置資訊。

查看關聯任務

在关联任务列下,將滑鼠懸浮在表徵圖

上,查看已關聯的DLC任務ID,並支援單擊跳轉到相關任務詳情頁面。

上,查看已關聯的DLC任務ID,並支援單擊跳轉到相關任務詳情頁面。查看關聯資料集

在关联数据集列下,將滑鼠懸浮在表徵圖

上,查看已關聯的資料集ID,並支援單擊跳轉到相關資料集詳情頁面。

上,查看已關聯的資料集ID,並支援單擊跳轉到相關資料集詳情頁面。查看執行時間長度

在执行时长列下,查看目標執行個體的運行時間長度。停止執行個體後,該時間將重設。

停止Tensorboard執行個體:

單擊目標執行個體操作列下的停止,直接停止執行個體。

單擊目標執行個體操作列下的自动停止设置,設定自動停止時間。

相關文檔

您也可以在頁面,為分布式訓練(DLC)任務建立Tensorboard執行個體。具體操作,請參見建立及管理Tensorboard執行個體。