即時整合支援多種來源端資料來源匯聚組合至目標端資料來源,形成即時同步鏈路進行資料同步。本文為您介紹如何建立即時整合任務。

前提條件

已完成資料來源配置。您需要在配置即時整合任務前,配置好您需要整合的資料來源,以便在配置即時整合任務過程中,選擇對應的來來源資料和目標資料。具體操作,請參見即時整合支援的資料來源。

背景資訊

目標資料來源類型選擇Oracle或MySQL時,將採用JDBC協議,不同的訊息將採用以下處理策略。

結果表不存在主鍵時。

接收到INSERT訊息時,將直接進行Append寫入。

接收到UPDATE_BEFORE訊息時,將會被直接丟棄,不做處理;接收UPDATE_AFTER訊息時,將直接進行Append寫入。

接收到DELETE訊息時,將會被直接丟棄,不做處理。

結果表存在主鍵時。

接收到INSERT訊息時,將作為UPSERT訊息進行處理。

接收到UPDATE_BEFORE訊息時,將會被直接丟棄,不做處理;接收UPDATE_AFTER訊息時,將作為UPSERT訊息進行處理。

接收到DELETE訊息時,將作為DELETE訊息進行處理。

因JDBC協議為立即寫,當任務Failover的情況下且結果表沒有主鍵時,可能存在重複資料,不支援Exactly-Once保證。

因JDBC協議僅支援建表DDL和加欄位DDL,其他類型的DDL訊息將會被直接丟棄。

Oracle目前僅支援基礎資料型別 (Elementary Data Type),不支援INTERVAL YEAR、INTERVAL DAY、BFILE、SYS.ANY、XML、地圖類型、ROWID、UROWID資料類型。

MySQL目前僅支援基礎資料型別 (Elementary Data Type),不支援地圖類型。

為避免亂序導致的資料不一致情況,僅支援單並發。

Oracle資料來源支援Oracle Database 11g、Oracle Database 19c、Oracle Database 21c版本。

MySQL資料來源支援MySQL8.0、MySQL8.4和MySQL5.7版本。

步驟一:建立即時整合任務

在Dataphin首頁的頂部功能表列中,選擇研發 > Data Integration。

在頂部功能表列中選擇專案(Dev-Prod模式需要選擇環境)。

在左側導覽列中,選擇整合 > 即時整合。

單擊即時整合列表中的

表徵圖,選擇即時整合任務,開啟建立即時整合任務對話方塊。

表徵圖,選擇即時整合任務,開啟建立即時整合任務對話方塊。在建立即時整合任務對話方塊中,配置以下參數。

參數

描述

任務名稱

填寫即時任務名稱。

以字母開頭,僅包含小寫英文字母、數字、底線(_),長度限制為4~63個字元。

生產/開發環境隊列資源

可選擇所有配置為即時任務的資源群組。

說明僅當專案所使用的計算源是部署模式為Kubernetes的Flink計算源時,支援此配置項。

描述

填寫任務的簡單描述資訊,長度不超過1000個字元。

選擇目錄

選擇即時任務所存放的目錄。

若未建立目錄,您可以建立檔案夾,操作方法如下:

在頁面左側即時工作清單上方單擊

表徵圖,開啟建立檔案夾對話方塊。

表徵圖,開啟建立檔案夾對話方塊。在建立檔案夾對話方塊中輸入檔案夾名稱並根據需要選擇目錄位置。

單擊確定。

配置完成後,單擊確定。

步驟二:配置即時整合任務

不同Realtime Compute引擎支援的來源和目標資料來源不同,詳情請參見即時整合支援的資料來源。

來來源資料源

當來來源資料源為外部資料源,且圈選方式為整庫或圈選表、圈選表選擇為批量選擇時,選擇表時將從中繼資料中心擷取表名中繼資料。若資料來源未配置中繼資料採集任務,可前往中繼資料 > 採集任務中建立採集任務。

MySQL

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇MySQL。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立MySQL資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

同步規則配置 | 同步方案 | 可選擇即時增量或即時增量+全量,預設為即時增量。

說明 當目標資料來源選擇Hive(Hudi表格式)、MaxCompute或Databricks時,同步方案支援選擇即時增量+全量。 |

圈選方式 | 支援整庫、圈選表、排除表三種方式。

| |

Microsoft SQL Server

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Microsoft SQL Server。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Microsoft SQL Server資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

同步規則配置 | 同步方案 | 僅支援即時增量。將來源資料庫的增量變更按照變更發生的順序採集並即時寫入下遊目標庫中。 |

圈選方式 | 支援整庫、圈選表、排除表三種方式。

| |

PostgreSQL

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇PostgreSQL。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立PostgreSQL資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

同步規則配置 | 同步方案 | 僅支援即時增量。將來源資料庫的增量變更按照變更發生的順序採集並即時寫入下遊目標庫中。 |

圈選方式 | 支援整庫和圈選表兩種方式。

| |

Oracle

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Oracle。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Oracle資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

同步規則配置 | 同步方案 | 僅支援即時增量。將來源資料庫的增量變更按照變更發生的順序採集並即時寫入下遊目標庫中。 |

圈選方式 | 支援整庫、圈選表、排除表三種方式。

| |

IBM DB2

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇IBM DB2。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立IBM DB2資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

同步規則配置 | 同步方案 | 僅支援即時增量。將來源資料庫的增量變更按照變更發生的順序採集並即時寫入下遊目標庫中。 |

圈選方式 | 支援整庫、圈選表、排除表三種方式。

| |

Kafka

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Kafka。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Kafka資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

來源topic | 選擇來來源資料的Topic,可輸入Topic名稱關鍵字進行模糊搜尋。 | |

資料格式 | 當前僅支援Canal JSON格式。Canal JSON是Canal的相容格式,其資料存放區格式為Canal JSON。 | |

鍵類型 | Kafka的Key類型,決定了初始化KafkaConsumer時的key.deserializer配置,當前僅支援STRING。 | |

實值型別 | Kafka的Value類型,決定了初始化KafkaConsumer時的value.deserializer配置,當前僅支援STRING。 | |

消費群組ID(非必填) | 輸入消費群組的ID。消費群組ID用於上報狀態位點。 | |

同步規則配置 | 表列表 | 輸入需要同步的表名,多個表名間使用換行分隔,不超過1024個字元。 表名支援以下三種格式: |

Hive(Hudi表格式)

僅當即時引擎使用Apache Flink,且計算源為Flink on yarn部署模式時,來源端資料來源支援選擇Hive(Hudi資料來源)。

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Hive。 |

資料來源 | 僅可選擇Hudi表格式的Hive資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Hive資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

同步規則配置 | 同步方案 | 僅支援即時增量。將來源資料庫的增量變更按照變更發生的順序採集並即時寫入下遊目標庫中。 |

選擇表 | 選擇需進行即時同步的單個表。 | |

PolarDB(MySQL資料庫類型)

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇PolarDB。 |

資料來源 | 僅可選擇MySQL資料庫類型的PolarDB資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立PolarDB資料來源。 重要 需在資料來源端開啟日誌,並需確保配置的賬戶有讀取日誌許可權,否則系統無法即時同步該資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

同步規則配置 | 同步方案 | 可選擇即時增量或即時增量+全量,預設為即時增量。

說明 當目標資料來源選擇Hive(Hudi表格式)、MaxCompute或Databricks時,同步方案支援選擇即時增量+全量。 |

圈選方式 | 支援整庫、圈選表、排除表三種方式。

| |

目標資料來源

MaxCompute

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇MaxCompute。 |

資料來源 | 選擇目標資料來源。支援選擇MaxCompute資料來源與專案。您也可以單擊建立,在資料來源頁面建立資料來源。具體操作,請參見建立MaxCompute資料來源。 | |

目標表建立配置 | 建立表類型 | 可選擇普通表或Delta表,預設為普通表。 若選擇Delta表,且目標表建立方式為自動建表,則會建立MaxCompute Delta表;建Delta表時,不使用附加欄位。 說明 完成目標表配置後,再修改建立表類型,此時系統會發起二次確認,您若在彈出的對話方塊中單擊確定,目標表配置將被清空,後續需重新填寫。 |

表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

| |

分區格式 | 建立表類型選擇為普通表時,分區格式僅支援多分區;建立表類型選擇為Delta表時,分區格式支援選擇無分區或多分區。 | |

分區間隔 | 當分區格式選擇為無分區時,不支援配置分區間隔;當分區格式選擇為多分區時,分區間隔支援選擇小時(hour)或天(day)。 說明

| |

MySQL

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇MySQL。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立MySQL資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

Microsoft SQL Server

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Microsoft SQL Server。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Microsoft SQL Server資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

Oracle

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Oracle。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Oracle資料來源。 | |

時區 | 展示所選資料來源配置的時區資訊。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

Kafka

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Kafka。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Kafka資料來源。 | |

目標Topic | 目標資料的Topic,可選擇單Topic或多Topic。選擇單Topic後,需選擇目標Topic,可輸入Topic名稱關鍵字進行搜尋;選擇多Topic後,支援配置Topic名轉換和Topic參數。

| |

資料格式 | 支援設定寫入資料的儲存格式,包括DTS Avro和Canal Json。

說明 當目標Topic選擇多Topic時,資料格式僅支援選擇Canal Json。 | |

目標topic配置 | Topic名轉換 | 單擊配置Topic名轉換,可在配置Topic名轉換規則對話方塊中,配置Topic名轉換規則以及Topic名稱的前尾碼。

說明

|

Topic參數 | 用於建立Topic時的附加參數,格式為 說明 僅當目標Topic選擇多Topic時,支援配置此項。 | |

DataHub

參數 | 描述 | |

目標資料 | 資料來源類型 | 選擇DataHub。 |

資料來源 | 選擇目標資料來源。 系統提供建立資料來源快捷操作入口,您可以單擊建立,在資料來源頁面建立DataHub資料來源。具體操作,請參見建立DataHub資料來源。 | |

目標Topic建立方式 | 支援建立Topic和使用已有Topic建立方式。

| |

目標Topic |

| |

Databricks

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Databricks。 |

資料來源 | 選擇目標資料來源。支援選擇Databricks資料來源與專案。您也可以單擊建立,在資料來源頁面建立資料來源。具體操作,請參見建立Databricks資料來源。 | |

時區 | 將根據當前時區對時間格式資料進行處理,預設為所選資料來源中配置的時區,不支援修改。 說明 僅當來來源資料源類型為MySQL或PostgreSQL,並且目標資料來源類型為Databricks時,支援時區轉換。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

分區格式 | 支援選擇無分區或多分區。 | |

分區間隔 | 當分區格式選擇為無分區時,不支援配置分區間隔;當分區格式選擇為多分區時,分區間隔支援選擇小時(hour)或天(day)。 說明

| |

SelectDB

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇SelectDB。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立SelectDB資料來源。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

Hive

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇資料來源類型為Hive。 |

資料來源 | 選擇資料來源。您也可以單擊建立,在資料來源頁面建立資料來源,詳情請參見建立Hive資料來源。 | |

目標表建立配置 | 資料湖表格式 | 可選擇為不選擇、Hudi、Iceberg或Paimon。

說明 僅當選擇的Hive資料來源開啟了資料湖表格式配置時,支援配置此項。 |

Hudi表類型/Paimon表類型 | Hudi表類型可選擇MOR(merge on read)或COW(copy on write)。 Paimon表類型可選擇MOR(merge on read)、COW(copy on write)或MOW(merge on write)。 說明 僅當資料湖表格式選擇為Hudi或Paimon時,支援配置此項。 | |

建表執行引擎 | 可選擇為Hive或Spark,選擇資料湖表格式後,預設選擇Spark。

| |

表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

| |

分區格式 | 可選擇單分區、多分區或固定分區。 說明 當格式選擇為單分區或固定分區時,分區欄位預設名稱為 | |

分區間隔 | 預設選擇小時(hour),可選擇天(day)。單擊分區間隔後的

說明 僅當分區格式選擇為單分區或多分區時,支援此配置項。 | |

分區值 | 填寫固定分區值,例如:20250101。 說明 僅當分區格式選擇為固定分區時,支援此配置項。 | |

Hologres

參數 | 描述 | |

資料來源配置 | 資料來源類型 | 選擇Hologres。 |

資料來源 | 選擇目標資料來源。支援選擇Hologres資料來源與專案。您也可以單擊建立,在資料來源頁面建立資料來源。具體操作,請參見建立Hologres資料來源。 | |

Schema | 選擇目標Schema。 | |

目標表建立配置 | 表名轉換 | 目標表名僅支援英文字母、數字及底線(_),若來源表名含有其他字元,需配置表名轉換規則。 單擊配置表名轉換,開啟配置表名轉換規則對話方塊。

說明

|

映射配置

目標資料來源類型選擇DataHub、Kafka(目標Topic為單Topic)時,不支援映射配置。

目標資料來源為外部資料源時,映射配置中的目標表名將從中繼資料中心擷取。此時,目標表建立方式不支援自動建表,需前往資料庫中手動建立目標表。

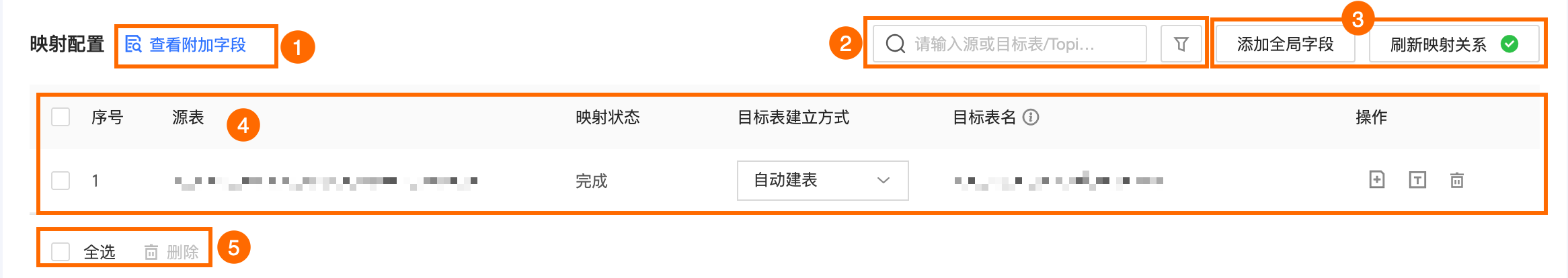

目標資料來源非Kafka

區塊 | 說明 |

①查看附加欄位 | 即時增量同步處理時,自動建表預設會添加附加欄位以便資料使用。單擊查看附加欄位查看欄位。在附加欄位對話方塊中,可查看當前所附加的欄位資訊。 重要

單擊查看添加欄位的DDL可查看添加附加欄位的DDL語句。 說明

|

②搜尋與篩選區域 | 支援按源表和目標表名進行搜尋。如需快速篩選目標表,單擊頂部的 |

③添加全域欄位、重新整理映射關係 |

|

④目標庫列表 | 目標庫列表包括序號、源表、映射狀態、目標表建立方式、目標表名,同時您可以對目標表進行添加欄位、查看欄位、重新整理、刪除的操作。

|

⑤大量操作 | 您可對目標表進行批量刪除操作。 |

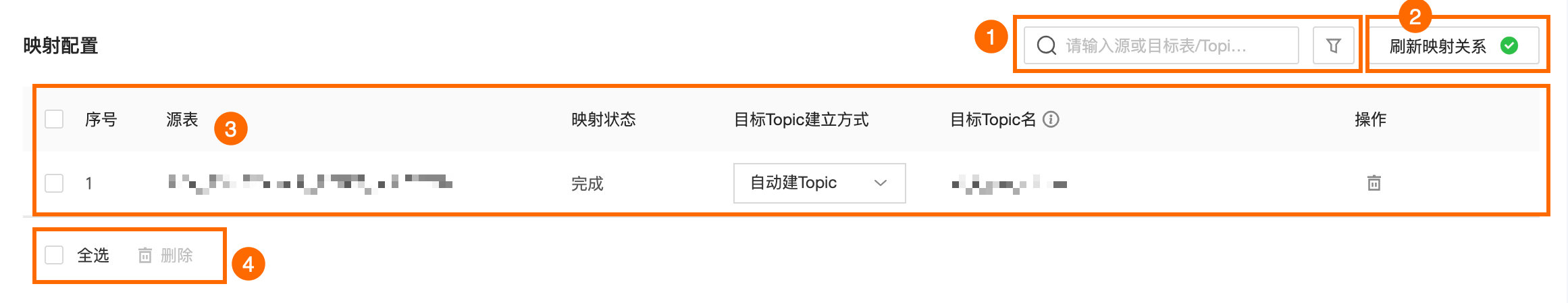

目標資料來源為Kafka(目標Topic為多Topic)

區塊 | 說明 |

①搜尋與篩選區域 | 支援按源表和目標Topic名進行搜尋。如需快速篩選目標表,單擊頂部的 |

②重新整理映射關係 | 如需重新整理目標表配置列表,請單擊重新整理映射關係。 重要 目標Topic配置中已有內容時,重新選擇資料來源類型及資料來源會導致目標Topic列表及映射關係情況重設,請謹慎操作。 |

③列表 | 列表包括序號、源表、映射狀態、目標Topic建立方式、目標Topic名,同時您可以對目標表進行刪除操作。

|

④大量操作 | 您可對目標表進行批量刪除操作。 |

DDL處理策略

來來源資料源類型選擇DataHub、Kafka時,不支援DDL處理策略。

目標資料來源類型選擇PostgreSQL、Hive(Hudi表類型)時,不支援DDL處理策略。

當目標資料來源類型選擇Hive(Hudi表類型),且資料湖表格式選擇為Hudi時,DDL處理策略均只支援忽略。

當來來源資料源類型選擇為Kafka時,DDL處理策略均只支援忽略。

對Hive、MaxCompute表已存在的分區添加的新增列無法被同步資料,即已存在分區中新增列的資料均為NULL,下一個建立分區正常生效可用。

建立表、新增列等:即正常處理(包含建立表、新增列、刪除列、重新命名列和修改列類型),此DDL資訊將繼續下發給目標資料來源,由目標資料來源處理,不同目標資料來源處理策略會不同。

忽略:丟棄掉此DDL資訊,不再向目標資料來源發送此資訊。

出錯:直接讓即時同步任務以出錯狀態終止運行。

步驟三:配置即時整合任務屬性

單擊當前即時整合任務頁簽頂部功能表列中的資源配置,或單擊右側邊欄的屬性,開啟屬性面板。

分別配置當前即時整合任務的基本資料和資源配置。

基本資料:選擇當前即時整合任務的開發負責人和營運負責人,並填入當前任務的相應描述,不超過1000個字元。

資源配置:詳情請參見即時整合資源配置。

步驟四:提交即時整合任務

單擊提交,提交當前即時整合任務。

在提交對話方塊,輸入提交備忘資訊並單擊確定並提交。

完成提交後,在提交對話方塊中,可查看提交詳情。

如果專案的模式為Dev-Prod,則您需要發布即時整合任務至生產環境。具體操作,請參見管理髮布任務。

後續步驟

可在營運中心查看並營運即時整合任務,保證任務的正常運行。具體操作,請參見查看並管理即時任務。