モデルについて

Alibaba Cloud は、2024 年 3 月 6 日に QwQ-32B 推論モデルをオープンソース化しました。大規模な強化学習を活用した QwQ-32B は、数学・プログラミング・汎用タスクの各分野で画期的な性能向上を実現しています。その総合的な性能は DeepSeek-R1 と同等でありながら、デプロイおよび運用コストを大幅に削減します。

-

数学能力を評価するベンチマーク「AIME24」およびプログラミング能力を評価するベンチマーク「LiveCodeBench」において、QwQ-32B は DeepSeek-R1 と同等の性能を発揮し、同サイズの o1-mini や R1 ディスティルドモデルを大きく上回ります。

-

Yann LeCun(Meta 社 Chief AI Scientist)が主導する「LiveBench」(LLM 最難関リーダーボード)、Google が提案した命令遂行能力評価ベンチマーク「IFEval」、UC Berkeley などにより開発された正確な関数/ツール呼び出し評価ベンチマーク「BFCL」において、QwQ-32B は DeepSeek-R1 を上回るスコアを記録しています。

-

QwQ-32B は、エージェント機能を革新的に統合しています。ツールを活用しながら批判的思考を行い、環境からのフィードバックに基づいて推論プロセスを動的に調整できます。

PAI Model Gallery では、QwQ-32B モデルのワンクリックによるデプロイ、ファインチューニング、および評価が完全にサポートされています。デプロイには VRAM 96 GB の GPU が必要です。また、量子化済みバージョンである QwQ-32B-GGUF および QwQ-32B-AWQ もサポートされており、単一の A10 GPU などの低コスト GPU でもデプロイ可能です。

モデルのデプロイ

-

Model Gallery ページへ移動します。

-

PAI コンソール にログインします。左上隅からご利用のニーズに合ったリージョンを選択します。利用可能な計算リソースにアクセスするために、必要に応じてリージョンを切り替えてください。

-

左側のナビゲーションウィンドウで、ワークスペース一覧 をクリックします。その後、ご利用のワークスペース名をクリックして開きます。

-

左側のナビゲーションウィンドウで、はじめに > Model Gallery をクリックします。

-

-

Model Gallery ページで QwQ-32B のモデルカードを見つけ、クリックしてモデル詳細ページを開きます。

-

右上角の **[デプロイ]** をクリックします。デプロイフレームワークを選択し、推論サービスの名前を入力し、必要なリソースを構成します。その後、**[デプロイ]** をクリックして、Alibaba Cloud の AI 推論プラットフォームである PAI-EAS 上でサービスを起動します。対応しているフレームワークには、SGLang、vLLM、および Alibaba Cloud PAI が開発したパフォーマンス専有型推論フレームワーク「BladeLLM」が含まれます。

-

推論サービスの利用:デプロイが完了すると、サービスページへ移動し、**[エンドポイント情報の表示]** をクリックしてエンドポイント URL およびトークンを取得します。サービスの呼び出し方法については、事前学習済みモデルのリンクをクリックしてモデル紹介ページに戻り、呼び出し手順をご参照ください。

また、デプロイ済みの QwQ-32B モデルを PAI-EAS 推論プラットフォーム上でオンラインでデバッグすることもできます。

モデルのファインチューニング

PAI Model Gallery では、QwQ-32B に対する教師ありファインチューニング(SFT)が提供されています。LoRA ファインチューニングおよび全パラメーターによるファインチューニングの両方が、設定不要で利用可能です。

-

学習データの準備:SFT アルゴリズムは JSONL 形式を含む複数の形式の学習データセットを受け付けます。その他のフォーマット要件については、モデルドキュメントをご参照ください。以下に JSONL 形式の学習データの例を示します:

{"messages": [{"role": "system", "content": "あなたは親切で無害なアシスタントです"}, {"role": "user", "content": "あなたは誰ですか?"}, {"role": "assistant", "content": "私は Xiao Pai という AI アシスタントで、PAI によって訓練されました。私の目標は、有用で正確かつタイムリーな情報を提供し、ユーザーが効果的にコミュニケーションできるよう支援することです。本日はどのようなお手伝いをしましょうか?"}]} {"messages": [{"role": "system", "content": "あなたは親切で無害なアシスタントです"}, {"role": "user", "content": "あなたは誰ですか!"}, {"role": "assistant", "content": "こんにちは!私は PAI が開発した AI 言語モデル「Xiao Pai」です。質問への回答、情報提供、会話、問題解決のお手伝いができます。何かご質問やお困りのことがあれば、いつでもお気軽にお知らせください!"}]} -

学習パラメーターの構成:学習データの準備が完了したら、Object Storage Service (OSS) バケットへアップロードします。QwQ-32B は大規模モデルであるため、学習には VRAM 96 GB 以上の GPU が必要です。リソースクォータに十分な計算リソースが確保されていることを確認してください。

下表に、サポートされているハイパーパラメーターを示します。データセットおよび計算リソースに応じて適宜調整するか、デフォルト値のまま使用してください。

パラメーター名

説明

補足

learning_rate

学習率。学習中にモデルの重みが変化する量を制御します。

学習率が高すぎると学習が不安定になり、損失値の大きな振動が生じます。逆に低すぎると収束が遅くなります。モデルが迅速かつ安定して収束できる値を選択してください。

num_train_epochs

学習データセットを繰り返し処理する回数。

エポック数が少なすぎると過小適合(アンダーフィッティング)が生じ、多すぎると過学習(オーバーフィッティング)が生じます。小規模データセットでは、過小適合を防ぐためエポック数を増加させることを推奨します。また、学習率が小さい場合は、通常、より多くのエポック数が必要です。

per_device_train_batch_size

1 回の学習ステップで、各 GPU が処理するサンプル数。

バッチサイズを大きくすると学習が高速化されますが、VRAM 使用量も増加します。GPU メモリに収まる最大のバッチサイズを使用してください。タスク監視ページで GPU メモリ使用量を確認できます。

gradient_accumulation_steps

モデルの重みを更新する前に勾配を蓄積するステップ数。

バッチサイズが小さいと勾配の分散が大きくなり、収束が遅くなります。勾配蓄積により、複数のバッチから得られた勾配を 1 回の更新前に合計できます。この値は、使用する GPU 数の倍数に設定することを推奨します。

max_length

1 回の学習ステップにおける入力データの最大トークン長。

トークン化後、学習データはトークンの列として表現されます。テキスト長の見積もりには、トークン推定ツールをご利用ください。

lora_rank

LoRA のランク。

lora_alpha

LoRA の重み。

LoRA スケーリング係数。通常は lora_rank × 2 に設定します。

lora_dropout

LoRA 学習時のドロップアウト率。過学習防止のため、学習中にランダムにニューロンを無効化します。

lorap_lr_ratio

LoRA+ の学習率比(λ = ηB/ηA)。ここで、ηA および ηB はアダプタ行列 A および B の学習率です。

LoRA と比較して、LoRA+ ではファインチューニングプロセスの重要な部分に対して異なる学習率を適用します。これにより、追加の計算コストをかけずに性能向上およびファインチューニングの高速化が実現されます。標準 LoRA を使用する場合は、lorap_lr_ratio を 0 に設定してください。

advanced_settings

このフィールドに、"--key1 value1 --key2 value2" の形式でカスタム引数を追加できます。必要ない場合は空欄のままにしてください。

-

save_strategy:モデルチェックポイントの保存戦略。選択肢:`steps`、`epoch`、`no`。デフォルト値:`steps`。

-

save_steps:チェックポイント保存間のステップ数。デフォルト値:500。

-

save_total_limit:保持するチェックポイントの最大数。古いチェックポイントは自動的に削除されます。デフォルト値:2。すべてのチェックポイントを保持する場合は `None` を指定します。

-

warmup_ratio:学習率ウォームアップに使用される学習ステップの割合。ウォームアップ期間中、学習率は小さな値から初期学習率まで徐々に増加します。デフォルト値:0。

-

-

**[学習]** をクリックして学習を開始します。学習ジョブのステータスおよびログをモニターします。学習が完了したら、ファインチューニング済みモデルをオンラインサービスとしてデプロイします。

モデルの評価

PAI Model Gallery には、一般的な評価アルゴリズムが組み込まれています。事前学習済みモデルおよびファインチューニング済みモデルのいずれも、設定不要で評価可能です。評価により、モデルの性能を定量的に把握したり、複数のモデルを比較してご利用のユースケースに最適なモデルを選定したりできます。

評価エントリポイント:

|

事前学習済みモデルを直接評価 |

|

|

学習ジョブの詳細ページからファインチューニング済みモデルを評価 |

|

評価では、カスタムデータセットおよび公開データセットの両方をサポートしています:

-

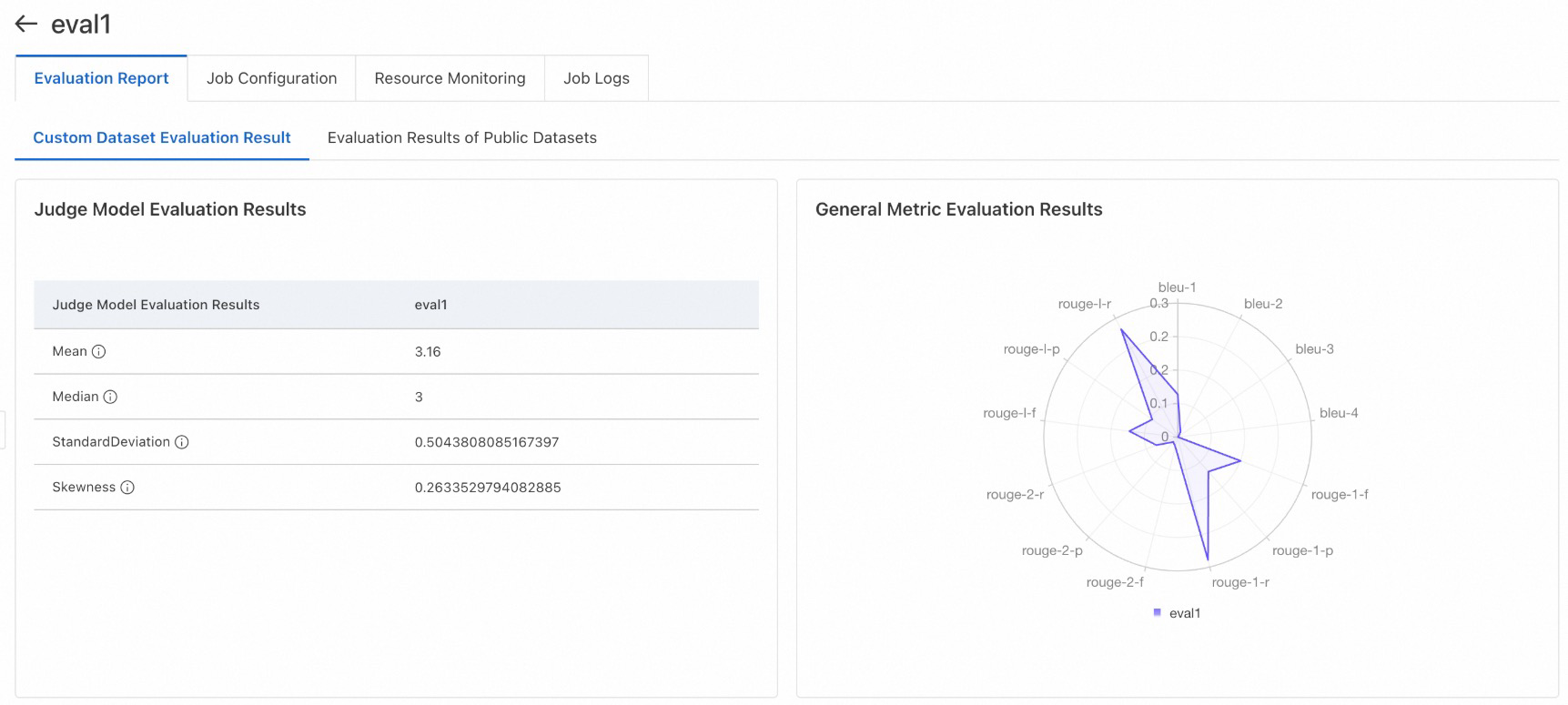

カスタムデータセットによる評価

サポートされる評価指標には、NLP 分野で広く用いられるテキスト一致スコアである BLEU および ROUGE のほか、エキスパートモードでのみ利用可能な「LLM-as-a-Judge 評価」があります。LLM-as-a-Judge では、別の LLM を用いて結果をスコアリングおよび説明します。これは、モデルがお客様独自のシナリオに適合するかどうかを検証する際に有効です。

JSONL 形式の評価データセットをご提供ください。各行は question および answer フィールドを含む JSON オブジェクトである必要があります。サンプルファイル例:evaluation_test.jsonl。

-

公開データセットによる評価

この手法では、オープンソースの評価データセットをドメイン別に分類することで、大規模言語モデル(LLM)の包括的な能力評価を実現します。PAI では現在、CMMLU、GSM8K、TriviaQA、MMLU、C-Eval、TruthfulQA、HellaSwag などのデータセットを提供しており、数学、知識、推論など多様なドメインをカバーしています。その他の公開データセットも順次統合予定です。なお、GSM8K、TriviaQA、HellaSwag の各データセットを用いた評価には長い時間がかかる場合があるため、必要に応じて選択してください。

評価結果の出力先パスを選択し、システム推奨に従って計算リソースを指定した後、評価ジョブを送信します。完了後、ジョブページから結果をご確認いただけます。複数のデータセットを選択した場合、モデルはそれらを 1 つずつ順次実行するため、待ち時間が長くなることがあります。どのデータセットが実行中かは、ログで確認できます。

評価レポートの表示:カスタムデータセットおよび公開データセットそれぞれの評価結果例:

お問い合わせ

PAI Model Gallery を引き続きご利用いただき、誠にありがとうございます。当社では、最新の最先端(SOTA)モデルを定期的に追加しています。モデルに関するご要望がございましたら、ぜひお知らせください。DingTalk の PAI Model Gallery ユーザーグループへは、グループ番号「79680024618」を検索してご参加ください。