Notebook は、コード、テキスト、チャートを組み合わせて他のユーザーと情報を共有できるインタラクティブなページです。このトピックでは、ワークスペースで Notebook を使用してデータをクエリおよび分析する方法について説明します。

前提条件

対象のワークスペースに AnalyticDB for MySQL インスタンスがインポートされていること。詳細については、「Notebook に必要なリソース」をご参照ください。

注意

新しい Notebook バージョンは、中国 (杭州)、中国 (北京)、中国 (上海)、中国 (深圳)、シンガポール、およびインドネシア (ジャカルタ) のリージョンでのみ利用可能です。

課金情報

Notebook セッションの料金は、その [仕様] (使用されるコンピュートユニット (CU) の数) に基づきます。単価については、リソースを設定する際のページの情報をご参照ください。

手順

Notebook ファイルを作成し、コードを実行します。

Notebook ファイルは、次のいずれかの方法で作成できます。

ファイルを手動で作成する

ワークスペースの右側にある

(リソースマネージャー) アイコンをクリックします。

(リソースマネージャー) アイコンをクリックします。WORKSPACE エリアで、空白領域を右クリックし、[新しい Notebook ファイル] を選択します。

ファイル名を入力し、[OK] をクリックします。

ファイルをインポートする

ワークスペースの右側にある

(リソースマネージャー) アイコンをクリックします。

(リソースマネージャー) アイコンをクリックします。WORKSPACE エリアで、空白領域を右クリックし、[ファイルをアップロード] を選択します。

アップロードするファイルを選択し、[OK] をクリックします。

説明Notebook ファイルを作成した後、ファイルがワークスペースエリアに表示されない場合は、

をクリックしてリソースマネージャーをリフレッシュします。

をクリックしてリソースマネージャーをリフレッシュします。ファイル名をダブルクリックしてコード実行ページを開き、そこでジョブを開発できます。

セルにコードを入力し、

実行ボタンをクリックします。

実行ボタンをクリックします。「実行に失敗しました。最初に Notebook セッションリソースを作成してマウントする必要があります。」というメッセージが表示された場合は、[セッションの作成] をクリックします。

Notebook セッションを作成します。

[セッションの作成] をクリックし、次のパラメーターを構成します。

パラメーター

説明

クラスター

ターゲットクラスターのタイプを選択します。

実行に CPU のみを使用する必要がある場合は、デフォルトの DMS CPU クラスターを選択します。このクラスターは、ワークスペースの作成時に自動的に作成されます。

Spark を使用してジョブを開発するには、Spark クラスターを選択します。このクラスターは手動で作成する必要があります。

クラスターのドロップダウンリストから、[クラスターの作成] をクリックし、Spark クラスターの作成 を選択できます。

セッション名

セッションのカスタム名を入力します。

イメージ

選択したクラスタータイプに基づいて、対応するイメージ仕様がページに表示されます。

Python3.9_U22.04:1.0.9

Python3.11_U22.04:1.0.9

Spark3.6_Scala2.12_Python3.9:1.0.9

Spark3.3_Scala2.12_Python3.9:1.0.9

仕様

ドライバーのリソース仕様。

1 Core 4 GB

2 Core 8 GB

4 Core 16 GB

8 Core 32 GB

16 Core 64 GB

構成

プロファイルリソース。

プロファイル名、リソースのリリース期間、データストレージの場所、Pypi パッケージ管理、および環境変数情報を編集できます。

説明リソースのリリース期間: リソースが指定された期間を超えてアイドル状態である場合、自動的にリリースされます。期間を 0 に設定した場合、リソースは自動的にリリースされることはありません。

[完了して作成] をクリックします。

ステータスが [実行中] に変わると、セッションが作成されます。

初めてセッションを作成するには約 5 分かかります。その後の作成または再起動には約 1 分かかります。

コードを再度実行します。

実行された Spark SQL コードの結果は、

データカタログエリアで表示できます。

データカタログエリアで表示できます。

Notebook インターフェイス

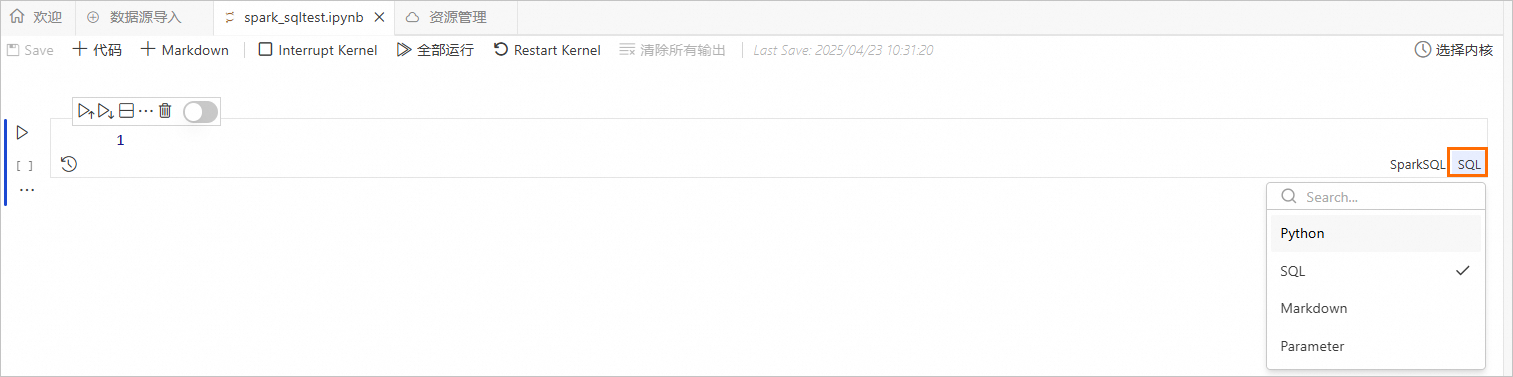

サポートされているセル プロパティ: Python、SQL、Markdown、およびパラメーター。

: Notebook のコードを保存します。説明

: Notebook のコードを保存します。説明デフォルトでは、DMS は実行されたコードのみを自動的に保存します。実行されていないコードは手動で保存する必要があります。そうしないと、機能ページまたはブラウザを閉じた場合に、変更が失われます。

: Python プロパティを持つセルを追加します。

: Python プロパティを持つセルを追加します。 : Markdown プロパティを持つセルを追加します。

: Markdown プロパティを持つセルを追加します。 : カーネルを中断します。これにより、現在選択されている Spark リソースを使用しているコードの実行が停止します。

: カーネルを中断します。これにより、現在選択されている Spark リソースを使用しているコードの実行が停止します。 : 現在の Notebook ファイル内の SQL を実行します。

: 現在の Notebook ファイル内の SQL を実行します。 : カーネルを再起動します。これにより、Spark リソースが再起動されます。

: カーネルを再起動します。これにより、Spark リソースが再起動されます。 : 選択したセルを実行します。

: 選択したセルを実行します。 : 現在のセルの上にあるすべてのセルを実行します。

: 現在のセルの上にあるすべてのセルを実行します。 : 現在のセルとその下にあるすべてのセルを実行します。

: 現在のセルとその下にあるすべてのセルを実行します。 : セルを分割します。

: セルを分割します。 : 選択したセルを削除します。

: 選択したセルを削除します。 : セルの実行履歴を表示します。

: セルの実行履歴を表示します。 : セルを無効にして、実行されないようにします。

: セルを無効にして、実行されないようにします。

Spark クラスターの作成

[クラスターの作成] ページで、[Spark クラスター] 情報を構成します。

次の表にパラメーターを示します。

パラメーター

説明

クラスター名

シナリオを識別するのに役立つクラスター名を入力します。

環境

次のイメージがサポートされています。

adb-spark:v3.3-python3.9-scala2.12

adb-spark:v3.5-python3.9-scala2.12

AnalyticDB インスタンス

ドロップダウンリストから、準備した AnalyticDB for MySQL インスタンスを選択します。

AnalyticDB For MySQL リソースグループ

ドロップダウンリストから、準備した Job リソースグループを選択します。

Spark アプリケーションエグゼキュータの仕様

AnalyticDB for MySQL Spark エグゼキュータのリソース仕様を選択します。

モデルの値が異なれば、仕様も異なります。詳細については、「Spark アプリケーションの構成パラメーター」の [モデル] 列をご参照ください。

VSwitch

現在の VPC 内の vSwitch を選択します。

依存 Jar

JAR パッケージの OSS ストレージパス。このパラメーターは、Python を使用してジョブを送信し、JAR パッケージが使用される場合にのみ指定します。

SparkConf

設定項目は、基本的にオープンソースの Spark のものと同じです。パラメーターのフォーマットは

key: valueです。オープンソースの Spark とは異なる方法で使用される構成パラメーター、および AnalyticDB for MySQL に固有のパラメーターについては、「Spark アプリケーションの構成パラメーター」をご参照ください。[クラスターの作成] をクリックします。

Notebook セッションで、作成した Spark クラスターを選択します。

Notebook セッションが Spark クラスターに関連付けられると、クラスター ステータスは [実行中] に変わります。

その他の操作

セルを追加する

Notebook ツールバーで、

SQL、Python、Markdown、または Parameter を選択して、対応するタイプの新しいセルを作成できます。コード編集エリアの既存のセルの上または下にもセルを追加できます。現在のセルの上にセルを追加する: セルの上部にマウスを合わせると、コードを追加するためのボタンが表示されます。

現在のセルの下にセルを追加する: セルの下部にマウスを合わせると、コードを追加するためのボタンが表示されます。

セル プロパティを切り替える

セルの右側にあるプロパティタイプをクリックして変更します。

セルでコードを開発する

対応するセルで SQL、Python、および Markdown のコードを編集できます。SQL セルにコードを記述するときは、SQL 構文が選択したセルタイプに対して有効であることを確認してください。