データディザスタリカバリ は、Alibaba Cloud データベース、Elastic Compute Service (ECS) インスタンスでホストされている自己管理データベース、オンプレミスデータベース、およびサードパーティプロバイダのクラウドデータベースをサポートしています。このトピックでは、オンプレミスデータベースまたはサードパーティプロバイダのクラウドデータベースをバックアップする方法について説明します。

使用上の注意

バックアップ対象のデータベースとテーブルに、不適切なテーブルスキーマ、大きなテーブル、大きなフィールドなどの問題がある場合、バックアップスケジュールに十分なリソースがない可能性があり、バックアップの例外が発生する可能性があります。そのため、後続のバックアップで例外が発生しないように、バックアップスケジュールを作成するときに大きな仕様タイプを選択することをお勧めします。

手順

サービスの自動バックアップ

バックアップスケジュールの購入(論理バックアップ)

DMS コンソール V5.0 にログオンします。

上部のナビゲーションバーで、 を選択します。

説明シンプルモードで DMS コンソールを使用する場合は、DMS コンソールの左上隅にある

アイコンにポインタを移動し、 を選択します。

アイコンにポインタを移動し、 を選択します。ページの上部で、リージョンを選択します。 [ディザスタリカバリデータソース] ページで、 を選択し、使用するデータソースの ID をクリックして詳細ページに移動します。

[バックアップポリシー] ページで、[バックアップポリシーの構成] をクリックします。

[バックアップスケジュールの選択] ステップで、[バックアップスケジュールの購入] をクリックして購入ページに移動します。

次のパラメータを構成し、ページの右下隅にある [今すぐ購入] をクリックします。

パラメータ

説明

製品タイプ

バックアップスケジュール を選択します。

リージョン

バックアップデータを保存するリージョン。

説明バックアップスケジュールと Elastic Compute Service (ECS) インスタンスが同じリージョンにあることを確認してください。

データソースタイプ

MySQL に設定します。

仕様

使用するバックアップスケジュールの仕様。仕様が高いほど、バックアップとリストアのパフォーマンスが高くなります。DBS は、micro、small、medium、large、xlarge のバックアップスケジュールの仕様をサポートしています。 xlarge 仕様タイプは、バックアップデータ量の制限がない特大仕様を提供します。

説明本番環境のデータベースインスタンスなど、特定のデータベースインスタンスのバックアップとリストアを高速化するには、xlarge または Large を選択することをお勧めします。

高いバックアップおよびリストアパフォーマンスが不要な場合は、ビジネス要件に基づいて最も費用対効果の高いバックアップスケジュールタイプを選択できます。詳細については、「バックアップスケジュールタイプの選択」をご参照ください。

バックアップ対象のデータベースとテーブルに、不適切なスキーマ、大きなテーブル、大きなフィールドなどの問題が関係する場合、仕様の低いバックアップインスタンスのリソースではバックアップを完了できない場合があります。その結果、バックアップエラーが発生します。バックアップエラーを防ぐために、より高い仕様のバックアップインスタンスを購入することをお勧めします。

バックアップ方法

論理バックアップ を選択します。

ストレージサイズ

バックアップスケジュールを作成するときに容量を選択する必要はありません。データディザスタリカバリに保存されているデータ量に基づいて課金されます。詳細については、「ストレージ料金」をご参照ください。

リソースグループ

バックアップスケジュールで使用されるリソースグループ。デフォルトのリソースグループを使用するか、ビジネス要件に基づいてリソースグループを選択できます。

数量

購入するバックアップスケジュールの数。複数のデータベースインスタンスをバックアップするには、複数のバックアップスケジュールを購入する必要があります。たとえば、データベースインスタンス A とデータベースインスタンス B をバックアップする場合、2 つのバックアップスケジュールを購入する必要があります。

サブスクリプション期間

購入するバックアップスケジュールのサブスクリプション期間。

[注文の確認] ページで、注文情報を確認し、サービス条件を読んで選択してから、[支払] をクリックします。

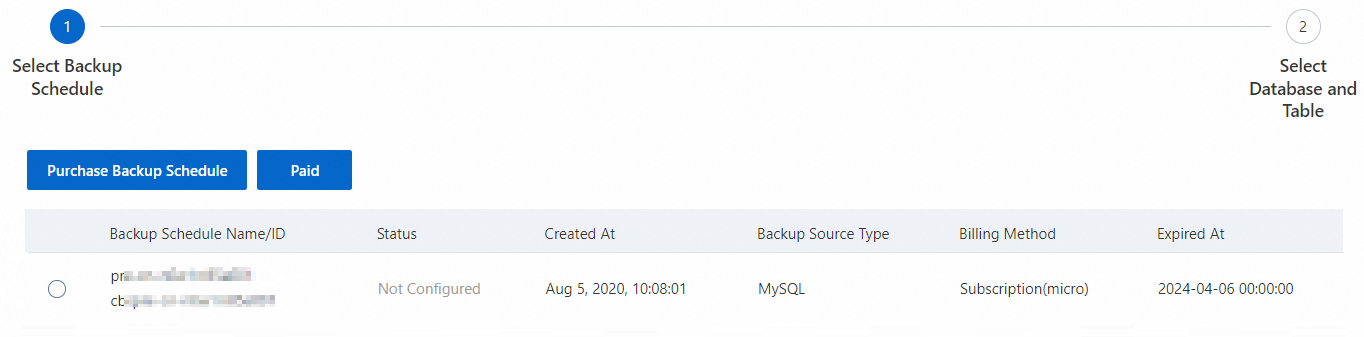

支払いが完了したら、[バックアップスケジュールの選択] ステップに戻り、[支払済] をクリックして、作成されたバックアップスケジュールを表示します。

バックアップポリシーの構成

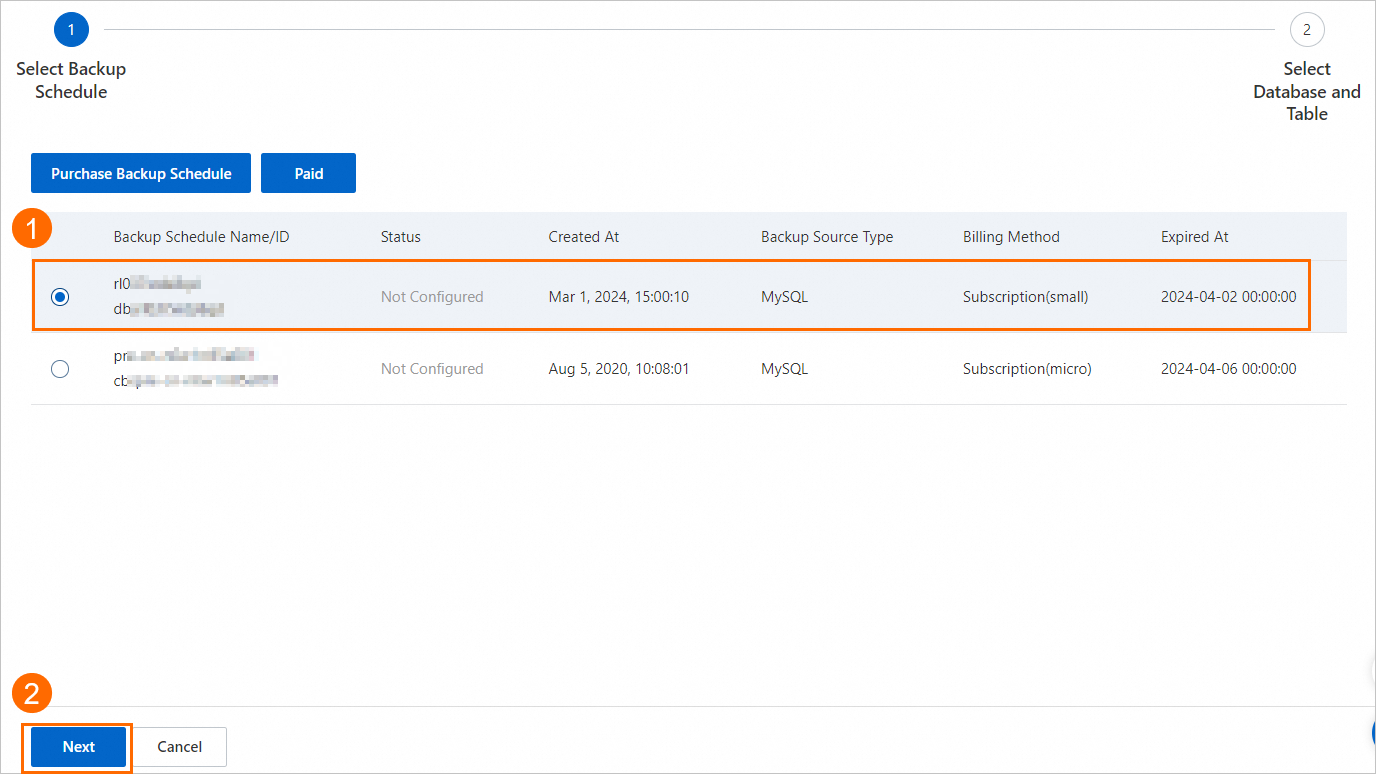

[バックアップスケジュールの選択] ステップで、構成するバックアップスケジュールを選択し、[次へ] をクリックします。

[データベースとテーブルの選択] ステップで、バックアップするデータベースとテーブルを選択し、

アイコンをクリックして [選択済みオブジェクト] セクションに移動してから、[送信] をクリックします。

アイコンをクリックして [選択済みオブジェクト] セクションに移動してから、[送信] をクリックします。

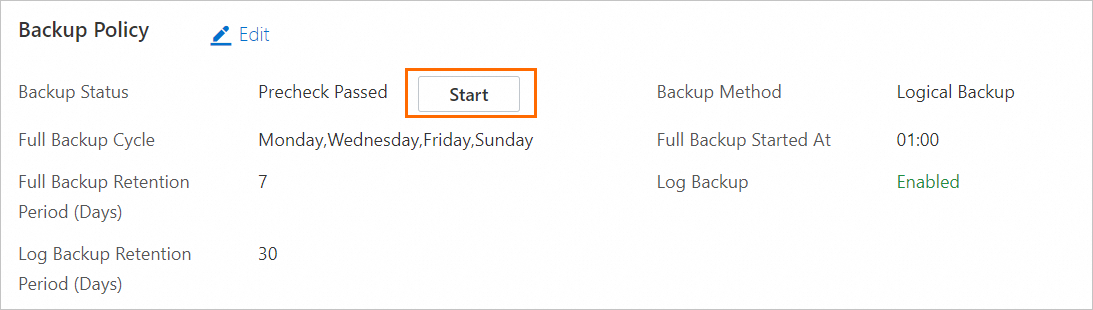

[バックアップポリシー] ページで、[論理バックアップ] タブをクリックし、[開始] をクリックしてバックアップを開始します。

[開始] をクリックすると、システムはすぐに完全バックアップと増分バックアップを開始します。

説明

説明バックアップポリシーの変更など、他の操作を実行する場合は、この手順をスキップできます。データディザスタリカバリは、後でバックアップポリシーに基づいてバックアップを自動的に開始します。

ユーザーの自動バックアップ

MySQL 5.5 を実行するデータベースインスタンスのみがサポートされています。

中国 (杭州) リージョンのみがサポートされています。

バックアップソースの構成とバックアップファイルのアップロード

DMS コンソール V5.0 にログオンします。

上部のナビゲーションバーで、 を選択します。

説明シンプルモードで DMS コンソールを使用する場合は、DMS コンソールの左上隅にある

アイコンにポインタを移動し、 を選択します。

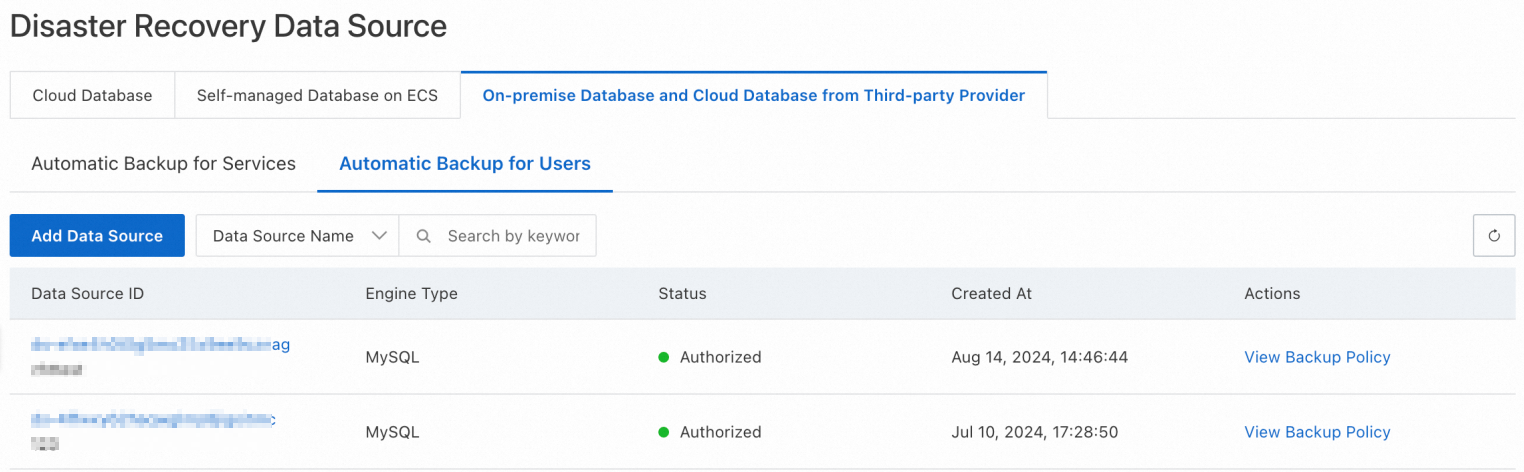

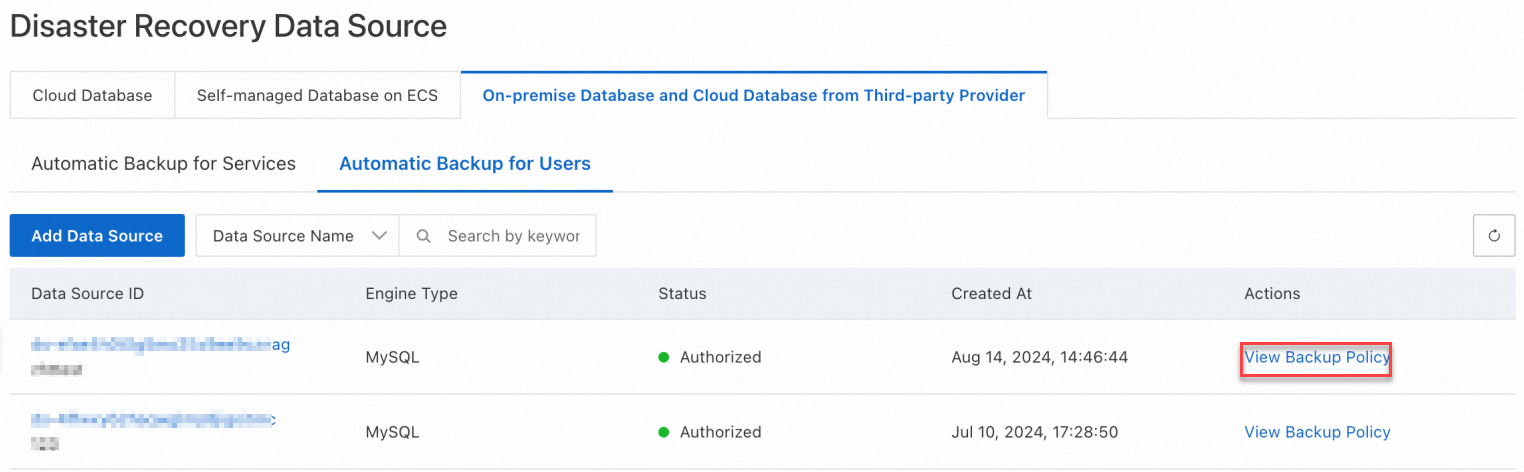

アイコンにポインタを移動し、 を選択します。ページの上部で、リージョンを選択します。 [ディザスタリカバリデータソース] ページで、[オンプレミスデータベースとサードパーティプロバイダのクラウドデータベース] タブをクリックし、データソースタイプに基づいてデータソースを追加します。

[データソースの追加] をクリックします。表示されるダイアログボックスで、次のパラメータを構成し、使用するバックアップスケジュールを選択して、[次へ] をクリックします。

パラメータ

説明

データソース名

識別しやすい説明的な名前を使用することをお勧めします。

エンジンの種類

データベースエンジンの種類。MySQL のみがサポートされています。

エンジンバージョン

バックアップするデータベースのエンジンバージョン。

エンジンパラメータ

{"lower_case_table_names":1}

使用可能なバックアップスケジュールがない場合は、[バックアップスケジュールの購入] をクリックして購入ページに移動し、バックアップスケジュールを購入します。

説明

製品タイプ

バックアップスケジュール を選択します。従量課金制はサポートされていません。

リージョン

バックアップデータを保存するリージョン。

データソースタイプ

MySQL を選択します。

仕様

xmicro を選択します。 xmicro 仕様タイプで提供される無料枠の詳細については、「バックアップスケジュールタイプ」をご参照ください。

バックアップ方法

物理バックアップ を選択します。

ストレージサイズ

バックアップスケジュールを作成するときに容量を選択する必要はありません。データディザスタリカバリ に保存されているデータ量に基づいて課金されます。詳細については、「ストレージ料金」をご参照ください。

リソースグループ

バックアップスケジュールで使用されるリソースグループ。デフォルトのリソースグループを使用するか、ビジネス要件に基づいてリソースグループを選択できます。

数量

購入するバックアップスケジュールの数。複数のデータベースインスタンスをバックアップするには、複数のバックアップスケジュールを購入する必要があります。たとえば、データベースインスタンス A とデータベースインスタンス B をバックアップする場合、2 つのバックアップスケジュールを購入する必要があります。

サブスクリプション期間

購入するバックアップスケジュールのサブスクリプション期間。

指定されたバケットにバックアップセットをアップロードします。詳細については、「データのアップロード (ユーザーの自動バックアップ)」をご参照ください。

[OK] をクリックします。

バックアップ情報の表示

[ユーザーの自動バックアップ] タブで、管理するデータソースの ID をクリックします。

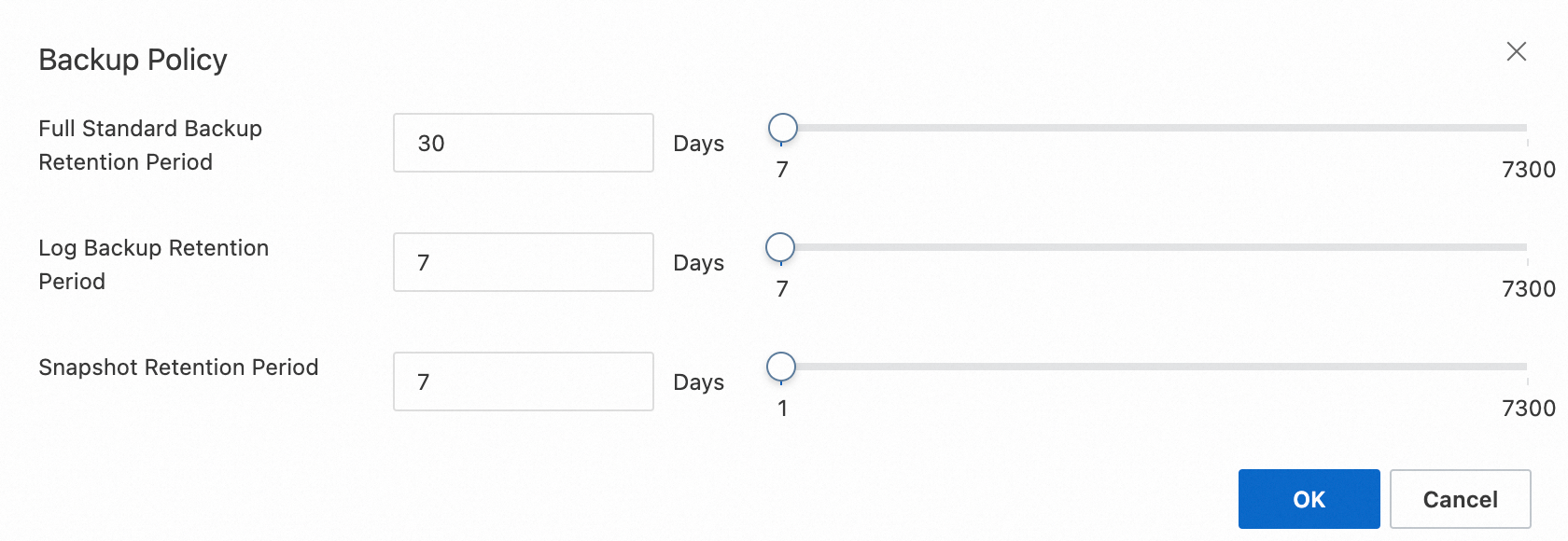

バックアップポリシーの構成

[ユーザーの自動バックアップ] タブで、管理するデータソースを見つけ、[操作] 列の [バックアップポリシーの表示] をクリックします。

[OK] をクリックします。

バックアップデータの表示とダウンロード

[ユーザーの自動バックアップ] タブで、管理するデータソースの ID をクリックします。

左側のナビゲーションウィンドウで、[バックアップデータ] をクリックします。

説明データスクリプトをアップロードしてデータソースを作成した後、新しいバックアップセットが生成されると、システムは自動的にバックアップセットを [バックアップデータ] ページに同期します。

バックアップセットの [操作] 列の [ダウンロード] をクリックして、バックアップセットをダウンロードします。

リストアタスクの作成

データをリストアするには、バックアップセットが [データバックアップ] ページに表示され、完了状態である必要があります。

[ユーザーの自動バックアップ] タブで、管理するデータソースの ID をクリックします。

左側のナビゲーションウィンドウで、[バックアップデータ] をクリックします。 [論理バックアップ] タブで、[リストアタスクの作成] をクリックして、次のリストアパラメータを構成します。

パラメータ

説明

タスク名

リストアタスクの名前。識別しやすい説明的な名前を使用することをお勧めします。

リストア先

ターゲットデータベースインスタンス。デフォルト値: 新しいインスタンス (RDS)。

データベースの場所

ターゲットデータベースインスタンスの場所。デフォルト値: RDS。

インスタンスリージョン

ターゲットデータベースインスタンスが存在するリージョン。中国 (杭州) リージョンのみがサポートされています。

VPC

ターゲットデータベースインスタンスが存在する VPC。

VSwitch

ターゲットデータベースに接続されている vSwitch。

インスタンスエディション

ターゲットデータベースインスタンスのエディション。

インスタンスの仕様

ターゲットデータベースインスタンスのタイプ。

ストレージスペース

ターゲットデータベースインスタンスに必要なストレージスペース。

リストアモード

ポイントインタイムでのみデータベースをリストアできます。

リストア時間

バックアップセットをリストアするポイントインタイム。使用可能な時間範囲は、リストアモード パラメータの後に表示されます。

構成が完了したら、[送信] をクリックします。リストアタスクが作成されます。タスク情報は [リストアタスク] ページに表示されます。

リストアタスクの表示

[ユーザーの自動バックアップ] タブで、管理するデータソースの ID をクリックします。

左側のナビゲーションウィンドウで、 を選択します。

[リストア結果] 列のインスタンス ID をクリックして、バックアップセットのリストア先の RDS インスタンスの [基本情報] ページに移動します。

リカバリルールの表示

[ユーザーの自動バックアップ] タブで、管理するデータソースの ID をクリックします。

左側のナビゲーションウィンドウで、[リカバリルール] をクリックします。

リカバリルールのメトリック

リカバリルールのメトリックは、[リカバリタスクの成功率]、[平均リカバリ時間]、[データバックアップルールのカバレッジ率]、[ログバックアップルールのカバレッジ率] です。

メトリック

説明

リカバリタスクの成功率

指定された期間内のポイントインタイムにデータをリストアするリストアタスクの成功率。

平均リカバリ時間

指定された期間内の成功したリストアタスクの平均時間。

データバックアップルールのカバレッジ率

指定された期間内にオープンソースの MySQL インスタンスまたは ApsaraDB RDS for MySQL インスタンスで実行されるデータリカバリルールのカバレッジ率。

ログバックアップルールのカバレッジ率

指定された期間内にオープンソースの MySQL インスタンスまたは ApsaraDB RDS for MySQL インスタンスで実行されるログリカバリルールのカバレッジ率。

リカバリルールのタイムライン

タイムラインには、指定された期間内の各ポイントインタイムにおけるリカバリルールの詳細が表示されます。タイムラインをクリックすると、現在のポイントインタイムのルール情報が表示されます。

リカバリルールの詳細

[データバックアップ] タブをクリックして、データバックアップのリカバリルールの詳細を表示します。 [ルール結果] 列のインスタンス ID をクリックして、リストアされた RDS インスタンスの [基本情報] ページに移動します。

[ログバックアップ] タブをクリックして、ログバックアップのリカバリルールの詳細を表示します。