Pelatihan AI sering kali memerlukan pembacaan berulang dari sejumlah besar data, yang menciptakan beban jaringan signifikan dan memengaruhi efisiensi pelatihan. PAI menyediakan fitur akselerasi cache lokal untuk Layanan Komputasi AI Lingjun. Fitur ini menyimpan data di disk lokal node komputasi untuk mengurangi beban jaringan, meningkatkan throughput pelatihan, dan memperbaiki kinerja pembacaan data, sehingga mempercepat tugas pelatihan AI Anda.

Keunggulan teknis

Cache Kecepatan Tinggi: Memanfaatkan memori dan disk lokal dari node komputasi untuk membangun cache bacaan single-node dan terdistribusi. Ini mempercepat akses ke set data dan checkpoint serta secara signifikan mengurangi latensi akses data.

Skalabilitas Horizontal: Throughput cache meningkat secara linear dengan jumlah node komputasi, mendukung skala dari ratusan hingga ribuan node.

Distribusi Model P2P: Mendukung pemuatan dan distribusi berskala besar model melalui teknologi peer-to-peer (P2P). Menggunakan jaringan berkecepatan tinggi antara node GPU untuk mempercepat pembacaan paralel data hot spot.

Tanpa Server dan Mudah Digunakan: Aktifkan atau nonaktifkan dengan satu klik. Tidak diperlukan modifikasi kode. Fitur ini non-intrusif terhadap program Anda dan tidak memerlukan operasi dan pemeliharaan (O&M).

Keterbatasan dan catatan

Dukungan Penyimpanan: Mendukung OSS dan CPFS Lingjun.

Sumber Daya yang Berlaku: Saat ini, hanya Sumber Daya Lingjun yang didukung. Perhatikan bahwa mengaktifkan fitur ini akan mengonsumsi sumber daya tertentu (CPU dan memori) dari node komputasi.

Kapasitas dan Kebijakan: Kapasitas cache maksimum bergantung pada spesifikasi Sumber Daya Lingjun. Kebijakan penggantian adalah Least Recently Used (LRU).

Target Akselerasi: Tujuan utamanya adalah meningkatkan kinerja pembacaan data. Operasi penulisan tidak didukung.

Ketersediaan Tinggi Data: Ketersediaan tinggi tidak dijamin. Data dalam cache lokal dapat hilang. Cadangkan data pelatihan penting secara tepat waktu.

Cara Kerjanya: Selama pelatihan multi-epoch, epoch pertama membaca data dari instans penyimpanan seperti OSS atau CP Lingjun. Performanya sama dengan membaca langsung dari instans penyimpanan. Pada epoch berikutnya, data dibaca dari cache lokal, yang meningkatkan kecepatan pembacaan.

Cara menggunakan

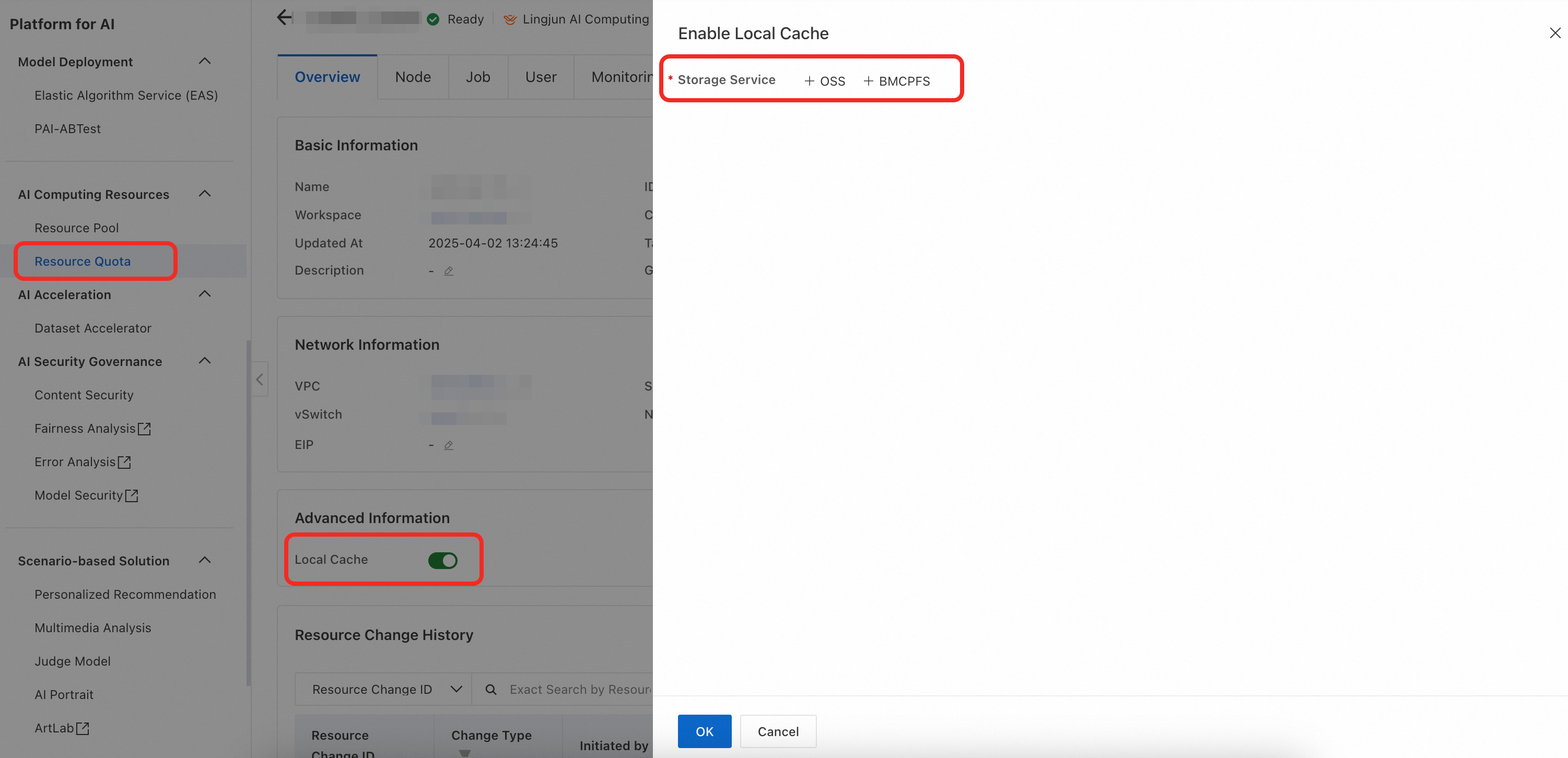

Aktifkan cache lokal untuk kuota sumber daya. Di panel navigasi di sebelah kiri, klik Resource Quota > Lingjun Resources. Temukan kuota target dan klik namanya untuk membuka halaman manajemennya. Aktifkan Local Cache dan atur jalur penyimpanan yang akan di-cache.

Jika Anda menggunakan kuota sumber daya bertingkat, pastikan bahwa cache lokal diaktifkan untuk kuota sumber daya tingkat atas.

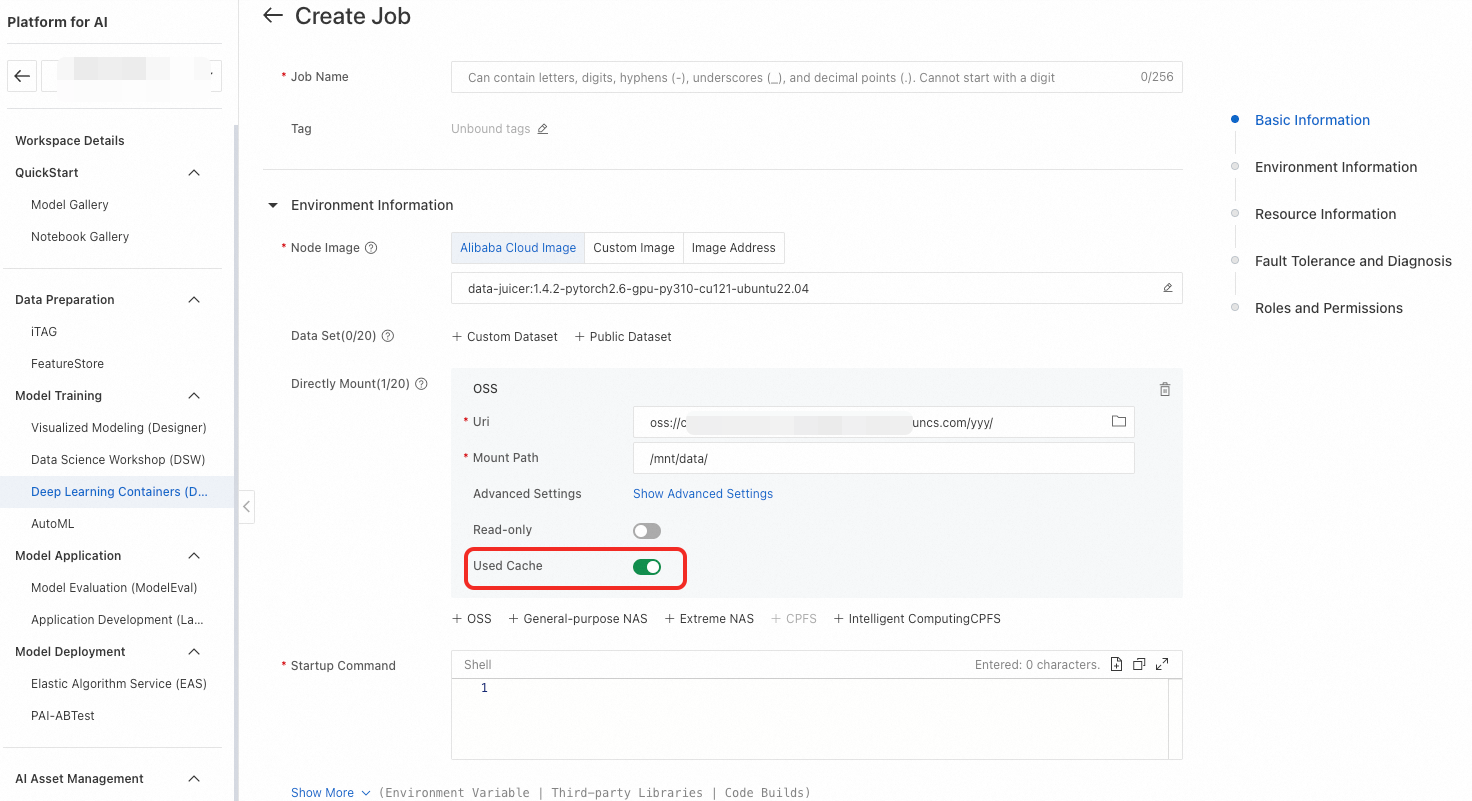

Buat Pekerjaan DLC menggunakan Sumber Daya Lingjun dari kuota sumber daya target dan aktifkan Used Cache. Ketika alamat penyimpanan yang dipasang sesuai dengan jalur cache yang Anda tentukan di Langkah 1, akselerasi diaktifkan secara default. Anda dapat memilih untuk menonaktifkannya.