Perkenalan model

Model inferensi QwQ-32B dari Alibaba Cloud menggunakan Pembelajaran Penguatan berskala besar untuk mencapai terobosan dalam kemampuan matematika, pemrograman, dan umum. Performanya setara dengan DeepSeek-R1 dengan biaya penerapan yang lebih rendah.

Setara dengan DeepSeek-R1 pada AIME24 (matematika) dan LiveCodeBench (pemrograman), serta mengungguli o1-mini dan model R1 hasil distilasi berukuran sama.

Mengungguli DeepSeek-R1 pada LiveBench (evaluasi LLM "tersulit" dari Meta), IFEval Google (kemampuan mengikuti instruksi), dan BFCL dari UC Berkeley (akurasi pemanggilan fungsi).

Mengintegrasikan kemampuan agen untuk berpikir kritis dengan penggunaan tool dan penyesuaian penalaran berdasarkan umpan balik lingkungan.

PAI-Model Gallery mendukung penerapan, fine-tuning, dan evaluasi QwQ-32B hanya dengan satu klik. Model lengkap memerlukan VRAM 96 GB. Versi terkuantisasi (QwQ-32B-GGUF, QwQ-32B-AWQ) dapat dijalankan pada GPU berbiaya lebih rendah seperti satu unit A10.

Menyebarkan model

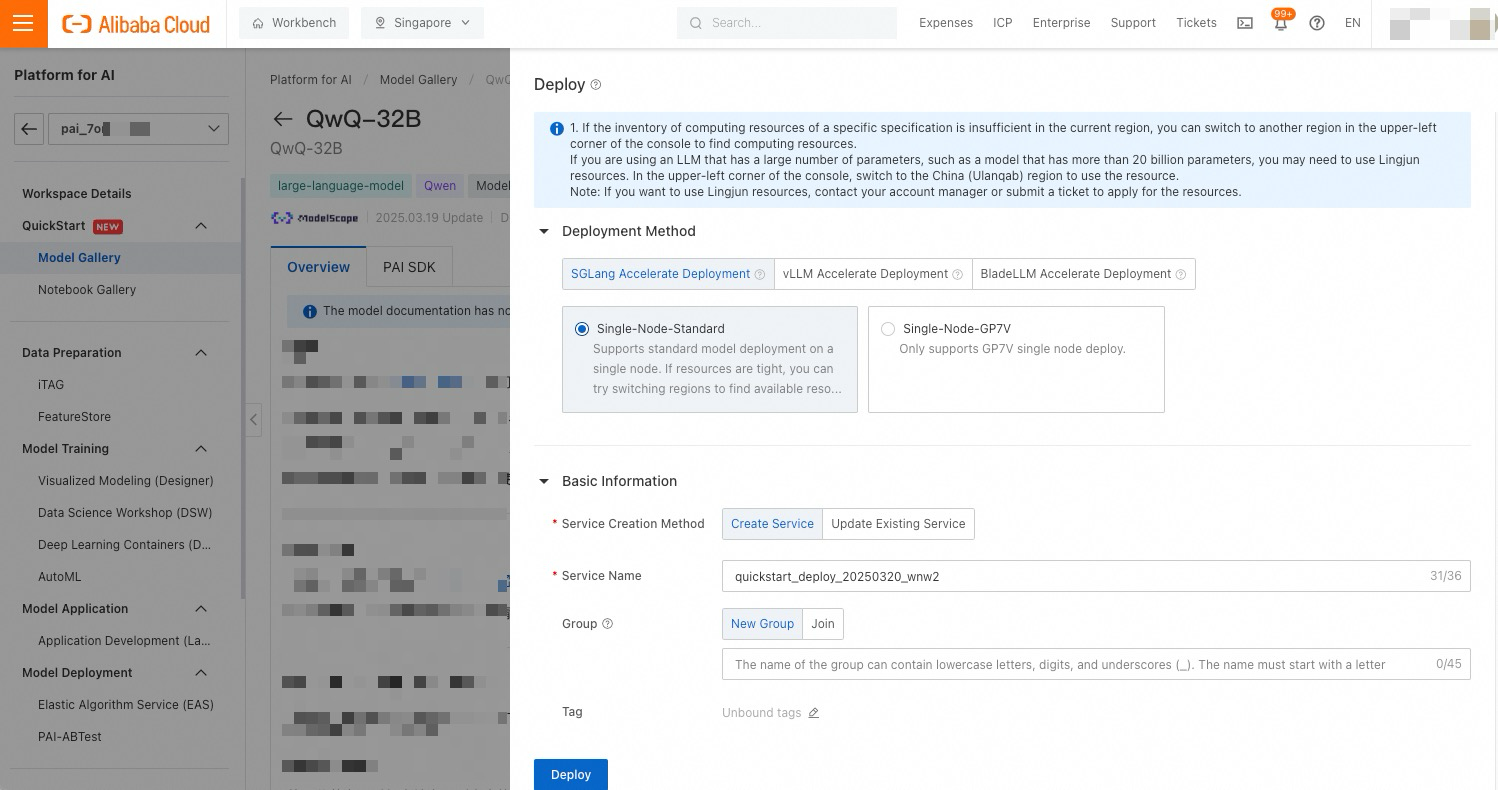

Buka halaman Model Gallery.

Login ke Konsol PAI. Di pojok kiri atas, pilih Wilayah Anda. Ganti wilayah untuk menemukan sumber daya komputasi yang tersedia.

Di panel navigasi kiri, pilih Workspace Management, lalu klik nama ruang kerja untuk membukanya.

Pilih QuickStart > Model Gallery.

Temukan kartu model QwQ-32B dan klik untuk membuka halaman detailnya.

Klik Deploy. Pilih framework penerapan, konfigurasikan nama layanan, dan tentukan sumber daya. Framework yang didukung: SGLang, vLLM, dan BladeLLM (framework inferensi berkinerja tinggi dari Alibaba Cloud PAI).

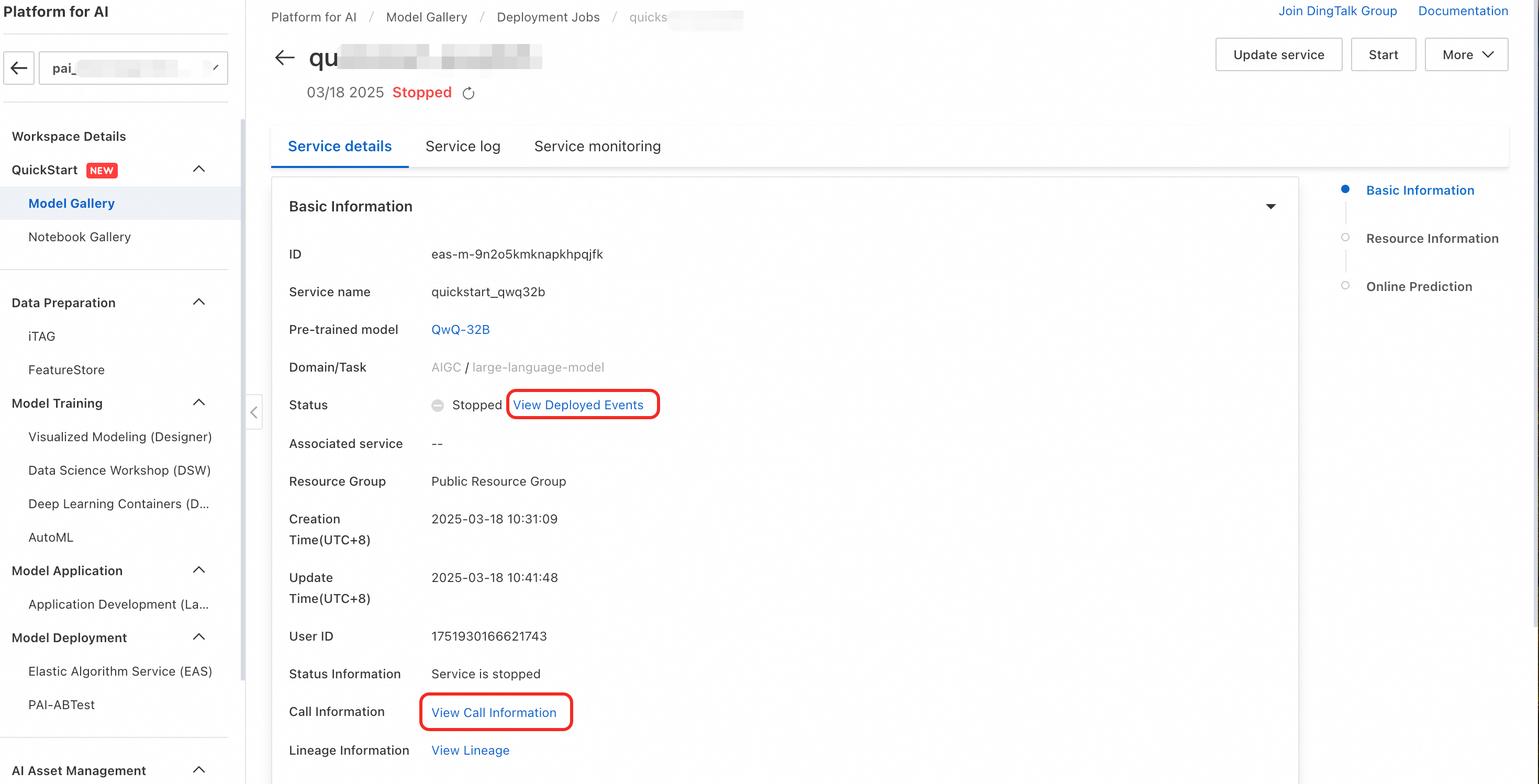

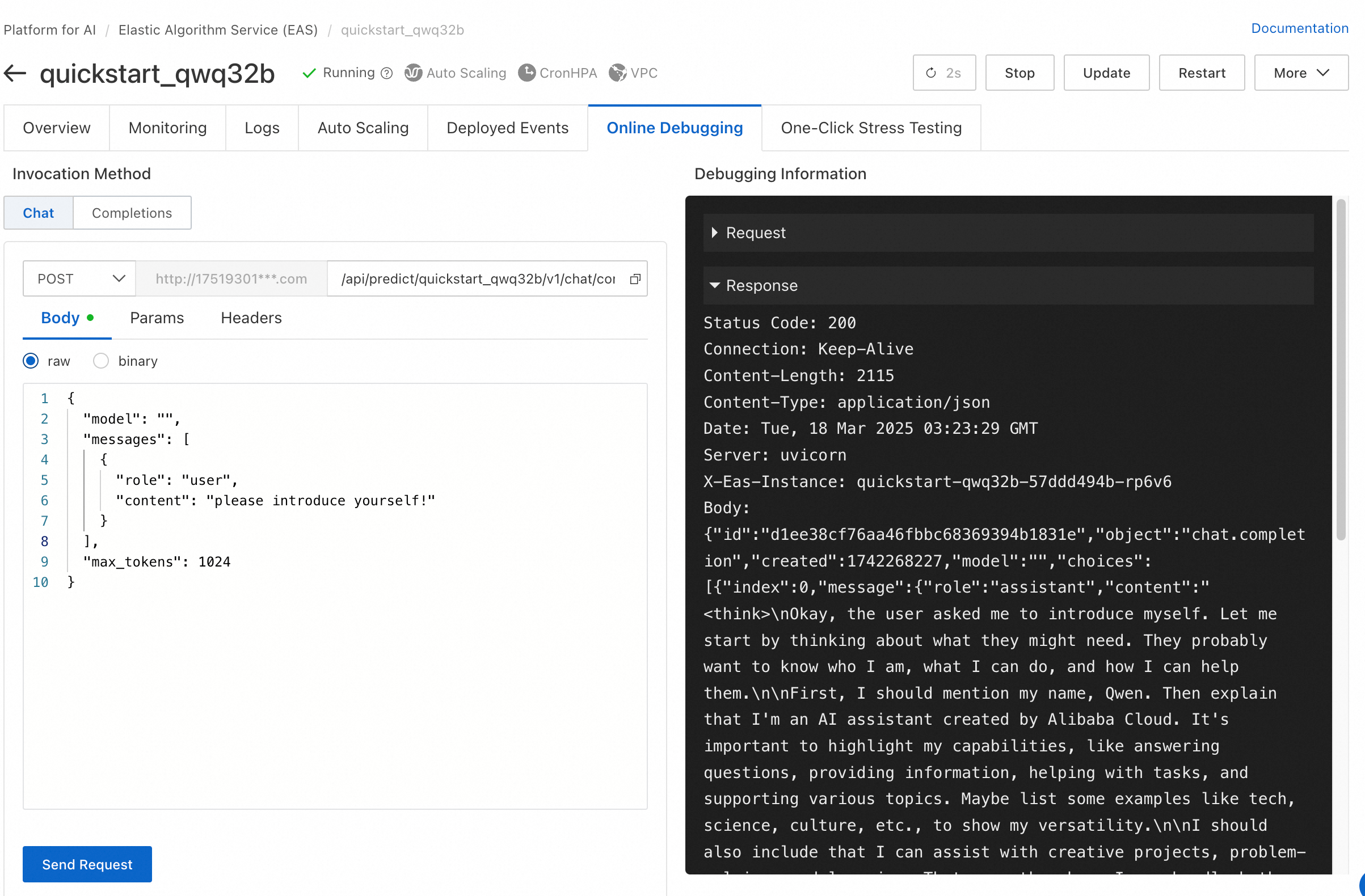

Gunakan layanan tersebut. Setelah penerapan berhasil, klik View Endpoint Information untuk mendapatkan titik akhir dan token. Klik tautan model untuk melihat petunjuk pemanggilan.

Debug layanan yang telah diterapkan secara online di PAI-EAS.

Fine-tune model

PAI-Model Gallery menyediakan supervised fine-tuning (SFT) untuk QwQ-32B dengan metode LoRA dan full-parameter.

Siapkan data pelatihan dalam format JSONL. Lihat dokumentasi model untuk persyaratan format. Contoh:

{"messages": [{"role": "system", "content": "You are a helpful and harmless assistant"}, {"role": "user", "content": "Who are you?"}, {"role": "assistant", "content": "I am Xiaopai, an AI assistant trained by PAI. My goal is to provide users with helpful, accurate, and timely information, and to help them communicate effectively in various ways. How can I help you?"}]} {"messages": [{"role": "system", "content": "You are a helpful and harmless assistant"}, {"role": "user", "content": "Who are you!"}, {"role": "assistant", "content": "Hello! I am an AI language model named Xiaopai, developed by PAI. I can answer your questions, provide information, engage in conversations, and help solve problems. If you have any questions or need help, please let me know!"}]}Konfigurasikan parameter pelatihan. Unggah data ke OSS. Model 32B memerlukan setidaknya 96 GB Memori GPU.

Hiperparameter yang didukung:

Parameter name

Deskripsi

Additional information

learning_rate

Mengontrol besarnya penyesuaian bobot model.

Terlalu besar: pelatihan tidak stabil, loss berfluktuasi. Terlalu kecil: konvergensi lambat. Laju optimal memungkinkan konvergensi cepat dan stabil.

num_train_epochs

Jumlah iterasi pelatihan terhadap seluruh dataset.

Terlalu sedikit: underfitting. Terlalu banyak: overfitting. Tambahkan untuk dataset kecil. Laju pembelajaran yang lebih kecil memerlukan lebih banyak epoch.

per_device_train_batch_size

Jumlah sampel yang diproses per GPU per iterasi.

Batch yang lebih besar meningkatkan kecepatan tetapi memerlukan lebih banyak VRAM. Gunakan nilai maksimum tanpa overflow. Periksa Memori GPU di halaman detail pelatihan.

gradient_accumulation_steps

Jumlah batch sebelum pembaruan gradien.

Mengurangi varians gradien dari batch kecil. Harus merupakan kelipatan jumlah GPU.

max_length

Panjang maksimum token input per sesi pelatihan.

Gunakan tool estimasi token untuk menghitung panjang teks setelah Tokenisasi.

lora_rank

Dimensi adapter LoRA.

lora_alpha

Faktor penskalaan LoRA.

Umumnya diatur ke lora_rank × 2.

lora_dropout

Laju dropout untuk mencegah overfitting.

lorap_lr_ratio

Rasio tingkat pembelajaran LoRA+ (λ = ηB/ηA) untuk matriks adapter A dan B.

LoRA+ menggunakan tingkat pembelajaran berbeda untuk fine-tuning lebih cepat. Atur ke 0 untuk LoRA standar.

Pengaturan Lanjutan

Parameter tambahan dalam format `--key1 value1 --key2 value2`. Biarkan kosong jika tidak diperlukan.

`save_strategy`: Kebijakan penyimpanan model. Nilai: `steps`, `epoch`, `no`. Default: `steps`.

`save_steps`: Interval penyimpanan. Default: 500.

`save_total_limit`: Jumlah maksimum checkpoint yang disimpan. Yang lebih lama akan dihapus. Default: 2. Atur ke `None` untuk menyimpan semua.

`warmup_ratio`: Proporsi pemanasan tingkat pembelajaran. Default: 0.

Klik Train untuk memulai. Lihat status tugas dan log. Setelah pelatihan selesai, terapkan model sebagai layanan online.

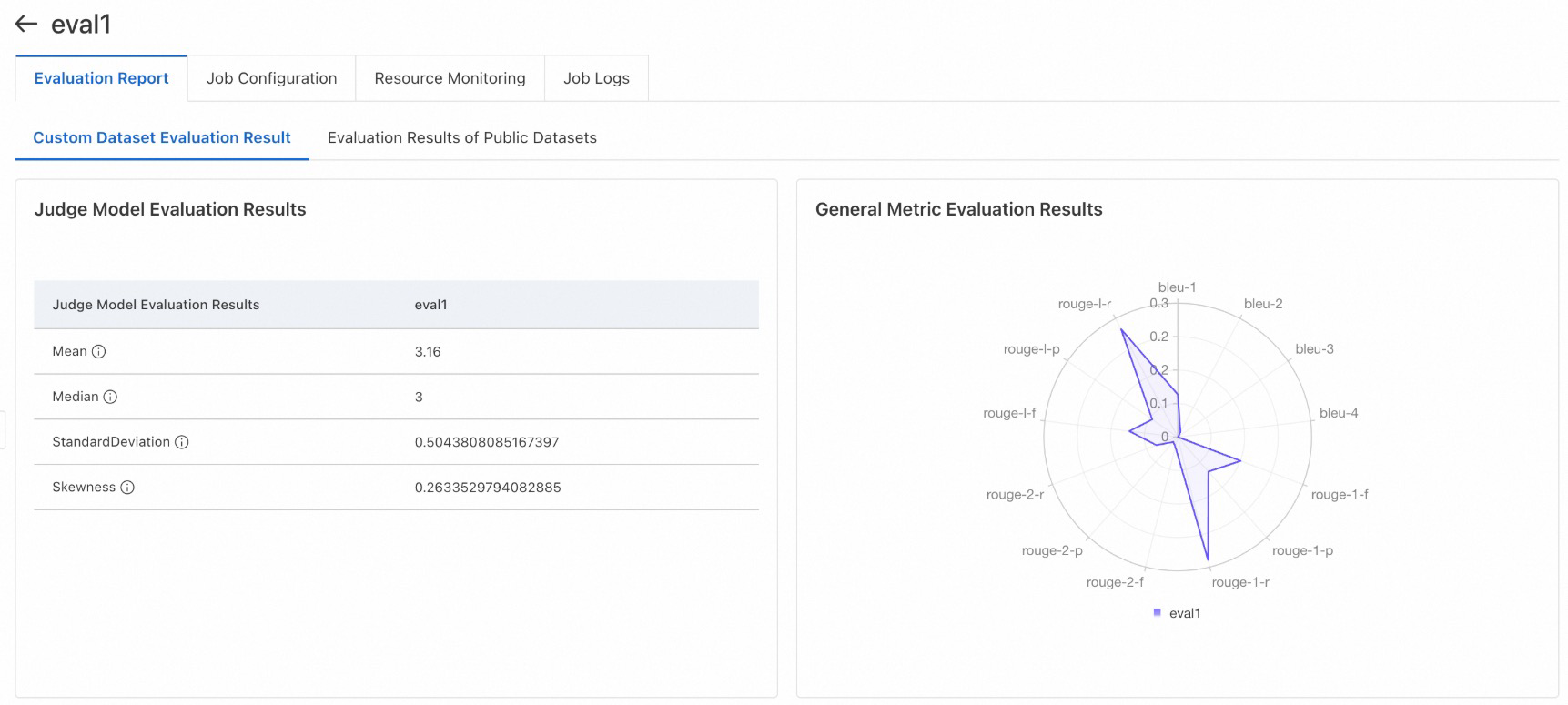

Evaluasi model

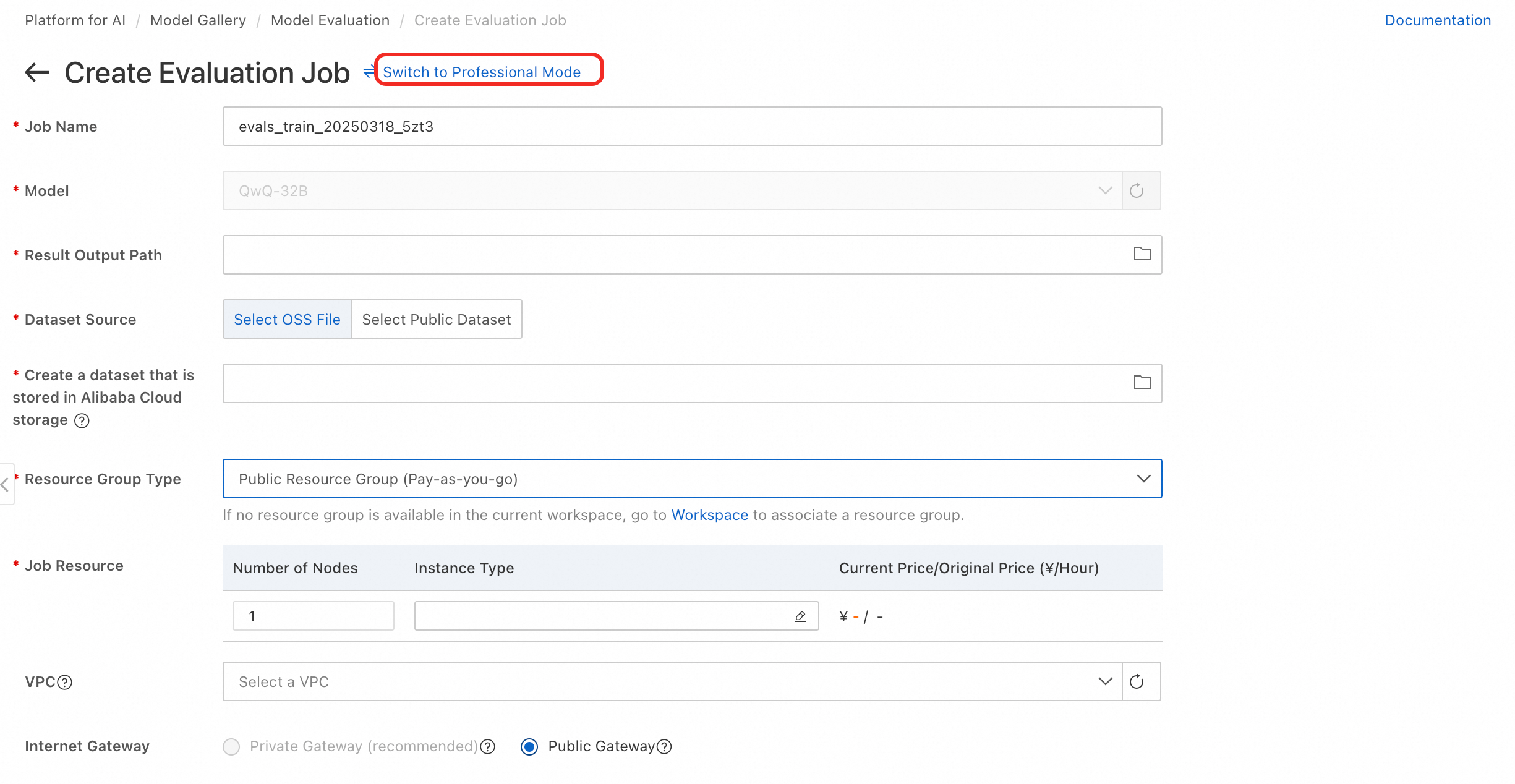

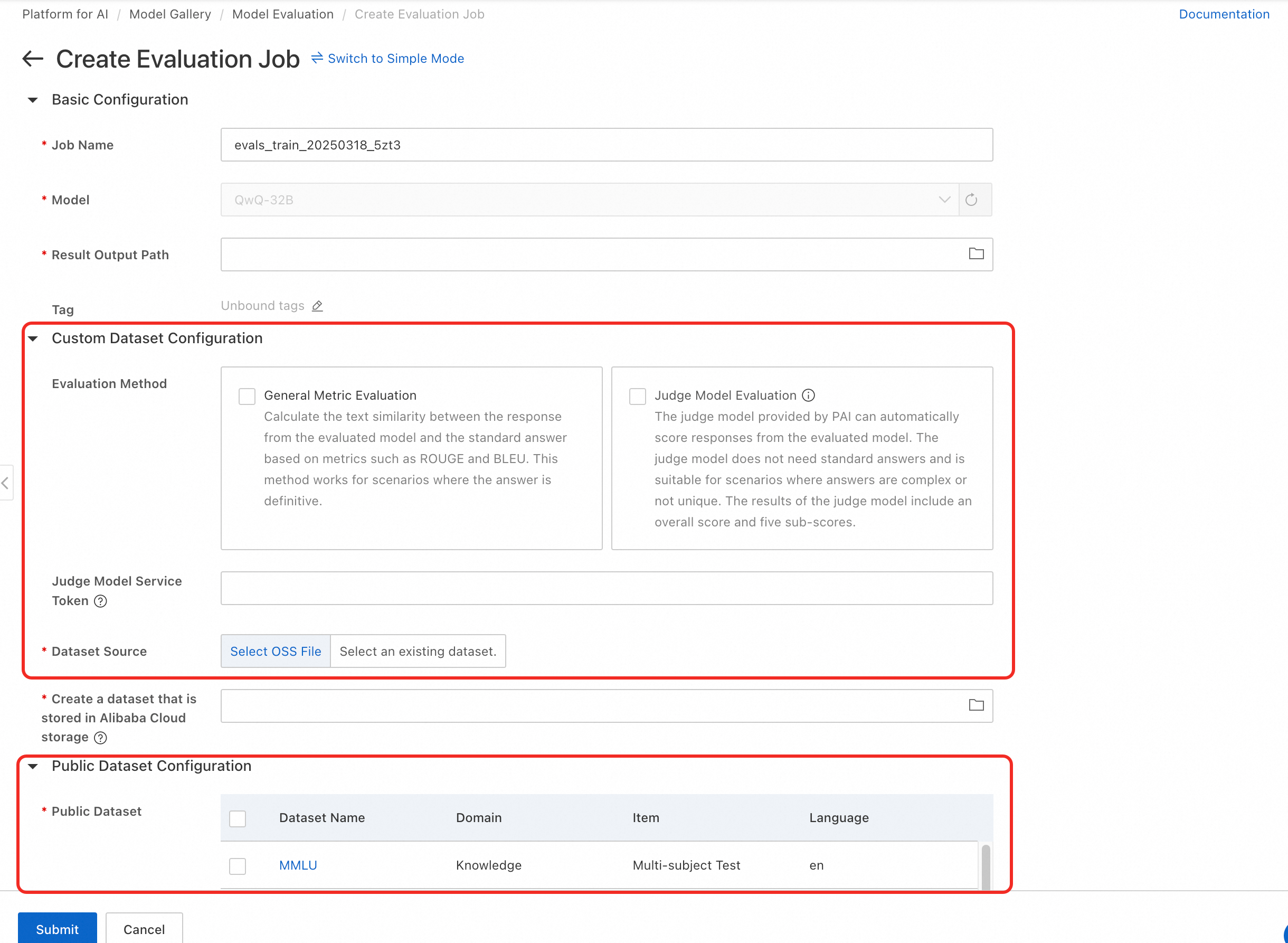

PAI-Model Gallery menyediakan algoritma evaluasi bawaan untuk model pre-trained dan hasil fine-tuning. Bandingkan beberapa model untuk memilih yang paling sesuai.

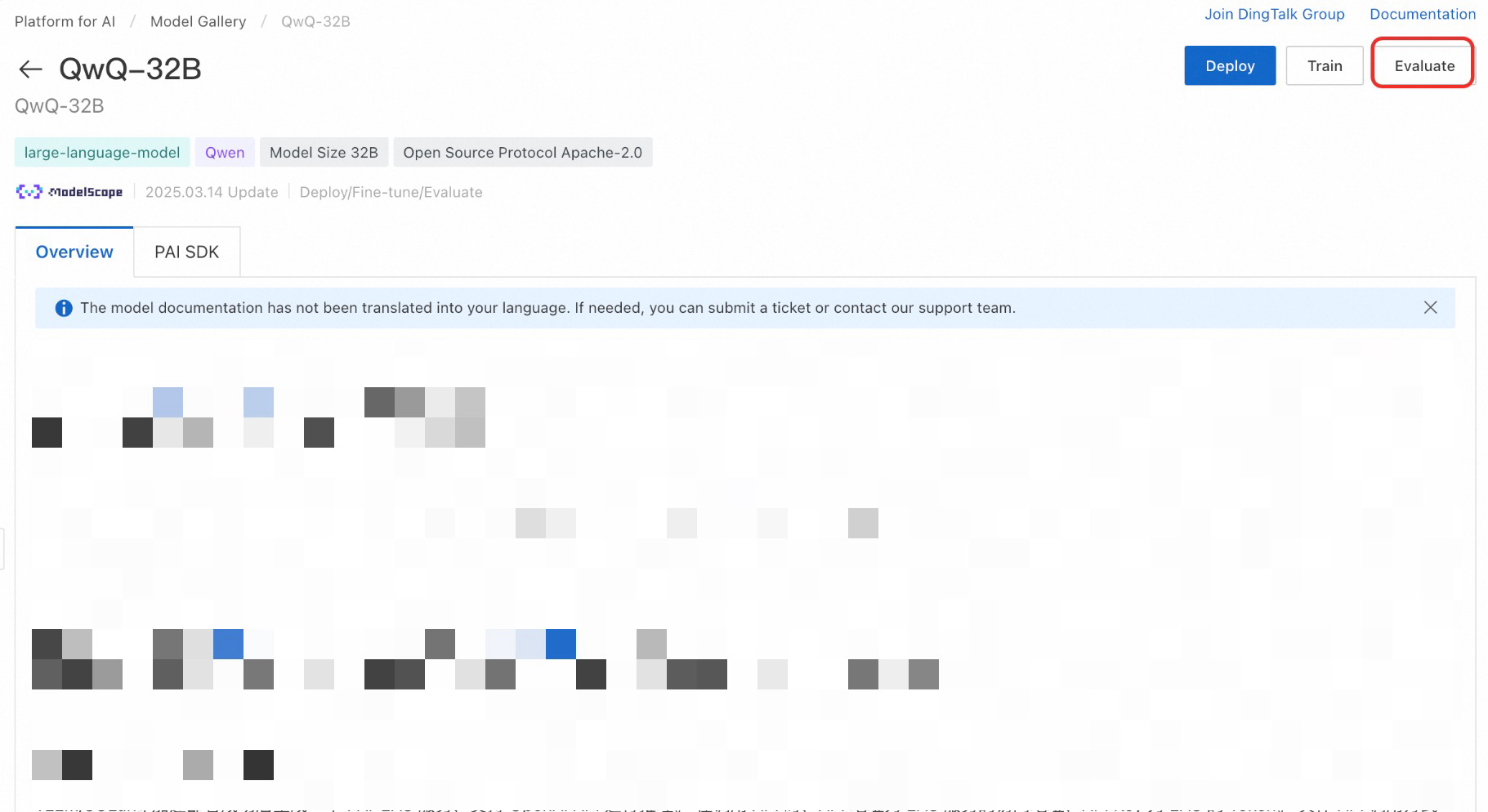

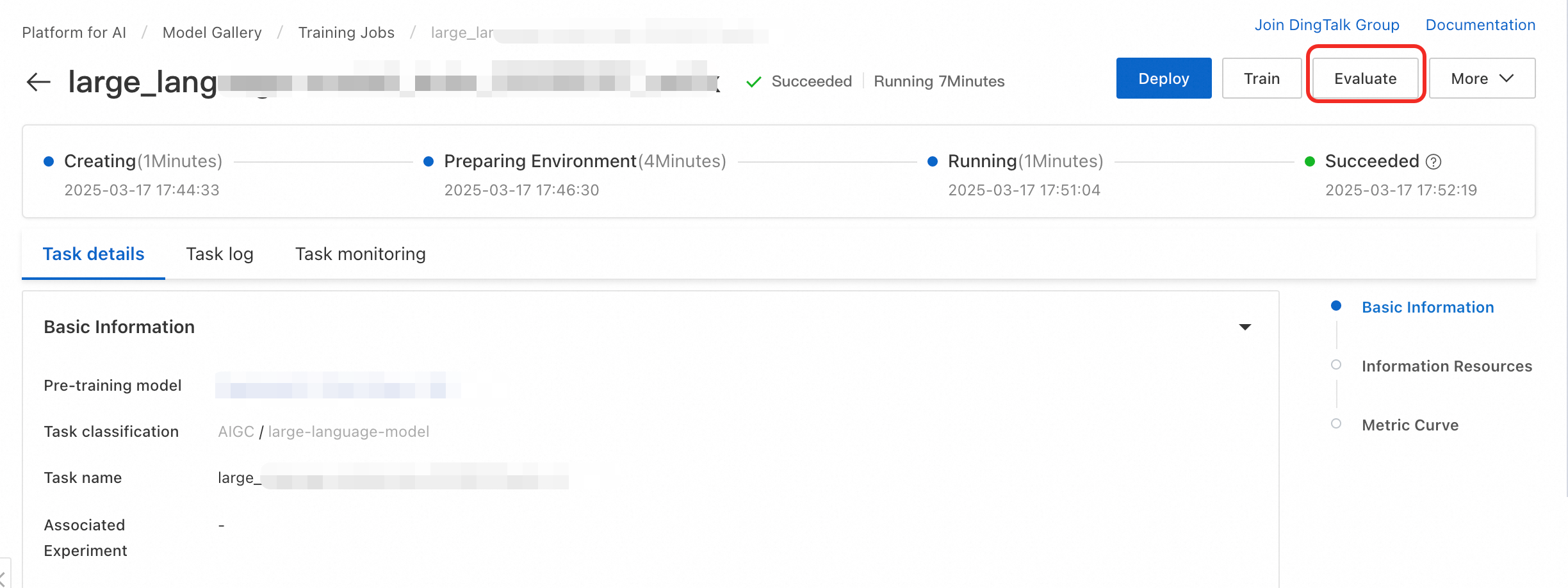

Titik masuk evaluasi:

Model pre-trained (dari kartu model) |

|

Model hasil fine-tuning (dari detail tugas pelatihan) |

|

Mendukung evaluasi menggunakan dataset publik dan kustom:

Dataset Kustom

Mendukung metrik BLEU/ROUGE dan LLM-as-a-Judge (hanya pada Expert Mode). Evaluasi apakah model sesuai dengan skenario Anda. Sediakan file JSONL dengan kolom `question` dan `answer`. Contoh: evaluation_test.jsonl.

Dataset Publik

PAI menyediakan dataset: CMMLU, GSM8K, TriviaQA, MMLU, C-Eval, TruthfulQA, dan HellaSwag (matematika, pengetahuan, penalaran). **Catatan:** Evaluasi GSM8K, TriviaQA, dan HellaSwag memerlukan waktu lebih lama.

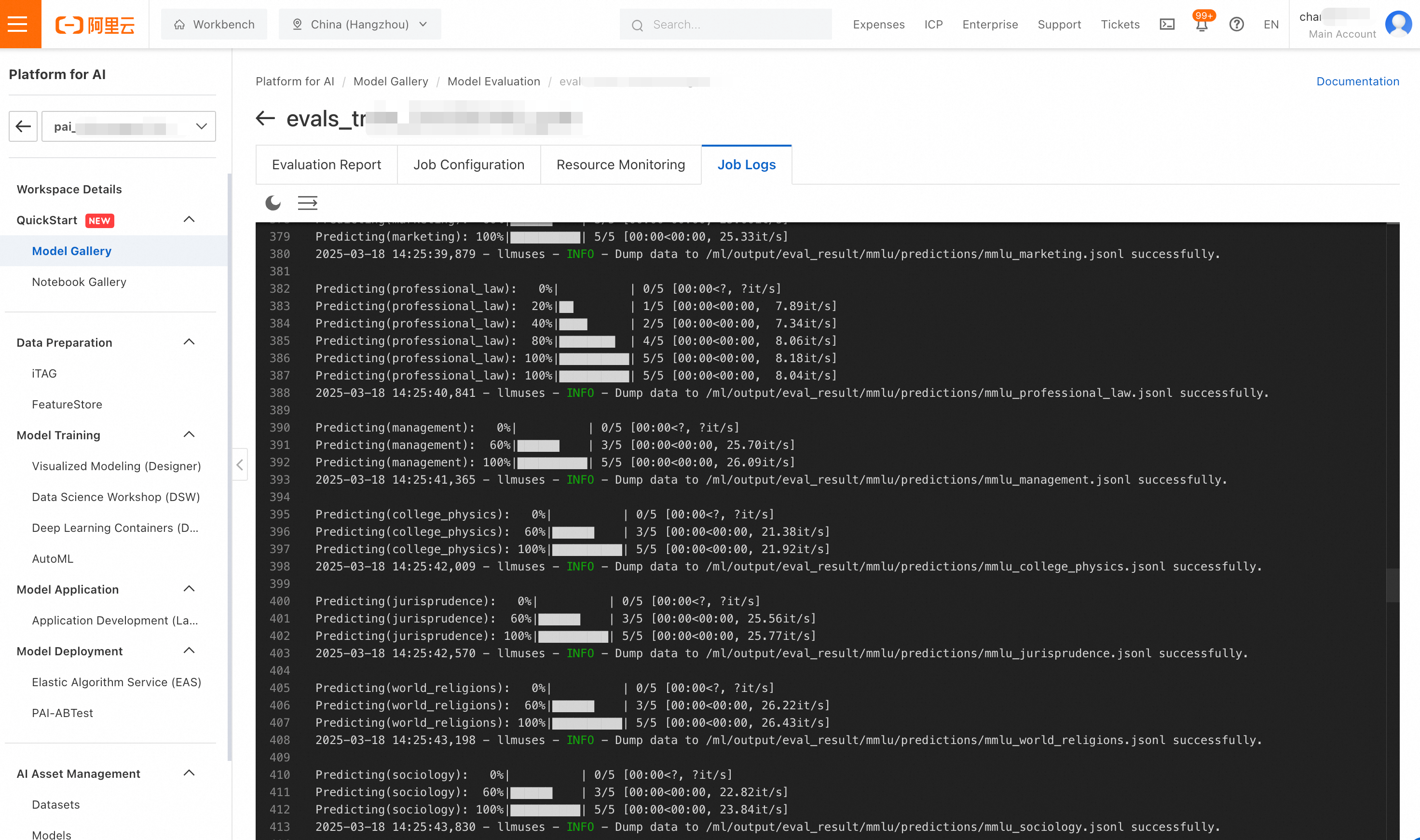

Pilih jalur output, pilih sumber daya komputasi, lalu kirim. Lihat hasil di halaman tugas. Beberapa dataset dijalankan secara berurutan; periksa log untuk memantau progres.

Contoh hasil evaluasi:

Hubungi kami

PAI-Model Gallery terus menambahkan model SOTA. Untuk permintaan model, bergabunglah dengan grup pengguna PAI-Model Gallery di DingTalk: 79680024618.