Komponen Pemrosesan Data LLM memungkinkan Anda mengedit, mentransformasi, menyaring, dan menghapus duplikat sampel data. Anda dapat menggabungkan berbagai komponen sesuai kebutuhan untuk memilih data berkualitas tinggi dan menghasilkan teks yang sesuai dengan kebutuhan Anda. Ini memberikan data berkualitas untuk pelatihan model bahasa besar (LLM). Topik ini menggunakan sejumlah kecil data dari dataset RedPajama Wikipedia sumber terbuka sebagai contoh untuk menunjukkan cara menggunakan komponen pemrosesan data model besar PAI dalam membersihkan dan memproses data Wikipedia.

Deskripsi Dataset

Template preset "Pemrosesan Data LLM-Wikipedia (data teks web)" di Machine Learning Designer menggunakan dataset 5.000 sampel yang diekstraksi dari data mentah proyek RedPajama sumber terbuka.

Buat dan jalankan alur kerja

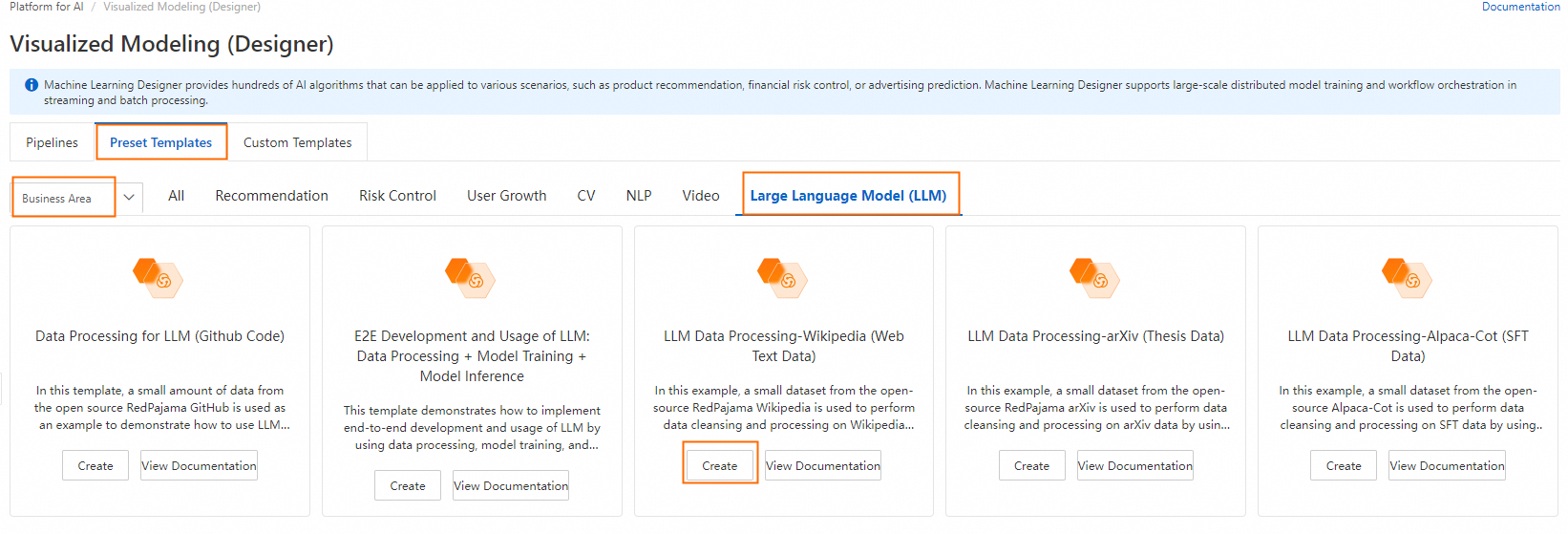

Buka halaman Machine Learning Designer.

Masuk ke Konsol PAI.

Di pojok kiri atas, pilih Wilayah sesuai kebutuhan.

Di panel navigasi sebelah kiri, klik Workspace Management. Pada halaman yang muncul, klik nama ruang kerja yang ingin digunakan.

Di panel navigasi sebelah kiri, pilih Model Development And Training > Machine Learning Designer.

Buat alur kerja.

Di tab Preset Templates, pilih Business Domain > Large Language Model. Pada kartu template LLM Data Processing-Wikipedia (web Text Data), klik Create.

Konfigurasikan parameter alur kerja atau pertahankan pengaturan default, lalu klik OK.

Dalam daftar alur kerja, pilih alur kerja yang telah dibuat dan klik Enter Workflow.

Deskripsi alur kerja:

Tabel berikut menjelaskan komponen algoritma utama dalam alur kerja:

LLM-Sensitive Content Mask (MaxCompute)-1

Menyamarkan informasi sensitif di bidang "text". Contohnya:

Mengganti alamat email dengan

[EMAIL].Mengganti nomor telepon dengan

[TELEPHONE]atau[MOBILEPHONE].Mengganti nomor KTP dengan

IDNUM.

LLM-Clean Special Content (MaxCompute)-1

Menghapus URL dari bidang "text".

LLM-Text Normalizer (MaxCompute)-1

Menormalkan teks di bidang "text" ke format Unicode dan mengonversi karakter Cina tradisional menjadi karakter Cina sederhana.

LLM-Count Filter (MaxCompute)-1

Menghapus sampel dari bidang "text" yang tidak memenuhi jumlah atau rasio karakter alfanumerik yang diperlukan. Sebagian besar karakter dalam dataset Wikipedia adalah huruf dan angka. Komponen ini dapat menghapus beberapa data kotor.

LLM-Length Filter (MaxCompute)-1

Menyaring sampel berdasarkan panjang garis rata-rata di bidang "text". Baris dibagi oleh karakter line feed

\n.LLM-N-Gram Repetition Filter (MaxCompute)-1

Menyaring sampel berdasarkan laju pengulangan N-gram pada tingkat karakter di bidang "text". Teks diproses menggunakan jendela geser berukuran N karakter untuk membentuk urutan segmen N-karakter. Setiap segmen disebut gram. Komponen menghitung kemunculan setiap gram. Laju pengulangan dihitung sebagai

total hitungan gram yang muncul lebih dari sekali / total hitungan semua gram. Sampel disaring berdasarkan laju ini.LLM-Sensitive Keywords Filter (MaxCompute)-1

Menggunakan file kata sensitif bawaan sistem untuk menyaring sampel di bidang "text" yang mengandung kata sensitif.

LLM-Language Recognition and Filter (MaxCompute)-1

Menghitung tingkat kepercayaan teks di bidang "text" dan menyaring sampel berdasarkan ambang batas kepercayaan yang dikonfigurasi.

LLM-Length Filter (MaxCompute)-2

Menyaring sampel berdasarkan panjang maksimum baris di bidang "text". Baris dibagi oleh karakter line feed

\n.LLM-Perplexity Filter (MaxCompute)-1

Menghitung perplexity teks di bidang "text" dan menyaring sampel berdasarkan ambang batas perplexity yang dikonfigurasi.

LLM-Special Characters Ratio Filter (MaxCompute)-1

Menghapus sampel dari bidang "text" yang tidak memenuhi rasio karakter khusus yang diperlukan.

LLM-Length Filter (MaxCompute)-3

Menyaring sampel berdasarkan panjang bidang "text".

LLM-Tokenization (MaxCompute)-1

Memotong teks di bidang "text" dan menyimpan hasilnya ke kolom baru.

LLM-Length Filter (MaxCompute)-4

Memisahkan sampel di bidang "text" menjadi daftar kata menggunakan karakter spasi

" "sebagai pemisah. Kemudian menyaring sampel berdasarkan panjang daftar yang dihasilkan, yang berarti penyaringan berdasarkan jumlah kata.LLM-N-Gram Repetition Filter (MaxCompute)-2

Menyaring sampel berdasarkan laju pengulangan N-gram pada tingkat kata di bidang "text". Semua kata pertama-tama dikonversi ke huruf kecil untuk menghitung laju pengulangan. Teks diproses menggunakan jendela geser berukuran N kata untuk membentuk urutan segmen N-kata. Setiap segmen disebut gram. Komponen menghitung kemunculan setiap gram. Laju pengulangan dihitung sebagai

total hitungan gram yang muncul lebih dari sekali / total hitungan semua gram. Sampel disaring berdasarkan laju ini.LLM-MinHash Deduplicator (MaxCompute)-1

Menghapus sampel serupa berdasarkan algoritma MinHash.

Jalankan alur kerja.

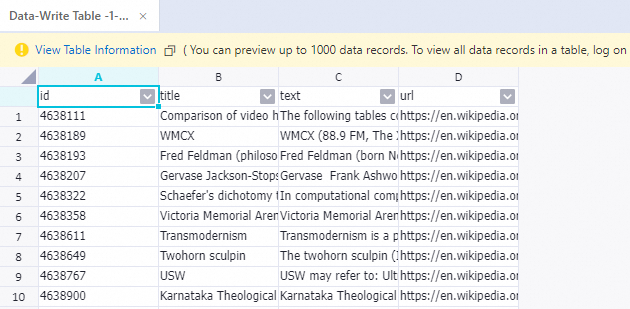

Setelah proses selesai, klik kanan komponen Write To Data Table-1 dan pilih View Data > Outputs untuk melihat sampel yang diproses oleh komponen sebelumnya.

Referensi

Untuk informasi lebih lanjut tentang komponen algoritma LLM, lihat Pemrosesan Data LLM (MaxCompute).