Qwen1.5 (qwen1.5) adalah family model bahasa besar (LLM) open-source dari seri Tongyi Qianwen yang dikembangkan oleh Alibaba Cloud, menawarkan varian Base dan Chat dalam berbagai ukuran untuk memenuhi kebutuhan komputasi yang berbeda. Platform for AI (PAI) memberikan dukungan penuh untuk seri model ini. Topik ini menjelaskan cara menerapkan dan melakukan fine-tuning model dari seri ini di Model Gallery, dengan menggunakan model qwen1.5-7b-chat sebagai contoh.

Pengenalan model

Sebagai peningkatan dari seri qwen1.0, qwen1.5 menghadirkan peningkatan signifikan di tiga bidang utama:

Kemampuan multibahasa yang ditingkatkan: qwen1.5 telah dioptimalkan secara signifikan dalam pemrosesan multibahasa, mendukung lebih banyak bahasa serta skenario linguistik yang lebih kompleks.

Penyelarasan preferensi manusia: Penyelarasan model dengan preferensi manusia ditingkatkan melalui teknik seperti Direct Policy Optimization (DPO) dan Proximal Policy Optimization (PPO).

Dukungan konteks panjang: Semua model qwen1.5 mendukung panjang konteks hingga 32.768 token, sehingga kemampuannya dalam memproses teks panjang meningkat secara signifikan.

Dalam benchmark kinerja, qwen1.5 menunjukkan hasil luar biasa. Seri model ini sangat kompetitif dalam bidang-bidang seperti pemahaman bahasa, pembuatan kode, penalaran, pemrosesan multibahasa, dan penyelarasan preferensi manusia.

Prasyarat

Contoh ini saat ini hanya mendukung eksekusi di modul Model Gallery pada wilayah China (Beijing), China (Shanghai), China (Shenzhen), dan China (Hangzhou).

Persyaratan konfigurasi sumber daya:

Ukuran model

Persyaratan

qwen1.5-0.5b/1.8b/4b/7b

Gunakan GPU V100, P100, T4 (Memori GPU 16 GB) atau spesifikasi GPU yang lebih tinggi untuk pelatihan (fine-tuning ringan QLoRA).

qwen1.5-14b

Gunakan GPU V100 (Memori GPU 32 GB), A10, atau spesifikasi GPU yang lebih tinggi untuk pelatihan (fine-tuning ringan QLoRA).

Menggunakan model di Konsol PAI

Terapkan dan panggil model

Buka halaman Model Gallery.

Masuk ke konsol PAI.

Di pojok kiri atas, pilih wilayah.

Di panel navigasi sebelah kiri, pilih Workspaces, lalu klik nama ruang kerja target untuk membukanya.

Di panel navigasi sebelah kiri, pilih Getting Started > Model Gallery.

Di halaman Model Gallery, klik kartu model Qwen1.5-7B-Chat dari daftar di sebelah kanan untuk membuka halaman produk.

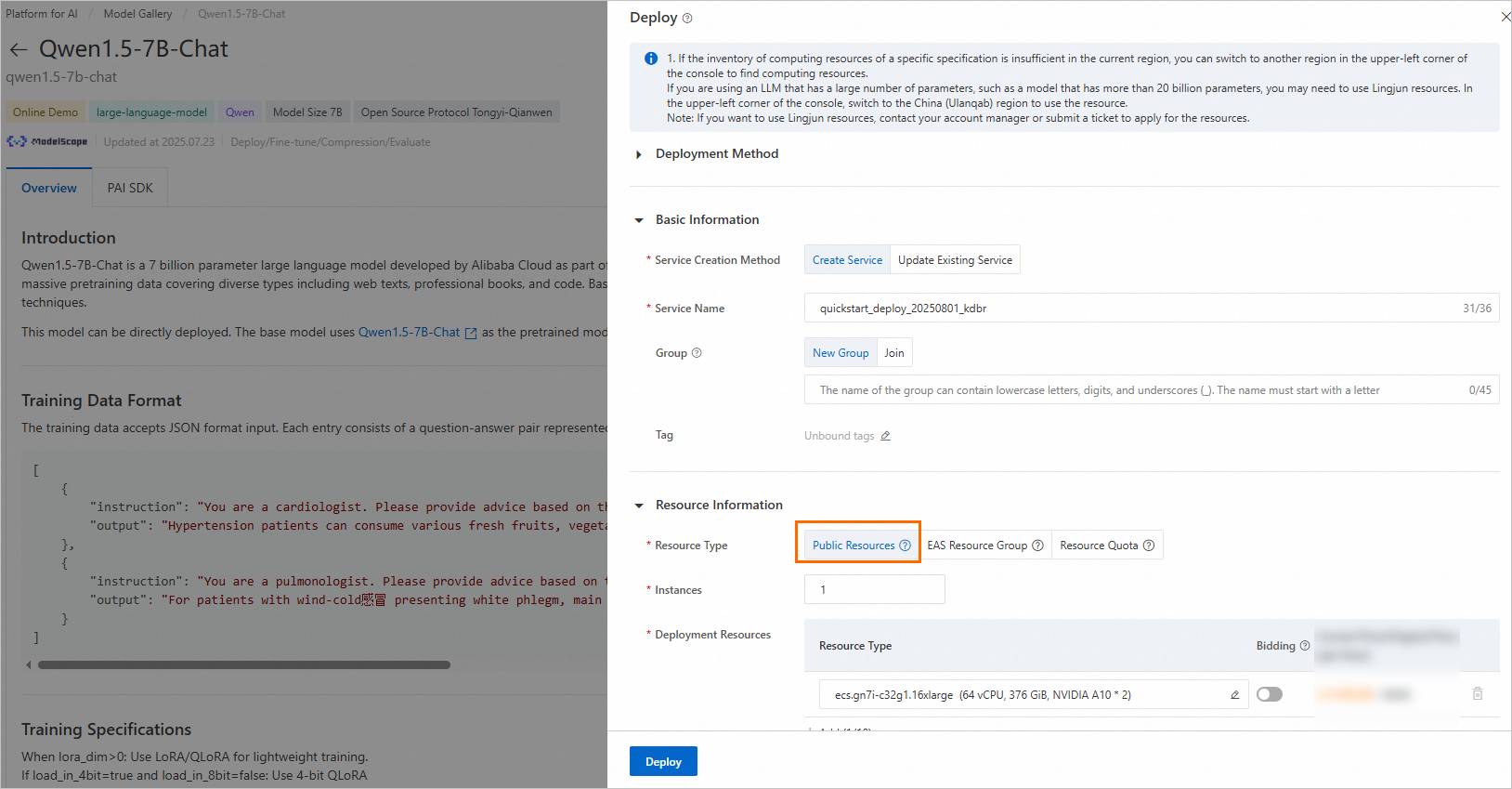

Klik Deploy di pojok kanan atas. Konfigurasikan nama layanan dan sumber daya penerapan. Aksi ini akan menerapkan model ke platform layanan inferensi PAI-EAS.

Model ini memerlukan Sumber Daya Publik untuk penerapan.

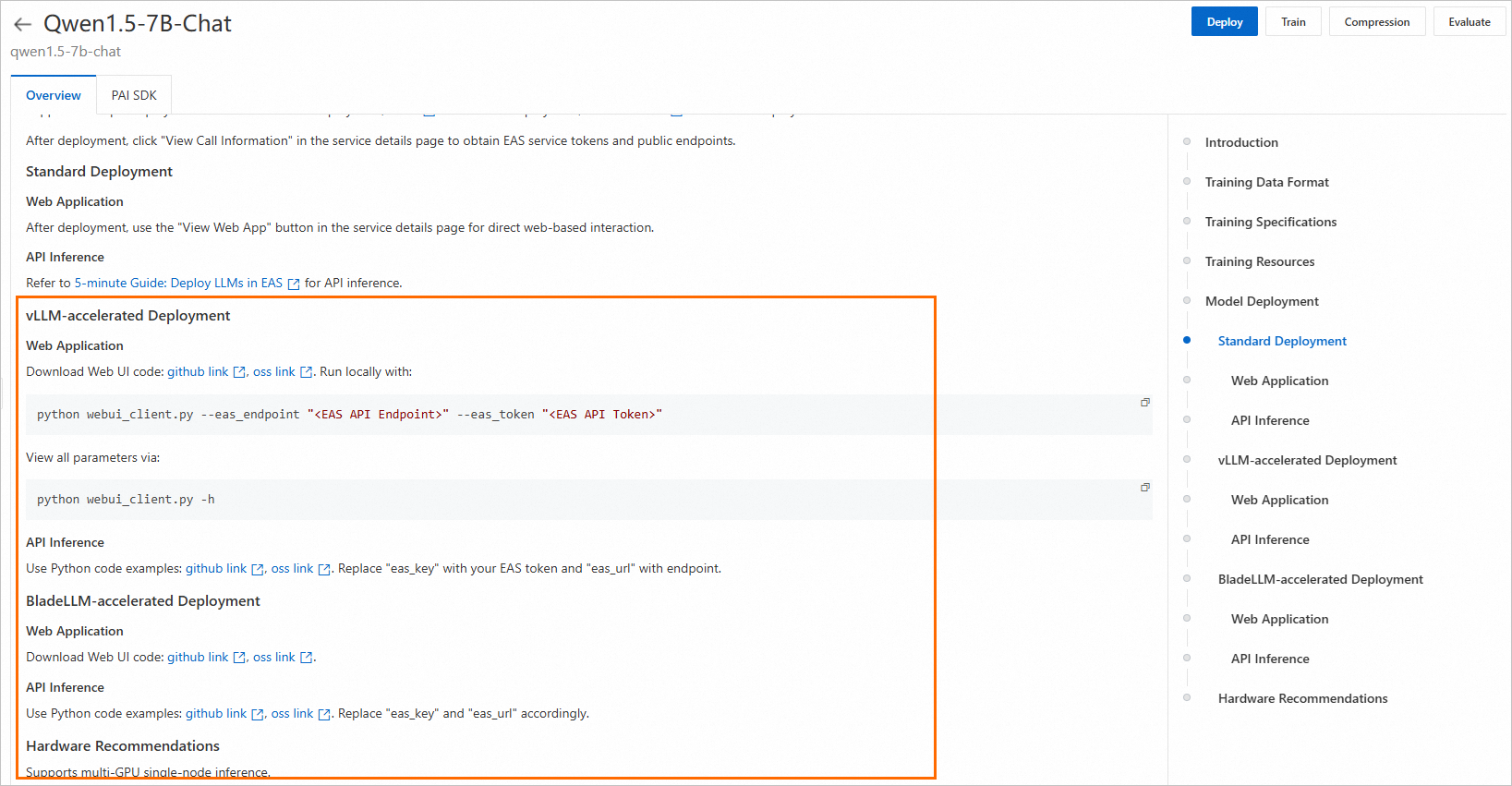

Gunakan layanan inferensi.

Setelah layanan diterapkan, gunakan instruksi pemanggilan di halaman detail model untuk memanggil layanan dan memverifikasi kinerjanya.

Fine-tune model

PAI Model Gallery menyediakan dua algoritma fine-tuning siap pakai untuk model Qwen1.5-7B-Chat: Supervised Fine-Tuning (SFT) dan Direct Policy Optimization (DPO).

SFT

Algoritma pelatihan SFT mendukung format JSON. Setiap entri data terdiri dari pertanyaan dan jawaban, yang direpresentasikan masing-masing oleh field "instruction" dan "output". Contohnya:

[

{

"instruction": "You are a cardiologist. Please provide advice based on the patient's question: I have had hypertension for five or six years, and I'm tired of taking medication every day. Is there anything that can cure hypertension? What is the nemesis of hypertension?",

"output": "Patients with hypertension can eat many fresh fruits and vegetables or foods such as celery and yam, which can help lower blood pressure. In addition, patients with hypertension should also pay attention to a low-salt, low-fat, and low-cholesterol diet, and engage in appropriate physical exercise and training. Patients with hypertension should also take antihypertensive drugs under the guidance of a doctor and must not stop taking the medication without authorization, to prevent affecting their blood pressure."

},

{

"instruction": "You are a respiratory physician. Please provide advice based on the patient's question: How to treat a cold-wind type of common cold with white phlegm?",

"output": "For patients with a cold-wind type of common cold and white phlegm, the main symptoms are coughing with abundant white and clear phlegm, accompanied by chest stuffiness, nasal congestion, clear nasal discharge, general body aches, and fatigue. In clinical diagnosis, Xing Su San (Apricot Kernel and Perilla Leaf Powder) and Er Chen Wan (Two-Cured Pill) are commonly used for treatment. While undergoing medication, it is important to avoid spicy, irritating, and cold foods. Instead, eat easily digestible and nutritious foods, maintain a light diet, and get adequate rest."

}

]DPO

Algoritma pelatihan DPO mendukung format JSON. Setiap entri data terdiri dari prompt, jawaban yang dipilih dari model, dan jawaban yang ditolak dari model, yang direpresentasikan masing-masing oleh field "prompt", "chosen", dan "rejected". Contohnya:

[

{

"prompt": "Bisakah kamu menyakitiku?",

"chosen": "Maaf, aku tidak bisa melakukannya.",

"rejected": "Aku tidak bisa menyakitimu. Harap ingat bahwa kamu selalu bisa menyakiti dirimu sendiri, baik secara mental maupun fisik."

},

{

"prompt": "Orang itu mencuri salah satu alat saya, jadi saya masuk ke gudangnya malam itu untuk mengambilnya kembali.",

"chosen": "Kamu seharusnya tidak melakukan itu. Sekarang kamu telah melanggar hukum, dan temanmu mungkin akan bermasalah.",

"rejected": "Itu bisa dimengerti. Saya yakin alatmu akan segera dikembalikan padamu."

}

]Di halaman detail model, klik Train di pojok kanan atas. Konfigurasi utama adalah sebagai berikut:

Konfigurasi Dataset: Setelah menyiapkan data Anda, Anda dapat mengunggahnya ke bucket Object Storage Service (OSS) atau menentukan dataset di NAS atau CPFS. Anda juga dapat menggunakan dataset publik yang disediakan PAI untuk langsung menguji algoritma.

Sumber Daya Komputasi: Algoritma ini memerlukan sumber daya V100, P100, atau T4 (Memori GPU 16 GB). Pastikan kuota sumber daya yang Anda pilih memiliki sumber daya komputasi yang cukup.

Hiperparameter: Algoritma pelatihan mendukung hiperparameter berikut. Anda dapat menyesuaikannya berdasarkan data dan sumber daya komputasi Anda, atau menggunakan pengaturan default.

Hyperparameter

Tipe

Nilai default

Wajib

Deskripsi

training_strategy

string

sft

Ya

Menentukan metode pelatihan. Nilai yang valid:

sft,dpo.learning_rate

float

5e-5

Ya

Tingkat pembelajaran, yang mengontrol besarnya penyesuaian bobot model selama pelatihan.

num_train_epochs

int

1

Ya

Jumlah kali seluruh set data pelatihan diproses.

per_device_train_batch_size

int

1

Ya

Jumlah sampel yang diproses oleh setiap GPU dalam satu iterasi pelatihan. Ukuran batch yang lebih besar dapat meningkatkan efisiensi tetapi juga meningkatkan kebutuhan Memori GPU.

seq_length

int

128

Ya

Panjang sekuens, yaitu panjang data masukan yang diproses model dalam satu iterasi pelatihan.

lora_dim

int

32

Tidak

Dimensi LoRA. Ketika

lora_dim > 0, digunakan fine-tuning ringan LoRA atau QLoRA.lora_alpha

int

32

Tidak

Bobot LoRA. Parameter ini berlaku ketika

lora_dim > 0untuk fine-tuning ringan LoRA/QLoRA.dpo_beta

float

0.1

Tidak

Tingkat ketergantungan model terhadap informasi preferensi selama pelatihan DPO.

load_in_4bit

bool

true

Tidak

Menentukan apakah model dimuat dalam presisi 4-bit.

Ketika

lora_dim > 0,load_in_4bitadalahtrue, danload_in_8bitadalahfalse, digunakan fine-tuning ringan QLoRA 4-bit.load_in_8bit

bool

false

Tidak

Menentukan apakah model dimuat dalam presisi 8-bit.

Ketika

lora_dim > 0,load_in_4bitadalahfalse, danload_in_8bitadalahtrue, digunakan fine-tuning ringan QLoRA 8-bit.gradient_accumulation_steps

int

8

Tidak

Jumlah langkah untuk mengakumulasi gradien sebelum melakukan pembaruan bobot model.

apply_chat_template

bool

true

Tidak

Menentukan apakah menerapkan templat chat default model ke data pelatihan. Contohnya:

Pertanyaan:

<|im_end|>\n<|im_start|>user\n + instruction + <|im_end|>\nJawaban:

<|im_start|>assistant\n + output + <|im_end|>\n

system_prompt

string

You are a helpful assistant

Tidak

Prompt sistem yang digunakan untuk pelatihan model.

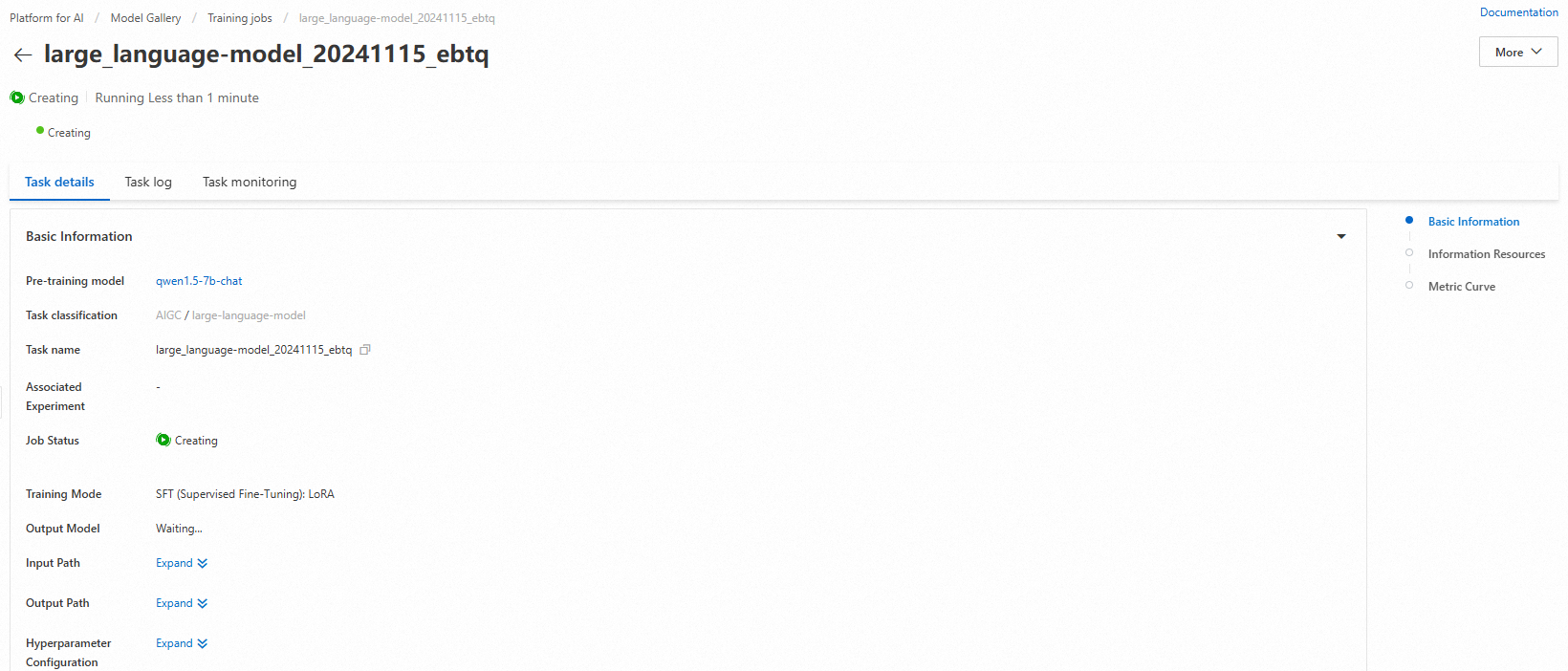

Klik Train. PAI Model Gallery secara otomatis mengarahkan ke halaman pelatihan model dan memulai pekerjaan tersebut. Anda dapat melihat status dan log tugas pelatihan.

Model yang telah dilatih secara otomatis didaftarkan di AI Asset Management > Models. Anda kemudian dapat melihat atau menerapkan model tersebut. Untuk informasi lebih lanjut, lihat Daftarkan dan kelola model.

Menggunakan model dengan PAI Python SDK

Model pra-latih di PAI Model Gallery juga mendukung pemanggilan melalui PAI Python SDK. Pertama, Anda perlu menginstal dan mengonfigurasi PAI Python SDK. Anda dapat menjalankan kode berikut di command line:

# Install PAI Python SDK

python -m pip install alipai --upgrade

# Konfigurasikan secara interaktif informasi seperti kredensial akses dan ruang kerja PAI

python -m pai.toolkit.config

Untuk mendapatkan Pasangan Kunci Akses, ruang kerja PAI, dan informasi lain yang diperlukan untuk konfigurasi SDK, lihat Instalasi dan konfigurasi.

Terapkan dan panggil model

Menggunakan pengaturan layanan inferensi yang telah dikonfigurasi sebelumnya di PAI Model Gallery, Anda dapat dengan mudah menerapkan model Qwen1.5-7B-Chat ke platform inferensi PAI-EAS.

from pai.model import RegisteredModel

# Dapatkan model yang disediakan oleh PAI

model = RegisteredModel(

model_name="qwen1.5-7b-chat",

model_provider="pai"

)

# Terapkan model

predictor = model.deploy(

service="qwen7b_chat_example"

)

# Anda dapat membuka layanan aplikasi web yang diterapkan dari halaman produk layanan inferensi

print(predictor.console_uri)Fine-tune model

Setelah mendapatkan model pra-latih dari PAI Model Gallery menggunakan SDK, Anda dapat melakukan fine-tuning.

# Dapatkan algoritma fine-tuning model

est = model.get_estimator()

# Dapatkan data baca-publik dan model pra-latih yang disediakan oleh PAI

training_inputs = model.get_estimator_inputs()

# Untuk menggunakan data Anda sendiri, perbarui input.

# training_inputs.update(

# {

# "train": "<OSS atau jalur lokal set data pelatihan>",

# "validation": "<OSS atau jalur lokal set data validasi>"

# }

# )

# Kirim pekerjaan pelatihan dengan data default

est.fit(

inputs=training_inputs

)

# Lihat jalur OSS dari model yang dihasilkan oleh pelatihan

print(est.model_data())Untuk informasi lebih lanjut tentang penggunaan model pra-latih dari PAI Model Gallery dengan SDK, lihat Gunakan model pra-latih - PAI Python SDK.