EMR Serverless Spark mendukung pengembangan interaktif menggunakan notebook. Topik ini menjelaskan cara membuat dan menjalankan notebook.

Prasyarat

Anda memiliki Akun Alibaba Cloud. Untuk informasi selengkapnya, lihat Pendaftaran Akun Alibaba Cloud.

Peran yang diperlukan telah diberikan. Untuk informasi selengkapnya, lihat Memberikan peran ke Akun Alibaba Cloud.

Ruang kerja dan instans sesi notebook telah dibuat. Untuk informasi selengkapnya, lihat Membuat ruang kerja dan Mengelola sesi notebook.

Prosedur

Langkah 1: Siapkan file uji

Topik ini menyediakan file uji untuk membantu Anda memahami pekerjaan notebook. Anda dapat mengunduh file tersebut untuk digunakan dalam langkah-langkah berikut.

Klik employee.csv untuk mengunduh file uji.

File employee.csv berisi data nama karyawan, departemen, dan gaji.

Langkah 2: Unggah file uji coba

Unggah file data (employee.csv) ke Konsol Object Storage Service (OSS). Untuk informasi selengkapnya, lihat Mengunggah file.

Langkah 3: Kembangkan dan jalankan notebook

Pada halaman EMR Serverless Spark, klik Data Development di panel navigasi sebelah kiri.

Buat notebook.

Pada tab Development, klik ikon

.

.Pada kotak dialog yang muncul, masukkan nama, pilih sebagai Jenis, lalu klik OK.

Di pojok kanan atas, pilih instans sesi notebook yang sedang berjalan.

Anda juga dapat memilih Create Notebook Session dari daftar drop-down untuk membuat instans sesi notebook baru. Untuk informasi selengkapnya tentang sesi notebook, lihat Mengelola sesi notebook.

CatatanBeberapa notebook dapat berbagi satu instans sesi notebook. Hal ini memungkinkan Anda mengakses dan menggunakan sumber daya sesi yang sama dari beberapa notebook secara bersamaan tanpa perlu membuat instans sesi baru untuk setiap notebook.

Proses dan visualisasikan data.

Jalankan pekerjaan PySpark

Salin kode berikut ke sel Python pada notebook baru.

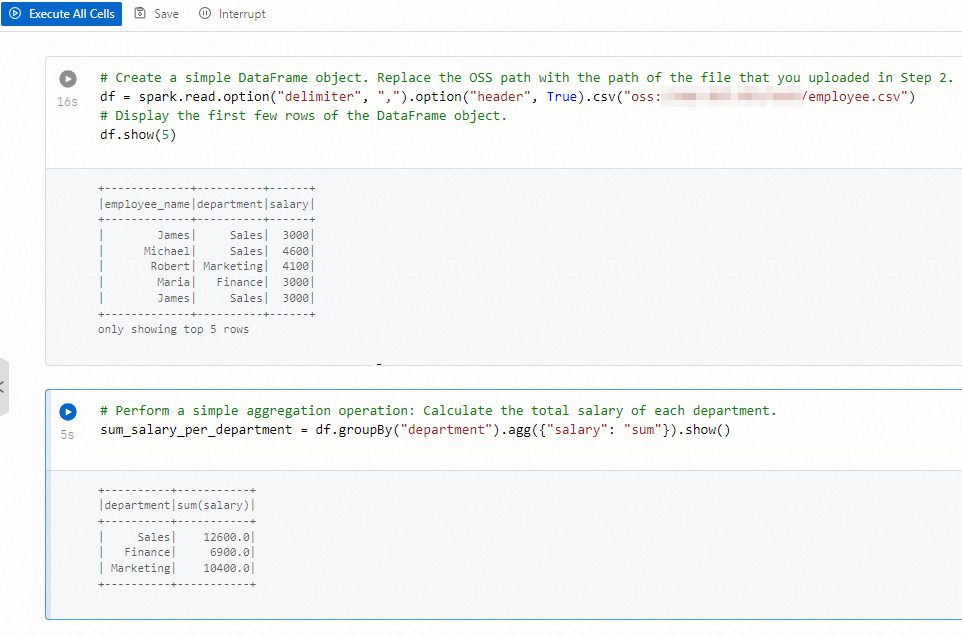

# Buat DataFrame sederhana. Ganti path OSS dengan path file yang Anda unggah di Langkah 2. df = spark.read.option("delimiter", ",").option("header", True).csv("oss://path/to/file") # Tampilkan beberapa baris pertama dari DataFrame. df.show(5) # Lakukan operasi agregasi sederhana untuk menghitung total gaji tiap departemen. sum_salary_per_department = df.groupBy("department").agg({"salary": "sum"}).show()Klik Run All Cells untuk menjalankan notebook.

Anda juga dapat menjalankan sel tertentu dengan mengklik ikon

di depan sel tersebut.

di depan sel tersebut.

(Opsional) Lihat Spark UI.

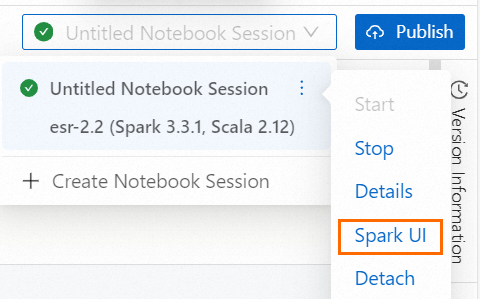

Pada daftar drop-down sesi, arahkan kursor ke ikon

untuk sesi notebook saat ini dan klik Spark UI. Anda akan diarahkan ke halaman Spark Jobs, tempat Anda dapat melihat informasi pekerjaan Spark.

untuk sesi notebook saat ini dan klik Spark UI. Anda akan diarahkan ke halaman Spark Jobs, tempat Anda dapat melihat informasi pekerjaan Spark.

Lakukan analitik visual menggunakan pustaka pihak ketiga

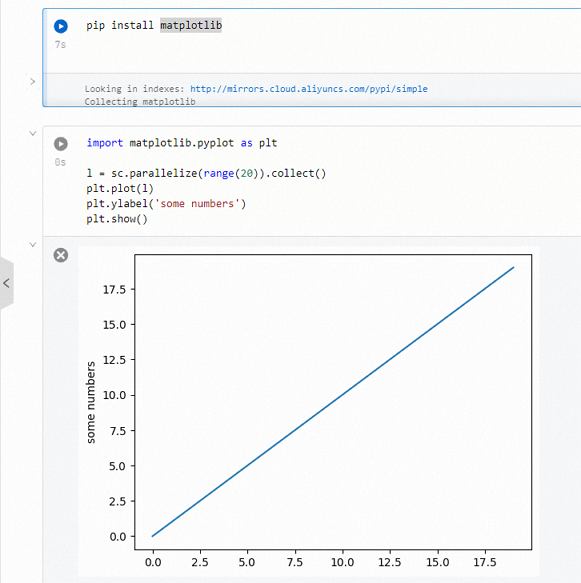

CatatanSesi notebook telah dilengkapi pustaka matplotlib, numpy, dan pandas secara pra-instal. Untuk informasi selengkapnya tentang cara menggunakan pustaka pihak ketiga lainnya, lihat Menggunakan pustaka Python pihak ketiga dalam notebook.

Gunakan pustaka matplotlib untuk memvisualisasikan data.

import matplotlib.pyplot as plt l = sc.parallelize(range(20)).collect() plt.plot(l) plt.ylabel('some numbers') plt.show()Klik Run All Cells untuk menjalankan notebook.

Anda juga dapat menjalankan sel tertentu dengan mengklik ikon

di depan sel tersebut.

di depan sel tersebut.

Langkah 4: Publikasikan notebook

Setelah notebook selesai dijalankan, klik Publish di pojok kanan atas.

Pada kotak dialog Publish, konfigurasikan parameter dan klik OK untuk menyimpan notebook sebagai versi baru.