Gunakan node E-MapReduce (EMR) Trino untuk melakukan agregasi data multidimensi skala besar atau analisis laporan.

Prasyarat

Anda telah membuat kluster Alibaba Cloud E-MapReduce (EMR) dan mendaftarkannya ke DataWorks. Untuk informasi selengkapnya, lihat Data Studio: Mengaitkan resource komputasi EMR.

(Opsional, wajib bagi pengguna RAM) Tambahkan pengguna Resource Access Management (RAM) yang bertanggung jawab atas pengembangan tugas ke Ruang Kerja dan berikan peran Developer atau Workspace Administrator. Peran Workspace Administrator memiliki izin yang luas, sehingga berikan dengan hati-hati. Untuk informasi selengkapnya tentang penambahan anggota, lihat Menambahkan anggota ke ruang kerja.

Jika Anda menggunakan akun Alibaba Cloud, Anda dapat melewati langkah ini.

Batasan

Anda hanya dapat menjalankan jenis node ini pada kelompok sumber daya Serverless.

Untuk mengelola metadata di DataWorks untuk DataLake atau kluster kustom, konfigurasikan EMR-HOOK pada kluster tersebut. Untuk informasi selengkapnya, lihat Mengonfigurasi EMR-HOOK untuk Hive.

CatatanJika EMR-HOOK tidak dikonfigurasi pada kluster, Anda tidak dapat melihat metadata secara real time, menghasilkan log audit, menampilkan alur data, atau menjalankan tugas tata kelola data terkait EMR di DataWorks.

Jika autentikasi LDAP diaktifkan untuk Trino, login ke node Master kluster EMR dan unduh file keystore dari direktori

/etc/taihao-apps/trino-conf. Login ke Konsol DataWorks. Pada bilah navigasi atas, alihkan ke wilayah target. Temukan ruang kerja Anda dan klik Manage di kolom Actions untuk masuk ke management center. Pada panel navigasi kiri, di bawah Compute Resources, temukan Account Mapping untuk kluster EMR Anda. Klik Edit Account Mapping di sebelah kanan. Pada halaman yang muncul, klik Upload Keystore File untuk mengunggah file tersebut.

Prosedur

Pada halaman edit node EMR Trino, ikuti langkah-langkah berikut untuk mengembangkan tugas Anda.

Konfigurasi konektor

Untuk mengkueri tabel di MySQL, konfigurasikan konektor EMR Trino bawaan. Untuk informasi selengkapnya, lihat Konektor MySQL.

Untuk mengkueri tabel di Hive, konfigurasikan konektor EMR Trino bawaan. Untuk informasi selengkapnya, lihat Konektor Hive.

Untuk mengkueri tabel di sumber data lain, lihat Mengonfigurasi konektor untuk petunjuk cara mengonfigurasi konektor bawaan.

Edit kode SQL

Tulis kode tugas Anda di editor SQL. Anda dapat mendefinisikan variabel dalam kode dengan menggunakan format

${variable_name}dan memberikan nilai pada bagian Scheduling Arguments di bawah Schedule pada sisi kanan halaman edit node. Hal ini memungkinkan Anda untuk secara dinamis pass parameter ke tugas terjadwal. Untuk informasi selengkapnya tentang penggunaan parameter penjadwalan, lihat Sumber dan ekspresi parameter penjadwalan. Kode berikut memberikan contoh.-- Penggunaan -- SELECT * FROM <catalog>.<schema>.<table>; -- Deskripsi -- <catalog>: Nama sumber data yang akan dihubungkan. -- <schema>: Nama database yang digunakan. -- <table>: Tabel yang akan dikueri. -- Misalnya, untuk melihat data di tabel hive_table pada database default dalam sumber data Hive: -- Mengkueri tabel Hive SELECT * FROM hive.default.hive_table; -- Misalnya, untuk melihat data di tabel rt_user pada database rt_data kustom dalam sumber data MySQL: -- Mengkueri tabel MySQL SELECT * FROM mysql.rt_data.rt_user; -- Menggabungkan tabel Hive dan tabel MySQL SELECT DISTINCT a.id, a.name,b.rt_name FROM hive.default.hive_table a INNER JOIN mysql.rt_data.rt_user b ON a.id = b.id; -- Mengkueri tabel Hive menggunakan parameter penjadwalan SELECT * FROM hive.default.${table_name};(Opsional) Konfigurasi parameter lanjutan

Pada sisi kanan halaman, buka panel Schedule. Konfigurasikan parameter dalam tabel berikut pada bagian .

CatatanAnda dapat mengonfigurasi properti Spark open-source tambahan pada bagian .

Parameter

Deskripsi

FLOW_SKIP_SQL_ANALYZE

Menentukan apakah pernyataan SQL dieksekusi satu per satu atau sebagai satu batch. Nilai yang valid:

true: Mengeksekusi beberapa pernyataan SQL sekaligus.false(default): Mengeksekusi satu pernyataan SQL dalam satu waktu.

DATAWORKS_SESSION_DISABLE

Parameter ini berlaku saat menjalankan pengujian di lingkungan pengembangan. Nilai yang valid:

true: Membuat koneksi JDBC baru untuk setiap pernyataan SQL.false(default): Menggunakan kembali koneksi JDBC yang sama untuk semua pernyataan SQL yang dijalankan pengguna dalam node tersebut.

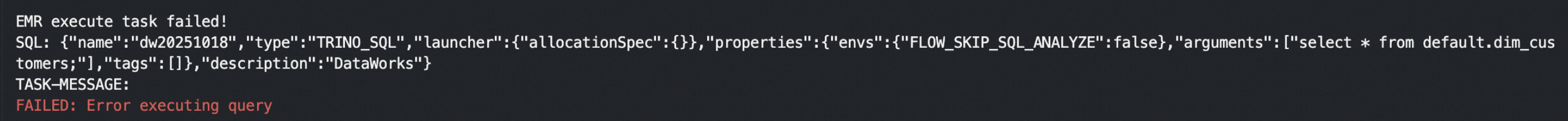

Jalankan tugas SQL

Pada Run Configuration di bawah Compute Resources, pilih dan konfigurasikan Compute Resources dan DataWorks resource group.

CatatanKonfigurasikan Scheduling CUs sesuai dengan sumber daya yang dibutuhkan tugas Anda. Nilai default adalah

0.25.Untuk mengakses sumber data di jaringan publik atau VPC, Anda harus menggunakan kelompok sumber daya penjadwalan yang dapat terhubung ke sumber data tersebut. Untuk informasi selengkapnya, lihat Solusi konektivitas jaringan.

Pada kotak dialog parameter pada bilah alat, pilih sumber data yang telah Anda buat dan klik Run untuk mengeksekusi tugas SQL.

CatatanKueri yang dijalankan pada node EMR Trino dapat mengembalikan maksimal 10.000 baris dan ukuran totalnya tidak boleh melebihi 10 MB.

Untuk menjalankan tugas node secara terjadwal, konfigurasikan pengaturan penjadwalannya sesuai kebutuhan bisnis Anda. Untuk informasi selengkapnya, lihat Konfigurasi penjadwalan node.

Setelah mengonfigurasi tugas node, lakukan penerapannya. Untuk informasi selengkapnya, lihat Penerapan node dan alur kerja.

Setelah tugas diterapkan, Anda dapat melihat status tugas periodik di Operation Center. Untuk informasi selengkapnya, lihat Memulai Operation Center.

FAQ

T: Mengapa terjadi error timeout koneksi saat saya menjalankan node?

J: Verifikasi konektivitas jaringan antara Resource Group dan Cluster. Buka halaman resource komputasi, temukan resource tersebut, lalu klik Initialize Resource. Pada kotak dialog yang muncul, klik Re-initialize dan pastikan inisialisasi berhasil.